基于深度學(xué)習(xí)的視網(wǎng)膜病變眼底圖視盤自動定位與分割研究*

楊帆,陳睿詩,莫陽,繆月紅,段平,谷浩,王麗會

(1.貴州醫(yī)科大學(xué) 生物與醫(yī)學(xué)工程重點實驗室,貴州 貴陽 550004; 2.貴州醫(yī)科大學(xué) 生物與工程學(xué)院 生物醫(yī)學(xué)工程教研室,貴州 貴陽 550004; 3.貴州醫(yī)科大學(xué)附院 眼科,貴州 貴陽 550004; 4.貴州大學(xué) 計算機(jī)科學(xué)與技術(shù)學(xué)院 貴州省智能醫(yī)學(xué)影像分析與精準(zhǔn)診斷重點實驗室,貴州 貴陽 550025)

目前,視網(wǎng)膜眼底圖像已經(jīng)廣泛用于視網(wǎng)膜病變、糖尿病性視網(wǎng)膜病變等診斷。青光眼是視神經(jīng)受損導(dǎo)致視力下降的一種疾病,一旦發(fā)病幾乎不可能完全治愈,但是及時的早期診斷及治療可以有效控制青光眼對視力的影響[1]。對于青光眼的診斷,可以通過眼底圖中視杯和視盤垂直直徑的比值作為診斷指標(biāo)[2],臨床上多采用目測方法得到比值,不同醫(yī)生得到結(jié)果存在差異;為了得到精確比值,可以借助計算機(jī)圖像處理技術(shù)自動實現(xiàn)視盤的定位、視盤及視杯分割,而關(guān)鍵步驟是視盤的定位與分割,以往對視盤定位的方法是假設(shè)視盤是圖像中最亮的區(qū)域,通過尋找最大像素的位置確定視盤[3],但該方法不適合對比度較低的圖像。對于視盤分割過去采用水平集方法[4-5],但此類方法對于初始曲線放置位置有較高要求,如果視盤中含有大量血管,算法魯棒性低。最近幾年,深度學(xué)習(xí)方法被廣泛用于醫(yī)學(xué)圖像的分割[6-14],其中U-Net深度學(xué)習(xí)法對于醫(yī)學(xué)圖像分割有較高的精度[15-16]。與過往的方法相比,深度學(xué)習(xí)法不需要對圖像做任何假設(shè)和預(yù)處理,僅需要提供訓(xùn)練圖像和標(biāo)記圖,通過網(wǎng)絡(luò)訓(xùn)練即可得到較好的分割結(jié)果,本研究在此基礎(chǔ)上,提出兩步U-Net網(wǎng)絡(luò)訓(xùn)練深度學(xué)習(xí)法,分別實現(xiàn)視盤的定位及分割。

1 材料與方法

1.1 主要材料

本文視盤定位數(shù)據(jù)采用了貴州醫(yī)科大學(xué)附院眼科視網(wǎng)膜病變眼底圖,共915張。視盤分割數(shù)據(jù)采用Messidor數(shù)據(jù)庫[17],該數(shù)據(jù)庫包含1 200張彩色視網(wǎng)膜病變圖像,以及每張圖像對應(yīng)的視盤邊界標(biāo)記圖。數(shù)據(jù)庫中圖像有3種尺寸,分別為1 440×960、2 240×1 488及2 304×1 536像素。

1.2 方法

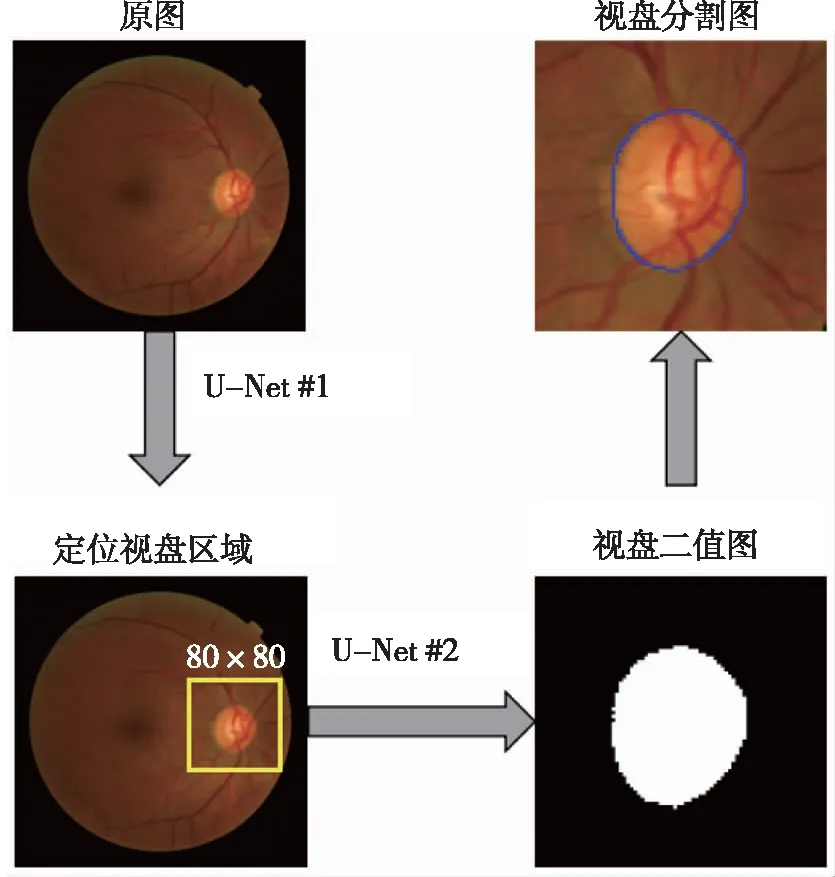

1.2.1主要算法流程 本文算法主要基于U-Net網(wǎng)絡(luò),其中算法分為2步,第1步將原圖輸入U-Net #1網(wǎng)絡(luò),通過網(wǎng)絡(luò)訓(xùn)練確定視盤在圖像中的位置;第2步根據(jù)視盤位置提取80×80的視盤區(qū)域圖像,輸入U-Net #2網(wǎng)絡(luò)用于視盤分割訓(xùn)練,將得到的視盤二值圖邊界標(biāo)記在原圖實現(xiàn)視盤的分割(圖1)。

圖1 視盤定位與分割算法主要流程Fig.1 The flow chart of Optic disk positioning and segmentation algorithm

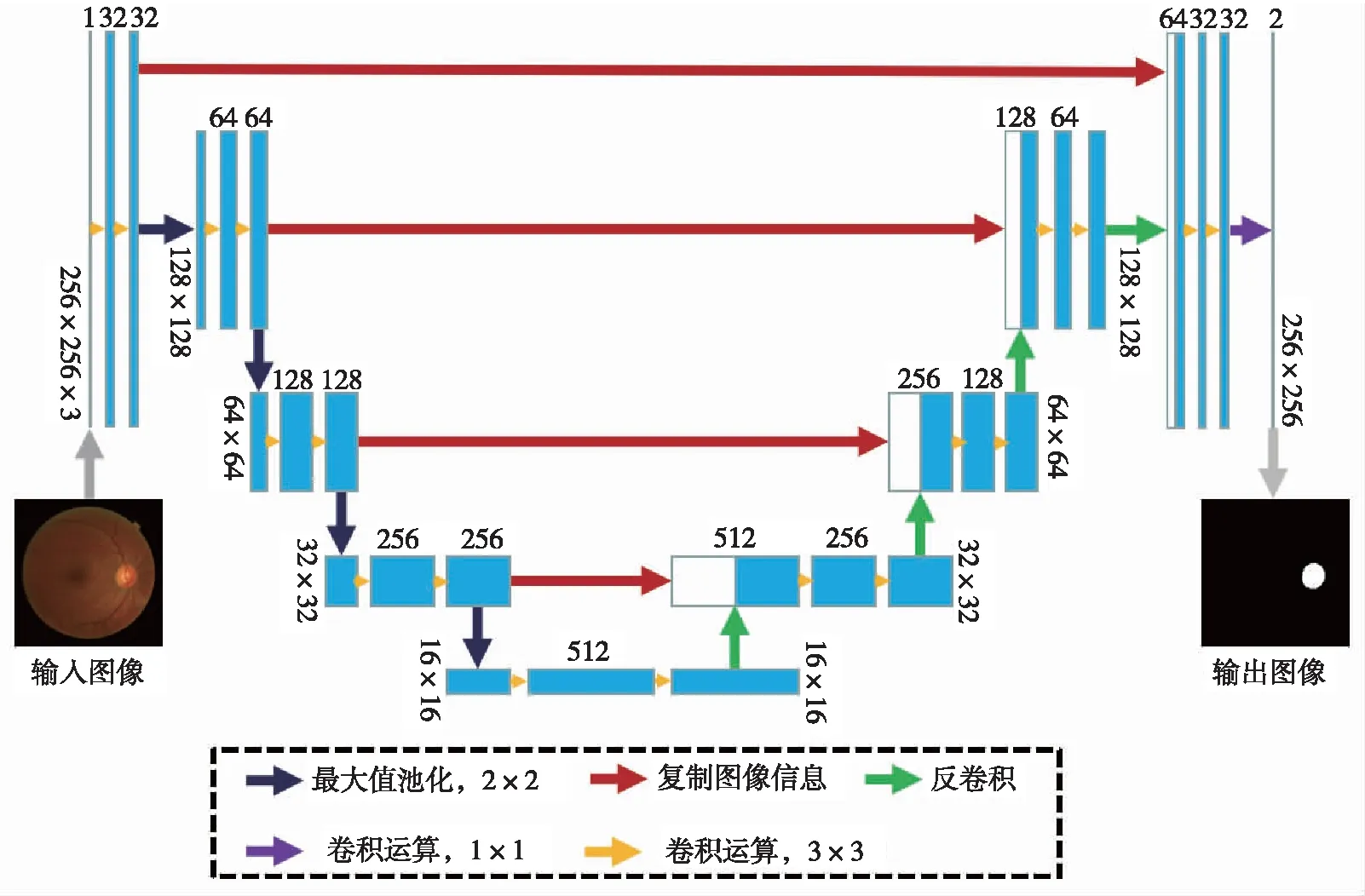

1.2.2U-Net網(wǎng)絡(luò)結(jié)構(gòu) 研究中采用的U-Net網(wǎng)絡(luò)模型呈U型結(jié)構(gòu),主要由卷積層、激活層、池化層、反卷積層等結(jié)構(gòu)組成,圖2顯示了算法第1步中的U-Net #1網(wǎng)絡(luò)模型。輸入圖像為256×256的彩色圖像,除了最后一層卷積層濾波器尺寸為1×1之外,其余所有卷積層濾波器尺寸為3×3,并且步長(stride)為1,補(bǔ)零(padding)為1;此外,3×3卷積層之后添加線性整流激活函數(shù)(rectified linear unit,ReLU)[18]增加網(wǎng)絡(luò)模型的非線性。網(wǎng)絡(luò)中下采樣階段使用的池化層為2×2的最大池化,上采樣階段使用步長為2,濾波器尺寸為2×2的反卷積將圖像恢復(fù)為輸入圖像尺寸;然后通過歸一化指數(shù)函數(shù)(softmax)得到每一類像素的概率值,并使用帶權(quán)重的交叉熵函數(shù)計算網(wǎng)絡(luò)的損失函數(shù)值(loss)。U-Net #2網(wǎng)絡(luò)模型和第1步采用網(wǎng)絡(luò)模型相同,唯一區(qū)別是輸入圖像為80×80的視盤區(qū)域圖像,輸出為80×80的視盤二值圖。

圖2 U-Net #1網(wǎng)絡(luò)結(jié)構(gòu)圖Fig.2 U-Net #1 network architecture

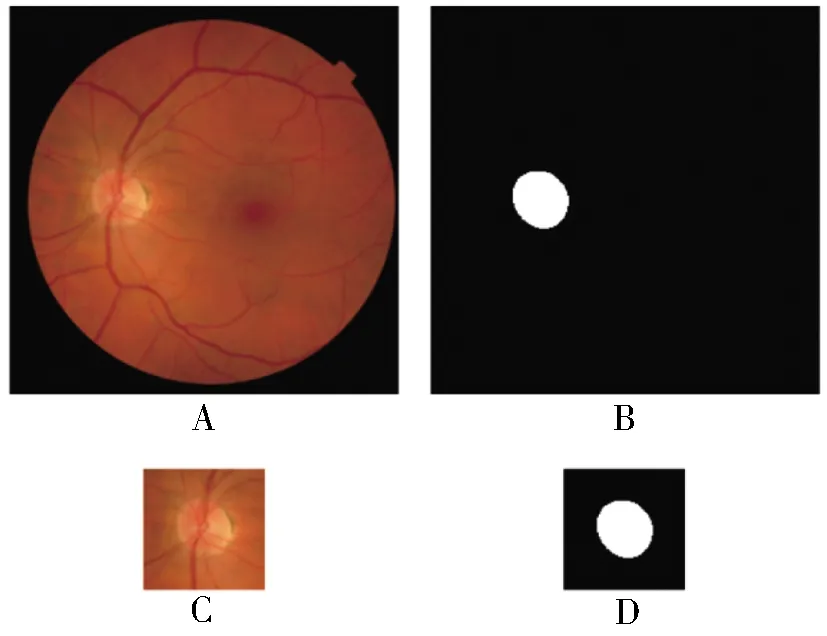

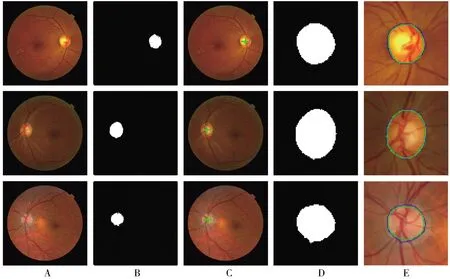

1.2.3數(shù)據(jù)處理 由于U-Net網(wǎng)絡(luò)要求輸入圖像尺寸相同,Messidor數(shù)據(jù)庫中的圖像通過Matlab 2018a軟件處理重新插值為256×256像素。Messidor數(shù)據(jù)庫中900幅用于網(wǎng)絡(luò)模型訓(xùn)練,300幅用于網(wǎng)絡(luò)模型測試。圖3分別顯示了算法第1步和第2步中用于訓(xùn)練的眼底圖及視盤標(biāo)記圖,其中第2步訓(xùn)練圖和標(biāo)記圖是根據(jù)第1步標(biāo)記圖中視盤中心位置截取80×80像素區(qū)域而得。標(biāo)記圖中白色區(qū)域像素值為2,黑色背景區(qū)域像素值為1。由于深度學(xué)習(xí)中需要大量的數(shù)據(jù)進(jìn)行網(wǎng)絡(luò)模型訓(xùn)練,訓(xùn)練集通過水平垂直鏡像、旋轉(zhuǎn)、高斯模糊等手段擴(kuò)增為14 400幅圖像。因此算法第1、2步中實際訓(xùn)練集為14 400幅圖像。

注:A為256×256像素眼底圖,B為256×256像素視盤標(biāo)記圖,C為80×80像素視盤區(qū)域圖像,D為80×80像素視盤區(qū)域標(biāo)記圖。圖3 眼底圖及視盤標(biāo)記圖Fig.3 Fundus image and labeled optic disk image

1.2.4實施細(xì)節(jié) 第1步中U-Net #1網(wǎng)絡(luò)訓(xùn)練每次輸入圖像為36幅,400次訓(xùn)練完成一個時期(epoch),當(dāng)loss及精度不再增加時停止訓(xùn)練(大約50個epoch);然后使用該訓(xùn)練好的模型檢測測試集圖像中的視盤位置,截取80×80像素視盤區(qū)域用于第2步中U-Net #2網(wǎng)絡(luò)測試。第2步中網(wǎng)絡(luò)訓(xùn)練同樣每次輸入36幅圖像,50個epoch后當(dāng)loss不再降低時停止訓(xùn)練。網(wǎng)絡(luò)初始學(xué)習(xí)率為0.05,每10個epoch下降為原來0.2倍。訓(xùn)練過程中使用深度學(xué)習(xí)平臺為Matlab 2018a,CPU為i7-7700 K,內(nèi)存64 g,顯卡為GTX 1080 Ti。

1.2.5數(shù)據(jù)評估方法 采用了準(zhǔn)確率、Dice系數(shù)、Jaccard系數(shù)、敏感性、特異性指標(biāo)評估實驗結(jié)果,用真陽性(TP)、真陰性(TN)、假陽性(FP)及假陰性(FN)計算上述指標(biāo)。計算方法如下:準(zhǔn)確率= (TP+TN)/(TP+TN+FP+FN),Dice系數(shù)=2TP/(2TP+FP+FN),Jaccard系數(shù)=TP/(TP+FP+FN),敏感性=TP/(TP+FN),特異性=TN/(TN+FP)。

2 結(jié)果

2.1 視盤定位及分割

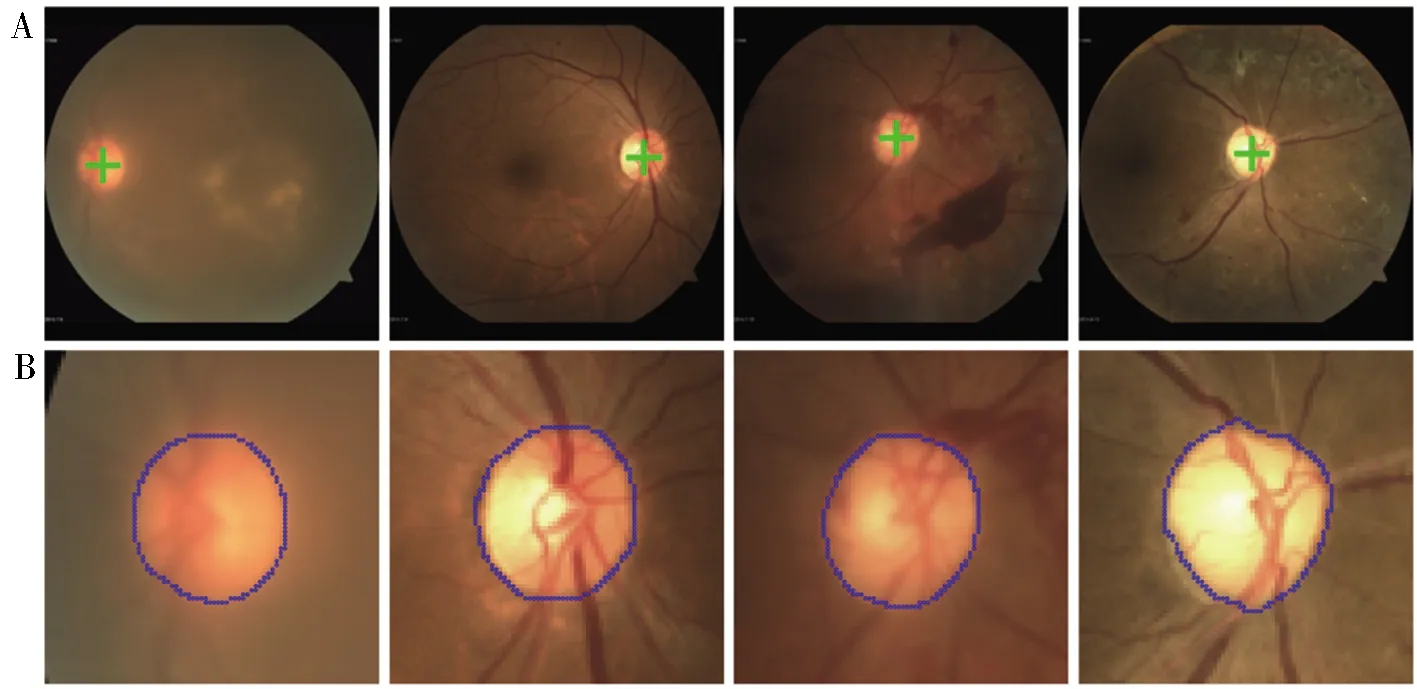

由于本院眼底數(shù)據(jù)沒有提供分割結(jié)果,該數(shù)據(jù)主要用于視盤定位。915幅圖像全部用于測試,視盤定位準(zhǔn)確率為87.10%。圖4顯示了部分視盤定位準(zhǔn)確的圖像及其分割結(jié)果,圖5顯示了部分未定位視盤圖像。此外,對Messidor數(shù)據(jù)庫中300張測試圖像進(jìn)行視盤定位,定位準(zhǔn)確率為100%。圖6顯示該數(shù)據(jù)庫部分視盤定位及分割圖像,其中綠色十字符號標(biāo)記了視盤在圖像中的位置,藍(lán)色線條為實際分割曲線,綠色線條為真實視盤邊界曲線。

注:A行為視盤定位圖像,B行為對應(yīng)眼底圖視盤分割結(jié)果;綠色十字符號標(biāo)記了視盤在圖像中的位置,藍(lán)色線條為實際分割結(jié)果。圖4 醫(yī)院數(shù)據(jù)視盤定位及分割結(jié)果Fig.4 Optic disk localization and segmentation from the hospital's images

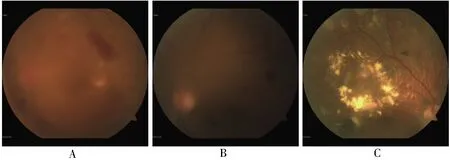

注:A未見視盤,B低對比度的視盤和眼底背景,C視盤殘缺。圖5 未定位視盤圖像Fig.5 Optic disk images without localization

注:A列圖像為原圖,B列為U-Net #1網(wǎng)絡(luò)輸出結(jié)果,C列為視盤定位圖,D列為U-Net #2網(wǎng)絡(luò)輸出結(jié)果,E列為最終分割結(jié)果。圖6 Messidor數(shù)據(jù)視盤定位及分割結(jié)果Fig.6 Optic disk localization and segmentation from Messidor database's images

2.2 統(tǒng)計結(jié)果

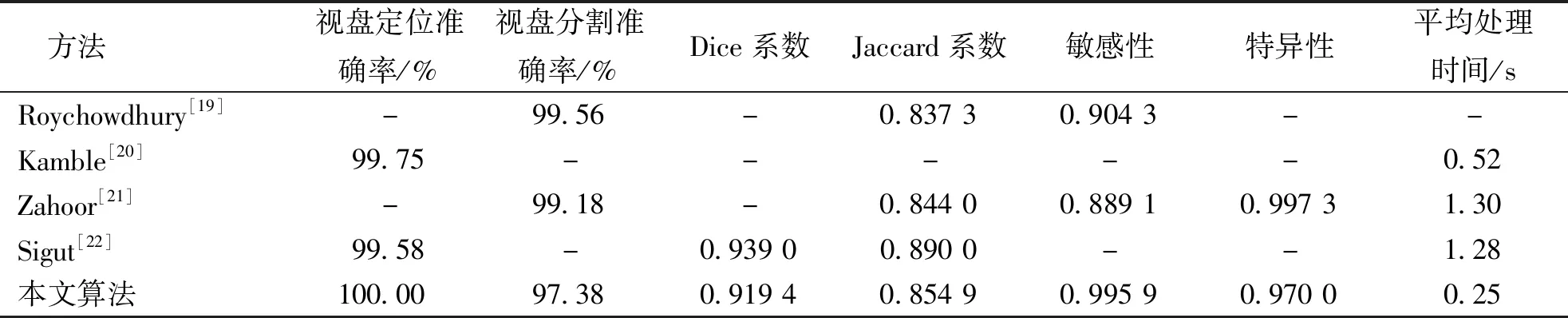

如表1所示,Messidor數(shù)據(jù)庫中300幅測試圖像視盤分割的平均準(zhǔn)確率、Dice系數(shù)、Jaccard系數(shù)、敏感性、特異性及平均單幅圖像處理時間指標(biāo),分別為97.38%、0.919 4、0.854 9、0.995 9、0.970 0及0.25 s。

表1 評估指標(biāo)統(tǒng)計結(jié)果比較Tab.1 Comparison of statistic results of evaluation parameters

注:“-”表示結(jié)果未給出。

3 討論

視盤的定位及分割是實現(xiàn)眼底圖像自動分析的重要環(huán)節(jié),特別是對于青光眼疾病的智能診斷。本文采用深度學(xué)習(xí)方法對視盤進(jìn)行定位及分割。對于視盤定位,從醫(yī)院采集數(shù)據(jù)定位準(zhǔn)確率為87.10%。部分圖像未定位的一個原因是圖像中未見視盤、視盤和眼底背景對比度低以及視盤殘缺。另外一個原因是研究中采用的訓(xùn)練數(shù)據(jù)來自Messidor數(shù)據(jù)庫,其中數(shù)據(jù)均含有視盤,且對比度高,沒有視盤殘缺的情況,因此使用該數(shù)據(jù)訓(xùn)練的網(wǎng)絡(luò)模型去測試時,會出現(xiàn)檢測不到視盤的情況。進(jìn)一步改善視盤定位精度,可以通過增加此類數(shù)據(jù)到訓(xùn)練集中進(jìn)行網(wǎng)絡(luò)訓(xùn)練。而Messidor數(shù)據(jù)庫中的圖像,本文算法視盤定位精度達(dá)到100%,高于其它方法。

對于視盤,在第1步視盤精確定位基礎(chǔ)上,利用U-Net #2網(wǎng)絡(luò)實現(xiàn)了視盤的分割。從結(jié)果可以看出實際分割線條和真實視盤邊界曲線相似,分割結(jié)果較好。另外從統(tǒng)計結(jié)果可以看出,本文算法各項評估指標(biāo)保持較高水平。雖然視盤分割準(zhǔn)確率、Dice系數(shù)、Jaccard系數(shù)略低于文獻(xiàn)[22]中的結(jié)果,但敏感性和平均處理時間遠(yuǎn)高于其它方法。特別是短的處理時間,對于實時處理數(shù)據(jù)有極大的幫助。此外,研究中只采用了900幅圖像用于訓(xùn)練,雖然通過圖像擴(kuò)增到14 400幅,但對于深度學(xué)習(xí)方法遠(yuǎn)遠(yuǎn)不夠,還需要繼續(xù)增加訓(xùn)練數(shù)據(jù)。

對于本文算法,主要采用了兩個U-Net網(wǎng)絡(luò)。其主要原因是視盤分割屬于圖像二分類問題(視盤和背景),當(dāng)樣本數(shù)據(jù)不平衡時,U-Net網(wǎng)絡(luò)達(dá)不到較高的分割精度。以往可以通過帶權(quán)重的交叉熵方法解決該問題,但研究中的視盤和背景像素總和差距較大,實驗結(jié)果精度低。因此通過第1步的U-Net網(wǎng)絡(luò)確定一個較小的視盤區(qū)域,輸入到第2個U-Net網(wǎng)絡(luò)中進(jìn)行測試。通過這種方法可以極大降低背景像素對于視盤分割的影響,從本研究的結(jié)果可以看出實際分割曲線和真實曲線幾乎重合。

綜上所述,本研究采用深度學(xué)習(xí)方法中的U-Net網(wǎng)絡(luò)分步實現(xiàn)了眼底圖中視盤的定位及分割,其視盤定位和視盤分割準(zhǔn)確率保存較高的精確度,同時極大縮減了圖像處理時間。通過與其它算法比較,證明了本算法的可行性和有效性。課題組將繼續(xù)擴(kuò)大訓(xùn)練集,采用新深度學(xué)習(xí)網(wǎng)絡(luò)模型提升視盤分割各項評估指標(biāo),使其在眼底圖像分析,尤其是青光眼智能診斷中發(fā)揮其應(yīng)用價值。

- 貴州醫(yī)科大學(xué)學(xué)報的其它文章

- 《貴州醫(yī)科大學(xué)學(xué)報》稿約

- Billroth-Ⅱ與Roux-en-Y重建消化道對高齡胃癌患者術(shù)后中長期生存質(zhì)量的影響*

- 莫西沙星對老年CAP患者肺功能及血清CRP、PCT、sTREM-1水平的影響*

- 不同BMI學(xué)齡期患兒行四肢手術(shù)插管全麻期間的血氣參數(shù)及呼吸參數(shù)特點分析*

- 點陣雙極射頻聯(lián)合透明質(zhì)酸凝膠敷料治療痤瘡凹陷性瘢痕的臨床觀察*

- 連續(xù)性腎臟替代治療對膿毒癥患者外周血部分T淋巴細(xì)胞、miRNA-155和miRNA-466表達(dá)的影響*