基于改進(jìn)ORB算法的VSLAM特征匹配算法研究

楊立闖 馬杰 馬鵬飛 王旭嬌 王楠楠

摘要 針對(duì)傳統(tǒng)特征匹配算法耗時(shí)較長(zhǎng)、匹配率不高的問(wèn)題,提出一種改進(jìn)ORB的圖像特征匹配算法。首先對(duì)FAST特征檢測(cè)算法進(jìn)行改進(jìn),構(gòu)建非線(xiàn)性尺度空間,采用非線(xiàn)性擴(kuò)散濾波方法,對(duì)金字塔進(jìn)行構(gòu)建,通過(guò)快速顯示擴(kuò)散形式(FED)進(jìn)行求解,得到尺度空間上的圖像,并采用灰度質(zhì)心法方法,對(duì)特征的角點(diǎn)方向進(jìn)行計(jì)算。然后對(duì)FREAK算法采樣模式進(jìn)行優(yōu)化,采用改進(jìn)的描述子構(gòu)建特征向量。最后采用GMS匹配算法剔除偽匹配點(diǎn)對(duì),有效降低誤匹配概率。實(shí)驗(yàn)證明,相比SIFT、SURF、FREAK、BRISK和ORB算法,本文改進(jìn)的算法在耗時(shí)和匹配率方面均有明顯效果,并在旋轉(zhuǎn)、尺度、光照等變換條件下,具有較強(qiáng)的魯棒性,適用于VSLAM系統(tǒng)。

關(guān) 鍵 詞 特征匹配;改進(jìn)ORB;FAST;特征檢測(cè);VSLAM

中圖分類(lèi)號(hào) TP391.41? ? ?文獻(xiàn)標(biāo)志碼 A

Research on VSLAM feature matching algorithm based on improved ORB algorithm

YANG Lichuang, MA Jie, MA Pengfei, WANG Xujiao, WANG Nannan

(School of Electronics and Information Engineering, Hebei University of Technology, Tianjin 300401,China)

Abstract Aiming at the problem of long time consuming and low matching rate of traditional feature matching algorithm, an improved image feature matching algorithm based on ORB is proposed. Firstly, the FAST feature detection algorithm is improved to build a nonlinear scale space, and the pyramid is constructed by using the nonlinear diffusion filtering method. The image in the scale space is obtained by solving the FAST display diffusion form (FED), and the corner direction of the feature is calculated by using the grayscale centroid method. Then, the sampling mode of the FREAK algorithm is optimized and the improved descriptor is used to construct the feature vector. Finally, the GMS matching algorithm is used to eliminate the false matching point pairs and effectively reduce the false matching probability. Compared with SIFT, SURF,F(xiàn)REAK,BRISK and ORB algorithms, the improved algorithm in this paper has obvious effects in terms of time consumption and matching rate, and has strong robustness under rotation, scale and illumination conditions, which is suitable for VSLAM systems.

Key words feature matching;? improved ORB; FAST; feature detection; VSLAM

0 引言

同時(shí)定位與地圖構(gòu)建(Simultaneous Localization and Mapping,SLAM)通過(guò)搭載某種設(shè)定的傳感器,在沒(méi)有環(huán)境先驗(yàn)信息的情況下,在運(yùn)動(dòng)過(guò)程中構(gòu)建環(huán)境的模型,同時(shí)估計(jì)自己的運(yùn)動(dòng)[1]。若此傳感器為視覺(jué)相機(jī),則稱(chēng)為視覺(jué)SLAM,簡(jiǎn)稱(chēng)VSLAM。經(jīng)典視覺(jué)SLAM框架主要包括視覺(jué)里程計(jì)(VO)、后端優(yōu)化、回環(huán)檢測(cè)以及地圖構(gòu)建等部分。精確的圖像匹配是系統(tǒng)良好運(yùn)動(dòng)估計(jì)以及建圖過(guò)程的前提,因此對(duì)特征匹配算法的研究至關(guān)重要。局部特征圖像特征匹配方法對(duì)旋轉(zhuǎn)、尺度變換、光照以及高斯噪聲等具有較好的不變性,在智能識(shí)別領(lǐng)域,圖像已經(jīng)成為信息獲取的重要途徑,因而匹配算法在目標(biāo)追蹤[2]、醫(yī)療疾病檢測(cè)[3]、安防監(jiān)控[4]、工業(yè)產(chǎn)品檢測(cè)[5]、空間遙感技術(shù)[6]等重要領(lǐng)域的研究及應(yīng)用越來(lái)越廣泛。

作為圖像處理學(xué)科研究熱點(diǎn),多年以來(lái),國(guó)內(nèi)外學(xué)者一直致力于圖像特征匹配算法研究。Lowe等[7]在2004年提出著名的SIFT算法,該算法對(duì)旋轉(zhuǎn)、尺度、光照等外界條件有較強(qiáng)的適應(yīng)性,匹配效率較高,但計(jì)算復(fù)雜度偏高,耗時(shí)嚴(yán)重,實(shí)時(shí)性較差。Bay等[8]在SIFT算法研究基礎(chǔ)之上,在2006年提出了SURF算法,采用積分圖像與多尺度箱體濾波器進(jìn)行卷積,運(yùn)算速度明顯提升,但穩(wěn)定性以及實(shí)時(shí)性不高。

近年來(lái),一些新的局部特征匹配算法不斷涌現(xiàn)。BRISK算法由Leutenegger等[9]在2011年提出,該算法尺度與旋轉(zhuǎn)不變性較好,匹配效率高,對(duì)具有高度模糊圖像匹配效果最佳。Rublee等[10]在2011年提出ORB算法,該算法通過(guò)FAST 檢測(cè)子[11]和BRIEF描述子[12]組合進(jìn)行實(shí)現(xiàn),具有高效運(yùn)算速度,分別比SIFT與SURF算法快2個(gè)和1個(gè)數(shù)量級(jí),但對(duì)圖像尺度變化適應(yīng)性差。Alahi等在2012年提出了FREAK算法[13],該算法根據(jù)人眼識(shí)別物體的原理進(jìn)行特征采樣,匹配速率較快,但對(duì)尺度變化圖像配準(zhǔn)的效果差。因而,本文基于傳統(tǒng)ORB算法提出了一種改進(jìn)的視覺(jué)圖像特征匹配算法,并通過(guò)與SIFT、SURF、FREAK、BRISK和ORB算法的對(duì)比實(shí)驗(yàn)進(jìn)行算法可行性分析。

1 改進(jìn)的VSLAM特征匹配算法

1.1 FAST特征提取算法

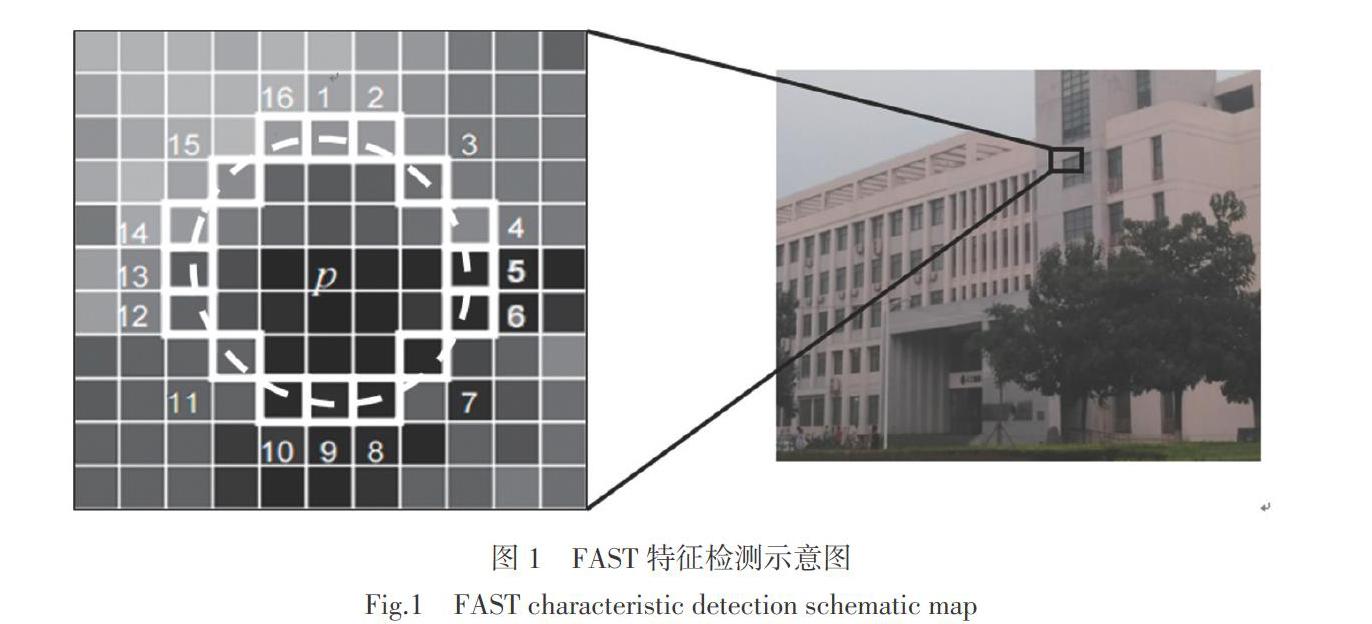

FAST角點(diǎn)算法根據(jù)灰度差異程度來(lái)檢測(cè),計(jì)算的時(shí)間復(fù)雜度較小,檢測(cè)效果比較突出。FAST角點(diǎn)檢測(cè)算法角點(diǎn)的定義為:如果圖像中某個(gè)像素點(diǎn)的灰度與周?chē)徲騼?nèi)數(shù)量足夠多的像素點(diǎn)差別足夠大,則將該特征像素點(diǎn)認(rèn)定為候選特征點(diǎn)。FAST特征點(diǎn)檢測(cè)如圖1所示。

在FAST角點(diǎn)檢測(cè)過(guò)程中,檢測(cè)圓心是像素點(diǎn)p,半徑為3像素的離散圓邊界上的16 個(gè)像素點(diǎn),若在圓周上存在N個(gè)連續(xù)像素點(diǎn),則中心點(diǎn)p是特征點(diǎn)的判斷模型[fdet]為

[ fdet=1,|Ix-Ip|>ξ? 0, Ix-Ip<ξ? ], (1)

式中:[I]表達(dá)的是灰度;x表示圓上的點(diǎn);ξ是設(shè)計(jì)的一個(gè)閾值。

[N=x∈circlepfdet(Ix , Ip)], (2)

式中:N表示全部判斷模型的相加總和,參數(shù)N為中心像素點(diǎn)p和圍繞其的圓環(huán)上像素的強(qiáng)度閾值;N的值通常取12,即FAST-12算法。N也經(jīng)常取值9以及11,即FAST-9和FAST-11算法。當(dāng)N=12情況時(shí),F(xiàn)AST 特征檢測(cè)算法獲得的特征點(diǎn)效果最好,質(zhì)量最佳。

1.2 改進(jìn)FAST特征提取算法

在本文改進(jìn)FAST特征提取算法中,開(kāi)始對(duì)圖像空間加入尺度信息,根據(jù)濾波的形式,通過(guò)快速顯示擴(kuò)散形式(FED)進(jìn)行計(jì)算,得到尺度空間上的圖像。然后采用灰度質(zhì)心法方法,對(duì)特征的角點(diǎn)方向進(jìn)行計(jì)算。

非線(xiàn)性擴(kuò)散濾波主要目的是對(duì)相異尺度空間中圖像亮度進(jìn)行表示,偏微分方程的非線(xiàn)性形式能夠?qū)瘮?shù)散度做描述,具體形式為

[?L?t=div(cx,y,t·? ? L)], (3)

[cx,y,t=g(|? ? Lσx,y,t|)], (4)

[g=11+|? ? Lσ|2/λ2], (5)

式中:[div]為散度;[▽]為梯度;L為亮度;[cx,y,t]為擴(kuò)散函數(shù);t為表示尺度的參數(shù),與尺度成正比關(guān)系;g為區(qū)域保留優(yōu)先級(jí)函數(shù);? [Lσ]表達(dá)高斯平滑,參數(shù)是圖像標(biāo)準(zhǔn)差σ;λ為對(duì)比度因子,與圖像邊緣信息成反比。

本文通過(guò)快速顯示擴(kuò)散方式(FED)對(duì)非線(xiàn)性擴(kuò)散濾波進(jìn)行計(jì)算。循環(huán)次數(shù)M后,獲得圖像濾波后總和。其中M = O·S, O和S分別是金字塔的組數(shù)和層數(shù)。N回迭代表示一回循環(huán),[τj]表示迭代第j回的步長(zhǎng):

[τj=τmax2cos2(π2j+14n+2)], (6)

式中[τmax]是保持迭代穩(wěn)定的步長(zhǎng)最大值。此時(shí)顯示形式的偏微分方程為

[Li+1-Liτ=A(Li)Li], (7)

式中:[τ]表示某個(gè)常量步長(zhǎng);[A(Li)]是傳導(dǎo)矩陣。

尺度參數(shù)[σi]表示高斯濾波后的濾波參數(shù),其數(shù)學(xué)形式為

[σio,s=2o+sS], (8)

式中:o∈[0,O-1],s∈[0,S-1],i ∈[0,M]。[σi]表示的是尺度,現(xiàn)在應(yīng)該把其等效成時(shí)間,高斯尺度空間中,圖像使用高斯核是標(biāo)準(zhǔn)差σ的卷積和t=[σ2i/2]連續(xù)濾波效果相當(dāng),所以,尺度參數(shù)[σi]與時(shí)間[ti]的轉(zhuǎn)換為

[ti=12σ2i]。 (9)

經(jīng)過(guò)[oi]層高斯濾波后,繼續(xù)對(duì)下一層做降采樣,使用FED算法,并對(duì)λ做調(diào)整,從而可獲得M次循環(huán)共O組S層金字塔非線(xiàn)性尺度空間。

然后采用灰度質(zhì)心法,對(duì)特征的角點(diǎn)方向進(jìn)行計(jì)算。灰度質(zhì)心法假定某一特征點(diǎn)的灰度與該鄰域重心之間存在某種偏移,確定特征點(diǎn)局部區(qū)域中的灰度中心C,從特征點(diǎn)P到灰度中心C的方向矢量即為特征點(diǎn)的主方向,定義局部圖塊區(qū)域S的矩為

[Mpq=(x,y)∈SxpyqIx,y,? ? ? ?p,q={0,1}], (10)

式中:I(x,y)是像素點(diǎn)(x,y)位置的灰度值。

根據(jù)圖像塊區(qū)域中的這些p+q階矩能夠得到灰度中心C的坐標(biāo)為

[C=Cx ,Cy=M10M00 , M01M00]。 (11)

特征點(diǎn)P與灰度中心C之間的方向角[θ]即為特征點(diǎn)的主方向:

[θ=arctanM01, M10=arctanyIx,yxIx,y,? ? ? (x,y)∈S]。 (12)

1.3 改進(jìn)FREAK的特征描述算法

FREAK算法是通過(guò)人眼視覺(jué)系統(tǒng)啟發(fā)提出的算法,人眼視網(wǎng)膜根據(jù)其感光細(xì)胞的密度差異分成4大區(qū)域:perifoveal、parafoveal、fovea、foveola,離中心區(qū)域越遠(yuǎn),神經(jīng)節(jié)細(xì)胞密度越小,其結(jié)構(gòu)如圖2所示。其中fovea區(qū)域負(fù)責(zé)接收高分辨率圖像,而低分辨率圖像由最外層區(qū)域形成。

FREAK描述子根據(jù)人類(lèi)視網(wǎng)膜感光原理設(shè)計(jì),傳統(tǒng)的采樣模型如圖3所示。采用6、6、6、6、6、6、6、1形式的采樣結(jié)構(gòu),除中心特征點(diǎn)外,在7個(gè)同心圓上每層采6個(gè)樣點(diǎn),一共43 個(gè)點(diǎn)數(shù)。在上邊的樣點(diǎn)獲取中,中心地方的樣點(diǎn)比較多,從中心點(diǎn)向外采樣點(diǎn)越來(lái)越稀疏。

本文采用簡(jiǎn)化的5層FREAK描述算子,采樣結(jié)構(gòu)為6、6、6、6、1形式,包括25個(gè)采樣點(diǎn),如圖4所示。采用簡(jiǎn)化的FREAK描述子對(duì)檢測(cè)到的特征點(diǎn)進(jìn)行特征描述,這里用F表示構(gòu)建的二進(jìn)制位串描述子:

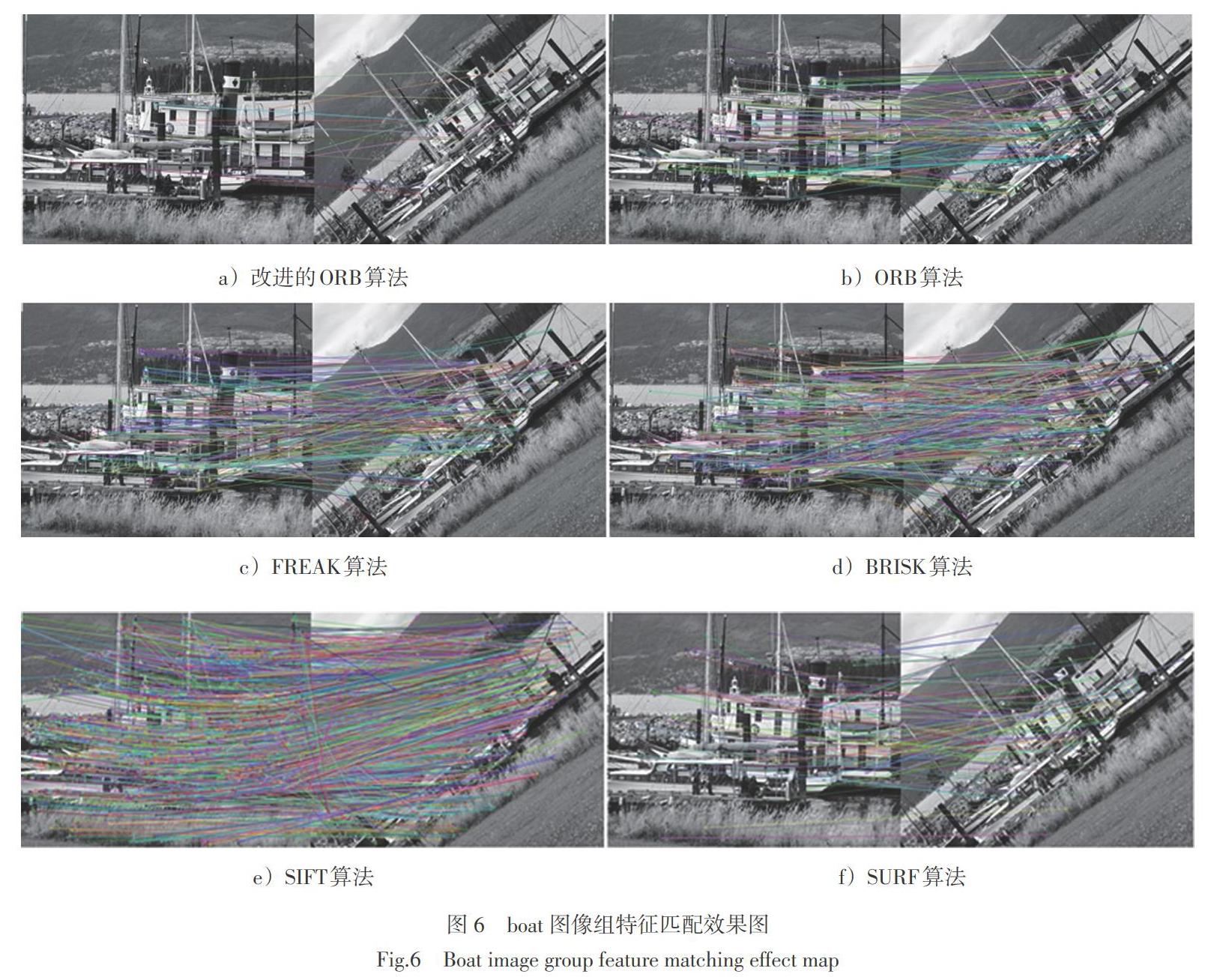

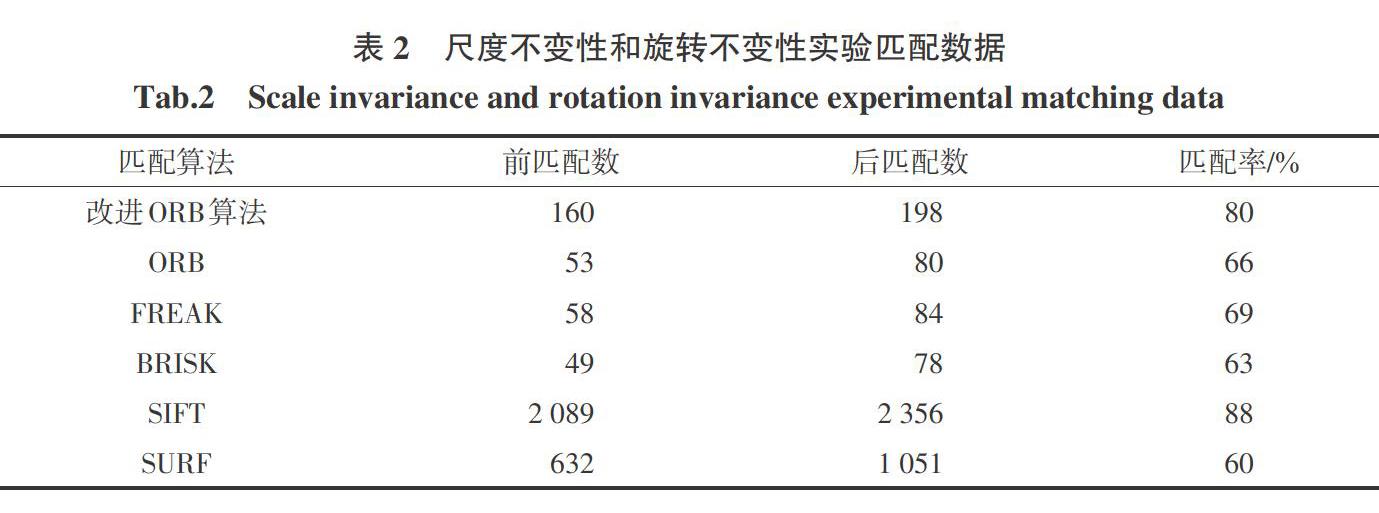

[F=0≤k [T(Pk)=1,? ? ? ? ? ? (I(Pr1k)-I(Pr2k) >0)? 0,? ? ? ? ? ? ? ? ? ? 其他? ? ? ? ? ?] ,? ? ? ? (14) 式中:Pk是當(dāng)前采樣點(diǎn)對(duì);N是生成特征向量的維數(shù);I([Pr1k])是采樣點(diǎn)經(jīng)過(guò)高斯平滑的灰度大小。 如果對(duì)圖像的采樣點(diǎn)數(shù)為M,則采樣點(diǎn)對(duì)的對(duì)數(shù)為[CM2]對(duì)。若按照傳統(tǒng)FREAK描述子采樣模式進(jìn)行采樣,此時(shí)采樣點(diǎn)總數(shù)為43,那么采樣點(diǎn)對(duì)數(shù)為[C432],即有903對(duì)采樣點(diǎn)。大多數(shù)采樣點(diǎn)對(duì)包含過(guò)多冗余或粗糙的信息,對(duì)于特征描述意義不大,并且還會(huì)增加過(guò)多不必要計(jì)算。因此采用簡(jiǎn)化的采樣模型構(gòu)建FREAK描述子,則采樣點(diǎn)總數(shù)減少為25,采樣點(diǎn)對(duì)數(shù)為[C252],即300對(duì)采樣點(diǎn)對(duì)。為提高描述子辨識(shí)度,剔除信息較匱乏的維度,對(duì)生成的二進(jìn)制描述子作維度篩選。 1)構(gòu)建矩陣D,其任意行皆為簡(jiǎn)化的FREAK二進(jìn)制描述子,因此由0和1組成的矩陣D每行包含[C252]個(gè)元素,即特征矩陣D的列數(shù)是300。 2)計(jì)算矩陣D各列均值,越接近0.5的列其方差越大。 3)根據(jù)方差遞減順序?qū)Ω髁羞M(jìn)行排序,選擇前256列為最終特征描述子。 根據(jù)視網(wǎng)膜采樣模型,分辨率越高維度越低,因此將具有32個(gè)字節(jié)的FREAK描述子進(jìn)行分段匹配,首先匹配前16字節(jié),若Hamming 距離小于設(shè)定的閾值T,則繼續(xù)匹配后16字節(jié),否則直接判定為非內(nèi)點(diǎn)。經(jīng)過(guò)分段匹配策略,可以剔除9成以上的偽匹配。 當(dāng)描述子分段匹配結(jié)束之后,則根據(jù)漢明距離進(jìn)行粗匹配,接著選用GMS匹配算法剔除偽匹配點(diǎn)對(duì),從而有效降低錯(cuò)誤匹配點(diǎn)對(duì)的出現(xiàn)概率,經(jīng)過(guò)多次相應(yīng)處理步驟將外點(diǎn)影響降到最低,最終獲得滿(mǎn)足要求的結(jié)果。 2 實(shí)驗(yàn)結(jié)果與分析 下面利用改進(jìn)ORB算法、SIFT算法、 SURF算法、ORB算法、FREAK算法以及BRISK算法,對(duì)圖像的旋轉(zhuǎn)不變性、尺度不變性、光照不變性、模糊不變性以及改進(jìn)算法的提取的特征點(diǎn)數(shù)量和實(shí)時(shí)性進(jìn)行分析研究。實(shí)驗(yàn)中采用的數(shù)據(jù)集為用于圖像處理特征點(diǎn)識(shí)別的標(biāo)準(zhǔn)數(shù)據(jù)集,即Mikolajczyk和Schmid提供的graffiti圖集、boat圖集、bike圖集和Leuven圖集。 2.1 特征點(diǎn)數(shù)量及耗時(shí)檢測(cè) 本文通過(guò)graffiti圖集對(duì)圖像進(jìn)行提取特征點(diǎn)時(shí)間和數(shù)量的測(cè)試,在相同的匹配環(huán)境下,對(duì)相同的一對(duì)圖像進(jìn)行比較,測(cè)試算法的執(zhí)行時(shí)間以及提取的特征點(diǎn)數(shù)。選取graffiti圖像組中的第1幅和第3幅圖片進(jìn)行測(cè)試實(shí)驗(yàn),改進(jìn)算法、ORB算法、FREAK算法、BRISK算法、SIFT算法和SURF算法的匹配效果如圖5所示,特征點(diǎn)數(shù)量和檢測(cè)時(shí)間均值數(shù)據(jù)如表1所示。 根據(jù)表1中可以看出: SIFT算法檢測(cè)的特征點(diǎn)數(shù)量均值最多,但是耗時(shí)非常嚴(yán)重,已經(jīng)高達(dá)1 716 ms。SURF算法特征數(shù)量檢測(cè)上效果不錯(cuò),然而檢測(cè)時(shí)間較長(zhǎng)。FREAK算法和BRISK算法在特征數(shù)量檢測(cè)上比ORB算法稍高一些,但耗時(shí)分別是ORB算法的1.8倍和2.9倍。本文改進(jìn)的算法在特征檢測(cè)上與SURF算法旗鼓相當(dāng),耗時(shí)僅為10 ms,比ORB算法節(jié)省了的8倍時(shí)間。相對(duì)于SIFT算法、SURF算法、FREAK算法、BRISK算法和ORB算法,本算法在特征點(diǎn)數(shù)量以及耗時(shí)方面表現(xiàn)出色。 2.2 尺度不變性和旋轉(zhuǎn)不變性檢測(cè) 本文通過(guò)boat圖集進(jìn)行測(cè)試。選取boat圖像組中的第1幅和第3幅圖片,進(jìn)行尺度不變性以及旋轉(zhuǎn)不變性的對(duì)比實(shí)驗(yàn)。改進(jìn)算法、ORB算法、FREAK算法、BRISK算法、SIFT算法和SURF算法的匹配效果和匹配數(shù)據(jù)如圖6和表2所示。根據(jù)表2可得:本文改進(jìn)的算法的匹配率是80%,僅次于SIFT算法,比SURF算法、FREAK算法、BRISK算法和ORB算法的匹配率都高,并且相對(duì)于ORB算法匹配率提高了14個(gè)百分點(diǎn)。 2.3 模糊不變性檢測(cè) 通過(guò)bike圖集進(jìn)行模糊不變性測(cè)試,選取bikes圖像組中的第1幅和第3幅圖片,進(jìn)行模糊不變性的對(duì)比實(shí)驗(yàn),最終實(shí)驗(yàn)的匹配效果如圖7所示。本文算法相對(duì)于SIFT算法、SURF算法、FREAK算法、BRISK算法和ORB算法的匹配數(shù)據(jù)如表3所示。根據(jù)表3不難看出:本文改進(jìn)算法的匹配率為92%,與SIFT算法匹配率相當(dāng),明顯高于SURF算法、FREAK算法、BRISK算法和ORB算法的匹配率。 2.4 光照不變性檢測(cè) 通過(guò)Leuven圖集進(jìn)行光照不變性實(shí)驗(yàn),選取Leuven圖像組中的第1幅和第5幅圖片,進(jìn)行光照不變性的對(duì)比實(shí)驗(yàn),最終實(shí)驗(yàn)的匹配效果如圖8所示。本文算法相對(duì)于SIFT算法、SURF算法、FREAK算法、BRISK算法和ORB算法的匹配數(shù)據(jù)如表4所示。根據(jù)表4不難看出:本文改進(jìn)算法的匹配率為88%,僅比SIFT算法匹配率低1個(gè)百分點(diǎn),并且比SURF算法、FREAK算法、BRISK算法以及ORB算法的匹配率要高。 通過(guò)上文對(duì)改進(jìn)ORB算法、ORB算法、FREAK算法、BRISK算法、SIFT算法以及SURF算法的實(shí)驗(yàn)分析測(cè)試,可以看出:本文改進(jìn)的ORB算法在旋轉(zhuǎn)、尺度、光照等變換條件下,能夠出色的實(shí)現(xiàn)特征點(diǎn)檢測(cè)和匹配過(guò)程,具有較強(qiáng)的魯棒性。 3 結(jié)論 本文主要對(duì)ORB算法進(jìn)行改進(jìn)研究,改進(jìn)了FAST特征提取和FREAK特征描述算法。首先介紹傳統(tǒng)FAST特征提取算法,并對(duì)特征提取算法進(jìn)行改進(jìn),構(gòu)建非線(xiàn)性尺度空間,采用非線(xiàn)性擴(kuò)散濾波方法,對(duì)金字塔進(jìn)行構(gòu)建,通過(guò)快速顯示擴(kuò)散形式(FED)進(jìn)行計(jì)算,得到尺度空間上的圖像,然后采用灰度質(zhì)心法方法,對(duì)特征的角點(diǎn)方向進(jìn)行計(jì)算。接著對(duì)FREAK的特征描述算法進(jìn)行優(yōu)化,改進(jìn)了FREAK描述子的采樣模式,對(duì)采樣點(diǎn)中的冗余信息進(jìn)行剔除,提高采樣效率和質(zhì)量。此外采用GMS圖像匹配算法剔除偽匹配點(diǎn)對(duì),降低錯(cuò)誤匹配點(diǎn)對(duì)的出現(xiàn)概率。最后對(duì)圖像的旋轉(zhuǎn)、尺度、光照和模糊不變性以及改進(jìn)算法的提取的特征點(diǎn)數(shù)量和實(shí)時(shí)性進(jìn)行了實(shí)驗(yàn),實(shí)驗(yàn)證明本文改進(jìn)算法在旋轉(zhuǎn)、尺度、光照等變換條件下,能夠出色地完成特征點(diǎn)檢測(cè)和匹配工作,具有較強(qiáng)的魯棒性,適用于VSLAM系統(tǒng)。 參考文獻(xiàn): [1]? ? 劉浩敏,章國(guó)鋒,鮑虎軍. 基于單目視覺(jué)的同時(shí)定位與地圖構(gòu)建方法綜述[J]. 計(jì)算機(jī)輔助設(shè)計(jì)與圖形學(xué)學(xué)報(bào),2016,28(6):855-868. [2]? ? SINHA S N,F(xiàn)RAHM J,POLLEFEYS M,et al. Feature tracking and matching in video using programmable graphics hardware[J]. Machine Vision and Applications,2011,22(1):207-217. [3]? ? GAO L L,PAN H W,HAN J M,et al. Corner detection and matching methods for brain medical image classification[C]//2016 IEEE International Conference on Bioinformatics and Biomedicine (BIBM),December 15-18,2016. Shenzhen,China. New York,USA:IEEE,2016:475-478. [4]? ? CHEN P W,GUI C F. Alpha divergences based mass transport models for image matching problems[J]. Inverse Problems and Imaging,2011,5(3):551-590. [5]? ? BLASCHKE T. Object based image analysis for remote sensing[J]. ISPRS Journal of Photogrammetry and Remote Sensing,2010,65(1):2-16. [6]? ? ZHAO M,AN B W,WU Y P,et al. RFVTM:A recovery and filtering vertex trichotomy matching for remote sensing image registration[J]. IEEE Transactions on Geoscience and Remote Sensing,2017,55(1):375-391. [7]? ? LOWE D G. Distinctive image features from scale-invariant key point [J]. International Journal of Computer Vision,2004,60(2):91-110. [8]? ? BAYH,ESSA,TUYTELAARS T,et al. Speeded-up robust features (SURF)[J]. Computer Vision and Image Understanding,2008,110(3):346-359. [9]? ? LEUTENEGGER S,CHLI M,SIEGWART R Y. BRISK:Binary Robust invariant scalable keypoints[C]//2011 International Conference on Computer Vision,November 6-13,2011. Barcelona,Spain. New York,USA:IEEE,2011. [10]? RUBLEE E,RABAUD V,KONOLIGE K,et al. ORB:An efficient alternative to SIFT or SURF[C]//2011 International Conference on Computer Vision,November 6-13,2011. Barcelona,Spain. New York,USA:IEEE,2011:2564-2571. [11]? ROSTEN E,DRUMMOND T. Machine learning for high-speed corner detection[M]. Computer Vision-ECCV 2006. Berlin,Heidelberg:Springer Berlin Heidelberg,2006:430-443. [12]? CALONDER M,LEPETIT V,STRECHA C,et al. BRIEF:binary robust independent elementary features[M]. Computer Vision-ECCV 2010. Berlin,Heidelberg:Springer Berlin Heidelberg,2010:778-792. [13]? ALAHI A,ORTIZ R,VANDERGHEYNST P. FREAK:fast retina keypoint[C]//Proceedings of the IEEE Computer Vision Pattern Recognition. [s. n. ]:2012:510-517. [責(zé)任編輯? ? 田? ? 豐]