基于紋理圖像與網(wǎng)格協(xié)同優(yōu)化算法的三維模型壓縮

董濤

摘? 要:該文提出一種基于紋理圖像與網(wǎng)格協(xié)同優(yōu)化算法的三維模型壓縮簡(jiǎn)化方法,在不降低三維模型視覺顯示效果前提下,壓縮三維模型數(shù)據(jù)。首先,對(duì)原始模型進(jìn)行重網(wǎng)格化,獲得具有規(guī)則拓?fù)浣Y(jié)構(gòu)的多分辨率網(wǎng)格;其次,結(jié)合模型網(wǎng)格提取紋理特征點(diǎn),依據(jù)特征點(diǎn)確定圖像有效區(qū)域;最后,利用嵌入式零樹小波算法對(duì)圖像進(jìn)行編碼和解碼操作,實(shí)現(xiàn)對(duì)三維模型的壓縮簡(jiǎn)化及圖像重建。實(shí)驗(yàn)證明,該方法提取的圖像有效區(qū)域更快捷、壓縮率高、細(xì)節(jié)豐富。

關(guān)鍵詞:紋理圖像? 三維模型? 壓縮

中圖分類號(hào):TP39 ? ?文獻(xiàn)標(biāo)識(shí)碼:A 文章編號(hào):1672-3791(2020)01(b)-0014-02

隨著計(jì)算機(jī)圖形圖像處理技術(shù)的不斷進(jìn)步,三維模型技術(shù)越來(lái)越多的應(yīng)用于互聯(lián)網(wǎng)領(lǐng)域。瀏覽三維模型時(shí),需將服務(wù)器端的模型文件傳輸?shù)娇蛻舳说臑g覽器上,渲染生成模型,直接使用高精度模型不便于存儲(chǔ)、傳輸和處理。三維技術(shù)在給用戶帶來(lái)真實(shí)體驗(yàn)的同時(shí),也帶來(lái)了龐大的模型及紋理數(shù)據(jù)量[1]。解決該問題,一方面要采取硬件方面的措施,另一方面需要圖形圖像方面的軟件技術(shù)支持。

多年來(lái)關(guān)于三維模型的壓縮與簡(jiǎn)化方面取得了較多的研究成果。Levoy首次提出直接使用點(diǎn)來(lái)表示和渲染三維模型表面。Michael Deering提出幾何壓縮方法。Beers等提出了一種紋理壓縮方法。Shao Yajuan提出三維網(wǎng)格和紋理圖像的同步壓縮與漸進(jìn)傳輸方案。Qin Aihong等提出借助一組具有值不變性的參照平面代替原有算法的預(yù)測(cè)點(diǎn),提高了壓縮算法精度。Sungyul Choe等設(shè)計(jì)實(shí)現(xiàn)了可隨機(jī)讀取模型局部信息的編碼算法。綜上所述,使用紋理圖像與網(wǎng)格協(xié)同優(yōu)化算法進(jìn)行三維模型壓縮尚未有人研究過。

1? 該文方法概述

該文算法首先運(yùn)用網(wǎng)格半正則化算法對(duì)原始模型進(jìn)行重網(wǎng)格化,生成具有半正則結(jié)構(gòu)的多分辨率網(wǎng)格,將模型的基網(wǎng)格作為原形,依據(jù)加入細(xì)節(jié)信息的數(shù)量建立多個(gè)層次,構(gòu)建網(wǎng)格的四叉樹結(jié)構(gòu)。其次求取基網(wǎng)格以外的所有層次頂點(diǎn)實(shí)際位置和預(yù)測(cè)位置的偏移量,構(gòu)建偏移量小波生成樹[2],依據(jù)特征點(diǎn)的分布區(qū)域及點(diǎn)之間的內(nèi)在聯(lián)系,提取感興趣區(qū)域。最后利用嵌入式零樹小波算法對(duì)圖像進(jìn)行編碼和解碼操作,實(shí)現(xiàn)對(duì)三維模型的壓縮簡(jiǎn)化及圖像重建。

2? 三維模型紋理圖像壓縮

2.1 紋理圖像與模型網(wǎng)格

紋理映射的過程是設(shè)備坐標(biāo)到的紋理坐標(biāo)的變換。給定空間曲面S∈R3,S中的隨機(jī)點(diǎn)(x、y、z),通過紋理映射τ找到它在參數(shù)域中的對(duì)應(yīng)點(diǎn)(u,v),可表示為:

其中,τ為紋理映射函數(shù),模型空間點(diǎn)坐標(biāo)(x、y、z)及其在紋理空間的對(duì)應(yīng)坐標(biāo)(u,v)均是已知信息,我們可以先提取三維模型網(wǎng)格的特征頂點(diǎn),并將其映射到紋理貼圖坐標(biāo)系中,獲取感興趣區(qū)域的特征點(diǎn)。這些特征點(diǎn)必然分布在紋理圖像的可見區(qū)域,并且集中在模型細(xì)節(jié)豐富區(qū)域,最后依據(jù)圖像紋理的連續(xù)性,可獲取紋理圖像的關(guān)鍵區(qū)域。

2.2 模型網(wǎng)格和紋理圖像的特征點(diǎn)提取

為方便提取模型網(wǎng)格的幾何信息,可以將模型的基網(wǎng)格作為原形,依據(jù)加入細(xì)節(jié)信息的數(shù)量建立多個(gè)層次,構(gòu)建網(wǎng)格的四叉樹結(jié)構(gòu)。該文采用基于多分支的半正則化方法對(duì)原始模型網(wǎng)格進(jìn)行重構(gòu),構(gòu)建半正則化拓?fù)浣Y(jié)構(gòu)網(wǎng)格。半正則網(wǎng)格的面具備樹形細(xì)分結(jié)構(gòu),邊和邊上的點(diǎn)也同樣是樹形結(jié)構(gòu)。

該文按照c1→c2→…→cn的順序?qū)m合我們需求層次的偏移量小波系數(shù)集合ci(i=1,2,…,n)進(jìn)行如下操作:首先對(duì)當(dāng)前集合,設(shè)閾值。將ci中各個(gè)小波系數(shù)cij(1≤j≤i)依次與閾值ωi比較,若小波系數(shù)大于閾值,則選擇該小波系數(shù)所屬的三維點(diǎn)作為備選特征點(diǎn)。其次檢測(cè)當(dāng)前分辨率下的集合中所有符合條件的特征點(diǎn)數(shù)目,如果數(shù)目大于預(yù)設(shè)值,則將當(dāng)前閾值增大一倍,繼續(xù)求取備選特征點(diǎn),直到特征點(diǎn)數(shù)目小于等于預(yù)設(shè)值,將所有備選點(diǎn)保存為特征點(diǎn)。對(duì)每個(gè)特征點(diǎn)vp,從原始模型網(wǎng)格中提取與特征點(diǎn)空間距離最小的點(diǎn)vm,并根據(jù)原始網(wǎng)格中每個(gè)頂點(diǎn)在紋理空間的映射位置,獲取該點(diǎn)在紋理圖像上的對(duì)應(yīng)像素點(diǎn),即為紋理圖像特征點(diǎn)Pvm。

2.3 紋理圖像感興趣區(qū)域的提取與變換

模型網(wǎng)格特征點(diǎn)提取后,依據(jù)特征點(diǎn)的分布區(qū)域及點(diǎn)之間的內(nèi)在聯(lián)系,便可以提取紋理圖像感興趣區(qū)域。對(duì)于某一感興趣區(qū)域而言,臨近特征點(diǎn)的紋理坐標(biāo)比較接近,因此可以把紋理圖像特征點(diǎn)的坐標(biāo)作為研究對(duì)象,依據(jù)坐標(biāo)的相似程度對(duì)各個(gè)特征點(diǎn)進(jìn)行深入分析,分成若干個(gè)類。將物理或抽象對(duì)象的集合分成由類似對(duì)象組成的多個(gè)類的過程被稱為聚類[3]。通過對(duì)紋理圖像特征點(diǎn)進(jìn)行聚類,可以實(shí)現(xiàn)圖像感興趣區(qū)域的提取,可以對(duì)圖像小波變換域的系數(shù)進(jìn)行進(jìn)一步處理。

依據(jù)獲得的特征點(diǎn)分布情況,我們可以在紋理圖像上進(jìn)行計(jì)算,劃分若干個(gè)包含特征點(diǎn)的矩形選區(qū),對(duì)選區(qū)包含的數(shù)據(jù)點(diǎn)進(jìn)行四叉樹分割,每個(gè)末端節(jié)點(diǎn)內(nèi)包含若干特征點(diǎn),然后定義四叉樹葉子節(jié)點(diǎn)中心的一個(gè)特征點(diǎn)為種子點(diǎn),將獲得n個(gè)種子點(diǎn)標(biāo)記為待聚類的中心。聚類時(shí)的點(diǎn)集不受葉節(jié)點(diǎn)內(nèi)點(diǎn)的限制,重復(fù)計(jì)算每個(gè)點(diǎn)到聚類中心的距離,將點(diǎn)歸類到距離最近的類中去,直到算法的結(jié)果收斂,不能被聚類的點(diǎn)認(rèn)為是噪聲點(diǎn)。提取包含一個(gè)類所有特征點(diǎn)的矩形選區(qū),這些矩形選區(qū)就是我們要提取的紋理圖像感興趣區(qū)域。

對(duì)原圖像進(jìn)行分解,將相鄰像素差值折半后存儲(chǔ)到高頻帶,相鄰像素的均值存儲(chǔ)到低頻帶,這樣就對(duì)紋理圖像完成了一次小波分解。如果需要對(duì)圖像實(shí)施進(jìn)一步小波變換[4],僅需針對(duì)原圖像的低頻區(qū)域操作即可。經(jīng)過小波變換后,可以獲得一幅包含多層次分辨率的圖像。對(duì)原始圖像變換后提取的感興趣區(qū)域進(jìn)行編解碼時(shí),需適當(dāng)調(diào)整區(qū)域內(nèi)部的小波系數(shù)。該文采用最大位移法[5],位移因子f滿足f≥max(Ma),Ma是小波系數(shù)幅值位平面的最大值。經(jīng)位平面提升的區(qū)域內(nèi)小波系數(shù)的最小幅度大于背景小波系數(shù)的最大幅值。以幅值2f為閾值,幅值大于閾值為感興趣區(qū)域小波系數(shù),反之為背景小波系數(shù)。通過該方法可以確定感興趣區(qū)域小波系數(shù),如果將這些系數(shù)右移f位,即可還原感興趣區(qū)域系數(shù)。

2.4 紋理圖像編碼與重建

該文采用嵌入式零樹小波算法對(duì)圖像進(jìn)行編碼,結(jié)合小波圖像多層的數(shù)據(jù)形態(tài),改善小波系數(shù)的組織方法,減少不重要系數(shù)的位運(yùn)算次數(shù),確保重要的小波系數(shù)被優(yōu)先表示和編碼,并盡可能提高相關(guān)的峰值信噪比,以期提高圖像重建質(zhì)量。根據(jù)數(shù)據(jù)先選擇一個(gè)初始閾值T0,T0>,其中Gmax是最大的小波系數(shù),接下來(lái)每次掃描的閾值是前次掃描閾值的一半。然后進(jìn)行主輔掃描,掃描中訪問到的每個(gè)系數(shù)都分類到正顯著(POS)、負(fù)顯著(NEG)、零樹根(ZTR)、孤立零(IZ)4個(gè)符號(hào)中,最終輸出編碼信號(hào)。

運(yùn)用嵌入式零樹小波算法對(duì)變換后獲取的小波系數(shù)進(jìn)行編碼,對(duì)于編碼后的輸出結(jié)果,可以采用Huffman Coding方法二次壓縮,最終生成紋理圖像的二進(jìn)制代碼文件。在三維模型的傳輸過程中,解碼器采用相反的操作過程,利用接收到的小波系數(shù)重建模型紋理圖像。在解碼恢復(fù)圖像的過程中,首先恢復(fù)最重要的系數(shù),再恢復(fù)閾值減半后控制輸出的系數(shù)。

3? 實(shí)驗(yàn)與結(jié)果分析

對(duì)實(shí)驗(yàn)三維模型進(jìn)行壓縮,采用最大位移法對(duì)模型紋理圖像小波系數(shù)進(jìn)行處理后,再對(duì)小波系數(shù)進(jìn)行嵌入式壓縮編碼和熵編碼,模型原始大小為8.21MB,采用上述方法對(duì)模型進(jìn)行壓縮簡(jiǎn)化處理后,獲得的二進(jìn)制壓縮文件大小為0.26MB,壓縮后文件與原始紋理貼圖的壓縮比為3.2%。解碼重建時(shí),解碼器對(duì)紋理圖像感興趣區(qū)域系數(shù)優(yōu)先解碼,獲得重建圖像。各頻帶經(jīng)過位移提升的系數(shù)優(yōu)先傳遞給解碼器,感興趣區(qū)域解碼后,快速獲得了清晰度較高的重建圖像。

解壓前,試驗(yàn)?zāi)P透信d趣區(qū)域小波系數(shù)的二進(jìn)制碼的數(shù)據(jù)量為0.12MB。用不完全解碼的文件重建紋理圖像,對(duì)模型進(jìn)行貼圖映射,獲得三維模型重建圖像。模型紋理圖像分辨率低的部分對(duì)模型表面集合細(xì)節(jié)復(fù)雜部分的影響較小。感興趣區(qū)域分辨率較高,貼圖紋理清晰、精細(xì)。而細(xì)節(jié)較少的次要區(qū)域圖像的紋理分辨率較低。使用壓縮文件中的部分?jǐn)?shù)據(jù)可以快速取得理想的三維模型紋理圖像重建效果。

最后,對(duì)壓縮文件的其余部分進(jìn)行解碼。對(duì)原始紋理貼圖進(jìn)行小波變換時(shí),小波系數(shù)的損失精度限于小數(shù)點(diǎn)后數(shù)位,對(duì)系數(shù)幅值產(chǎn)生的影響可忽略,利用這些系數(shù)可精確還原模型紋理圖像。解碼后生成的紋理圖像與感興趣區(qū)域重建圖像。重建后,三維模型的紋理圖案保持了很高的分辨率,解碼器能準(zhǔn)確的重建原模型的顏色信息。

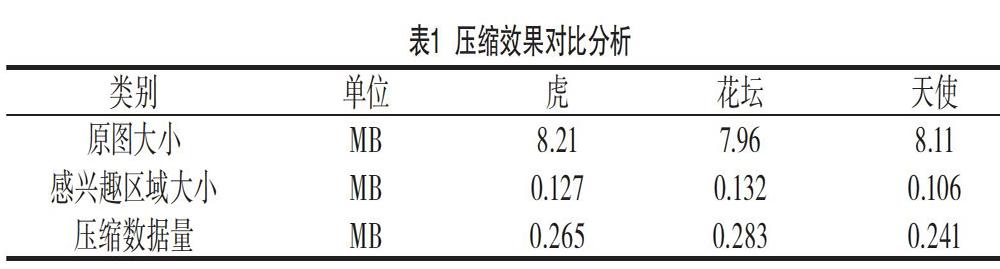

表1中記錄了實(shí)驗(yàn)?zāi)P蛪嚎s前的文件大小;經(jīng)過嵌入式零樹小波算法壓縮后的文件的大小;優(yōu)先傳輸?shù)奈募笮 ?/p>

4? 結(jié)語(yǔ)

該文針對(duì)三維模型紋理圖像的壓縮簡(jiǎn)化過程進(jìn)行了深入研究,提出了基于紋理圖像與網(wǎng)格協(xié)同優(yōu)化的三維模型壓縮算法,構(gòu)建針對(duì)三維模型紋理圖像的編解碼實(shí)驗(yàn)平臺(tái),對(duì)壓縮簡(jiǎn)化算法進(jìn)行驗(yàn)證,取得了較好的實(shí)驗(yàn)效果。該文算法需瀏覽原始模型網(wǎng)格全部頂點(diǎn),依次提取原網(wǎng)格頂點(diǎn)中與每一個(gè)半正則網(wǎng)格特征點(diǎn)距離最近的頂點(diǎn),進(jìn)一步提取紋理圖像特征點(diǎn),巨大的特征點(diǎn)數(shù)量必然會(huì)降低算法的計(jì)算效率。后續(xù)研究會(huì)嘗試建立更合理的數(shù)學(xué)模型,進(jìn)一步提高算法的執(zhí)行效率。

參考文獻(xiàn)

[1] 武艷芳.基于Web3D的產(chǎn)品虛擬展示與用戶定制[J].圖學(xué)學(xué)報(bào),2012(13):85-89.

[2] 馬建平,羅笑男,陳渤,等.面向移動(dòng)終端的三角網(wǎng)格逆細(xì)分壓縮算法[J].軟件學(xué)報(bào),2009(19):2607-2615.

[3] 劉銘,劉秉權(quán),劉涵超,等.面向信息檢索的快速聚類算法[J].計(jì)算機(jī)研究與發(fā)展,2013(7):1452-1463.

[4] 康學(xué)凈.面向移動(dòng)物聯(lián)網(wǎng)應(yīng)用的小波圖像去噪及壓縮方法研究[D].天津理工大學(xué),2012.

[5] 晏秀梅.基于小波和輪廓波變換的感興趣區(qū)域編碼研究[D].中南民族大學(xué),2010.