紅外與可見(jiàn)光圖像融合的空間碎片識(shí)別方法

陶 江,曹云峰,莊麗葵,丁 萌

(1.南京航空航天大學(xué)航天學(xué)院,南京 210016;2.南京航空航天大學(xué)民航學(xué)院,南京 211106)

0 引言

空間碎片是在軌航天器安全運(yùn)行的主要威脅。空間碎片是指處于地球軌道或再入大氣層中無(wú)法正常工作的人造物及其碎片[1],如失效航天器、運(yùn)載火箭發(fā)射階段產(chǎn)生的火箭殘骸、失效航天器碰撞或爆炸產(chǎn)生的碎片均屬于空間碎片。上述空間碎片的持續(xù)碰撞會(huì)進(jìn)一步加劇其數(shù)量增長(zhǎng),從而導(dǎo)致在軌航天器與碎片發(fā)生碰撞的概率進(jìn)一步加大。因此,空間碎片監(jiān)視對(duì)于規(guī)避碰撞風(fēng)險(xiǎn)以確保航天器的安全至關(guān)重要,而其中的關(guān)鍵在于在軌航天器對(duì)空間碎片的精確識(shí)別。識(shí)別結(jié)果又能為下一步對(duì)空間碎片的精確跟蹤、威脅度評(píng)估、碎片清除等技術(shù)提供重要依據(jù)[2]。因此,關(guān)于空間碎片的識(shí)別方法研究意義重大。

由于可見(jiàn)光傳感器具有成本低、體積小、分辨率高等特點(diǎn),被廣泛應(yīng)用于天基空間目標(biāo)監(jiān)視系統(tǒng)中,如美國(guó)天基可見(jiàn)光(Space-Based Visible, SBV)項(xiàng)目[3]、美國(guó)天基空間監(jiān)視(Space-Based Space Surveillance,SBSS)系統(tǒng)[4]、加拿大空間監(jiān)視系統(tǒng)(Canadian Space Surveillance System,CSSS)[5]等。然而,由于天基監(jiān)視系統(tǒng)和太陽(yáng)以及空間碎片之間存在相對(duì)運(yùn)動(dòng),導(dǎo)致可見(jiàn)光相機(jī)在對(duì)空間碎片成像過(guò)程中,空間碎片的光照區(qū)域呈現(xiàn)出非均勻特性[3],即空間碎片的可見(jiàn)區(qū)域會(huì)隨著光源入射角的變化而變化,從而造成圖像源細(xì)節(jié)部分丟失,這對(duì)基于圖像的空間碎片識(shí)別性能帶來(lái)巨大挑戰(zhàn)。而紅外圖像對(duì)光源入射角度不如可見(jiàn)光圖像敏感,并可以記錄物體非可見(jiàn)光部分的熱輻射信息[7],但其所包含目標(biāo)的頻譜信息和反射特性卻不如可見(jiàn)光圖像源豐富,如可見(jiàn)光圖像中包含豐富的邊緣、紋理等細(xì)節(jié)。因此,將目標(biāo)的紅外圖像源和可見(jiàn)光圖像源進(jìn)行深度融合,得到相較于單一圖像源細(xì)節(jié)更加豐富的圖像,將更有利于目標(biāo)識(shí)別[8]。

由于可見(jiàn)光和紅外圖像融合所帶來(lái)的優(yōu)勢(shì),融合技術(shù)被廣泛應(yīng)用于軍事偵查、農(nóng)業(yè)自動(dòng)化、空間探測(cè)等領(lǐng)域。根據(jù)不同的應(yīng)用對(duì)象和應(yīng)用背景,各種紅外和可見(jiàn)光圖像融合方法也相繼被提出。總體上,融合方法主要分為兩大類(lèi):空間域方法,變換域方法。近年來(lái),隨著深度學(xué)習(xí)技術(shù)的迅猛發(fā)展,基于深度學(xué)習(xí)的紅外和可見(jiàn)光融合方法也取得一定的進(jìn)展。相較于傳統(tǒng)的圖像融合方法,基于深度學(xué)習(xí)的圖像融合方法在特征表達(dá)和映射方面呈現(xiàn)出巨大優(yōu)勢(shì)[10]。例如基于卷積稀疏表示的異源圖像融合方法不僅具有較強(qiáng)的細(xì)節(jié)保留能力,還對(duì)異源圖像的誤匹配具有較強(qiáng)的魯棒性[11]。這對(duì)本文的空間碎片的紅外和可見(jiàn)光圖像融合具有重要參考價(jià)值。

在過(guò)去幾十年中,空間碎片識(shí)別方法也得到了廣泛研究,而大多數(shù)方法是基于傳統(tǒng)的人工特征來(lái)訓(xùn)練分類(lèi)器,如K近鄰(k-Nearest Neighbor,KNN)分類(lèi)器[12]、支持向量機(jī)(Support Vector Machine,SVM)[13]等。這些方法的性能?chē)?yán)重受限于人工特征設(shè)計(jì),且人工特征存在對(duì)目標(biāo)描述不夠本質(zhì)的問(wèn)題。基于深度學(xué)習(xí)的空間碎片識(shí)別方法研究較少,目前只有西北工業(yè)大學(xué)提出了基于LeNet-5網(wǎng)絡(luò)的空間碎片深度學(xué)習(xí)識(shí)別模型[14],然而其驗(yàn)證所用空間碎片圖像并未考慮光照因素。本文提出了一種新的基于深度學(xué)習(xí)的空間碎片識(shí)別框架,并采取基于卷積稀疏表示的圖像融合方法提高空間碎片識(shí)別性能。通過(guò)實(shí)驗(yàn)對(duì)比結(jié)果表明,本文的基于卷積稀疏表示的識(shí)別模型性能優(yōu)于基于單一可見(jiàn)光圖像的識(shí)別方法。

1 空間碎片識(shí)別數(shù)據(jù)庫(kù)

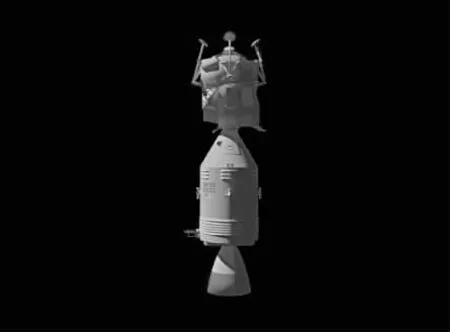

空間碎片數(shù)據(jù)庫(kù)的建立在天基空間目標(biāo)監(jiān)視系統(tǒng)研制開(kāi)發(fā)過(guò)程中起著重要作用,為載荷參數(shù)優(yōu)化確定以及相關(guān)關(guān)鍵技術(shù)驗(yàn)證提供了必要的模擬數(shù)據(jù)源。本文以Apollo-11號(hào)探測(cè)器作為空間目標(biāo)模擬失效航天器這一類(lèi)空間碎片。首先利用三維動(dòng)畫(huà)軟件3DMAX建立失效衛(wèi)星的三維幾何模型,然后添加光源,設(shè)置相機(jī)參數(shù),最后利用VRay渲染器對(duì)幾何模型進(jìn)行渲染,得到不同光源入射角下的空間碎片可見(jiàn)光圖像數(shù)據(jù)庫(kù)。空間碎片可見(jiàn)光圖像仿真流程如圖1所示。

圖1 空間碎片可將光圖像仿真流程Fig.1 Simulation process of visible image of space debris

空間碎片相應(yīng)的紅外圖像數(shù)據(jù)庫(kù)由Vega Prime軟件仿真模擬得到。在仿真紅外圖像時(shí),將空間碎片三維模型在Vega Prime軟件中調(diào)整到和3DMAX同一位置和視角下,則不需經(jīng)過(guò)配準(zhǔn)即可通過(guò)圖像融合得到空間碎片的融合圖像。本文融合圖像數(shù)據(jù)庫(kù)包含100幅融合圖像,圖像大小為640×480。圖2所示為空間碎片在不同光源入射角下的部分融合圖像樣本。

圖2 空間碎片圖像數(shù)據(jù)庫(kù)部分樣本Fig.2 Part of fused image samples of space debris

2 空間碎片識(shí)別

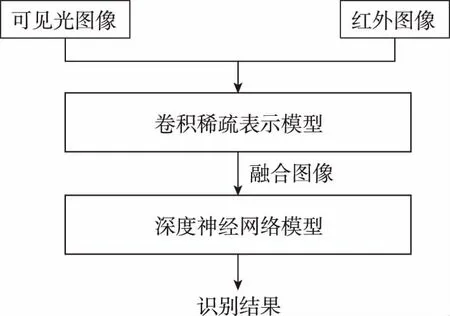

本文提出的空間碎片識(shí)別框架如圖3所示。首先采用基于卷積稀疏表示的方法對(duì)空間碎片的可見(jiàn)光和紅外圖像進(jìn)行融合得到融合圖像;然后基于空間碎片融合圖像訓(xùn)練樣本通過(guò)深度神經(jīng)網(wǎng)絡(luò)模型訓(xùn)練得到空間碎片識(shí)別模型;最后將空間碎片的融合圖像輸入識(shí)別模型便可得到識(shí)別結(jié)果。

圖3 空間碎片識(shí)別框架Fig.3 Scheme of space debris recognition

2.1 基于卷積稀疏表示的圖像融合方法

(1)

其中:gx=[-1 1]和gy=[-1 1]T分別為水平方向和豎直方向的梯度算子。η為正則化參數(shù),本文取其經(jīng)驗(yàn)值5。細(xì)節(jié)層可通過(guò)求解式(2)得到

(2)

(3)

假設(shè)Ck,1∶M(x,y)表示稀疏系數(shù)圖Ck,m在位置(x,y)上的值,則稀疏向量Ck,1∶M(x,y)在每個(gè)像素位置上的l1范數(shù)作為源圖像的活躍度測(cè)量。活躍度Ak(x,y)由式(4)得到

(4)

為使圖像融合過(guò)程對(duì)誤匹配有較強(qiáng)的魯棒性,采取對(duì)活躍度Ak(x,y)取局部窗口平均值的策略重新計(jì)算活躍度,如式(5)所示

(5)

其中,r表示窗口尺寸。對(duì)于紅外可見(jiàn)光圖像融合,需要考慮尺寸較小的細(xì)節(jié)(如邊緣、紋理等),因此r取較小的值更有利,本文取經(jīng)驗(yàn)值3。采取選擇最大策略計(jì)算融合系數(shù)圖

Cf,1∶M(x,y)=Ck*,1∶M(x,y),k*

(6)

然后將所有源圖像分解的細(xì)節(jié)層通過(guò)式(7)進(jìn)行融合重建

(7)

采取平均值策略對(duì)各個(gè)基礎(chǔ)層進(jìn)行融合重建,以減小各個(gè)源圖像在同一位置上的灰度值的不一致性問(wèn)題。則所有源圖像分解的基礎(chǔ)層按式(8)進(jìn)行融合重建

(8)

(9)

圖4所示為空間碎片的紅外和可見(jiàn)光圖像融合結(jié)果。左圖為空間碎片的可見(jiàn)光圖像,可以看出空間碎片右邊未被光線照射的部分基本沒(méi)有紋理等細(xì)節(jié)被反射;中圖為空間碎片的紅外圖像,可以看出其基本不受光照影響,非可見(jiàn)光部分的輻射信息也得到較好呈現(xiàn);右圖為空間碎片的融合圖像,可以看出相較于可見(jiàn)光圖像,將右半部分的不可見(jiàn)部分的紋理保留下來(lái),左邊可見(jiàn)光部分相較于紅外圖像,細(xì)節(jié)紋理也更加豐富。

圖4 空間碎片紅外和可見(jiàn)光圖像融合結(jié)果Fig.4 Visible and infrared image fusion result of space debris

2.2 基于深度卷積神經(jīng)網(wǎng)絡(luò)的空間碎片識(shí)別方法

本文提出的深度神經(jīng)網(wǎng)絡(luò)架構(gòu)(Deep Convolutional Neural Networks,DCNN)基于AlexNet[15]模型。DCNN模型由8個(gè)帶權(quán)重參數(shù)的層構(gòu)成,包含5個(gè)卷積層和3個(gè)全連接層。第1個(gè)卷積層由96個(gè)11×11×3的卷積核構(gòu)成,步長(zhǎng)為4,輸入圖像大小為224×224×3;第2個(gè)卷積層由256個(gè)大小為5×5×48的卷積核構(gòu)成;第3個(gè)卷積層由384個(gè)大小為3×3×256的卷積核構(gòu)成;第4個(gè)卷積層由384個(gè)大小為3×3×192的卷積核構(gòu)成;第5個(gè)卷積層由256個(gè)大小為3×3×192的卷積核構(gòu)成。3個(gè)全連接層每層都由4096個(gè)神經(jīng)元構(gòu)成。最后的全連接層輸出到一個(gè)二分類(lèi)函數(shù)softmax中,最終輸出每幅圖像被分類(lèi)為某種目標(biāo)的概率。采取修正線性單元(Rectified Linear Units,ReLUs)作為每個(gè)卷積層和全連接層的激活函數(shù)。ReLUs的表達(dá)式如下

f(x)=max(0,x)

(10)

其中,x和f(x)分別表示某個(gè)神經(jīng)元的輸入和輸出。第1個(gè)卷積層和第2個(gè)卷積層后分別添加一個(gè)響應(yīng)歸一化層。響應(yīng)歸一化的活躍度由式(11)表示

(11)

由于本文建立的空間碎片圖像數(shù)據(jù)庫(kù)只有1000幅圖像,在訓(xùn)練過(guò)程中可能存在訓(xùn)練數(shù)據(jù)不足導(dǎo)致的過(guò)擬合問(wèn)題。為此,首先對(duì)空間碎片圖像數(shù)據(jù)庫(kù)采取標(biāo)簽保留轉(zhuǎn)換[16]方式進(jìn)行數(shù)據(jù)增強(qiáng)。包括對(duì)圖像進(jìn)行水平翻轉(zhuǎn)和垂直翻轉(zhuǎn)。此外,本文還考慮對(duì)圖像添加亮度變化以增強(qiáng)數(shù)據(jù)。由于在不同光源入射角照射下,空間碎片目標(biāo)本身的可見(jiàn)區(qū)域也隨之變化,從而導(dǎo)致圖像本身的亮度也會(huì)隨之變化。因此,添加亮度變化對(duì)于防止本文光照不均勻環(huán)境下識(shí)別模型的過(guò)擬合有利。此外,由于空間碎片具有翻滾特性,其姿態(tài)也不斷變化,因此,通過(guò)對(duì)空間碎片圖像進(jìn)行旋轉(zhuǎn)來(lái)增強(qiáng)數(shù)據(jù)。首先對(duì)原始100幅空間碎片圖像進(jìn)行水平和垂直翻轉(zhuǎn)得到200幅圖像;然后對(duì)原始圖像數(shù)據(jù)集每幅圖像每隔36°旋轉(zhuǎn)1次,共旋轉(zhuǎn)10次,得到1000幅圖像;通過(guò)Gamma矯正的方式實(shí)現(xiàn)圖像亮度變化,取gamma值由0.1間隔0.1變化到1得到1000幅圖像。圖5所示分別為gamma=0.3和0.8時(shí)的圖像。最終通過(guò)數(shù)據(jù)增強(qiáng)得到2200幅圖像,將其中的1500幅圖像作為訓(xùn)練樣本,700幅作為測(cè)試樣本。

(a) gamma=0.8

(b) gamma=0.3圖5 空間碎片圖像亮度變化Fig.5 Image brightness changes of space debris

3 仿真驗(yàn)證

首先對(duì)基于卷積稀疏表示的圖像融合方法進(jìn)行仿真驗(yàn)證,并與基于稀疏表示(Sparse Representation,SR)的融合方法進(jìn)行對(duì)比。本文對(duì)空間碎片圖像數(shù)據(jù)庫(kù)的100幅源圖像進(jìn)行融合對(duì)比實(shí)驗(yàn),采取主觀評(píng)價(jià)方法和客觀評(píng)價(jià)方法兩種方式對(duì)融合效果進(jìn)行評(píng)估。主觀評(píng)價(jià)方法是指目視評(píng)估法,即直接通過(guò)肉眼對(duì)融合圖像的質(zhì)量進(jìn)行評(píng)估。CSR和SR兩種融合方法的部分結(jié)果如圖6所示。從圖6中可以看出,CSR融合方法比SR方法能從源圖像中提取出更多的細(xì)節(jié)。

(a) SR

(b) CSR圖6 空間碎片圖像融合方法性能對(duì)比Fig.6 Comparison of different image fusion method

此外,選取了四種常用的圖像融合客觀評(píng)價(jià)指標(biāo)對(duì)空間碎片的可見(jiàn)光和紅外圖像融合算法性能進(jìn)行評(píng)估分析。這四種指標(biāo)分別為:熵EN(Entropy),表征圖像包含的信息量和紋理豐富程度,值越大,信息量越多;標(biāo)準(zhǔn)差(Standard Deviation,STD),表征圖像亮度,值越大,圖像對(duì)比度越大,即灰度級(jí)越分散;平均梯度(Average Gradient,AG),表征圖像銳度,值越大,表明圖像信息量越豐富;空間頻率(Spatial Frequency,SF),表征圖像清晰度,值越大,表明圖像紋理和邊緣細(xì)節(jié)越豐富。對(duì)比結(jié)果如表1所示。從表1中可以看出,CSR融合方法的圖像的細(xì)節(jié)豐富程度均優(yōu)于SR融合方法。

表1 圖像融合客觀評(píng)價(jià)指標(biāo)對(duì)比Tab.1 Objective metrics comparison for image fusion methods

經(jīng)試驗(yàn),在小數(shù)據(jù)集上隨機(jī)梯度下降法(Stochastic Gradient Descent,SGD)收斂速度比Adam慢但收斂性能更好,本文的深度神經(jīng)網(wǎng)絡(luò)采用SGD進(jìn)行迭代優(yōu)化。考慮到計(jì)算機(jī)內(nèi)存等性能因素,選取小批量訓(xùn)練樣本,將batch size設(shè)為64。為加快收斂速度并減小SGD震蕩,設(shè)置動(dòng)量(momentum)為0.9。考慮本文的網(wǎng)絡(luò)深度,將權(quán)重衰減(weight decay)為0.0005即可。學(xué)習(xí)率設(shè)為0.001,迭代訓(xùn)練50次后停止訓(xùn)練。由于本文訓(xùn)練集不大,采用dropout正則化來(lái)減輕過(guò)擬合,具有較好的效果,將隱藏層的采樣概率設(shè)為經(jīng)驗(yàn)值0.5。訓(xùn)練過(guò)程如圖7所示,當(dāng)?shù)?0次左右時(shí),訓(xùn)練精度和訓(xùn)練損失均已收斂。收斂較快的原因有三方面:1)空間碎片本身目標(biāo)特性(如紋理、顏色、形狀、大小等)明顯,對(duì)深度特征的學(xué)習(xí)與提取比較有利;2)空間碎片圖像背景相對(duì)簡(jiǎn)單,沒(méi)有其他天體和雜波干擾,這對(duì)于分類(lèi)器的區(qū)分度量也較為有利;3)訓(xùn)練樣本相對(duì)較少,圖像數(shù)據(jù)為單通道圖像且分辨率不高,也減少了訓(xùn)練時(shí)間。對(duì)可見(jiàn)光圖像數(shù)據(jù)和融合圖像數(shù)據(jù)分別進(jìn)行訓(xùn)練得到2個(gè)深度學(xué)習(xí)模型進(jìn)行對(duì)比,二者訓(xùn)練超參數(shù)設(shè)置相同。此外,本文的深度學(xué)習(xí)模型還與文獻(xiàn)[14]提出的LeNet-5模型以及文獻(xiàn)[13]提出的基于SVM的方法進(jìn)行了對(duì)比,對(duì)比實(shí)驗(yàn)結(jié)果如表2所示。從表2中可以看出,本文提出的深度學(xué)習(xí)模型對(duì)空間碎片的識(shí)別性能優(yōu)于LeNet-5模型和基于SVM的方法,識(shí)別正確率可達(dá)99.93%。此外,融合圖像訓(xùn)練得到的識(shí)別模型性能均優(yōu)于單一可見(jiàn)光圖像訓(xùn)練得到的識(shí)別模型。

圖7 深度卷積神經(jīng)網(wǎng)絡(luò)訓(xùn)練過(guò)程Fig.7 Training process of different deep convolutional neural network

表2 空間碎片識(shí)別方法對(duì)比實(shí)驗(yàn)結(jié)果Tab.2 Experiment results comparison of space debris recognition methods

4 結(jié)論

本文針對(duì)暗弱空間環(huán)境中的空間碎片識(shí)別問(wèn)題,提出了一種基于深度卷積神經(jīng)網(wǎng)絡(luò)的空間碎片識(shí)別框架。算法分析與實(shí)驗(yàn)結(jié)果表明:

1)通過(guò)對(duì)空間碎片圖像數(shù)據(jù)集進(jìn)行數(shù)據(jù)增強(qiáng),可減輕訓(xùn)練過(guò)程中的過(guò)擬合現(xiàn)象。本文針對(duì)空間碎片光照區(qū)域不均勻這一特點(diǎn),通過(guò)對(duì)原始圖像數(shù)據(jù)集調(diào)節(jié)亮度來(lái)增強(qiáng)數(shù)據(jù)集,可提高對(duì)光照不均勻條件下的空間碎片識(shí)別性能。

2)在暗弱空間環(huán)境中,通過(guò)對(duì)空間碎片的紅外和可見(jiàn)光圖像進(jìn)行融合,然后再進(jìn)行識(shí)別的方案,相較于基于單一可見(jiàn)光圖像的識(shí)別方案識(shí)別性能更好。這是因?yàn)槿诤蠄D像不僅包含了紅外圖像中的熱輻射特征,也包含了可見(jiàn)光圖像高分辨率的細(xì)節(jié)特性,相較于單一圖像源所含信息量更豐富,這對(duì)于基于深度學(xué)習(xí)的識(shí)別模型是有利的。

3)在實(shí)際空間環(huán)境中,空間碎片圖像背景可能包含太陽(yáng)、行星、地球等其他天體,以及噪聲干擾。而本文圖像數(shù)據(jù)庫(kù)圖像背景為純色背景,在實(shí)際應(yīng)用過(guò)程中可能會(huì)存在識(shí)別性能下降問(wèn)題。因此需要進(jìn)一步完善圖像數(shù)據(jù)庫(kù),添加典型背景噪聲干擾,使其更具通用性。