一種算法對于深層神經網絡訓練速度的提升

劉建 黃嬌潔

摘要:如今深度學習在聲紋識別的領域取得了不錯的成績,其中代表就是卷積神經網絡(CNN),但是傳統的神經網絡訓練過程中需要耗費大量的時間。為了解決這一問題,本文了快速批量歸一化算法(FBN),用以提高網絡的融合速度,縮短培訓時間。卷積神經網絡訓練時需要大量的樣本數據,本文對TIMIT數據集預處理之后進行數據增強處理,防止過擬合發生。實驗結果表明,與沒有FBN的網絡相比,具有FBN的CNN網絡減少了48.04%的額訓練時間。

關鍵詞: 聲紋識別 ;CNN ;FBN;數據增強

中圖分類號:TP393? ? ? ? 文獻標識碼:A

文章編號:1009-3044(2019)24-0207-03

開放科學(資源服務)標識碼(OSID):

An Algorithm for Improving the Training Speed of Deep Neural Networks

LIU Jian1, HUANG Jiao-Jie2

(1.School of Electronic Information , Yangtze University , Jingzhou 434023, China; 2.School of Mechanical Engineering, Hubei University of Technology, Wuhan 430068, China)

Abstract: Today, deep learning has achieved good results in the field of voiceprint recognition. The representative is the Convolutional Neural Network (CNN), but the traditional neural network training process takes a lot of time. In order to solve this problem, this paper proposes a fast batch normalization algorithm (FBN) to improve the network convergence speed and shorten the training time. Convolutional neural network training requires a large amount of sample data. In this paper, the TIMIT data set is preprocessed and data enhancement processing is performed to prevent over-fitting. The experimental results show that compared with the network without FBN, the CNN network with FBN reduces the training time by 48.04%.

Key words: Voiceprint recognition ; CNN ; FBN ; Data enhancement

聲紋識別是一種生物識別技術[1],通過聲紋特征來識別說話人。隨著深度學習的出現,卷積神經網絡(CNN)被廣泛用于語音識別[2-4]。訓練深度神經網絡需要大量的訓練樣本來訓練數百萬個網絡參數[5]來提升精確度,這也就是耗時長的問題。Le Cun 提出數據規范化可能會加速網絡融合[6]。根據批量歸一化(BN)[7]的啟發,提出快速批量歸一化算法(FBN)。本文中使用的CNN-FBN網絡由五個卷積層和三個全連接層組成,在激活功能之前將FBN添加到卷積層,可以有效地加速網絡的收斂。

1 算法描述

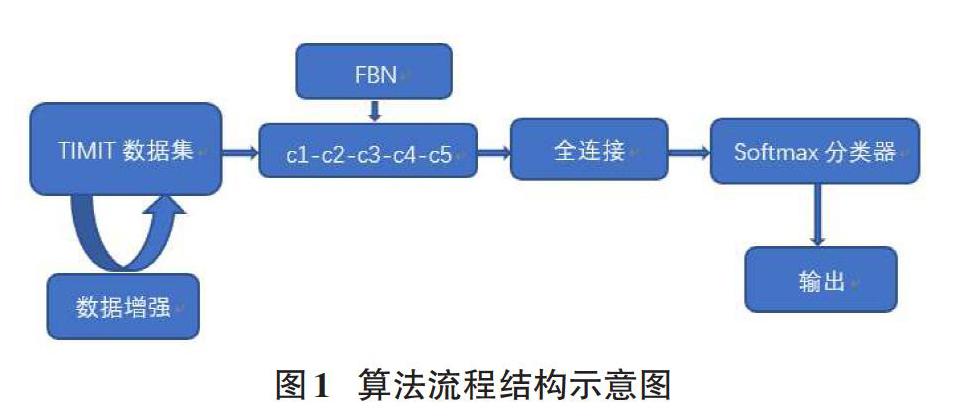

當小樣本聲紋數據集被用于訓練CNN網絡時,由于樣本少,聲紋的識別準確度低。為了提高樣本聲紋識別的性能,我們將源樣本進行數據增強,并在CNN網絡模型激活功能之前,將FBN添加到卷積層中。通過卷積和池化功能,CNN網絡的全連接層集成了所有的聲紋特征映射,達到提高識別率和訓練速度。算法流程如圖1所示:

2 預處理

在使用語言訓練之前,由于語音信號的短時不變性,語音信號[x(t)]首先被分成[x(m,n)](m是幀數,n是幀長度),通過短時傅里葉變換獲得[X(m,n)]。周期圖[Y(m,n)]使用公式[(Ym,n=Xm,n×Xm,n?)] 從[X(m,n)]中獲得,然后取[10×lgY(m,n)]。最后根據時間將m轉換成標度M,根據頻率將n轉換為標度N,并根據[(M,N,10×lgYm,n)]繪制二維語譜圖。語譜圖(b)由原始語音信號(a)產生,如圖2所示:

2.1 數據增強

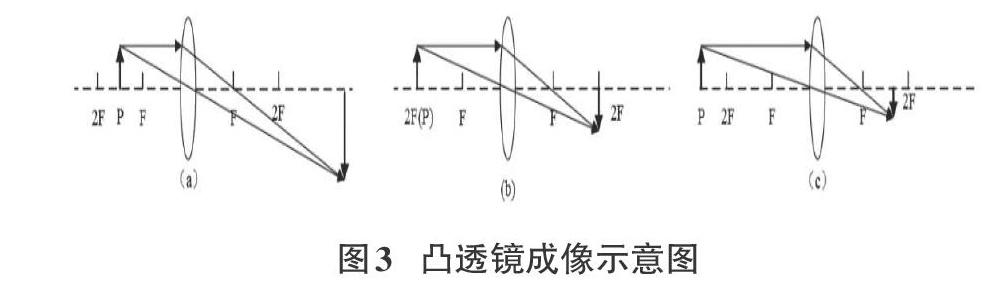

為了防止過擬合,數據增強是一種方法,將一系列的幾何變換添加到原始語譜圖中[8]。它主要有刻度、變焦、移位和噪聲。本文中,我們通過基于凸透鏡成像的數據增強來增加樣本集[9]。

基于凸透鏡成像的方法如下:

(1) 根據凸透鏡成像原理,通過取P點位置L1(F (2) 通過取P位置L2(L2=2F)得到與原始圖像一樣大的圖像,如圖3b所示。 (3) 通過取P位置L3(L3>2F)得到比原始圖像小的圖像,如圖3c所示。 (4) 最后將所有圖像尺度歸一化為227*227作為CNN網絡的輸入。 2.2卷積神經網絡模型 本文中使用CNN-FBN網絡由五個卷積層、三個全連接層組成。在激活功能之前將FBN添加到卷積層。輸入的訓練集維度大小是227*227。卷積層CONV1使用96*11*11*3卷積核來滑動輸入語譜圖像的227*227維,步長為4像素。卷積層CONV2使用256*3*3*96卷積核,卷積層CONV3-CONV4-CONV5依次使用384*3*3*256,384*3*3*384,256*3*3*384卷積核。FC6-FC8中神經元數量依次為4096,4096,200。CONV1-CONV5具有獲得的tezhe特征映射最大池化,全連接層用于對聲紋進行分類。網絡結構圖如圖4所示: 通過前向傳播學習網絡參數。在每個圖層中,輸入要素計算方法如下: [netl+1j=wljxlj+bl+1j]? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ?(1) [xl+1j=s(FBN(netl+1j))]? ? ? ? ? ? ? ? ? ? ? ? ? (2) [xlj]表示第[l]層的第[j]個特征圖,[xl+1j]表示第[(l+1)]層的第[j]個特征圖,[Wl+1j]和[bl+1j]分別是權重矩陣和特征映射[xl+1j]的偏差。[s(*)]是RELU函數,[FBN(*)]是快速批量歸一化算法。其中FBN算法獨立應用于每個激活,本文關注的具有t維輸入的層的特定激活[ek(k∈[1,t])]。FBN算法的詳細情況如下: 小批量:[μ=1si=1sei]? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? (3) 小批量差異:[σ2=1si=1s(ei-μ)2]? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? (4) 標準化值:[gi=ei-μσ]? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ?(5) 更新全球平均值:[μB=1-ξ*μB+ξ*μ]? ? ? ? ? ? ? ? ? ? (6) 更新全局差異:[σB2=1-ζ*σB2+ζ*σ2]? ? ? ? ? ? ? ? ? (7) 更新動量值[ξ]:[ξ=ξ-γ?L?ξ]? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ?(8) 跟新動量值[ζ]:[ζ=ζ- γ?L?ζ]? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? (9) 在FBN算法中,[μB]和[σB2]分別初始化0和1。對于學習率[γ],初始化為0.01。另外,它與[ξ]和[ζ]有關,它們是從批量數據中學習的。所以組合系數[ξ]和[ζ]實現了每次激活的自適應。驗證過程中,采用[μB]和[σB2]的最終訓練結果。通過規范整個網絡的激活,FBN有效解決了內部協變量偏移引起的問題[7]。可以使用更高的學習率而不考慮過擬合的風險,從而加速網絡的訓練。 3 實驗設置 3.1 數據集 本文采用的是美國國家標準技術局的TIMIT數據庫[10]。TIMIT數據集中包含來自美國不同地區的630人(每人10個句子),處理過程中只得到4620張語譜圖,利用數據增強將源數據集擴充到13860張語譜圖,實驗按照3:1的比例分為訓練集和測試集,其中訓練集和測試集大小為10395和3465張語譜圖。 3.2 硬件設施和實驗設置 實驗在ubuntu 1604的操作系統中進行,具有GTX 1060 GPU,內存為8GB,python3.5上的軟件平臺,以及用于跨平臺Qt機器的接口軟件tensorflow1.2.1。CNN、CNN+BN、CNN+FBN的網絡設置如表1所示: 表1中,dropout表示可以防止模型過擬合的技術,其中“--”表示網絡不需要dropout,因為批量標準化可以防止模型過擬合[7]。 3.3 實驗結果與分析 在設置相關參數后進行實驗,訓練過程中三種模型的準確率和損失函數如圖5,圖6所示: 由圖5,圖6分析可知,CNN模型的發展很成熟,所以三種模型的準確率基本都在95%以上。同時由損失函數可以發現具有FBN網絡的模型收斂速度明顯快于其他兩個模型。 3.4 三種模型的收斂速度比較 為了證明模型的收斂速度優越性,本文進行了三種模型訓練的時間對比實驗,使用相同的數據集,對于沒有BN和FBN的深層網絡,基本學習率設置為0.01;對于具有BN和FBN的深層網絡,基本學習率設置為0.05;并且整體網絡損失設置為0.01。以下實驗結果顯示了三次實驗的平均值,如圖7所示: 由圖7可知,CNN+FBN網絡與原始網絡比較,訓練時間減少了48.04%,與CNN+BN比較,訓練時間減少了19.11%。這有兩個原因:首先,快速批量歸一化操作將數據歸一化為零均值和單位方差;其次,總方差和均值分別由小批量方差和均值代替,從而減少了整體計算量。經驗證,將FBN網絡添加到卷積過程中將加速網絡的收斂。 4 總結 本文基于BN算法的啟發,提出了FBN算法, 并結合卷積神經網絡的方法進行了測試, 并且取得了相較好的成績,證實本文提出的模型可以很好地解決深層神經網絡收斂速度的問題。同時網絡模型的準確率也比之傳統的CNN網絡要高。 參考文獻: [1] Islam M A. Frequency domain linear prediction-based robust text-dependent speaker identi?cation. In Proceedings of the International Conference on Innovations in Science, Engineering and Technology (ICISET), Dhaka, Bangladesh, 28–29 October 2016:1–4. [2] Abdel-Hamid O,Mohamed A R,Jiang H. Convolutional neural networks for speech recognition. IEEE/ACM Trans. Audio Speech Lang. Process. 2014, 22, 1533–1545. [3] Huang J T,Li J,Gong Y. An analysis of convolutional neural networks for speech recognition. In Proceedings of the IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), Brisbane, Australia, 19–24 April 2015; pp. 4989–4993. [4] Lukic Y,Vogt C,Dürr O. Speaker identi?cation and clustering using convolutional neural networks. In Proceedings of the IEEE International Workshop on Machine Learning for Signal Processing (MLSP), Salerno, Italy, 13–16 September 2016; pp. 1–6. [5] Oquab M,Bottou L,Laptev, I. Learning and transferring mid-level image representations using convolutional neural networks. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Columbus, OH, USA, 23–28 June 2014; pp. 1717-1724. [6] LeCun Y,Bottou L, Bengio Y,et al. Gradient-based learning applied to document recognition. Proceed. IEEE 1998, 86, 2278-2324. [7] Ioffe S,Szegedy C. Batch normalization: Acceleratingdeep network training by reducing internal covariate shift. In Proceedings of the International Conference Machine Learning (ICML), Lille, France, 6–11 July 2015; pp. 448–456. [8] Dutta T.Dynamic time warping based approach to text-dependent speaker identification using spectrograms.In Proceedings of the 2008 IEEE Congress on Image and Signal Processing? CISP08, Hainan, China, 27–30 March 2008; pp. 354–360. [9] Niu Y F,Zou D S,Niu Y D,et al. A breakthrough in speech emotion recognition using deep retinal convolution neural networks. Comput. Sci. 2017, arXiv:1707.09917. [10] DARPA TIMIT Acoustic-Phonetic Continuous Speech Corpus. Available online: https://catalog.ldc.upenn. edu/ldc93s1 (accessed on 25 December 2017). 【通聯編輯:唐一東】