基于注意力機制的LSTM語音情感主要特征選擇

胡婷婷,馮亞琴,沈凌潔,王蔚

基于注意力機制的LSTM語音情感主要特征選擇

胡婷婷,馮亞琴,沈凌潔,王蔚

(南京師范大學教育科學學院機器學習與認知實驗室,江蘇南京 210097)

傳統的語音情感識別方式采用的語音特征具有數據量大且無關特征多的特點,因此選擇出與情感相關的語音特征具有重要意義。通過提出將注意力機制結合長短時記憶網絡(Long Short Term Memory, LSTM),根據注意力權重進行特征選擇,在兩個數據集上進行了實驗。結果發現:(1) 基于注意力機制的LSTM相比于單獨的LSTM模型,識別率提高了5.4%,可見此算法有效提高了模型的識別效果;(2) 注意力機制是一種有效的特征選擇方法。采用注意力機制選擇出了具有實際物理意義的聲學特征子集,此特征集相比于原有公用特征集在降低了維數的情況下,提高了識別準確率;(3) 根據選擇結果對聲學特征進行分析,發現有聲片段長度特征、無聲片段長度特征、梅爾倒譜系數(Mel-Frequency Cepstral Coefficient, MFCC)、F0基頻等特征與情感識別具有較大相關性。

特征選擇;語音情感識別;深度學習;注意力機制

0 引言

情感計算是人工智能一個重要研究領域,在人機交互中情感交互具有重要意義。語音情感識別是情感計算的一個主要研究課題。在語音情感識別中,選擇與情感相關的語音特征語音是情感識別中重要的工作環節。在情感識別中,研究者們通過各種特征選擇方法去選擇合適的語音情感特征,迄今為止,如何選擇出最好的特征集,仍然沒有一致清晰的意見。

聲學特征是語音識別中最常用的一類特征,語音識別與語音情感識別之間有著不可分割的關聯。因此,從眾多語音聲學特征中尋找與情感相關的特征具有重要研究意義。常用的聲學特征包括音高、音強等韻律特征,頻譜特征以及聲音質量特征。語音特征采用開源工具openSMILE(open-Source Media Interpretation by Large Feature-space Extraction)進行提取,關于具體提取方式與算法詳見文獻[1]。由于語音提取工具的標準化以及語音識別研究的逐步深入,提取的語音特征數量也越來越多。從INTERSPEECH 2009 Emotion Challenge中的聲學特征集的384維[2],到INTERSPEECH 2010 Paralinguistic Challenge中聲學特征集1 582維[3],到INTERSPEECH 2014 Computational Paralinguistics ChallengE中的聲學特征集已達到6 373維[4]。盡管這些特征集在情感識別中取得了不錯的效果,但因其維數過大,若直接使用所有的情感特征建模,由于冗余特征與噪聲數據的存在,會造成計算效率低、計算成本高、建模精度差、特征之間相互影響等問題。因此,為了得到維數較低、效果較好的特征集,需要使用特征選擇算法從所有原始特征中選擇出一個子集。

特征選擇指從已有特征集中選取維數更小的子集,且識別效果不降低或更佳。目前常用的特征選擇方法有以下幾種:對原始數據進行隨機的試探性的特征選擇算法,如順序前進選擇法,其選擇時隨機性較大[5];對原始數據進行數學變換的特征選擇算法,如主成份分析(Principal Component Analysis, PCA)[6]以及線性判別分析(Linear Discriminant Analysis, LDA)等[7],對原始特征空間進行數學變換與降維,導致無法對原始特征進行選擇;還有一些基于機器學習的選擇方法,對原始數據用分類器進行特征選擇。CAO等[8]采用隨機森林的特征選擇算法,選擇出最有效的聲學特征以提高識別效果。姜曉慶等[9]使用二次特征選擇的方法,選擇出具有情感區分性的語音特征子集。KIM[10]使用線性特征選擇方法,結合高斯混合模型以選取聲學特征。陶勇森等[11]提出將信息增益與和聲搜索算法相結合的方法進行語音情感特征選擇,以上研究中結合分類器對特征進行選擇,旨在提高識別準確率。

在聲學特征分析中,WU等[12]得出梅爾倒譜系數(Mel-Frequency Cepstral Coefficient, MFCC)情感識別效果優于音高和能量特征,相比于前兩種特征,持續時長特征識別效果較差。在對語音情感識別的特征重要性分析中,得出F0類識別效果優于持續時長特征,其中不同的應用統計函數得到的特征效果差異也較大,例如F0均值分類效果最佳,而F0最大值位置分類的效果較差[13]。在情感維度分類識別中,研究得到音質特征與情感的愉悅度有密切關系,韻律特征與情感激活度相關性較大的結論[14]。因此,選擇出一致認同的,具有物理意義的,與情感具有較大關聯性的聲學特征,對于語音情感識別具有重要意義。

注意力機制最早提出于手寫字生成,后來逐漸運用于多個領域。現今在機器翻譯、圖像標題生成、語音識別、自然語言處理多領域得到成功運用[15-18]。在語音識別中,注意力機制被用來選擇出基于時序的幀水平的特征中,整個時間序列上一句話的某一幀或者某些幀的片段在整句話中的重要程度[19]。本研究受此啟發,采用注意力機制在句子水平的全局特征中選擇出具有重要作用的特征種類,將注意力機制結合長短時記憶網絡(Long Short Term Memory, LSTM)作為一種特征選擇方式。基于注意力矩陣參數選擇出重要的聲學情感特征并對其進行分析。同時,通過注意力機制改進深度學習中的LSTM識別算法,以提高情感識別效果。

1 基于注意力機制的LSTM情感識別模型

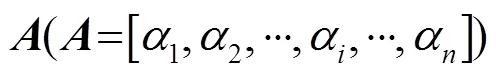

1.1 注意力機制

1.2 LSTM模型

循環神經網絡(Recursive Neural Network, RNN)是包含循環的網絡,循環可以使得信息可以從當前步傳遞到下一步LSTM結構,允許信息的持久化。然而,相關信息和當前預測位置之間的間隔不斷增大時,RNN會喪失連接遠距離信息的學習能力。LSTM由HOCHREITER及SCHMIDHUBER提出,并被GRAVES進行了改良和推廣,是一種RNN特殊的類型,可以學習長期依賴信息[20]。

1.3 基于注意力機制的LSTM

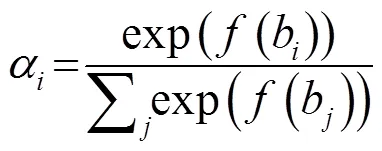

采用LSTM結合注意力機制的方式,去訓練語音聲學特征,建立情感識別模型。情感識別模型結構如下圖1所示。

圖1 結合注意力機制的LSTM模型結構圖

2 語音特征介紹

本研究采用開源軟件openSMILE進行幀水平的低層次基礎聲學特征的提取,應用全局統計函數得到句子水平全局特征[1]。比如F0基頻特征,通過openSMILE軟件,提取每一幀的特征,之后使用均值、方差、百分位數等函數進行全局統計,得到本研究中使用的全局特征。本研究參考之前研究中提出的GeMAPs特征集,提取出相關的88個聲學特征。以下內容對Gemaps特征集中包含的特征做一個簡單介紹,詳細內容參見文獻[21]。

GeMAPs聲學特征集是用于語音情感計算的常用特征集之一。采用其擴展特征集包含以下88個聲學特征參數。特征集中包含以下18個低水平描述特征(Low Level Descriptors, LLDs)特征參數:

(1) 頻率相關參數:F0基頻,頻率微擾(jitter),振峰頻率(第一、第二、第三共振峰的中心頻率),共振峰(第一共振峰的帶寬)。

(3) 頻譜(平衡)參數:Alpha比,Hammarberg指數,頻譜斜率(0~500 Hz和500~1 500 Hz),第一、第二、第三共振峰相關能量是H1、H2、H3,第一、第二諧波差值(H1-H2),第一、第三諧波差值(H1-H3)。

以上所有的18個LLDs都用3幀長對稱移動平均濾波器在時間上進行平滑處理。在音高、振幅微擾和頻率微擾3項特征上,只在有聲片段進行平滑處理,對于從無聲到有聲片段之間的轉換區域不做平滑處理。算術均值和變異系數(算術均值標準化后的標準差,變異系數)作為統計函數應用在所有的18個LLDs上,產生了36個特征參數。對于響度和音高額外應用了以下8個統計函數:20,50和80的百分位數,以及20~80范圍的百分位數,信號部分上升、下降的斜率的均值和標準差。所有的函數都應用在有聲音的區域(非0的F0基頻區域),一共產生了52個參數。

此外,在無聲片段的Alpha比,Hammarberg指數,頻譜斜率(0~500 Hz和500~1 500 Hz)的算術平均數這4個參數以及以下介紹的6個時間特征也被加入特征中,這6個時間特征是:

(4) 時間特征:響度峰值的比率,連續聲音區域(F0>0)的平均長度和標準差,無聲區域(F0=0,近似停頓)的平均長度和標準差,每秒鐘連續發聲區域的數目(偽音節率)。

之前的研究證明,倒譜系數在情感狀態模型中具有重要作用。因此添加了以下7個LLDs成為我們擴展的特征集:

(5) 倒譜特征參數

頻譜參數:梅爾頻率倒譜系數1~4,頻譜流量。

頻率相關參數:第二、第三共振峰的帶寬。

對這7個LLDs在所有的部分(包括無聲和有聲部分)應用算術均值和變異系數,對共振峰帶寬參數(僅在有聲部分應用統計函數),得到14個參數。加上頻譜流量只在無聲部分的算術均值,以及頻譜流量和MFCC 1-4在有聲部分的算術均值和變異系數,得到11個參數。此外,等效聲級也被包括進來,共得到額外的26個參數,從而得到共88個參數的擴展的eGeMAPS(Extend Geneva Minimaliastic Acoustic Parameter set)特征集。

3 情感識別與特征選擇實驗

3.1 數據集介紹

數據是進行研究的基礎,良好的實驗數據對實驗結果有著直接的影響。本研究采用由美國南加州大學SAIL實驗室收集的IEMOCAP(interactive emotional dyadic motion capture database)公用英文數據集中語音數據進行語音情感特征選擇與情感識別[22],作為本研究的數據集一,進行模型訓練與特征選擇。使用The eNTERFACE’05 Audio-Visual Emotion Database數據集作為數據集二,用于驗證我們選取的聲學特征子集在情感識別中的適用性與普遍性[23]。

本研究采用IEMOCAP數據集中語音數據提取情感識別中的語音聲學特征。IEMOCAP數據集由5男5女在錄音室進行錄制,每個句子樣本對應一個情感標簽,情感在離散方式上標注為“憤怒”“悲傷”“開心”“厭惡”“恐懼”“驚訝”“沮喪”“激動”“中性情感”九類情感。在之前的研究中,在情感聚類識別時,由于激動和開心表現相似,區分不明顯。因此將其處理為一類情感,合并為“開心”[24]。最終本研究參考一種常用情感識別方式,選取“中性”“憤怒”“開心”“悲傷”4類情感,共5 531個樣本進行模型訓練。eNTERFACE’05數據集被設計用于測試和評價語音與視頻中情感識別任務。數據集由來自14個不同國家,共44個說話人進行錄制。每個說話人根據要求錄制“憤怒”“沮喪”“害怕”“開心”“悲傷”“驚訝”6種情感的句子,每種情感包含5個句子。本研究選取“憤怒”“開心”“悲傷”3種情感,共630個樣本來驗證選取的情感特征的有效性。

3.2 基于注意力機制LSTM的情感識別

使用數據集一中的5 531句聲音數據,作為實驗樣本。根據eGeMAPs特征集,使用openSMILE工具對每句話提取出88維聲學特征。每句話對應的手工情感標注作為訓練標簽。采用1.3節介紹的基于注意力機制的LSTM模型,將88維的聲音特征作為輸入序列輸入到該模型中,對該模型進行訓練,模型輸出每句語音對應的情感的類別。采用十折交叉方式驗證模型預測效果,使用樣本的9/10進行訓練,1/10進行測試,進行10輪訓練與預測,對10次的預測結果進行平均取值。在數據集一中的預測結果如表1所示,準確率(Accuracy, ACC)和不加權平均召回率(Unweighted Average Recall, UAR)分別達到了0.570和0.582。沒有注意力機制的LSTM分類結果ACC和UAR分別為0.516和0.529。因此通過添加注意力機制,ACC和UAR分別提高了5.4%和5.3%,證明通過注意力機制改進的情感識別模型,有效提高了情感識別準確率。

表1 基于注意力機制LSTM與LSTM模型識別準確率對比

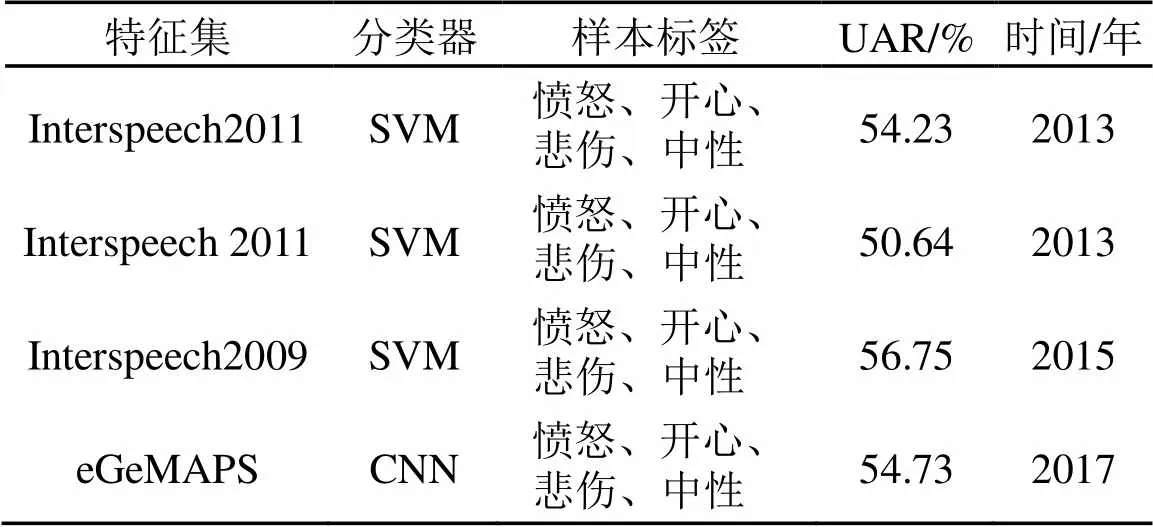

在之前的基于IEMOCAP數據集的研究中,使用四類情感5531個樣本,采用不同的分類器、特征集、樣本得到不同的識別結果[25-28],如表2所示。與之前的實驗結果相比,本研究的實驗結果得到了較高的識別準確率。可見,本研究實驗結果表現較好。

表2 基于IEMOCAP數據集研究的識別率

3.3 基于注意力機制的特征選擇

特征選擇一直是機器學習中至關重要的一個步驟,算法改進可以提高識別率,特征的好壞決定了準確率的高低。因此在語音情感識別中選取對情感識別影響力大的特征具有重要意義。選擇具有實際可以解釋的、具有物理意義的聲學特征對特征選擇起到至關重要的作用。選擇出重要的特征后,使得后續的研究者們可以參考與借鑒。本研究采用注意力機制進行特征選擇。

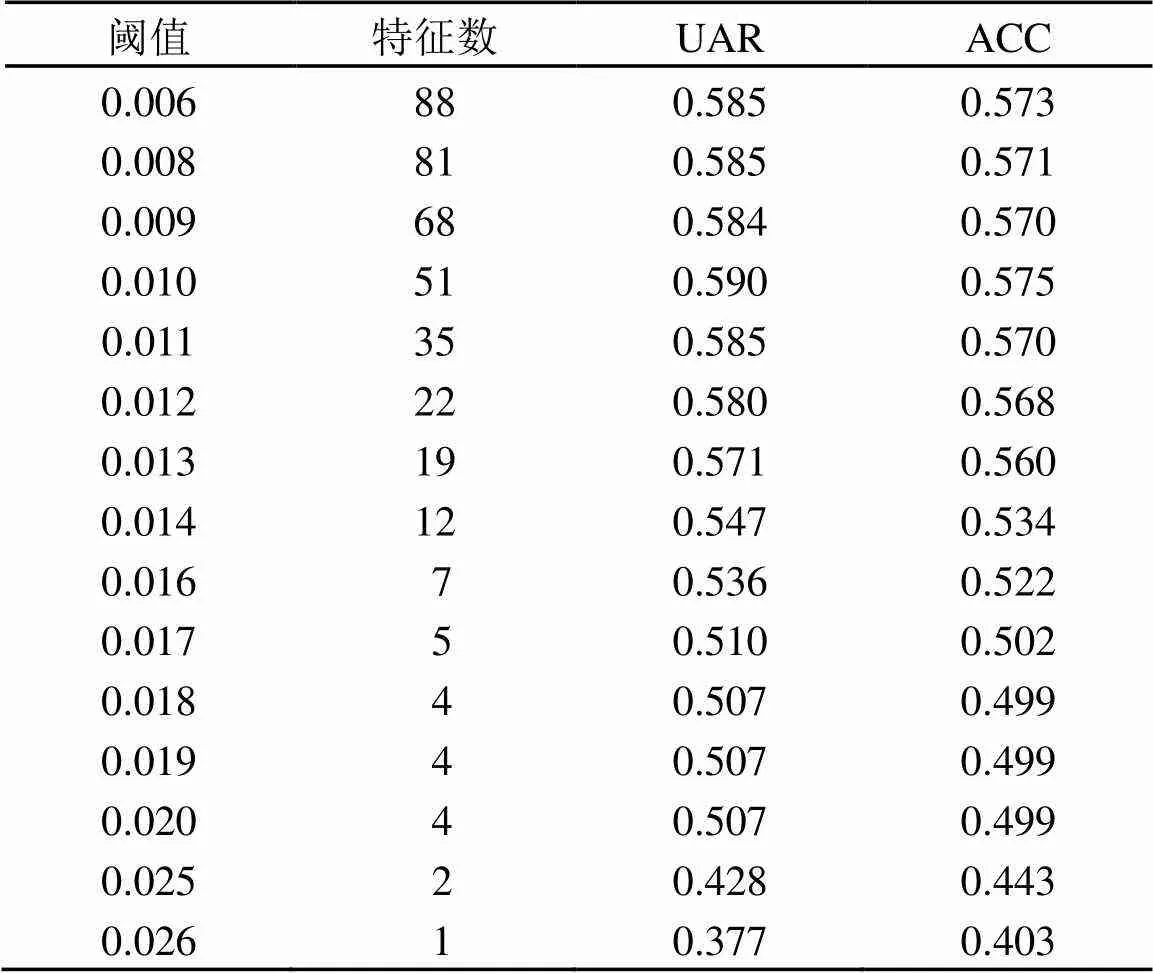

在注意力機制中,得到注意力參數矩陣,對所有參數進行求和后進行標準化(標準化是數據處理中,類似于歸一化的預處理方式,將數據處理為均值為0,標準差為1的一組數據),得到每個特征的在情感識別模型中的概率。本研究使用IEMOCAP中的5 531個樣本,提取出88個聲學特征,對識別模型訓練進行特征選擇,使用十折交叉驗證的方式對模型進行評估,根據注意力矩陣中每個特征對應的注意力參數,選擇出對情感識別作用較大的特征。根據閾值選擇出的特征數與識別率如表3所示,根據特征注意力參數,選擇出參數大于0.08的特征有81個,大于0.01的有51個,大于0.16的只有7個。

表3 根據閾值選擇出的特征數與識別率

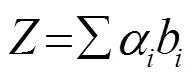

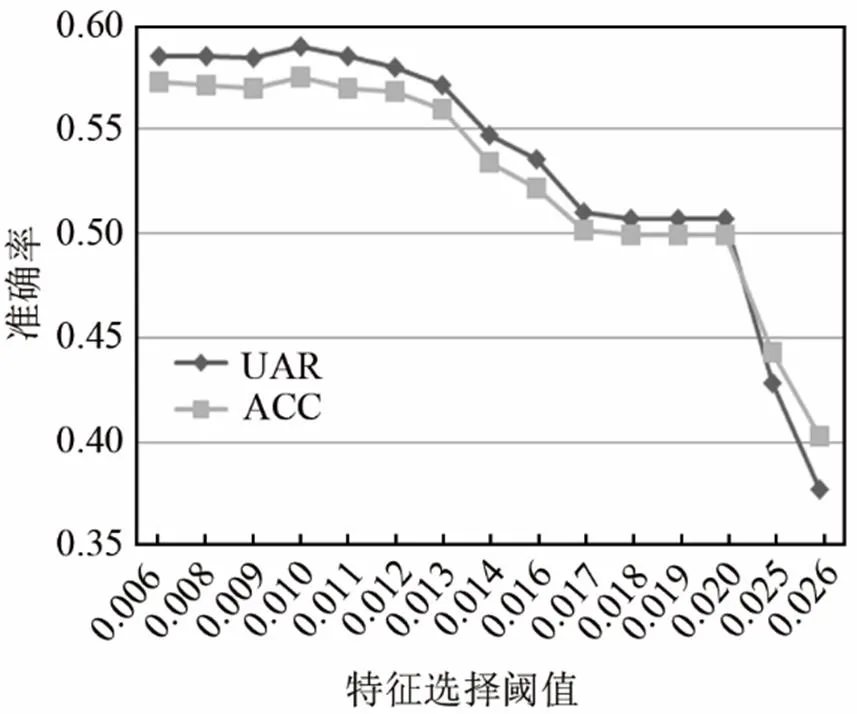

圖2為不同數量特征分類的結果。由圖2可知,在選擇閾值設置為0.01時選擇出的51個特征取得了較高的識別效果,因此選取前51個特征作為本次研究的情感特征的子特征集。

圖2 不同特征數的分類結果

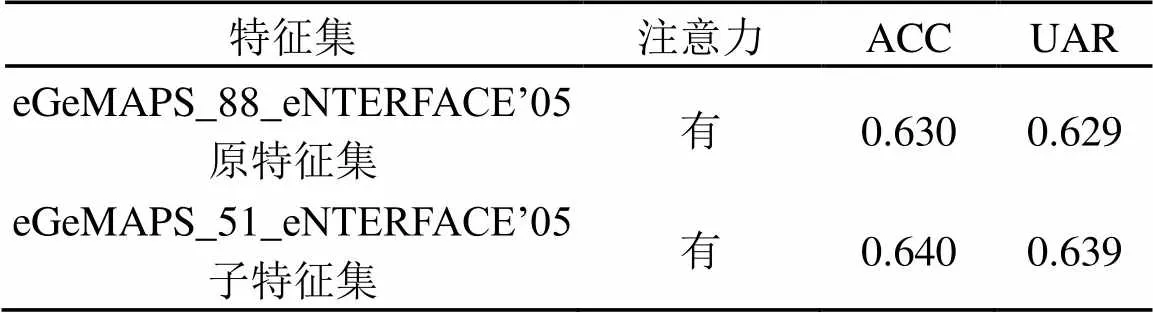

為了對此子特征集的有效性進行驗證,在eNTERFACE’05中使用此子特征集進行驗證。由于IEMOCAP數據樣本數多,eNTERFACE’05樣本數相比較少,因此IEMOCAP作為對模型進行訓練與特征選擇的主要實驗數據集,eNTERFACE’05作為驗證數據集。在eNTERFACE’05數據集中使用選擇出的子特征集對基于注意力機制的LSTM模型進行訓練,發現本次選取的子特征集在驗證數據集上也表現良好,如表4所示,相比于選取之前的88維特征集,在降低了維數的情況下,識別準確率有小幅度提升。有效驗證了選取的子特征集不僅在選取的原數據集上表現良好,在其他數據集也表現良好,證明了此子特征集的有效性。

表4 子特征集在驗證集eNTERFACE’05上的表現

為了更好地比較兩個數據集間的異同,補充了兩數據集之間遷移學習的實驗。使用數據集一的樣本數據與標簽訓練模型,使用本研究選擇后的51維特征集,采用基于注意力機制的LSTM分類器,對模型進行訓練與預測,并將訓練好的模型進行保存后,再使用數據二的數據來進行預測,將數據集一訓練好的模型直接導入使用,分析數據集一訓練好的模型在情感識別中是否具有可遷移性與通用性。由于數據集二中不含中性情感樣本,因此對于中性情感標簽在模型導入使用時進行補0處理。實驗結果發現,數據集二使用該模型預測的ACC為0.403,UAR為0.403。可以分析,數據集一與數據集二在情感表達上具有一定的相似性。

3.4 聲學特征重要性分析

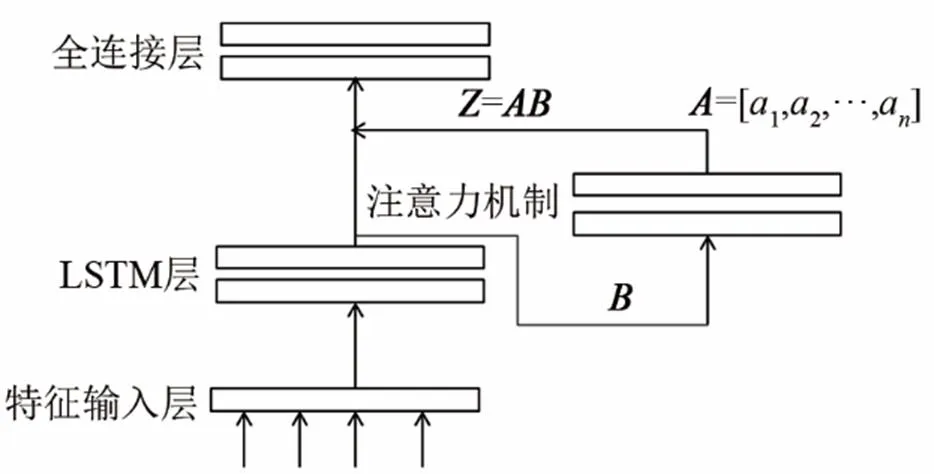

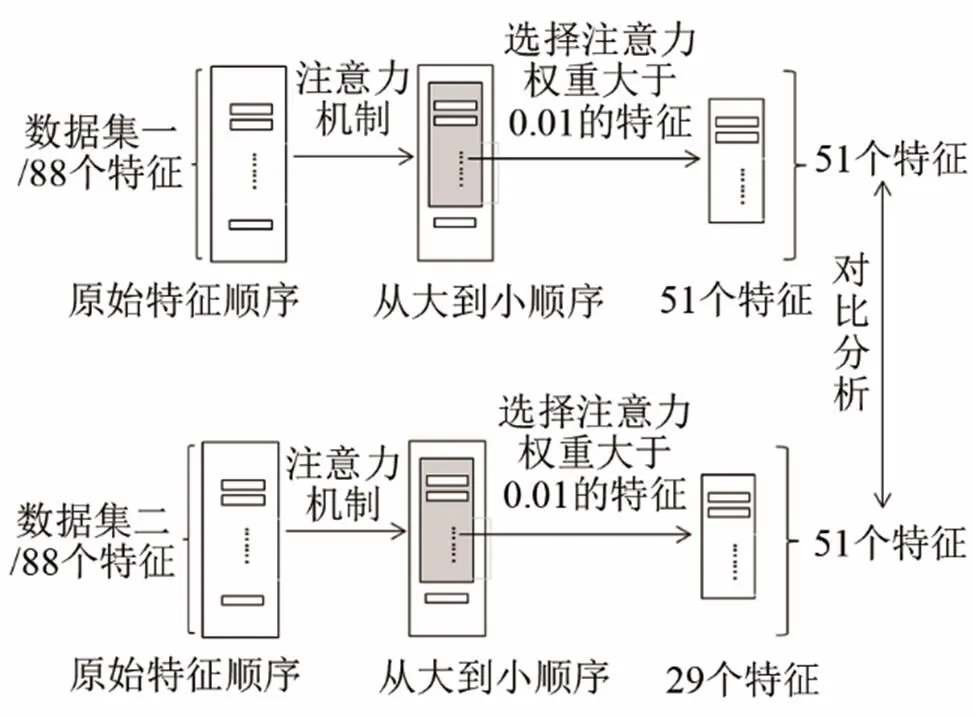

在對特征進行重要性排序時,基于注意力機制的特征選擇步驟如圖3所示。

首先對IEMOCAP數據集中樣本數據提取的88維特征使用基于注意力機制的LSTM進行訓練,再根據注意力參數進行排序,得到每個特征的重要性排序。之后eNTERFACE’05數據集使用基于注意力機制的LSTM再進行訓練,根據注意力參數對特征進行重要性排序。比較兩個數據集選取出的重要情感特征是否具有一致性,驗證特征在識別中的穩定性與普遍性。

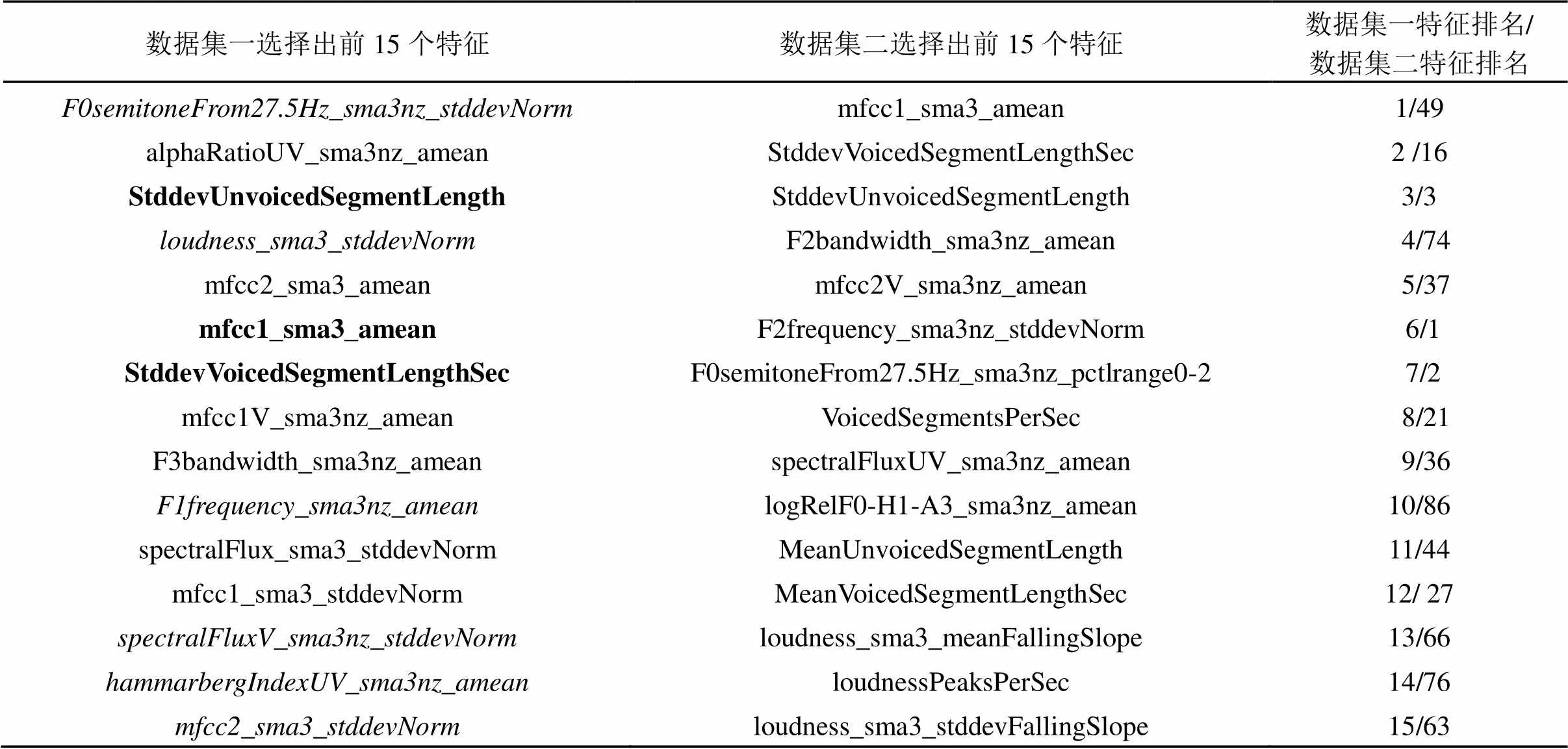

表5列出了根據注意力機制計算出的特征重要性排序。表5中的第一列表示由IEMOCAP數據選擇出的重要特征,第二列表示eNTERFACE’05驗證集數據選擇出的排序靠前的特征的名稱,第三列是其特征在兩個數據集中的排名。由于篇幅限制只列出了前15個特征。

圖3 基于注意力機制的特征選擇步驟

分析發現,在數據集一中,F0排名最高,只用一個音高特征F0_stddevNorm進行預測時,準確率已經能到達0.403,可見其在語音情感識別中的重要性,然而在數據集二中,該特征則表現一般。可見在不同數據集中,由于說話人、環境不同等原因會造成特征的差異。在表5中對兩個數據集中表現差異大的特征進行了斜體標注,兩個數據集中都表現良好的進行了粗體標注以方便分析。

其中,無聲片段的長度(Stddev_Unvoiced Segment Length)、有聲片段的長度(Stddev_Voiced Segment Length)、MFCC1均值這3個特征在兩個數據集中的表現均很好,而且保持穩定。基于本研究的分析中,這3種特征與情感之間具有很大關聯,在情感識別中起較大作用。而之前研究中得出的結論為F0基頻、響度特征優于持續時長的表現,本研究中時長特征表現良好,且在兩個數據集中表現穩定。

另外,無聲部分Alpha比表現良好,與F0特征兩者結合在數據集一中識別準確率可達0.443,且在數據集二中也表現良好。使用標準差統計的無聲區域長度,以及響度的標準差參數在數據集一上也表現很好,以上4個特征已經可以達到0.499的準確率。其中響度的標準差參數、F1頻率均值、有聲片段頻譜流量、無聲部分的hammarberg指數,MFCC2_stddev這幾個特征在兩個數據集上的表現差異很大,在數據集一中表現很好,而在數據集二中表現較差。

對于特征的統計函數進行分析發現,使用算術均值和變異系數統計的特征表現優于使用百分位數或者斜率等函數統計的同類特征。更多信息我們可以從表5中獲得,不再做詳細描述。

基于選取的前50個聲學特征可以分析出,F0基頻、Alpha比、Hammarberg指數、等效聲級、響度斜率相關特征、MFCC和頻譜流量類的倒譜特征、jitter、shimmer、振峰頻率、頻譜斜率、連續聲音區域和無聲區域的平均長度和標準差、偽音節率等特征在數據集一中表現良好。

表5 根據注意力參數的特征排序

注:表中,amean:算術平均;stddevNorm:變異系數;sma3:三幀長對稱移動平均濾波器;nz:非零F0;V:有聲;UV:無聲表中斜體標注特征表示兩個數據集中差異較大,黑體標注特征表示該特征在兩個數據集中均表現良好

相比以上的特征來說,共振峰帶寬,第一、第二、第三共振峰的中心頻率的頻譜諧波峰值能量和F0頻譜峰值能量的比、諧波差異、諧噪比,以及部分響度的參數等特征在識別中注意力參數較小,識別力較差。

4 結論

注意力機制是通過計算特征的注意力參數,將其與深度學習模型結合訓練的一種方式。本研究通過加入注意力機制,改進了LSTM模型,有效提高語音情感識別準確率,相比于單LSTM模型,準確率提高了5.4%。

使用注意力機制進行特征選擇是一種有效的特征選擇方法。基于此方式選取了重要的聲學特征,并且根據注意力參數,對特征進行重要性排序。本研究基于原有通用的88位特征集的基礎上,選取了51維的子特征集,在降低了特征維數的情況下,取得更好的識別效果,在數據集一、二上均取得良好的結果。

對特征進行分析發現,無聲片段的長度、有聲片段的長度、MFCC1均值三個特征在訓練數據集與驗證數據集中均表現良好,證明此3個特征對于情感識別的重要作用。F0、alpha比、響度特征等與情感也具有較強關聯性,在情感識別中起重要作用。算術均值與變異系數相比于其他百分位、斜率等統計函數更加具有表現力。

采用了兩個數據集進行了模型的訓練與特征的選擇。分別使用注意力參數選擇靠前的特征,發現重要的特征雖然在兩次選擇時,參數會有小幅波動,但是波動范圍較小,說明重要的特征即使在不同數據集中,仍然保持穩定的表現,情感識別效果良好。

5 討論

本研究采用兩個英文數據集進行情感識別與特征選擇實驗,由于數據集的采集方式、說話人、環境等因素不同,會對特征選擇的結果產生一定程度的影響,產生不一致的結論。因此克服數據不同帶來的影響,從而獲得更一般性的結論至關重要。本研究為了克服數據的影響,在大樣本的數據集上進行特征選擇實驗,在小樣本的數據集上進行驗證。為了消除數據產生的影響,對小樣本數據集也進行了選擇實驗,對實驗結果進行對比分析,以求獲得一般性的可靠結論。但是由于數據集二中包含的樣本與數據集一中有所不同,沒有包含中性情感,對結果會造成一定程度的影響。在未來的工作中,希望能夠發現或者制造出包含相同情感種類、相同語言并且樣本數量較多的數據集以供使用。

當前語音情感識別的研究中,由于深度學習對數據量的要求增加,數據量越大模型的訓練效果越可靠。但是由于單一的數據集樣本量有一定限制,因此多數據集、跨數據集是研究的必然趨勢。在未來的研究中,可以進行跨庫、跨語言以及多語言的情感識別實驗,進行更多深層次關于遷移學習在情感識別中的研究。分析不同語言、不同文化在表達情感時的共同點,分析語音中包含的信息特定情感之間關聯性。

[1] EYBEN F. Opensmile: the munich versatile and fast open-source audio feature extractor[C]//Firenze, Italy: MM '10 Proceedings of the 18th ACM international conference on Multimedia, 2010: 1459-1462.

[2] SCHULLER B, STEIDL S, BATLINER A. The interspeech 2009 emotion challenge[C]//Brighton,UK:Interspeech(2009), ISCA, 2009: 312–315.

[3] SCHULLER B, STEIDL S, BATLINER A, et al. The interspeech 2010 paralinguistic challenge[C]//Chiba, Japan: Conference of the International Speech Communication Association, 2010: 2794-2797.

[4] SCHULLER B, STEIDL S, BATLINER A, et al. The interspeech 2014 computational paralinguistics challenge: cognitive & physical load[C]//Singapore:Proc. Interspeech 2014, 2014: 427-431.

[5] PéREZ-ESPINOSA H, REYES-GARCíA C A, VILLASE?OR-PINEDA L. Acoustic feature selection and classification of emotions in speech using a 3D continuous emotion model[J]. Biomedical Signal Processing & Control(S1746-8094), 2012, 7(1): 79-87.

[6] SONG P, HENGW Z, LIANG R. Speech emotion recognition based on sparse transfer learning method[J]. Ieice Transactions on Information & Systems(S1745-1361) , 2015, 98(7): 1409-1412.

[7] ZHANG X, ZHA C, XU X, et al. Speech emotion recognition based on LDA+kernel-KNNFLC[J]. Journal of Southeast University (S1003 -7985), 2015, 45(1): 5-11.

[8] CAO W H, XU J P, LIU Z T. Speaker-independent Speech Emotion Recognition Based on Random Forest Feature Selection Algorithm[C]//Dalian, China: Proceedings of the 36th Chinese control conference, 2017: 10995-10998.

[9] 姜曉慶, 夏克文, 林永良. 使用二次特征選擇及核融合的語音情感識別[J]. 計算機工程與應用, 2017, 53(3): 7-11.

JIANG Xiaoqing, XIA Kewen , LIN Yongliang. Speech emotion recognition using secondary feature selection and kernel fusion[J]. Computer Engineering and Applications, 2017, 53(3): 7-11.

[10] KIM W G. Speech emotion recognition using feature selection and fusion method[J]. Transactions of the Korean Institute of Electrical Engineers(S1975-8359), 2017, 66(8): 1265-1271.

[11] 陶勇森, 王坤俠, 楊靜. 融合信息增益與和聲搜索的語音情感特征選擇[J]. 小型微型計算機系統, 2017, 38(5): 1164-1168.

TAO Yongsen , WANG Kunxia , YANG Jing. Hybridizing information gain and harmony search for feature selection on speech emotion[J]. Journal of Chinese Computer Systems, 2017, 38(5): 1164-1168.

[12] WU D, PARSONS T D, NARAYANAN S S. Acoustic feature analysis in speech emotion primitives estimation[C]//Makuhari, Chiba, Japan: Conference of the International Speech Communication Association, 2010: 785-788.

[13] TAO J, KANG Y. Features importance analysis for emotional speech classification[C]//Berlin: International Conference on Affective Computing & Intelligent Interaction, 2005, 3784: 449-457.

[14] 黃程韋, 趙艷, 金赟. 實用語音情感的特征分析與識別的研究[J]. 電子與信息學報, 2011, 33(1): 112-116.

HUANG Chengwei , ZHAO Yan , JIN Yun. A sstudy on feature analysis and recognition of practical speech emotion[J]. Journal of Electronics & Information Technology, 2011, 33(1): 112-116.

[15] BAHDANAU D, CHO K, BENGIO Y. Neural machine translation by jointly learning to align and translate[J]. Computer Science, 2014, arXiv: 1409.0473.

[16] XU K, BA J, KIROS R, et al. Show, attend and tell: Neural image caption generation with visual attention[C]//ICML, 2015, 14: 77–81.

[17] CHOROWSKI J K, BAHDANAU D, SERDYUK D, et al. Attention-based models for speech recognition[J]. Computer Science (S2333-9721), 2015, 10(4): 429-439.

[18] ADEL H, SCHUTZE H. Exploring different dimensions of attention for uncertainty detection[C]//Valencia, Spain: Proceedings of the 15th Conference of the European Chapter of the Association for Computational Linguistics, 2016: 22-34.

[19] MIRSAMADI S, BARSOUM E, ZHANG C. Automatic speech emotion recognition using recurrent neural networks with local attention[C]//New Orleans, LA, USA: IEEE International Conference on Acoustics , 2017: 2227-2231.

[20] GREFF K, SRIVASTAVA R K, KOUTNIK J, et al. LSTM: a search space odyssey[J]. IEEE Transactions on Neural Networks & Learning Systems(S2162-237X), 2015, 28(10): 2222-2232.

[21] EYBE F, SCHERER K, TRUONG K, et al. The geneva minimalistic acoustic parameter set (gemaps) for voice research and affective computing[J]. IEEE Transactions on Affective Computing(S 1949-3045), 2016, 7(2): 190-202.

[22] BUSSO C, BULUT M, LEE C C. IEMOCAP: interactive emotional dyadic motion capture database[J]. LanguageResources&Evaluation(S1574-020X), 2008, 42(4): 335-359.

[23] MARTIN O, KOTSIA I, MACQ B. The eNTERFACE'05 audio-visual emotion database[C]//Atlanta, GA, USA: Conference on Data Engineering Workshops, 2006: 8-12.

[24] METALLINOU A, WOLLMER M, EYBEN F, et al. Context-sensitive learning for enhanced audiovisual emotion classification[J]. IEEE Transactions on Affective Computing(S1949- 3045), 2012, 3(2): 184-198.

[25] MARIOORYAD S, BUSSO C. Compensating for speaker or lexical variabilities in speech for emotion recognition[J]. Speech Communication(S0167-6393), 2014, 57(1): 1-12.

[26] MARIOORYAD S, BUSSO C. Exploring cross-modality affective reactions for audiovisual emotion recognition[J]. IEEE Transactions on Affective Computing(S1949-3045), 2013, 4(2): 183-196.

[27] GAMAGE K W, SETHU V, LE P N, et al. An i-vector GPLDA system for speech based emotion recognition[C]//Asia-Pacific Signal and Information Processing Association Summit and Conference. IEEE, 2015: 289-292.

[28] NEUMANN M, VU N T. Attentive convolutional neural network based speech emotion recognition: a study on the impact of input features, signal length, and acted speech[C]//Stockholm, Sweden :Interspeech, 2017: 1263-1267.

The salient feature selection by attention mechanism based LSTM in speech emotion recognition

HU Ting-ting, FENG Ya-qin, SHEN Ling-jie, WANG Wei

(Machine learning and cognition lab, School of Education Science, Nanjing Normal University, Nanjing 210097, Jiangsu, China)

The traditional approaches to speech emotion recognition use the acoustic features characterized by large amount of data and redundancy. So, it is of great significance to choose the important phonetic features related to emotion. In this study, the attention mechanism is combined with Long Short Term Memory (LSTM) to conduct feature selection according to the attention parameters. The results show that: (1) the recognition rate of the attention mechanism based LSTM is increased by 5.4% compared with the single LSTM model, so this algorithm effectively improves the recognition accuracy; (2) the attention mechanism is an effective feature selection method, by which, the subsets of acoustic features with practical physical significance can be selected to improve the recognition accuracy and reduce the dimension compared with the original common feature set; (3) according to the selection results, the acoustic features are analyzed, and it is found that the emotion recognition is correlated with the features of voiced segment length, unvoiced segment length, fundamental frequency F0 and Mel-frequency cepstral coefficients.

feature selection; speech emotion recognition; deep learning; attention mechanism

H107

A

1000-3630(2019)-04-0414-08

10.16300/j.cnki.1000-3630.2019.04.010

2018-08-09;

2018-09-03

中國國家社會科學基金會項目(BCA150054)

胡婷婷(1994-), 女, 安徽蕪湖人, 碩士研究生, 研究方向為器學習與深度學習,語音情感識別。

王蔚, E-mail: 769370106@qq.com