多通道深度可分離卷積模型實時識別復雜背景下甜菜與雜草

孫 俊,譚文軍,武小紅,沈繼鋒,蘆 兵,戴春霞

多通道深度可分離卷積模型實時識別復雜背景下甜菜與雜草

孫 俊,譚文軍,武小紅,沈繼鋒,蘆 兵,戴春霞

(江蘇大學電氣信息工程學院,鎮(zhèn)江 212013)

針對實際復雜田間環(huán)境下雜草與作物識別精度低和實時性差的問題,為減少弱光環(huán)境對分割識別效果的影響,實現(xiàn)甜菜與雜草的實時精確分割識別,該文首先將可見光圖像進行對比度增強,再將近紅外與可見光圖像融合為4通道圖像;將深度可分離卷積以及殘差塊構(gòu)成分割識別模型的卷積層,減少模型參數(shù)量及計算量,構(gòu)建編碼與解碼結(jié)構(gòu)并融合底層特征,細化分割邊界。以分割識別精度、參數(shù)量以及運行效率為評價指標,通過設置不同寬度系數(shù)以及輸入圖像分辨率選出最優(yōu)模型。試驗結(jié)果表明:本文模型的平均交并比達到87.58%,平均像素準確率為99.19%,幀頻可達42.064幀/s,參數(shù)量僅為525 763,具有較高分割識別精度和較好實時性。該方法有效實現(xiàn)了甜菜與雜草的精確實時識別,可為后續(xù)機器人精確除草提供理論參考。

作物;圖像分割;卷積神經(jīng)網(wǎng)絡;深度學習;甜菜;雜草;實時

0 引 言

雜草是影響作物生長的重要因素之一,會與作物爭肥爭水,增加病蟲害的傳播,故及時去除雜草對于保證作物高產(chǎn)具有重要意義[2]。傳統(tǒng)除草一般是人工除草,通過人力挖除或者噴藥實現(xiàn)除草,但需要耗費大量人力。另外噴藥產(chǎn)生的農(nóng)藥殘留不僅對人類健康產(chǎn)生巨大威脅,而且容易破壞生態(tài)環(huán)境[1]-[2]。隨著綠色農(nóng)業(yè)的概念提出,為了提高作物產(chǎn)量、減少環(huán)境污染,實現(xiàn)智能化除草,解決雜草與作物實時精確識別問題就顯得尤為重要[3-6]。

機器視覺在農(nóng)業(yè)中應用廣泛[7-8],目前大多數(shù)雜草與作物識別研究也是基于機器視覺技術(shù),通常包含特征提取與模式識別兩個步驟。何東健等[9]提取植物葉片形狀、紋理等特征并提出了一種多特征融合的方法,最后通過支持向量機(support vector machine,SVM)建模識別雜草。趙川源等[10]將多光譜圖像轉(zhuǎn)換為Lab顏色空間,提取葉片多種特征,并采用C4.5算法對雜草進行識別。Pulido等[11]計算圖像灰度共生矩陣(gray-level co-occurrence matrix,GLCM),然后使用支持向量機分類器區(qū)分雜草與蔬菜。以上文獻均是先提取特征然后通過分類器實現(xiàn)雜草識別,雖然在特定環(huán)境下取得較好效果,但是實際雜草識別中,識別效果容易受光照、遮擋、以及圖像采集質(zhì)量等因素的影響,所以提高雜草識別方法的魯棒性在傳統(tǒng)機器視覺中仍然是一個難以解決的問題。

深度學習[12]是機器學習的一個分支,其中的卷積神經(jīng)網(wǎng)絡(convolutional neural network,CNN)成為了圖像處理中一個研究熱點。近些年,卷積神經(jīng)網(wǎng)絡在圖像識別[13-16]、語義分割[17-18]、目標檢測[19-20]中取得重大突破,由于其對圖像特征表征能力強,所以越來越多學者將卷積神經(jīng)網(wǎng)絡應用在農(nóng)業(yè)領(lǐng)域。王璨等[21]以幼苗期玉米及雜草為研究對象,構(gòu)建卷積神經(jīng)網(wǎng)絡模型,提取圖像高斯金字塔多尺度特征,并結(jié)合超像素分割避免雜草識別中重疊問題。孫俊等[22]提出了一種空洞卷積與全局池化相結(jié)合的多尺度特征融合卷積模型,有效的識別多種雜草。Tang等[23]采用K-means學習的圖像特征,并將其參數(shù)替換卷積神經(jīng)網(wǎng)絡的隨機初始化參數(shù),最后通過微調(diào)模型參數(shù)的方法提高雜草識別精度。上述文獻均是采用基于分類思想實現(xiàn)雜草識別,為了更精確定位雜草與作物位置,Milioto等[24]采用基于語義分割的模型實現(xiàn)端到端的圖像像素點分類,提取傳統(tǒng)圖像特征并按通道進行像素級疊加從而構(gòu)建14通道的輸入圖像,獲得了較好分割識別效果。

以上文獻表明將卷積神經(jīng)網(wǎng)絡模型應用于雜草識別是可行的,且能避免傳統(tǒng)機器視覺方法中特征提取過程帶來的主觀性,提高了雜草識別精度。但是,由于實際環(huán)境下除草機器設備配置低,因此如何在有限硬件環(huán)境配置下節(jié)省資源消耗,達到實時精確的識別效果是需要解決的一個關(guān)鍵問題。為解決上述問題,本文以甜菜為對象,通過獲取田間甜菜的近紅外以及可見光圖像,構(gòu)建了4通道輸入圖像,并提出了一種編碼與解碼型輕量級卷積神經(jīng)網(wǎng)絡結(jié)構(gòu),通過加入深度可分離卷積減少模型參數(shù)量與計算量。本文最后通過試驗研究模型參數(shù)優(yōu)化選擇,為后續(xù)智能除草機的研制提供理論依據(jù)。

1 試驗數(shù)據(jù)

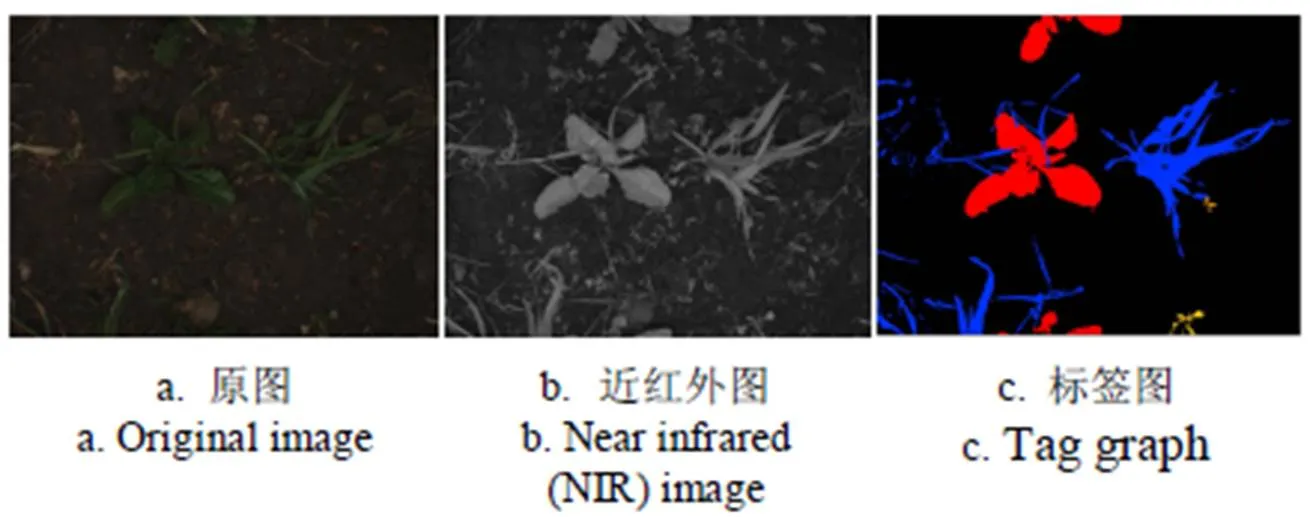

本文采用2016年德國波恩大學采集的甜菜與雜草圖片作為數(shù)據(jù)集[25],該數(shù)據(jù)集在德國波恩的農(nóng)場采集,數(shù)據(jù)集涵蓋了不同生長階段的甜菜圖片。采集圖片的機器人上配備JAI AD-130 GE攝像頭,可以同時獲取RGB圖片和近紅外(near infrared,NIR)圖片。由于像素級別的圖片標注難度大,故該數(shù)據(jù)集中帶標簽的圖片較少,共283張。數(shù)據(jù)集樣例如圖1所示,圖片包含甜菜和其他各類雜草,其中標簽的紅色區(qū)域表示甜菜,其他顏色區(qū)域表示雜草。

圖1 數(shù)據(jù)集示例

深度學習是數(shù)據(jù)驅(qū)動的自動特征學習方法,通常深度學習語義分割模型的輸入圖片是RGB三通道圖片。由于已標注圖片數(shù)量過少,訓練一個魯棒性較好的深度學習模型難度較大,一方面,淺層次模型難以擬合復雜背景圖片,另一方面,設計深層模型對數(shù)據(jù)量要求高,容易發(fā)生過擬合現(xiàn)象。針對上述問題,Milioto等[24]在論文中提出增加額外特征圖作為卷積神經(jīng)網(wǎng)絡模型的輸入,其試驗結(jié)果證明了特征融合的方法確實可以提升模型的精度。本文參考該論文的方法,與其不同的是,本文先對原始RGB圖像進行對比度增強,然后將圖像增強后的圖片與NIR圖片進行融合,構(gòu)成4通道輸入圖像,避免原始圖片特征冗余和減少計算量。隨機選取226張圖片作為訓練集,剩余57張作為測試集。

2 甜菜與雜草分割識別模型

2.1 深度可分離卷積