基于傳感數據的學習分析應用研究

李卿 任緣 黃田田 劉三女牙 屈杰

[摘? ?要] 數據是學習分析研究的重要前提。傳感技術的發展極大地提升了物理學習空間中的數據采集能力,拓展了學習分析的邊界。為把握傳感技術的應用現狀與趨勢,文章在分析傳感技術的特征和功能基礎上,使用文獻研究法探討了傳感數據與學習分析結合的應用價值,構建了基于傳感數據的學習分析框架,包括感知學習狀態、預測學習表現、干預與反饋學習過程等。基于現有研究成果,將基于傳感數據的學習分析應用歸納為學習認知、學習情感和動作技能等三個領域,分析了傳感數據采集、模型優化、反饋機制等方面的挑戰并提出未來可關注的研究方向。

[關鍵詞] 教育大數據; 傳感數據; 學習分析; 可穿戴技術

[中圖分類號] G434? ? ? ? ? ? [文獻標志碼] A

[作者簡介] 李卿(1982—),女,湖北武漢人。助理研究員,博士,主要從事教育大數據、感知計算技術等方面的研究。E-mail:viven_a@mail.ccnu.edu.cn。劉三女牙為通訊作者,E-mail:lsy5918@mail.ccnu.edu.cn。

[Abstract] Data is an important prerequisite for research on learning analytics. The development of sensing technology has greatly improved the ability of data acquisition in physics learning space and expanded the boundary of learning analytics. In order to grasp the application status and trend of sensing technology, based on the analysis of the characteristics and functions of sensing technology, this paper adopts literature research method to explore the application value of combining sensing data with learning analytics. A framework of learning analytics based on sensing data is constructed, including perceiving learning state, predicting learning performance, intervention and feedback learning process, etc. Based on the existing research results, the application of learning analytics based on sensing data is summarized into three fields: learning cognition, learning emotion and motor skill. Finally, this paper analyzes the challenges of sensor data acquisition, model optimization and feedback mechanism, and proposes the future research directions as well.

[Keywords] Big Data in Education; Sensing Data; Learning Analysis; Wearable Technology

一、引? ?言

大數據在教育領域的運用是學習分析產生的前提,學習分析是通過對學習者及其情境數據的測量、采集、分析和報告,了解和優化學習和學習發生的情境[1]。現已有眾多學習分析系統,如美國普渡大學的Course Signals系統,根據學習管理系統中學生的表現和個性化指標預測學生是否能完成課程[2];亞琛工業大學(RWTH Aachen)的 eLAT(Exploratory Learning Analytics Toolkit)[3]通過在線學習分析,基于教師個人興趣對教學進行反思與改進。由于網絡學習開啟了學習行為數據爆發式增長的潮流,現有的學習行為數據大多來源于線上(如學習管理系統、瀏覽器數據)。然而,很多學習發生在線下的現實情境中,只有捕捉現實情境中的學習行為數據,才能深入了解教與學的過程,以洞察學習者的學習心理,發現學習規律,優化學習過程,提高學習效率[4]。線下學習數據的采集將極大地豐富學習行為的類型,拓展學習分析的邊界。因此,線下學習行為分析是學習分析研究的重要趨勢。

隨著各類新型傳感器、穿戴設備的普及以及傳感技術的成熟,線下學習行為的采集也在逐漸突破技術的限制,如可通過視頻采集設備、可穿戴設備等采集課堂教學的全過程數據,也可通過人臉識別等專用設備對課堂學習者進行定向跟蹤,采集學習者的表情、言行等數據。因此,將傳感技術引入教育領域,可以實時收集物理空間數據,全面描述學習者,為實現學習過程的全方位量化提供了可能[5-6]。從2012年起,連續六屆“學習分析技術與知識國際會議”都指出,傳感技術(如眼動、腦電和心電等)成為學習分析重要的研究手段[7-8]。因此,如何將傳感技術的優勢與教學應用相結合,為學習分析研究帶來了新的研究視角和挑戰。

二、傳感技術

(一)傳感技術的定義與特點

傳感技術是一種高精度、高效率、高可靠性的采集各種信息的技術,基本的傳感設備包括動作傳感器,聲、光、電、溫度、濕度和位置傳感器等[9]。作為信息社會的支柱,傳感技術已滲透在醫療保健、體育娛樂、工業生產、軍事國防、交通管理等各個領域之中。

當前,傳感技術日趨微型化、智能化和集成化。傳感元件體積和質量越來越小,便于攜帶和使用;多種傳感元件可集成在一個平臺上或嵌入到智能手機中,實時采集信息,實現多功能集成;不僅能夠代表生物器官進行視覺、聽覺、觸覺和溫度等方面的感知,而且更加靈敏高效。

(二)傳感器與傳感數據

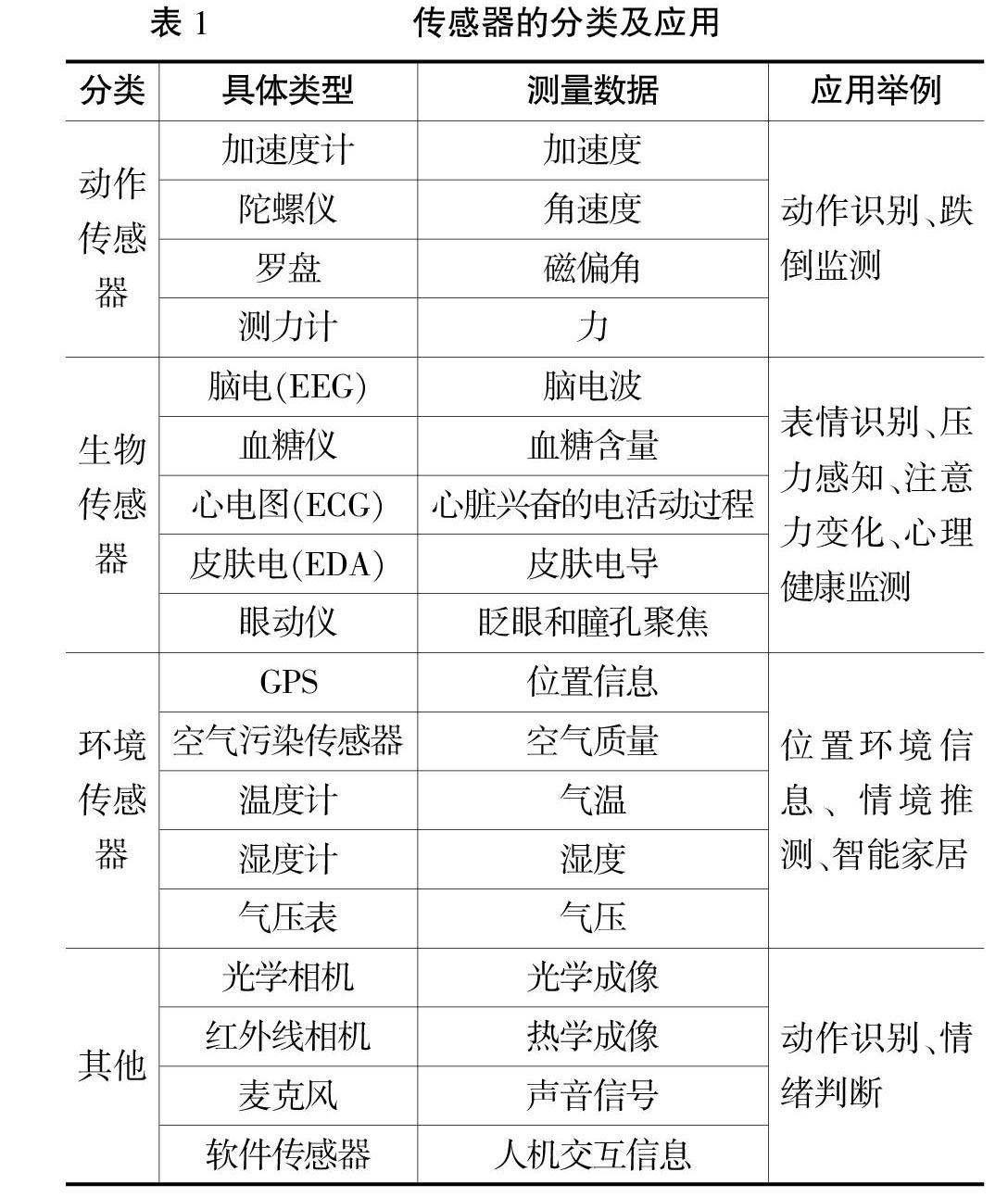

傳感器種類多樣,根據功能差異一般可分為動作傳感器、生物傳感器和環境傳感器[10]三種類型。除此之外,光學相機、熱學相機、麥克風等也被認為是傳感器,既能進行動作識別,又能輔助情感計算。傳感器的分類與應用見表1。

可穿戴式動作傳感器是放置在人體各部位的微小元件,能精確地捕獲和傳輸佩戴者的動作信息,如加速度、角速度等。動作傳感器的主要功能是人體活動識別,在醫療護理、體育娛樂、智能家居等領域廣泛使用。

生物傳感器能對人體的生理特征進行無感化測量,如心率、呼吸、血壓和體溫等。由于生物傳感器能連續監控和實時傳輸生命體征數據,多用于健康監測、疾病診斷等醫療領域。

環境傳感器可以捕獲人類周圍的環境信息,如所處的位置、光線強弱、空氣質量、噪音級別、天氣情況和大氣壓力等。環境傳感器在智能家居中技術較為成熟,主要用于監測環境變化,提高生活質量。

三、基于傳感數據的學習分析方法

在學習分析研究中,有眾多的學習分析模型,無論是反饋環狀還是交互網狀模型,從宏觀上都包括數據的采集、分析和反饋,即對學習行為和狀態的感知、預測與反饋。其中,學習數據的采集是學習分析的前提和基石。

目前,學習數據采集方法有基于Web的日志挖掘、學習者自我報告、基于傳感等多種手段或幾種方式的組合[11-12]。傳統的技術手段獲取的多是學習者線上的、結構化的學習行為數據,傳感技術可以采集學習者的運動行為、生理數據和所在環境信息。通過動作傳感器可以記錄學習過程中學習者相關行為數據并進行序列分析,從而推測學習狀態;通過生物傳感器可以測量學習者的心率、呼吸、血壓、體溫等生理信息,獲得與學習相關的認知和情感層面的支持,如研究證明,心率變化可以反映人的壓力大小[13],腦電波可以顯示注意力的變化[14];通過環境傳感器可獲取學習者所處的位置、光線強弱、噪音級別、天氣情況等周圍的環境信息,以分析環境可能對學習行為產生的影響,如噪聲、天氣、溫度都會影響學習者的精力集中程度。

面向學習者的傳感數據是教育大數據的重要組成部分,由多種傳感設備組合而成的傳感器平臺能多維度地監測和采集學習者數據,全面準確地描述學習行為。相較基于Web的日志挖掘,傳感數據更貼近真實的學習情境,增加了數據的有效性和可靠性。相較于傳統的問卷量表或訪談,傳感技術可以發揮高速率、高準確度、個性化的優勢。

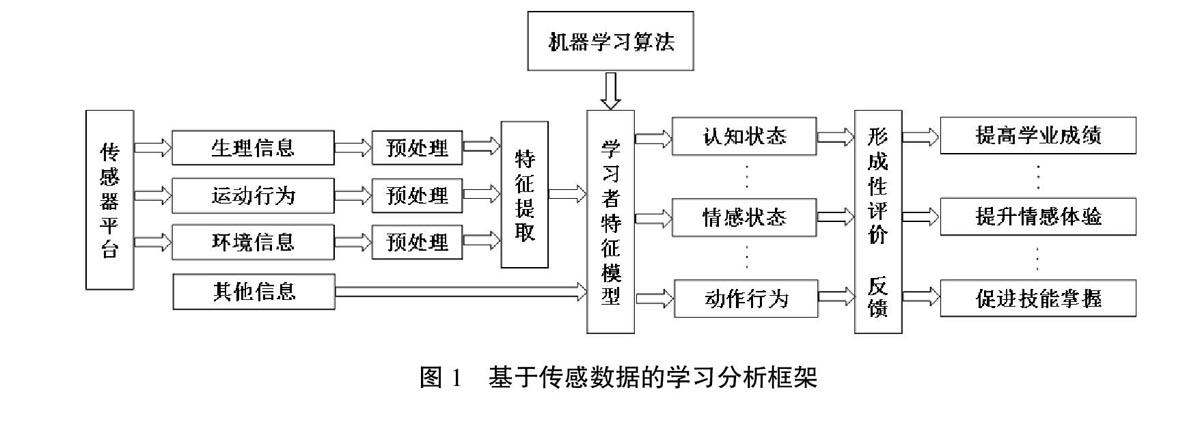

基于傳感數據的學習分析通過采集學習者多模態數據,建立相應模型,評估和預測學習表現,并為學習者提供個性化的指導和服務。具體流程如圖1所示。

(一)狀態感知,了解學習過程

學習狀態的感知既可以來自學習管理系統、學生信息系統、網絡課程和社交媒體中產生的數據,還包括基于傳感平臺測量的有關學習者的生理信息、運動行為和情境信息。為了獲得全面準確的信息,可在學習環境和學習者身上裝置相應的傳感器,進行量化跟蹤。如嵌入加速度計、心率傳感器、皮電裝置、GPS、溫度和氣壓等傳感器的智能手環,可對個體進行健康追蹤和運動監測,進一步整合視頻、音頻、日志、文本等多源數據進行學習狀態感知和分析。

(二)數據建模,預測學習表現

傳感設備采集大量關于學習者低層次的生理、心理和活動的多模數據后,提取關鍵特征,通過建模將低層次數據與高層次學習狀態建立聯系,用來評估和預測學生的表現,如信心程度、注意力狀態、認知負荷、情緒波動、社會交互等,監控學生的不良學習行為,促進學生的課堂參與度,提高學習效率等。一般采用監督機器學習方法,通過訓練模型以預測學生未來可能的學習表現。因為該方法需要大量的數據集和正確注釋的標簽,給建模帶來了許多挑戰,所以,目前在探究使用無監督或半監督的機器學習方法解決上述矛盾。

(三)結果評估,反饋和干預學習過程

傳感器連續測量數據并進行分析后,可以用于評價任務中,特別是形成性學習評價中。形成性評價是一種持續地判斷學生的學習狀態和衡量學習效率的評價方法。基于傳感器的學習平臺能推測和判斷學生目前的學習水平,并識別學生可能存在的錯誤,進而作出反饋。

高質量的反饋是形成性評價的關鍵要素,基于傳感平臺的反饋有震動、音頻、視頻等多種形式。如平臺預測學習者處于低迷狀態時,利用手環震動來進行提醒。

四、基于傳感數據的學習分析應用綜述

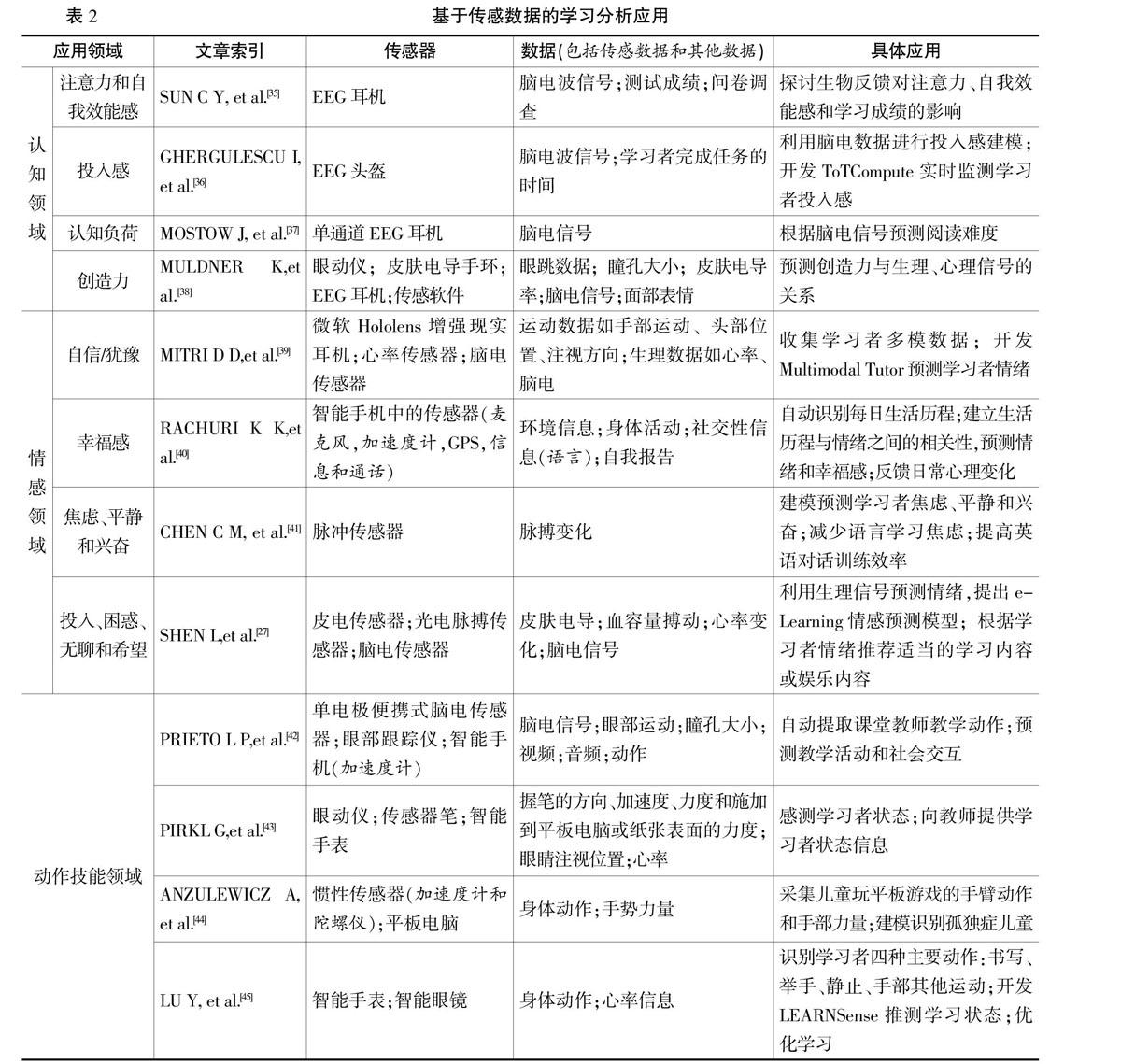

當前傳感數據與學習分析正在不斷地深度融合,國內外許多專家在積極地開展基于傳感數據的學習狀態的感知與優化方面的研究,本文根據布魯姆的學習結果分類理論,將基于傳感數據的學習分析應用歸納為認知、情感和動作技能三個領域,具體應用見表2。

(一)認知領域

學習者認知狀態的感知和評估是一個復雜的過程,借助于傳感技術可以對學習者的注意力、課堂投入感、認知負荷和創造力等狀態進行客觀有效的測量與評估。

注意力是影響學習效果的重要因素,通常使用自我報告來衡量被試注意力的集中度,如用認知失敗問卷(CFQ)來衡量人們無法持續關注所從事活動的頻率。但這種方法主觀性強,數據量有限,測量過程會中斷任務的執行。在傳感技術中,自我報告一般作為輔助手段衡量注意力狀態。如Steil等人使用可穿戴頭部相機、移動手機和眼動儀獲取了20位在校大學生的所在環境位置信息、運動模式、手機應用軟件情況和眼部活動等數據,采用機器學習方法進行數據集標注和學習者建模,預測用戶在使用手機時的注意力轉移、注意力廣度和注意焦點的變化[15],有助于感知學習者在移動學習中的認知狀態和注意力變化,幫助學習者及時剖析自我、調整狀態,提高注意力水平和自我效能感。

投入感是衡量注意力的重要指標,它表示學習者在學習、理解和掌握知識及學習過程中為取得成功的心理投入程度和學習的意愿、需求、欲望和沖動[16]。Csikszentmihalyi曾以心流來表示人們的投入感,即當人們完全融入所從事的活動時所體驗的一種整體感受[17]。傳感技術可以將這種主觀感受通過身體動作和生理信息自動外顯化表示出來,如Monkaresi等人在寫作過程中引入基于視頻的方法自動檢測學生投入感,使用Microsoft Kinect傳感器記錄學習者的面部表情、聲音和上半身動作,并使用心率傳感裝置提取學習者的心率變化,在論文寫作過程中和之后分別收集實時性和回顧性的投入感自我報告,分別進行機器學習建模,結果表示融合兩種自我報告的模型檢測效果最佳[18]。

認知負荷理論認為工作記憶是有限的,如果學習任務需要太多的記憶容量,學習速度會變慢,因此,認知負荷與學習效率之間存在緊密聯系。認知負荷的測量通常有主觀測量、行為表現測量和心理生理學測量[19]三種方式。傳感技術使心理、生理學測量方法的準確率更高,操作更為便捷。其主要優點在于測量的客觀性,對不同認知過程的敏感性及過程的內隱性和連續性[20]。如Haapalainen等人通過傳感設備測量人在執行不同難度水平的任務時的心率變化、瞳孔大小、腦電信息、皮膚電導、熱通量和心電圖等生理信息,間接反應認知負荷的大小,結果顯示,熱通量和心電圖測量值在區分低水平和高水平認知負荷時最準確,組合使用時準確度超過80%[21]。

創造力是21世紀的關鍵能力。盡管各行各業強調創造力的重要性,但是在實際教育中,它遠沒有紀律受到的重視多[22],大多數教師往往側重于知識獲取,而不是創造力等能力的培養。創造力一般使用人為的方式進行評估,如創造性量表[23],或構造評估特定產品設計的創造力模型[24],這種方法需要人為指定產品功能,因此,目前僅限于有限的概念空間。基于傳感數據的方法可以用來解決這一難題,如Lopata等人已經證明腦電信號中的Alpha波能區分不同創造力,通過記錄腦電信號對比音樂家在高、低創造力需求的任務時的Alpha波活動差異,發現在創造力要求高的任務中Alpha波段更為活躍,且音樂家的Alpha波與個人表現的客觀評級之間顯著相關[25]。

(二)情感領域

情感體驗影響人類的認知和決策過程,是影響學習的另一個重要因素,如自信、無聊和困惑是影響學業成績和預測學業表現的重要指標[26-27]。因此,情緒識別是分析學習者情感狀態的重要研究領域。研究者們基于生理信號、身體動作、面部表情、語言信息、在線文本、互動日志和問卷量表數據開發了眾多的情緒識別系統,對一般的情緒有著較高的識別率。其中傳感技術是重要的情感識別手段,使用腦電、皮電和脈搏表等設備獲取生理信號,可穿戴動作傳感器捕獲學習者的動作信息,光學和深度相機記錄面部表情變化,結合多模信息提高情緒識別的準確率,具體應用見表2。

到目前為止,情緒識別技術發展純熟,根據Russell的情緒環狀模型[28],正面情緒(驚奇、興奮、愉悅、滿足、放松)和負面情緒(恐懼、緊張、失望、悲痛、傷心、沮喪、無聊)幾乎涵蓋了人類所有的情緒表現。雖然情緒情感種類繁多、結構復雜,但是教師和智能導師系統只需了解學習者最基本、最常見的情緒進行智能決策[29]。

Isen等人指出,積極的情緒對學習過程具有促進作用,特別是在創造力問題的解決方面[30]。而傳統上被認為是消極的情緒在某些條件下也可能對學習產生正面影響,例如,困惑和緊張等,它們只有在發展到一定程度時才會對學習產生負面影響。所以,當系統檢測到學生處于負面情緒或情感體驗持續較低時,相應的反饋和調節至關重要。如將感知到的情感信息整合到e-Learning平臺上,根據學習者的情緒狀態定制不同學習材料,提高學習體驗;教師根據學習者情緒反應,調節教學進程,提高學習效率。

(三)動作技能領域

人體動作識別技術是傳感技術在行為活動領域應用的基礎。人體動作識別主要有基于視覺傳感和基于慣性傳感兩種類型。視覺傳感主要使用RGB光學相機、3D立體相機和深度傳感器如Microsoft Kinect和Asus Xtion Pro等記錄身體動作。基于視覺的人類行為識別易于操作,捕獲信息豐富,但識別性能受相機位置、主體活動范圍、拍攝背景的影響;基于慣性傳感的動作識別主要使用加速度計、陀螺儀和磁力計等可穿戴設備記錄佩戴者的運動信息。這種方法不受時空限制,能長期記錄和持續交互,但是也有自身的局限性,如長期使用導致傳感設備損耗,測量準確率下降等。所以Chen等人開始將兩種類型的傳感技術相融合,提高動作識別的準確率[31-33]。

目前該領域的研究大都集中在低層次的基本動作識別上,如站、坐、走、跑、抬頭、閱讀、舉手等,或者多個簡單動作序列的識別。簡單的非言語行為對于學習支持起到一定的解釋作用,但是人們越來越關心學習者的動作與認知和情感等高級心理機制之間的關系[34],通過學習者不同的動作行為表征他們的認知狀態和情感體驗。除此之外,基于傳感數據的動作識別在體育運動中可以提高運動員的動作技能,通過識別運動員的關鍵動作,判斷他們的動作的精確度、力度和穩定性,推薦個性化訓練指導,發揮智能導師作用。

五、總結與展望

隨著傳感技術、網絡通信、人工智能等技術的發展,學習環境也發生了巨大變化,由最初固定的學習環境發展為移動學習和隨時隨地的學習。多種傳感設備的有效結合可以形成功能強大的傳感網絡,以非侵入式的方式實時采集學習者的多維數據,診斷學習者現存的或潛在的問題,通過個性化的評價與反饋為學習提供有力支持。

學習分析強調基于數據的學習描述、診斷、預測和干預,結合應用現狀發現,當前基于傳感數據的學習分析仍存在諸多問題與挑戰。在數據采集方面,為全面描述學習行為,一般采用傳感數據與自我報告相結合的方法,數據在真實無感與全面準確之間難以兼顧;在模型建立方面,機器學習模型的擬合度不高,且目前大多數采用監督機器學習的方式訓練模型,標簽成本較大;在反饋回應方面,現有的反饋形式相對單一,且個性化反饋程度較差。未來的相關研究還可以在以下方面進行突破。首先,在量化學習行為方面,將線上和線下發生的所有學習行為通過傳感手段進行自然的伴隨式采集,同時,將一些定性的數據進行科學準確的量化表達;其次,目前尚缺乏融合多影響因素的數據關聯模型與精準分析,需進一步改進和優化數據模型,提高預測的準確性;最后,如何利用傳感數據的過程性反饋優勢,在學習過程中進行個性化的干預,如何把握干預的方式、時機與場景以實現有效的反饋都需要深入探究。

[參考文獻]

[1] SIEMENS G. Learning and knowledge analytics- knewton-the future of education?[EB/OL].[2011-04-14]. http://www.learninganalytics.net/ ?p=126.

[2] ARNOLD K E, PISTILLI M D. Course signals at purdue: using learning analytics to increase student success[C]//Proceedings of the 2nd international conference on learning analytics and knowledge. New York: ACM, 2012: 267-270.

[3] DYCKHOFF A L, ZIELKE D, BULTMANN M, et al. Design and implementation of a learning analytics toolkit for teachers[J]. Educational technology & society, 2012, 15(3):58-76.

[4] 劉三女牙,李卿,孫建文,劉智.量化學習:數字化學習發展前瞻[J].教育研究,2016(7):119-126.

[5] 徐曉青,趙蔚,劉紅霞.混合式學習環境下情緒分析應用與模型研究——基于元分析的視角[J].電化教育研究,2018,39(8):70-77.

[6] 張琪,武法提.學習分析中的生物數據表征——眼動與多模態技術應用前瞻[J].電化教育研究,2016,37(9):76-81.

[7] 李香勇,左明章,王志鋒. 學習分析的研究現狀與未來展望——2016年學習分析和知識國際會議述評[J]. 開放教育研究,2017,23(1):46-55.

[8] 吳永和,李若晨,王浩楠. 學習分析研究的現狀與未來發展——2017年學習分析與知識國際會議評析[J]. 開放教育研究,2017,23(5):42-56.

[9] SWAN M. Sensor mania! The internet of things, wearable computing, objective metrics, and the quantified self 2.0[J]. Journal of sensor and actuator networks, 2012,1(3):217-253.

[10] TH?譈S H, CHATTI M A, YALCIN E, et al. Mobile learning in context[J]. International journal of technology enhanced learning, 2012,4(5/6):332-344.

[11] VANLEHN K, ZHANG L, BURLSON W, et al. Can an non-cognitive learning companion increase the effectiveness of a meta-cognitive learning strategy?[J]. IEEE transactions on learning technologies, 2017,10(3):277-289.

[12] CATRYSSE L, GIJBELS D, DONCHE V, et al. How are learning strategies reflected in the eyes? Combining results from self‐reports and eye‐tracking[J]. British journal of educational psychology, 2017,88(5):118-137.

[13] TAELMAN J, VANDEPUT S, SPAEPEN A, et al. Influence of mental stress on heart rate and heart rate variability[C]//4th European Conference of the International Federation for Medical and Biological Engineering. Berlin, Heidelberg: Springer, 2009: 1366-1369.

[14] AFTANAS L I, GOLOCHEIKINE S A. Human anterior and frontal midline theta and lower alpha reflect emotionally positive state and internalized attention: high-resolution EEG investigation of meditation[J]. Neuroscience letters, 2001, 310(1):57-60.

[15] STEIL J, M?譈LLER P, SUGANO Y, et al. Forecasting user attention during everyday mobile interactions using device-integrated and wearable sensors[C]//Proceedings of the 20th International Conference on Human-Computer Interaction with Mobile Devices and Services. New York: ACM, 2018.

[31] CHEN C, JAFARI R, KEHTARNAVAZ N. Improving human action recognition using fusion of depth camera and inertial sensors[J]. IEEE transactions on human-machine systems, 2015, 45(1):51-61.

[32] CHEN C, JAFARI R, KEHTARNAVAZ N. A real-time human action recognition system using depth and inertial sensor fusion[J]. IEEE sensors journal, 2016, 16(3):773-781.

[33] CHEN C, JAFARI R, KEHTARNAVAZ N. A survey of depth and inertial sensor fusion for human action recognition[J]. Multimedia tools & applications, 2017, 76(3):4405-4425.

[34] BOWMAN L C, THORPE S G, CANNON E N, et al. Action mechanisms for social cognition: behavioral and neural correlates of developing theory of mind[J]. Developmental science, 2017, 20(5): 1-16.

[35] SUN C Y, YEH P C. The effects of attention monitoring with EEG biofeedback on university students' attention and self-efficacy: the case of anti-phishing instructional materials[J]. Computers & Education, 2017, 106:73-82.

[36] GHERGULESCU I, MUNTEAN C H. ToTCompute: a novel EEG-based timeontask threshold computation mechanism for engagement modelling and monitoring[J]. International journal of artificial intelligence in education, 2016, 26(3):821-854.

[37] MOSTOW J, CHANG K, NELSON J. Toward exploiting EEG input in a reading tutor[J]. International journal of artificial intelligence in education, 2013, 22(1-2):19-38.

[38] MULDNER K, BURLESON W. Utilizing sensor data to model students creativity in a digital environment[J]. Computers in human behavior, 2015(42):127-137.

[39] MITRI D D, KLEMKE R, DRACHSLER H, et al. Towards a real-time feedback system based on analysis of multimodal data[C]//European Conference on Technology Enhanced Learning, 2017.

[40] RACHURI K K, MASCOLO C, RENTFROW P J, et al. Mobile sensing at the service of mental well-being: a large-scale longitudinal study[C]//Proceedings of the 26th International Conference on World Wide Web. International World Wide Web Conferences Steering Committee, 2017: 103-112.

[41] CHEN C M, LEE T H. Emotion recognition and communication for reducing second‐language speaking anxiety in a web‐based one‐to‐one synchronous learning environment[J]. British journal of educational technology, 2011, 42(3): 417-440.

[42] PRIETO L P, SHARMA K, DILLENBOURG P. Teaching analytics: towards automatic extraction of orchestration graphs using wearable sensors[C]//Proceedings of the Sixth International Conference on Learning Analytics & Knowledge. New York:ACM, 2016: 148-157.

[43] PIRKL G, HEVESI P, LUKOWICZ P, et al. Any problems? A wearable sensor-based platform for representational learning-analytics[C]//Proceedings of the 2016 ACM International Joint Conference on Pervasive and Ubiquitous Computing: Adjunct. New York:ACM, 2016: 353-356.

[44] ANZULEWICZ A, SOBOTA K, DELAFIELDBUTT J T. Toward the autism motor signature: gesture patterns during smart tablet gameplay identify children with autism[J]. Scientific reports, 2016, 6, 31107: 1-13.

[45] LU Y, ZHANG S, ZHANG Z, et al. A framework for learning analytics using commodity wearable devices[J]. Sensors, 2017, 17(6), 1382: 1-25.