基于Q-Learning算法的建筑能耗預測①

陳建平, 陳其強, 胡 文, 陸 悠, 吳宏杰, 傅啟明

(蘇州科技大學 電子與信息工程學院, 蘇州 215009)

(江蘇省建筑智慧節能重點實驗室, 蘇州 215009)

(蘇州市移動網絡技術與應用重點實驗室, 蘇州 215009)

1 引言

建筑作為能耗占比最大的領域, 雖然自身擁有巨大的節能潛力, 但是, 隨著經濟的高度發展, 建筑面臨的高能耗低能效的問題也日益嚴峻. 近年來, 我國在建筑節能領域取得了明顯進展, 但從能耗預測的角度看,建筑能耗預測仍然存在很多不足之處[1]. 構建建筑能耗預測模型是預測建筑未來時刻能耗、在線控制能耗以及獲取能耗運行最優策略的前提和核心[2-4]. 但是, 建筑具有面積大、能耗大和能耗復雜等特點, 并且建筑自身是一個包含多種系統, 設備相互連接的復雜非線性系統. 因此, 研發精度高、適應性強的能耗預測模型并非是件容易的事. 從建筑自身來說, 其能耗受到多種外界因素的影響, 例如外界氣候、建筑物自身結構、內部設備運行特點、人員分布動態特征等, 這些因素使得建筑物能耗變得更加復雜, 也加劇了能耗預測的難度. 近年來, 國內外許多業界學者和專家的主要關注點在于如何在提高建筑能耗預測的準確性并簡化能耗預測模型的同時, 實現在線控制及優化建筑能耗. 建筑的完整生命周期包括很多環節, 如設計、建造、運行、維護等, 其中每個環節運用的節能方法或者技術都能夠對實現節能的目標產生重要影響, 因此, 能耗預測在建筑節能中就顯得勢在必行. 與此同時, 建筑在自身運行中產生的一大批真實能耗數據被擱置或者直接丟棄, 并沒有真正實現任何價值, 對節能而言, 又是一種資源浪費.

強化學習在智能建筑領域, 尤其是在建筑節能問題上已經引起國內外相關學者的廣泛關注. Dalamagkidis等人提出設計一種線性強化學習控制器, 可監督控制建筑熱舒適度、空氣質量、光照需求度、噪音等, 與傳統Fuzzy-PD相比, 其效果更優[5]; Yu等人提出了一種用強化學習在線調整低能耗建筑系統的監督模糊控制器的無模型方法, 其中用Q-learning算法監控建筑物的能源系統[6]; Bielskis等人利用強化學習方法構建室內照明控制器, 通過強化學習方法自適應調節照明系統, 進而節約能源消耗[7]; Li等人提出一種多網格Q-learning方法, 通過近似建筑環境模型求解近似節能優化策略, 并將初始策略用于精確建筑模型, 在線學習最優控制策略, 加快算法求解實際問題中的收斂速度[8];Liu等人提出基于強化學習Q-learning算法監督控制建筑熱質量, 進而節約能源消耗[9]; Yang等人提出基于強化學習方法的建筑能耗控制方法, 該控制方法運用表格式Q學習和批量式Q學習在Matlab平臺上實現建筑能耗控制, 實驗結果表明, 該方法較其他方法多節約百分之十的能耗[10]; Zamora-Martínez 等人給出一種利用位置環境在線預測建筑物能耗的方法, 該方法從一個完全隨機的模型或者一個無偏的先驗知識獲得模型參數, 并運用自動化技術使得房屋適應未來的溫度條件, 達到節能的效果[11]; Nijhuis等人提出一種基于公開可用的數據開發住宅負載模型, 該模型運用強化學習中蒙特卡羅算法, 基于時間使用規律對家庭居住房屋進行建模, 該模型中主要影響能耗的相關因素為天氣變量、領域特征和人員行為數據, 通過對100多個家庭每周的用電量進行驗證, 實驗結果表明, 該方法的預測性能較其他類似方法更精確[12]; Liesje Van Gelder等人基于強化學習中蒙特卡羅方法提出一種整合影響建筑能耗諸多不確定因素的概率分析和設計方法, 該方法可以合并原模型, 取代原始模型, 并檢查潛在情景的優化結果[13].

本文利用DBN將建筑能耗初始狀態映射至高維特征空間, 結合強化學習中Q-learning算法, 將輸出的狀態特征向量作為Q-learning算法的輸入, 實現對建筑能耗的預測. 實驗表明, 運用強化學習進行能耗預測是可行的, 并且改進后的能耗預測方法精度更高, 這充分說明了強化學習在建筑能耗預測領域具有很大的研究潛力.

2 相關理論

2.1 馬爾可夫決策過程

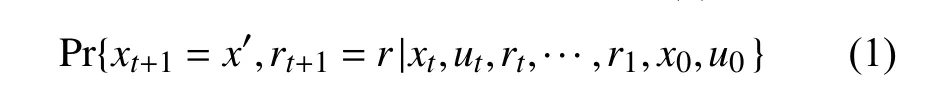

能成功保留所有相關信息的狀態信號就是具有馬爾科夫性(Markov Property)的, 而只要具有馬爾可夫性的強化學習問題就被稱為馬爾可夫決策過程(Markov Decision Process, MDP). 馬爾可夫性可作如下定義: 假設強化學習問題中, 狀態和獎賞值的數量都是有窮的,在問題中, 學習器(Agent)與環境交互, 在t時刻執行動作后, 會在時刻獲得一個反饋, 在最普通的情況中,這個反饋可能是基于前面發生的一切, 因此, 這種環境動態性可以通過概率分布來定義, 如公式(1)所示:

然而, 如果狀態信號也是有馬爾可夫性的, 那么Agent在t+1時獲得的環境反饋就只取決于Agent在t時刻的狀態和動作. 在此情況下, 這種環境動態性可以通過公式(2)來定義:

MDP可以用來對強化學習問題進行建模, 其通常被定義為一個四元組其中表示狀態集合;表示動作集;表示獎賞函數是指Agent在狀態時采取動作所獲得的回報值;是狀態轉移函數,是指Agent在狀態下 采取動作后轉移到狀態的概率.

強化學習的最終目標是要學習到一個能夠獲得最大期望累計獎賞的最優策略, 并利用該策略進行決策.然而, 由于最終計算獲得的最優策略可能是一個動作,也可能是某個動作被選擇的概率, 因此, 策略被分為確定策略(deterministic policy)和隨機策略(random policy)兩種. 其中, 確定策略表示 Agent在某一狀態下執行某一動作, 例如表示Agent在狀態下執行動作; 隨機策略表示Agent在某一狀態下執行某一動作的概率, 例如表示Agent在狀態下執行動作的概率. 在本文中, 策略直接用表示, 策略是每個狀態和動作在狀態下執行動作的概率的映射. 假設當前時刻為, 當前狀態為, 策略為, 而Agent依據當前狀態和策略執行動作后, 在時刻, Agent通過環境反饋, 獲得的立即獎賞為Agent在強化學習問題中, 不斷地重復上述過程, 并且與環境不斷交互,學習到最優策略, 并達到獲取最大期望累計獎賞的目的.

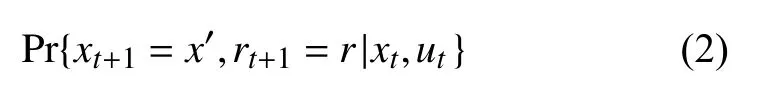

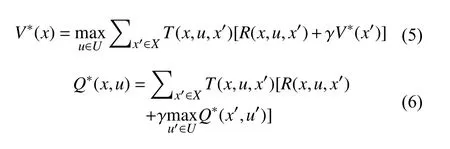

對Agent在給定一個狀態或者狀態動作對時, 為了評估該狀態或者狀態動作對的好壞程度, 在強化學習中給出值函數的定義. 幾乎所有強化學習算法都是通過值函數對策略進行評估, 而值函數有狀態值函數Vk(x)和動作值函數Qk(x,u)兩種. 其中,Vk(x)表示Agent在當前狀態下遵循策略的期望回報; 而Qk(x,u)表示Agent在當前狀態動作對(x,u)下遵循策略h所 能獲得的期望回報.Vk(x)和Qk(x,u)是相應Bellman公式的不動點解, 如公式(3)和公式(4)所示:

上述兩個公式也被稱作最優Bellman公式.

2.2 Q-learning算法

Q-learning是一種經典的離策略算法, 其更新準則:, 即Q-learning是利用基于行為策略所選擇的實際動作來更新目標策略Q值的. Q-learning算法具體流程如算法1所示[14].

算法1. Q-learning算法3. 初始化4. Repeat(for each step of episode)1. 隨機初始化2. Repeat(for each episode) 5. 利用從 中得到的策略在中選擇 6. 采取動作 , 得到 7.8.9. 直到是終止狀態10. 直到 最優

3 基于Q-learning算法的建筑能耗預測方法

3.1 建筑能耗狀態表示

DBN可以應用在多種領域的問題中, 例如執行非線性維數減少、圖像識別、視頻序列和動作捕捉數據等問題. 此外, DBN可以根據不同的抽象層將學習任務分解成相應的子問題.

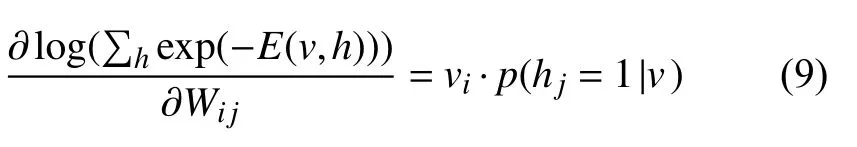

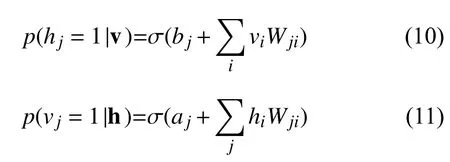

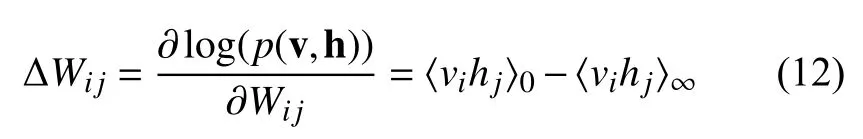

DBN由很多限制玻爾茲曼機堆疊在一起, DBN是一個時滯神經網絡, 主要分為可視層和隱層, 每一層之間存在相關鏈接, 但每一層內的單元之間不存在相互鏈接. 隱層每個單元的作用主要在于獲取可視層單元的輸入數據所具有的高階數據的特征, 因此, 由可視層和隱層鏈接配置的能量被定義為:

其中,i表示可視層節點,表示隱層節點,表示第i個可視單元與第個隱層單元之間的權重. 此外和表示第i個可視單元與第個隱層單元的狀態,和表示可視層與隱層的偏置向量.表示隱層和可視單元之間的輸出與它們的相關權重的乘積和分別表示可視層和隱層的輸出. RBM定義了一個聯合的概率p(v,h), 覆蓋了隱層和可視層.

在RBM中隱藏層和可視層被激活的概率可以用下面的公式來表示:

總的來說, 一個深度信念網絡是由一個任意的數字給出的. 其中, 可視層(輸入向量)和l層隱層的之間的聯合分布的定義如公式(13)所示:

如圖1所示, 一個DBN包含1個可視層和3個隱層, 其中,層是可視層;是隱層. 可視層的每個單元代表真實值, 隱層的每個單元代表2進制的神經元. DBN可以通過貪心無監督的方法進行訓練, 通過從下到上的順序分別訓練其中的每一個RBM, 使用隱層的輸出作為下一個RBM的輸入, 直到最后一個RBM被訓練結束. 此外, DBN通過在模型的底層修改初始狀態以此推斷出最頂層的隱藏層, 從而將從環境中獲取的初始狀態映射到二值狀態空間.

圖1 DBN框架圖

3.2 環境建模

3.3 基于Q-learning算法的建筑能耗預測算法

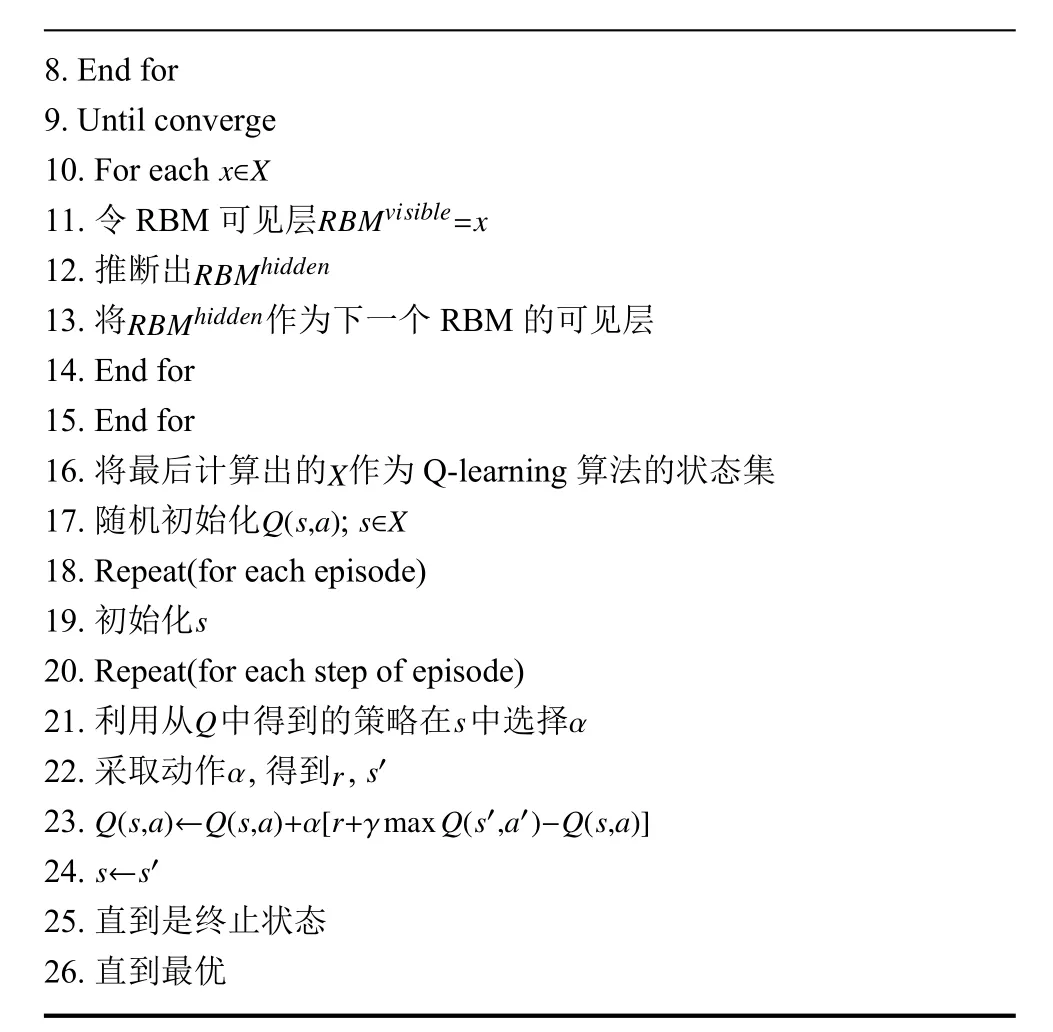

DBN將從環境中獲取的初始狀態映射到一個二值狀態空間, 并且將獲得的狀態作為Q-learning算法的輸入, 基于Q-learning算法的建筑能耗預測算法具體流程如算法2所示.

算法2. 基于Q-learning算法的建筑能耗預測算法X 4. For each 1. 初始化 DBN, 輸入狀態集2. For each RBM in DBN 3. Repeat x∈X 5. 令RBM可見層6. 執行RBM, 訓練出RBM的參數7. 更新RBM的權重及各個節點的偏置, 固定RBM的參數RBMvisible=x

8. End for 9. Until converge x∈X 10. For each 11. 令RBM可見層RBMhidden RBMvisible=x 12. 推斷出RBMhidden 13. 將 作為下一個RBM的可見層14. End for 15. End for X 16. 將最后計算出的 作為Q-learning算法的狀態集Q(s,a)17. 隨機初始化 ;18. Repeat(for each episode)s s∈X 19. 初始化20. Repeat(for each step of episode)Q 21. 利用從 中得到的策略在 中選擇α s α 22. 采取動作 , 得到 ,Q(s,a)←Q(s,a)+α[r+γmaxQ(s′,a′)-Q(s,a)]r s′23.24.25. 直到是終止狀態26. 直到最優s←s′

4 實驗及結果分析

4.1 實驗設置

為了驗證本文所提出的建筑能耗預測方法的有效性, 本章節采用的實驗數據是美國巴爾的摩燃氣和電力公司記載的建筑能耗數據, 具體時間為2007年1月至2017年12月. 本節以其中General Service(< 60 kW)部分數據為實驗數據集, 如圖2所示, 子圖1表示2017年9月共30天的能耗數據, 子圖2展示的是2017年9月23日至9月29日共一周7天的能耗數據, 圖2中數據采集的步長為1次/1 h. 在所有實驗中,數據集分為兩部分, 一部分用于模型的訓練, 一部分用來評估該能耗預測方法的性能, 學習速率 α =0.4, 折扣因子 γ =0.99.

圖2 能耗實際值

4.2 實驗結果分析

圖3 和圖4主要展示了Q-learning、基于DBN的Q-learning算法對一個星期的建筑能耗預測值與實際值的對比圖, 橫坐標表示時間, 縱坐標表示建筑能耗.在實驗過程中, 每個算法都被獨立執行20次, 圖中的數據即20次實驗的平均值. 從兩幅圖中可以看出, 兩種算法都可以預測出未來一周的建筑能耗值. 因此, 用DBN構建能耗動態模型, 并采用Q-learning算法進行建筑能耗預測的方法是可行的. 此外, 從圖中可以清晰地看出, 改進的基于DBN的Q-learning算法的能耗預測準確性較經典Q-learning算法更高, 主要原因是通過DBN構造高維特征向量, 進一步提高函數逼近器的泛化能力, 提高算法預測的準確性.

圖3 Q-learning算法能耗預測值與實際值對比

圖4 基于DBN的Q-learning算法能耗預測值與實際值對比

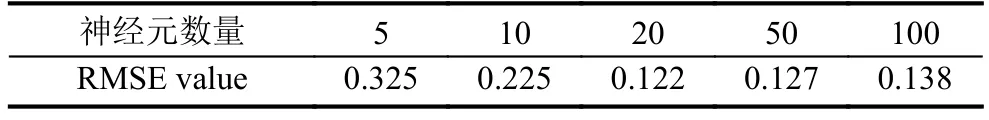

表1主要表示了DBN隱藏層神經元個數不同時,不同算法對能耗預測的性能分析. 表格中的數據表示建筑能耗實際值與預測值的均方根誤差, 表格中的數據是算法被獨立執行20次的平均值. 從表1還可以看出相同算法在不同隱藏層神經元的個數下, 算法的性能也不一致, 當隱藏層神經元個數為 5, 10, 20, 50,100時, 建筑能耗的預測值與實際值的均方根誤差分別為 0.325, 0.225, 0.122, 0.127, 0.138. 由此可以看出, 神經元個數越少, 預測的準確性越差, 而神經元個數越多時, 預測的準確性越好, 但是當神經元數量足夠多時,預測的準確性幾乎保持一致, 甚至準確性變差. 由此可見, 為了提高建筑能耗預測的準確性, 選擇合適的隱藏層神經元個數是有必要的, 由表 1 可知, 本文中, 隱藏層神經元個數取20.

表1 神經元個數對基于DBN的Q-learning算法預測性能的影響

表2主要表示了不同α值以及在不同數據步長對基于DBN的Q-learning算法預測性能的影響分析. 表格的第一行表示α的不同取值, 表格的第一列表示數據的步長, 即每個數據之間的時間間隔分別為1 h, 1 day, 1 week和1 month. 表格中的數據表示建筑能耗實際值與預測值的均方根誤差, 都是算法被獨立執行20次的平均值. 由表2可以清晰地知道, 當數據步長為1 h時, 盡管α的取值在不斷變化, 建筑能耗的預測值與實際值的均方根誤差總是比較穩定, 預測的準確性較高; 當數據步長為 1 week 時,α取值越大, 建筑能耗的預測值和實際值的均方根誤差越小, 預測的準確性相對較低; 而當數據步長為1 week和1 month時,α取值越大, 建筑能耗的預測值和實際值的均方根誤差越大, 預測的準確性更低. 同樣的, 當α(α≥0.4)取值一致時, 數據的步長越小, 建筑能耗的預測值和實際值的均方根誤差越小, 預測的準確性越高; 數據的步長越大,建筑能耗的預測值和實際值的均方根誤差越大, 預測的準確性越低. 綜上所述, 為了最大化能耗預測的準確性, 這里我們選取數據步長為1 h,α取值我們選取0.4.

表2 不同 值及不同數據步長對基于DBN的Q-learning算法預測性能的影響

表2 不同 值及不同數據步長對基于DBN的Q-learning算法預測性能的影響

數據步長 α值0.2 0.3 0.4 0.5 0.6 0.7 1 h 0.136 0.132 0.122 0.119 0.129 0.135 1 day 1.233 1.156 0.985 0.912 0.685 0.843 1 week 1.312 1.114 1.109 1.112 1.698 1.723 1 month 1.205 2.209 2.352 2.417 2.423 2.436

5 結束語

本文提出一種基于Q-learning算法的建筑能耗預測模型. 該模型通過深度置信網自動提取特征, 并利用貪心無監督的方法自下而上地訓練深度置信網中的每一個RBM. 所提出的模型將隱層的輸出作為下一個RBM的輸入, 實現對能耗狀態的預處理, 并以此構建高維狀態向量. 此外, 該模型將能耗預測問題建模為一個標準的馬爾可夫決策過程, 將深度置信網的輸出狀態向量作為Q-learning算法的輸入, 利用Q-learning實現對能耗的實時預測. 為了驗證模型的有效性, 本文采用美國巴爾的摩燃氣和電力公司記載的建筑能耗數據進行測試實驗, 實驗結果表明, 所提出的模型可以有效地預測建筑能耗, 并且基于DBN的Q-learning算法較傳統的Q-learning算法有較高的預測精度. 此外, 本文還進一步分析了相關參數對算法性能的影響.

本文主要對單一固定建筑能耗進行預測, 下一步,將考慮對多樣變化的建筑能耗進行預測和遷移研究,同時不斷完善模型, 更好地實現建筑能耗預測, 進一步達到建筑節能的目的.