多視角特征共享的空間對齊跨領域情感分類

賈熹濱 靳 亞 陳軍成

1(北京工業大學信息學部 北京 100124) 2(多媒體與智能軟件技術北京市重點實驗室(北京工業大學) 北京 100124) (jiaxibin@bjut.edu.cn)

隨著互聯網的快速發展,網絡上出現了大量由用戶發起的評論信息,包括對電影、產品、社會熱點事件等的評論,這些評論信息中通常包含了豐富的情感信息,表達了用戶對商品、電影等話題的觀點和看法.如果能自動地將這些信息加以處理、分析和總結可以為用戶和公司等提供決策幫助[1],同時也方便政府了解群眾對于社會熱點事件的觀點和看法[2].例如,用戶在網絡上購買商品時可以參考該商品其他用戶的評價意見,為自己提供決策幫助;公司可以通過收集用戶對商品的評價信息并分析出商品在各個方面的優點和不足,為公司改善商品質量、對用戶進行個性化推薦和增加商品銷售量提供幫助等.因此,情感分類技術(又稱意見挖掘技術)因能及時地對網絡中帶有主觀情緒色彩的文本進行分析并帶來巨大的經濟和社會價值而引起了較廣泛的關注,成為了近年來的研究熱點[3].

傳統的機器學習算法,尤其是有監督學習算法已經被廣泛應用在電影影評、產品評論和微博短文本等帶有主觀情感色彩的文本情感分類中[3-6],并且作為情感分類問題主流的算法,也取得了很好的研究成果.但是,有監督學習算法通常需要大量的標定數據來訓練情感分類器,并且要求訓練樣本和測試樣本應同分布以便共享信息[7].而網絡上評論信息涉及的領域范圍非常廣泛,為每一個領域手工標定足夠的訓練樣本是非常耗時耗力的[8].同時,不同的用戶在面對不同的評價主體時,評價角度和表達方式通常存在很大的差異,導致領域間信息非同分布.比如,“分辨率”、“電池”、“durable”等詞語經常會出現在電子產品的評論語料中,而極少出現在電影、書籍類產品的評論語料中;同樣,“紙質”、“印刷”、“misspelling”等詞語會頻繁出現在書籍類產品中,卻很少出現在電影、電子產品等的評論語料中.最后是情感詞的極性分歧問題,即同一情感詞在不同領域的語料中可能有不同的情感傾向.比如,“long”在廚房用具的評論語料中可能表示使用壽命長,是一個正極性的情感詞,而在書籍的評論語料中可能表示段落冗長,是一個負極性的情感詞.所以基于以上問題,很難將一個在源領域訓練好的分類器直接應用到一個全新的目標領域[9-10].

近年來,為了解決領域間差異造成的情感分類器準確率降低的問題.跨領域情感分類技術的研究得到了快速的發展,目前的解決方法主要從樣本、特征和主題3個方面的遷移進行研究.就特征遷移而言,主要通過一些策略尋找源領域和目標領域間的共享特征,構建跨領域數據的統一特征表示空間來消除領域間的差異[8-9,11-13].

為解決領域間差異造成的情感分類器準確率降低的問題,本文提出了一種基于多視角共享特征的領域空間對齊跨領域情感分類(domain alignment based on multi-viewpoint domain-shared feature for cross-domain sentiment classification, DAMF)算法.本文中的特征詞是指包含在各領域語料中的詞匯,通常分為有情感極性的特征詞(也叫情感詞)和其他特征詞(指描述對象等無極性詞匯).算法借助已有的情感詞典和改進的互信息(mutual information, MI)[8]技術,建立領域間無歧義共享特征集合,并通過句法分析和關聯規則算法進行領域間專有特征詞對的提取,實現領域詞典的擴展和領域間信息分布空間的對齊.同時,在Amazon產品評論數據集[11]上和已有的相關算法進行比較實驗,表明本文提出的算法在一定程度上提高了跨領域情感分類的正確率.

1 相關研究

如引言所述,目前解決跨領域的情感分類問題的方法主要有3種:基于樣本加權重采樣的方法、基于特征對齊的方法和基于主題模型的方法.

基于樣本加權重采樣解決跨領域情感分類問題的關鍵技術在于為原始領域的標定樣本采用加權策略,使訓練數據和測試數據有相似的分布,適用于源領域和目標領域的樣本分布差距較小的情況.主要的研究成果有:Dai等人[14]提出的TrAdaBoost的半監督算法,在訓練過程中通過加入目標領域少量的標定樣本,在優化損失函數的過程中,加強原始領域訓練樣本中與目標領域有相似分布的樣本權重值,減少與目標領域不相似的樣本權重值,使訓練過程更傾向于目標領域的分布,從而建立目標領域的情感分類器;Hu等人[15]提出了基于類分布的多領域自適應算法(muti-domain adaptation algorithm based on the class distribution, MACD),算法通過多個源領域的標定樣本訓練多個基礎分類器,并根據源領域和目標領域的類別分布距離來動態調整和選擇高置信度的標定數據加入訓練樣本集,使每一個原始領域都更好地適應目標領域,建立應用于目標領域的情感分類器的集成分類器.Li等人[16]首先通過主動學習的策略選取少量目標領域帶標簽的數據,然后用源領域和目標領域中帶標簽的數據訓練2個獨立的分類器,采用委員會投票算法根據2個分類器的結果作出最后的決策.

基于特征對齊解決跨領域情感分類問題的關鍵技術在于學習2個領域信息的統一特征表示空間,減少領域信息分布的差異,適用于因源領域和目標領域的樣本分布差距較大、很難在樣本層面找到2個領域間交集的情況.主要的研究成果有:Blitzer等人[9]提出了結構對應學習(structural correspondence learning, SCL)的算法,通過選擇原始領域和目標領域都頻繁出現的“樞紐”特征集合,建立學習“樞紐”特征和其他特征間的關聯關系模型,實現源領域和目標領域特征層面的對齊.Pan等人[8]提出了光譜對齊(spectral feature alignment, SFA)算法,通過改進的互信息來選取領域專有特征和領域通用特征,并通過在通用特征和專有特征建立的二部圖中進行圖譜聚類操作學習到新的特征表示,以領域通用特征為橋梁,實現領域專有特征的對齊,減少領域間的差距.吳瓊等人[7]提出了基于圖的隨機游走模型,通過利用源領域和目標領域的文本和詞之間的關聯關系來實現知識在領域間的遷移,借助圖迭代計算的思想對待標注文本計算情感分層,來判斷文本的情感傾向性.Glorot等人[17]提出了基于堆疊去噪自動編碼機(stacked denoising auto-encoders, SDA)的跨領域情感分類算法,通過深度神經網絡的隱層節點學習不同領域間通用的特征表示,通過通用特征構建新的特征空間,減少不同領域間特征分布的差異,實現源領域和目標領域特征的對齊.

基于主題的跨領域情感分類技術主要通過提取能代表不同領域文本的共有潛在特征(包括潛在主題、主要組成元素等)來減少領域間信息分布的差異.主要的研究成果有:Li等人[12]提出了主題關聯分析(topic correlation analysis, TCA)算法,通過提取領域間共享主題和各個領域的特定主題,計算各個領域特定主題間的相關性,利用相關性將各個領域的特征映射到新的特征空間,在新的特征空間訓練情感分類器,用于目標領域的情感分類.

這3種方法都是通過一定技術學習目標領域與源領域之間具有相同分布的樣本或者潛在的共享特征,并以具有相同分布的源領域樣本或者共享特征為橋梁,實現目標領域與源領域在樣本層面的對齊,來獲得領域間的統一特征表示空間.但是,當2個領域的數據分布差異非常大或者選取的共享特征存在極性分歧時,都將會導致跨領域情感分類器的準確率降低,甚至會出現負遷移[18].

2 一種空間對齊跨領域情感分類算法

2.1 總體框架

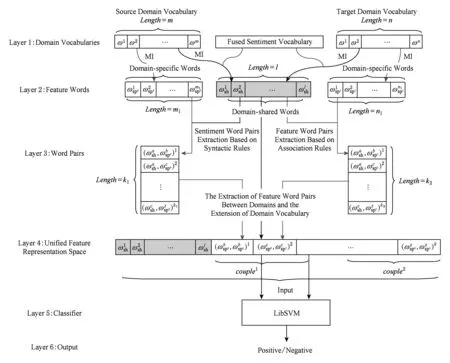

基于多視角共享特征的領域空間對齊的跨領域情感分類算法的總體框架如圖1所示.算法首先利用已有的情感詞典,建立無極性分歧的情感詞集合,并結合改進的MI[8]技術來選擇預處理后的源領域和目標領域語料中共享的無極性分歧的特征,構成共享特征集合.然后,通過句法分析和關聯規則算法,分別迭代地獲取各領域中具有相同極性的特征詞對和具有強關聯關系的特征詞對.在此基礎上,以領域間無歧義共享特征集合為橋梁,進行領域間專有特征詞對的提取,實現領域詞典的擴展和領域間信息分布空間的對齊.最后根據源領域對齊后的標定樣本訓練分類器,即可得到適用于目標領域的情感分類模型.

Fig. 1 Overview of our proposed algorithm for cross-domain sentiment classification圖1 基于多視角共享特征的領域空間對齊跨領域情感分類算法的總體框架

2.2 領域間無歧義共享特征集合的構建

本節我們將介紹如何從多視角構建領域間無歧義共享特征集合,為消除不同領域中情感詞極性分歧和對齊領域信息分布空間,并建立跨領域情感分類模型做基礎.

2.2.1 無極性分歧的情感詞集合的構建

情感詞典通常為待分析文本的關鍵情感詞提供極性參考,所以在情感分析系統中扮演著重要的角色.常見的英文情感詞典有:SentiWordNet[19],Bing Liu’s Sentiment Lexicon[20](下文簡寫為BLSentiLex),MPQA[21]等.這些情感詞典通常都是基于一定的語料庫進行統計手工標注或者利用算法學習獲得,包含情感詞的集合及其對應的極性等屬性.因語料庫的差異,不同的情感詞典包含的情感詞和其對應的極性不盡相同,如情感詞“defeat”在BLSentiLex[20]詞典中的情感極性為正極性,但是在MPQA[21]詞典中的情感極性為負極性.同時也有“good”,“wonderful”,“bad”,“worst”等情感詞在各詞典中的極性完全一致.所以為了消除情感詞的極性分歧,我們將常用的情感詞典進行融合,構建無極性分歧的情感詞集合.

3種英文情感詞典的詳細描述如表1所示.在對3種情感詞典中的情感詞進行清洗整理時,去除情感詞極性強弱、詞性等屬性信息,僅保留正負極性信息.在SentiWordNet詞典中,分別給出了情感詞的正負極性的分數值,我們通過計算情感詞正負極性分數值的差值來標注情感極性,即當差值大于0時,該詞的情感極性被標注為正極性;當差值小于0時,該詞的情感極性被標注為負極性;當差值等于0時,該詞的情感極性被標注為中性極性.在融合3個情感詞典時,通過選擇在3個情感詞典中均有出現的且具有相同的情感極性的詞,構成無極性分歧的情感詞集合來消除情感詞在不同語料中的極性分歧問題.

Table 1 Detailed Description of the Four Sentiment Dictionaries

Table 2 An Example of the Fused Sentiment Word Set表2 融合后的情感詞集合舉例

2.2.2 領域間無歧義共享特征集合的構建

除了消除各情感詞典因語料不同而造成的情感詞差異和極性分歧,我們還需確定在源領域和目標領域間共享的特征集合,以及各領域的專有特征集合.通過構建領域間無歧義共享特征集合,為實現領域間專有特征詞對的提取和領域間信息分布空間的對齊建立基礎.

在信息論中,MI技術通常是用來描述2個變量之間的關聯關系.在文獻[8]中,同樣采用MI的方法來衡量2個領域中的特征詞與領域間的關聯關系.如果1個特征詞與領域有較高的MI值,則認為該詞是領域的專有特征詞,否則認為該詞是領域共享特征詞.所以本文也采用同樣的方法進行領域間共享特征詞和專有特征詞的選取.

(1)

利用MI進行領域間共享特征集合構建時,僅考慮到特征詞在各個領域中和各領域間的出現頻率,所以會導致所選擇的共享特征集合中包含有極性分歧的情感詞.比如,在書籍和電子產品領域,用MI的方法,情感詞“easy”會被選為共享特征.但是“easy”在2個領域中存在極性分歧:在書籍領域中更多地表達了書籍過于簡單的消極情感,是負極性;在電子產品領域中更傾向于表達使用便捷、操作簡單的積極情感,是正極性.為了消除通過MI提取的共享特征集合中情感詞的極性分歧,本文將結合2.2.1節中構建的無極性分歧的情感詞集合,完成領域間無歧義共享特征集合的構建,確保所選擇作為橋梁進行領域專有特征詞對提取的特征極性的唯一性.

Fig. 2 An illustrative example of extracting sentiment polarity relations based on syntactic parsing and dependency parsing圖2 基于句法和依存關系解析的情感詞極性關系提取的示意圖

2.3 領域間專有特征詞對的提取

2.2節通過情感詞典和MI的方法構建領域間無歧義共享特征集合,并提取領域專有特征.本節我們將通過2種方法以2.2節構建的領域間無歧義共享特征為橋梁進行專有特征詞對的提取,實現領域詞典的擴展和領域間統一特征空間構建.

2.3.1 基于語法規則進行情感詞對提取

1) 相同極性的情感詞對挖掘

受文獻[22-24]的啟發,通常可通過4條規則來挖掘未標定樣本中情感詞的極性關系:①情感詞間用連詞“and”,“or”,“as well as”相連,并且沒有否定詞修飾時,可以推斷2個情感詞可能具有相同的情感極性.比如:句子“The spoon is very cheap and easy-to-use.”中的情感詞“cheap”和“easy-to-use”在修飾“spoon”時可以推斷它們具有相同的情感極性.②情感詞在沒有否定詞修飾和連詞相連的情況下并列出現來描述同一對象時,可以推斷它們可能具有相同的情感極性.比如:句子“It is a beautiful,durable,convenient table lamp.”中的情感詞“beautiful”,“durable”,“convenient”通常具有相同的情感極性.③情感詞用連詞“but”,“however”相連并且沒有否定詞修飾時,可以推斷2個情感詞可能具有相反的情感極性.比如:句子“This book is very beautiful but too easy for me.”中的情感詞“beautiful”和“easy”的描述對象都是 “book”,但是用轉折詞“but”相連,它們可能表達了相反的情感極性.④情感詞并列出現或者用“and”,“or”,“as well as”連詞相連來描述同一對象,但是有否定詞修飾時,可以推斷它們可能具有相反的情感極性.比如:句子“The battery of this camera is small and not durable.”中的情感詞“small”和“durable”用連詞“and”相連但是“durable”用否定詞“not”作修飾,所以它們可能具有相反的情感極性.圖2中用句法解析樹和依存關系分析,具體說明了利用上面的①~④條規則從評論語句中提取情感詞極性關系的方法.

僅通過一條符合4條規則的評論語句進行情感詞間極性關系判別時,會出現誤判的可能.比如,在電子產品領域中有一條評論語句為“This product has good and bad points.”根據判別規則,由于情感詞“good”和“bad”用連詞“and”相連,同時沒有否定詞修飾,可以判斷它們具有相同的情感極性,但是這明顯是一種誤判的情況.所以,本文將通過結合2個情感詞在領域的整個語料中,基于4條規則所提取到的情感極性關系來減少誤判的可能性.具體的2個特征詞的情感極性關系判別如式(2):

(2)

其中,ns和no分別代表特征詞ωi和ωj在語料中基于語法規則所提取的相同和相反情感極性關系的頻率.當PR(ωi,ωj)>0時,說明特征詞ωi和ωj有相同的情感極性;否則,特征詞間有相反的情感極性.本節需要提取所有具有相同情感極性關系的情感詞對,所以暫不考慮所有PR(ωi,ωj)<0的詞對.

2) 領域間相同極性的專有情感詞對提取

根據從目標領域和源領域中挖掘到的具有相同極性的情感詞對,并以2.2節提取的領域間無歧義共享特征集合為橋梁,進行領域間專有情感詞對提取的描述如算法1.

利用4條規則在語法解析的基礎上進行領域中相同極性的情感詞對的挖掘和領域間相同極性的專有情感詞對的提取,其結果通常有較高的準確率.但是,由于語料中能滿足4條規則可以進行極性關系挖掘的評論語句所占的比例非常小,比如在句子“What an amazing product for such a small price.”中,雖然可以推斷出情感詞“amazing”和“small price”有相同的極性,但是并不能通過4條規則進行極性關系的挖掘.所以該方法不能挖掘到所有包含在領域語料中具有相同極性的情感詞,也不能對領域間中性特征詞的關系進行挖掘,故僅通過語法解析進行領域間情感詞對的提取無法構建領域間統一特征空間.為了彌補這種不足,我們提出了第2種基于關聯規則提取領域間特征詞對的方法.

2.3.2 基于關聯規則進行特征詞對提取

1) 強關聯規則集的挖掘

關聯規則算法的主要思想是通過統計分析,挖掘事物之間的聯系.較常用的是Apriori算法,通過最小支持度來進行頻繁項集的挖掘,并利用頻繁項集和最小置信度來挖掘強關聯規則.本節將通過該算法挖掘領域中特征詞間的強關聯關系,并以領域間無歧義的共享特征集合為橋梁,提取領域間有強關聯關系的專有特征詞對,實現領域間統一特征空間的構建.

首先,記D={Ds,Dt} 為領域集合,包括源領域Ds和目標領域Dt,W為源領域和目標領域的特征詞集合,即

(3)

其中,專有情感特征集合Wsp由源領域的專有特征詞集合Wspt和目標領域的專有特征詞集合Wsps組成;Wsh為2個領域共享的無歧義特征詞集合;n,m,l分別表示目標領域、源領域專有特征詞數量及領域間無歧義共享特征詞的數量.

算法1. 領域間相同極性的專有情感詞對挖掘算法.

① for each (ωi,ωj) inPairt

② ifωi∈Wshandωj∈Wspt

SET1.add((ωi,ωj));

elseωj∈Wshandωi∈Wspt

SET1.add((ωi,ωj));

③ end if

④ end for

⑤ for each (ωi,ωj) inPairs

⑥ ifωi∈Wshandωj∈Wsps

SET2.add((ωi,ωj));

⑦ elseωj∈Wshandωi∈Wsps

SET2.add((ωi,ωj));

⑧ end if

⑨ end for

⑩ for each (ωi,ωk) inSET1 and (ωk,ωj) inSET2

Couple1.add((ωi,ωj));

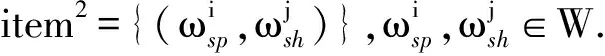

Apriori算法的主要思想是通過k項頻繁集的先驗知識和最小支持度min_s來生成k+1項頻繁集,并根據最小置信度min_c完成強關聯關系的挖掘.本文將通過Apriori算法進行各領域中特征詞間強關聯關系的挖掘.其中,用item1表示生成的1項頻繁集,item2表示生成的2項頻繁集.其中item1和item2表示為

頻繁集中的任意元素it的支持度都大于最小支持度min_s,支持度計算為

support(it)=P(it),

(4)

其中,it∈item1或it∈item2,P(it)表示it在樣本集中出現的概率.

在2項頻繁集中找到滿足最小置信度min_c并且由一個領域共享特征詞和一個領域專有特征詞構成的強關聯規則,強關聯規則rk的挖掘和置信度計算為

(5)

(6)

算法2. 強關聯規則集挖掘算法.

①L1=find_frequent_1_itemsets(W),ωi∈W;

②L2_candidate=apriori_gen(L1,min_s);

③ fo rwinReviews

Cw=subset(w);

④ forcinCw

c.count++;

⑤ end for

⑥ end for

⑦L2={c},c∈L2_candidateandc.count

∑c.count≥min_s;

⑧ forrinL2

⑨ if(support_count(r)support_count(r.ωsh))≥min_c

⑩RS.add(r);

2) 領域間強關聯關系的專有特征詞對提取

Fig. 3 Directed graph G: the description of strong correlation relationship between domain-shared words and domain-specific words圖3 有向圖G:描述領域共享詞和專有詞的強關聯關系

(7)

(8)

(9)

2.4 領域間統一特征空間的構建和分類模型的訓練

本節將結合在2.3.1節和2.3.2節中提取的領域間相同極性的專有情感特征詞對和領域間強關聯關系的專有特征詞對進行領域間統一特征空間的構建,具體構建過程如圖4前4層所示.并利用源領域標定樣本的統一特征表示來訓練跨領域情感分類模型,如圖4中的層5、層6.

Fig. 4 An illustrative example of training the cross-domain sentiment classifier圖4 訓練跨領域情感分類器的示例圖

(10)

在此基礎上,利用源領域中的標定樣本在領域間統一特征空間的映射,完成跨領域情感分類器的訓練.具體分類器的選擇,在第3節中選擇LibSVM[25]作為跨領域情感分類器,其中參數均為默認參數.

3 實驗設計與結果分析

本節使用本文提出構建領域間統一特征空間的方法,消除領域間情感詞的極性分歧和信息空間分布的差異,完成跨領域情感分類器的訓練,并且在Amazon產品評論數據集[9]測試了我們的方法.

3.1 數據集概述和預處理

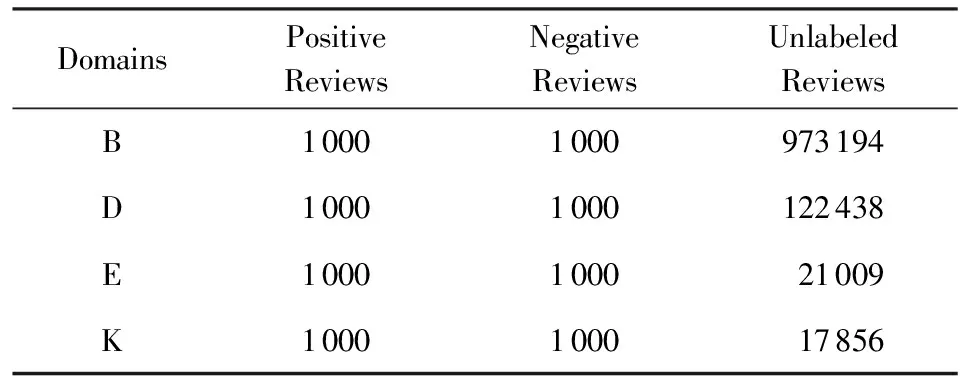

在實驗中,所采用的數據集是由Blitzer[9]收集的Amazon產品評論數據集,是被廣泛應用在跨領域情感分類的基準數據庫.數據庫中包含了4個領域的英文評論數據,分別是B(Book),D(Dvds),E(Electronics)和K(Kitchen)領域.每個領域中均有2 000條標定評論,其中1 000條是積極評論,1 000條是消極評論和若干條未標定評論.積極評論的情感標簽為+1,消極情感標簽為-1.表3是對Amazon產品評論數據集的詳細描述.

Table 3 Detailed Description of Amazon Data Sets Used for Experiments

各領域的特征詞集合都是由每條評論語句在去除停用詞、詞干提取、小寫轉換后的一元和二元混合語法形式組成.如“i_love”,“worth”,“right”,“a_great”等.同時,Pang等人[3]用實驗證明了采用所有詞作為特征,并且用一個詞出現與否作為權重,比使用詞出現的頻率作為權重,可以達到更好的情感分類效果.因此,在本文中也采用布爾值作為特征權重,即如果特征在評論語句中出現則權重為1,否則為0.同時,對于用于構建統一特征空間中的特征詞對,只要其中一個在評論語句中出現,則權重為1,否則為0.

3.2 實驗設計和結果分析

為了驗證本文所提出的基于多視角共享特征的領域空間對齊模型對跨領域情感分類的有效性,本文將4個領域的產品評論語料組成了12個跨領域任務:D→B,D→E,D→K,B→D,B→E,B→K,E→B,E→D,E→K,K→B,K→D,K→E,其中箭頭左側表示源領域,箭頭右側表示目標領域.在領域空間對齊階段采用的是2個領域所有的樣本;在分類器訓練階段也就是圖4中5,6層,我們使用LibSVM[25]作為跨領域情感分類器,其中參數均為默認參數.源領域中消極評論和積極評論各800條構為訓練數據,用目標領域消極評論和積極評論各200條進行測試.實驗涉及的超參數依次設置為:領域間無歧義共享特征個數l=600,最小支持度min_s=0.014,最小置信度min_c=0.08,關聯度閾值ε=0.005.為了避免實驗結果的偶然性,我們對每個實驗獨立重復進行5次,并取平均值作為最終的跨領域情感分類的準確率.選擇以下6種算法進行對比實驗.

1) NoTransf.不進行領域空間對齊,在源領域數據集上訓練LibSVM[25]分類器,直接在目標領域數據集上測試.

2) SCL[9].由Blitzer提出的結構對應學習算法進行跨領域情感分類.

3) SFA[8].由Pan等人提出的光譜對齊算法進行跨領域情感分類.

4) LP-based[16].由Li等人提出的基于圖排序的算法,實現情感標簽從源領域到目標領域的傳播,實現跨領域情感分類.

5) DAMF(Single).在DAMF算法中僅通過互信息進行領域間共享特征的選擇,并僅通過關聯規則(Apriori)算法實現領域空間的對齊.

6) DAMF.本文提出的基于多視角共享特征的領域空間對齊的跨領域情感分類模型.

6種算法的實驗結果比較如表4所示.

在表4中我們可以看出:

1) 無論哪一種方法,任務E→K和K→E的結果均優于其他10項任務,這表明Electronics領域與Kitchen領域相較于其他領域的相關性較大.

2) 5種跨領域情感分類的算法幾乎在所有子任務中均優于NoTransf,這表明在跨領域情感分類任務中,充分利用源領域和目標領域的樣本來實現樣本層面和特征層面的對齊,有助于提高分類的準確率.

3) DAMF與DAMF(Single)相比平均準確率提高0.42%,說明從多視角提取領域間共享特征,有助于消除共享特征詞的極性分歧,并以共享特征為橋梁,通過2種方式提取領域中相同極性的情感詞對和強關聯關系詞對,更有助于消除領域間信息分布的差異,實現領域空間的對齊,更有利于跨領域情感分類.

4) 在任務B→E,D→K,E→K中,本文所提算法DAMF的準確率略低于SCL和SFA,說明在一些情況下,基于語法規則和關聯規則,不能提取到潛在的強關聯關系,無法實現領域空間的對齊,使跨領域情感分類的準確率得到提升.

5) 總體上,DAMF與SCL,SFA,LP-based跨領域情感分類算法相比,在9個任務上的準確率均有提高,平均準確率達到了78.7%,說明通過以無歧義共享特征為橋梁挖掘領域專有特征間的關聯關系,有助于消除領域信息分布的差異,實現跨領域情感分類.

Table 4 Accuracy on 12 Subtasks of 6 Cross-Domain Sentiment Classification Algorithms表4 6種跨領域算法在12個跨領域任務上的準確率

Notes: The bold value in each cross-domain subtask means the best value.

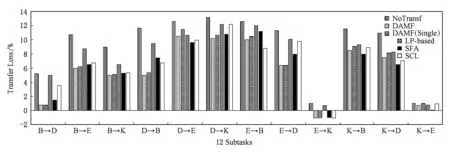

Fig. 5 The transfer loss of 6 cross-domain sentiment classification algorithms on 12 subtasks圖5 6種算法在12個跨領域任務上的傳遞損失率

為了進一步驗證本文所提算法的有效性, 我們分別計算了各算法在知識傳遞過程中的傳遞損失,結果如圖5所示.傳遞損失的計算公式為

t(Ds,Dt)=e(Ds,Dt)-e(Dt,Dt),

(13)

其中,e(Ds,Dt)表示采用領域空間對齊策略后,用源領域樣本訓練得到分類器,在目標領域測試時產生的誤差;e(Dt,Dt)表示以目標領域的標定樣本訓練分類器,并以目標領域的樣本進行測試所產生的誤差.t(Ds,Dt)表示采用跨領域情感分類所變化的傳遞誤差.

由圖5可看出在12個子任務中,不進行領域知識傳遞的NoTransf方法的傳遞損失最大.同時,在其中7個子任務中,相較于其他跨領域算法,本文所提出的基于領域間無歧義共享特征詞為橋梁,實現領域空間對齊的傳遞損失最小.在子任務K→E中,除不進行知識傳遞的NoTransf和LP-based算法,其他跨領域算法均出現傳遞損失為負的情況,說明電子產品領域的評論數據分布可能與廚房用品的評論數據分布相似,但由于源領域的標定樣本更豐富,所以導致預測的準確率更高,傳遞損失為負值.

3.3 參數分析

本節中,我們將分別進行實驗來探索在2.2節和2.3節中所涉及的4個參數:l,min_s,min_c,ε,在不同取值情況下對12個跨領域分類任務準確率的影響.實驗結果如圖6所示,它們分別代表這4個參數在不同取值時對準確率的影響.

Fig. 6 Effect of four parameters value on the accuracy of experiments圖6 4個參數的取值對實驗準確率的影響

在圖6(a)中,領域間無歧義共享特征詞個數l的取值為400~1 100,步長為100;并觀察到當l的取值范圍在500~700之間時,實驗結果的準確相對較高.當l取值較小時,部分可以作為領域間共享特征詞被丟失,導致相應的關聯關系丟失,所提取的詞對數量減少,所以實驗準確率相對較低;同時當l取值較大時,部分與領域相關度較大的特征詞會被誤選為共享特征,導致無法消除領域間的差異,使實驗的準確率降低.

在圖6(b)和圖6(c)中,通過設置最小支持度min_s和最小置信度min_c來進行關聯規則的學習,發現最適合的參數取值使實驗的準確率達到最高.從圖6(b)看出,設置min_s為0.002~0.02,步長為0.002進行實驗.當min_s的取值范圍在0.008~0.016之間時,有利于進行頻繁項集的挖掘,使分類的準確率較高;當min_s<0.008時,部分領域間共享特征和專有特征不會被選為頻繁項集,則導致部分規則被丟失,使準確率降低.同時從圖6(c)可看出,通過設置min_c為0.02~0.2,步長為0.02進行實驗.當min_c取值范圍從0.06~0.12之間時,分類器的準確率較高;當min_c取值較大時,由于較多的無關規則被保留,所以對于領域空間對齊產生了干擾,準確率較低;當min_c取值較小時,部分有用規則會被丟棄所以使某些詞對未能提取,領域空間不能對齊,也會使準確率降低.

在圖6(d)中,通過設置關聯度閾值ε為0.001~0.01、步長為0.001來進行分類器準確率的分析.從圖6(d)中可以看出,雖然某些取值會使實驗的準確率波動較大,但當ε取值為0.005或0.007時,對各任務分類的準確率都相對較高.

4 結 論

本文針對跨領域情感詞存在特征分布不一致性而導致的識別率低問題,提出了多視角共享特征提取和挖掘策略,在建立統一特征表示空間基礎上,實現了跨領域情感分類,提升了分類準確率,降低了知識傳遞的損失。已完成的主要創新工作和下一步工作如下:

1) 本文提出的基于多視角共享特征的領域空間對齊的跨領域情感分類算法充分利用了現有的情感詞典并結合特征詞的互信息值進行領域間無歧義共享特征詞的提取.以無歧義共享特征詞為橋梁,利用語法規則提取到的相同極性情感詞對和關聯規則算法學習到的領域中有強關聯關系的特征詞對,建立領域間專有特征詞的映射關系,構建領域數據的統一特征表示空間.實現了共享特征詞中歧義情感詞的消除和領域空間的對齊,提升了跨領域情感分類的準確性.

2) 本文工作中無論是通過特征互信息值來進行領域共享特征和專有特征的選擇,還是利用語法規則和關聯規則來進行相同情感詞對和有強關聯關系的特征詞對的提取,均可在未標定樣本集上進行,降低了對各個領域中標定樣本的依賴,減少了標注樣本所需的人力物力.擴大了算法在各個領域上的適用性,降低了對訓練樣本的依賴,提升了算法的泛化性能.

3) 本文所提算法僅以有共現關系的領域無歧義共享特征詞為橋梁,完成領域間專有特征詞的映射.所以當2個領域間信息分布差距較大、共現的特征詞較少、挖掘到的領域間特征詞對較少時,無法實現領域空間對齊,如任務B→K和D→E.所以未來的研究工作將同時考慮如何利用多個源領域的語料來輔助單個目標領域的情感分類問題,以及如何充分利用各領域中的未標定數據基于數據驅動挖掘領域間潛在的關聯關系,完成領域公共特征空間的學習.