基于視頻序列的人體三維重建

吳濤,葉煉,柯穎悅

(武漢理工大學,湖北武漢,430000)

引言

基于圖像的三維重建的研究目的是利用計算機對物體二維圖像信息進行處理,進而得到物體的三維信息,還原出其三維模型。人體三維重建是三維重建技術的一個重要方面,廣泛用于醫學、人體測量、游戲等領域,具有相當高的研究價值。

人體三維重建的方法主要有基于點云的方法、基于圖像的方法、基于點云與圖像相結合的方法。

基于點云的方法,是利用激光掃描儀采集人體表面的點云信息,,然后對簡化處理采集得來的點云數據,之后對處理后的點云數據進行三角網格化,最后恢復出人體的三維表面模型。基于點云的方法可以有效得到高精度的三維人體模型,但其成本較高,且對計算機資源有較高的要求,所以它主要應用于一些對精度有特殊要求的場景。基于點云的方法的主要步驟包括以下幾步:

(1)點云數據采集

首先利用三維掃描儀獲得人體的點云信息,由于在掃描過程中易受到外界環境因素的干擾,因此,需要對點云數據進行預處理。剔除點云數據中的不穩定點和錯誤點。另一方面,普通的掃描儀得到的點云數據比較稠密,如果直接進行使用將花費不必要的計算機資源。因此,還需要對得到的點云數據進行簡化處理以簡化后續處理的計算與存儲。

(2)點云配準

利用公共區域的同名點進行兩兩匹配,將多組點云數據映射到一個統一的世界坐標系。新的點云數據為后續的統一計算提供了便利,其中最典型的精配準方法為ICP算法。

(3)三維重建

多組點云數據在配準后出現的點云重疊與冗余問題,需要對點云數據去冗余。對簡化的點云數據進行三角網格化處理,進而恢復出三維人體模型,它展示了人體的三維表面信息。

基于圖像的方法,即使用直接拍攝到的照片進行三維重建。其三維重建方法主要有立體視覺法、運動圖像序列法、光度立體學等。基于視頻序列的三維重建方法是從SFM技術[1-3]出發,該技術可以同時恢復相機的運動軌跡和三維結構。

基于點云的方法盡管精度較高,但是無法獲得物體的紋理信息且成本高昂,而基于圖像的的方法速度受到限制孩子,精度也不夠高,而基于結合點云與圖像的深度相機的方法結合了前面兩種方法的優點,利用深度相機可以得到物體的幾何結構與紋理映射,進而得到較高真實度的三維模型。

1 主要技術

1.1 相機標定

計算機視覺研究領域有三種常見的坐標系:像素坐標系、圖像坐標系、相機坐標系。我們采用針孔模型,使用SFM[1-3]算法同時得到場景的三維結構和相機姿勢。

1.2 深度恢復

在這一階段,我們對已選取的若干段視頻序列的每幀圖像求解深度圖,使用圖像分割技術來提升部分沒有特征區域深度恢復的質量,最后對前述序列進行集束調整的迭代以優化圖像序列。

1.3 特征匹配

特征匹配主要用來進行圖像之間的檢索,特征匹配的方法主要有由Lowe[4]等人提出的SIFT尺度不變特征變換算法、由Bay[5]等人提出加速魯棒的SURF算法、由Rosten[6]等人提出的FAST算法,SIFT算法具有對光不敏感、尺度不變性和旋轉不變性等優點[1]。故本文采用SIFT算法進行特征匹配。

2 多序列特征匹配與模型重建

2.1 多序列特征匹配

特征匹配的結果會影響到序列對齊的質量,這決定了三維模型重建結果的準確性。通常的雙目立體視覺是建立在對應點的視差基礎上,因此兩幅圖像中各點的匹配關系成為立體視覺技研究中的一個極其重要的問題。如果視角發生很大變化,會造成尺度和光照的明顯變化,圖像之間會發生一定的旋轉。這些因素對特征匹配有很大的影響。人們研究了許多約束方法來減少對應點的匹配錯誤,期望達到更好的匹配效果,通常特征匹配的方法是相關匹配。在這里,我們選擇SIFT用作特征描述子用于序列間的特征匹配。

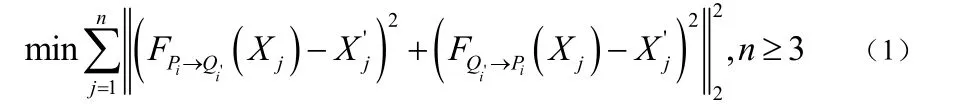

首先,分別取兩幅圖像序列,我們把P中的每一幀圖像和Q中所有的進行特征匹配,即總共有組圖像進行特征匹配。然后從這些組中選出一組匹配點的重投影誤差最低的圖像組,公式化的表達形式如式(1):

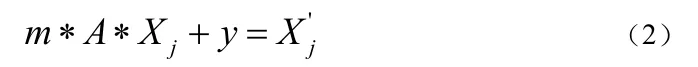

目標函數是使得式(3-1)達到極小值,在實際沒有切實簡單的方法直接優化上式并求解。因此,為了簡化求解過程,我們做了適當的假設,假設在兩個序列P和Q間存在且只存在一個相似變換,這樣序列P中的點和序列Q中與其相對應的點之間存在這樣的對應關系,如式(2)所示:

其次,假設已經知道了k個相對應的點,序列P中的記為和序列Q中的記為,那么要解決的問題變成了下式(3):

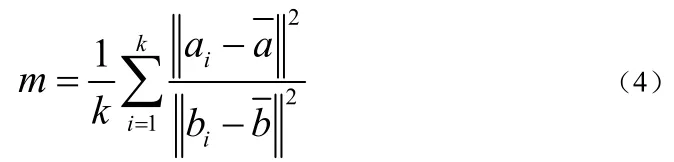

為了簡化求解過程,我們先根據匹配的特征點確定尺度變量m,依式(4)所示:

式(4)中的和分別是a和b的重心。在確定了以后,那么上面的式(3)可以變化寫成下式的(5):

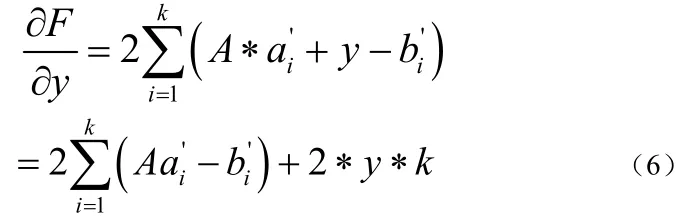

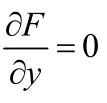

其中的。假設A不變,對F關于y求導得到下式(6):

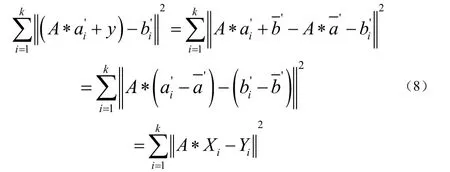

將式(7)中關于y的表達式代入式(5)可以得到如下式(8):

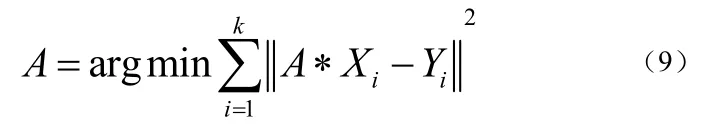

據此可以推導出式(9):

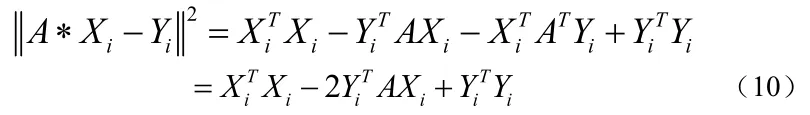

然后將(9)中的表達式展開計算可得到如下式(10):

最初的問題轉化為(11):

上式中的X和Y都是3k′的矩陣,在代數中tr代表矩陣的跡。

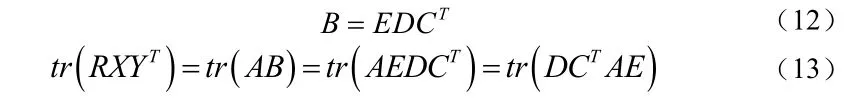

令,對B做SVD分解,如下式(12)所示:

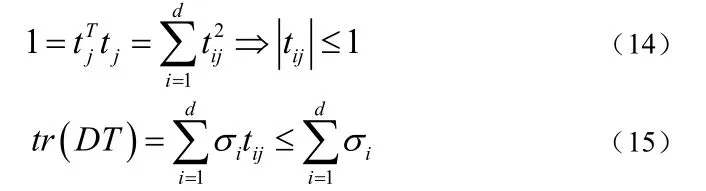

E和C都是正交矩陣,由正交矩陣的性質,可得同樣也是正交矩陣,那么可以得到下式(14)和式(15)所示的關系:

由式(15)可知,如果要使達到極大值,就必須使得,而T是正交矩陣,故T必然是單位矩陣,即可以得到下式(16)

依照上式(16)求出的正交矩陣必定是最優的,可是也有可能這個矩陣是反射矩陣。所以,一旦我們求解得到的矩陣是反射矩陣,那么我們還需要調整相應的結果,尋求下一個相對最符合要求的次優解[7]。

因為不同序列的圖像之間的視角變化差異較大,為了降低因視角變換給求解所帶來的負面影響,對于每幅圖像,我們都會在多視角下生成不同的投影[8-9]。

對于每一幅投影圖像,我們都會進行特征檢測和匹配,然后再把匹配的結果投影到原始給定的圖像上。

在求解SRT時,深度誤差的產生會對結果產生影響,為了解決這個問題,我們采用了基于RANSAC的迭代分層式求解方法。

在初始狀態,我們使用的所有匹配的特征點計算 SRT。理論上,只有三個相應的點可以計算為SRT。根據從上層獲得的SRT,我們計算匹配點的投影誤差,如公式(1),然后拒絕匹配點的重投影誤差大于一定的閾值,并保留匹配點應用到下一級的輸入。

必須要注意的是,在初始層的時候,要選擇比較大的重投影誤差閾值,這一措施保證了正確的匹配點不被錯誤的剔除掉。隨著層數越大,重投影誤差閾值隨之動態逐漸減小。通過這些方法,我們可以逐層消除重投影誤差較大的點。保留下來的匹配圖像對其中的大部分都可以保持顏色的一致性和幾何的一致性,有可能仍然存在誤差較大的圖像對,因此不能用所有的圖像對參與SRT的計算,我們從所有的有效匹配圖像中選出重投影誤差盡可能小同時匹配特征點數盡可能多的一對圖像進行SRT的求解。

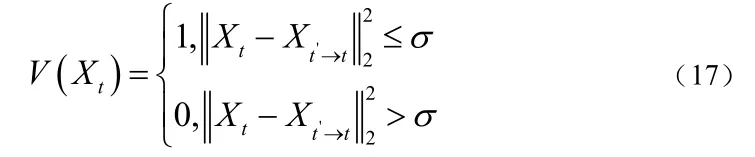

考慮到需要持續減小深度誤差對特征匹配的干擾,在特征匹配之前,我們需要對深度圖進行一致性檢驗。對于每一個位置,利用深度投影到相鄰多幀 ,然后通過反投影到當前幀,如果重投影誤差大于某一閾值,則標記當前位置的深度值無效。如下式(17),表示處深度值是有效地,否則表示無效。

結果發現,如果匹配點聚集在圖像的一個小區域,就會產生較大的對齊錯誤[10]。因為假設利用歐式距離計算出所有的匹配點對很近,那么根據這些點對計算得到的SRT更容易受到深度值的影響,深度上的的極小的誤差也會造成對齊結果的很大偏離。考慮到這些,我們對匹配的特征點對進行稀疏采樣:對一對新的匹配點,檢查鄰域范圍內是否存在其他的匹配對。如果有,把這個放在賽點上。事實上,這種方法相當于在特征點均勻分布上的施加了限制。

2.2 多視圖融合

多視圖融合的目的是獲得每幀深度圖所對應的三維點集,并通過重投影深度誤差統計剔除部分不精確的三維點;然后將多幀的三維點集合并成場景整體的三維點云,并剔除其中重復冗余的三維點;得到可靠性較高但規模較小的點云。

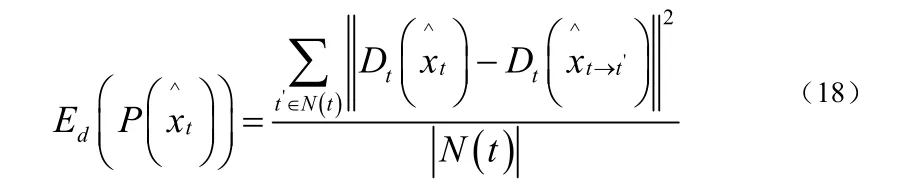

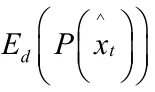

本部分采取基于多視圖深度采樣[11]的方法。首先獲得每幀深度圖的三維采樣點集合,然后給每個三維采樣點統計其在相鄰幀上的投影深度誤差,根據給定的閾值,剔除誤差較大的三維點,深度誤差計算方法如下式(18):

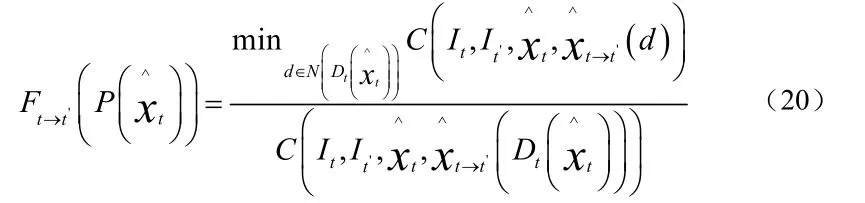

對三位采樣點集合進行多幀之間的融合以獲得場景完整的三維點云,相對而言,最簡單直接的融合多幀三維采樣點的方法是取交集。然而多幀視圖之間存在許多重疊區域,這會導致直接求交集所獲得的三維點云存在很多冗余的三維點,重復的三維點集不僅會大大增加云數據量還會降低模型的精確度。所以接下來需要對每個三維采樣點計算深度置信度,剔除掉重復的三維點,通過置信度排序實現多幀三維點采樣點的無重復融合。利用三維點在相鄰幀的重投影顏色誤差來計算其深度置信度,以此衡量該點的精度,置信度計算方法如下式(19)

為二維點利用深度重投影的投影點,表示神隊友鄰域范圍內的2K個深度值集合,表示像素衍射差值平方和誤差。

把所有采樣點的深度置信度都計算之后,依照置信度由高到低的順序對每幀的三維點集合進行排序并剔除不精確采樣點。然后依據歸并排序的方法對視頻序列中的若干幀三維采樣點進行排序。為了排除合并和排序過程中的重復采樣點,我們以當前采樣點為中心半徑R的窗口區域投影到相鄰多幀,并去除投影區域中的每一個三維采樣點。利用上述方法尋找并移除所有其余幀上的重復采樣點,從而保證融合而成的三維點云中不存在重復冗余。由于依照深度置信度由高到低的順序做歸并排序,因此能夠保證融合成的三維點云具有最高的精度,同時剔除較低精度的重復三維點。

3 基于模版的深度優化

3.1 Daisy描述子

Daisy是一種用于稠密特征提取的快速計算局部圖像特征描述子。它的本質思想是分塊統計梯度方向直方圖。不同于SIFT,Daisy改進了分塊的策略,利用高斯卷積進行分塊匯聚,因此利用高斯卷積的可快速計算性可以快速稠密地提取特征描述子。

3.2 魯棒的模版與模型對齊方法

對齊方法是三維重建領域研究的一個重要問題。常用的對齊方法有迭代最近點算法和基于RANSAC的算法。兩種算法均需要提供初始的對應點,當點集的狀態差別很大,算法就不適用了。

針對這個問題,提出了一種新的模型對齊方法。人體模型的主方向是沿著身高的方向,次方向是沿著兩臂伸展的方向的。利用這一事實,我們的模型對齊方法基于PCA技術[12]。PCA技術用于減少數據的維度,不僅能保留主要成分,還能消除干擾的噪音。對數據降維而言,假設每個人體模型最多只允許由三個最主要的分量描述,那一定是身高、腰圍和胸圍這類信息。

我們的模型對齊方法包括主成分分析、模板與模型的對齊和模板變形三個步驟。以下僅介紹對齊和變形部分。

3.3 模板與模型對齊

假設已經知道了兩個模型的三個主方向。由于分解得到的三個主方向是線性無關的,所以可以由三個主方向向量對確定旋轉矩陣。

為了確定兩個模型之間的尺度,我們把模型上的所有點投影到第一個主方向上,記錄投影點的最遠距離和最近距離。

顯然,因為不同人體模型的質量重心和幾何中心并不重疊,所以如果計算簡單的平移,模型對齊的結果會產生一定的偏差從而影響最終的建模結果。

我們可以選擇一個體型等各方面都是標準的人體模型作為實驗目標模型,把數據庫的 平均模型作為待對齊模型,獲取一個大致對齊的結果。

事實上,由PCA技術確定的模型的主方向,其朝向并不顯而易見,這會影響模版對齊的結果。想要解決這個問題,可以利用地平面數據和相機的朝向信息。

3.4 模板變形

上面提到的待對齊模型是選擇一個三維人體模型數據庫,然后對其中的所有模型數據進行平均獲得的,用R表示,參考模型是經過多段圖片序列融合而得到的,用S表示。我們對R應用4.3中的方法,可以獲得一個大致對齊的模型。但R和S之間仍存在較大的對齊誤差,因為上面的方法只能解決模型之間主方向的對齊的問題,而并不能解決模型之間的胖瘦程度不一致的問題,因此我們還需要對R進行變形[13]以得到一個與S更加接近的結果。

模板變形的過程使用一個計算幾何開源庫 CGAL[14]。此外在計算控制點形變位置的過程利用相鄰采樣點加權的方式,可以在一定程度上提高模型的平滑程度。

4 結束語

本文提出了一種人體三維重建方法,即基于視頻序列,利用多序列特征匹配和模版約束兩種方法的的人體三維重建方法。我們的系統為了實現多序列特征匹配,利用了一種基于RANSAC的迭代分層式求解法,這種方法可以有效消除由于深度誤差帶來的影響。為了剔除背景點的干擾,我們通過引入深度信息,對匹配的特征點對投影來實 現。為了減少求解SRT的數值上的誤差,我們對匹配特征點進行均勻采樣。此外,為了防止出現特征過少,我們對原始的序列分別生成多個視角的圖像,在各個視角進行特征檢測和匹配,這種方法對特征匹配的穩定性有極大的提高。

[1]Snavely N, Seitz S M, Szeliski R.Modeling the world from internet photo collections[J].International Journal of Computer Vision, 2008, 80(2):189-210.

[2]Lourakis M I A, Argyros A A.SBA:A software package for generic sparse bundle adjustment[J].ACM TRANSACtions on Mathematical Software(TOMS), 2009, 36(1): 2.

[3]Wu C.VisualSFM:A visual structure form motion system[J].URL://home.CS.washington.edu/-ccwu/vsfm, 2011, 9.

[4]Lowe D G.Distinctive image features from scale-invariant keypoints[J].International journal of computer vision, 2004, 60(2): 91-110

[5]Bay H,Tuytelaars T, Van Gool L.Surf:Speeded up robust features[M]/Computer vision-ECCV 2006.Springer Berlin Heidelberg, 2006:404-417

[6]Rosten E, Drummod T.Machine learning for high-speed corner detection[M]/Computer Vision-ECCV 2006.Springer Berlin Heidelberg,2006: 430-443

[7]Sorkine O.Least-squares rigid motion using svd[J].Technical notes, 2009,120: 3.

[8]Yu G, Morel J M.Asift:An algorithm for fully affine invariant comparison[J].Image Processing On Line, 2011.

[9]Wu C, Clipp B, Li X, et a1.3d model matching with viewpoint-invariant patches(vip)[C]//Computer Vision and Pattern Recognition,2008.CVPR 2008.IEEE Conference on.IEEE, 2008: 1-8.

[10]Tan W:Liu H,Dong Z,et a1.Robust monocular SLAM in dynamic environments[C]//Mixed and Augmented Reality(ISMAR), 2013 IEEE International Symposium on.IEEE.2013: 209-218.

[11]姜翰青, 趙長飛, 章國鋒, 等.基于多視圖深度采樣的自然場景三維重建[J].計算機輔助設計與圖形學學報, 2015, 27(10): 1805-1815.

[12]Bro R, Smilde A K.Principal component analysis[J].Analytical Methods,2014, 6(9): 2812-2831.

[13]Chao I, Pinkall U, Sanan P, et a1.A simple geometric model for elastic deformations[C]//ACM Transactions on Graphics(TOG).ACM, 2010, 29(4):38.

[14]Fabri A, Pion S.CGAL:the Computational Geometry Algorithms Library[J].Sandia National Laboratory, 2009, 30(200009): 538-539.