基于Kinect的手勢圖像識別研究*

金宏碩,劉振宇

(沈陽工業大學信息科學與工程學院,沈陽110870)

1 引言

手語識別作為一種人機交互方式,越來越受到人們的重視。相比于鼠標和鍵盤等人機交互方式,手語識別更加簡單化、自然化和直觀化。手語不但可以維持聾啞人的日常生活,而且在人工智能等方面具有很大的研究價值,所以手語手勢識別具有廣泛的應用前景。

早期的手語識別主要是應用數據手套等傳感器設備采集手部姿態信息進行手勢識別,如Zhang等人[1]通過手上佩戴的加速度傳感器采樣XYZ三個方向的加速度值作為手寫的阿拉伯數字軌跡特征,然后使用隱馬爾可夫模型對加速度特征序列進行訓練和識別,最后在420個樣本的數據集上取得了94.3%的識別率。Fang等[2]利用三個位置跟蹤器獲取雙手的方向、位置和運動軌跡信息,同時利用2個數據手套獲取雙手手型特征,并結合運動過渡模型(transition movement models)對由中國手語構成的句子進行識別,平均識別率為91.9%。基于數據手套的識別方法穿戴復雜,手套和位置跟蹤器等設備價格昂貴,嚴重影響了人機交互的自然性。

近年來隨著技術的不斷發展,基于視覺的手勢識別逐漸成為主流。鄒節華等人[3]通過對單個攝像頭采集得到的數據采用運動檢測、膚色提取手勢區域,然后采用Mean Shift跟蹤算法獲取手勢軌跡,并采用隱馬爾可夫模型對手勢進行識別。翁漢良等[4]利用顏色特征檢測膚色區域分割人手,根據人手的輪廓及凸缺陷來檢測指尖,利用指尖數目和方位來表示手勢,進而完成手勢識別。基于膚色和顏色等檢測方法容易受到復雜背景和光照等條件的影響且識別精度不高。

2013年5月微軟推出了新一代用于Xbox One的體感外設3D攝影機Kinect 2.0。它可以獲取拍攝圖像的深度信息,具有即時動態捕捉、影響辨別、語音識別和手勢識別等功能。Zhou等[5]提出基于Kinect的手勢識別方法,利用FEMD(finger-earth mover's distance)算法實現穩定的靜態手勢識別,該算法需要大量的數據進行訓練。王松林等人[6]通過Kinect釆集和分割手勢圖像,通過K曲率算法識別靜態手勢,并將靜態手勢結合DTW算法識別預先定義的六個簡單的動態手勢(前進后退等)控制機器人的行動。Gu Y等人[7]利用Kinect攝像機從人體骨架中提取特征,并使用隱馬爾可夫模型對手勢動作進行訓練和測試,但該方法平均識別率不高。Hasnain Heickal等人[8]利用Kinect捕捉人體關鍵部位關節點的運動特征作為特征矢量,通過神經網絡和樸素貝葉斯兩種方法進行分類,正確率分別達到98.11%和88.84%,但是實時效果不好。

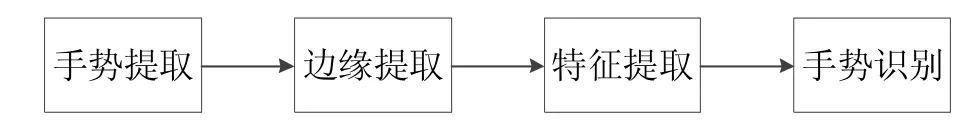

本文采用Kinect深度攝像機采集手語深度圖像,有效避免了光照和復雜背景對手勢提取的影響,并采用了支持向量機、神經網絡和隨機森林三種分類器方法,對采集到的不同角度的手語手勢圖像進行識別。手勢識別的基本流程如圖1所示。

圖1 手勢識別流程

2 手勢ROI區域提取

采用Kinect設備對手勢圖像進行提取,既可以拍攝深度圖像又可以拍攝彩色圖像[9]。如圖2所示即為深度圖像的一個示例。通過對深度圖像進行處理,可以獲得手部圖像。

圖2 深度圖像

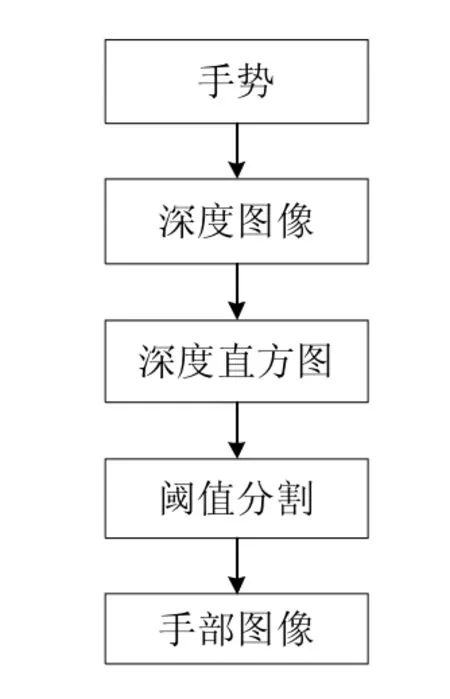

利用深度圖像進行手勢提取的流程如圖3所示。

圖3 分割手部圖像流程

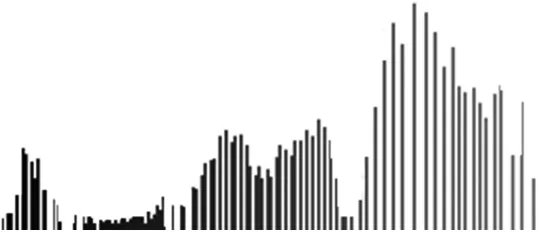

首先應用Kinect設備直接對手勢進行拍攝采集,得到手部深度圖像。對于深度圖像來說,手掌區域是距離Kinect最近的區域,所以手部深度值和身體部分深度值之間會有很大差異。再通過對深度圖像進行計算,得到深度圖像的深度直方圖[10]。深度直方圖可以很好地反應出深度值在距離區間上的分布,從深度值出現的頻率和聚集上可以很好地看出分組情況,所以可通過確定閾值來區分手勢區域和背景區域。圖4為深度直方圖示例,其橫坐標為距離區間,縱坐標為該距離區間上的像素點的數量。

圖4 深度直方圖

通過深度直方圖可進行閾值的選取。通過對深度直方圖的觀察發現,像素點大致集中在三個距離區間上,第一個區間即是手掌區域,第二部分即是手臂和測試者身體部分的像素集中點,最后一部分則是測試者身后的背景區間像素點。采用第一部分與第二部分之間像素點最小值作為手部閾值分割點。在深度圖像中,將距離小于閾值的所有像素點判定為手掌區域,并將數值改為“1”,大于閾值部分的像素點被舍棄,將數值改為“0”,由此完成了圖像的二值化,得到二值手勢圖像,如圖5所示。

圖5 分割出的二值化手部圖像

3 手勢圖像預處理

對采集到的手部圖像進行處理可以去除噪聲和冗余信息,從而減少計算量,加快運行速度。圖像邊緣是圖像特征選擇中的一個非常重要的基礎特征,它可以保留原始圖像的大部分信息,是圖像特征提取的關鍵[11]。

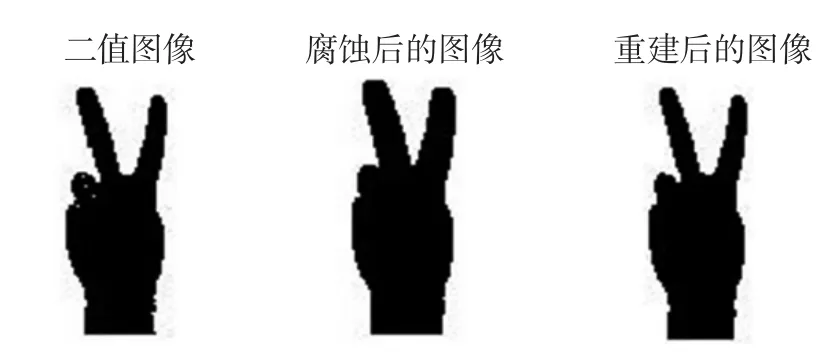

首先對二值手勢圖像進行腐蝕運算和形態學重建,即腐蝕形態學重建,這樣可以消除邊界點、平滑手勢圖像邊界,并且不會改變手勢區域的面積。

腐蝕是一種消除邊界點、使邊界向內部收縮的過程,它可以用來消除小且無意義的物體。腐蝕形態學重建就相當于開運算,先對圖像進行腐蝕導致圖像中高亮部分像素被侵蝕,使效果圖擁有比原圖更小的高亮區域。而后進行形態學重建操作可以正確恢復腐蝕后的圖像物體形狀,使圖像內部的空洞沒有全部被填充,確保手語區域的完整性與精確性。上述腐蝕形態學重建處理過程如圖6所示。

圖6 手勢圖像腐蝕形態學重建處理

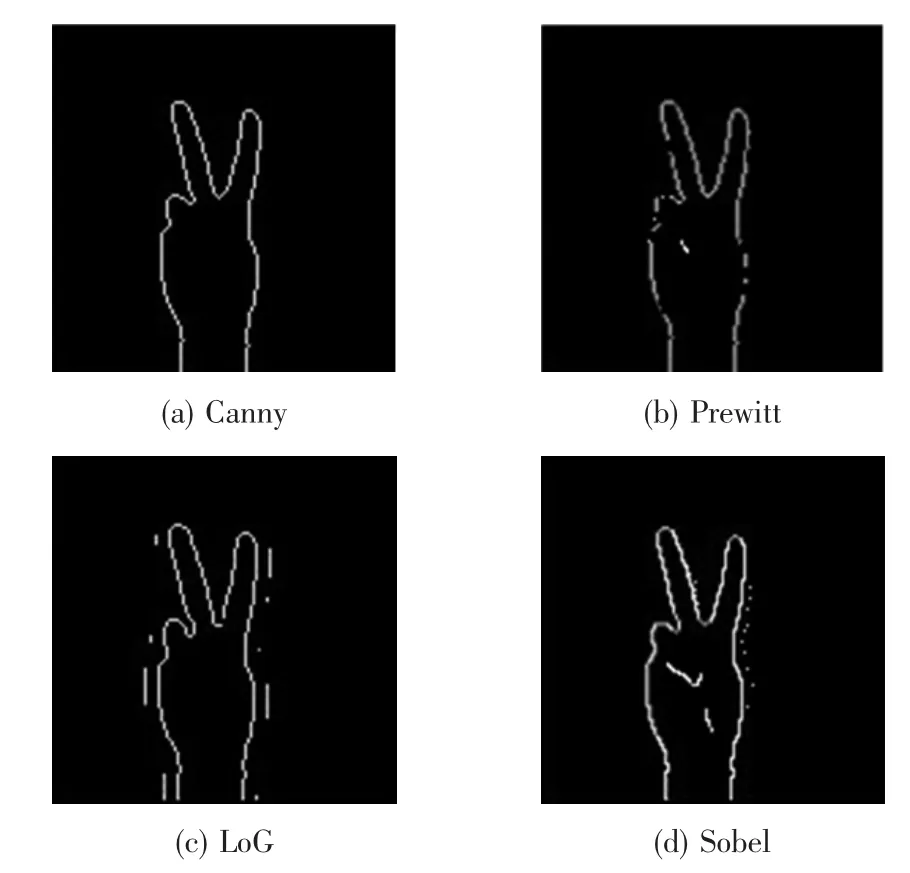

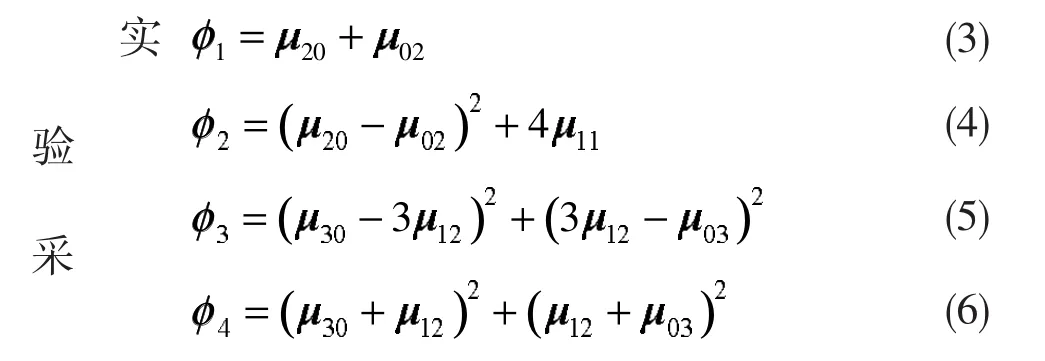

然后對處理過的手勢圖像進行邊緣提取,分別使用Sobel算子、Prewitt算子、LoG算子及Canny算子,以四種不同邊緣檢測算法進行對比實驗。對比效果如圖7所示。

圖7 四種不同算法的邊緣檢測效果對比圖

通過比較,最終選用Canny算子邊緣檢測方法對手勢圖片進行邊緣提取。Canny算子根據對信噪比與定位乘積進行測度,可以得到最優化逼近算子。它能夠檢測到圖像邊緣的精確位置,同時也對噪聲具有很強的抵抗能力。用該算法提取手語圖像的最大外輪廓,既能保證提取輪廓的完整性又能確保邊緣輪廓的連續性,對后續提取Hu矩輪廓特征點的精確性具有非常重要的作用。

4 Hu矩特征提取

特征提取是手語識別的關鍵步驟,選取好的手勢特征對手語識別的成功率有重要作用。由于采集到的每張手語圖像存在平移、大小和旋轉等變化,在特征提取時手語邊緣圖像特征值會改變,所以采用提取手部Hu矩特征的方法[12]。Hu矩特征具有平移、縮放和旋轉不變性,對識別結果影響較小。Hu矩共有七個矩,是由圖像的二階矩和三階矩組成的,包含了圖像面積、重心與對稱性等特征。

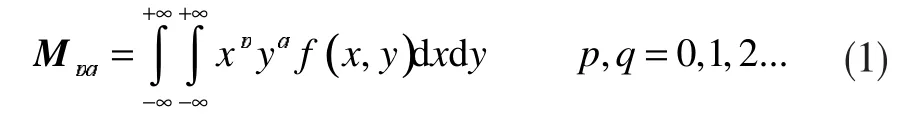

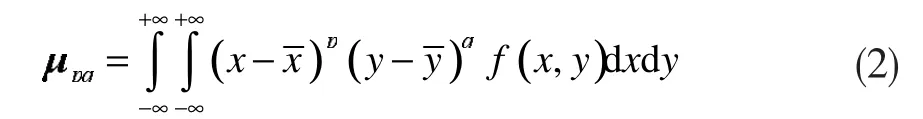

對于手勢圖像f(x,y)來說,它的(p+q)階二維原點矩Mpq的定義為:

相應的中心矩為:

重心坐標為:根據中心矩的定義,可以推出中心矩μ10和μ01均為0。

矩的物理意義為:零階矩表示圖像的面積;一階矩可以確定圖像的灰度重心;二階矩也稱慣性矩,可以確定圖像主軸、圖像橢圓長短半軸等特性;三階及三階以上矩,主要描述了圖像的細節,包括圖像投影扭曲程度和圖像投影峰度等。矩還具有平移變換、比例變換、旋轉變換、反射變換和增強變換等特性。

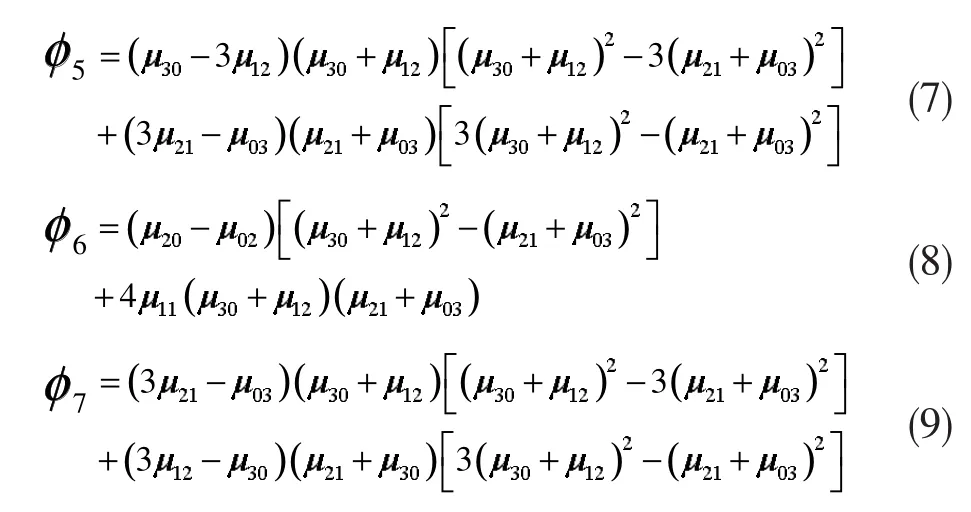

由于直接用原點矩或中心矩作為圖像特征不能保證特征同時具有平移、縮放和旋轉不變性,所以由二階矩和三階矩中心矩的線性組合構成七個不變矩,可以確保圖像同時具有平移、縮放和旋轉不變性。表達式如下:

集了七個Hu矩特征量作為手語圖像的要功能是解決在樣本數量有限的情況下的模式識別問題。其基本思想是在樣本空間或特征空間構造出最優超平面,使超平面與小同類樣本集之間的距離最大,從而達到最大的泛化能力。

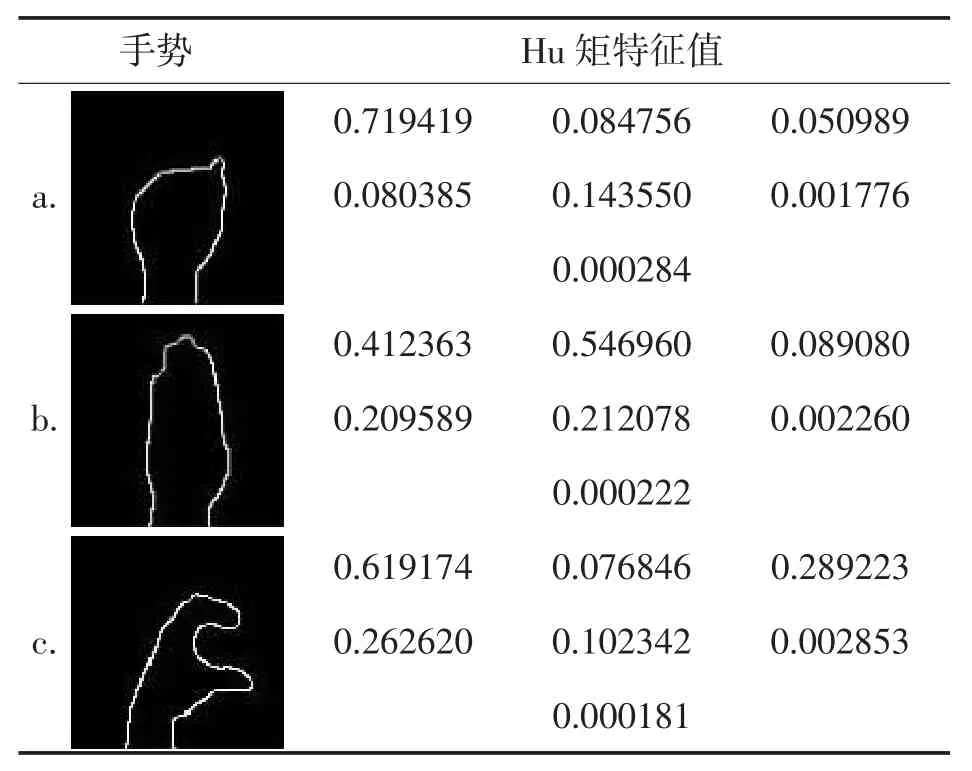

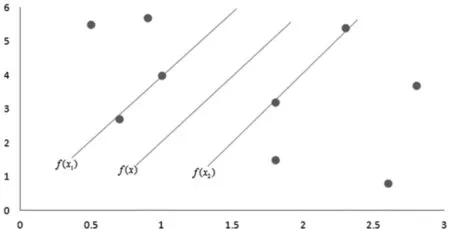

圖8為二維線性可分的情況,其中f(x)為分類線,f(x1)和f(x2)分別為兩類樣本中過離分類線最近的點且平行于f(x)的直線,f(x1)和f(x2)之間的距離稱為兩類的分類間隔。特征向量,φ形成特征集合表1列出了手語a、手語b和手語c的邊緣圖像所對應的七個Hu矩特征值。

表1 不同手勢Hu矩特征值

由于在手語采集過程中會發生旋轉、平移和縮放,影響手勢的識別效果,采用Hu矩特征則可以很好地解決這些問題,其描述的圖像特征具有很強的代表性,涵概了圖像的很多整體特征,而且數據少,識別速度快。

5 手語識別

在手語識別階段,分別采用了支持向量機[13]、神經網絡[14]和隨機森林[15]三種分類方法進行研究,并對三種手語識別方法進行了實驗與分析。

5.1 基于支持向量機的手語識別

首先對支持向量機進行分類識別研究,介紹它的基本原理、核函數及相關參數的選取。實驗中,將前面提取的手勢邊緣Hu矩特征數據以N×7的矩陣作為支持向量機訓練集的輸入,N為訓練樣本數,再將M×7特征數據作為測試集的輸入,M為測試樣本數,最終得到不同手勢的識別率。

支持向量機是一種新型的機器學習方法,其主

圖8 二分類示意圖

SVM的基本思想是尋找一個可以將兩類樣本分開的最優分類線,使分類間隔最大。設判別函數為

其中f(x)為訓練類別標簽;W是權重函數;x為訓練樣本特征。

當f(x)=0的時候,即為決策邊界,f(x1)和f(x2)上的樣本稱為支持向量。對判別函數進行歸一化后兩類樣本都滿足分類間隔為滿足的樣本就是f(x1)和f(x2)上的支持向量。

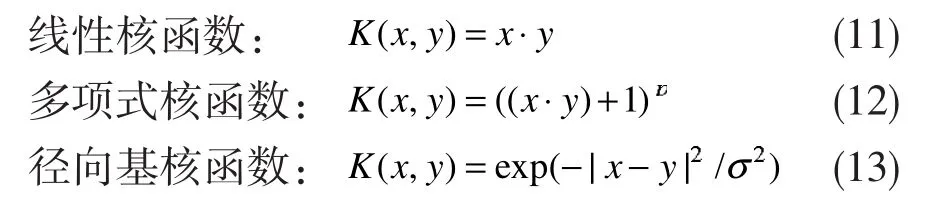

支持向量機的優勢主要體現在解決線性不可分問題,它通過引入核函數,巧妙地解決了在高維空間中的內積運算,從而很好地解決了非線性分類問題。常見的核函數包括

本實驗選取了徑向基核函數,也稱高斯核函數,它具有較寬的收斂性,而本研究中的手勢識別具有低維、小樣本特性,非常符合高斯核函數的要求。

核函數的參數和懲罰因子C是影響支持向量機性能的關鍵因素。C越大,懲罰力度越大,對數據的逼近誤差越小,容易發生過擬合現象;C越小則越容易發生欠擬合。σ2被用來控制回歸逼近誤差度,其值越大則支持向量數目越少,同時精度變差;相反,則支持向量數目變多,精度變高。

采用網格搜索方法來尋找最優參數C和1/σ2,即分別選取不同的參數組合,得出不同的錯誤率,選取其中錯誤率最小的作為最優參數組合,所以采用了臺灣林智仁教授開發的libsvm支持向量機庫中的數據進行參數選優,最終確定本文參數為2和0.5。

5.2 基于神經網絡的手語識別

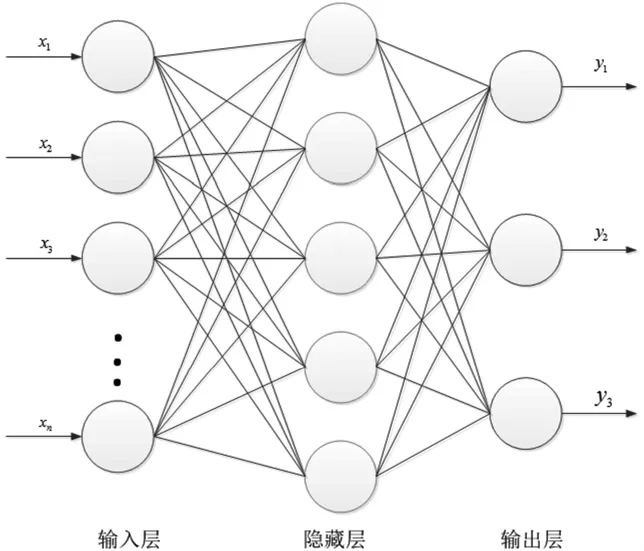

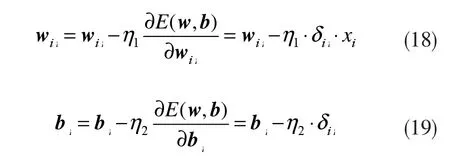

神經網絡是一種按誤差逆傳播算法訓練的多層前饋性網絡,由輸入層、隱藏層和輸出層構成,如圖9所示。它包括數據的正向傳播和誤差的反向傳播兩個過程。正向傳播時,輸入樣本數據從輸入層傳入,經過隱含層計算后,再由輸出層輸出實際輸出值,并與期望值做比較。若輸出的實際值與期望值不符,則進入誤差的反向傳播,此時誤差信號從輸出層逐層反傳回輸入層,在此過程中將誤差分配給各層各個節點,通過修改層與層之間的權值與閾值來減小誤差信號,并最終收斂,得到期望的輸出。

圖9 神經網絡示意圖

神經網絡的輸入層輸入為七個Hu矩特征量,所以取輸入層節點數為7。由于需要識別出五類手勢,所以輸出層節點數取5。隱含層節點數可以通過如下經驗公式得出:

式(14)中,h為隱含層節點數目,m為輸入層節點數目,n為輸出層節點數目,a為1~10之間的調節常數。因為不同隱含層節點數對神經網絡的收斂速度快慢有明顯影響,當有較少的隱含層節點數時,可提高神經網絡的收斂速度,而較多的節點數目會導致訓練時間過長。所以根據既能快速訓練網絡又能準確得到結果的原則,經過多次試驗,取定隱含層節點數目為10。

由于需要區分的手勢有五種,所以設置每種手勢類別的期望值為:

式(15)中,T1~T5分別為每種手勢的期望輸出值。用這五個向量來表示實際輸出值與該手勢的期望值的相似度。激活函數選擇S型函數:,輸入層與隱含層之間的權值及閾值為wki,bi,隱含層與輸出層之間的權值及閾值為wij,bj。

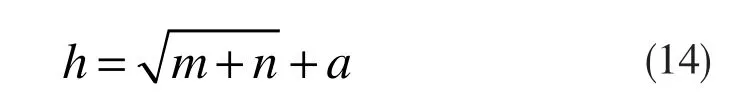

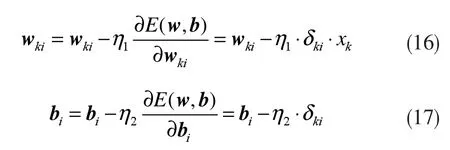

根據梯度下降法得到輸入層和隱含層之間的權值和閥值調整有:

同樣,對于隱含層和輸出層之間的權值和閾值調整如下:

式中E(w,b)為誤差函數,

首先將訓練樣本的Hu矩特征作為輸入層的輸入,通過與各層之間的權值及閾值計算,得到實際的輸出,并與期望輸出值進行比較得到誤差函數,然后用梯度下降法將誤差函數反向傳播,修改閾值和權值,使系統達到收斂,網絡達到穩定。為了使最終的輸出值可以在網絡定型時確定誤差,可使最后輸出的五個數值全部介于0到1之間且它們的總和為1,即為概率值。對比這5個概率值,概率最大值所在的行即為手勢類別。

在構造一個神經網絡時,為了使網絡能夠收斂,需要考慮一些參數的設定,包括:初始化權值與閾值,以及學習率。本文初始化權矩陣時,選取在-1~1之間的不同的小偽隨機數。學習率的過大或過小都會導致網絡的不穩定,經過多次實驗,最終選取學習率為0.02。

5.3 基于隨機森林的手語識別

隨機森林算法是一個具有很好分類效果和具有很高實時性的機器學習方法,其基本思想是通過多棵決策樹進行投票選擇最終的分類結果。隨機森林不但不容易陷入過擬合,而且具有很好的抗噪能力,這主要是得益于隨機性的引入。

隨機森林的識別過程為:首先,采用bootstrap抽樣方法從原始訓練集中有放回地隨機抽取s個新訓練集,每個新的訓練集的大小約為原始訓練集的2/3;然后,從七個特征中隨機抽取m個(m≤M),在這m個屬性中根據信息增益率選出最優的屬性作為根節點,對每個新的訓練集建立決策樹,組成具有s棵決策樹的隨機森林;最后,通過統計每棵決策樹的預測結果,采用投票的結果來決定最終的分類類別。由于每次的采樣都會有部分數據未被選中,稱為袋外數據(Out-of-Bag),將這些數據用作內部誤差估計,即袋外誤差。通過袋外誤差可以確定隨機森林中構建決策樹的數量范圍。

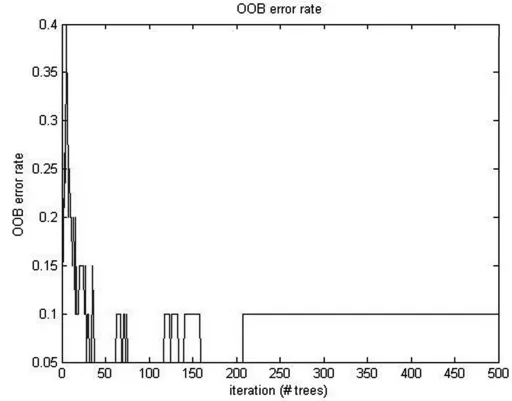

通過實驗發現,分類情況的袋外誤差趨于穩定時,隨機森林不會出現過擬合現象,此時的隨機森林中樹的數目為≥200,如圖10所示,所以取隨機森林中決策樹的棵數為200棵。隨機森林中每棵決策樹主要是根據信息增益最大的屬性來劃分樣例集合。

圖10 袋外誤差率

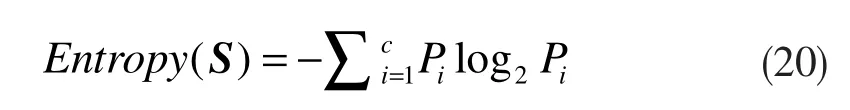

選取的手語Hu矩七個特征作為決策樹的屬性,表示為:F=(f1,f2,f3,f4,f5,f6,f7),S 為訓練數據集合。信息熵Entropy(S)表示為:

式(20)中,c表示識別的手勢類別數量,Pi表示第i個類別在整個訓練集中出現的概率。信息熵主要用于描述手勢類型信息的不純度。信息增益Gain(S,F)為樣本按照某屬性劃分時造成熵減少的期望,表達式為:

式(21)中,V(F)是F的值域,Sv是S中在屬性F上值等于v的樣本集合。式中后半部分為:F對訓練集S劃分的期望信息。

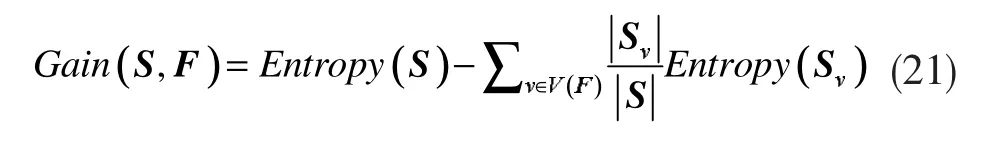

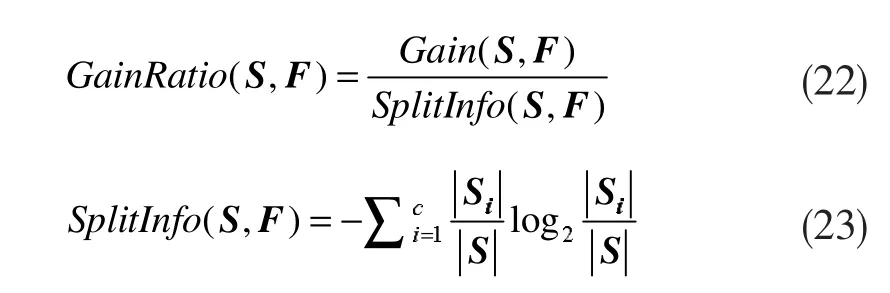

由于采用信息增益來確定屬性的重要性,通常偏向于取值較多的特征,信息熵的值具有偏向性,導致信息增益不準確。為了減小影響,采用信息增益率(Gain Ratio)對屬性進行劃分,其公式為:

式(23)中,Si為第 i類手勢訓練集,SplitInfo(S,F)為訓練集S的分裂信息。

決策樹[16]的建立是通過對樣本集不斷地進行劃分,使其末端分支所包含的樣本盡可能屬于同一個類別,從而進行分類。其中屬性劃分點的最優選擇是關鍵。由于手勢數據集中每個手勢的特征值較多,因此采用二分法選取分裂節點,即將特征屬性值按從小到大排序,并去掉相同的屬性值,取每兩個相鄰的屬性值加和的一半作為劃分點,再求取每個劃分點的信息增益,最后信息增益最大的選取為最優劃分點。以此建立每棵決策樹,由多棵樹組成隨機森林后,采用投票的方式對每棵樹的分類結果進行統計,最終選擇得票最多的結構為測試樣本的分類類別。

6 實驗結果及分析

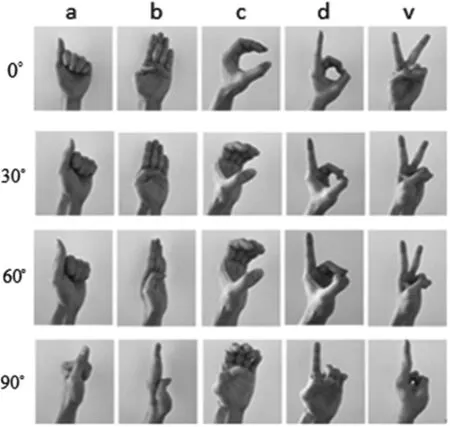

實驗采用MATLAB軟件進行程序編寫及測試,主要識別了五種手語手勢,分別為手語字母a、b、c、d和v,如圖11所示。應用微軟Xbox One 3D體感設備Kinect攝像機采集手勢圖像,共由50名同學采集完成,包括男生和女生且為正常人。采集數據時,通過實驗發現,Kinect攝像頭在120度范圍內捕捉手勢效果最好,因此全部數據都選在此范圍內完成。其中每種手勢每人采集5張,共1250張手語圖像。采集的圖片包括不同背景、不同光照和不同手部角度,其中不同的手勢角度即攝像頭平面與標準手勢平面之間存在夾角,規定當手勢平面與攝像頭平面平行(夾角為0°)時,為標準手勢。在標準手勢沿豎直中線逆時針分別旋轉 15°、30°、45°、60°和 90°時生成手勢圖像,圖11為其中選取夾角為 0°、30°、60°、90°時的手勢圖。

圖11 五種手語及不同角度手勢圖

圖中,第一行為標準手語,其余為發生旋轉之后的手勢圖像,可以明顯看出當旋轉至90度時手語已無法識別。采集數據后將手勢圖像進行尺寸歸一化,每張手勢圖片大小都轉化為100×100像素。

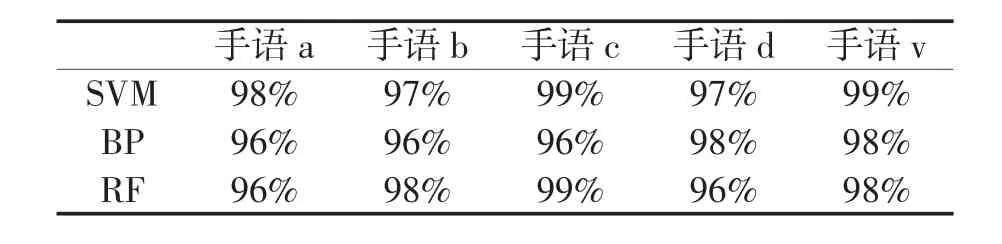

每種手勢圖片共采集250張手勢圖片,隨機挑選150張圖片作為訓練集,另外100張作為測試集。每種手勢標簽完畢后,將訓練數據和測試數據分別放入支持向量機、神經網絡和隨機森林算法中進行分類識別,識別率如表2所示。

表2 五種手語在不同分類方法下的識別率

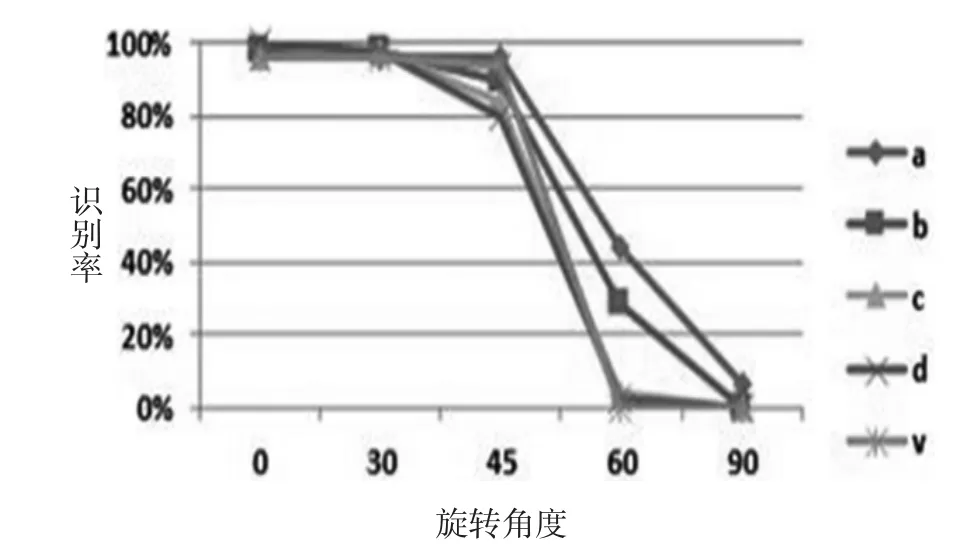

圖12為不同手部角度識別結果對比折線圖。可以看出識別率在隨著手勢偏轉角度的增大而下降,當手勢平面與攝像頭呈垂直角度時則完全識別不出手語手勢。

圖12 不同角度的手語在SVM下的識別率

對這五種手勢的識別結果取平均值進一步研究的結果如表3所示。可見,在正常情況下,支持向量機的識別率最高,其次是隨機森林,最后是神經網絡。由于采集的手勢樣本數量限制,使神經網絡在小樣本集下識別率略低于支持向量機。對于隨機森林來說最重要的參數便是特征的選取,而采用的是Hu矩特征,這對隨機森林影響很大,但對于支持向量機來說就非常的適合。但在時間消耗方面,隨機森林的用時最少,神經網絡則最慢。這主要是因為隨機森林算法對數據無需預處理,加之其算法特性使然;而神經網絡算法計算量大,導致其運行速度最慢。

表3 平均識別率和平均用時

通過Kinect方法進行采集手勢圖像可以避免復雜背景和光照的影響,但是在手指發生重疊時識別率依然很低,識別效果較差。通過實驗發現,當手勢平面與攝像頭平面夾角超過60°時識別率明顯下降,所以Kinect識別手勢的臨界值為60°。考慮到對稱性,Kinect設備的最佳識別范圍為120°。

7 結束語

在科技水平和社會需求不斷提高的今天,人機交互領域中手勢識別越來越受到人們關注。如何更好解決人機交互中存在的局限性和更好地服務于大眾,是目前手勢識別研究的重點。應用Kinect設備,利用深度信息提取手語,解決了復雜背景及光照等因素的影響,并找到了最佳的手勢采集范圍。對于服務機器人行業來說具有很好的人機交互性能。研究也發現,在小樣本情況下支持向量識別率最高,隨機森林實時性最好,但是同時保證準確性和實時性是很難實現的,所以接下來的研究將在保證準確性的前提下,提高實時性,為研究具有更高識別率和實時性的手勢識別算法做進一步研究。

[1]ZHANG S,YUAN C,ZHANG Y.Handwritten character recognition using orientation quantization based on 3D accelerometer[C]//International Conference on Mobile and Ubiquitous Systems:Computing,Networking,and Services,MOBIQUITOUS 2008,July 21-25,2008,Dublin,Ireland.DBLP,2008.

[2]FANG Gaolin,GAO Wen,ZHAO Debin.Large-vocabulary continuous sign language recognition based on ransition-movement models[J].IEEE Transactions on Systems,Man,and Cybernetics,Part A:Systems and Humans,2007,37(1):1-9.

[3]鄒節華.基于單目視覺的動態手勢軌跡識別系統研究[D].西安:西安電子科技大學,2012.ZOU Jiehua.Research on dynamic gesture trajectory recognition system based on monocular vision[D].Xi'an:Xidian University,2012.

[4]翁漢良,戰蔭偉.基于視覺的多特征手勢識別[J].計算機工程與科學,2012,34(2):123-127.WENG Hanliang,ZHAN Yinwei.Multi-feature gesture recognition based on vision[J].Computer Engineering and Science,2012,34(2):123-127.

[5]REN Z,MENG J,YUAN J,et al.Robust hand gesture recognition with kinect sensor[J].MM'11-Proceedings of the 2011 ACM Multimedia Conference and Co-Located Workshops,2011.

[6]王松林.基于Kinect的手勢識別與機器人控制技術研究[D].北京:北京交通大學,2014.WANG Songlin.Research on gesture recognition and robot control technology based on Kinect[D].Bejing:Beijing Jiaotong University,2014.

[7]GU Y,DO H,OU Y,et al.Human gesture recognition through a Kinect sensor[C]//Intelligent Human-Machine System and Cyberneties(IHMSC),2012 4th International Conference on.IEEE,2012,1:274-279.

[8]Heickal H,ZHANG T,HASANUZZAMAN M.Real-time 3D full body motion gesture recognition[C]//International Conference on Robotics and Biomimetics(ROBIO),December 12-14,2013,Shenzhen.IEEE,2013:798-803.

[9]宋宏亮.基于Kinect深度圖像的靜態手勢識別的研究與應用[D].沈陽:東北大學,2013.SONG Hongliang.Research and application of static gesture recognition based on Kinect depth image[D].Shenyang:Northeastern University,2013.

[10]鄧瑞,周玲玲,應忍冬.基于Kinect深度信息的手勢提取與識別研究[J].計算機應用研究,2013,30(4):1263-1265.DENG Rui,ZHOU Lingling,YING Rendong.Research on gesture extraction and recognition based on Kinect depth information[J].Application Research of Computers,2013,30(4):1263-1265.

[11]武紅嬌.復雜背景下的靜態手語識別技術研究[D].沈陽工業大學,2017.WU Hongjiao.Research on static sign language recognition technologyundercomplexbackground[D].Shenyang:Shenyang University of Technology,2017.

[12]董立峰.基于Hu矩和支持向量機的靜態手勢識別及應用[D].武漢理工大學,2012.DONG Lifeng.Static gesture recognition and application based on Hu moments and support vector machines[D].Wuhan:Wuhan University of Technology,2012.

[13]劉小建,張元.基于多特征提取和SVM分類的手勢識別[J].計算機工程與設計,2017,38(4):953-958.LIU Xiaojian,ZHANG Yuan.Gesture recognition based on multi-feature extraction and SVM classification[J].Computer Engineering and Design,2017,38(4):953-958.

[14]李歌.基于BP神經網絡的手勢識別研究[D].秦皇島:燕山大學,2013.LI Ge.Research on gesture recognition based on BP neural network[D].Qinhuangdao:Yanshan University,2013.

[15]趙顯.基于隨機森林的手勢檢測與識別系統的研究[D].湘潭:湘潭大學,2012.ZHAO Xian.Research on gesture detection and recognition system based on random forest[D].Xiangtan:Xiangtan University,2012.

[16]林水強,吳亞東,陳永輝.基于幾何特征的手勢識別方法[J].計算機工程與設計,2014,35(2):636-640.LIN Shuiqiang,WU Yadong,CHEN Yonghui.Gesture recognition method based on geometric features[J].Computer Engineering and Design,2014,35(2):636-640.