利用候選區域的多模型跟蹤算法

畢篤彥 張園強 查宇飛 庫 濤 吳 敏 唐書娟

(空軍工程大學航空航天工程學院, 西安 710038)

利用候選區域的多模型跟蹤算法

畢篤彥 張園強 查宇飛 庫 濤 吳 敏 唐書娟

(空軍工程大學航空航天工程學院, 西安 710038)

跟蹤過程中發生的尺度變化、形變、遮擋是導致模型漂移的重要原因。為了克服模型漂移對魯棒跟蹤的影響,本文提出了一種利用多判別式模型和候選區域的跟蹤算法。首先,該算法采用候選區域替代傳統的滑動采樣,適應跟蹤過程中目標的位移和尺度變化。接下來,為了提高目標的表征能力,先用預訓練網絡提取整幅圖片的深度特征,再通過感興趣區域采樣層(ROI pooling layer)快速提取每一個候選區域的深度特征,進一步提高跟蹤算法的魯棒性。最后,運用多模型選擇機制進行回撤過去錯誤的模型更新,并通過調整搜索區域實現對目標的重檢測,有效抑制了模型漂移對魯棒跟蹤的影響。實驗中,本文算法與相關算法在OTB 2013數據庫和UAV 20L數據庫上進行了對比。結果表明,本文算法在精確度與成功率上均取得了最優性能,并能有效抑制模型漂移對魯棒跟蹤的影響。

目標跟蹤; 候選區域; 重檢測

引言

目標跟蹤被廣泛應用于人機交互、軍事導航以及機器人等眾多領域[1-2]。但是在跟蹤過程中出現的尺度變化、形變以及遮擋是導致模型漂移的一個重要原因。近幾年,基于相關濾波的跟蹤算法如KCF[3]、SRDCF[4],利用循環矩陣的性質提高了跟蹤的性能與效率。但其適應目標的尺度變換是通過在初始幀長寬比不變的情況下進行同比例縮放,不能很好地反映跟蹤目標的尺度變化。其他的一些算法如GOTURN[5]、MDNet[6],利用深度學習的強大表征能力提高了跟蹤性能,但其尺度變化亦不能反映目標的物質屬性。候選區域(Object proposals)[7]是一種最開始被應用于圖像檢測的方法。它克服了傳統的滑動采樣的劣勢,能夠大量減少候選樣本的數目,并反映目標的物質屬性和尺度屬性,適應檢測中目標的長寬比變化。EBT[8]、sPST[9]是近兩年將候選區域與傳統算法相結合的跟蹤算法,在2015年的視覺目標跟蹤競賽[10](Visual object tracking 2015,VOT2015)中取得了不錯的成績。但是,這些算法一方面沒有利用深度學習的強大表征能力, 另一方面,它們缺少對模型的糾錯機制。所以一旦目標發生遮擋或者形變很容易發生模型漂移,進而導致跟蹤失敗。因而,本文提出一種利用候選區域的多模型跟蹤算法,該算法利用候選區域適應目標的尺度變化,建立多模型選擇機制以糾正模型。

1 算法流程

在本文算法中,首先候選區域被用來適應目標的尺度變化,在當前幀的深度特征與候選區域的位置信息被輸入感興趣區域采樣層[11](Region of interest pooling layer, ROI pooling layer)后,每一個候選區域的深度特征可以被快速獲取;接下來,通過每隔φ幀保存跟蹤模型而建立的多模型系統對這些樣本進行評估。在這過程中,每一個模型的判決結果都會被熵決策機制評估,并且當感知到模型發生漂移時,該文算法可以通過擴大搜索區域對目標實現重檢測。最后,最好的跟蹤模型確定當前幀目標的位置,并對其進行模型更新。整個跟蹤算法的流程如圖1所示。

圖1 整個跟蹤算法的流程圖Fig.1 Flow chart of whole tracking algorithm

2 初始化

2.1 特征提取

如圖1所示,為獲取目標的特征表征,本文算法首先將該幀圖像輸入一個預訓練網絡獲取該幀的特征。接下來,通過把整幅圖像的特征與每一個候選區域的位置信息輸入感興趣區域采樣層(ROI pooling layer)[11],最終快速獲取每個候選區域的深度卷積特征。

在這里需要注意的是,感興趣區域采樣層的輸出是相同長度的特征向量,也就是說,感興趣區域采樣層能夠將不同尺寸的候選區域變成相同長度的特征向量。

在本文中,基于區域塊的快速卷積神經網絡(Fast region-based convolutional network, FR-CNN)[11]被作為預訓練網絡,并提取其第1層全連接輸出作為特征。但是其他的網絡結構也可以被用來提取樣本的特征。從整個網絡結構來看,FR-CNN中的感興趣區域采樣層能夠一次性地快速提取所有候選區域的特征,因而本文選取FR-CNN作為預訓練網絡來提取樣本特征。

2.2 樣本選取與模型訓練

在獲取每個候選區域的深度特征之后,需進行正負樣本的選取。正負樣本的選取被定義為

(1)

式中s(xi)——第i個候選樣本的面積

xi——第i個候選樣本

x*——當前幀算法預測的目標區域

s(x*)——算法在當前幀預測的目標區域面積

y(i)——第i個樣本的標簽

從式(1)可以看出比率在0.5~0.9之間的樣本沒有參與正負樣本的選擇,這是為了避免模型漂移的發生,提高跟蹤算法的魯棒性。

得到正負樣本之后,接下來是對支持向量機(Support vector machine,SVM)的訓練。在本文中,采用來源于MEEM[12]算法中的SVM模型,與傳統SVM模型不同的是,它使用1個標準樣本集來概括先前的支持向量與當前的正負樣本,并用這個樣本集來更新跟蹤模型。當支持向量的數目超過某個閾值的時候,通過計算樣本之間的距離來使最相近的支持向量進行融合,最終使得支持向量的數目不超過某個閾值。

總的來說,本文算法所提出的跟蹤器具有很強的魯棒性,主要體現在:來自于edgebox算法[7]的候選區域不僅能夠適應跟蹤過程中目標長寬比變化,而且候選區域所具有的物質屬性為模型的訓練更新提供了高質量的樣本;本文算法使用深度特征來表征每一個候選區域,它能夠提高目標的表征能力,進而提高跟蹤算法的魯棒性。

3 利用候選區域的多模型跟蹤

3.1 熵決策機制

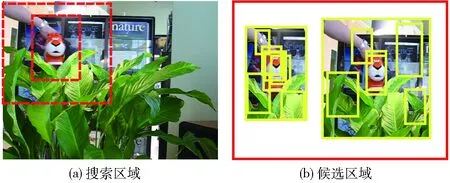

因為圖像檢測的目的是檢測出圖像中所有目標,而跟蹤卻只要求跟蹤某個特定的目標。目標框中輪廓線條的多少與目標框包含物體的概率有著密切的關系,DOLLAR基于這樣的觀察提出了edgebox算法[7],它能夠快速精準地產生包含目標的候選區域,但是在跟蹤過程中,生成的候選區域與搜索區域的大小有關。因為一個大的搜索框通常含有更多的線條,而當目標相對于該幀圖像尺寸很小時,此時就很難產生針對該目標的候選區域了。針對此問題,本文比較了不同搜索區域大小對生成候選區域的影響。其結果如圖2所示,從圖2可以看出,一個比目標尺寸稍大的搜索區域能產生許多高質量的候選區域。因而,比目標尺寸稍大的搜索區域更適合用于目標跟蹤任務。然而,當目標發生模型漂移時,一個小的搜索區域很容易導致目標跟蹤失敗。

圖2 不同搜索區域大小對生成候選區域的影響Fig.2 Effects of different searching area sizes on generated object proposals

針對這個問題,本文一方面利用熵決策機制自動決定搜索區域的大小。另一方面,多模型選擇機制被用來撤銷由模型漂移導致的錯誤模型更新。具體來說,當模型發生漂移并被熵決策機制感知時,搜索區域將會被放大以實現對目標的重檢測。同時,通過選擇先前的跟蹤模型,可以撤銷先前錯誤的模型更新。

熵決策機制最早出現于文獻[13],而后被適當修改后應用于MEEM[12]跟蹤算法中,本文算法類似于MEEM算法,多模型選擇機制被用以減少模型漂移的影響,但是基于熵決策機制,一種新的目標重檢測策略被用來進一步提高目標跟蹤的魯棒性,這是MEEM算法所忽略的。除此之外,本文算法將候選區域融入跟蹤框架,并用深度特征來表征它,這使得本文算法能夠適應目標的尺度變化,因而本文算法能夠更好地應對模型漂移對魯棒跟蹤的影響。

對于熵決策機制,本文首先定義候選樣本x=(x1,x2,…,xn)為可能的目標集。yi=(ωi,li)是某個候選樣本xi對應的標簽。式中ωi∈(0,1)表示目標的前景與背景的標簽,li表示樣本xi的位置。z=((ω1,l1),…,(ωn,ln))代表可能的標簽集。損失函數被定義為

Jm(x,z)=-L(θm;x,z)+λH(y|x,z;θm)

(2)

其中

(3)

(4)

式中L(θm;x,z)——模型的對數似然函數

H(y|x,z;θm)——經驗條件熵

λ——對數似然函數和經驗條件熵之間的權衡因子

θm——模型的參數

由式(3)和式(4)可得知,標簽yi=(ωi,li)僅僅取決于樣本xi的特征和位置信息。詳細來說,樣本xi是通過空間的先驗概率P(li|ωi)和后驗概率P(ωi|xi;θm)來確定目標位置的。其中,P(li|ωi)由一個高斯函數來表征,它的中心是上一幀目標的中心位置。從式(3)和式(4)也可看出,P(ωi|xi;θm)的值越大,似然函數L(θm;x,z)的值也將越大。

經驗條件熵被定義為

(5)

其中

(6)

式中δz(y)、δz(y′)——脈沖函數

y′——候選樣本x的標簽

唯有y∈z時,δz(y)的取值為1,否則為0。從式(5)和式(6)可以看出,當N個模型在目標位置上沒有分歧時,P(y|x,z;θm)的值為1,熵正則化項H(y|x,z;θm)的值為0。但是,當N個模型在目標位置上存在分歧時,熵正則化項將不會為0,因為P(y|x,z;θm)的值將不再等于1。總的來說,在目標位置上的分歧越大,不確定性與熵將越大。

3.2 模型選擇與候選區域的生成

一般來說,最好的模型具有最強的判別力,因而它在幾個可能的目標位置上的得分差異更大。基于這樣的共識,假設長時間的遮擋已經發生,通過每隔φ幀保存1個模型,最新的N個模型將會被用來評估當前的樣本集,不同的模型對目標的位置預測有著不同的答案。

在這里,mc代表當前最好的模型,mt代表之前的某個模型。相比于當前的模型mc,之前的模型在可能的目標位置上分歧將會更大。原因在于當前最好的模型由于學習到了遮擋時錯誤的背景信息,而之前的模型mt由于沒有學到錯誤的背景信息,因而它的判別能力更強,它在幾個可能的目標位置上的得分差異性將更大。

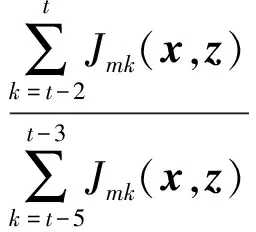

而熵是不確定性的度量,不確定性越大,熵越大。所以通過式(2)對每個跟蹤模型進行評估,最好的模型將會具有最小的損失值。不失一般性,本文通過計算最近若干幀的損失值之和來決定最好的跟蹤模型。對最好模型的選擇基于

(7)

其中

M=(mt1,mt2,…)

式中M*——最好的模型

M——模型集合

Jmk——某個模型在第k幀的損失值

除了通過熵決策機制選擇最好的跟蹤模型之外,本文利用最好的模型在最近幾幀的損失值來確定搜索區域的大小。由于在大部分情形中,多個模型在目標的位置上是一致的,也就是說對當前幀的目標位置不確定性為零,所以式(2)中熵正則化項的值為零,模型的損失值很小,但是當模型漂移發生時,此時多個模型存在對目標位置的分歧,不確定性不為零,從而式(2)中的熵正則化不為零,所以模型的損失值將會增大。基于這樣的發現,本文提出了一種通過擴大搜索區域來實現目標重檢測的方法,其中搜索區域的改變基于

(8)

式中t——當前幀η——損失值比率

當比率η超出某個閾值時,模型漂移很有可能發生,此時通過擴大搜索區域對目標進行重檢測,模型漂移的影響將會被減小。

3.3 候選樣本的生成

對于候選樣本x=(x1,x2,…,xn)的選擇是基于

Smi=P(li|+)P(+|xE∪Ri;θm)

(9)

其中

(10)

式中li——某個樣本的中心位置

f(xE∪Ri)——樣本xE∪Ri被某個模型計算后的得分

一個標準差為15的二維高斯函數被用來代表空域優先概率P(li|+)。在所有的樣本xE∪R經過式(9)和式(10)計算之后,得分值被歸一化為0~1,并經過非極大值抑制處理后,只有得分值大于0.9的樣本將會被作為候選樣本。

4 仿真

4.1 OTB 2013 數據集

在OTB 2013 數據集中,本文算法與SRDCF[4]、MEEM[12]、CNN-SVM[16]等30種較新的算法進行了對比分析。這些算法都是近幾年排名靠前的算法。在本次實驗中,精確度與成功率這2個指標被用來評估本文算法與對比算法的性能。

其中精確度是一項基于中心位置誤差的指標。中心位置誤差是指預測的目標位置中心與實際的目標位置中心之間的歐氏距離。而精確度是指距離小于某個門限值的幀數占整個視頻幀數的百分比。

成功率是另外一項基于重疊率的性能指標。重疊率表示預測區域與實際區域的交集與其并集之比,成功率表示重疊率大于某個閾值的幀數占視頻總幀數的比重。

圖3為各種算法在OTB 2013數據庫中的總體效果。圖中只列出排名靠前的10種算法。由圖3可以看出,在精確度與成功率這2個性能指標上,本文算法均取得了最好的效果。

圖3 各算法在OTB 2013數據庫上的性能對比Fig.3 Performance comparisons of algorithms in OTB 2013 database

在精確度上,CNN-SVM獲得了一個得分為77.7%的次優結果。它是利用卷積神經網絡獲取指定目標的顯著性映射的一種方法。SRDCF比CNN-SVM得分低1.7個百分點,獲得了第3名的結果。由于本文算法的候選樣本融入了候選區域,而這些候選區域能夠自然地適應目標的長寬比變化,除此之外,當模型發生漂移時,自適應的調整搜索區域實現對目標的重檢測,能夠很好的減輕模型漂移對跟蹤模型的影響。所以本文算法獲得了最高得分80.2%,達到了最好的跟蹤性能。

圖4 各算法在不同屬性上的性能對比Fig.4 Performance comparisons of different attributes of algorithm

在成功率這個評價指標上,由于MEEM不能適應目標的尺度變化,所以它在成功率上的指標比較靠后。SRDCF是一種通過壓制邊界效應的相關濾波算法,它獲得了一個62.6%的得分。本文算法得分為63.6%,獲得了最好的性能結果。

為進一步分析本文算法在解決模型漂移上的優越性,本文對比了不同算法在不同屬性指標上的性能,部分實驗結果如圖4所示。

在尺度變化中,一些視頻序列比如滑雪,目標涉及到突然的長寬比變化,由圖4可以看出,本文算法效果明顯比CNN-SVM[16]、DSST[17]等算法要好。長寬比變化自適應是本文算法取得最優效果的一個重要原因。

在形變、平面旋轉以及遮擋等屬性中,模型漂移很容易發生。尤其是在發生長時間的遮擋后,由于錯誤的模型更新,背景信息不可避免的被跟蹤模型學到,所以跟蹤失敗很容易發生在接下來的跟蹤過程中。但是對于本文跟蹤算法,一方面,候選區域具有物質屬性,這在一定程度上能夠減輕形變或平面旋轉對跟蹤性能的影響。另一方面,通過保存之前跟蹤模型建立的多模型選擇機制,在多個模型中選擇最具有判別力的跟蹤模型,這樣就能減輕由于遮擋造成的模型漂移對跟蹤性能的影響。所以在這3個屬性指標上,本文算法均實現了最好性能。

4.2 UAV 20L 數據庫

最近發布的UAV 20L數據庫包含了20個長視頻序列,共有58 670幀圖像。基于當前無人機跟蹤在搜索與營救、障礙規避等計算機視覺領域的廣泛應用,UAV 20L數據庫被用來評估本文算法在無人機長期跟蹤上的魯棒性。精確度與成功率被用來評估本文算法在此數據庫上的有效性。

在本次實驗中,15個包含有MEEM[12]、DSST[17]、SAMF[18]、MUSTER[19]、Struck[20]等先進跟蹤算法被用來驗證本文算法在UAV 20L數據庫上的優越性,圖5是它們在整個數據庫上的整體性能比較,圖6展示了本文算法與部分對比算法的跟蹤結果。

圖5 各算法在UAV 20L數據庫上的性能對比Fig.5 Performance comparisons of algorithms in UAV 20L database

圖6 跟蹤效果示意圖Fig.6 Sketch images of tracking effect

與各個算法在OTB 2013數據庫上的得分相比,在UAV 20L數據庫上的得分普遍偏低,這說明UAV 20L相比于OTB 2013數據庫更具挑戰性。因為在無人機視頻跟蹤過程中,一方面無人機可能因為前方建筑等障礙物需實時轉換角度或高度;另一方面,也因為目標所處地理環境復雜,無人機必須得實時轉換角度和位置才能適應目標的變化。這些因素最終導致的尺度變化和形變是UAV 20L數據庫上的主要屬性,而且在尺度變化中,長寬比變化相比于OTB 2013數據庫更為常見。

由圖5可以得知,SRDCF在成功率上取得了次優結果,它的成功率為0.413。由于本文算法融入了候選區域,這些候選區域能夠自適應目標的長寬比變化,因而本文算法在尺度變化上更為靈活,這是一些經典算法如SRDCF、SAMF所不能實現的。在模型更新上,本文引入了多模型選擇機制來回撤錯誤模型更新,并通過改變搜索區域實現目標的重檢測以應對跟蹤過程中遮擋的影響,因而本文算法在成功率上取得了最優性能。

4.3 參數分析與算法復雜度

為進一步分析本文算法各個環節對跟蹤性能的影響,本文算法在OTB 2013數據庫上分別分析了樣本xR和候選區域xE的加入分別對跟蹤性能的影響,成功率被用來對比它們之間的性能差異。結果如表1所示。

表1 xR和xE不同結合方式對跟蹤性能的影響

從表1中可以看出,當只把滑動樣本作為候選樣本時,其得分比只把候選區域作為候選樣本的得分值低,滑動樣本沒有尺度變化是一個重要原因。但它比MEEM的得分值要高,說明深度特征比傳統的特征要好,xR和xE結合的方式取得了最高分,說明在一些復雜場景如部分遮擋時,候選區域并不能很好的框住目標,而滑動采樣彌補了這一缺陷,使其取得了最好的跟蹤效果。除此之外,本文還進一步分析了候選區域的數量對跟蹤性能的影響,其結果如表2所示。

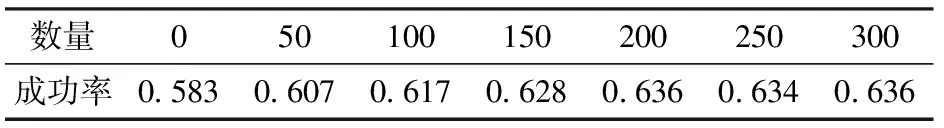

表2 不同數量的候選區域對跟蹤性能的影響Tab.2 Effects of different numbers of objectproposals on tracking performance

從表2可以看出,當候選區域的數量達到200個時,跟蹤算法的性能基本保持穩定,此時增加候選區域的樣本只能增加計算的冗余度,因而本文算法選取200個候選樣本用于跟蹤。

在該文算法中,深度特征的提取是本文算法比較耗時的一個部分,為此,本文使用GPU對特征提取部分加速,使得特征提取部分速度得到提高,最終使得算法跟蹤速度達到了4幀/s。

5 結束語

本文提出了一種利用候選區域的多判別式模型跟蹤算法。在本文算法中,深度特征表征的候選區域被用來適應目標的尺度變化,基于熵決策機制的多判別式模型被用來修正錯誤的模型更新,對目標的重檢測有效避免了遮擋對魯棒跟蹤的影響。在實驗中,OTB 2013數據庫與UAV 20L數據庫被用來驗證本文算法的優越性,實驗結果表明本文算法取得了最好的性能結果,并能有效克服模型漂移對魯棒跟蹤的影響。

1 李盛輝,田光兆,姬長英,等.自主導航農業車輛的全景視覺多運動目標識別跟蹤[J/OL].農業機械學報,2015,46(1):1-7. http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?flag=1amp;file_no=20150101amp;journal_id=jcsam.DOI:10.6041/j.issn.1000-1298.2015.01.001.

LI Shenghui, TIAN Guangzhao, JI Changying, et al. Multiple moving objects tracking based on panoramic vision for autonomous navigation of agricultural vehicle[J/OL].Transactions of the Chinese Society for Agricultural Machinery, 2015,46(1):1-7.(in Chinese)

2 張園強,畢篤彥,查宇飛,等.一種利用最大間隔相關濾波的魯棒目標跟蹤方法[J]. 空軍工程大學學報:自然科學版,2017, 18(2):63-68.

ZHANG Yuanqiang, BI Duyan, ZHA Yufei,et al. A robust object tracking algorithm using maximum margin correlation filter[J]. Journal of Air Force Engineering University: Natural Science Edition, 2017,18(2):63-68.(in Chinese)

3 HENRIQUES J, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2015, 37(3): 583-596.

4 DANELLJAN M, HAGER G, SHAHBAZ K F, et al. Learning spatially regularized correlation filters for visual tracking[C]∥IEEE International Conference on Computer Vision, 2015:4310-4318.

5 HELD D, THRUN S, SAVARESE S. Learning to track at 100 fps with deep regression networks[EB/OL]. [2016] .https:∥arxiv.org/abs/1604.01802.

6 NAM H, HAN B. Learning multi-domain convolutional neural networks for visual tracking[EB/OL]. [2015]. https:∥arxiv.org/abs/1510.07945.

7 ZITNICK C L, DOLLAR P. Edge boxes: locating object proposals from edges[C]∥European Conference on Computer Vision, 2014:391-405.

8 ZHU G, PORIKLI F, LI H. Beyond local search: tracking objects everywhere with instance-specific proposals[EB/OL]. [2016]. https:∥arxiv.org/abs/arXiv:1605.01839.

9 HUA Y, ALAHARI K, SCHMID C. Online object tracking with proposal selection[C]∥IEEE International Conference on Computer Vision, 2015:3092-3100.

10 KRISTAN M, MATAS J, LEONARDIS A, et al. The visual object tracking VOT2015 challenge results[C]∥ IEEE International Conference on Computer Vision Workshop, 2015:564-586.

11 GIRSHICK R. Fast r-cnn[C]∥IEEE International Conference on Computer Vision, 2015:1440-1448.

12 ZHANG J, MA S, SCLAROFF S. MEEM: robust tracking via multiple experts using entropy minimization[C]∥European Conference on Computer Vision, 2014:188-203.

13 GRANDVALET Y, BENGIO Y. Semi-supervised learning by entropy minimization[C]∥Neural Information Processing Systems,2005:529-536.

14 WU Y, LIM J, YANG M H. Online object tracking: a benchmark[C]∥ IEEE Conference on Computer Vision and Pattern Recognition, 2013: 2411-2418.

15 MUELLER M, SMITH N, GHANEM B. A benchmark and simulator for uav tracking[C]∥ European Conference on Computer Vision, 2016: 445-461.

16 HONG S, YOU T, KWAK S, et al. Online tracking by learning discriminative saliency map with convolutional neural network[EB/OL]. [2015]. https:∥arxiv.org/abs/1502.06796.

17 DANELLJAN M, HAGER G, KHAN F S, et al. Accurate scale estimation for robust visual tracking[C]∥British Machine Vision Conference, 2014:65.1-65.11.

18 LI Y, ZHU J. A scale adaptive kernel correlation filter tracker with feature integration[C]∥European Conference on Computer Vision, 2014:254-265.

19 HONG Z, CHEN Z, WANG C, et al. Multi-store tracker (muster): a cognitive psychology inspired approach to object tracking[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2015:749-758.

20 HARE S, SAFFARI A, TORR P H S. Struck: structured output tracking with kernels[C]∥IEEE International Conference on Computer Vision,2011:263-270.

MultipleModelTrackingAlgorithmUsingObjectProposals

BI Duyan ZHANG Yuanqiang ZHA Yufei KU Tao WU Min TANG Shujuan

(InstituteofAeronauticsandAstronauticsEngineering,AirForceEngineeringUniversity,Xi’an710038,China)

The scale variation, deformation and occlusion are the important reasons for model drift. In order to overcome the effect of model drift on robust tracking, a multiple model tracking algorithm based on object proposals was proposed. Firstly, as object proposals can reflect the general object material properties, the proposed tracker replaced traditional sliding sampling with object proposals to adapt the displacement and scale variation in the tracking process. And then, in order to enhance the object representation ability, the deep convolutional feature was used to characterize the target. During this process, although the previous size of object proposals may be different, the deep convolutional feature of each object proposal can be extracted quickly by a ROI pooling layer, and each object proposals feature had the same length, which can help to model training and further improve the robustness of the tracker. Lastly, the multi-models selection mechanism was used to undo past bad model updates by selecting the best tracking model, and adjusting the searching area can achieve object re-detection. These measures can inhibit the effect of model drift on robust tracking. In order to verify the superiority of the algorithm, the OTB 2013 benchmark and UAV 20L benchmark, and some classic contrast algorithms recently were used to evaluate the proposed tracker. The results showed that the proposed tracker achieved the best performance on precision and success rate, and the effect of model drift on robust tracking can be effectively suppressed.

object tracking; object proposals; re-detection

10.6041/j.issn.1000-1298.2017.11.005

TP391.4

A

1000-1298(2017)11-0035-08

2017-03-14

2017-04-01

國家自然科學基金項目(61472442)和航空科學基金項目(20155596024)

畢篤彥(1962—),男,教授,博士生導師,主要從事計算機視覺與圖像處理研究,E-mail: 463431261@qq.com