視覺導航技術的發(fā)展

張 海,吳克強,張曉鷗

(1.北京航空航天大學自動化科學與電氣工程學院,北京 100191; 2.北京航空航天大學無人駕駛飛行器設計研究所,北京 100191)

視覺導航技術的發(fā)展

張 海1,吳克強1,張曉鷗2

(1.北京航空航天大學自動化科學與電氣工程學院,北京 100191; 2.北京航空航天大學無人駕駛飛行器設計研究所,北京 100191)

近20年來視覺導航技術發(fā)展迅速,在原理方法與技術實現(xiàn)上取得了重要突破,規(guī)模化應用已經(jīng)成為可能。以視覺導航中光流、視覺里程計、視覺同步定位與地圖構建等主流研究方向為對象,對其發(fā)展概況、基本原理、技術優(yōu)勢與難點等進行了簡要介紹與分析,并從近期應用推廣及長遠發(fā)展角度對視覺及視覺組合導航技術進行了展望。

SFM;視覺里程計;VSLAM;光流;組合導航

0 引言

導航伴隨著人類文明的發(fā)展已有數(shù)千年的歷史,20世紀以來更出現(xiàn)了跨越式的進步,以慣性、無線電、天文、地磁、光學為基礎的導航系統(tǒng)發(fā)展日新月異,在軍事領域取得舉足輕重地位的同時,也正在加速進入民用領域。美國國防部高級研究計劃局(DARPA)2004年開始組織自動駕駛車輛大賽,極大地推動了相關技術的發(fā)展,也客觀促成了今天Google、Uber、Tesla、百度等無人駕駛技術的示范應用。亞馬遜公司為提高倉庫工作效率,收購了Kiva system公司,并將Kiva機器人應用于自動化倉庫,實現(xiàn)了大規(guī)模機器人全自動商品搬運,成為自動導引車輛(AGV)應用范例。我國洋山港自動化碼頭,在可靠的組合導航系統(tǒng)支持下,已采用130臺AGV實現(xiàn)集裝箱裝卸、轉運自動化,能24h工作,車輛定位精度達到2cm,港區(qū)的工作人員減少了75%,但工作效率卻提升了30%。

視覺是自然界絕大多數(shù)動物采用的導航手段,因圖像中含有豐富的空間信息,特別是視覺作為一種自主的測量方式,在衛(wèi)星導航(GNSS)受干擾、遮擋而無法工作的情況下仍能有效發(fā)揮作用,相對慣性導航具有良好的誤差累積抑制能力,在導彈武器、火星探測機器人、無人駕駛汽車、小型無人機等領域已經(jīng)得到有效的應用,并具有進一步小型化、低成本化能力,發(fā)展空間十分廣闊。

20世紀50年代開始的計算機視覺理論研究奠定了視覺導航的基礎[1],70年代后Moravec等學者就開始了面向導航的視覺應用探究[2],90年代后因計算機處理能力的快速進步,計算機視覺及視覺導航應用研究工作得到了快速發(fā)展,Hartley在其研究成果基礎上對視覺解算、幾何解算進行了全面總結[30],特別是2000年后Nistér、Davison、Klein等學者的創(chuàng)造性研究工作極大地推動了該領域研究的快速發(fā)展,視覺及視覺組合導航已經(jīng)進入了一個全新的階段。下面對視覺導航主要技術分支及其發(fā)展情況進行簡要介紹、分析,并給出視覺及視覺相關導航技術的未來發(fā)展趨勢。

1 視覺導航技術研究進展

視覺或圖像技術在導航中的應用眾多,如目標跟蹤、景象匹配、距離測量等,但不能提供完整導航功能,如不具備僅利用該方法自身實現(xiàn)攝像機速度、位置、姿態(tài)等完整導航信息輸出的能力,故未作為視覺導航方法進行討論。

光流的概念在20世紀50年代由Gibson提出,已被證明是昆蟲、鳥類有效的導航方式。光流利用連續(xù)采集圖像獲得速度、轉動估計,是仿生導航重要的研究對象[3]。與視覺里程計、視覺同時定位與地圖構建不同,它不能僅依據(jù)圖像內容的空間幾何關系進行導航計算,而對相機相對環(huán)境的瞬時運動具有較好的測量能力,Lucas-Kanade[4]、Horn-Schunk[5]是兩種最為經(jīng)典的計算方法,Mukauwa[6]針對光流計算中不連續(xù)性問題進行改進。光流已被廣泛應用于障礙物檢測與著陸[7],Ohnishi等[8]利用光流法實現(xiàn)場景中支配性平面檢測,進而為機器人提供導航服務。近年來,馬里蘭大學研究團隊從仿生角度出發(fā)提出了Wide Field Integration處理模型[9-10],證明了光流法可以滿足6自由度自主導航應用。

SFM (Structure From Motion,運動重建結構)是利用二維圖像序列恢復空間三維結構及相機位姿信息方法的總稱。雖然SFM具有相機位姿估計的功能,但其初衷是以環(huán)境的三維重構為首要目標,相機運動甚至可以是已知或可直接測量的。SFM概念形成較早,20世紀80年代Longuet-Higgins[11]、Harris[12]等的研究工作實質性地推動了SFM的發(fā)展,SFM算法的研究熱點也從借助慣性等輔助測量[13]向純視覺處理方向轉變[14],且研究重點逐漸向單目視覺、相機精確定位、快速處理、稠密重構等方向集中。

VO(Visual Odometry,視覺里程計)是一個十分活躍的視覺導航研究方向,其功能是對相機的運動速度、軌跡及相機位姿進行準確估計,因此VO具有完整的導航應用功能,并被認為是一種特殊的SFM[15]。Nistér在2004年提出了系統(tǒng)的本質矩陣五點估計法[16],進而提出了VO的概念[17],并給出了可實時處理的單目/雙目VO實現(xiàn)方案,被認為是VO的開創(chuàng)性工作。迄今絕大多數(shù)VO采用特征點匹配的稀疏方案,精度較高。近年來出現(xiàn)了采用圖像亮度而非特征的直接計算半稠密、稠密VO[18-19],在獲得相機位姿信息的同時能夠對環(huán)境進行大范圍深度感知。目前VO的研究已經(jīng)能夠實現(xiàn)單目視覺下實時圖像特征提取及相機定位,但在魯棒性、準確性方面尚有很大的改善空間,VO與慣性測量結合能夠更有效應對復雜非結構化環(huán)境,取得良好的導航效果[20]。

VSLAM(Visual Simultaneous Localization and Mapping,視覺同步定位與地圖構建)是在經(jīng)典SLAM算法基礎上發(fā)展起來的視覺導航方案,以視覺取代傳統(tǒng)SLAM中激光雷達等方式實現(xiàn)地標點測量,因其基于不同時刻二維圖像進行導航定位,故也屬于SFM,研究難點主要集中在如何實現(xiàn)單目純視覺條件下快速相機定位與地圖構建[21-22]。VSLAM從其估計精度優(yōu)化方式出發(fā)可以分為濾波、非濾波方法兩大類[15,21],濾波方法通過EKF(Extended Kalman Filter,擴展Kalman濾波)、UKF(Uncented Kalman Filter,無跡Kalman濾波)以及PF(Particle Filter,粒子濾波)等濾波解算提高導航精度,非濾波方法則是利用多幅圖像構建對相機及特征點的聯(lián)合幾何約束進行導航參數(shù)優(yōu)化。因受到單目視覺原理上的距離尺度模糊、地標數(shù)量造成的計算量過大兩個共性難點的限制,直至2003年,兩類研究仍然進展緩慢。

在濾波VSLAM方面,Davison在2003年提出的一種單目實時VSLAM方案[22]具有開創(chuàng)性,通過濾波模型設計及尺度概率估計方式得到小空間內有效的定位結果。針對單目視覺尺度模糊問題,Nützi[14]在VSLAM姿態(tài)位置估計結果基礎上,建立了載體位置、速度、加速度及尺度因子的EKF估計模型,以VSLAM位置及加速度計測量為輸入,實現(xiàn)了運動參數(shù)尺度修正估計;Montemerlo等設計了基于PF的快速濾波方案,并證明了其濾波穩(wěn)定性[40]。非濾波VSLAM主要采用的優(yōu)化方法有BA(Bundle Adjustment,光束平差法 )、Pose Graph,其中BA應用最為普遍[21],因其實現(xiàn)需要利用一段時間內眾多關鍵幀建立幾何約束關系,進而對相機運動參數(shù)進行最優(yōu)搜索,計算量巨大,長期以來限制了實際應用。Klein與Murray在2007年公布的PTAM算法通過高效的處理機制打破了BA研究的僵局[23],使實時應用成為可能。因PATM是一種框架性的解決方案,目前已經(jīng)成為BA類方法普遍采用模式,DTAM[38]、ORB-SLAM[32]、LSD-SLAM[19]等實時性算法都采用PTAM方案。

VO、VSLAM同屬于SFM方法,從功能上都能完整實現(xiàn)導航,且在特征提取、精度優(yōu)化等實現(xiàn)步驟上可采用完全相同的技術,其區(qū)別主要體現(xiàn)在VSLAM針對往復運動區(qū)域,為保證地圖及導航精度需要進行地圖閉環(huán)處理(Loop closure或Loop Closing),而VO不考慮閉環(huán)應用,在使用過程中僅保存最近的地圖信息。

VO及VSLAM兩種最為主要的視覺導航方法已具有較好的實時處理能力,克服了傳統(tǒng)SFM算法僅能事后離線處理的不足。使用極線幾何或其他亮度信息計算方法[18-19],能夠實現(xiàn)針對圖像中每個像素或局部區(qū)域每個像素的稠密、半稠密三維重構,進而可以獲得豐富的場景信息,極大地推動了AR(Augmented Reality,增強現(xiàn)實)領域的發(fā)展,基于PTAM框架的VO、VSLAM已經(jīng)成為AR領域的重要技術方法。稠密、半稠密地圖可以獲得比特征點更為豐富的形狀、輪廓等深度信息,目前因地圖精度有限、復雜地圖信息難以利用等原因,半稠密、稠密地圖尚不能對導航精度改善發(fā)揮有效作用,但對未來視覺語義化的導航應用有重要意義,在此將基于特征點的稀疏地圖方法作為主要分析對象。

立體視覺具有距離測量能力,相對單目視覺具有原理上的優(yōu)勢,目前立體視覺導航研究主要集中在應用方面,重點解決處理速度與導航精度的問題。單目視覺因不具備距離直接測量能力,在無外界測量輔助或先驗知識情況下,不具備距離無尺度模糊恢復能力。立體視覺因實際應用受到基線長度的限制,無法實現(xiàn)超過一定閾值距離的有效測量,退化為單目視覺。此外立體視覺對攝像機參數(shù)、基線長度的穩(wěn)定性有很高的要求,也需要更高的處理能力。因此,取得單目視覺在原理、方法上的突破意義重大、更具挑戰(zhàn)性,這也是目前Davison等國內外知名學者專注于單目視覺系統(tǒng)研究的主要原因。

2 光流法導航的基本原理

為有效描述動物在運動過程中視覺的變化,Gibson定義的光流是因觀測者與環(huán)境間的相對運動而在觀測者視覺中明顯表現(xiàn)出來的運動模式。

光流計算通常是建立在以下假設基礎之上的:1)亮度一致性假設,給定點在不同的圖像中具有相同的亮度;2)灰度梯度一致性假設,給定點在不同圖像中具有相同灰度梯度;3)平滑性假設,相鄰點位移不會劇烈變化;4)小幅運動假設,圖像采集具有足夠幀率,相鄰幀僅存在小幅運動。

I(x,y,t)=I(x+Δx,y+Δy,t+Δt)

(1)

IxVx+IyVy+It=0

(2)

光流的亮度不變假設如式(1),其中I為圖像,通過泰勒展開、整理可以得到速度表達式(2),Ix、Iy為圖像沿x、y向灰度的偏導數(shù),It為圖像對時間偏導數(shù),Vx、Vy分別為沿x及y方向的速度。下面僅對經(jīng)典的光流計算原理進行簡要說明。

Lucas-Kanade法[4],假定p點小領域內點具有相同的位移,利用相鄰多m點正交方向速度一致性假設,在式(3)基礎上利用最小二乘法獲得速度估計。該方法對圖像噪聲有抑制作用,無迭代計算、效率高。在梯度變化不明顯區(qū)域,因計算原理限制,無法求解,該方法通常是針對圖像特征點進行計算的。

(3)

Horn-Schunk法[5],基于圖像相同點亮度一致的假設,認為圖像中的光流平滑連續(xù)變化,在亮度一階泰勒展開基礎上,利用式(4)所示誤差罰函數(shù)約束,進行迭代求解,獲得全局、稠密運動信息。但因一階泰勒展開的作用,要求圖像位移小于1個像素,實際應用中采用模糊化、下采樣等方式應對較大位移影響。

E= ?[(Ixu+Iyv+It)2+

(4)

針對Horn-Schunk類算法因線性化帶來的不足,文獻[24]雖沒有進行線性化,但算法復雜,僅能通過迭代的方式進行解算。為獲得局部解算中良好的噪聲抑制能力以及全局稠密光流,文獻[25]提出了局部-全局組合方法(combinedlocal-globalmethods)。Bruhn等[26]提出了可以有效實現(xiàn)局部、全局光流相結合組合檢測方案。

因光流計算能夠獲得相對運動信息,從而實現(xiàn)障礙物探測、運動物體識別、運動速度估計、相對旋轉判定等[27-28],可以被廣泛應用于機器人、無人機導航與自動駕駛系統(tǒng)中,Centeye公司已經(jīng)開發(fā)出低分辨率下可每秒計算達數(shù)千次的芯片級光流傳感器[29],并滿足2%對比度、照度1lux下應用。

光流法是基于亮度不變等假設的,需要高幀頻圖像采集保證相鄰幀滿足計算要求,在圖像移動較大情況下會失去計算合理性,不能利用不連續(xù)圖像獲得導航信息,此外光照的實時變化會影響計算精度。絕大多數(shù)光流計算是建立在單目視覺基礎上的,其速度信息具有尺度模糊性。因此光流法更多應用于速度連續(xù)測量、避障等情況,雖然馬里蘭大學研究團隊提出了較為有效的光流導航方案[9-10],但因僅利用光流不能實現(xiàn)利用歷史圖像進行平差處理,對誤差累積的抑制能力不強,在實現(xiàn)完整視覺導航功能方面相對VO、VSLAM尚有差距。

3 VO的基本工作原理

多視圖幾何是VO、VSLAM工作的基本原理,在此對透視幾何基本內容進行簡要說明。

3.1 攝像機透視投影及視覺導航信息

相機坐標系中坐標為Xc(xc,yc,zc)的空間點,經(jīng)線性相機透視后在圖像坐標系中投影坐標為(u,v),其轉換關系用齊次坐標表示如下

(5)

其中,λ為比例因子,αx、αy分別是u軸與v軸的尺度因子,r是u軸與v軸的不垂直因子,通常為0,u0、v0為光學中心。當世界坐標系與攝像機坐標系間存在旋轉R3×3及平移t=(txtytz)T關系時,世界坐標Xw(xw,yw,zw)與攝像機坐標系的轉化關系為

(6)

極線約束方程如下

(7)

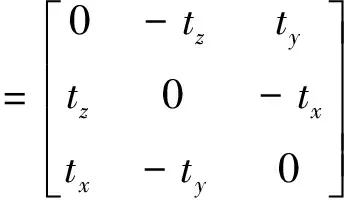

其中,pl、pr為雙目情況下左右攝像機或單目情況下不同時刻圖像中匹配的點對,其齊次坐標為pl=[ul,vl,1]T,[t]×為平移向量的反對稱陣。則點對空間約束關系表示如下:

(8)

E=[t]×R

(9)

可見E包含了轉動與平移信息,稱為本質矩陣,有5個自由度,秩為2,有2個相等不為零奇異值。故僅依據(jù)2幅可匹配的圖像即可獲得攝像機間的相對運動信息,在相機內部參數(shù)K已知情況下可以使用5點法得到R、t,從而獲得相機的相對運動信息。

3.2VO的通用處理方法

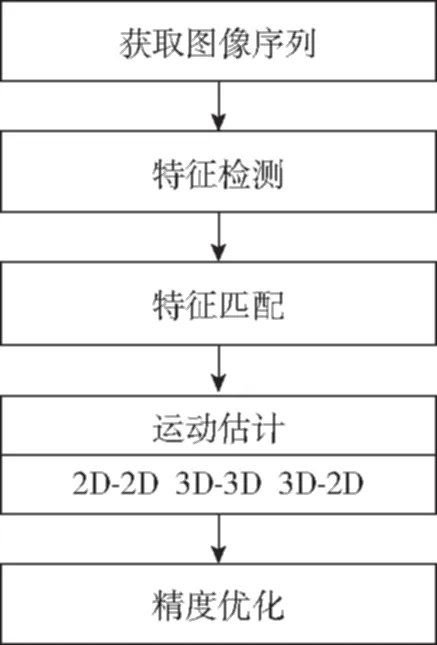

VO有立體、單目視覺等不同的實現(xiàn)方法,Scaramuzza等[21]對各類VO的基本計算過程總結如圖1所示。

圖1 VO的處理過程Fig.1 The processing of VO

穩(wěn)定的圖像特征可以作為圖像中的地標點,從而可以利用3.1節(jié)中的極限約束關系得到2幅圖像間的相對運動信息,但成功匹配特征眾多且存在誤匹配情況,需要利用RANSAC進行誤匹配剔除處理。因VO有基于立體、單目視覺等不同的實現(xiàn)方式,在相對運動估計中可使用不同計算方法,Scaramuzza將其歸納為2D-2D、3D-3D以及3D-2D三類。

2D-2D模式就是利用2幅平面圖像信息進行R、t計算,則式(7)可化為

(10)

針對每一匹配點對,式(10)可以進行如下變形

(11)

其中,E=[e11e12e13e21e22e23e31e32e33]T,依據(jù)Nistér5點法,選擇5對匹配點按照式(11)可構成求解關系,利用SVD法求解得到的本質矩陣,進而可以依據(jù)E分解得到R、t,具體分解方法可參考文獻[16]。

3D-3D模式是利用不同時刻特征點的三維坐標測量結果進行本質矩陣恢復,進而獲得R、t。3D-2D模式則是將之前已經(jīng)獲得特征點三維坐標投影到當前二維圖像中,然后進行的求解。由于3D-2D模式相對3D-3D利用了更多的直接測量結果,能夠更好地減少計算誤差,因此即使雙目VO中也是更多采用的3D-2D方案。

(12)

5點法計算得到的相對運動信息會含有誤差,必須進行誤差抑制,否則會造成嚴重的誤差累積。誤差抑制的方法有多種,如PoseGraph、RANSAC以及BA,其中BA是目前使用最多的方法。BA利用距當前時刻一段時間內的圖像特征點及相對運動結果進行平差,其基本處理思想如式(13)

(13)

如前所述,VO、VSLAM同屬于SFM方法,VO與VSLAM在計算原理上是相同的,因此對VO不同實現(xiàn)方式的比較在VSLAM中統(tǒng)一進行。

4 VSLAM的基本工作原理

按照VSLAM的實現(xiàn)方式,下面分別對濾波、BA、PoseGraph三種方法的基本思想進行介紹,并給出比較分析。

4.1 濾波VSLAM

濾波模型的有效工作是建立在對被估計對象變化規(guī)律、測量原理的有效描述之上的,為完成相機、地標點同時交叉定位的目的,SLAM算法的通用濾波模型可以描述如下:

狀態(tài)方程描述了相機運動及地標點位置的變化規(guī)律,如式(14)

(14)

觀測方程利用每個地標點在圖像中的投影構建, 是投影坐標與相機位置及地標點位置間的函數(shù)關系。

(15)

實際應用中不同方法會對式(14)的狀態(tài)向量有不同的選擇,進而也會造成函數(shù)f的變化。Davison[22]針對單目VSLAM首先使用了三維直角坐標與四元數(shù)相結合的七維攝像機位姿信息狀態(tài),Civera、Davison等對地標點采用了直角坐標與角度、inverse depth相結合的六維向量[31],還有其他研究者使用相機姿態(tài)歐拉角描述方案,但會造成系統(tǒng)模型有較嚴重非線性。

SLAM濾波模型是非線性的,通常采用EKF求解,基于PF的FastSLAM也是一種代表性方法,UKF逐漸被研究者采納,但更多地是應用于視覺/慣性等組合應用中[34]。此外,目前的VSLAM濾波處理更多是各種標準化濾波方法的簡單應用,對如何最優(yōu)化使用濾波器的考慮不夠,未能有效發(fā)揮自適應濾波等技術對估計精度提高的潛力。

4.2 BA優(yōu)化VSLAM

VSLAM中的BA算法從原理上與VO中的完全相同,僅是在具體實現(xiàn)中使用了不同的改進設計,在保證處理效果基礎上提高BA處理速度是此類算法研究的重點。

1)PTAM

PTAM算法的核心內容是僅利用關鍵幀進行地圖構建,并將地圖構建與地標點跟蹤在計算上進行了分離,采用2個獨立的線程進行處理。在圖像處理環(huán)節(jié),針對每個關鍵幀都進行了4層金字塔處理,以便實現(xiàn)不同尺度下特征的快速搜索,采用FAST特征。在跟蹤階段,當新的圖像采集完成后,使用既有相機位姿預測新位姿,以大尺度關鍵圖粗搜索由少量特征匹配計算獲得的相機初步位姿,并在此初步位姿基礎上重新進行大量特征投影、匹配,進而獲得高精度的位姿更新。在地圖創(chuàng)建中,僅針對選定關鍵幀進行,采用了局部BA與全局BA相結合的方式進一步提高處理速度。PTAM在地圖初始化階段,利用雙目視覺完成稠密3D重構,后續(xù)執(zhí)行過程中可完全使用單目攝像機工作。PTAM是一種可滿足實時應用的框架性方案。

2)ORB-SLAM

ORB-SLAM[32]是建立在PTAM處理框架之上的改進實時處理算法。ORB-SLAM針對PTAM的不足進行了有針對性的改進,首先使用了具有尺度、旋轉不變性的ORB特征,除滿足跟蹤需求外,具有場景識別能力;場景識別處理可獨立工作,在跟蹤異常情況下進行相機初步重定位;使用Covisibility Graph、Pose Graph進行了地圖閉環(huán)處理。因ORB-SLAM強調了閉環(huán)處理,并使用了詞袋進行場景識別,在KITTI測試集的封閉路段取得很好的導航效果,但在非重復路段定位效果仍有待提高。

4.3 Pose Graph優(yōu)化VSLAM

Pose Graph優(yōu)化也是SLAM研究中重要的一種優(yōu)化方法,通過關鍵幀之間位姿關系約束進行地圖優(yōu)化[33],其基本原理可用式(16)說明

(16)

Ci為第i幀圖像時攝像機在世界坐標系的位姿矩陣, Ti,j為i,j兩時刻攝像機位姿矩陣間的轉移矩陣,在得到各時刻攝像機位姿信息后,通過式(16)最小化可達到地圖優(yōu)化的目的,通常也是在最近時間窗內進行優(yōu)化的。

Engle等[19]提出的LSD-SLAM是目前使用PoseGraph較成功的算法,同時也使用了EKF、關鍵幀、地圖跟蹤與創(chuàng)建分離等技術,其目的是在獲得相機位姿的同時對場景進行大規(guī)模三維重構,所有工作都實時完成,該方法能夠直接部署到手機上作為VO實時工作。

LSD-SLAM建立在一種Semi-denseVO[18]方法之上,其一個重要特點是直接利用圖像亮度信息進行深度計算,相對圖像特征而言能夠使用更多的圖像信息。其三維重構是針對圖像中梯度較大的區(qū)域進行,因此是一種半稠密重構。深度信息估計中使用了EKF,通過預測、校正提高深度圖的準確性。

4.4 優(yōu)化方法的分析

濾波VSLAM是通過濾波計算提高相機及特征點的估計精度,EKF、UKF、PF等算法都是采用連續(xù)遞推方式,具有序列化合理利用圖像特征空間約束的作用,但是解算會存在以下不足:濾波精度受視覺觀測誤差不確定性的影響明顯;EKF的計算量隨特征點數(shù)量的增加指數(shù)上升;缺乏利用時間窗口內多幅關鍵幀內圖像特征進行聯(lián)合約束的處理方式,在濾波器受干擾下誤差的抑制能力不足。BA優(yōu)化VSLAM有效利用了時間窗內觀測及計算信息進行綜合約束,能夠達到良好的平差效果,但是計算量過大,需要采用PTAM等快速處理方法才能實現(xiàn)實時處理。PoseGraph優(yōu)化VSLAM在優(yōu)化方式上僅是使用了序列位姿關系的一致性,相對BA約束條件有所弱化,會導致優(yōu)化結果最優(yōu)性有所降低。

Strasdt[21]針對濾波及BA兩種方法,通過對單目、雙目VSLAM的分析及大量仿真,得出了增加特征點數(shù)量而不是關鍵幀對精度提高最有效的結論,這種情況下BA的效率要優(yōu)于濾波VSLAM。對于BA與PoseGraph,Mur-Artal[32]在ORB-SLAM、PTAM及LSD-SLAM性能對比試驗中發(fā)現(xiàn)從導航精度角度出發(fā),ORB-SLAM略優(yōu)于PTAM,LSD-SLAM精度較差,主要原因是LSD-SLAM采用了PoseGraph優(yōu)化,從側面反映了BA與PoseGraph的差別。

5 視覺導航技術未來發(fā)展

純視覺導航研究取得了重要的進展,并較好地實現(xiàn)了精度與處理速度的大幅度提高,特別是突破了單目視覺在應用中的多種局限性,已經(jīng)初步形成了理論體系并能夠支撐實際應用,但在無先驗知識、非往復運動情況下,同樣存在不可避免的導航誤差累積問題,且成像干擾、圖像中斷會導致測量精度迅速下降甚至不可用。視覺導航與衛(wèi)星導航、慣性導航等其他導航方式相比,體現(xiàn)出更多的互補性,因此組合導航仍然是最為有效的解決途徑。在眾多組合模式中,視覺/慣性組合具有良好的互補性、自主性,普及推廣優(yōu)勢明顯,實踐證明慣性信息的引入,可以大幅度降低算法的復雜度、提高性能[20,33,35-37]。面向應用的視覺/慣性組合有2個方面的問題亟待解決:1)針對移動平臺具有較高慣性測量精度的組合應用,因慣性測量對短時間內運動變化的測量精度遠高于視覺,應重點研究可被短時間內視覺測量敏感的慣性誤差表現(xiàn)形式,否則失去組合的必要性;2)針對低成本組合應用,重點解決低成本慣性器件高測量誤差下的BA加速、視覺/慣性濾波組合,使緊湊、小型化嵌入式組合系統(tǒng)達到因時間造成的累積誤差近似于零的水平,并具備可靠的模塊化應用能力。

VO、VSLAM雖然目前已經(jīng)能夠通過濾波、PTAM實現(xiàn)實時計算,地圖在向稠密構建方向發(fā)展,并已能夠初步實現(xiàn)空間的稠密實時三維重構[38],但對于導航應用,基于魯棒特征的最簡化稀疏地圖構建、BA快速實現(xiàn)等方面的研究可大幅度提高視覺及其組合導航系統(tǒng)的魯棒性、可實現(xiàn)性,意義十分重要。此外因地標點具有絕對空間位置的不變性,存在僅利用其不變性約束、回避地標點具體位置解算的簡化、高精度處理可能,該方向研究的成果可從根本上降低計算量,使視覺及視覺組合導航應用能夠高可靠性地部署到低成本硬件平臺上。

場景自動識別已經(jīng)成為視覺導航一個重要研究方向[39],深度學習等智能化算法在場景稠密深度圖實時構造輔助下,使場景深入理解成為可能,從而可以克服目前導航地圖只包含無意義的空間坐標信息的不足,賦予場景中全部或主要對象明確的語義,就可以在語義層次上實現(xiàn)導航,在現(xiàn)有導航系統(tǒng)能力上增加基于環(huán)境理解的宏觀導航精度保障措施,是未來視覺導航技術的必然發(fā)展方向。

[1] 張廣軍. 機器視覺[M]. 北京:科學出版社,2005.

[2]MorevecHP.Towardsautomaticvisualobstacleavoidance[C].InternationalJointConferenceonArtificialIntelligence.MorganKaufmannPublishersInc. 1977:584-584.

[3]FranzMO,MallotHA.Biomimeticrobotnavigation[J].RoboticsandAutonomousSystems, 2000, 30(1): 133-153.

[4]LucasBD,KanadeT.Aniterativeimageregistrationtechniquewithanapplicationtostereovision[C].InternationalJointConferenceonArtificialIntelligence.MorganKaufmannPublishersInc. 1981:674-679.

[5]HornBKP,SchunckBG.Determiningopticalflow[J].ArtificialIntelligence, 1980, 17(1-3):185-203.

[6]MukawaN.Optical-model-basedanalysisofconsecutiveimages[J].ComputerVisionandImageUnderstanding, 1997, 66(1): 25-32.

[7]IzzoD,WeissN,SeidlT.Constant-optic-flowlunarlanding:Optimalityandguidance[J].JournalofGuidance,Control,andDynamics, 2012, 34(5): 1383-1395.

[8]OhnishiN,ImiyaA.Dominantplanedetectionfromopticalflowforrobotnavigation[J].PatternRecognitionLetters, 2006, 27(9): 1009-1021.

[9]HyslopA,HumbertJS.Wide-fieldintegrationmethodsforautonomousnavigationin3-Denvironments[C].AIAAGuidance,NavigationandControlConferenceandExhibit, 2008:1-18.

[10]HyslopAM,HumbertJS.Autonomousnavigationinthree-dimensionalurbanenvironmentsusingwide-fieldintegrationofopticflow[J].JournalofGuidance,Control,andDynamics, 2010, 33(1): 147-159.

[11]Longuet-HigginsHC.Acomputeralgorithmforreconstructingascenefromtwoprojections[J].Nature, 1981, 293(5828):133-135.

[12]HarrisCG,PikeJM. 3Dpositionalintegrationfromimagesequences[J].ImageandVisionComputing, 1988, 6(2): 87-90.

[13]JungSH,TaylorCJ.Cameratrajectoryestimationusinginertialsensormeasurementsandstructurefrommotionresults[C].Proceedingsofthe2001IEEEComputerSocietyConferenceonComputerVisionandPatternRecognition.IEEE, 2001:732-737.

[14]NütziG,WeissS,ScaramuzzaD,etal.FusionofIMUandvisionforabsolutescaleestimationinmonocularSLAM[J].JournalofIntelligent&RoboticSystems, 2011, 61(1): 287-299.

[15]ScaramuzzaD,FraundorferF.Tutorial:visualodometry[J].IEEERoboticsandAutomationMagazine, 2011, 18(4): 80-92.

[16]NistérD.Anefficientsolutiontothefive-pointrelativeposeproblem[J].IEEETransactionsonPatternAnalysisandMachineIntelligence, 2004, 26(6): 756-770.

[17]NistérD,NaroditskyO,BergenJ.Visualodometry[C].Proceedingsofthe2004IEEEComputerSocietyConferenceonComputerVisionandPatternRecognition.IEEE, 2004:652-659.

[18]Sch?psT,EngelJ,CremersD.Semi-densevisualodometryforARonasmartphone[C]. 2014IEEEInternationalSymposiumonMixedandAugmentedReality(ISMAR)-Media,Arts,SocialScience,HumanitiesandDesign.IEEE, 2014: 145-150.

[19]EngelJ,Sch?psT,CremersD.LSD-SLAM:Large-scaledirectmonocularSLAM[C].EuropeanConferenceonComputerVision.SpringerInternationalPublishing, 2014: 834-849.

[20]TardifJP,GeorgeM,LaverneM,etal.Anewapproachtovision-aidedinertialnavigation[C]// 2010IEEE/RSJInternationalConferenceonIntelligentRobotsandSystems(IROS).IEEE, 2010: 4161-4168.

[21]StrasdatH,MontielJMM,DavisonAJ.Real-timemonocularSLAM:Whyfilter?[C]. 2010IEEEInternationalConferenceonRoboticsandAutomation(ICRA).IEEE, 2010: 2657-2664.

[22]DavisonAJ.Real-timesimultaneouslocalisationandmappingwithasinglecamera[C].ProceedingsoftheIEEEInternationalConferenceonComputerVision.IEEE, 2003:1403-1410.

[23]KleinG,MurrayD.ParalleltrackingandmappingforsmallARworkspaces[C].IEEEandACMInternationalSymposiumonMixedandAugmentedReality.IEEEComputerSociety, 2007: 225 - 234.

[24]BroxT,BruhnA,PapenbergN,etal.Highaccuracyopticalflowestimationbasedonatheoryforwarping[C].EuropeanConferenceonComputerVision.SpringerBerlinHeidelberg, 2004: 25-36.

[25]BroxT,BreglerC,MalikJ.Largedisplacementopticalflow[C].IEEEConferenceonComputerVisionandPatternRecognition.IEEE, 2009: 41-48.

[26]BruhnA,WeickertJ,Schn?rrC,etal.Lucas/KanademeetsHorn/Schunck:Combininglocalandglobalopticflowmethods[J].InternationalJournalofComputerVision, 2005, 61(3): 211-231.

[27]ChaoH,GuY,GrossJ,etal.AcomparativestudyofopticalflowandtraditionalsensorsinUAVnavigation[C].AmericanControlConference(ACC).IEEE, 2013: 3858-3863.

[28]ChaoH,GuY,NapolitanoM.Asurveyofopticalflowtechniquesforroboticsnavigationapplications[J].JournalofIntelligent&RoboticSystems, 2014, 73(1): 361-372.

[29]http://www.centeye.com/technology/vision-chips/

[30]HartleyR,ZissermanA.Multipleviewgeometryincomputervision. 2nded[M].CambridgeUniversityPress, 2003.

[31]CiveraJ,DavisonAJ,MontielJMM.Inversedepthtodepthconversionformonocularslam[C]. 2007IEEEInternationalConferenceonRoboticsandAutomation.IEEE, 2007: 2778-2783.

[32]Mur-ArtalR,MontielJMM,TardosJD.ORB-SLAM:aversatileandaccuratemonocularSLAMsystem[J].IEEETransactionsonRobotics, 2015, 31(5): 1147-1163.

[33]TiefenbacherP,SchulzeT,RigollG.Off-the-shelfsensorintegrationformono-SLAMonsmartdevices[C].ProceedingsoftheIEEEConferenceonComputerVisionandPatternRecognitionWorkshops.IEEE, 2015: 15-20.

[34]OlsonE,LeonardJ,TellerS.Fastiterativealignmentofposegraphswithpoorinitialestimates[C].Proceedingsofthe2006IEEEInternationalConferenceonRoboticsandAutomation.IEEE, 2006: 2262-2269.

[35]ZhouH,NiK,ZhouQ,etal.AnSfMalgorithmwithgoodconvergencethataddressesoutliersforrealizingmono-SLAM[J].IEEETransactionsonIndustrialInformatics, 2016, 12(2): 515-523.

[36]HuangR,TanP,ChenBM.Monocularvision-basedautonomousnavigationsystemonatoyquadcopterinunknownenvironments[C]. 2015InternationalConferenceonUnmannedAircraftSystems(ICUAS).IEEE, 2015: 1260-1269.

[37]IndelmanV,GurfilP,RivlinE,etal.Real-timevision-aidedlocalizationandnavigationbasedonthree-viewgeometry[J].IEEETransactionsonAerospaceandElectronicSystems, 2012, 48(3): 2239-2259.

[38]NewcombeRA,LovegroveSJ,DavisonAJ.DTAM:Densetrackingandmappinginreal-time[C].IEEEInternationalConferenceonComputerVision.IEEEComputerSociety, 2011:2320-2327.

[39]LowryS,SünderhaufN,NewmanP,etal.Visualplacerecognition:Asurvey[J].IEEETransactionsonRobotics, 2016, 32(1):1-19.

[40]MichaelM,SebastianT,DaphneK,etal.FastSLAM2.0:Animprovedparticlefilteringalgorithmforsimultaneouslocalizationandmappingthatprovablyconverges[C].Proceedingsofthe16thInternationalJointConferenceonArtificialIntelligence(IJCAI). 2003:1151-1156.

The Development of Visual Navigation

ZHANG Hai1, WU Ke-qiang1, ZHANG Xiao-ou2

(1.School of Automation Science and Electrical Engineering, Beihang University, Beijing 100191, China; 2.Unmanned Aerial Vehicle Research Institute, Beihang University, Beijing 100191, China)

Along with the fast development of visual navigation in the last two decades, some significant progresses have been achieved and applications in wide fields are ready to come. The developments,theories, advantages and difficulties are introduced according to the main visual navigation algorithms of optical flow, Visual Odometry and VSLAM. Finally, the future researches of coming and long term stages are analyzed in brief.

SFM; VO; VSLAM;Optical flow; Integrated navigation

2017-02-07;

2017-03-08

國家重點研發(fā)計劃(2016YFB0502004);國家自然科學基金國際合作與交流項目(61320106010)

張海(1970-),男,博士,副教授,主要從事慣性、視覺及組合導航技術等方面的研究。 E-mail:zhanghai@buaa.edu.cn

10.19306/j.cnki.2095-8110.2017.02.001

TP391.4

A

2095-8110(2017)02-0001-08