卷積神經網絡與時空上下文結合的目標跟蹤算法

閔召陽,趙文杰

?

卷積神經網絡與時空上下文結合的目標跟蹤算法

閔召陽,趙文杰

(空軍航空大學 航空航天情報系,吉林 長春 130022)

本文所提算法是一種卷積神經網絡與時空上下文結合的目標跟蹤算法。將卷積神經網絡算法融入時空上下文算法框架下,使得跟蹤系統整體的魯棒性有顯著提高。引入Kalman濾波來處理目標被嚴重遮擋時,跟蹤框容易漂移的問題。此外,整個跟蹤系統采取由粗到精的雙重目標位置定位方式,由時空上下文算法實現目標初定位,由卷積神經網絡進行目標位置的精確定位。經實驗驗證,算法不僅穩定性和魯棒性較好,而且實時性的條件也基本滿足。

目標跟蹤;時空上下文;卷積神經網絡

0 引言

目標跟蹤是計算機視覺領域比較熱門的研究熱點之一,目前在這方面有很多優秀的算法,但是這些算法通常只能在處理某一類問題時表現出色,很難找到一種算法在應付目標的尺度變化,形狀變化,運動速度和方向變化,環境光照以及目標遮擋等一系列問題時都保持魯棒的跟蹤。因此未來一段時間里,跟蹤問題在計算機視覺領域中的研究難度依舊較高。

生成式和判別式是目前針對目標跟蹤算法的兩種主流的分類方法。生成式跟蹤算法[1]需要對局部或全局圖像進行搜索,找出重構誤差最小的區域作為預測位置。其工作重點在于如何利用學習到的特征對目標進行描述,并構建外觀模型。而判別式跟蹤算法在對背景信息的利用上比較充分,但是跟蹤的準確度容易受樣本的影響。兩類算法各有優劣,生成式跟蹤算法忽略了背景信息對目標的影響,目標與背景相似時容易造成誤跟蹤,判別式跟蹤算法[2-5],將目標與背景的信息都進行了利用,其目的是尋找能夠將目標和背景分離開的最優化決策邊界,從而將其轉化為二分類問題。

時空上下文目標跟蹤算法(Spatio Temporal Context, STC)對目標位置的確定使用了時間和空間的局部相關性提供輔助信息,又稱上下文關系。該算法由Zhang[6]等人提出。這種算法通過計算目標及其周圍區域的低階特征進行統計建模,并利用置信圖進行最大似然估計,預測出目標位置。算法本身計算量較小,且在應對短時部分遮擋時具有較高的穩定性。但是該算法仍然存在以下幾個問題:①STC僅僅利用了圖像的低階特征,當目標與背景比較相似的時候,容易導致跟蹤失敗;②不具備檢測能力,一旦跟蹤框漂移出去,目標無法找回;③該算法在應對部分遮擋以及短時遮擋時表現較好,一旦遮擋時間拉長,跟蹤效果就會大打折扣。

針對上述問題,本文將卷積神經網絡(Convolutional Neural Network, CNN)融入時空上下文跟蹤框架下,形成一種新的目標跟蹤算法。將時空上下文算法作為跟蹤器,將卷積神經網絡作為檢測器,提高了目標經過相似背景時的跟蹤魯棒性。對于前景信息對目標造成嚴重或長時遮擋的情況,啟用Kalman濾波機制對目標的速度,加速度以及位置信息進行預估,并在預測區域利用卷積神經網絡進行檢測,從而使得目標在這兩種情況下的跟蹤穩定性得到提升。此外,基于目標當前的置信圖對時空上下文模型進行更新同時對卷積神經網絡模型進行微調,而更新速率由目標當前位置前兩幀位置置信圖的梯度決定,避免了目標被遮擋時模型進行錯誤的更新。

1 時空上下文及卷積神經網絡算法

時空上下文算法是基于Bayes算法框架,對目標和其周圍區域建立時空對應關系,利用圖像的低階特征進行統計建模,通過對置信圖的計算,找到似然概率最大的區域,即為下一幀跟蹤結果位置。

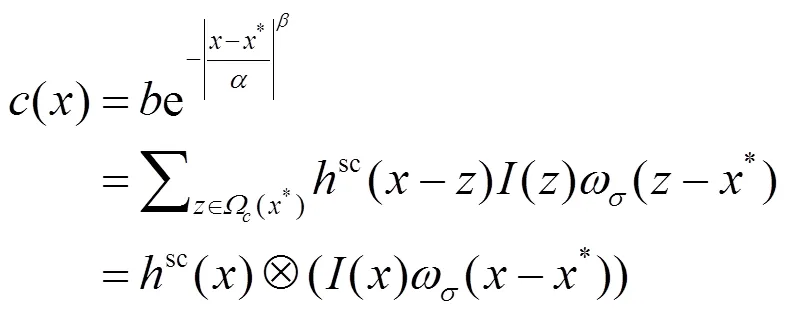

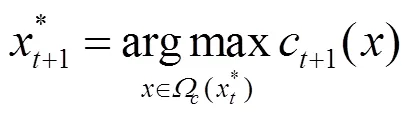

假定當前幀中,目標的位置已知,設為*,則當前幀的圖像特征可以表示為:

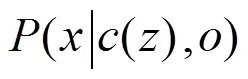

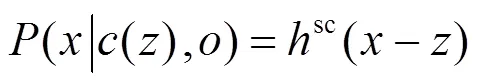

式中:()表示點位置的圖像灰度;(*)表示目標在當前幀中的局部區域,然后文獻[7]給出了目標的置信度表示:

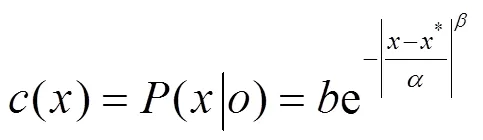

式中:()為目標的置信圖;表示尺度參數;表示形狀參數。

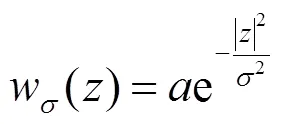

式中:()表示圖像的灰度特征;表示權重函數;-*表示點與目標位置*的距離關系。從幀速與目標移動速度對比來看,通常情況下與上一幀目標位置距離越近的點對目標越重要,因此要賦予更大的權重。對權重函數的定義為:

式中:是尺度參數;而是歸一化參數。

目標置信圖()的定義式為:

式中:表示形狀參數;表示尺度參數;表示歸一化系數,實驗表明,=1時跟蹤效果較好。結合上述各公式可以將(2)式改寫為:

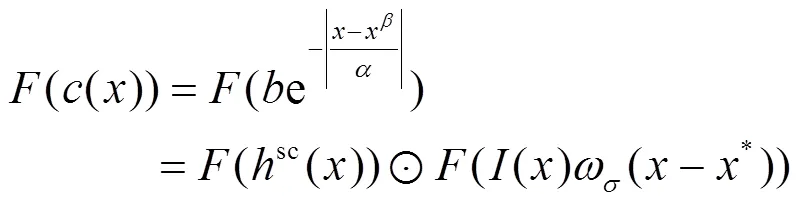

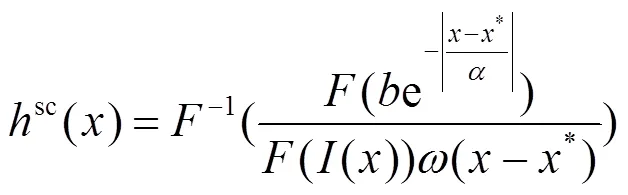

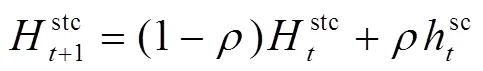

式中:()表示處的像素值,?代表卷積運算,由于時域的卷積可以轉化為頻域的乘法運算,提高計算速度,因此通常利用快速傅里葉將上式轉換到頻域:

進而可以學習出空間上下文模型:

基于幀目標位置找出+1幀的局部預估區域:

其中對c+1()的定義為:

通過計算出+1幀中最大似然概率在置信圖中的位置,完成當前幀的跟蹤。

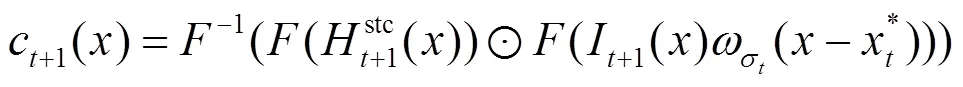

深度學習在圖像識別領域已經取得了顯著的效果,而CNN又是深度學習的一個重要分支,它在計算機視覺的各個研究方向上都是一個研究熱點[8]。CNN由卷積層和全連接層組成,可以通過權值共享,降采樣和多卷積核的方式降低參數數目并提高識別效果,在學習目標高維特征方面具有突出優勢。而本文的CNN結構輸入設計為區域圖像,使得目標的檢出效率和跟蹤的魯棒性都有所提高。

CNN是一個多層次模型。每一層都可以通過多種特征處理方式生成多個特征面,而特征面又包含多個神經元。CNN提取特征的部分分為降采樣層(S層)和特征提取層(C層)兩種,降采樣層跟在特征提取層之后,通常在訓練網絡時特征提取層的數量采用兩層及以上的結構,這樣會使訓練出來的網絡對變形有較高的容忍能力。考慮到算法本身要兼顧跟蹤的實時性和檢測的準確性,本文特征提取層數量設置為兩層然后通過全連接層和輸出層輸出結果如圖1所示。

2 本文算法

本文將CNN算法融入STC框架,同時引入了Kalman濾波進行強遮擋情況下的位置預測。對于檢測模塊,將STC算法預測的目標及其時空上下文區域作為卷積神經網絡識別的初始區域,避免了卷積神經網絡耗時的全圖搜索同時彌補STC算法不能跟蹤重現目標的缺陷,當目標被嚴重遮擋時,啟用Kalman濾波算法預測目標相關信息,并利用卷積神經網絡算法搜索該區域,將搜索結果作為最終位置輸出。本文算法框架如圖2所示。

2.1 網絡建模與訓練

卷積神經網絡的優勢體現在其海量的樣本數據上,而訓練過程相對耗時,因此在跟蹤前需要進行離線訓練,本文選用了城市SUV和多車交叉行駛兩個視頻進行仿真實驗,針對兩個實驗視頻分別進行了兩次模型訓練,輸入圖片分為正負樣本,正樣本為小汽車目標,負樣本為背景圖片,針對第一種實驗視頻的兩類圖片大小經處理后都為18pixel×27pixel,針對第二個視頻的兩類圖片大小經處理后都為10pixel×10pixel。圖片采集來源于UIUC Image Database,正負樣本總數量為20183張。以線下訓練的方式得到了小汽車的廣義化特征。

在第一層卷積操作中,權重矩陣設為1,其中有6種卷積核,也即6個特征映射矩陣:

1=[11,21,3141,51,61],"1?3×11×11(11)

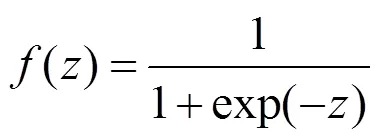

每個卷積核對應的參數在第一層卷積操作中的表示為1,核的通道數為3,尺寸為5×5。下采樣間隔設為1。本文激活函數采用常用的sigmoid函數,公式如下所示:

第二層卷積操作公式不再贅述,核通道數仍為3,尺寸變為3×3。CNN特征提取部分之后為全連接層,最后是輸出層,用以輸出數據的最終特征,公式如下:

4=43(13)

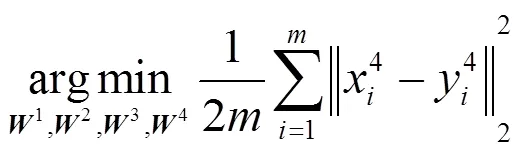

本文選用歐氏距離作為目標函數求取正負樣本間的相關程度,公式如下:

學習到的權重可以映射到目標的參考區域。

2.2 目標運動跟蹤

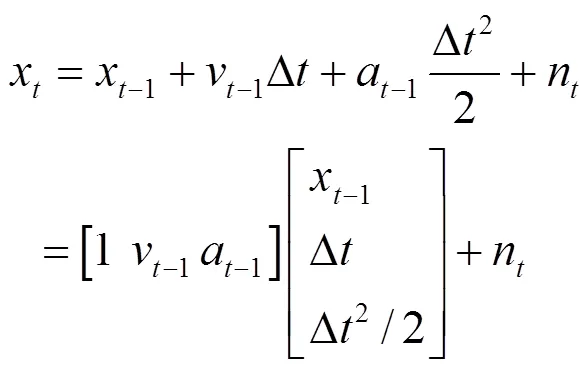

目標的運動跟蹤采用STC跟蹤器與CNN相結合的方式進行,在視頻跟蹤的大部分時間里STC算法表現比較穩定,尤其是應對前景信息短時或部分遮擋目標時有較好的適應性。但是當目標在幀間運動距離過大、遮擋嚴重或者遮擋時間過長時,容易導致跟蹤失敗,因此本文引入Kalman濾波進行位置預測[9],目標的中心坐標位置(,)是目標跟蹤中狀態方程的重要參量,狀態方程為:

式中:n表示系統噪聲;a-1表示-1時刻的加速度;v-1表示-1時刻的速度;x表示時刻的狀態。

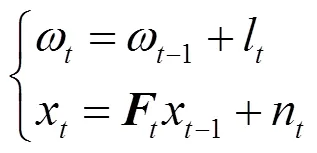

跟蹤正常時,將上式得出的值視為真值與前幾次的位置信息保留,用以計算上一幀的速度v-1和加速度a-1,狀態和觀測方程可寫為如下所示:

式中:表示狀態轉移矩陣;l表示觀測噪聲;表示待估參數。

Kalman濾波機制是在目標被嚴重遮擋或者出現其它問題時啟用。利用上一幀位置和速度信息預估出當前幀的位置,在該位置下利用CNN搜索,本文搜索范圍默認為局部上下文區域的大小。

2.3 算法實現

本文算法實現具體流程如下:

1)創建正負樣本訓練數據集;

2)創建CNN模型;

3)訓練CNN;

4)輸入視頻幀;

5)初始化目標跟蹤框;

6)STC算法跟蹤,給出跟蹤結果(包括目標位置、空間上下文區域和置信圖);

7)CNN算法在給出的空間上下文區域內進行搜索識別,給出目標結果置信圖;

8)使用Kalman濾波預測出目標的速度、加速度和位置信息并將值保留(若STC和CNN沒有檢測到目標則不對模型進行更新);

9)判斷:當兩種算法都對目標做出了標定時,轉入步驟10);若STC或CNN其中一種算法預估出目標所在位置,轉入步驟11);若兩種算法都沒有捕獲目標,則用上一步Kalman算法得到的速度和加速度預估出位置,對置信度進行計算并與閾值對比,小于閾值時認定當前幀中無目標,保留速度、加速度和當前位置信息,并在下一幀開始時,直接啟用Kalman濾波進行位置預測,然后將當前結果視為最終位置,轉入步驟12);

10)用STC和CNN兩種算法所取得的置信度作為衡量標準,篩選出值高的位置作為備選結果;

11)求得目標最終位置,同時刷新步驟8中的位置信息;

12)模型更新,輸入下一幀。

3 實驗結果分析

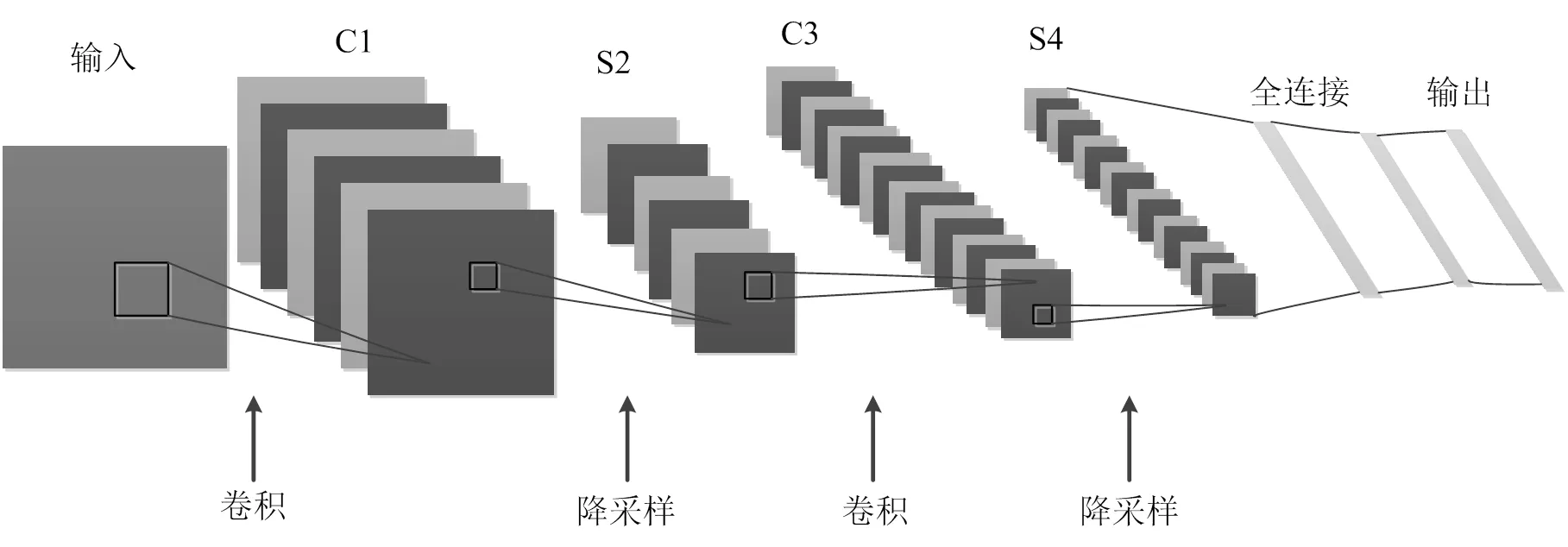

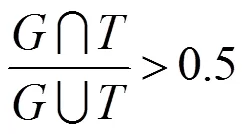

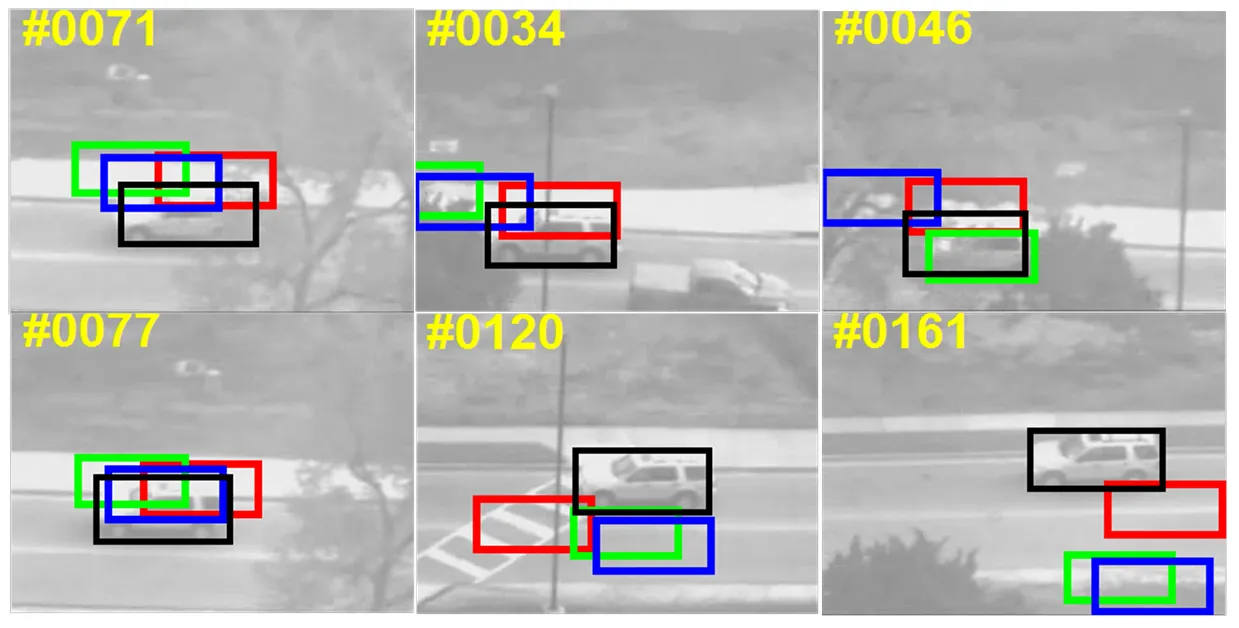

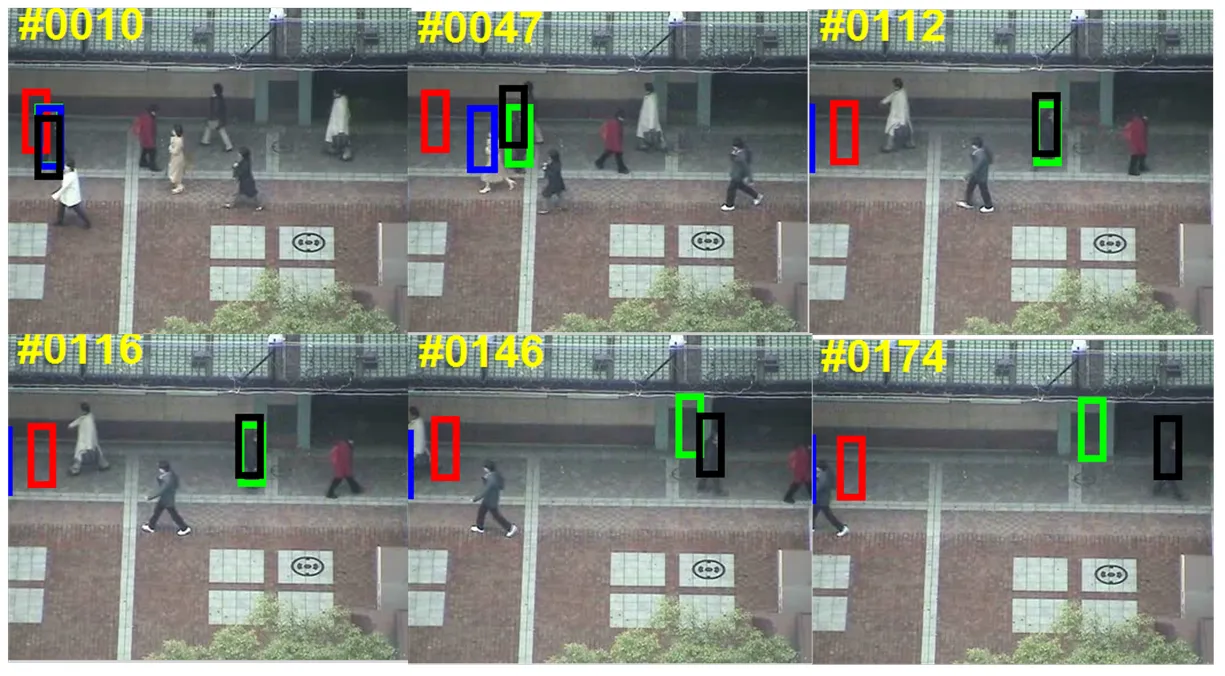

為測試本文所提算法的性能,將本文算法與目前主流的幾個算法進行實驗對比分析,如圖3、圖4所示,深灰色框為MS[10],灰色框為TLD[5],淺灰色框為CT[11],黑色框為本文算法。硬件環境:CPU Intel Core i5 2.60GHz,GPU NVIDIA GeForce GTX950M,安裝內存4.00GB,系統類型64位操作系統。軟件平臺:MATLAB R2010b。本文使用兩個標準實驗測試視頻分別對本文算法和主流算法進行比對。

第一組實驗選用的是320×240城市SUV視頻。如圖3和圖4所示,第34幀的時候進入遮擋,第46幀時,幾種算法都還保持著一定的穩定性,這是由于兩種算法在應對短時局部遮擋時表現都比較好,然而46幀~71幀都是遮擋的過程,STC算法在應對長時嚴重遮擋時跟蹤性能明顯下降,在77幀經過遮擋區域后時,主流算法的跟蹤框都出現比較嚴重的偏移。120幀時,出現與車相近的背景信息,主流算法看跟蹤框出現明顯偏移,而由于本文算法此時發揮了CNN的優勢,跟蹤比較穩定,161幀時,主流算法跟蹤框基本無法找回。

第二組實驗選用的是352×288行人視頻。如圖4所示,視頻在10幀時行人開始出現交叉,47幀左右出現遮擋,此時TLD和MS跟蹤框漂移出去,146幀時目標附近出現相似的背景,STC算法跟蹤框在這種情況下,出現了誤跟,導致目標跟蹤失敗,而本文算法由于利用了CNN算法的優勢,因此對目標的識別穩定性較好,在遇到相似背景時能夠保持較高的分辨能力。

圖3 實驗視頻一:算法實驗序列截取結果

圖4 實驗視頻二:算法實驗序列截取結果

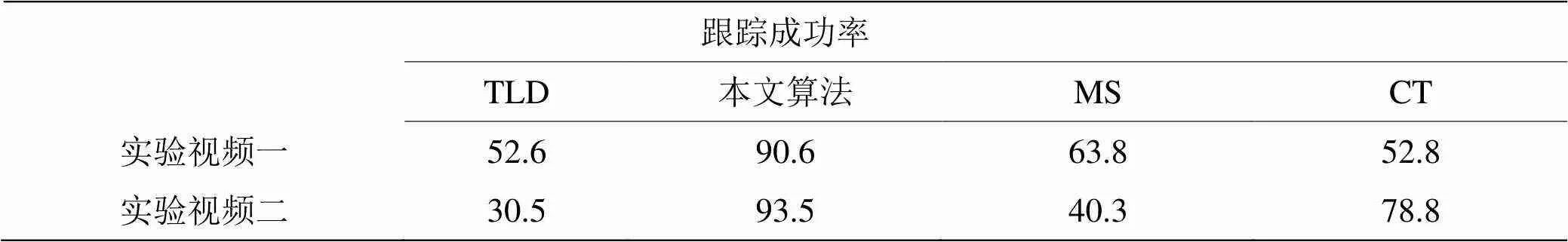

表1給出了包括本文算法在內的4種跟蹤算法的跟蹤成功率對比,表2給出了4種算法的平均幀率對比。從表中可以看出,雖然平均幀率這一指標上略低,但是本文算法在跟蹤成功率上高于主流算法,這是因為本文算法引入了CNN和Kalman濾波,增強了跟蹤的魯棒性,但同時也提高了算法的復雜度和計算量,因此平均幀率與主流算法相比有所降低,不過基本滿足實時性要求。

表1 成功率對比評價表

表2 平均幀率對比評價表

4 總結

本文所提一種CNN與STC相融合的目標跟蹤算法。將CNN算法嵌入在STC算法的框架中,實現了目標的穩定跟蹤,并且穩定性得到顯著加強,并且本文算法引入了Kalman濾波預測應對長時嚴重遮擋,彌補了STC算法的遇到嚴重遮擋后跟蹤框漂移不能檢測找回的不足。經實驗驗證,本文算法很好地融合了STC和CNN的優勢,魯棒性強,并且在遭遇嚴重遮擋后目標重新找回時情況表現良好。而算法的實時性上較STC算法相比有所下降,但是20.9f/s的平均跟蹤速率基本可以滿足實時性的要求。

[1] 呂枘蓬, 蔡肖芋, 董亮, 等. 基于TLD框架的上下文目標跟蹤算法[J]. 電視技術, 2015, 39 (9): 6-9.

LV N P, CAI X Y, DONG L, et al. The context of the target tracking algorithm based on TLD framework[J]., 2015, 39(9): 6-9.

[2] WU Y, LIN J, YANG M H. Online object tracking: A benchmark[C]//, 2013: 2411-2418.

[3] Grabner H, Leistner C, Bischof H. Semi-supervised on-line boosting for robust tracking[C]//, 2008, 5302: 234-247.

[4] Babenko B, Yang M H, Belongie S. Robust object tracking with online multiple instance learning[J]., 2011, 33(8): 1619-1632.

[5] Kalal Z, Mikolajczyk K, Matas J. Tracking-learning-detection[J]., 2012, 34(7): 1409-1422.

[6] ZHANG K H, ZHANG L, LIU Q S, et al. Fast visual tracking via dense spatio-temporal context learning[C]//, 2014, 8693: 127-141.

[7] 劉威, 趙文杰, 李成. 時空上下文學習長時目標跟蹤[J]. 光學學報, 2016(1): 179-186.

LIU W, ZHAO W J, LI C. Long-term target tracking based on spatial and temporal context learning[J]., 2016(1): 179-186.

[8] Krizhevsky A, Sutskever I, Hinton G E. Image net classification with deep convolutional neural networks[J]., 2012, 25(2): 2012.

[9] 王江濤, 楊靜宇. 遮擋情況下基于Kalman均值偏移的目標跟蹤[J]. 系統仿真學報, 2007, 19(18):4216-4220.

WANG J T, YANG J Y. Target tracking based on Kalman mean shift in occlusion[J]., 2007, 19(18): 4216-4220.

[10] Collins R T. Mean-shift blob tracking through scale space[C]//on, 2003, 2: 234-240..

[11] ZHANG K, ZHANG L, YANG M H. Real-time compressive tracking[C]//, 2012: 864-877.

[12] Everingham M, Gool L V, Williams C K I, et al. The Pascal, visual object classes (VOC) challenge[J]., 2010, 88(2): 303-338.

A Target Tracking Algorithm Combining Convolution Neural Network with Spatio Temporal Context

MIN Zhaoyang,ZHAO Wenjie

(,,130022,)

In this paper, an algorithm of the target tracking combining convolution neural network with the temporal and spatial context is proposed. In the framework of the context-based algorithm, the convolutional neural network algorithm is integrated to improve the stability and robustness of the tracking system. The Kalman filter is introduced to deal with the problem that the target is obscured. In addition, the whole tracking system adopts a coarse-to-fine target location method, and the target localization is achieved by the temporal and spatial context algorithm, and the target location is accurately located by the convolution neural network. Experimental results show that the proposed algorithm is stable and robust for real-time performance.

target tracking,spatio temporal context,convolution neural network

TP391

A

1001-8891(2017)08-0740-06

2016-12-29;

2017-02-21.

閔召陽(1992-),碩士研究生。研究方向:模式識別與智能系統。E-mail:361109520@qq.com。

趙文杰(1968-),博士。研究方向:光學成像自動目標識別。