基于三維人體語(yǔ)義骨架點(diǎn)的姿態(tài)匹配

王大鵬 黎 琳 韓 麗 張美超 王露晨

(遼寧師范大學(xué)計(jì)算機(jī)與信息技術(shù)學(xué)院 遼寧 大連 116081)

基于三維人體語(yǔ)義骨架點(diǎn)的姿態(tài)匹配

王大鵬 黎 琳 韓 麗 張美超 王露晨

(遼寧師范大學(xué)計(jì)算機(jī)與信息技術(shù)學(xué)院 遼寧 大連 116081)

針對(duì)三維人體模型結(jié)構(gòu)復(fù)雜,處理數(shù)量大且不易提取控制點(diǎn)等問(wèn)題,提出通過(guò)對(duì)人體形狀進(jìn)行特征分析描述人體結(jié)構(gòu)并進(jìn)行姿態(tài)識(shí)別的算法。融合測(cè)地線(xiàn)與空間結(jié)構(gòu)等特征提取骨架點(diǎn)有效減少數(shù)據(jù)的計(jì)算量,并通過(guò)ICP算法進(jìn)行姿態(tài)的行為識(shí)別。實(shí)驗(yàn)證明,該算法有效地提升了三維姿態(tài)的識(shí)別效率,并有很好的魯棒性。

三維人體 語(yǔ)義骨架 姿態(tài)識(shí)別

0 引 言

近年來(lái),人體姿態(tài)識(shí)別成了計(jì)算機(jī)視覺(jué)領(lǐng)域中的一個(gè)重要研究方向。人作為社會(huì)活動(dòng)的主體,對(duì)人的動(dòng)作行為進(jìn)行識(shí)別分析具有重要的研究?jī)r(jià)值,在醫(yī)療、監(jiān)控、人機(jī)交互等方面具有廣闊的應(yīng)用前景。對(duì)于大量的三維人體模型數(shù)據(jù),如何去自動(dòng)獲取人體特征、學(xué)習(xí)并分析其動(dòng)作行為[1]已是目前研究的重點(diǎn)和難點(diǎn)所在。

人體姿態(tài)行為具有高度靈活、內(nèi)部結(jié)構(gòu)復(fù)雜的特性,很難用單一特征進(jìn)行描述或分類(lèi)提取。在常用的基于統(tǒng)計(jì)的方法中,可從統(tǒng)計(jì)學(xué)的角度分析動(dòng)作特征和之前的關(guān)聯(lián)情況,常見(jiàn)的統(tǒng)計(jì)模型主要有:隱馬爾科夫模型HMM(Hidden Markov Model)[2]、高斯混合模型GMM(Gaussian Mixture Model)等。基于時(shí)空特征的方法是將一段時(shí)間序列的動(dòng)態(tài)過(guò)程進(jìn)行分析,通過(guò)訓(xùn)練樣本來(lái)獲取動(dòng)作的模型參數(shù),常見(jiàn)的方法包括線(xiàn)性動(dòng)態(tài)系統(tǒng)LDS(Linear Dynamic System)等。Natarajan等人[3]通過(guò)動(dòng)態(tài)貝葉斯網(wǎng)絡(luò)DBN(Dynamic Bayesian Network)來(lái)表示分解后的運(yùn)動(dòng)序列,描述復(fù)雜動(dòng)作拆分后的轉(zhuǎn)換關(guān)系。基于時(shí)空特征的分析法中,Wang等[4]利用局部興趣點(diǎn)的密度特性,觀察局部興趣點(diǎn)的多尺度時(shí)空上下文特征進(jìn)行行為識(shí)別。Wu等[5]結(jié)合兩種分布特征類(lèi)型:時(shí)空上下文和外觀分布特征,利用多核學(xué)習(xí)方法有效融合這兩種異構(gòu)和互補(bǔ)分布特性進(jìn)行姿態(tài)識(shí)別。基于模板的大致可分為兩類(lèi),一類(lèi)為模板匹配法,另一類(lèi)為動(dòng)態(tài)的時(shí)空規(guī)整法和動(dòng)態(tài)規(guī)劃法。基于模板方法將識(shí)別出的模型姿態(tài)與樣本模型進(jìn)行比較,算法效率較高,簡(jiǎn)單高效,可廣泛地應(yīng)用于日常行為姿態(tài)的識(shí)別。

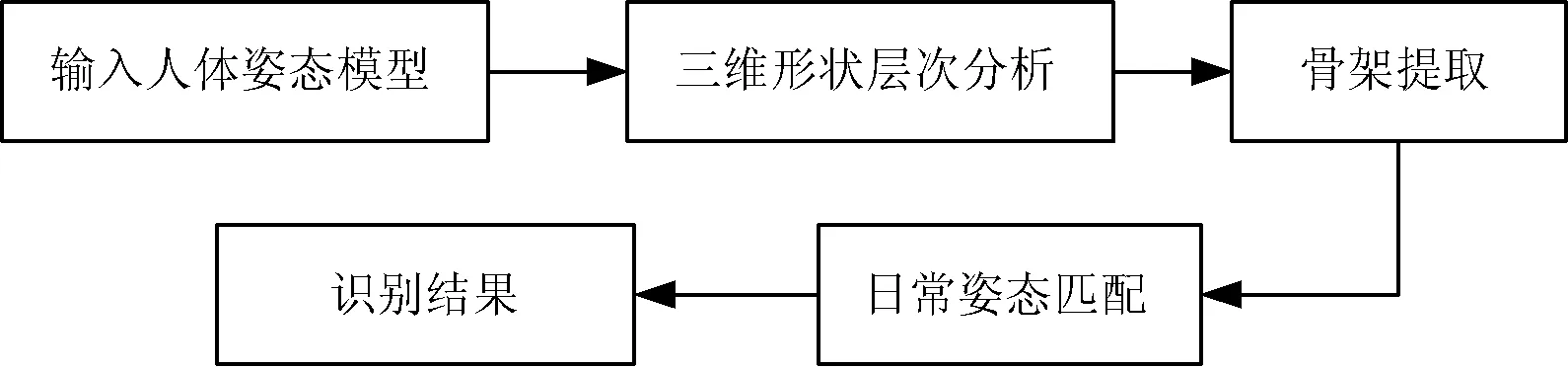

大多人體姿態(tài)識(shí)別方法通常通過(guò)單視角或多視角的二維圖像進(jìn)行提取,描述特征主要為目標(biāo)人物的顏色、輪廓、形狀、深度信息等,導(dǎo)致一些算法容易受光照、環(huán)境、遮擋等因素的影響,具有一定的局限性。三維模型數(shù)據(jù)從本質(zhì)上克服了二維信息的不利影響因素,本文在充分考慮三維人體模型特性的基礎(chǔ)之上,提出一種新穎的人體姿態(tài)分析及識(shí)別算法,層次化提取出人體骨架結(jié)構(gòu)后,基于迭代最近點(diǎn)算法ICP(Iterative Closest Point)進(jìn)行日常姿態(tài)模板識(shí)別,有效提升了姿態(tài)識(shí)別的計(jì)算效率(如圖1所示)。

圖1 算法流程圖

在日常行為當(dāng)中人體的姿態(tài)雖然具有高度的靈活性,但都基于人體骨架所驅(qū)動(dòng)而發(fā)現(xiàn)形變,通過(guò)獲取人體基本骨架即可識(shí)別出其行為狀態(tài),而不需要觀察其外部細(xì)節(jié)。姿態(tài)識(shí)別的關(guān)鍵問(wèn)題是:所提取的特征和采用什么方法進(jìn)行姿態(tài)判別。通過(guò)二維圖像信息所提取的特征很難應(yīng)用于復(fù)雜環(huán)境的行為系統(tǒng)中。因此,本文提出一種多尺度提取三維人體結(jié)構(gòu)特征方法基于人體語(yǔ)義結(jié)構(gòu)層次化提取骨架姿態(tài)模型,融合測(cè)地線(xiàn)、內(nèi)部空間體積和結(jié)構(gòu)比例特征分析提取層次結(jié)構(gòu)。最后,通過(guò)ICP算法實(shí)現(xiàn)快速的姿態(tài)識(shí)別。算法不僅保留了了人體的結(jié)構(gòu)特征,且便于理解與實(shí)現(xiàn),可快速識(shí)別出簡(jiǎn)單的日常人體行為姿態(tài)。

1 人體語(yǔ)義骨架點(diǎn)

根據(jù)人體日常活動(dòng)的姿態(tài)變化,定義14個(gè)關(guān)鍵行為關(guān)節(jié)點(diǎn)[6],并將其劃分為三個(gè)層次:外層關(guān)節(jié)點(diǎn)、內(nèi)層關(guān)節(jié)點(diǎn)和中層關(guān)節(jié)點(diǎn)。人體姿態(tài)大致經(jīng)由這些關(guān)鍵關(guān)節(jié)點(diǎn)的變化而組成,準(zhǔn)確獲得關(guān)鍵行為關(guān)節(jié)點(diǎn)后連接而成的骨架即可描述人體姿態(tài),將大量復(fù)雜的三維數(shù)據(jù)簡(jiǎn)化成全局性描述的骨架信息。

首先,通過(guò)計(jì)算表面測(cè)地線(xiàn)距離建立人體模型的初始結(jié)構(gòu),遍歷葉子節(jié)點(diǎn)區(qū)域,通過(guò)極值點(diǎn)判定得到外層關(guān)節(jié)點(diǎn);結(jié)合空間體積特征,檢測(cè)模型內(nèi)部體積的突變區(qū)域確定內(nèi)層關(guān)節(jié)點(diǎn);結(jié)合已獲得的關(guān)節(jié)點(diǎn)信息和人體測(cè)量學(xué)理論,聯(lián)合定位中層關(guān)鍵點(diǎn)的預(yù)測(cè)位置。根據(jù)三層關(guān)節(jié)點(diǎn)連接形成的層次骨架,通過(guò)ICP算法進(jìn)行姿態(tài)識(shí)別,將待測(cè)模型姿態(tài)與標(biāo)注姿態(tài)進(jìn)行匹配識(shí)別,實(shí)現(xiàn)日常行為姿態(tài)的快速檢測(cè)。

2 人體姿態(tài)骨架的層次提取

(1)

其中,area為模型參考點(diǎn){ai}所占模型表面的面積,geod(v,ai)表示頂點(diǎn)v到參考點(diǎn)ai的測(cè)地線(xiàn)距離。

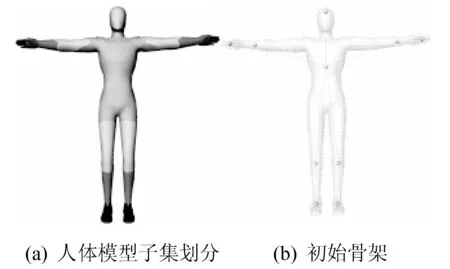

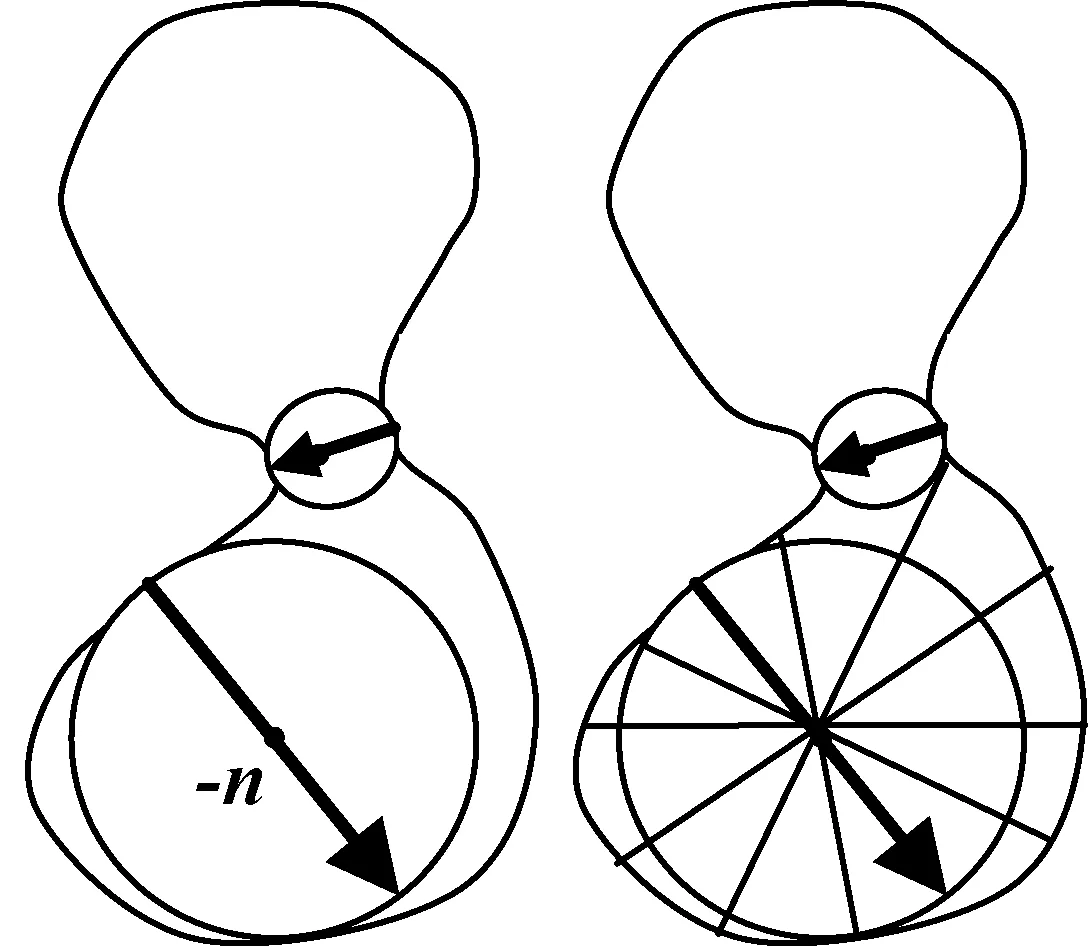

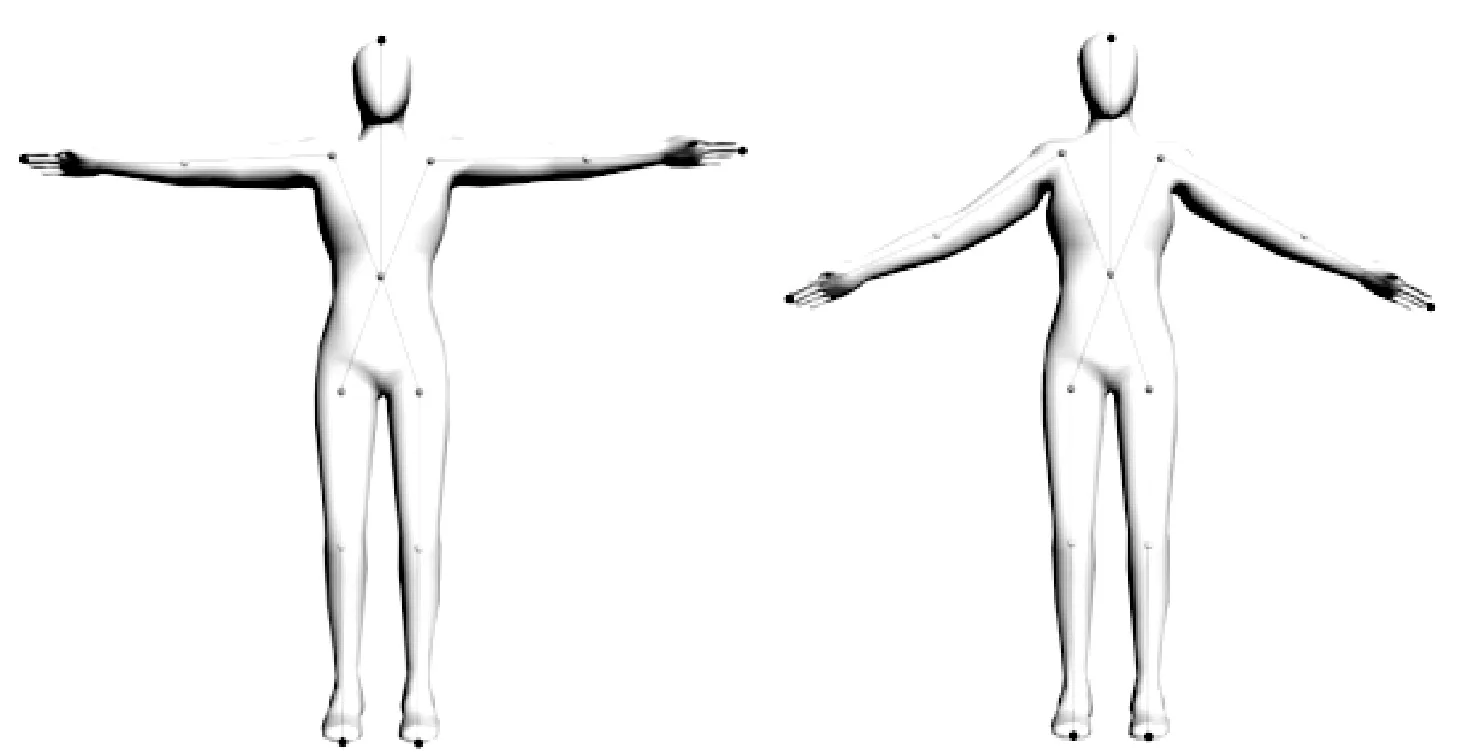

圖2 人體模型初始結(jié)構(gòu)提取

假設(shè)以模型內(nèi)部的點(diǎn)出發(fā)作為可視化視角,每一點(diǎn)的可視化區(qū)域?qū)⑹潜3址€(wěn)定或逐漸變化的。我們首先將模型表面上的點(diǎn)標(biāo)準(zhǔn)化后映射到模型內(nèi)部;再?gòu)挠成潼c(diǎn)采樣發(fā)出射線(xiàn),將所有射線(xiàn)與模型表面交點(diǎn)的長(zhǎng)度進(jìn)行求和,作為該點(diǎn)的內(nèi)部體積特征值[8]。根據(jù)人體組織架構(gòu)的幾何特征,內(nèi)層關(guān)節(jié)點(diǎn)位于內(nèi)部體積值顯著突變區(qū)域,可以通過(guò)內(nèi)部體積特征有效得到人體內(nèi)層關(guān)節(jié)點(diǎn),有效識(shí)別出模型內(nèi)部關(guān)鍵區(qū)域(如圖3所示)。令模型表面頂點(diǎn)為{K1,K2,…,Ki,…,Kn},以Ki為頂點(diǎn),其負(fù)法向量ni為主軸朝模型內(nèi)部發(fā)射m條射線(xiàn),射線(xiàn)d與之間的椎角為(0≤β≤90°),與模型表面點(diǎn)Ki相交的最大內(nèi)切球直徑可用式(2)求出:

dj=argmin{‖Dj‖/cosβj}

(2)

圖3 內(nèi)部映射點(diǎn)計(jì)算

為了獲得各個(gè)頂點(diǎn)局部收斂性,引入權(quán)值wi對(duì)特征值進(jìn)行去噪處理。其中μ是平均值,σ為標(biāo)準(zhǔn)差。對(duì)于人體模型而言,無(wú)論其姿勢(shì)形態(tài)如何改變,所提取的層次結(jié)構(gòu)特征應(yīng)該是相對(duì)穩(wěn)定的。

(3)

骨骼作為更高級(jí)別的形狀特征,可以作為人體姿態(tài)內(nèi)在結(jié)構(gòu)的描述和轉(zhuǎn)換。Wu等[9]對(duì)人體模型的測(cè)地線(xiàn)值進(jìn)行度量研究,發(fā)現(xiàn)盡管人體結(jié)構(gòu)形狀較為復(fù)雜,人體特征在不同個(gè)體上存在細(xì)微差異,但通過(guò)研究發(fā)現(xiàn)各關(guān)節(jié)之間的相對(duì)比例存在穩(wěn)定的數(shù)量關(guān)系,且不會(huì)受姿態(tài)等外界因素的影響。結(jié)合外層關(guān)節(jié)點(diǎn)和內(nèi)層關(guān)節(jié)點(diǎn),依據(jù)人體測(cè)量學(xué)比例理論,采用測(cè)地線(xiàn)比例定位中層關(guān)節(jié)點(diǎn)位置。由于人體結(jié)構(gòu)具有對(duì)稱(chēng)性,測(cè)地線(xiàn)值最大的兩個(gè)外層關(guān)節(jié)點(diǎn)為腿部末端點(diǎn),次大距離關(guān)節(jié)點(diǎn)為手部點(diǎn),最小的為頭部點(diǎn),進(jìn)行語(yǔ)義判別后,自動(dòng)求解比例從而實(shí)現(xiàn)中層關(guān)節(jié)點(diǎn)的定位提取(如圖4所示)。

圖4 人體層次骨架提取

3 人體姿態(tài)識(shí)別

到目前為止,已提取到人體結(jié)構(gòu)關(guān)節(jié)的層次骨架信息,鏈接而成可獲得簡(jiǎn)化后的高級(jí)骨架描述特征。針對(duì)不同層次的骨架關(guān)節(jié),根據(jù)其生理特征采用不同的算法提取關(guān)節(jié)點(diǎn)位置,有效識(shí)別出人體姿態(tài)的骨架信息,將復(fù)雜的三維數(shù)據(jù)簡(jiǎn)化為提煉后的骨架進(jìn)行姿態(tài)的識(shí)別。

在計(jì)算機(jī)視覺(jué)的應(yīng)用研究領(lǐng)域,目前國(guó)內(nèi)外應(yīng)用最為廣泛的模型匹配經(jīng)典方法為迭代最近點(diǎn)(ICP)算法[10]。算法分為點(diǎn)集數(shù)據(jù)采集、確定對(duì)應(yīng)點(diǎn)集、求解優(yōu)化轉(zhuǎn)換矩陣等步驟,該算法計(jì)算簡(jiǎn)單、精確度高且具有較高的穩(wěn)定性,具有非常高的應(yīng)用研究?jī)r(jià)值。迭代最近點(diǎn)算法的實(shí)質(zhì)為通過(guò)最小二乘法的計(jì)算得到最優(yōu)匹配變化,通過(guò)迭代優(yōu)化兩點(diǎn)集的轉(zhuǎn)換矩陣,使得誤差函數(shù)值最小,從而實(shí)現(xiàn)兩模型間的精確匹配。在算法計(jì)算過(guò)程中,最耗時(shí)的步驟為計(jì)算模型間對(duì)應(yīng)點(diǎn),當(dāng)點(diǎn)集數(shù)據(jù)個(gè)數(shù)很大時(shí),計(jì)算所花費(fèi)的時(shí)間會(huì)大大增加,算法執(zhí)行效率因此降低。本文算法將龐大的三維面片信息簡(jiǎn)化為有限的三維骨架點(diǎn)集,大大縮減了對(duì)應(yīng)點(diǎn)的搜索范圍,同時(shí)保證了算法的精確度。

(4)

步驟一 讀入點(diǎn)集Dq、Dq信息。

步驟二 求解待匹配點(diǎn)集的對(duì)應(yīng)點(diǎn)對(duì),使得‖pi-qi‖→min。

步驟五 若更新后的點(diǎn)集與參考點(diǎn)集的誤差距離小于閾值,或k達(dá)到最大迭代次數(shù)(設(shè)k=10),則算法結(jié)束,否則將更新點(diǎn)集帶入繼續(xù)進(jìn)行迭代。

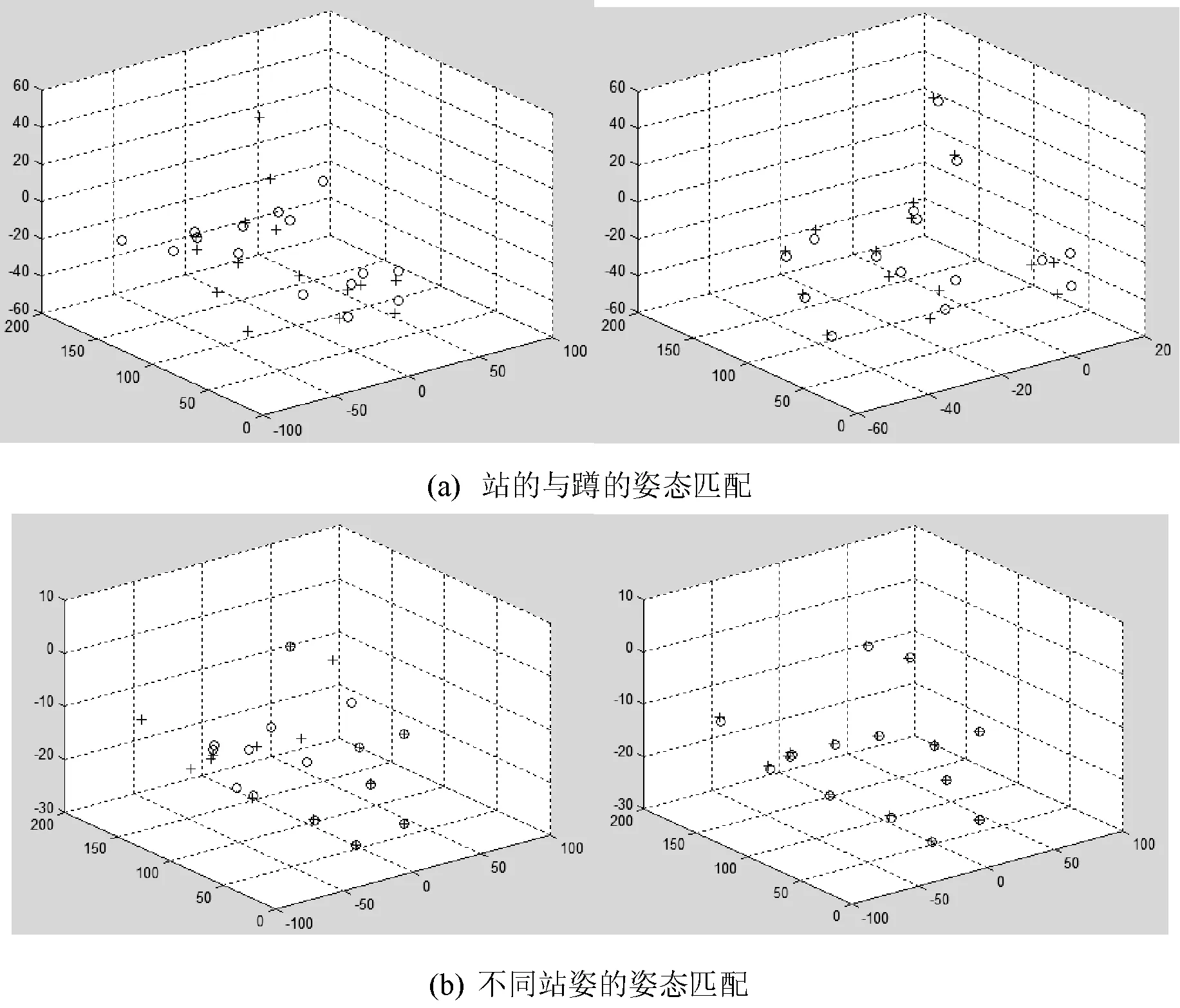

圖5 兩姿態(tài)匹配前后對(duì)比

圖5中,(a)為人體站著和蹲著的姿態(tài)匹配,匹配前姿態(tài)差異較大,匹配后基本關(guān)節(jié)點(diǎn)均能呈現(xiàn)出較好的對(duì)應(yīng)關(guān)系;(b)為不同站姿的匹配,匹配前差異程度較小,經(jīng)過(guò)匹配兩姿態(tài)能準(zhǔn)確對(duì)應(yīng)。經(jīng)試驗(yàn)層次提取后的骨架點(diǎn)集經(jīng)過(guò)ICP算法匹配后,算法能有效匹配姿態(tài)各異的骨架模型并用于姿態(tài)匹配識(shí)別中。本文方法將復(fù)雜的三維模型簡(jiǎn)化為有限的骨架點(diǎn)集信息,對(duì)提取骨架的精度要求較高,對(duì)骨架信息的識(shí)別過(guò)程能很好地將不同姿態(tài)的模型進(jìn)行匹配,且算法具有很好的精度和魯棒性,適用于各種人體姿態(tài)的匹配。

4 實(shí)驗(yàn)結(jié)果分析

為了驗(yàn)證本文算法姿態(tài)識(shí)別的有效性,在Intel(R) Xeon(R) CPU的Windows 7操作系統(tǒng)上,基于Visual C++和Matlab進(jìn)行三維人體姿態(tài)識(shí)別,人體庫(kù)為150個(gè)不同姿態(tài)的三維人體模型。

本文算法在姿態(tài)識(shí)別的精度上和速度上均有一定的優(yōu)勢(shì),且當(dāng)三維人體模型面片數(shù)量越大時(shí),通過(guò)人體層次提取后再進(jìn)行姿態(tài)識(shí)別,算法執(zhí)行效率越占優(yōu)勢(shì)。本文方法將復(fù)雜的三維模型簡(jiǎn)化為有限的骨架點(diǎn)集信息,對(duì)提取骨架的精度要求較高,對(duì)骨架信息的識(shí)別過(guò)程能很好地將不同姿態(tài)的模型進(jìn)行匹配,且算法具有很好的執(zhí)行效率,適用于各種人體姿態(tài)的識(shí)別。

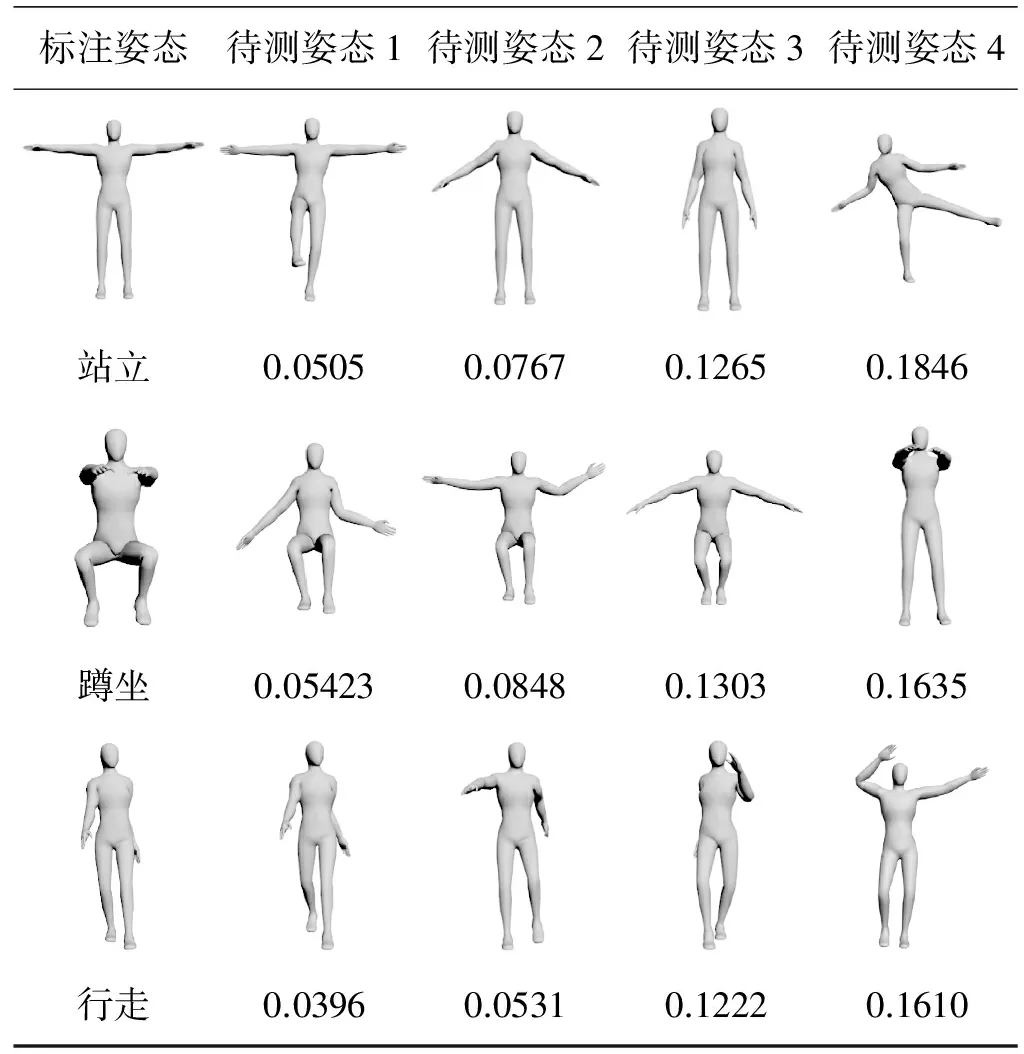

在三維人體模型庫(kù)中,將人體日常行為動(dòng)作劃分為三類(lèi):行走,站立,蹲坐,組成動(dòng)作集合A={行走,站立,蹲坐},將不同人體模型與標(biāo)注姿態(tài)進(jìn)行匹配,可發(fā)現(xiàn)動(dòng)作近似的模型姿態(tài)差異度值較小,而在走的姿態(tài)中,不同人因行為習(xí)慣不同,存在一定的誤差,但差異值變化較為穩(wěn)定,如表1所示。

表1 人體姿態(tài)差異度值比較

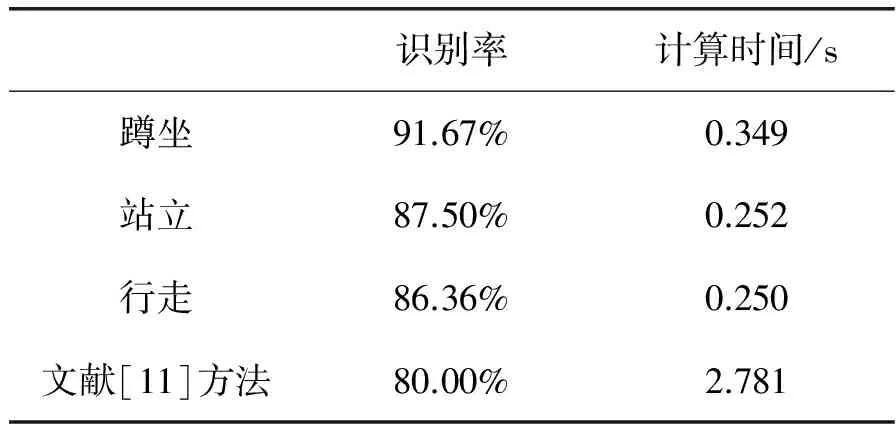

為進(jìn)一步驗(yàn)證不同姿態(tài)的骨架與標(biāo)注姿態(tài)識(shí)別的有效性,將待測(cè)姿態(tài)骨架點(diǎn)集與樣本庫(kù)中姿態(tài)進(jìn)行一一匹配,選取日常姿態(tài)中的六個(gè)最佳標(biāo)準(zhǔn)姿態(tài)建立樣本庫(kù),計(jì)算待測(cè)姿態(tài)與樣本庫(kù)中姿態(tài)平均差異值,我們定義匹配識(shí)別函數(shù)S為:

(5)

匹配識(shí)別函數(shù)S中,E表示待測(cè)姿態(tài)i與庫(kù)中標(biāo)準(zhǔn)姿態(tài)j姿態(tài)識(shí)別后骨架對(duì)應(yīng)點(diǎn)間的平均歐氏距離,Zn、Dn、Xn分別表示姿態(tài)樣本庫(kù)中標(biāo)準(zhǔn)姿態(tài)站立、蹲坐、行走模型集合。將人體模型庫(kù)中模型與標(biāo)準(zhǔn)樣本姿態(tài)庫(kù)中模型進(jìn)行識(shí)別,實(shí)驗(yàn)結(jié)果如表2所示,并與基于MRG骨架樹(shù)的檢索方法進(jìn)行比較。本文方法所提取的骨架點(diǎn)包含語(yǔ)義信息,并且能較為高效準(zhǔn)確地識(shí)別出日常的基本姿態(tài),能有效識(shí)別人體的剛性變換,但是對(duì)于行走和站立的靜態(tài)模型,有些姿態(tài)較為相似,容易出現(xiàn)識(shí)別錯(cuò)誤的情況。方法只適用于簡(jiǎn)單標(biāo)準(zhǔn)姿態(tài)的行為識(shí)別,但對(duì)復(fù)雜行為姿態(tài)不作語(yǔ)義識(shí)別判定。文獻(xiàn)[11]方法基于MRG原理提取骨架,骨架節(jié)點(diǎn)具有拓?fù)鋵傩院蛶缀涡螤钐卣鳎狈φZ(yǔ)義和姿態(tài)的行為屬性判定,在結(jié)構(gòu)提取前需要對(duì)模型進(jìn)行統(tǒng)一的分區(qū),同一模型不同結(jié)構(gòu)分區(qū)的拓?fù)涔羌芟嗖钶^大,較為適用于相同分區(qū)的統(tǒng)一結(jié)構(gòu)。

表2 實(shí)驗(yàn)結(jié)果比較

5 結(jié) 語(yǔ)

本文利用測(cè)地線(xiàn)距離、內(nèi)部空間體積特征分析人體模型后,結(jié)合人體測(cè)量學(xué)理論層次化提取人體骨架信息來(lái)進(jìn)行姿態(tài)識(shí)別。本文方法通過(guò)簡(jiǎn)單的骨架信息點(diǎn)集來(lái)有效表示復(fù)雜的人體三維模型,這種層次化的姿態(tài)識(shí)別方法,有效簡(jiǎn)化了人體姿態(tài)識(shí)別過(guò)程,提高了算法執(zhí)行時(shí)間,在計(jì)算大量三維數(shù)據(jù)時(shí)具有明顯優(yōu)勢(shì),并且便于拓展應(yīng)用,能與步態(tài)識(shí)別、人體檢測(cè)等方向進(jìn)行結(jié)合,有很強(qiáng)的延伸實(shí)用性。算法雖然能高效解決人體姿態(tài)識(shí)別問(wèn)題,但是通過(guò)骨架信息識(shí)別姿態(tài)仍具有一定的不確定性,目前樣本庫(kù)中姿態(tài)只能識(shí)別出較為簡(jiǎn)單的日常行為動(dòng)作。日后工作會(huì)對(duì)復(fù)雜姿態(tài)進(jìn)行進(jìn)一步研究,實(shí)現(xiàn)高層次的人體姿態(tài)識(shí)別與應(yīng)用。

[1] Aggarwal J K, Ryoo M S. Human Activity Analysis: A Review[J]. ACM Computer Surveys, 2011, 43(3):194-4218.

[2] Xia L, Chen C C, Aggarwal J K. View invariant human action recognition using histograms of 3D joints[C]//2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops, 2012:20-427.

[3] Natarajan P, Singh V K, Nevatia R. Learning 3D action models from a few 2D videos for view invariant action recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, San Francisco, USA, 2010:20006-42013.

[4] Wang J, Chen Z, Wu Y. Action recognition with multiscale spatio-temporal contexts[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2011:3185-43192 .

[5] Wu X, Xu D, Duan L, et al. Action recognition using context and appearance distribution features[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2011:489-4496.

[6] 陳啟華, 潘翔, 張三元. 語(yǔ)義知識(shí)約束的三維人體特征點(diǎn)檢測(cè)和分割[J]. 計(jì)算機(jī)輔助設(shè)計(jì)與圖形學(xué)學(xué)報(bào), 2011, 23(6):1061-41068.

[7] 韓麗, 楚秉智, 高小山. 高斯曲率約束的MRG骨架提取優(yōu)化算法[J]. 計(jì)算機(jī)輔助設(shè)計(jì)與圖形學(xué)學(xué)報(bào), 2009, 21(9):1227-41231.

[8] Liu R, Zhang H, Shamir A, et al. A part-aware surface metric for shape analysis[J]. Computer Graphics Forum, 2009, 28(2) 397-4406.

[9] Wu W, Hao A, Zhao Y. Geodesic model of human body[C]//Proceedings of the 2010 International Conference on Cyberworlds. Los Alamitos, CA: IEEE Computer Society Press, 2010:391-4397.

[10] 戴靜蘭, 陳志楊, 葉修梓. ICP算法在點(diǎn)云配準(zhǔn)中的應(yīng)用[J]. 中國(guó)圖象圖形學(xué)報(bào), 2007, 12(3):517-4521.

[11] 韓麗, 張黎娜, 楚秉智. 一種MRG骨架樹(shù)的三維模型檢索方法[J]. 計(jì)算機(jī)工程與應(yīng)用, 2011, 47(31):167-4170.

ATTITUDE MATCHING BASED ON THE THREE-DIMENSIONAL HUMAN BODY SEMANTIC SKELETON POINTS

Wang Dapeng Li Lin Han Li Zhang Meichao Wang Luchen

(SchoolofComputerandInformationTechnology,LiaoningNormalUniversity,Dalian116081,Liaoning,China)

Aiming at several problems such as the complex structure, large processing quantity and difficult extraction of control points of three-dimensional human body models, an algorithm of describing body structure and doing pose recognition by analyzing characteristics of shape of human body is proposed. It fused the characteristics of geodesic and spatial structure to extract skeleton points which reduce the calculation effectively and make behavior recognition of attitude by using ICP algorithm. Experiments proved that using this algorithm could recognize the three-dimensional pose more effectively with good robustness.

Three-dimensional human body Semantic skeleton Pose recognition

2015-05-23。遼寧省高等學(xué)校優(yōu)秀人才支持項(xiàng)目(LJQ 2013110)。王大鵬,講師,主研領(lǐng)域:計(jì)算機(jī)圖形學(xué)。黎琳,碩士生。韓麗,教授。張美超,碩士生。王露晨,碩士生。

TP3

A

10.3969/j.issn.1000-386x.2017.01.031