網絡媒體大數據流異構多模態目標識別策略

文孟飛 劉偉榮 胡 超

1(中南大學信息科學與工程學院 長沙 410083)2(中南大學信息與網絡中心 長沙 410083)3(醫學信息研究湖南省普通高等學校重點實驗室(中南大學) 長沙 410083)4 (湖南省教育科學研究院 長沙 410005)(wmfdcf@126.com)

網絡媒體大數據流異構多模態目標識別策略

文孟飛1,4劉偉榮1胡 超2,3

1(中南大學信息科學與工程學院 長沙 410083)2(中南大學信息與網絡中心 長沙 410083)3(醫學信息研究湖南省普通高等學校重點實驗室(中南大學) 長沙 410083)4(湖南省教育科學研究院 長沙 410005)(wmfdcf@126.com)

如何對海量的網絡媒體大數據進行準確地目標識別,是當前的一個研究熱點和難點.針對此問題提出一種利用媒體流時間相關特性的異構多模態目標識別策略.首先基于媒體流中同時存在音頻和視頻信息的特征,建立一種異構多模態深度學習結構;結合卷積神經網絡(convolutional neural network, CNN)和限制波爾茲曼機(restricted Boltzmann machine, RBM)的算法優點,對音頻信息和視頻信息分別并行處理,這種異構模式可以充分利用不同深度神經網絡的特點;然后生成基于典型關聯分析的共享特征表示,并進一步利用時間相關特性進行參數的優化.3種對比實驗用來驗證所提策略的效果,首先將策略與單一模態算法進行對比;然后再在復合的數據庫上建立對比實驗;最后在網絡視頻庫上建立對比實驗,這些對比實驗驗證了策略的有效性.

目標識別;深度學習;卷積神經網絡;限制玻爾茲曼機;典型關聯分析

網絡技術的發展使互聯網上各種結構化、非結構化的海量大數據應運而生[1].如何建立起一種高效、準確的網絡大數據目標識別策略已成為國內外學者的研究熱點[2].現今互聯網上85%以上已捕獲的都是非結構化的文件、圖像、視頻、點擊流和地理空間數據[3].迫切需要找尋網絡大數據的共性規律,實現網絡大數據的特征提取和目標識別[4].機器學習是目標識別的主要方法,目前已經從淺層學習發展到深度學習.

淺層結構模型通常包含單層或雙層的非線性特征變換[5],如高斯混合模型(Gaussian mixture model, GMM)[6]、條件隨機場(conditional random fields, CRF)[7]模型、支持向量機(support vector machine, SVM[8])模型以及含有單隱層的多層感知機(multi-layer perceptron, MLP)[9]模型等.淺層結構能有效地解決許多簡單的或具有明確約束的問題,但需要依靠人工來抽取樣本的特征,難以將其擴展到視頻的特征提取[10],而且淺層模型的自糾錯能力比較有限[11].

針對上述問題,Hinton等人[12]于2006年提出深度置信網絡(deep belief network, DBN)結構和非監督貪心逐層訓練算法,可表征復雜高維函數,提取多重水平的特征,獲得更多的有用信息[13].

深度學習的2種典型結構為限制波爾茲曼機(restricted Boltzmann machine, RBM)和卷積神經網絡(convolutional neural network, CNN).RBM在語音識別體現了較好的優勢[14],而LeCun等研究者[15]使用CNN在處理識別圖像信息取得了比其他學習方法更好的結果.

目前,隨著互聯網的發展以及視頻編解碼技術的成熟,視頻數據呈現出爆炸式的增長[16].出現了如優酷、土豆、Youtube等資源豐富且訪問量巨大的視頻網站,為視頻數據的目標識別提出了新的需求.目前已經有將深度學習方法應用到視頻數據目標識別的若干研究成果[17-19].

上述的研究成果往往針對視頻的視覺信號進行單一模態的處理.但對于一段視頻來說,視覺和聽覺信號都能夠為目標識別提供重要的信息.因此出現了結合各種不同的模態之間的有效信息的多模態學習方法.如Leonardi等人在文獻[20]中使用了底層的視覺和音頻特征來檢測足球視頻中的進球鏡頭.文獻[21]使用多模態方法并行處理人物口型和所發出的音節.

目前這2種多模態學習方法都采用同一種深層結構處理音頻和視頻信號.但在多模態方法中使用不同深層結構將會取得更好的效果.如RBM對聲音的識別具有較好的識別效果,而CNN對時間相關的動態視覺信號有較強的魯棒性[22].

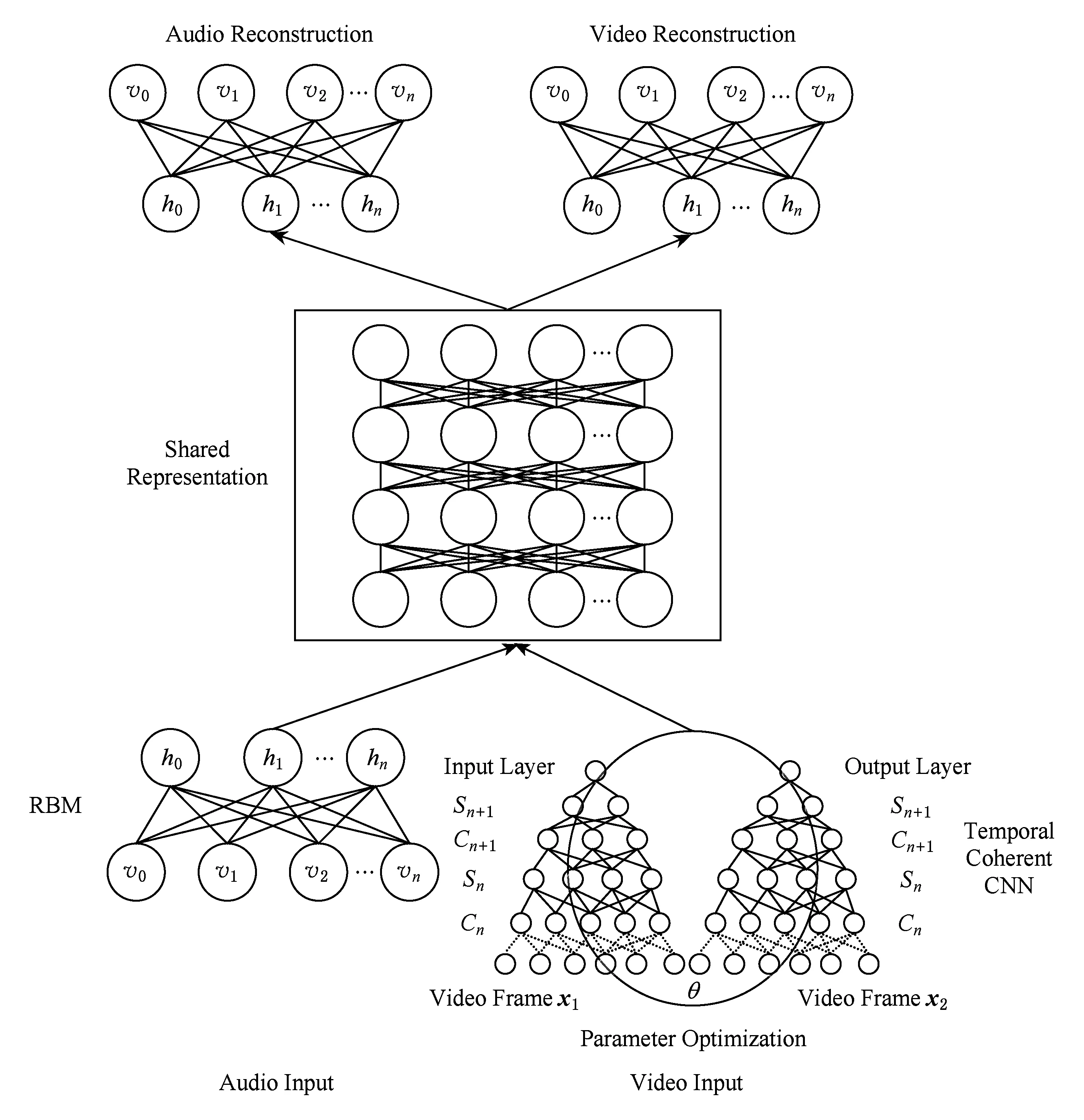

基于以上討論,本文提出一種針對媒體大數據流的異構多模態目標識別策略,綜合RBM的語音識別能力和CNN的圖像處理能力,并建立RBM和CNN的共享關聯表示,以更有效地識別視頻中的目標.在對視覺信號進行處理時,進一步利用視頻中相鄰2幀的時間相關性,優化神經網絡多層結構的參數,提高目標識別的準確度.

1 異構多模態深度學習的目標識別策略

多媒體數據中目標識別的關鍵是能夠獲取數據的主要特征.網絡資源中的多媒體視頻數據具有較大的復雜性與多樣性.僅僅利用視頻數據中單一模態進行處理往往難以得到較好的效果.使用多模態結合的方法提取數據特征能夠更有效應用于媒體數據流的特征提取:將視覺圖像和音頻數據分別作為2種模態輸入,并行進行處理,同時得到2種模態的高層特征,進而通過最大化2種模態之間的關聯性建立模態間的共享表示,可得到更好的識別效果.

由于視頻信息中視覺信息和聽覺信息的特點不同,本文建立了多模態的異構深度學習框架,該框架結合了不同類別的深度網絡分別對視覺信息和聽覺信息進行處理,而不同類別的深度網絡會對視覺信息和聽覺信息分別具有各自的優勢.這種處理將會增加結構的復雜程度,但是可針對不同模態的數據提取出更有效的特征,從而增加目標識別的精度.本文分別利用RBM和CNN處理視頻數據流的音頻信號和視頻圖像信號.

RBM是一種特殊形式的玻爾茲曼機,可通過輸入數據集學習概率分布隨機生成神經網絡,具有較好的泛化能力.而由多個RBM結構堆疊而成的深度信念網絡能提取出多層抽象的特征,從而用于分類和目標識別.

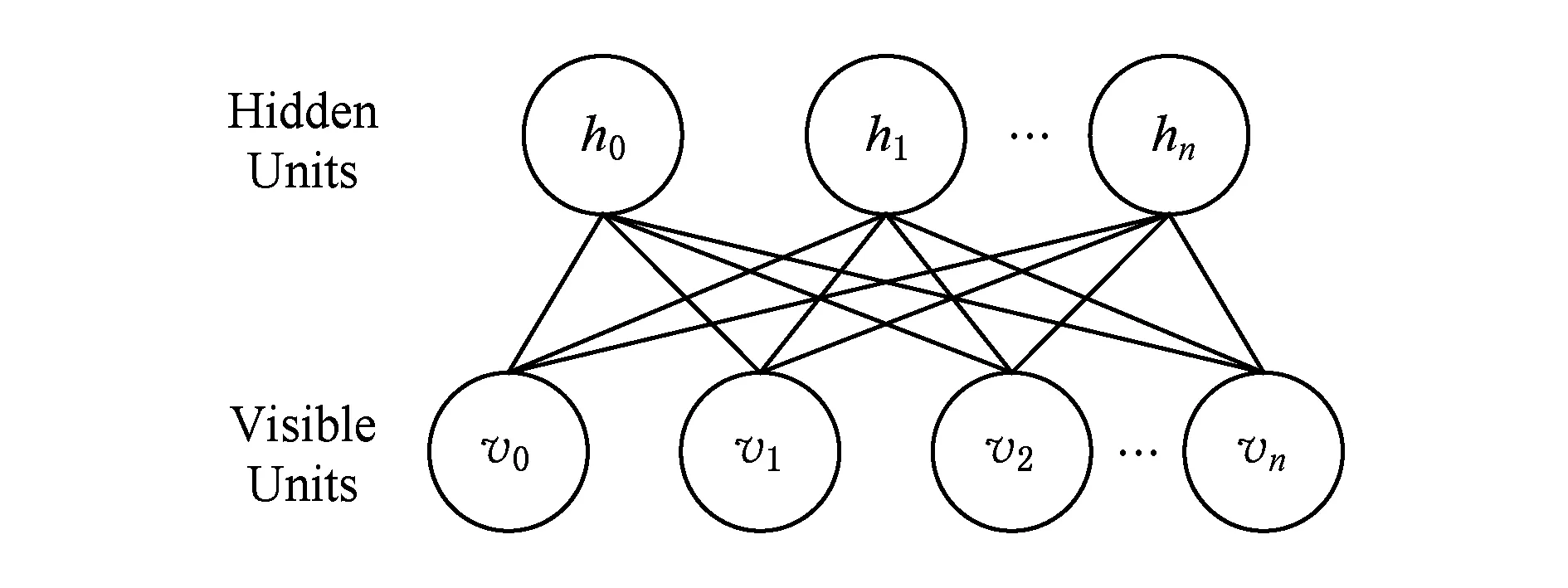

本文我們采用RBM模型進行音頻處理,RBM的結構如圖1所示,整體是一個二分圖的結構,分為2層,一層為可見層(visible units),一層為隱層(hidden units),可見層也稱為輸入層.

Fig. 1 Structure of RBM圖1 RBM的結構圖

Fig. 2 Multiple convolution operation and sample process of the convolutional neural network圖2 卷積神經網絡多層卷積運算和采樣過程圖

RBM的隱藏向量h和可見向量v之間存在對稱性的連接Wi,j,但是隱藏向量之間或者可見向量之間沒有連接.該模型通過模擬熱力學能量定義了基于h,v的聯合概率分布,如式(1)所示.由于同層變量之間沒有連接,因此根據聯合概率分布可方便計算出每一個單元的激發概率.

-lgP(v,h)∝E(v,h)=

(1)

其中,c,b為偏置參數向量,W為RBM連接權值矩陣,E(·)為RBM能量函數.

根據式(1),可定義隱層和可見層的概率分布:

(2)

(3)

(4)

每一個單元的激發概率為

(5)

(6)

CNN是多層感知機(MLP)的一個變種模型,是近幾年來快速發展并引起廣泛重視的一種高效識別方法,它是從生物學概念中演化而來的.20世紀60年代,Hubel和Wiesel在研究貓腦皮層中用于局部敏感和方向選擇的神經元時發現其獨特的網絡結構可以有效地降低反饋神經網絡的復雜性,繼而LeCun等人以此為基礎提出了CNN[15].

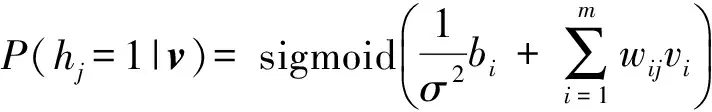

一般來說,CNN的基本結構包括2層:1)特征提取層,每個神經元的輸入與前一層的局部接受域相連,并提取該局部的特征.一旦該局部特征被提取后,它與其他特征間的位置關系也隨之確定下來.2)特征映射層,網絡的每個計算層由多個特征映射組成,每個特征映射是一個平面,平面上所有神經元的權值相等.特征映射結構采用sigmoid函數作為卷積網絡的激活函數,使得特征映射具有位移不變性.此外,由于一個映射面上的神經元共享權值,因而減少了網絡自由參數的個數.卷積神經網絡中的每一個卷積層都緊跟著一個用來求局部平均與2次提取的計算層,這種特有的2次特征提取結構減小了特征分辨率.其具體結構圖如圖2所示:

(7)

子抽樣層Sl在每個出入位面上使用Kl×Kl平滑濾波:

(8)

首先將視頻模型描述為視聽雙模態,其中該模型的信號是視頻幀和與視頻幀同步的連續聲譜.本文采用了基于稀疏理論深度自動編碼器的異構多模態深度學習策略.

深度自動編碼器是一種利用無監督逐層貪心預訓練和系統性參數優化的多層非線性網絡,能夠從無標簽數據中提取高維復雜輸入數據的分層特征,并得到原始數據的分布式特征表示的深度學習神經網絡結構,其由編碼器、解碼器和隱含層組成.

基于稀疏理論的深度自動編碼器[10]對原始自動編碼器的隱含層添加了約束條件并增加了隱含層數量,能提取高維數據向量的稀疏解釋性因子,保留原始輸入的非零特征,增加表示算法的魯棒性,增強數據的線性可分性,使物體邊界變得更加清晰.

該識別模型分為輸入層、共享表示層以及輸出層.

1) 輸入層.為視頻資源的2個模態,即聲譜和視頻幀,其中聲譜采用RBM訓練,視頻幀采用CNN訓練.

2) 共享表示層.這一層的關鍵是找到特征模態的轉換表示從而最大化模態之間的關聯性.本文采用典型關聯分析(canonical correlation analysis, CCA)的方法尋找聲譜波和視頻幀數據的線性轉換從而形成性能優良的共享表示.

其中,CCA是一種先將較多變量轉化為少數幾個典型變量,再通過其間的典型相關系數來描述2組多元隨機變量之間關系的統計方法.有助于綜合地描述2組變量之間的典型相關關系.基本過程是從2組變量各自的線性函數中各抽取一個組成一對,它們應是相關系數達到最大值的一對,稱為第1對典型變量,類似地就可以求出第2對、第3對,……,這些成對變量之間互不相關,各對典型變量的相關系數稱為典型相關系數.所得到的典型相關系數的數目不超過原2組變量中任何一組變量的數目.

3) 輸出層.這一層為聲譜和視頻的重構.還原視頻信息的同時,識別視頻中的物體.

2 基于視頻時間相關特性的參數優化

2.1 視頻相關性描述

視頻是由一系列圖像所組成,圖像中目標識別的方法可以用來對視頻進行識別,一段視頻可以分解成很多幀,同一視頻中連續的2個視頻幀很有可能表示同樣的內容,視頻的這種特性我們稱之為相關特性.將這視頻的這種特性用于視頻的目標識別,可以使識別效果得到很大程度的提高[22].

利用視頻的時間相關性來提高識別準確性已成功用于視頻的動作識別[23].實驗表明具有時間相關性視頻卷積網絡的識別效果明顯比采用視頻單幀進行訓練的卷積網絡效果優越.

2.2 利用視頻相關特性的優化

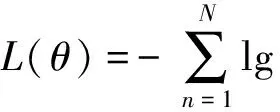

CNN中在每個卷積層和子采樣層之后都運用了一個非線性函數tanh(·),最后使用經典的全連接層輸出識別標簽向量,我們引入了softmax層,向量的概率計算為

(9)

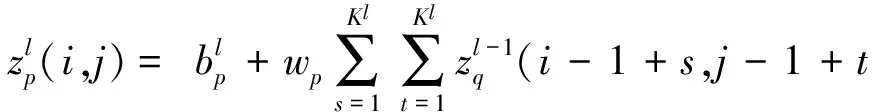

在普通CNN對視頻的處理過程中,我們從視頻的全部圖像幀中抽取一部分作為訓練樣本,{(xn,yn)}n=1,2,…,N,xn代表二維的輸入圖像,yn為分類或識別的標簽.對CNN網絡中的相鄰幀參數θ,以最小化似然函數L(θ)為目標,優化參數θ.似然函數L(θ)的表達式如下:

(10)

為達到這個目的,采用隨機梯度下降算法對式(10)中的參數θ進行訓練,從訓練樣本中取一個隨機樣本(x,y),計算出梯度?L(θ)?θ后,按照式(11)更新參數θ.

(11)

得到的新參數θ能使CNN對視頻中目標識別的性能更準確.其中λ是根據實驗選擇的學習率.

為了使CNN更好地訓練θ,以達到更好的識別正確率,我們利用視頻中存在的時間相關性進一步對似然函數L(θ)進行優化.

Lcoh(θ,x1,x2)=

(12)

其中,δ為邊緣尺寸,是一個提前選取好的參數,例如δ=1.

Fig. 3 Parameter optimization by utilizing the coherence圖3 利用相關特性優化學習參數示意圖

上述的CNN自身對目標識別的任務和使用視頻時間相關性對網絡進行優化是同時進行的,最后我們得到一個優化后的參數:

(13)式(13)最小的參數θ即是我們要訓練的θ值.在式(13)中,為了限制參數的數量,為相關似然函數Lcoh(θ,x1,x2)設置了相同的γ,如可令γ=1.

2.3 基于時間相關的異構多模態深度學習算法

基于時間相關性的異構多模態的結構如圖4所示,我們將視頻中的2個模態視頻和音頻分別采用CCN和RBM進行處理得到相應的識別標簽向量.

RBM網絡的輸入為與視頻幀相對應的同步連續聲譜,我們采用深度自動編碼器的學習模型對音頻進行處理,該學習模型仍然與第1節類似,分為輸入層、共享表示層以及輸出層.

1) 輸入層.為視頻資源的2個模態,即聲譜波和視頻幀,其中聲譜采用RBM訓練,視頻幀采用CNN訓練.

2) 共享表示層.這一層的關鍵是找到特征模態的轉換表示從而最大化模態之間的關聯性.與第1節不同的是,該共享層的視頻部分的特征由并行CNN產生.本文采用CCA的方法尋找聲譜數據的線性轉換從而形成性能優良的共享表示.

3) 輸出層.為該深度學習模型的識別標簽向量.

RBM的目標是最大化訓練樣本集V中的概率之積:

(14)

CNN的優化目標則是最大化式(9)中的概率,基于時間相關的異構多模態深度學習算法的目的就是對參數w,θ優化RBM和CNN的聯合概率:

(15)

具體的算法如算法1所示.

算法1. 利用時間相關性的學習參數優化算法.

輸入:標簽數據(an,xn,yn),n=1,2,…,N,非標簽視頻數據an,xn,n=N+1,N+2,…,N+U;

輸出:神經網絡的參數w,θ和識別標簽label.

Repeat:

Step1. 取一個隨機標簽樣本(an,xn,yn);

Step2. 針對音頻輸入an,執行一次梯度下降迭代優化RBM的連接參數w;

Step3. 對視頻輸入幀中連續的xn,yn和似然函數L(θ,xn,yn),執行1次梯度下降迭代;

Step4. 對視頻輸入幀中不連續的xm,xn和相關似然函數Lcoh(θ,xm,xn),執行1次梯度下降迭代;

Fig. 4 Structure of heterogeneous multimodal deep learning based on temporal coherence圖4 基于時間相關的異構多模態深度學習結構圖

Step5. 針對音頻輸入an,再執行1次梯度下降迭代優化RBM的連接參數w,選擇參數w,θ最大化式(15)中的聯合概率.

Until迭代誤差小于設置的閾值.

上述算法就是通過交替更新目標識別任務的聲譜識別和視頻圖像幀識別的參數來實現優化,在視頻圖像幀中同時利用了連續幀和非連續幀的特征進行優化,以達到提高識別效率的目的.

3 實驗與分析

為了驗證本文提出的異構多模態深度學習的目標識別方法的性能,構造了3組對比實驗:組1的測試數據來自于單一的數據庫,主要說明異構架構結合多種神經網絡的有效性;組2的測試數據來自不同的數據庫,主要說明算法的適應性;組3的測試數據來自視頻網站的電影視頻,說明算法的實際應用性.

對比實驗采用了高性能雙CPU服務器硬件配置,帶有128 GB內存,并配備一塊雙GPU加速卡.基于caffe開源平臺進行深度學習異構平臺的搭建,使用了其中的CNN工具,并加入了多層RBM神經網絡和共享的關聯分析.

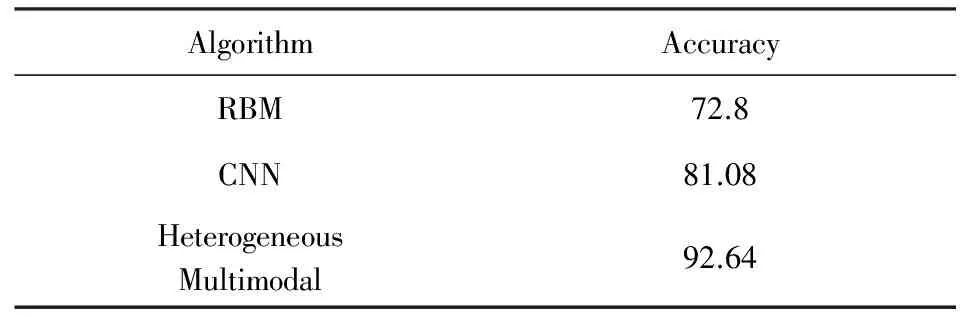

3.1 對比實驗1

為說明異構深度學習架構的有效性,將本文提出的異構多模態策略與分別基于單一神經網絡CNN和RBM的算法進行對比.選用BANCA[24]數據庫中的視頻作為測試數據來源,該數據庫由26個被測對象(13個男性和13個女性)的發音視頻組成.每個被測對象記錄24段視頻,每段視頻大致延續15 s.在這段視頻中被測對象要么讀數字,要么讀他們自己或別人的名字與地址.某些片段會加入噪聲.

對每個被測對象的24段視頻,其中8段作為訓練組,16段作為測試組,對比的結果如表1所示.由表1可以看出,基于異構多模態的神經網絡架構的深度學習目標識別結果比基于單一網絡的深度學習的目標識別結果有了顯著提高.

Table 1 Comparison of Neural Network Algorithms withDifferent Structures Based on BANCA

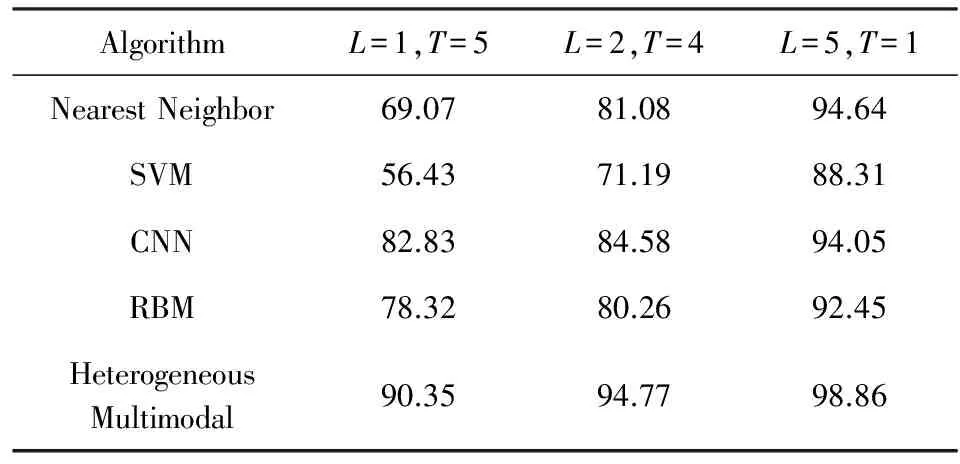

3.2 對比實驗2

為了說明算法的適應性,在這組實驗中分別采用來自不同的數據庫作為測試視頻的聲音和圖像幀信息,使用的數據庫如下:

1) Stanford Dataset.該數據庫是來自于斯坦福大學的一個網絡數據庫.我們選用其中的語音數據部分,使用庫中23名志愿者朗讀從0~9的數字、從A~Z的字母和從TIMIT標準語音庫里挑選的語句,以作為聲音訓練和測試數據.

2) Olivetti Faces.該數據庫是紐約大學的一個人臉數據庫,由40個人的400張圖片構成,即每個人的人臉圖片為10張.每張圖片的灰度級為8 b,每個像素的灰度大小位于0~255之間,每張圖片大小為64×64.使用圖片構造被測視頻的圖像幀,采用人工設定視頻中的人臉視頻與語音數據的對應關系.視頻幀中的幀1,4,5作為標簽數據,其余的圖像作為非標簽數據.

此外,為了驗證算法的有效性,我們將所提出異構多模態深度學習方法同已有的近鄰取樣、支持向量機和傳統的卷積神經網絡和玻爾茲曼機等目標識別方法進行比較.我們將所用圖像和語音數據平均分成6組,分為訓練組L和測試組T,進行如下操作:1)L=1,T=5; 2)L=2,T=4; 3)L=5,T=1,測試結果如表2所示:

Table 2 Comparison of Algorithms Based on StanfordDataset and Olivetti Faces

由實驗結果可以看出隨著訓練集的規模增大,所有目標識別方法的測試精度都得到了顯著提高.跟傳統的4種目標識別方法相比,由于本文提出的異構多模態深度學習方法能夠抽象學習目標與時間相關的特性信息,能不依賴大量對象集進行目標識別訓練,所以異構多模態深度學習方法能始終獲得最高的訓練精度.在訓練組較小L=1,T=5時,異構多模態深度學習方法的測試精度是90.35%;在訓練組較多L=5,T=1時,測試精度提升了8.51%,誤差率只有1.14%.

3.3 對比實驗3

此外,我們利用以下3種具有復雜場景和多種表情動作的視頻數據集以驗證本算法的有效性:UCF sport actions, Hollywood2和YouTube action.這些數據集提取自實際場景,具有場景復雜、待識別目標具有移動性、目標捕捉困難、面對干擾較大等特性.

由于使用了帶有GPU的高性能服務器,所有的算法在訓練后都可以在連續播放5~10幀的時間內完成目標識別.而本文所提出異構算法所需要的時間略高,較所有算法的平均時間大約高出7%,但仍然對所測試的視頻基本上可以滿足實時性的要求.

在本次實驗中我們利用較多訓練組L=5,T=1來驗證目標識別精度.比較結果如表3所示.由仿真結果可以看出在更復雜的場景下,所有4種方法的目標識別都更加困難.特別是針對高度復雜的好萊塢電影場景,目標識別精度最高只有63.86%.

Table 3 Comparison of Algorithms Based on UCF, Hollywood2and YouTube Action

由于4種數據集場景具有較大的干擾,所以具有濾波作用的玻爾茲曼機方法和異構多模態深度學習方法具有更高的識別精度.此外本文提出的異構多模態深度學習方法能夠抽象的學習目標與時間相關的特性信息,特別適用于移動場景目標的識別,能始終獲得最高的目標識別精度.

4 結束語

本文針對網絡媒體數據中同時包含音頻信號和時間相關的視頻圖像信號的特點,提出一種異構多模態目標識別的策略,結合RBM和CNN分別處理媒體數據的音頻和視頻信息,并進一步根據視頻幀之間的時間相關性優化神經網絡的參數,所提出的策略將2種模態特征進行共享學習表示.通過結合2種模態之間的特征,對視頻數據進行更為準確的目標識別.本文給出的算法實驗和比較結果,顯示了本文算法的有效性與優越性.在下一步的研究中,將會考慮更為復雜的視頻場景和充分的噪聲干擾,并考慮不同分辨率視頻信息的融合,以增加算法在實際應用場景的識別能力和適應性能.

[1]Yu Wei, Li Shijun, Yang Sha, et al. Automatically discovering of inconsistency among cross-source data based on Web big data[J]. Journal of Computer Research and Development, 2015, 52(2): 295-308 (in Chinese)(余偉, 李石君, 楊莎, 等. Web大數據環境下的不一致跨源數據發現[J]. 計算機研究與發展, 2015, 52(2): 295-308)

[2]Chen X W, Lin X. Big data deep learning: Challenges and perspectives[J]. IEEE Access, 2014, 2: 514-525

[3]Li Guojie. The scientific value in the study of the big data[J]. Communications of CCF, 2012, 8(9): 8-15 (in Chinese)(李國杰. 大數據研究的科學價值[J]. 中國計算機學會通訊, 2012, 8(9): 8-15)

[4]Lowe D G. Object recognition from local scale-invariant features[C]Proc of the 7th IEEE Int Conf on Computer Vision. Piscataway, NJ: IEEE, 1999: 1150-1157

[5]Deng L, Yu D. Deep learning: Methods and applications[J]. Foundations and Trends in Signal Processing, 2014, 7(34): 197-387

[6]Zivkovic Z. Improved adaptive Gaussian mixture model for background subtraction[C]Proc of the 17th Int Conf on Pattern Recognition. Piscataway, NJ: IEEE, 2004: 28-31

[7]Quattoni A, Collins M, Darrell T. Conditional random fields for object recognition[C]Proc of the Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2004: 1097-1104

[8]Suykens J A K, Vandewalle J. Least squares support vector machine classifiers[J]. Neural Processing Letters, 1999, 9(3): 293-300

[9]Morgan N, Bourlard H. Continuous speech recognition using multilayer perceptrons with hidden Markov models[C]Proc of Int Conf on Acoustics, Speech, and Signal Processing. Piscataway, NJ: IEEE, 1990: 413-416

[10]Le Q V, Zou W Y, Yeung S Y, et al. Learning hierarchical invariant spatio-temporal features for action recognition with independent subspace analysis[C]Proc of IEEE Conf on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2011: 3361-3368

[11]Arel I, Rose D C, Karnowski T P. Deep machine learning-a new frontier in artificial intelligence research[J]. IEEE Computational Intelligence Magazine, 2010, 5(4): 13-18

[12]Hinton G E, Salakhutdinov R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006, 313(5786): 504-507

[13]Liu Jianwei, Liu Yuan, Luo Xionglin. The research and progress of deep learning[J]. Application Research of Computers, 2014, 31(7): 1921-1930 (in Chinese)(劉建偉, 劉媛, 羅雄麟. 深度學習研究進展[J]. 計算機應用研究, 2014, 31(7): 1921-1930)

[14]Hinton G, Deng L, Yu D, et al. Deep neural networks for acoustic modeling in speech recognition: The shared views of four research groups[J]. IEEE Signal Processing Magazine, 2012, 29(6): 82-97

[15]LeCun Y, Bottou L, Bengio Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278-2324

[16]Cheng Dongyang. Multimedia content analysis based on unsupervised feature learning[D]. Shanghai: Shanghai Jiao Tong University, 2014: 1-93 (in Chinese)(程東陽. 基于無監督特征學習的多媒體內容算法研究[D]. 上海: 上海交通大學, 2014: 1-93)

[17]You Qingzhen. The radio face recognition method based on the deep learning[D]. Harbin: Harbin Institute of Technology, 2012: 3-20 (in Chinese)(由清圳. 基于深度學習的視頻人臉識別[D]. 哈爾濱: 哈爾濱工業大學, 2012: 3-20)

[18]Wang Y S, Fu H, Sorkine O, et al. Motion-aware temporal coherence for video resizing[J]. ACM Trans on Graphics, 2009, 28(5): 127-127

[19]Zou W, Zhu S, Yu K, et al. Deep learning of invariant features via simulated fixations in video[C]Proc of the Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2012: 3212-3220

[20]Leonardi R, Migliorati P, Prandini M. Semantic indexing of soccer audio-visual sequences: A multimodal approach based on controlled Markov chains[J]. IEEE Trans on Circuits and Systems for Video Technology, 2004, 14(5): 634-643

[21]Ngiam J, Khosla A, Kim M, et al. Multimodal deep learning[C]Proc of the 28th Int Conf on Machine Learning. New York: ACM, 2011: 689-696

[22]Mobahi H, Collobert R, Weston J. Deep learning from temporal coherence in video[C]Proc of the 26th Int Conf on Machine Learning. New York: ACM, 2009: 737-744

[23]Simonyan K, Zisserman A. Two-stream convolutional networks for action recognition in videos[C]Proc of the Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2014: 568-576

[24]Bailly-Baillie`re E, Bengio S, Bimbot F, et al. The BANCA database and evaluation protocol[G]LNCS 2688: Proc of the 4th Int Conf on Audio-and Video-Based Biometric Person Authentication. Berlin: Springer, 2003: 625-638

Wen Mengfei, born in 1975. Associate professor. PhD from Central South University, postdoctor of Hunan Provincial Research Institute of Education. His main research interests include automation control, computer science and multi-agent system.

Liu Weirong, born in 1976. PhD. Associate professor of Central South University. Member of CCF. His main research interests include computer science, machine learning, big data, cooperative communication and cooperative control.

Hu Chao, born in 1980. PhD from Central South University. Associate dean of Information and Network Center of Central South University. His main research interests include computer science, network management and regional medical informationization (huchao@csu.edu.cn).

A Heterogeneous Multimodal Object Recognition Strategy of the Massive Network Data Flow

Wen Mengfei1,4, Liu Weirong1, and Hu Chao2,3

1(SchoolofInformationScienceandEngineering,CentralSouthUniversity,Changsha410083)2(InformationandNetworkCenter,CentralSouthUniversity,Changsha410083)3(KeyLaboratoryofMedicalInformationResearch(CentralSouthUniversity),CollegeofHunanProvince,Changsha4100834(HunanProvincialResearchInstituteofEducation,Changsha410005)

It is a research hot to achieve the object recognition of the massive network media data nowadays. To address the problem, an object recognition strategy is proposed to handle the massive network media data flow which adopts heterogeneous multimodal structure while utilizing the temporal coherence. Firstly, based on the video and audio co-existing feature of media network data, a heterogeneous multimodal structure is constructed to incorporate the convolutional neural network(CNN) and the restricted Boltzmann machine(RBM). The audio information is processed by restricted Boltzmann machine and the video information is processed by convolutional neural network respectively. The heterogeneous multimodal structure can exploit the merits of different deep learning neural networks. After that, the share characteristic representation are generated by using the canonical correlation analysis(CCA). Then the temporal coherence of video frame is utilized to improve the recognizing accuracy further. There kinds of experiments are adopted to validate the effectiveness of the proposed strategy. The first type of experiment compares the proposed strategy with single-mode algorithm. The second type of experiment illustrates the result based on composite database. Finally the videos coming from real websites are extracted to compare the proposed strategy with other algorithms. These experiments prove the effectiveness of the proposed heterogeneous multimodal strategy.

object recognition; deep learning; convolutional neural network (CNN); restricted Boltzmann machine (RBM); canonical correlation analysis (CCA)

2015-08-03;

2015-12-16

湖南省教育科學“十二五”規劃重點資助項目(XJK014AJC001);國家自然科學基金項目(61379111,61672539,61202342) This work was supported by the Key Project of Educational and Scientific Foundation of Hunan Province During the 12th Five-Year Plan Period(XJK014AJC001) and the National Natural Science Foundation of China (61379111,61672539,61202342).

劉偉榮(frat@csu.edu.cn)

TP391