基于深度學習的頭部姿態(tài)估計

賀飛翔,趙啟軍

(四川大學 視覺合成圖形圖像技術國防重點學科實驗室,四川 成都 610065)

基于深度學習的頭部姿態(tài)估計

賀飛翔,趙啟軍

(四川大學 視覺合成圖形圖像技術國防重點學科實驗室,四川 成都 610065)

頭部姿態(tài)估計在人工智能、模式識別及人機智能交互等領域應用廣泛。好的頭部姿態(tài)估計算法應對光照、噪聲、身份、遮擋等因素時魯棒性較好,但目前為止如何提高姿態(tài)估計的精確度與魯棒性依然是計算機視覺領域的一大挑戰(zhàn)。提出了一種基于深度學習進行頭部姿態(tài)估計的方法。利用深度學習強大的學習能力,對輸入的人臉圖像進行一系列的非線性操作,逐層提取圖像中抽象的特征,然后利用提取的特征進行分類。此類特征在姿態(tài)上具有較大的差異性,同時對光照、身份、遮擋等因素魯棒。在CAS-PEAL數據集上對該方法進行了評估實驗。實驗結果表明,該方法有效地提高了姿態(tài)估計的準確性。

頭部姿態(tài)估計;深度學習;提取特征;分類

1 概 述

頭部姿態(tài)是研究人類行為和注意力的關鍵,在人際交往中,扮演著非常重要的角色。頭部姿態(tài)的改變也包含豐富的信息,例如同意、反對、理解、迷惑、驚喜等。此外,頭部姿態(tài)還是包括人臉識別、表情識別、視線估計在內的許多智能系統(tǒng)在非約束條件下進行身份識別與行為預測所需要的關鍵信息。因此,頭部姿態(tài)估計是計算機視覺與模式識別領域一個非常重要的應用,其算法研究的意義非常大。

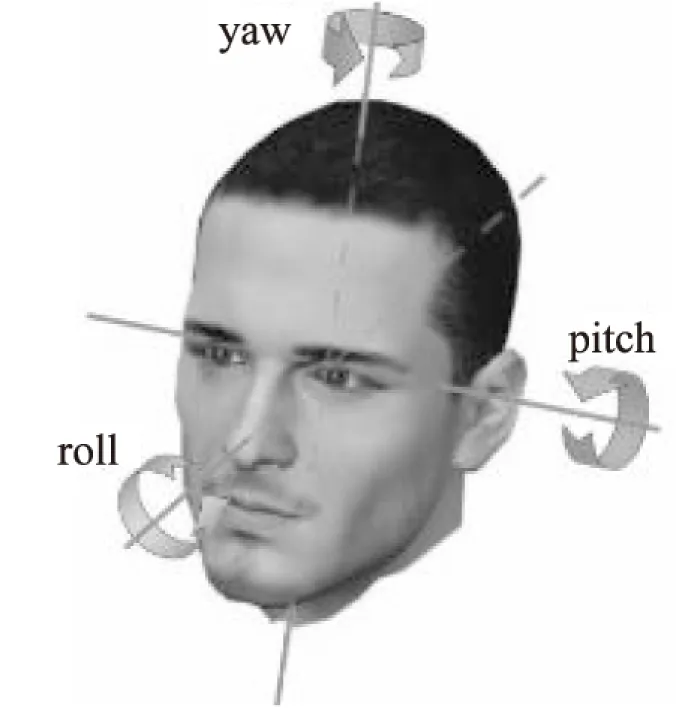

在計算機視覺領域,頭部姿態(tài)估計[1]是指計算機通過對輸入圖像或者視頻序列的分析、預測,確定人的頭部在三維空間(相對于攝像機)中的位置及姿態(tài)參量。通常說來,假設頭部姿態(tài)估計是一個剛體變換,存在pitch,yaw,roll三個方向自由度,如圖1所示。由于受非約束壞境中的投影幾何形變、背影光照變化、前景遮擋問題和低分辨率等因素的影響,使得頭部姿態(tài)的多自由度估計一直是一個富有挑戰(zhàn)性的領域。

針對人臉頭部姿態(tài)估計的算法,主要分為基于模型的方法和基于人臉表觀的方法。其中,基于模型的方法[2-4]主要是利用若干臉部特征點構成的模型,通過提取不同姿態(tài)下模型的差異預測頭部姿態(tài)。此類方法實現(xiàn)簡單、計算高效準確、易于理解,但強烈依賴特征點定位的準確程度,而準確的特征點檢測在姿態(tài)變化較大時仍然是一個急待解決的挑戰(zhàn)。基于表觀學習[5-10]的方法是通過大量的訓練數據直接學習圖像與頭部姿態(tài)之間的映射關系。與基于模型匹配方法相比,其主要優(yōu)點是提取基于表觀的特征不依賴特征點的位置,具有較高的魯棒性與估計精確度。文中研究的方法屬于基于表觀學習的方法。

圖1 人臉頭部姿態(tài)三個旋轉方向

基于圖像表觀的學習方法解決姿態(tài)的問題通常可以看作是分類問題或者是回歸問題。此類算法的核心主要分為兩部分:第一部分是提取圖片中與頭部姿態(tài)變化緊密相關的特征,此類特征對人的身份、表情、光照等無關因素魯棒;第二部分是通過某種分類算法,對提取的特征進行分類或回歸對姿態(tài)角度進行估計。

深度學習是機器學習中一個新的領域。從2006年開始,深度學習在語音識別、計算機視覺(包括人臉識別、特征點檢測、人臉檢測等)、自然語言處理以及信息檢索等領域性能優(yōu)異。深度學習可通過學習一種深層非線性網絡結構,實現(xiàn)復雜函數逼近,其特有的層次結構能夠對數據局部特征進行多層次抽象化的學習與表達。文中主要是利用深度學習強大的學習能力,學習輸入圖片中與對象的身份、光照、表情等因素無關,且僅與姿態(tài)有關的特征,然后通過分類,用以解決頭部姿態(tài)估計的問題。

2 基于卷積網絡頭部姿態(tài)估計

2.1 基于CNN的深度學習網絡

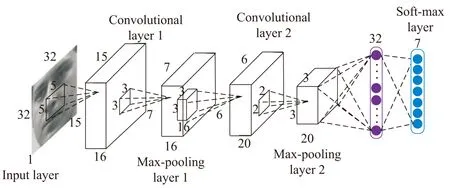

文中采用的深度網絡結構模型主要包括2個卷積層(含2個采樣層),后接1個全連接層和soft-max輸出層。如圖2所示(圖中外面的大立方體的長、寬、高分別表示每一層特征圖的個數與特征圖的維度,里面的小立方體和正方形分別表示卷積過程中卷積核的尺寸與下采樣過程中采樣矩形框的尺寸,最后兩層是全連接中神經元的個數),輸入圖片x0是尺度大小歸一化至32×32的灰度圖像。圖像輸入到網絡結構,逐層對輸入圖片進行卷積與池化采樣,提取抽象的特征,通過soft-max對提取的抽象特征分類,網絡的最終輸出為輸入圖片的頭部姿態(tài)。當輸入圖片的尺寸發(fā)生變化時,網絡結構中每一層特征譜的髙與寬都會發(fā)生相應的變化。在提取圖像特征的過程中,特征逐漸抽象化,特征的維度逐漸下降,形成更加簡潔抽象且具有高度區(qū)分性的特征,從而能夠正確分類出輸入圖片中頭部姿態(tài)所屬類別。

在卷積階段,利用卷積核對特征圖進行卷積操作,加強原信號信息,并且降低圖片噪音。在卷積神經網絡中,每個卷積核能夠提取輸入特征圖中所有位置上的某一特定特征,每一個卷積濾波器共享相同的參數,包括相同的權值矩陣與偏置項,從而實現(xiàn)同一個輸入特征圖上的權值共享[11]。權值共享的優(yōu)點是在對圖片提取特征時不用考慮局部特征權重的差異(比如鼻子、眼睛、嘴巴),使要學習的卷積神經網絡模型的參數數量大大降低。

圖2 深度網絡結構詳圖

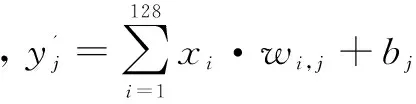

為了提取能夠預測輸入圖片中人臉頭部偏轉角度的多個特征,需要使用不同的卷積核進行卷積操作。卷積運算可表示如下:

(1)

其中,xi與yj分別表示第i個輸入特征圖與第j個輸出特征圖;wij是第i個輸入特征圖與第j個輸出特征圖之間的卷積核;*表示卷積;bj是第j個輸出圖的偏置項。

為了避免線性模型表達能力不夠,通常需要對卷積過后得到的特征圖進行非線性化操作,防止過擬合。常用的非線性函數主要有sigmoid、tanh、ReLU等。文中對隱層神經元使用不飽和非線性函數ReLU。

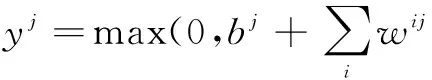

下采樣主要是實現(xiàn)特征的降維。由于圖像局部相關性原理,通過對圖像進行下采樣,在保留圖像有用信息的同時降低了特征圖的維度。下采樣階段主要是對單個特征圖進行操作,主要有平均池化下采樣與最大池化下采樣。平均池化下采樣是取鄰域中的平均值作為輸出,最大池化下采樣是取鄰域中的最大值作為輸出。文中采用的是最大池化下采樣,過程可表示為:

(2)

其中,yj表示下采樣過程中的第i個輸出譜,其中的每一個神經元是從第i個輸入譜中s×s局部區(qū)域采樣得到的;m與n分別表示下采樣框移動的步長。

SoftMax回歸是在邏輯回歸的基礎上擴張而來的,主要是為了解決多分類問題,是有監(jiān)督的學習算法。網絡的最后一層是SoftMax函數,與深度學習結合使用,用來區(qū)分輸入圖片的角度類別。

(3)

因此整個網絡的優(yōu)化目標是最小化-logyt。

2.2 網絡的訓練與測試

訓練深度網絡模型的本質就是獲得構建網絡的所有參數(包括權重與偏置),其訓練的復雜程度與參數的數量正相關。

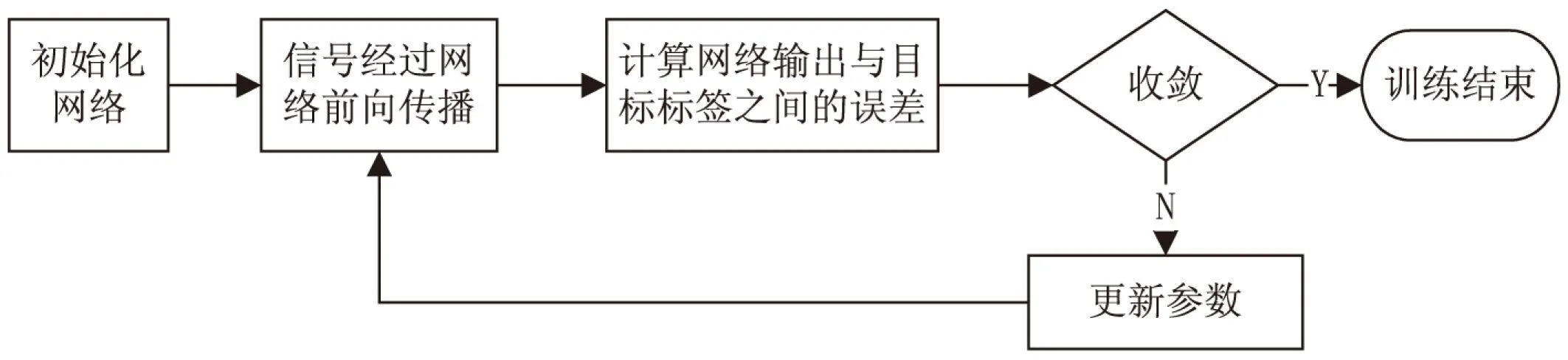

訓練網絡流程圖如圖3所示。

圖3 訓練網絡流程圖

Step1:圖片預處理。用雙線性內插法將測試樣本與訓練樣本歸一化至尺寸為32×32的灰度圖像。

Step2:將訓練樣本輸入網絡并前向傳播,計算網絡的輸出與給定的目標標簽之間的誤差,判斷是否有收斂。

Step3:若收斂,則訓練結束;若不收斂,則誤差反向傳遞,逐層更新參數,然后轉到Step2。

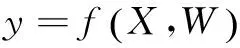

圖4 網絡結構的抽象表示

整個網絡的誤差對每一層參數求導的公式為:

在網絡測試階段,將測試圖片通過訓練好的網絡,網絡的輸出即為測試圖片的角度類別標簽。

3 實驗與結果分析

3.1 實驗數據庫

文中實驗主要是在CAS-PEAL數據集上進行。CAS-PEAL是進行頭部姿態(tài)估計常用的一個數據集。在該數據集上,頭部姿態(tài)被劃分為7個yaw方向上的離散角度{-45°,-30°,-15°,0°,15°,30°,45°}和3個pitch方向的離散角度{-30°,0°,30°}。對于每一張圖片,使用一個人臉檢測器[12]定位圖片的人臉區(qū)域,截取人臉圖片并將其歸一化至32*32。CAS-PEAL中一些樣本圖片如圖5所示。

圖5 CAS-PEAL數據集中的樣本圖片

3.2 實驗結果

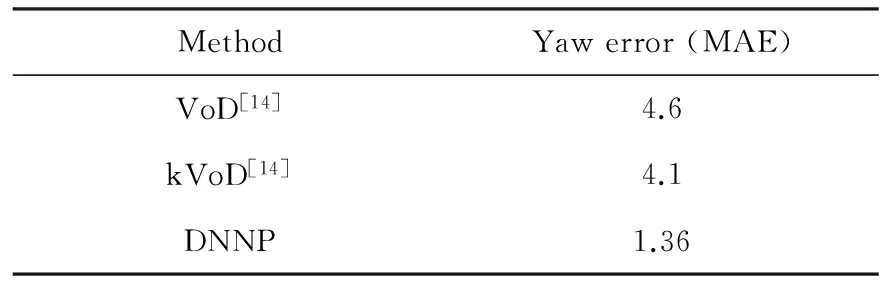

在CAS-PEAL數據集中對象編號為401~600的子集上進行實驗。該數據子集上共有4 200(21*200)張圖片,使用人臉檢測器檢測到的人臉圖片共4 166張。使用三折交叉驗證,將實驗數據集分成三個數據子集,其中一個數據子集用來測試,剩下的兩個用來訓練。通過這樣的方式,保證所有訓練圖片與測試圖片不交叉。重復三次實驗使每一個子集都參與測試,實驗結果為三次測試結果的平均值。在該實驗數據集上,實驗結果如表1所示。其中,VoD與kVoD使用的是另一個人臉檢測器[13]。

表1 CAS-PEAL數據集上幾種方法的平均絕對誤差(MAE)比較

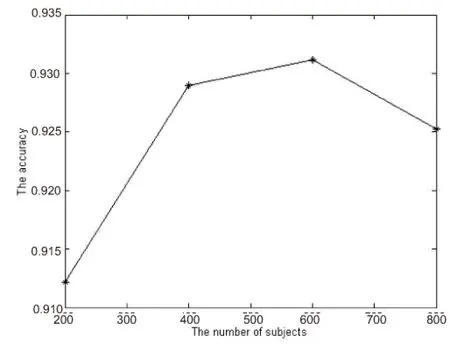

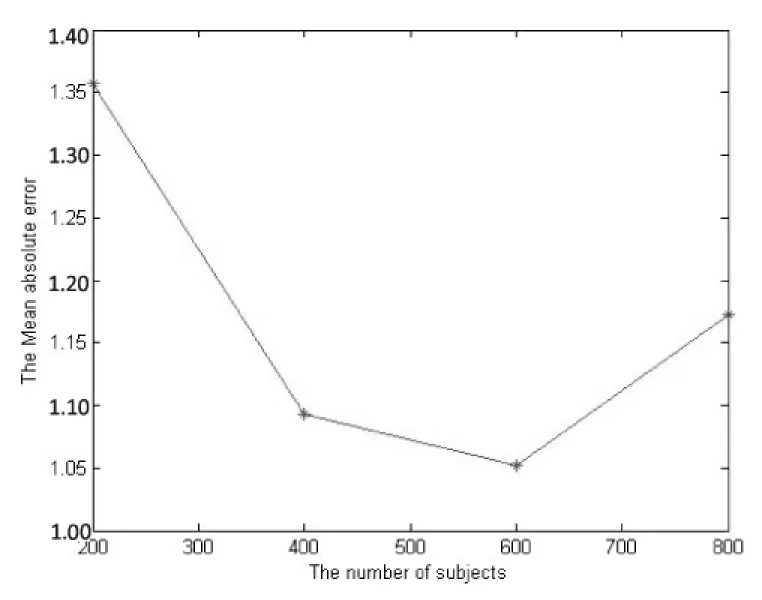

在CAS-PEAL數據集上,分別取編號為401~600、201~600、201~800、201~1 002的四個子集進行實驗,實驗數據集中包含對象數量分別為200、400、600、800,檢出的人臉圖片數量分別為4 166,8 313,12 502,16 670。分別對四個實驗數據集使用三折交叉驗證。不同數據集下的分類準確率與Yaw方向角度的平均絕對誤差分別如圖6和圖7所示。

實驗結果表明,隨著實驗數據集中對象數量的增加,數據集中包含的具有代表性的信息越多,在相同的網絡結構下,測試圖片的分類準確率逐漸增加,平均絕對誤差逐漸減小。當樣本對象數量超過600后,實驗結果有所下降。

圖6 不同規(guī)模數據集下的分類準確率

圖7 不同規(guī)模下的平均絕對誤差

4 結束語

文中提出了基于深度學習的頭部姿態(tài)估計方法。通過深度網絡提取特征并對其進行分類預測,在CAS-PEAL數據集上顯著降低了姿態(tài)估計的誤差,取得了較好的實驗效果。但是該方法的泛化能力強弱依賴于訓練數據的多樣性與網絡結構的復雜度。由于訓練圖片來自CAS-PEAL數據集,若測試圖片來自其他數據集,則測試效果不理想。

下一步的工作主要是融合多個數據集訓練更加復雜的網絡結構,在保證較低的姿態(tài)角度誤差的前提下,增大網絡結構的泛化能力。

[1] Kuchinsky A,Pering C,Creech M L,et al.FotoFile:a consumer multimedia organization and retrieval system[C]//Proceedings of the SIGCHI conference on human factors in computing systems.New York:ACM,1999:496-503.

[2] Wang Jiangang,Eric S.EM enhancement of 3D head pose estimated by point at infinity[J].Image and Vision Computing,2007,25(12):1864-1874.

[3] Ebisawa Y.Head pose detection with one camera based on pupil and nostril detection technique[C]//Proceedings of the IEEE international conference on virtual environments,human-computer interfaces and measurement systems.[s.l.]:IEEE,2008:172-177.

[4] Kong S G,Mbouna R O.Head pose estimation from a 2d face image using 3D face morphing with depth parameters[J].IEEE Transactions on Image Processing,2015,24(6):1801-1808.

[5] Haj M A,Gonzalez J,Davis L S.On partial least squares in head pose estimation:how to simultaneously deal with misalignment[C]//Proceedings of IEEE conference on computer vision and pattern recognition.[s.l.]:IEEE,2012:2602-2609.

[6] Foytik J,Asari V K.A two-layer framework for piecewise linear manifold-based head pose estimation[J].International Journal of Computer Vision,2013,101(2):270-287.

[7] Lu J,Tan Y P.Ordinary preserving manifold analysis for human age and head pose estimation[J].IEEE Transactions on Human-Machine Systems,2013,43(2):249-258.

[8] Fanelli G, Dantone M, Gall J,et al.Random forests for real time 3D face analysis[J].International Journal of Computer Vision,2013,101(3):437-458.

[9] Ma B,Chai X,Wang T.A novel feature descriptor based on biologically inspired feature for head pose estimation[J].Neurocomputing,2013,115:1-10.

[10] Geng X,Xia Y.Head pose estimation based on multivariate label distribution[C]//IEEE conference on computer vision and pattern recognition.[s.l.]:IEEE,2014:1837-1842.

[11] Le Cun Y,Bottou L,Bengio Y,et al.Gradient-based learning applied to document recognition[J].Proceedings of the IEEE,1998,86(11):2278-2324.

[12] Sun Y,Wang X,Tang X.Deep convolutional network cascade for facial point detection[C]//IEEE conference on computer vision and pattern recognition.[s.l.]:IEEE,2013:3476-3483.

[13] Yan S,Shan S,Chen X,et al.Matrix-Structural Learning (MSL) of cascaded classifier from enormous training set[C]//IEEE conference on computer vision and pattern recognition.[s.l.]:IEEE,2007.

[14] Ma B,Huang R,Qin L.VoD:a novel image representation for head yaw estimation[J].Neurocomputing,2015,148:455-466.

Head Pose Estimation Based on Deep Learning

HE Fei-xiang,ZHAO Qi-jun

(National Key Laboratory of Fundamental Science on Synthetic Vision,Sichuan University, Chengdu 610065,China)

Head pose estimation has been widely used in the field of artificial intelligence,pattern recognition and intelligent human-computer interaction and so on.Good head pose estimation algorithm should deal with light,noise,identity,shelter and other factors robustly,but so far how to improve the accuracy and robustness of attitude estimation remains a major challenge in the field of computer vision.A method based on deep learning for pose estimation is presented.Deep learning with a strong learning ability,it can extract high-level image features of the input image by through a series of non-linear operation,then classifying the input image using the extracted feature.Such characteristics have greater differences in pose,while they are robust of light,identity,occlusion and other factors.The proposed head pose estimation is evaluated on the CAS-PEAL data set.Experimental results show that this method is effective to improve the accuracy of pose estimation.

head pose estimation;deep learning;extracting feature;classification

2016-01-29

2016-05-18

時間:2016-10-24

國家自然科學基金資助項目(61202160,61202161);科技部重大儀器專項(2013YQ49087904)

賀飛翔(1992-),男,碩士研究生,研究方向為生物特征識別;趙啟軍,副教授,碩士研究生導師,研究方向為生物特征識別。

http://www.cnki.net/kcms/detail/61.1450.TP.20161024.1117.076.html

TP301.6

A

1673-629X(2016)11-0001-04

10.3969/j.issn.1673-629X.2016.11.001