融合塊顯著質心描述和多級關聯的多目標跟蹤

路 紅,李宏勝,費樹岷,程 勇

(1.南京工程學院自動化學院,南京江蘇211167;2.東南大學自動化學院,南京江蘇210096)

融合塊顯著質心描述和多級關聯的多目標跟蹤

路 紅1,李宏勝1,費樹岷2,程 勇1

(1.南京工程學院自動化學院,南京江蘇211167;2.東南大學自動化學院,南京江蘇210096)

提出一種融合目標分塊、顯著質心建模和多級關聯的多目標跟蹤(multi-target tracking,MTT)方法,用于提高互遮擋、相似目標干擾場景中的跟蹤魯棒、準確性。利用自適應閾值背景差分檢測運動區域;將目標區域分塊,根據塊中運動像素處背景差分值計算色彩顯著度,建立運動、色彩顯著質心模型;建立目標間、目標與運動檢測間全局、塊級數據關聯,判別互遮擋目標及塊,并據塊遮擋矩陣更新目標模板;利用有效色彩和運動信息計算塊質心轉移向量及融合權值,獲得目標全局質心轉移向量以定位目標。實驗結果表明該方法對互遮擋、相似目標干擾及外觀變化的多目標均具有穩定跟蹤性能。

多目標跟蹤;顯著質心;多級關聯;塊質心轉移

0 引 言

基于視覺的多目標跟蹤(multi-target tracking,MTT)是計算機視覺領域的一個重要研究方向,也是國際計算機智能視頻監控領域研究的熱點,在地面交通管制、工業機器人手眼系統和港口監視等多方面都具有廣泛應用。但由于復雜場景中遮擋、相似特征目標(或背景)干擾、目標外觀變化等影響,MTT的魯棒性、準確性和實時性問題仍未得到完善解決[1]。

早期MTT側重于目標運動分析法[2-3],近年來,針對測量-跟蹤間分配問題,基于外觀模型的MTT研究逐漸成為熱點。由于色彩直方圖(color histogram,CH)[3]等能較好刻畫目標外觀特征,準確定位動態遮擋引起的運動檢測合并區域中的單個目標,基于運動特征和CH的多特征融合MTT方法[3-5]得到一定應用。同時,針對CH光照敏感問題,考慮光照容忍的目標描述研究也開始涌現,如邊緣方向直方圖[6]、局部二值模式[7]等。上述經典直方圖特征由于忽視空間信息,在相似特征目標或背景干擾、目標外觀變化(由旋轉或部分遮擋等引起)時鑒別力下降。因此針對如何建立魯棒的目標外觀模型以提高目標描述力成為研究熱點。其研究成果目前主要集中在單目標跟蹤上,并在旋轉和縮放預測、擁擠和部分遮擋場景中取得良好跟蹤結果,如共生色彩對相關圖描述[8]、基于水平集背景消除的面積加權質心描述[9]、非對稱核函數加權模型[10]等,這些研究考慮了特征空間分布信息,相比經典全局特征方法,能夠提高目標描述力,對提高MTT魯棒性具有重要意義。文獻[11]針對單目標和MTT,在Log-euclidean塊分割外觀模型中融入全局和局部外觀空間信息建立目標模型,具有抗部分遮擋和光照魯棒性,但是遮擋判別依賴塊自身特征協方差,沒有發揮多目標間相互作用。

對于固定場景中的多運動目標檢測,背景差法是最佳的,其中背景重構等問題得到了廣泛研究,如背景數學建模[4]和像素灰度選擇[1213]方法的應用等。基于運動檢測的MTT能自動起始跟蹤,快速關聯獨立運動目標,若輔以魯棒的目標外觀模型匹配跟蹤,則有利于實現互遮擋目標合并區域中測量-跟蹤間準確分配。與多特征融合相對應,多種檢測和跟蹤算法融合也成為關注的焦點,如背景差法與均值漂移(mean shift,MS)融合[4]、背景差法與粒子濾波(particle filter,PF)融合[3]、MS與卡爾曼濾波(Kalman filter,KF)融合[6]等。文獻[4]利用目標運動檢測框間重疊與否判斷遮擋,采用前景檢測消除背景對目標特征模型的影響,并將互遮擋目標作為一個整體進行核掩膜MS跟蹤;由于遮擋目標全局模板在整個遮擋過程中不更新,因此在長期部分遮擋并發生目標外觀漸變時,難以持續準確跟蹤;若互遮擋目標外觀相似,則將會因缺乏合并過程中目標個體的確切位置信息,引起目標分離時單個目標定位錯亂。還有一些與特征模型相對應的目標檢測新方法,如基于PF貝葉斯狀態推理的目標檢測和跟蹤方法[11]、一步質心轉移法[9]等。文獻[9]針對單目標跟蹤提出一步質心定位概念,利用目標區域中各色彩覆蓋面積計算該色彩質心在目標定位中的權值。由于色彩質心對像素數目變化不敏感,因此具有目標定位穩定性。但當目標與所處背景色彩大面積相似或受鄰近相似特征目標干擾時,將產生跟蹤漂移。一步質心定位克服了經典迭代搜索和大量樣本訓練方法的計算量問題,但目前僅局限于單目標跟蹤,若合理拓展到MTT框架中,將有利于提高跟蹤效率。

經典數據關聯方法主要針對空中目標或點目標跟蹤,聯合概率數據關聯[1415]等理論得到了廣泛應用。這些方法主要集中在利用概率分析推理測量-跟蹤間分配問題,方法復雜、計算耗費大。針對地面小目標跟蹤,文獻[16]采用兩級目標檢測和跟蹤算法,在低級階段利用目標位置和形狀信息進行聚類以獲得測量信息,在高級階段進行聯合概率數據關聯跟蹤。最近的MTT研究集中在基于外觀模型的方法上,針對單一數據關聯方法難以應對復雜場景中目標行為、外觀變化多樣性,多種關聯融合方法得到廣泛研究,在遮擋推理、部分可觀測區域關聯及歧義目標跟蹤方面取得一系列成果。如針對動態遮擋MTT的基于PF估計和區域關聯算法[3],基于中心最近鄰、尺度最近鄰和MS融合算法[4],針對擁擠場景MTT的基于運動估計、Hungarian算法和場景推理的三級關聯算法[17],以及針對攝像機抖動場景中MTT的目標組數據關聯和單個目標獨立匹配兩級關聯算法[5]等。從數據關聯機制上看,若對目標區域分塊,建立不同(互遮擋)目標間基于塊的數據關聯,則可將遮擋判斷精確到塊級,同時可利用局部可觀測塊提高測量-跟蹤間分配以及模板更新效率。

本文針對多目標互遮擋、相似特征目標干擾問題,設計了一種有效增強目標描述力、提高測量-跟蹤間分配魯棒、穩定性的多目標全自動跟蹤方法。將自適應運動檢測、運動和色彩顯著質心模型描述、基于兩級關聯的遮擋塊定位、塊質心轉移向量融合及模板更新融入MTT框架。實驗結果表明:本文算法與面積加權質心轉移算法、掩膜MS跟蹤算法相比,具有遮擋跟蹤穩定、抗相似特征目標干擾能力強等特點,在目標持續合并和遮擋、合并和分離交替以及外觀變化過程中均具有魯棒定位性能。

1 運動檢測和目標描述算法

1.1 運動檢測

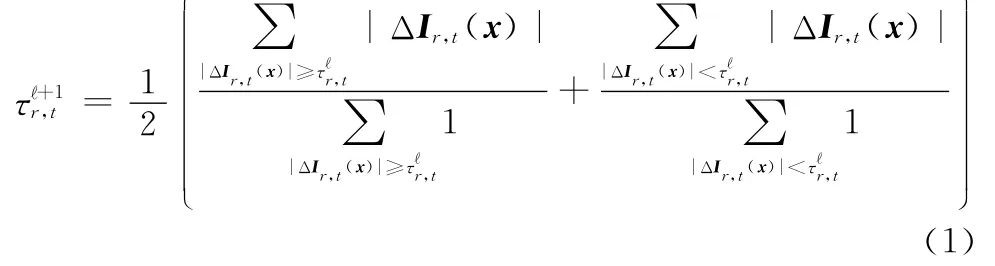

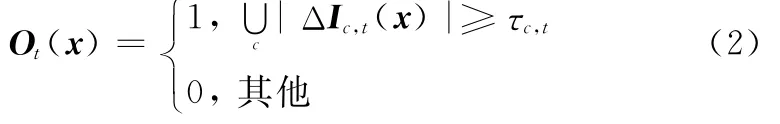

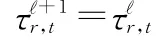

運動檢測方法中,背景差分法因其能獲得相對當完整的運動區域、計算量小等優點得到廣泛應用。為了使檢測算法對場景及光照漸變具有自適應性,這里采用閾值迭代算法獲取當前幀It與背景Bt色彩分量絕對差分圖像{|ΔIr,t|,|ΔIg,t|,|ΔIb,t|}各自的自適應分割閾值{τr,t,τg,t,τb,t},如式(1)所示。

式中,|ΔIr,t|=|Ir,t-Br,t|。

通過融合分量分割結果獲得當前幀中二值運動檢測區域Ot(x),如式(2)所示。

1.2 運動像素色彩顯著度

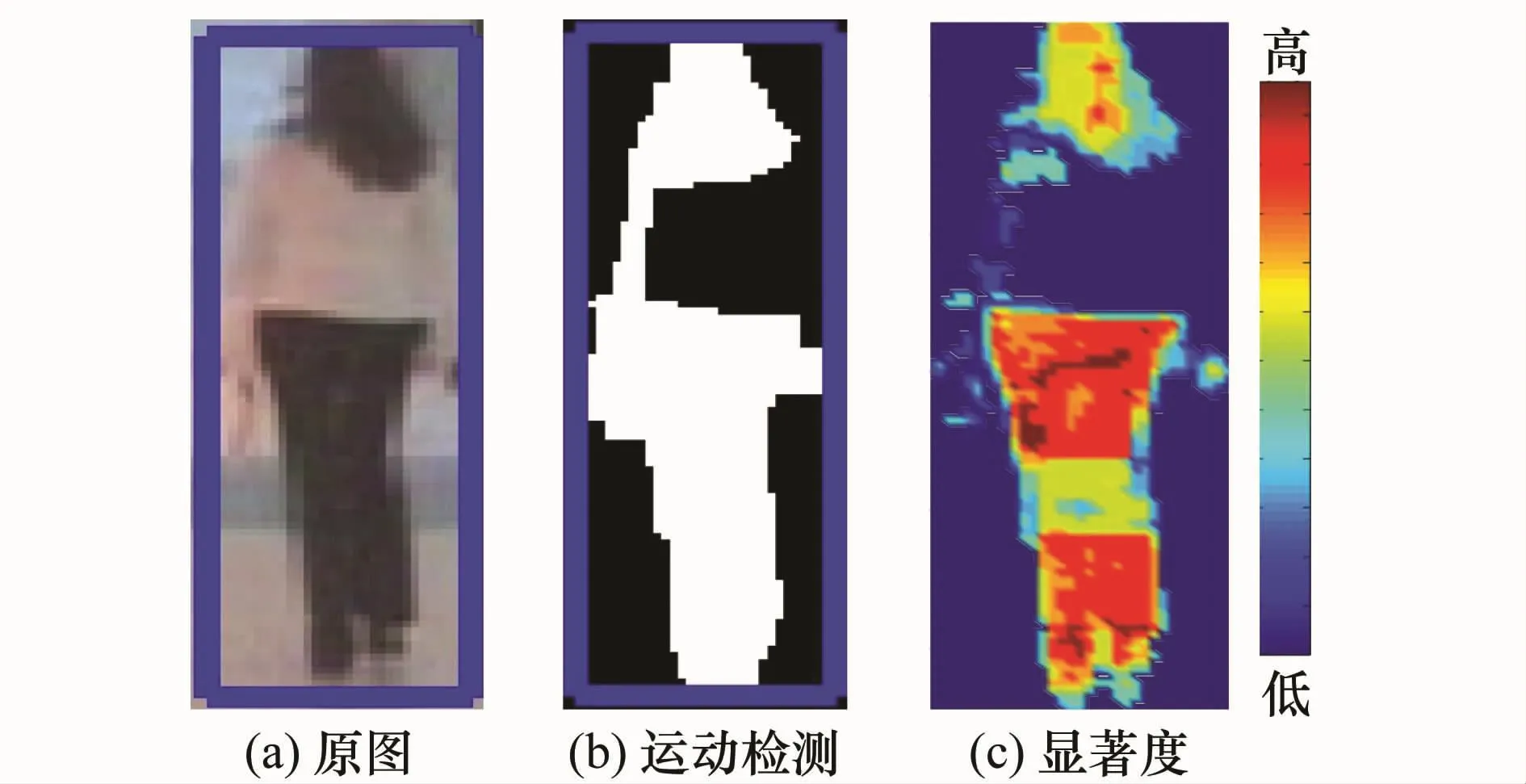

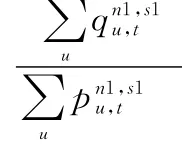

人眼跟蹤目標時,依據的不僅僅是目標主色彩(覆蓋面積大)對視覺的刺激,那些相對背景對比度大的運動像素和顯著色彩,即使覆蓋面較小,在主色彩和背景色彩相近、目標被部分遮擋時,卻往往能成為目標定位的重要依據。由于|ΔIr,t|能直觀反映前景與背景間色彩差異,因此這里用其來計算運動像素xi處色彩u=[|ΔIr,t(xi)|,|ΔIg,t(xi)|,|ΔIb,t(xi)|]的顯著度wt(u,xi)。將u視為3位(M+1)進制數,以其十進制表示的歸一化值作為xi處顯著度,如式(3)和圖1所示。

式中,M為灰度級。圖1(a)為原圖的16×16×16色彩空間降維圖像(M=15),藍色外接矩形框包圍的為目標區域;圖1(b)為目標二值運動區域;圖1(c)中色彩代表wt(u,xi)值:目標頭部和褲子相對背景的區分度較大,對應顯著度值較大,而覆蓋面積較大的上衣由于與背景色彩相似,呈現出較低顯著度值。

圖1 運動像素色彩顯著度圖

1.3 分塊顯著質心描述

將目標區域沿水平和垂直方向均分為互不重疊的L1×L2塊,獲得各塊中心坐標、尺度、面積和運動像素占空比;以第n個塊中運動像素色彩顯著度(u,xi)加權各色彩u的坐標xi,獲得該塊色彩質心以及質心顯著度,建立塊級運動像素色彩顯著度加權質心模型,如式(4)和式(5)所示。

式中,Rn為塊n中二值區域“1”的個數;δ為狄拉克函數。

2 塊質心轉移融合和多級關聯MTT

2.1 算法總體流程

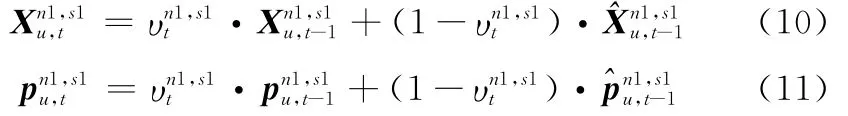

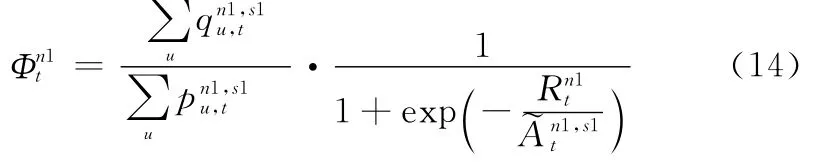

設第t-1幀跟蹤目標為s1(s1=1,2,…,N1),第t幀運動檢測目標(二值聯通域)為k(k=1,2,…,N2)。定義:、和分別為第s1個目標跟蹤矩形框中心坐標和尺度;和分別為第k個運動檢測區域外接矩形框中心坐標和尺度;、和分別為目標映射矩形框中心坐標、第n1個塊中心坐標和尺度為]確定的檢測區域;為[]確定的映射區域;(+Δ)為由[,+Δ]確定的目標映射擴展矩形,Δ為擴展的像素數目。如圖2所示,紅色實線框為第t-1幀目標跟蹤框,綠色虛線框、紅色點線框和黃色點劃線框分別為第t幀目標檢測矩形、映射矩形和映射擴展矩形。

圖2 目標跟蹤、檢測、映射和擴展矩形框

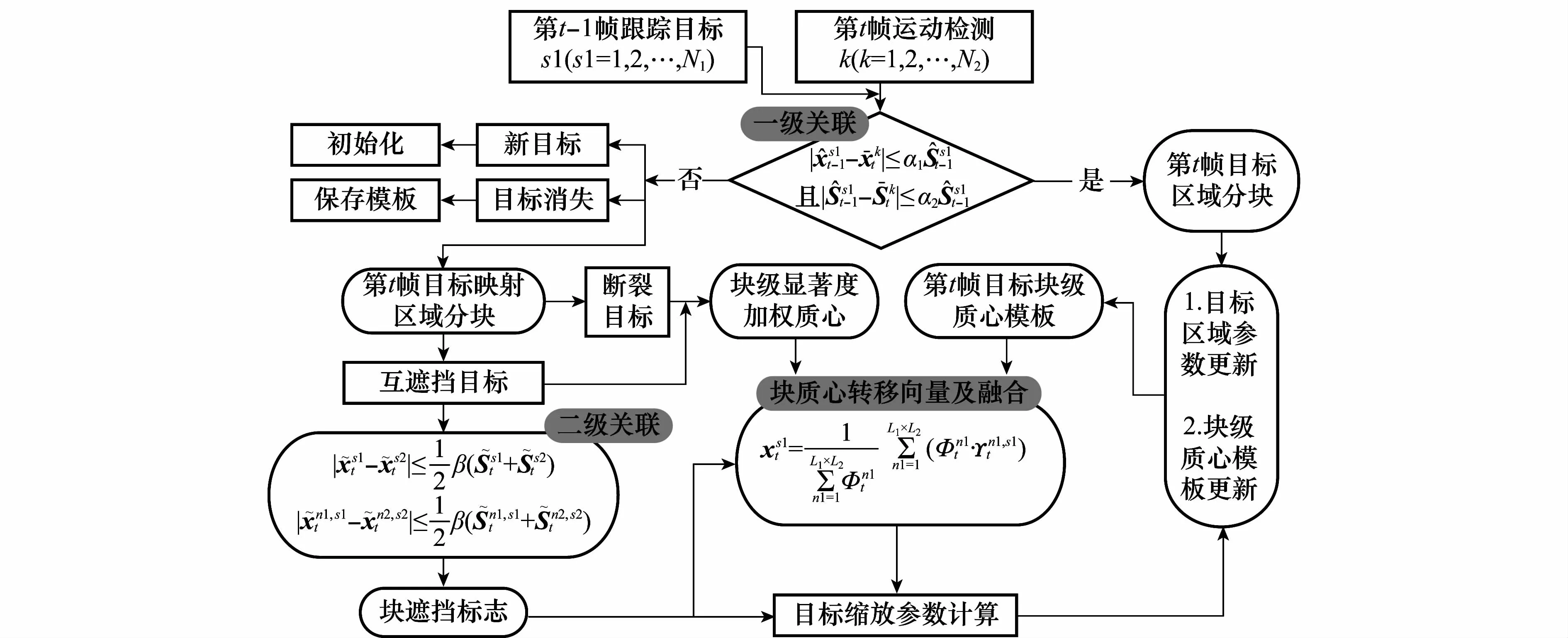

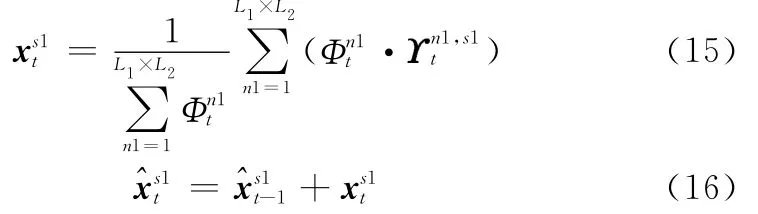

圖3為本文算法總體流程框圖。首先建立上一幀跟蹤與當前第t幀運動檢測間一級全局關聯,初步判斷目標運動狀態,如遮擋、斷裂(包括分離)及新出現等。然后根據二級全局關聯和塊間關聯確定哪些目標間發生了互遮擋,并定位發生遮擋的局部塊區域;針對不同目標運動狀態,切換跟蹤方案:如對斷裂目標基于塊質心轉移向量融合以定位目標;對于遮擋目標,將塊遮擋標志融入塊質心轉移向量融合過程以定位目標;采用遮擋自適應的塊級模板更新方法,即使目標處于在遮擋中,其局部可觀測區域仍可得到魯棒更新。最后根據目標相鄰塊間有效色彩質心距離更新尺度。

2.2 多級數據關聯和遮擋定位

處于互遮擋中的多目標經常是部分可觀測的,若能準確判斷遮擋發生的位置和區域,則可利用即使是片段的部分可觀測信息,實現目標定位和模板更新。為了提高關聯效率,采用以下數據關聯步驟,其中,λ,α1,α2,β為比例因子。

步驟1 基于中心和尺度關聯,建立s1與k間一級全局關聯,如式(6)所示。將滿足一對一關聯(對任意s1,只有唯一k與之對應,反之亦然)目標的檢測區域與上一幀跟蹤區域加權作為跟蹤結果,即;對新出現目標(不存在與k對應的s1且為空集)利用運動檢測對其初始化,并從目標出現的第2幀開始跟蹤;對消失目標(不存在與s1對應的k且映射區域中無運動像素)暫存模板,若后續連續10~15幀中均未檢測到運動像素存在,則退出跟蹤;對斷裂目標(多個k滿足∩≠Φ,k≥1),只計算目標s1的映射區域。

步驟2 對互遮擋目標(多個s1對應同一個k),利用式(7)建立上一幀跟蹤目標在當前幀映射矩形區域間二級全局關聯。若式(7)成立,則判定目標s1和s2發生互遮擋。

步驟3 對滿足式(7)的目標對(以s1,s2為例)利用式(8)在塊n1(n1=1,2,…,L1×L2)(s1的塊)和n2(n2=1, 2,…,L1×L2)(s2的塊)間進行二級塊關聯。若式(8)成立,則判定塊n1和n2發生互遮擋。

圖3 MTT算法總體流程框圖

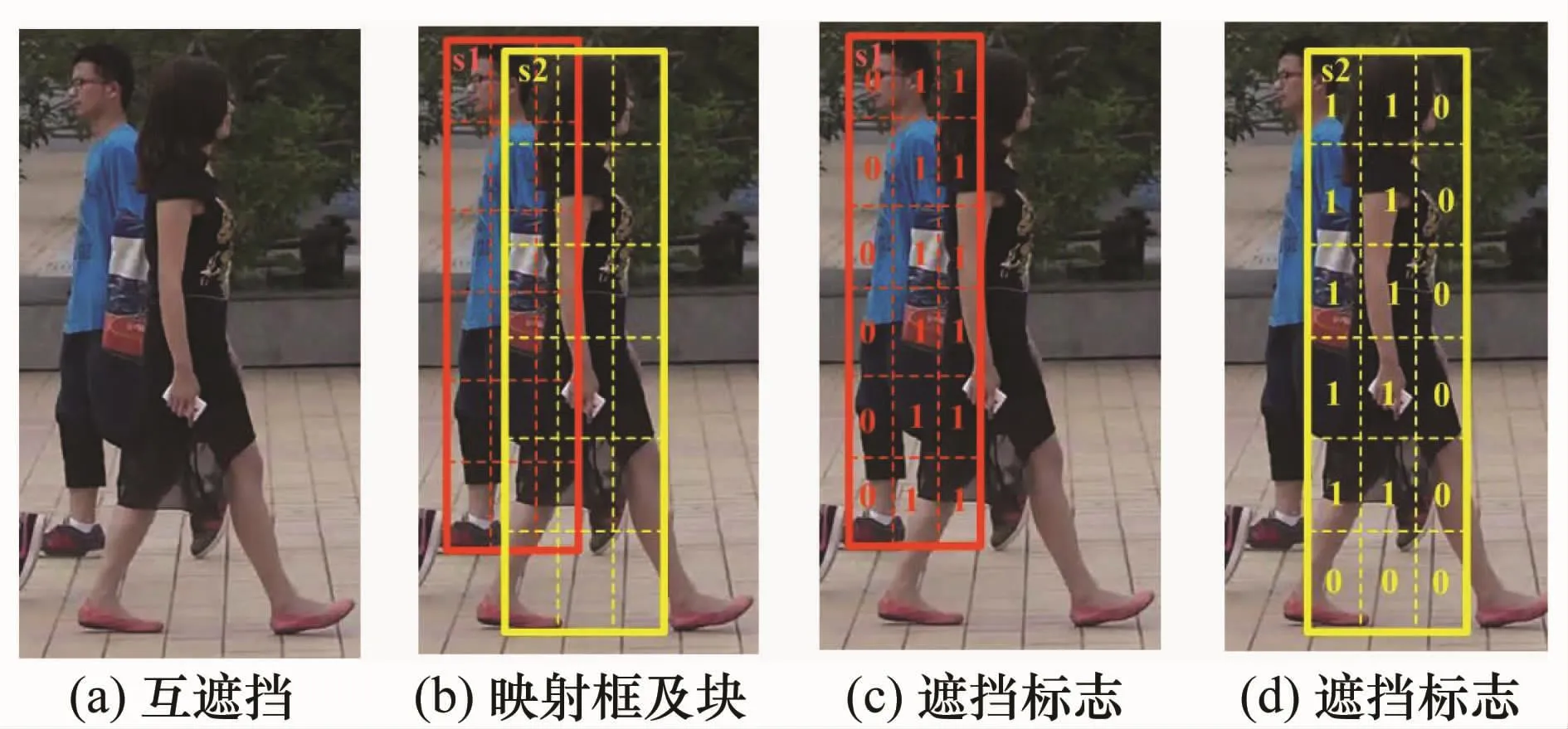

2.3 塊級模板更新

常用的全局模板更新方法,如參考模型與最佳候選模型的線性加權更新,在目標被部分遮擋時,容易在模板中引入遮擋物信息,在后續跟蹤中產生累積誤差。若根據二級塊級關聯建立塊遮擋標志矩陣,并據此指導目標模板塊級更新,則可使更新過程具有遮擋和外觀自適應性。圖4(a)為兩個互遮擋目標s1和s2,圖4(b)為映射框(實線框)和塊(虛線框)間相對關系圖。根據式(9)將滿足式(8)塊級關聯條件的塊區域標志置為“1”,否則置“0”,得到圖4(c)和圖4(d)所示遮擋標志矩陣。

圖4 塊遮擋標志矩陣

當目標滿足一對一全局關聯、為新出現或斷裂時,塊遮擋標志為“0”,因此該更新算法具有普遍適用性。

2.4 塊質心轉移向量及融合

運動像素占空比較低的塊(如邊緣輪廓塊)往往包含重要質心轉移信息,而占空比較大的塊卻可能包含無效質心轉移信息,若能根據塊包含的有效信息量合理融合各塊,則可提高目標全局質心轉移向量可靠性和目標定位精度。據此,塊質心轉移向量計算及融合步驟如下:

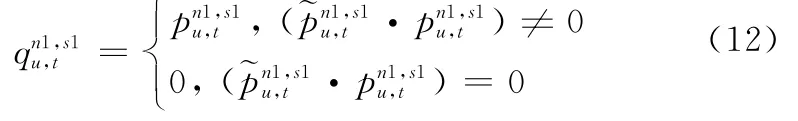

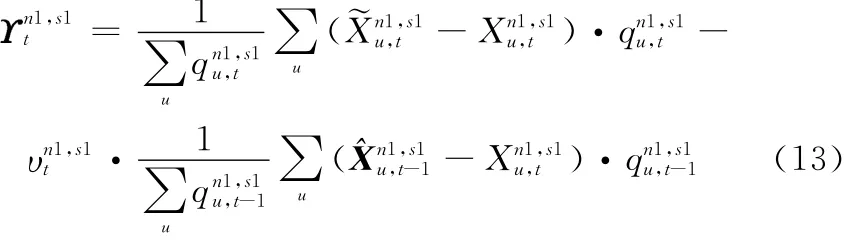

步驟1 對目標映射擴展矩形+Δ)分塊,根據式(12)選擇各塊區域與模板對應塊間共有色彩質心顯著度,以去除無效信息。Δ取2~8個像素。當塊n1未發生遮擋時(=0),根據式(13)用加權塊n 1中色彩u的質心轉移向量),獲得該塊平均質心轉移向量;當塊n1發生遮擋時(=1),由于遮擋過程中塊模板未更新,需減去上一幀中對應塊跟蹤結果相對模板的質心轉移向量以獲得。

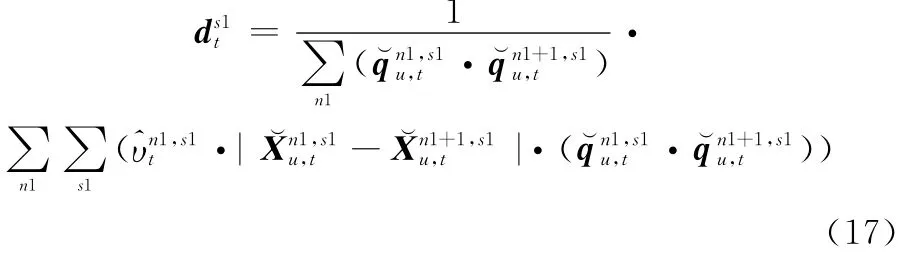

步驟3 根據式(15)融合各塊獲得目標s1的全局質心轉移向量;并利用式(16)獲得目標最優中心位置。2.5 目標尺度更新

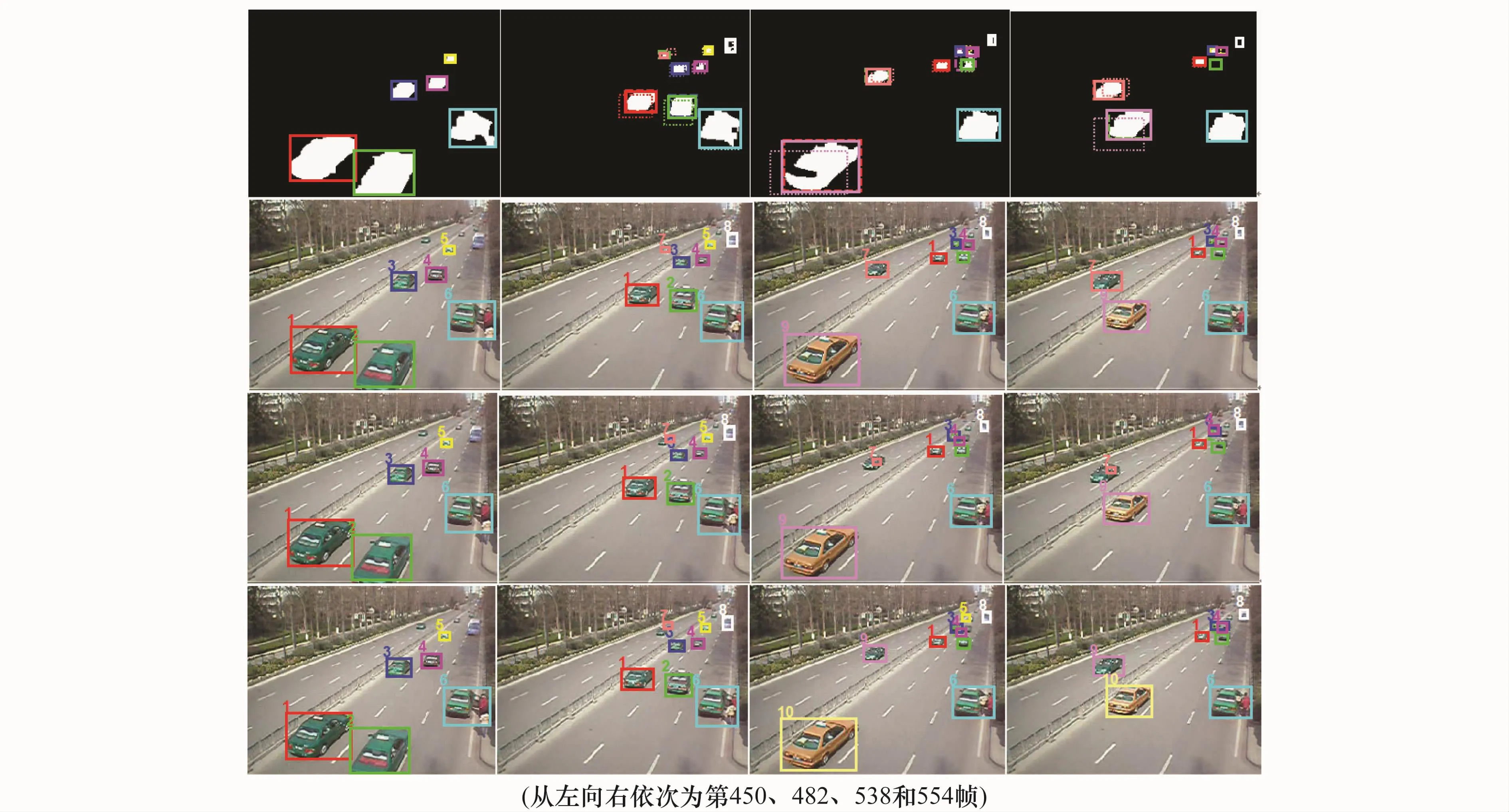

目標外觀色彩質心間距離變化與目標尺度變化密切相關。目標尺度變大時,色彩質心間距離變大,反之亦然。由于遮擋時部分色彩質心發生位置偏移,不能提供可靠尺度變化信息,因此利用未發生遮擋塊間質心距離獲得水平和垂直方目標尺度縮放參數。首先對?xst1為中心的目標映射擴展區域[+Δ]分塊,計算各塊質心模型和,并根據式(12)獲得塊有效色彩顯著度。然后根據式(17)沿水平(或垂直)方向按n1→n1+1順序計算相鄰且未發生遮擋的第n1和n1+1個塊間有效色彩質心距離;并以有效質心顯著度乘積的歸一化值作為質心距離權值,以使顯著度較大的質心具有較高的距離表決權,經各鄰塊質心距離加權得到平均質心距離;其中當即相鄰塊同時未發生遮擋時,該鄰塊間色彩質心才參與距離計算;最后根據式(18)計算目標在鄰幀間的質心距離比值得到水平(或垂直)方向目標尺度縮放參數,以自適應更新目標尺度;當未被遮擋塊的數目<2時,置=1,不更新尺度。其中,γ為遺忘因子。

3 實驗及結果分析

采用3組實驗驗證本文算法的有效性,實驗視頻中的多目標運動狀態包括互遮擋、合并-分離混合和交替、斷裂、外觀變化、新出現和消失等。實驗環境采用Matlab R2010b,2.1 GHz CPU PC;場景背景通過像素灰度歸類法[13]離線重構獲得。試驗結果分別與面積加權質心算法[9]、核掩膜MS跟蹤算法[4]進行對比。為了檢測和對比本文方法在遮擋、相似特征場景干擾情況下目標個體定位性能,將面積加權質心轉移算法、核掩膜MS算法納入本文MTT框架,利用本文背景差分方法代替文獻[4]和文獻[9]的前景檢測方法,以去除周圍背景對目標初始模板的影響,僅在目標滿足一對一全局關聯、新出現、消失時采用本文跟蹤策略,以不增加額外誤差。考慮到目標數量和跟蹤效率,取L1=2,L2=3。圖5~圖7中:實線框為目標跟蹤結果;虛線框為運動檢測連通域外接矩形,點線框為上一幀跟蹤目標在當前幀中的映射區域。相關參數設置為λ∈[0.6,0.9],α1=0.5,α2∈[0.2,0.4],β=0.8,γ∈[0.1,0.4]。

3.1 運動檢測和跟蹤實驗結果

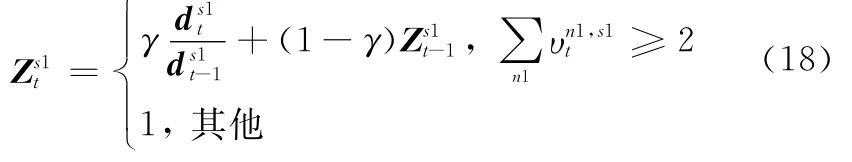

實驗1 證明初始分離→合并和分離混合→持續遮擋(部分遮擋)并伴隨相似特征干擾場景中,本文算法的跟蹤魯棒、穩定性。選取一段CAVIAR商店走廊視頻序列,分別采用本文算法、面積加權質心轉移和核掩膜MS跟蹤算法對第225幀中處于分離狀態的3個目標基于本文運動檢測算法自動起始跟蹤,結果如圖5所示。

圖5中第1~2行分別為本文方法運動檢測和跟蹤結果,第3~4行分別為面積加權質心轉移和核掩膜MS算法跟蹤結果。紅色框跟蹤的目標1進入視場后逐漸把綠色框跟蹤的目標2遮擋,藍色框跟蹤的目標3上衣色彩與背景相似;目標2頭部色彩與目標3褲子色彩相似且像素鄰近。可以看出,持續遮擋(第246幀中3個目標持續合并)、遮擋和分離混合(第267和291幀中:目標2和3持續遮擋,并與目標1分離)、斷裂(第267幀中目標3頭部和身體檢測為兩個運動區域,其中身體部分與目標2合并為紅色虛線框包圍的運動區域)并伴隨相似特征干擾場景中,本文方法具有更準確的定位性能。面積加權質心算法在目標定位時,全局質心轉移向量計算受相鄰目標相似色彩影響,引起目標2跟蹤框右偏、目標3跟蹤框下偏;核掩膜MS算法受到的影響較大,引起目標2跟蹤框嚴重偏移。

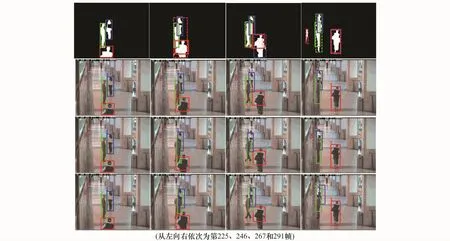

實驗2 證明初始合并→持續遮擋(包括嚴重遮擋)→分離和合并交替并伴隨相似特征干擾場景中,本文算法的跟蹤魯棒、穩定性。選取一段拍攝的校園行人視頻序列,分別采用本文算法、面積加權質心轉移和核掩膜MS算法,對第18幀中本文運動檢測自動起始的2個目標進行跟蹤,其中目標2是兩個行人的合并,跟蹤結果如圖6所示。

圖5 抗遮擋和相似特征干擾測試1

圖6 抗遮擋和相似特征干擾測試2

圖6中第1~2行和第5~6行為本文方法運動檢測和跟蹤結果,第3行和第7行為面積加權質心轉移跟蹤結果,第4行和第8行為核掩膜MS跟蹤結果。從第50幀開始,目標1和目標2發生合并;第52幀中目標2內白色和藍色上衣行人分離,同時與目標1合并、發生部分遮擋,目標2(斷裂)中藍色上衣行人單獨檢測為一個目標;第54幀中目標1與目標2再次合并,并將目標2中白色上衣行人幾乎全部遮擋;第56幀和第58幀中目標1分別與目標2中藍色上衣行人發生部分和嚴重遮擋;第60幀中目標2(斷裂)分離為兩個目標,本文方法根據塊質心轉移融合和尺度更新定位藍色上衣行人并保持標號2,白色上衣行人作為新出現目標賦予標號3;第62幀中藍色和白色上衣行人重新合并,但由于二者在前一次分離時已經具備了各自的顯著質心外觀模型,因此在之后的合并過程中,根據本文的塊質心轉移向量融合算法保持獨立跟蹤,有效提高了目標定位準確性。由于遮擋過程中目標1和目標2對向運動,黑色頭發、褲子和背包,以及手臂和腿部皮膚色彩對彼此的全局面積加權質心及核掩膜直方圖模型干擾較大,以至面積加權質心轉移和核掩膜MS算法在跟蹤過程中發生誤跟蹤和誤起始。

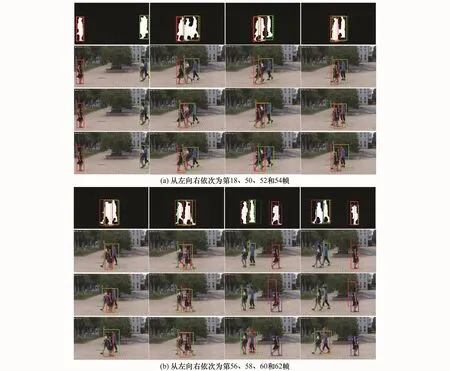

實驗3 證明目標外觀漸變、合并、新出現和消失場景中,本文算法的跟蹤魯棒、穩定性。選取一段拍攝的交通視頻序列,分別采用本文算法、面積加權質心轉移和核掩膜MS算法進行跟蹤,結果如圖7所示。第1行和第2行分別為本文算法運動檢測和跟蹤結果,第3行和第4行分別為面積加權質心轉移和核掩膜MS算法跟蹤結果。在第450幀中根據運動檢測自動起始跟蹤6個目標,對滿足一級一對一全局關聯的目標,直接融合當前檢測和上一幀跟蹤以定位目標和更新尺度。第482幀桔紅色框跟蹤的目標7,起始跟蹤后在連續幀中運動檢測面積為零,引起映射點線框滯后累積,導致核掩膜MS丟失跟蹤,該目標再次出現時被作為新目標9重新跟蹤;而本文方法和面積加權質心轉移算法憑借映射擴展區域與新檢測區域間交集,獲得了質心轉移向量,從而能保持跟蹤。目標5連續檢測失敗超過限定幀數,視為消失,取消跟蹤。隨駛離攝像頭漸遠,目標變小、模糊,一些鄰近目標檢測為合并(未遮擋),如第538幀和第554幀中目標3和目標4。由于未更新模板,面積加權質心和核掩膜MS算法發生誤跟蹤和丟失跟蹤。本文算法則可根據最近的模板定位目標,有效提高了跟蹤性能。

圖7 目標外觀漸變、合并、新出現和消失測試3

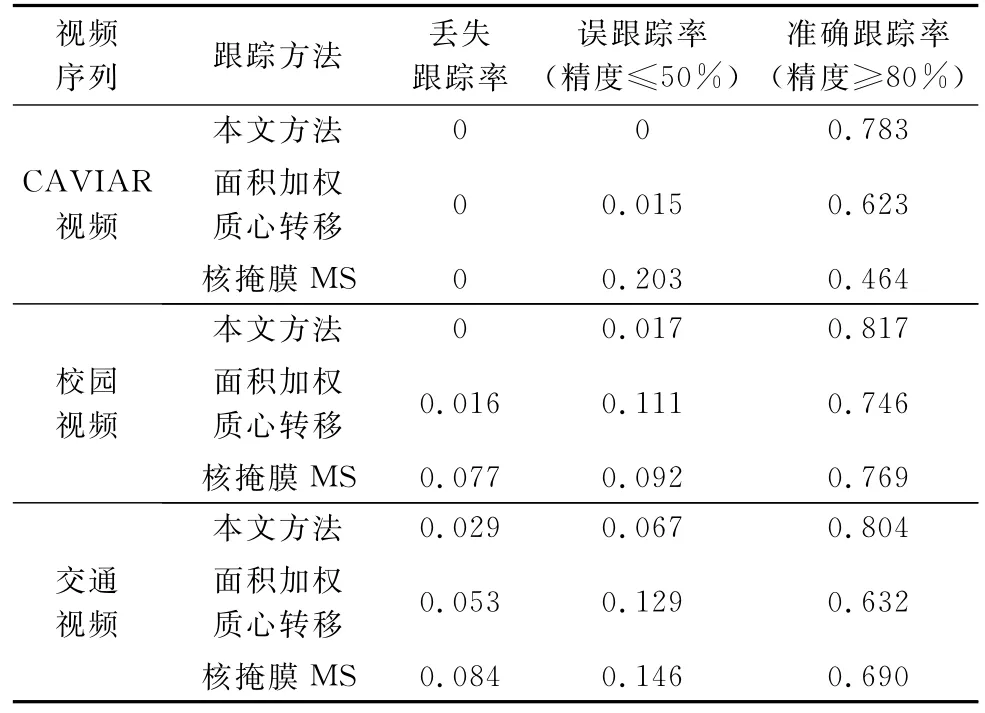

3.2 跟蹤結果統計及分析

為了對所采用算法的目標跟蹤準確度進行定量分析,表1分別給出了本文算法、面積加權質心轉移及核掩膜MS算法在跟蹤3個視頻序列時的“丟失跟蹤”“誤跟蹤”和“準確跟蹤”統計。丟失跟蹤指一個跟蹤框沒跟蹤到對應的目標;誤跟蹤指對一個目標的跟蹤精度≤50%;準確跟蹤指對一個目標的跟蹤精度≥80%。定義“跟蹤精度”為跟蹤框與對應目標實際外接矩形框的交叉面積占目標實際外接矩形框面積的百分比;表1中數據為丟失跟蹤率、誤跟蹤率和準確跟蹤率,即:丟失跟蹤、誤跟蹤和準確跟蹤目標數目分別與跟蹤過程中目標總數目的比值。從實驗數據比較可以看出,對于遮擋、相似目標干擾場景中的MTT,所提出的算法具有丟失跟蹤和誤跟蹤率低,準確跟蹤率高的特點,較面積加權質心轉移和核掩膜MS算法具有更高的跟蹤魯棒、穩定性能。這是由于面積加權質心轉移算法在候選目標區域計算全局質心時,與之發生遮擋的目標外觀相似色彩對該目標的質心坐標計算產生了較大影響,從而降低了質心轉移向量的精度,引起誤跟蹤率上升,準確跟蹤率下降;核掩膜MS算法雖然在初始模板中去除了背景影響,但直方圖固有的統計特性丟失了特征空間位置信息,而MS易陷入局部最優的特點使得該算法在多目標合并區域中依靠迭代定位目標個體的準確性下降、誤跟蹤率增加。交通視頻場景中,面積加權質心轉移和核掩膜MS算法具有較高的誤跟蹤率,主要是由于目標尺度和外觀變化過程中模板沒有更新以及個別目標運動區域檢測不完整,從而引起跟蹤滯后甚至丟失。

表1 跟蹤誤差分析

進一步優化算法,實現MTT實時跟蹤是下一步工作。與核掩膜MS算法相比,本文算法雖然在目標分塊和遮擋定位方面有一定耗時,但是一步質心轉移定位目標不需要迭代,有利于提高系統實時性。與面積加權質心轉移方法(針對單目標跟蹤,跟蹤速度可達0.001 4秒/幀)相比,本文算法針對一對一關聯目標,采用基于檢測和跟蹤融合的簡單算法;針對多目標遮擋和合并,根據目標相互間關聯關系判斷和定位遮擋,而不是單目標個體的獨立判斷,有利于進一步提高多目標的平均跟蹤速度。

4 結 論

針對制約MTT性能的互遮擋、相似特征目標干擾問題,提出一種基于分塊顯著質心描述和多級關聯的多目標全自動跟蹤方法。采用自適應閾值分割背景差分圖像以檢測運動區域和初始化新目標,提高了運動檢測算法的場景及光照變化自適應能力;目標區域分塊、塊運動像素色彩顯著質心建模、基于信息量占空比加權的塊質心轉移向量融合算法,計算效率高、抗遮擋和相似特征目標干擾能力強;利用多級數據關聯和塊質心轉移向量融合解決多目標測量-跟蹤間分配問題,能準確判別互遮擋目標及發生遮擋的塊區域,并指導塊模板自適應更新,提高目標跟蹤效率。實驗結果表明,本文算法比面積加權質心轉移算法、核掩膜MS算法具有更強跟蹤魯棒、穩定性。

[1]Yang H X,Shao L,Zheng F,et al.Recent advances and trends in visual tracking:a review[J].Neurocomputing,2011,74(18):3823-3831.

[2]Xu M,Ellis T.Tracking occluded objects using partial observation[J].Acta Automatica Sinica,2003,29(3):370-380.

[3]Choeychuen K,Kumhom P,Chamnongthai K.Robust ambiguous target handling for visual object tracking[J].International Journal Electronics and Communications,2010,64(10):960-970.

[4]Beyan C,Temizel A.Adaptive mean-shift for automated multiobject tracking[J].IET Computer Vision,2012,6(1):1-12.

[5]Cao X B,Shi Z R,Yan P K,et al.Tracking vehicles as groups in airborne videos[J].Neurocomputing,2013,99(1):38-45.

[6]Liu W J,Zhang Y J.Edge-color-histogram and Kalman flterbased real-time object tracking[J].Journal of Tsinghua University(Sci&Tech),2008,48(7):1104-1107.(劉惟錦,章毓晉.基于Kalman濾波和邊緣直方圖的實時目標跟蹤[J].清華大學學報(自然科學版),2008,48(7):1104-1107.)

[7]Zhao Z X,Yu S Q,Wu X Y,et al.A multi-target tracking algorithm using texture for real-time surveillance[C]∥Proc.of the International Conference on Robotics and Biomimetics,2009:2150-2155.

[8]Zhao Q,Tao H.A motion observable representation using color correlogram and its applications to tracking[J].Computer Vision and Image Understanding,2009,113(2):273-290.

[9]Lee S H,Kang M G.Motion tracking based on area and level set weighted centroid shifting[J].IET Computer Vision,2010,4(2):73-84.

[10]Liu Q,Tang L B,Zhao B J,et al.Improved mean shift target tracking algorithm[J].Systems Engieering and Electro-nics,2013,35(6):1318-1323.(劉晴,唐林波,趙保軍,等.改進的mean shift目標跟蹤算法[J].系統工程與電子技術,2013,35(6):1318-1323.)

[11]Hu W M,Li X,Luo W H,et al.Single and multiple object tracking using Log-Euclidean Riemannian subspace and blockdivision appearance model[J].IEEE Trans.on Pattern Analysis and Machine Intelligence,2012,34(12):2420-2440.

[12]Hou Z Q,Han C Z.A background reconstruction algorithm based on pixel intensity classification[J].Journal of Software,2005,16(9),1568-1575.(侯志強,韓崇昭.基于像素灰度歸類的背景重構算法[J].軟件學報,2005,16(9):1568-1575.)

[13]Lu H,Fei S M,Zheng J Y,et al.Moving object segmentation based on background reconstruction and shadow elimination[J].Journal of Image and Graphics,2009,14(10):2023-2028.(路紅,費樹岷,鄭建勇,等.基于背景重構和陰影消除的運動目標分割[J].中國圖象圖形學報,2009,14(10):2023 -2028.)

[14]Quan W,Chen J X,Yu N Y.Adaptive collaborative tracking for multiple targets[J].Measurement Science and Technology,2012,23(12):5407-5417.

[15]Kang J,Li Y B,Lin Y,et al.Joint probability data association algorithm based on evidence theory[J].Systems and Engineering and Electronics,2013,35(8):1620-1626.(康健,李一兵,林云,等.基于證據理論的聯合概率數據關聯算法[J].系統工程與電子技術,2013,35(8):1620-1626.)

[16]Laet T De,Bruyninckx H,Schutter J D.Shape-based online multitarget tracking and detection for targets causing multiple measurements:variational bayesian clustering and lossless data association[J].IEEE Trans.on Pattern Analysis and Machine Intelligence,2011,33(12):2477-2491.

[17]Huang C,Wu B,Nevatia R.Robust object tracking by hierarchical association of detection responses[C]∥Proc.of the 10th European Conference on Computer Vision,2008:788-801.

Block-level saliency centroid representation and multi-level association based multi-target tracking

LU Hong1,LI Hong-sheng1,FEI Shu-min2,CHENG Yong1

(1.School of Automation,Nanjing Institute of Technology,Nanjing 211167,China;2.School of Automation,Southeast University,Nanjing 210096,China)

A novel frame-work of multi-target tracking(MTT)based on block-division,saliency centroid modeling and multi-level association is presented to enhance the robustness and accuracy of tracker under occlusion among targets and disturbance caused by similar target.Self-adaptive threshold value based background difference is employed to detect motion regions.Based on block-division of target region,the block-level color saliency computed from background difference at each moving pixel,is utilized to model the centroid being with motion and color saliency.To discriminate the targets and blocks being in occlusion,the global and bolck associations are established among tracked targets and motion regions,and the block occlusion matrix is built to update the target model.The valid color and motion pixels are utilized to calculate the shifting vetor and fusion weight of each block centroid,then the global centroid shifting vetor is gained and used to locate the target.Experiments demonstrate that the proposed method is robust enough for tracking the multi-target in scenarios of occlusion,similar target disturbance and appearance change.

multi-target tracking(MTT);saliency centroid;multi-level association;block centroid shifting

TP 391 文獻標志碼:A DOI:10.3969/j.issn.1001-506X.2015.09.34

路 紅(1973-),女,副教授,博士,主要研究方向為計算機視覺、運動目標檢測和跟蹤。

E-mail:zdhxlh@njit.edu.cn

李宏勝(1966-),男,教授,博士,主要研究方向為人工智能、機器人控制技術、模式識別。

E-mail:zdhxlhs@njit.edu.cn

費樹岷(1961-),男,教授,博士,主要研究方向為計算機視覺、機器人控制技術、非線性控制系統分析與綜合。

E-mail:smfei@seu.edu.cn

程 勇(1975-),男,副教授,博士,主要研究方向為計算機視覺、運動目標檢測和跟蹤。

E-mail:chengy@njit.edu.cn

1001-506X(2015)09-2182-09

2014-10-23;

2015-03-03;網絡優先出版日期:2015-05-04。

網絡優先出版地址:http://www.cnki.net/kcms/detail/11.2422.TN.20150504.0941.002.html

國家自然科學基金(61305011);江蘇省自然科學基金(BK20131342);南京工程學院創新基金(CKJA201203,QKJB2011009)資助課題