基于人臉姿態估計的虛擬眼鏡試戴技術

(吉林大學通信工程學院,吉林 長春 130012)

(吉林大學通信工程學院,吉林 長春 130012)

為解決用戶線上眼鏡的最優選購,提出了一種基于人臉姿態估計的虛擬眼鏡試戴技術。首先采用膚色模型與形狀模型結合的算法對場景中的人臉區域進行檢測,然后根據人眼在人臉中的幾何位置關系實現人眼的精確定位;進一步利用人眼對稱性先驗知識來估計臉在三維空間中的姿態信息,即人臉與正面的偏移角度;最后,依據人眼位置和人臉姿態將眼鏡圖像融合到眼睛區域,即完成眼鏡的虛擬試戴。該方法為3D環境下客戶與商品之間虛擬視覺化的實現提供了一種可靠的技術支撐和應用思路。

姿態估計;圖像融合;人臉檢測;人眼定位

1 引言

隨著互聯網和電子商務技術的快速發展,網上購物受到更多人的青睞,越來越多商家把在線銷售作為實體店銷售的一種補充方式。傳統的網絡購物方式已滿足不了消費者的需求,最主要的問題是消費群體無法看到本人試穿的效果,導致判斷錯誤,造成不必要的經濟開銷。人們傳統購物的“真實性”理念與網絡購物的“虛幻性”特點不能得到有機的統一。而在線網絡試穿、虛擬試戴等技術的出現彌補了網絡購物的缺陷,使網絡購物更加真實化、人性化,成為近年來機器視覺研究領域的熱點[1]。如何真實、快速地實現虛擬眼鏡試戴是本文研究的主要目的。

以往的人臉檢測技術僅僅停留在判斷目標視頻序列或圖像中是否存在人臉,以及進一步確定存在人臉的位置及大小等。為了實現虛擬眼鏡試戴,僅檢測到人臉是遠遠不夠的,還需要獲取眼睛的輪廓信息。解決此類問題需要對人臉的特征點進行定位,它是研究圖像中人臉的前提。而人眼定位是眼鏡虛擬試戴的關鍵技術,大多研究方法集中于對正面人臉的檢測以及人眼定位。本文針對不同姿態人臉的估計提出了一種幾何方法,能夠準確地估計出人臉的姿態,從而實現眼鏡的虛擬試戴。

2 人臉檢測及定位

人臉檢測作為人臉信息識別中一項極為關鍵的技術,在生物信息識別、安防監測中都得到了廣泛的應用,由于其重要性和必需性,近年來在機器視覺、行為分析等課題領域得到了普遍的重視[2-3]。人臉檢測的核心內容就是找尋人臉區域區別于其他區域的特征,人臉最基本的特征有顏色特征(膚色、發色、唇色、灰度),幾何特征(輪廓、五官、對稱性),統計特征(均值、方差、相關系數、直方圖、鑲嵌圖特征)等。目前已有的人臉檢測算法有快速檢測算法和基于模板的方法[4]。前者的主要算法基于先驗知識的方法,后者的主要算法基于后驗知識學習和訓練的方法。

由于論文的目標是實現不同姿態下人臉圖像的檢測,因此算法要求對人臉的旋轉具有魯棒性,故本論文采用基于先驗知識的方法進行人臉檢測。人臉區域中,膚色是占主導地位的像素值,由于它很好的適應性,可以適應人臉各種角度的旋轉;并且不受人臉面部表情以及細節特征的改變而改變,具有很好的穩定性,所以本論文選擇膚色模型來進行人臉檢測。考慮到RGB色彩空間內人臉膚色受光照影響嚴重,并且膚色與非膚色的重疊性較大[6-7],而YIQ顏色空間利用人眼的色分能力,使人眼對不同的色彩具有很明顯的區分度;并且YIQ色彩空間在處理彩色信息時冗余度較少。綜上,本論文選擇基于YIQ色彩空間建立膚色模型進行人臉檢測。

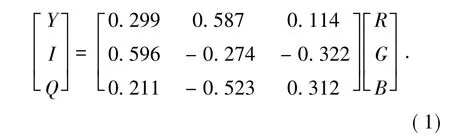

在YIQ彩色模型中,Y是指顏色的亮度,而I和Q是指色調,用于描述圖像色彩的飽和度。RGB與YIQ之間的對應關系如式(1):

由此定義膚色模型:對于彩色圖像中的像素點p,將其從RGB模型變換到YIQ模型,如果滿足不等式(2),則點p為膚色像素,反之為非膚色像素[5]。

式中,Ip和Qp分別代表p點對應的I分量和Q分量,r和q分別代表I分量和Q分量的范圍,m代表I分量的均值。

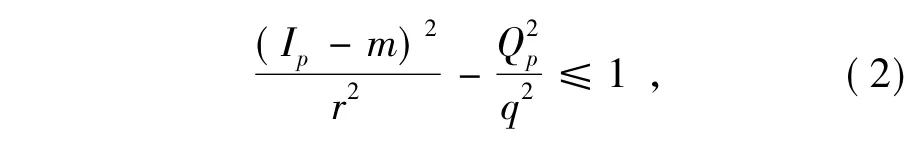

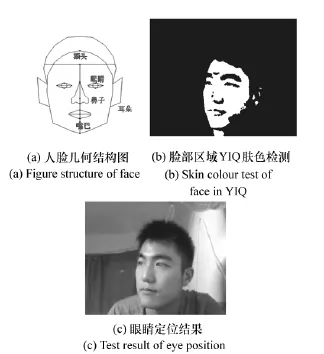

以I代表像素分量,選擇的YIQ空間的膚色范圍為(5,150),對圖1(a)運行結果如圖1(b)所示。然后根據面積約束剔除分割出的小目標區域;最后將潛在所有的連通區域提取出來,計算其橫向對稱度、縱向對稱度、橢圓度等特征,融合3個特征計算每個區域的得分,取得分最大的區域為人臉區域,從而得到人臉的精確定位,效果如圖1(c)所示。

圖1 人臉檢測及定位Fig.1 Face detection and location

3 人臉姿態估計

在人機交互、行為分析等領域人臉檢測已經不僅僅滿足于檢測出人臉區域,姿態估計得到了越來越多的重視。人臉姿態估計是對目標視頻序列或圖像中獲取人臉在三維坐標系空間中的角度信息。要判斷一幅人臉圖像的角度信息,就需要確定圖像中人臉是否在某一個方向上存在著偏轉。而將高維空間上一幅復雜人臉圖像的數據與姿態角度概念建立聯系則需要進行一系列的處理。因此提出了一種幾何方法對人臉姿態進行準確估計。

3.1 基于形狀和空間位置關系約束的人眼定位

人眼定位是人臉檢測中的關鍵步驟,對姿態估計效果影響很大。多數人臉檢測中的第一步就是實現人眼定位,精確的人眼定位為人臉特征值的提取以及人臉信息分析奠定了堅實的基礎。本文在進行人眼定位之前,對待檢測人眼區域進行平滑濾波操作[6,8]。現有的基于人臉幾何特征進行人眼定位的算法僅考慮人臉的幾何約束特征,忽略了圖像尺寸大小對于定位的影響。故本文針對這點不足采用一種圖像歸一化的算法,經實驗可知此算法對不同尺寸的圖像以及不同大小的人眼來說具有普遍適用性。基于形狀和空間位置關系約束的人眼定位方法,對于不同尺寸的圖像,其約束關系包括眼睛黑色區域面積,眼睛黑色區域的像素個數,眼睛黑色區域下方一定區域不存在其他黑色區域等。

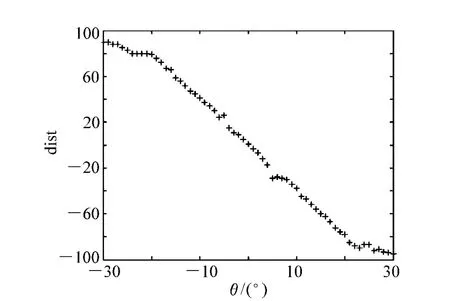

通常,人眼的初定位是根據眼睛在二值化人臉圖像中的幾何位置確定的,判定通常基于以下幾條人臉幾何約束條件:

(1)人雙眼中心距的限定范圍:人的雙眼中心距離不是一個隨意的值,而是在某一確定的距離范圍內波動:就一幅尺寸為160 pixel×120 pixel的圖像來說,正常的人雙眼距離應在像素個數區間(20,50)內;

(2)人眼下方一定范圍內不允許出現其他黑色區域:這意味著人雙眼下方不允許存在其他人體器官,因此對應于人臉二值化圖像中就是不允許出現其他黑色區域;

(3)眼睛黑色區域像素值個數范圍確定:正常的人眼大小大致活動在一個固定的范圍,故在對應的二值化人臉圖像中眼睛黑色區域的大小也應在某個確定范圍內波動,過大的黑色區域不可能是人眼;

圖2 人眼定位Fig.2 Eye location

(4)人眼黑色區域外接矩形的形狀要求寬大于或者等于高:從生理學可知,由于人眼的特定形狀是橢圓或近似圓形,故其外接矩形的形狀必定是寬大于或者等于高,所以高遠大于寬的外接矩形對應的黑色區域不可能是眼塊。

根據圖1(c)臉的定位結果,在人臉區域使用YIQ膚色模型進一步膚色檢測,可知:人臉中的眉毛、眼睛全都不屬于膚色范圍,所以在二值化圖像中以黑洞的形式存在。然后結合人臉的幾何分布結構,找到額頭所在的位置,向下偏移一定的距離尋找對稱橢圓區域即可定位到眼睛。如圖2所示,為人眼定位各部分結果圖。

經實驗測試分析,經過以上的人眼約束條件,人眼檢測的準確率高達90%。

3.2 人臉姿態估計的數學描述

假設不同姿態的人臉圖像已經被定位,并將圖像縮放為寬為W高為H。這些像素點的灰度值組成了一個W×H=p維的圖像向量x,x所在的空間被稱為外觀空間Rp。因為人臉在旋轉過程中有3個自由度:左右擺動、上下擺動、圖像內旋轉,因此定義自由度為向量y,而y所在的空間被稱為姿態空間Rq,q≤3。人臉外觀圖像的均值向量為xm,相應的姿態均值向量為ym。經過均值歸一化的人臉圖像樣本集合為X={x1,…,xN},相應的姿態樣本集合為Y={y1,…,yN}。其中=xi-xm,=yi-ym,N為樣本總數[10-11]。

因此,對于一個處于任意姿態的人臉樣本t來說,姿態估計的任務就是要計算出自由度向量y的各個參數值,實現虛擬試戴。為了實現準確且逼真的試戴效果,本論文僅考慮圖像內的旋轉這個自由度。

3.3 基于人眼對稱性先驗的人臉姿態估計

姿態估計是人臉跟蹤、人臉三維模型初始化等應用中至關重要的環節。已存在的姿態估計算法可以分為以下三類:(1)基于幾何形狀分析:這類方法在建立的人臉模型的基礎上將模型與新輸入的人臉圖像建立對應關系。由于人臉幾何結構不考慮不同姿態人臉的可感知差異,如鼻子的偏移和人臉的對稱性等,就可以利用精確的人臉特征點定位方法來進行人臉姿態估計;(2)基于流形學習的方法:因為人臉頭部運動具有3個自由度,將同一目標人物的不同姿態在高維圖像空間中構成一個低維流形,進而找到人臉流形在低維空間的嵌入,從而估計出人臉姿態;(3)基于分類器的方法:將姿態估計同化為一個模式分類識別的問題,利用分類器將不同姿態進行分類、學習來對人臉進行姿態估計[9,12]。

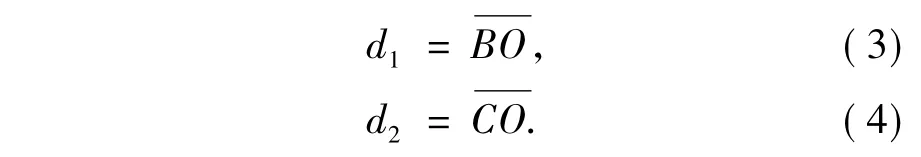

本文在基于形狀的幾何分析方法基礎上,提出了一種新的基于人臉對稱性先驗的姿態估計方法。人臉的形狀近似于橢圓形,當人臉只繞著垂直方向左右旋轉時,可以近似看成一個剛體,橢圓的一致性保持良好。因此,采用人眼對稱性先驗的方法進行人臉姿態估計,建立如圖3所示的橢圓模型。

在圖3(a)中,點B,C分別表示左眼,右眼所在矩形中的中心點,經過BC的直線交橢圓于A,D兩點,做線段BC的垂直平分線,交橢圓于E,F兩點,直線EF與直線AD相交于點O。

令:

圖3 人臉橢圓Fig.3 Elliptical model of face

當人臉繞著EF軸向左轉動時,d1逐漸增大,d2逐漸減小;同理,當人臉繞著EF軸向右轉動時,d1逐漸減少,d2逐漸增大。令θ表示人臉繞著EF直線的轉動角度,如果用大量樣本建立d1,d2與姿態參數θ之間的對應關系,即可根據未知圖像中人臉的位置參數估計出人臉的姿態。由于考慮到眼鏡試戴的實際效果,所以轉動一定的角度即可,過大的角度會導致試戴效果失真。假設正面的人臉對應的角度為零度,向左偏移表示負方向,右偏表示為正方向。圖4為人臉在不同角度下的投影。

通過分析不同的人臉圖像,發現對于所有正面的人臉圖像,兩只眼睛的中心點與臉的中位線之間的距離相等,如圖5所示。

圖4 不同姿態的人眼定位效果圖Fig.4 Eye location rendering of different attitude angle

圖5 實際人臉結構示意圖Fig.5 Diagram of actual face structure

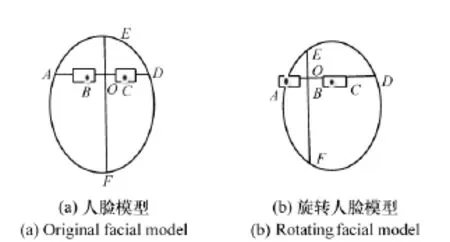

在圖5中,直線L為臉的中位線,A為左眼中心點,B為右眼中心點。設點A到直線L的距離為dist1,B到直線L的距離為dist2,定義兩眼到中位線距離差dist=dist1-dist2。對于正面人臉圖像θ=0一般有dist≈0,理想情況下滿足dist=0;當臉往左邊偏轉時θ<0,則dist>0;往右偏轉時θ>0,則有dist<0。因此,人臉偏移角度θ可表示為θ=f(dist)。函數f(x)一般為非線性函數,為了模擬出該函數,采集到不同角度的人臉樣本,其角度和距離差的關系曲線如圖6所示。

從上圖6可以看出,人臉偏移角度θ與距離差dist呈現出很強的線性關系,通過最小二乘擬合得到如下關系函數:θ=(1.279-dist)/3.577。依據這種線性關系,準確定位出人眼的位置則快速高效的得到人臉姿態的估計,從而有助于完成最終的眼鏡試戴任務。

圖6 距離差與角度的關系圖Fig.6 Diagram of distance difference vs.angle

4 摳圖處理與實驗分析

數字圖像摳圖問題為數字圖像處理中比較典型的一類問題,分為藍色背景下的藍屏摳圖以及一般背景下的圖像摳圖。其中,一般背景摳圖通常需要Trimap模板的輸入,用來初步指定一些已知的前景、背景和未知區域。然而,由于摳圖問題的欠約束性,以及假設方式的局限性,通常的摳圖方法會與真實值存在較大偏差,這也嚴重影響了圖像的最終合成效果。同時,目前摳圖領域也缺乏標準且有效的像素級評價系統。本文將問題進行了簡化,避免復雜的背景,將眼鏡的背景設定為純色,與鏡框和鏡片不沖突的顏色。因此,根據定位到的眼睛所在的位置以及估計出的人臉姿態直接將眼鏡圖像融合到眼睛所在的區域即可完成試戴任務。

實驗用到的眼鏡圖像是通過OpenGL實現-90°~90°偏轉范圍內的任意姿態的眼鏡圖像,滿足實驗要求。

本實驗環境為:CPU為Intel Core i5,M450,2.4GHz,內存為2.00GB的Win7中MATLAB2013A,每幅圖片的平均處理時間為1.1s;而將相同的實驗圖采用Adaboost模型和ANN模型進行處理,處理時間分別為1.5和1.0s。

對比于Adaboost算法來說,本文的算法在檢測時間上有很大的優勢,可以實現更快速有效的檢測;對比與ANN模型算法來說,雖說檢測時間略慢于該算法,但是ANN模型算法是采用分類器學習的方法進行人臉檢測,該算法雖然檢測速度快,但是訓練速度過慢,所以對于網絡大數據情況下實現快速有效的檢測是很難的。綜上,本文的算法在有效性和快速性上都有更大的優勢。

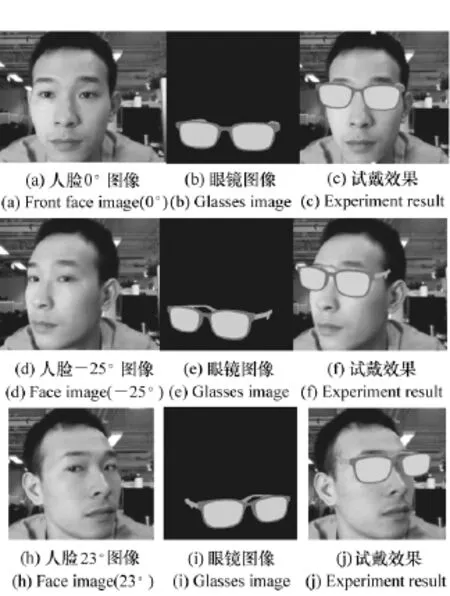

對于眼鏡虛擬試戴問題,源圖像為眼鏡圖像庫中任意選擇的圖像,目標圖像為用戶提供的正面人臉圖像,其試戴效果如圖7所示。

圖7 男士實驗結果Fig.7 Experiment results for man

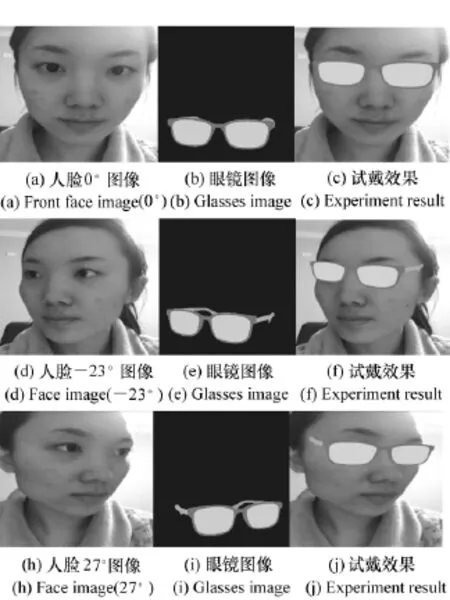

如圖7和圖8所示,本論文分別選取了兩位不同的目標對象進行實驗,針對每個目標對象扭轉角度的不同,共對5個不同旋轉角度(分別為:0°、-25°、23°、-23°、27°)的人臉進行檢測以及選取相對應的眼鏡,進行融合得到最終的試戴效果圖。通過不同姿態試戴效果的對比,可以看出本文提出的算法試戴效果很好地保留了眼鏡的顏色,且與目標圖像融合自然,試戴效果逼真。

圖8 女士實驗結果Fig.8 Experiment results for lady

5 結論

本文對人臉檢測、定位以及人臉姿態估計進行了研究,提出了基于姿態估計的眼鏡虛擬試戴技術。實驗結果表明,該算法速度快,在成像距離一定的情況下,檢測效率高,試戴的效果自然逼真,具有很好的實用性;但本文依靠的膚色模型目前只能處理黃種人膚色。今后的重點研究工作將會提升人臉的檢測率,提高人臉特征點的精度和魯棒性。圖像摳圖和圖像合成最早出現在影視作品中,如何生動逼真自然的融合圖像成為研究的目標。目前,虛擬試戴、試穿的研究甚少,但隨著科技的不斷發展,其必將具有良好的應用前景。

[1]ZHANG Z,TONG T.Research on computer aided glasses selection and virtual try on[J].Computer Engineering and De-sign,2007,30:45-46.

[2]HJELMAS E.Face detection:a survey[J].Computer Vision and Image Understanding,2001,83:236-274.

[3]HUANG L,JIANG H,HUO G.Face recognition based on multi-scale feature extraction and multiple regression analysis[J].Optics&Optoelectronic Technology,2012,6:90-93.

[4]SHEN L,LANG B,ZHU M.Face recognition method based on artificial neural network[J].Chinese J.Liquid Crystal and Displays,2011,6:836-840.

[5]QUAN X,ZHANG L.Research on the face detection based on skin color model and eye location[J].Science Technology and Engineering,2010,31:7822-7824+7829.

[6]JI Q,HU R.3D Face pose estimation and tracking from a monocular camera[J].Image and Vision Computing,2002,20(7):499-511.

[7]NIE X,TAN Z,GUO J.Face illumination compensation based on wavelet transform[J].Optics and Precision Engineering.2008,1:150-155.

[8]HUANG B,TANG J.Novel method of eye detection in facial images[J].Chinese J.Liquid Crystal and Displays,2009,2:278-282.

[9]LIU M,GUO D,MA J,et al..Face pose estimation based on elliptical model and neural network[J].J.Jilin University(Science Edition),2008,7-11.

[10]LI J,YANG J.Eyeglasses try-on based on improved poisson equation[C].2011 International Conference Multimedia Technology.Hangzhou,China,2011:3058-3061.

[11]BLACK M J,YACOOB Y.Tracking and recognizing rigid and non2rigid facial motions using local parametric models of image motion[C].Fifth International Conference on Computer Vision.Cambridge,MA.USA,IEEE.1995:3742381.

[12]SCHWERDT K,CROWLEY J L.Robust face tracking using color[C].Fourth IEEE International Conference on Automatic Face and Gesture Recognition.Grenoble,Frane,2000:902-905.

盧 洋(1991—),女,河南焦作人,碩士研究生,2010年于吉林大學獲得學士學位,主要從事圖像視頻處理方面的研究。E-mail:407851137@qq.com

王世剛(1961—),男,吉林長春人,教授,博士生導師,1983年于東北大學獲得學士學位,1997年于吉林工業大學獲得碩士學位,2001年于吉林大學獲得博士學位,主要從事圖像與視頻信號智能處理方面的研究。E-mail:wangshigang@vip.sina.com

趙文婷(1989—),女,吉林省吉林市人,博士研究生,2012年于吉林大學獲得學士學位,主要從事視頻圖像處理方面的研究。E-mail:985817166@qq.com

武 偉(1982—),女,吉林長春人,博士研究生,2005年、2009年于長春工業大學分別獲得學士、碩士學位,主要從事立體視頻方面的研究。E-mail:114188246@qq.com

基于人臉姿態估計的虛擬眼鏡試戴技術

盧 洋,王世剛*,趙文婷,武 偉

Technology of virtual eyeglasses try-on system based on face pose estimation

LU Yang,WANG Shi-gang*,ZHAO Wen-ting,WU Wei

(College of Communication Engineering,Jilin University,Changchun 130012,China)

*Corresponding author,E-mail:wangshigang@vip.sina.com

In this paper,we present a new virtual eyeglasses try-on system based on face pose estimation,and provides technical support for the realization of the user online optimal commodity purchase.Firstly,we use color model combining shape model for face detection in the scene.Then,we use face geometry relationship to achieve precise positioning of the human eye.We furtherly estimate the face pose information based on a priori knowledge of the symmetrical of eyes in the face region,which is the deviation angle of face with the front side.Finally,we integrate the images of glasses to face and achieve the virtual eyeglasses try-on system according to calculating the angle and location information of eyes.This method provides a reliable technical support and application for the future implementation of virtual visualization between customers and goods in 3D environment.

pose estimation;image fusion;face detection;eye location

教育部博士點基金資助項目(No.20120061110091)

2095-1531(2015)04-0582-07

TP391.4 文獻標識碼:A doi:10.3788/CO.20150804.0582

2015-03-06;

2015-04-20