404 Not Found

404 Not Found

基于動態匹配模型的駕駛人嘴部行為識別與分級預警*

付 銳,程文冬,張名芳,袁 偉,劉卓凡,郭艷君

(1.長安大學,汽車運輸保障技術交通行業重點實驗室,西安 710064; 2.長安大學汽車學院,西安 710064;3.西安工業大學機電工程學院,西安 710032)

?

2015188

基于動態匹配模型的駕駛人嘴部行為識別與分級預警*

付 銳1,程文冬2,3,張名芳2,袁 偉2,劉卓凡2,郭艷君2

(1.長安大學,汽車運輸保障技術交通行業重點實驗室,西安 710064; 2.長安大學汽車學院,西安 710064;3.西安工業大學機電工程學院,西安 710032)

鑒于嘴部行為能夠反映出駕駛人不同的精神狀態,本文中提出了一種基于機器視覺的嘴部行為識別與精神狀態預警方法。首先采用改進的高斯混合模型進行光照自適應的唇色分割。然后在嘴唇區域內建立了基于灰度能量角點的嘴唇動態匹配模型,用于描述嘴部特征并提取動作參數。最終建立了嘴部行為的判別模式,實現了駕駛人精神狀態的分級預警。實驗結果表明,動態匹配模型具有較高的嘴部特征匹配精度和動作適應能力。算法能夠有效檢測“閉嘴”、“說話”和“打哈欠”行為,分心預警和疲勞預警的監測精度分別為85.8%和92.9%。

嘴部行為;高斯混合模型;能量角點;動態匹配模型;分級預警

前言

基于機器視覺的駕駛人面部行為與狀態識別已成為安全輔助駕駛研究的重要內容[1]。此項研究多集中于眼睛運動與頭部姿態識別,例如監測眼睛開啟度與眨眼頻率,結合PERCLOS等法則進行疲勞預警[2];建立眼睛運動模型并結合頭部姿態來估計駕駛人的關注區域和駕駛意圖等[3]。事實上,嘴部行為特征也能夠反映駕駛人的多種精神狀態,例如文獻[4]中研究發現說話行為會削減駕駛人對交通環境的感知能力以及規避風險的反應速度;文獻[5]中認為打哈欠直接反映出駕駛人處于疲勞狀態,并將其作為重要的判別指標引入疲勞駕駛監測。針對駕駛人嘴部行為的圖像識別與安全預警逐漸成為安全輔助駕駛技術的熱點課題,對提高車輛主動安全具有重要意義。

嘴部區域具有姿態的不確定性、行為表征的隱匿性、行為習慣的個體差異性,駕駛人嘴部特征識別與行為理解成為異常精神狀態預警的瓶頸問題。嘴唇特征識別方法主要分為兩類:一是基于形狀結構規則的機器學習方法,例如Adaboost算法[6]、主動表觀模型[7](AAM)等,此類方法將嘴唇重要特征表達為不相關低維向量的特征信息并抽象為數學模型,運用控制點和曲線擬合逼近嘴部形態,此類方法對光照變化的魯棒性很強,但對駕駛人隨機性頭部姿態與嘴唇運動的適應能力較差,而且正負樣本的訓練數量大;第二類為基于像素的特征識別方法,如唇色概率估計[8]、顯著邊緣檢測[9]、基于梯度的特征角點檢測[10]等,再通過合理的匹配模板還原嘴部特征,此類方法對頭部姿態與嘴唇動作的適應性強,可獲取豐富的特征信息,缺點是對光照較為敏感,在復雜環境中的自適應收斂能力較差。

基于上述分析,本文中提出一種基于動態匹配模型的駕駛人嘴部特征識別方法,確保嘴唇檢測的光照魯棒性與動作適應性,在此基礎上建立特征模型與嘴部行為的映射模型,實現駕駛人異常精神狀態預警。

1 總體方案

本文的整體方案如圖1所示。系統通過儀表盤內的CCD攝像頭實時采集駕駛人面部圖像,根據面部特征(皮膚、嘴唇和頭發等)的色度聚類特性,運用改進的高斯混合模型實現面部膚色識別與自適應唇色分割。隨后在嘴唇粗區域內建立基于灰度能量角點的嘴唇動態匹配模型,提取出能夠映射“閉嘴”、“說話”和“打哈欠”3類動作的隱匿性行為參數指標。通過嘴部行為的模式識別建立駕駛人異常精神狀態的分級預警,用于監測駕駛人的正常駕駛狀態、分心狀態與疲勞狀態。

2 自適應唇色分割

監控圖像中嘴唇目標較小,在全局范圍內直接檢測嘴唇的難度較大。剔除頭發、駕駛室背景等無意義的信息,降低動態光照的干擾是嘴唇準確定位的關鍵。Adaboost和AAM等基于形狀規則與樣本學習的方法具有強大的目標識別能力,但由于駕駛人面部具有多尺度、多姿態、多干擾等特點,當人臉與嘴唇的形狀規則跳出了訓練樣本的表達范圍時,檢測容易失效。而基于色度信息與生理先驗知識的面部特征識別方法對頭部姿態、部分遮擋等因素的容忍度很高,更適合駕駛人面部建模。本文中提出一種基于高斯混合模型(Gaussian mixture model, GMM)[11]的“全局—膚色—唇色”分層局部搜索方法來實現嘴唇定位。

2.1 膚色與唇色估計

RGB圖像各分量中均含有亮度信息,易受到環境中光照的干擾。而HSI色彩空間[12]能夠很好地分離出光照不敏感分量,適用于復雜環境下的色度分割。如圖2所示,在H-S二維色度平面上,皮膚和嘴唇各自具有顯著的聚類特性,可采用GMM來進行顏色概率估計。HSI-GMM算法流程如圖3所示。為實現精準估計,面部像素的訓練樣本分為4類:皮膚、嘴唇、低灰度區域(頭發、眼睛、鼻孔)與駕駛室背景。各類樣本的H和S向量作為特征訓練集,再運用高斯混合參數模型估計各類顏色概率密度:

(1)

2.2 自適應唇色建模

光照變化容易致使嘴唇色度與飽和度的聚類分布發生漂移和畸變,傳統GMM唇色估計方法易導致漏檢、誤檢等問題,因此提升GMM光照自適應能力成為嘴唇穩定分割的關鍵。受到文獻[13]和文獻[14]的啟發,本文中針對2.1節中的μlip與Σlip進行GMM自適應參數迭代(adaptive parameter iteration, GMM-API),當唇色在H-S色度平面上發生漂移時,計算漂移狀態下的μlip與Σlip。按照μ±Σ原則建立初始矩形Rec1,中心為O1(H,S),如圖4所示。設矩形Rec1內像素的質心為O1′(H,S)。由于O1(H,S)與O1′(H,S)并不重合,此時將矩形沿著O1至O1′方向進行移動,移動后的矩形中心為O2。移動矢量為

(2)

3 嘴唇動態匹配模型

3.1 嘴唇特征點集

嘴唇特征模型是在關鍵特征點的基礎上建立的,本文中提出了嘴唇特征點集Clip的概念:

Clip={Pleft,Pright,Pupper,Plower}

(3)

式中:Pleft和Pright是左右嘴角點,由兩點距離確定嘴唇的寬度Dwidth;Pupper和Plower分別表示上嘴唇邊緣的最高點和下嘴唇邊緣的最低點,兩點距離定義了嘴唇的張開程度。嘴唇邊緣曲線可以由點集Clip進行擬合。

3.2 基于能量信息的角點探測

當前多數文獻根據全局灰度信息以及邊緣特征進行嘴唇區域的特征匹配。雖然嘴唇具有較強的色度聚類性,但是在復雜光照環境下,嘴唇與皮膚的紋理特征并不顯著,單純依靠邊緣信息進行嘴唇特征匹配并不理想。事實上,嘴唇區域還具有較明顯的灰度能量信息。圖6表示嘴唇區域灰度能量的3D分布,能量角點則位于局部能量域的最大值處。如果建立合理的局部窗口函數進行能量域的梯度檢測,則嘴部特征可通過能量角點的形式進行描述。與邊緣檢測方法相比,該方法能夠更充分地提取嘴唇紋理的梯度特征,所提取的嘴唇信息更為充分。

一般認為嘴唇與膚色區域的紅色分量比較接近,但測試發現綠色分量更能突顯嘴唇的灰度能量信息。本文中首先在Green通道中采用多尺度Retinex法[15]進行嘴唇粗區域的灰度增強,在此基礎上采用響應函數R[16]來度量像素的灰度能量:

R=det(M)-kTrace2(M)

(4)

式中:k為權重系數;Trace為矩陣的跡,表示矩陣主對角線上所有元素之和;G為梯度積分的高斯平滑量;ω為高斯平滑函數;Ix和Iy表示Green通道中x與y方向的灰度梯度。當灰度能量R大于設定閾值fT時,則認為存在能量角點Pcorner:

(5)

角點的數量與嘴唇特征匹配效率密切相關。角點過少,會丟失有用的嘴部特征,帶來較大的匹配誤差;角點過多,則會降低匹配實時性。經過實驗測試,取G=2.5~2.8,k=0.05,fT=800,將角點數量控制在40個以內,能夠較好地實現匹配速度和精度上的平衡。

3.3 特征角點匹配

嘴唇區域的能量角點整體上比較雜亂,因此需要根據生理先驗知識進行角點篩選與匹配,獲取圖像中最具表征意義的特征角點。匹配算法共分為3步。

步驟1:左右嘴角匹配。在含有q個角點的嘴部區域中,求得角點集質心坐標O(xO,yO):

(6)

求得質心O與任意一角點i的距離DOi。由于嘴唇的形狀近似于紡錘,產生最大距離的角點必然對應著左嘴角或右嘴角,若將該點記作P1(x1,y1),則

算例3的電動汽車SOC變化和調制功率變化曲線如圖11所示。由圖11可知,與算例2相比,算例3的電動汽車在設置的光伏功率波動區間,即在12:00~14:00之間開始放電,SOC下降較快,電動汽車的調制功率在12:00~14:00之間為正,以此來改善母線電壓質量。

(7)

同理,距離P1最遠角點的必為另一個嘴角P2(x2,y2),P1與P2即為圖7中的Pleft與Pright。

步驟2:上下嘴唇特征點匹配。連接點Pleft與點Pright得直線L,其長度為嘴唇的寬度Dwidth。在其余的q-2個角點中,任一角點n與L的距離為

n=1,2,…,q-2

(8)

由于角點被直線L分割為上側和下側兩部分,則Dn集被分為Dupper和Dlower,見式(9)和式(10)。在Dupper集合中篩選出兩個最大值所對應的角點,求其平均坐標作為上嘴唇特征點Pupper。同理,可定位下嘴唇特征點Plower。Pupper與Plower沿垂直于直線L方向上的距離Dheight代表嘴唇張開的程度。

(9)

(10)

步驟3:上下嘴唇邊緣擬合。由于光照條件、圖像分辨率與設備抑噪性能的限制,運用常規邊緣算子直接獲取的嘴唇輪廓并不完整。本文中在獲得特征點集Clip的基礎上,對上下嘴唇邊緣進行NURBS[17]三次曲線擬合。NURBS曲線C表達式為

(11)

式中:ωi是對應特征點集Clip-i的權重因子,通常ωi≥0;Ni,k(t)表示規范NURBS曲線的基函數。圖7中的兩條白色曲線即為NURBS擬合輪廓。

4 嘴部行為模式識別與預警方法

4.1 預警方案

4.2 “打哈欠”行為判據

相對于“說話”和“閉嘴”狀態,打哈欠時嘴唇的張開程度更大,持續時間更長,根據這些特征運用嘴唇開啟度φ進行判別:

(12)

式中:Dhi為上一節定義的上下嘴唇特征角點的像素距離;Dh0為閉嘴時上下嘴唇特征角點的距離初始值。本文中將初始3s緩存累積圖像中最小的25%個Dhi的平均值作為Dh0。若φ超過開啟度閾值φth,則駕駛人可能存在“打哈欠”行為。考慮到說話時有可能出現開啟度過大而誤判為“打哈欠”,本文中引入時間條件進行二次判別:在φ≥φth的條件下開始計算幀數,若超過時間閾值Tth便判定為“打哈欠”,否則認定為“其它”狀態。經實驗統計,定義φth=1.5,Tth=2s。

4.3 “說話”行為判據

說話時一部分嘴唇姿態近似于“閉嘴”,因此開啟度φ并不能作為識別“說話”的判據。但相對于“閉嘴”狀態,說話時開啟度φ更具有時序上的波動特性,因此,本文中采用樣本方差S2進行評價:

(13)

5 實驗結果分析

圖像采集裝置安裝在儀表盤內,約25°仰視拍攝駕駛人面部,圖像大小為1080×720,幀率為20fps。視頻分別在晴天、陰天、樹木與建筑遮擋的道路環境下進行采集,確保樣本光照條件的多樣性,以充分驗證唇色分割的光照魯棒性與動態匹配模型的有效性。測試對象為18名駕駛人(12男6女),在安全駕駛的前提下完成嘴部動作,獲得視頻樣本數量240組(共計358 032幀),其中“閉嘴”、“說話”和“打哈欠”行為的樣本分別為77組、92組和71組。

5.1 唇色分割的魯棒性實驗

針對不同光照與嘴部動作的圖像(共計9 215幀)進行唇色分割實驗。圖9為兩組唇色分割結果,第一組測試的光照均勻,第二組的光照變動頻繁。圖中A,B和C輪廓分別是由GMM-API,GMM和HSI恒定閾值3種算法實現的嘴唇分割,對比可見GMM-API算法對嘴唇輪廓的還原性更好。圖10為光照頻繁變動環境下的唇色面積檢測結果。GMM與HSI恒定閾值法檢測結果的波動性很大,而GMM-API具有自適應收斂特性,能有效克服光照變化引起的唇色漂移,分割的唇色面積更為穩定,這是本文中嘴部行為識別與預警準確率較高的內在原因之一。

5.2 特征點匹配實驗

(14)

表1 匹配誤差i,e與匹配精確率ξi

5.3 嘴部行為模式識別與預警實驗

實驗針對“閉嘴”、“說話”和“打哈欠”行為的表征參數開展測試。圖12為6名駕駛人分別進行“說話”和“打哈欠”的開啟度φ曲線,波動范圍分別為0.8~1.5和2~2.5,具有顯著的可分性。“打哈欠”持續時間均大于4s,由于設定時間閾值Tth來進行二次判別,因此疲勞預警存在2s延遲。測試發現,φth和Tth是一對“此消彼長”的矛盾關系。提高開啟度閾值φth會相應提高“說話”的識別率,但也會降低“打哈欠”識別的時間寬裕度,導致疲勞預警準確率下降。而降低φth又會導致一些“說話”行為被認定為“其它”,增加“正常駕駛”的誤警率。大量實驗證明,φth=1.5,Tth=2s能夠最大程度上準確識別“說話”和“打哈欠”行為。

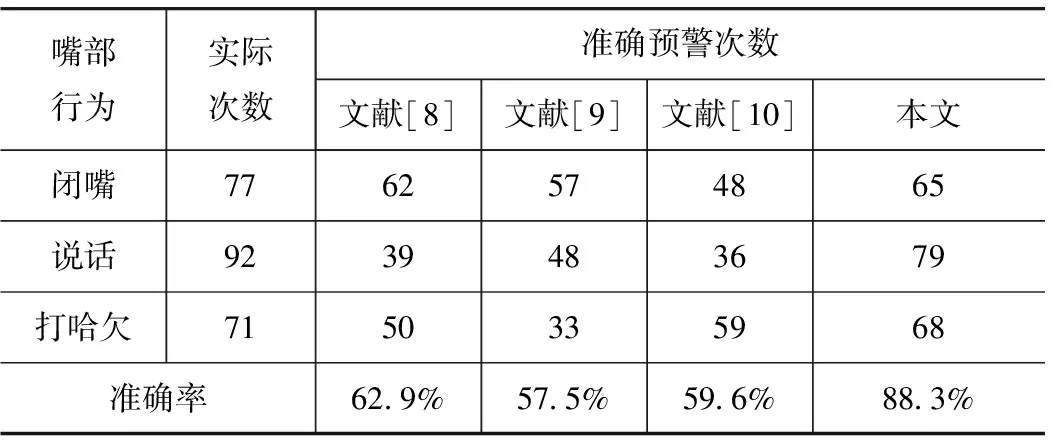

針對240組行為樣本開展分類預警實驗,同時采用其它文獻[8-10]的算法進行對比測試,預警準確率的統計見表2。文獻[8]中采用簡單的嘴唇色度分布與像素數量來識別“打哈欠”等動作,但未充分考慮個體差異性與嘴唇輪廓的紋理特性,因此在實際駕駛場景中的適應性不足。文獻[9]中依據嘴唇面積與高寬比來識別嘴部動作,由于未引入嘴部動作的時域特性,故無法有效區分“說話”與“打哈欠”行為。文獻[10]中通過灰度水平投影結合二維Gabor濾波來識別嘴唇開閉狀態,該方法在動態光照的干擾下識別效果不佳。與上述方法相比,本文中算法有針對性地考慮了駕駛室光照干擾與嘴唇動作的幅頻特性,更適用于駕駛人嘴部行為識別與分級預警。由于“打哈欠”行為在開啟度φ與時域空間上具有顯著的可識別特征,該行為的預警準確率較高,達92.9%。而說話時嘴部動作隨機而復雜,發音方式和語速也有很大的個體差異,因此“說話”行為的預警率相對較低,為85.8%。

表2 預警準確率

6 結論

以駕駛人精神狀態分級預警為目標,提出了一種基于機器視覺的嘴部行為識別方法。首先在HSI色彩空間中運用GMM分割膚色與唇色區域。考慮動態光照的干擾,運用GMM-API改進算法進行唇色的自適應參數迭代,有效提高了嘴唇區域分割的完整性與準確性。建立了基于灰度能量角點的嘴唇動態匹配模型,準確描述左右嘴角與上下嘴唇特征點并有效提取嘴部運動參數,在此基礎上建立嘴部行為的識別模式,實現駕駛人精神狀態的分級預警。實驗結果表明,提出的嘴唇動態模型具有較高的特征匹配精度和魯棒的動作適應能力,各特征點的匹配精度在85.8%以上。算法能夠有效檢測“閉嘴”、“說話”和“打哈欠”行為,分心預警和疲勞預警檢測精度分別達到85.8%和92.9%。在今后的研究中,擬將嘴部行為與眼睛運動和頭部姿態等行為進行信息融合,實現基于復合指標的駕駛人精神狀態安全預警。

[1] 李克強.汽車技術的發展動向及我國的對策[J].汽車工程,2009,31(11):1005-1016.

[2] 程文冬,付銳,袁偉,等.駕駛人疲勞監測預警技術研究與應用綜述[J].中國安全科學學報,2013,23(1):155-160.

[3] 成波,孟傳,張偉.基于機器視覺的駕駛員注意力狀態監測技術研究[J].汽車工程,2009,31(12):1137-1140.

[4] Ishigami Y, Klein P M. Is a Hands-free Phone Safer Than a Handheld Phone?[J]. Journal of Safety Research,2009,40(2):157-164.

[5] Azim T, Jaffar M A, Mirza Anwar M. Fully Automated Real Time Fatigue Detection of Drivers Through Fuzzy Expert Systems[J]. Applied Soft Computing,2014(18):25-38.

[6] Hong S J, Sarang Khim, Phill Kyu Rhee. Efficient Landmark Localization Using Spatial-Contextual Adaboost Algorithm[J]. Journal of Visual Communication and Image Representation,2014,25(6):1366-1377.

[7] Lee S J, Park K R, Kim J.A Comparative Study of Facial Appearance Modeling Methods for Active Appearance Models[J]. Pattern Recognition Letters,30(14):1335-1346.

[8] Abtahi S, Hariri B, Shirmohammadi S. Driver Drowsiness Monitoring Based on Yawning Detection[C]. Instrumentation and Measurement Technology Conference (I2MTC),2011 IEEE,2011:1-4.

[9] 周云鵬,朱青,王耀南,等.面部多特征融合的駕駛員疲勞檢測方法[J].電子測量與儀器學報,2014,28(10):1140-1148.

[10] Fan X, Yin B C, Sun Y F. Yawning Detection for Monitoring Driver Fatigue[C]. Machine Learning and Cybernetics,2007 International Conference on, IEEE,2007,2:664-668.

[11] Kakumanu P, Makrogiannis S, Bourbakis N. A Survey of Skin-color Modeling and Detection Methods[J]. Pattern Recognition,2007,40(3):1106-1122.

[12] Ban Y, Kim S, Kim S, et al. Face Detection Based on Skin Color Likelihood[J]. Pattern Recognition,2014,47(4):1573-1585.

[13] Cheng Y Z. Mean Shift, Mode Seeking and Clustering[C]. IEEE Transactions on Pattern Analysis and Machine Intelligence, IEEE,1995:790-799.

[14] Cho K M, Jang J H, Hong K S. Adaptive Skin-Color Filter[J]. Pattern Recognition,2001,5(34):1067-1073.

[15] Kimme R , Elad M, Shaked D, et al. A Variational Framework for Retinex[J]. International Journal of Computer Vision,2003,52(1):7-23.

[16] Chen L, Lu W, Ni J, et al. Region Duplication Detection Based on Harris Corner Points and Step Sector Statistics[J]. Journal of Visual Communication & Image Representation,2013,24(3):244-254.

[17] Ding H, Hong Y. NURBS Curve Controlled Modeling for Facial Animation[J]. Computers & Graphics:2003,27(3):373-385.

漢地潤滑科技(中國)有限公司新品發布會盛大召開

2015年9月14日,漢地潤滑科技(中國)有限公司“傳承質造 潤贏天下”新品發布會于北京嘉里大酒店順利召開。本次發布會昭示漢地潤滑油將傳承上游基礎油產業鏈的優勢,以塑造“中國第四桶油”的宏大愿景,強勢打造高端潤滑產業鏈及世界知名潤滑油品牌。行業內外的重量級嘉賓、媒體和合作伙伴等近200名來賓蒞臨現場、濟濟一堂,共同見證和開啟漢地潤滑油的新時代。

漢地潤滑科技(中國)有限公司一舉發布了14款新品,涵蓋氫勁、氫龍系列11款車用潤滑油,3款防凍液,宣告了漢地潤滑科技(中國)有限公司正式進軍國內潤滑油市場。

漢地潤滑科技(中國)有限公司旨在整合上、下游產業鏈,打造一個自有潤滑油產業鏈。漢地潤滑科技(中國)有限公司將依托領先的HYDROPURE氫純技術,牢牢把控潤滑油產品質量,做好油,為渠道、為客戶提供最優質的產品及服務,打造最具價值的高端潤滑油品牌。在未來,漢地潤滑科技(中國)有限公司也將采取資本聯合方式,與國內外的潤滑油品牌廠商進行多種形式的合作,共享價值、共贏未來!

Driver Mouth Behavior Recognition and HierarchicalPrewarning Based on Dynamic Matching Model

Fu Rui1, Cheng Wendong2,3, Zhang Mingfang2, Yuan Wei2, Liu Zhuofan2& Guo Yanjun2

1.Chang’anUniversity,KeyLaboratoryofAutomotiveTransportationSafetyTechnology,MinistryofCommunication,Xi’an710064;2.AutomobileCollege,Chang’anUniversity,Xi’an710064; 3.SchoolofMechatronicEngineering,Xi’anTechnologicalUniversity,Xi’an710032

In view of that mouth behaviors can reflect different mental states of driver, a machine vision-based mouth behavior recognition and mental state prewarning method for driver is proposed in this paper. Firstly an improved Gaussian mixed model is adopted for light-adaptive lip segmentation. Then a dynamic matching model for lip region is proposed based on gray-scale energy corners to describe lip features and extract mouth movement parameters. Finally a discrimination pattern of mouth behavior is built to fulfill the hierarchical prewarning of driver’s mental states. Experimental results demonstrate that the dynamic matching model proposed has high matching accuracy in mouth features and strong adaptability to mouth movement. The algorithm can effectively detect the mouth behaviors of “closed”, “speaking” and “yawning”. The monitoring accuracies of distraction and fatigue prewarning reach 85.8% and 92.9% respectively.

mouth behaviors; Gaussian mixed model; energy corners; dynamic matching model; hierarchical prewarning

*長江學者和創新團隊發展計劃項目(IRT1286)、國家自然科學基金(61374196和61473046)和中央高校基本科研業務費專項資金(2013G2221006,2013G1502060和2013G1502062)資助。

原稿收到日期為2014年9月25日,修改稿收到日期為2015年4月28日。