基于紋理抑制和連續(xù)分布估計的顯著性目標檢測方法

鄧 丹,吳 謹,朱 磊,劉 勁

(武漢科技大學 信息科學與工程學院,湖北 武漢430081)

1 引 言

人類視覺系統(tǒng)提取出視覺場景中感興趣的區(qū)域的過程包含兩個階段。首先是一個自底而上的,快速的,由數(shù)據(jù)驅(qū)動的過程。接著是一個自頂而下的,慢速的,由知識驅(qū)動的過程。在第一個階段中,由于整個處理只與觀察的場景有關(guān),具有較高的客觀性,近幾年來在圖像處理領(lǐng)域被廣泛地研究。

圖像顯著性研究方法主要有3類:像素、固定塊和區(qū)域。2007年,Hou等人[1]提出了顯著性檢測的一個譜殘差的方法,該方法主要是通過計算增量編碼長度來測量信息熵增益,但是這種結(jié)構(gòu)的前提是圖像必須具備相對復(fù)雜的背景。同年Harel等人[2]提出一種基于圖的視覺顯著性,該方法主要是在顯著性區(qū)域檢測中應(yīng)用馬爾可夫鏈的平穩(wěn)分布作為圖像的顯著性度量。2009 年Achanta[3]提出一種調(diào)頻顯著性檢測方法并于2010年對該方法進行了改進,該方法主要是通過在每一個像素上計算當前像素的顏色以及亮度與全圖像的平均顏色及亮度的差異來去除低頻部分(模糊部分)。Goferman等人[4]在2011年提出一種基于上下文的顯著性檢測方法,該方法使用局部對比,結(jié)合顯著區(qū)域的上下文信息檢測出現(xiàn)顯著對象。在眾多的顯著性檢測方法中以Itti算法[5]最為典型,該方法通過中央-鄰域差異算子(Center-surround differences)進行多尺度顯著性度量并將度量結(jié)果合并成一幅顯著圖。

中心-鄰域差異性被證明是目標之所以顯著的首要原因,受到該原理的啟發(fā),很多文獻提出了他們的顯著性檢測方法[6-7]。這種測量通常是在圖像的一個局部區(qū)域內(nèi)完成的,在自然場景下不可避免地受到目標內(nèi)部紋理擾動的影響。本文首先通過對圖像進行雙邊濾波處理,在保留目標和背景之間的主要邊緣的同時,平滑目標或者背景區(qū)域內(nèi)部的擾動。

中心-鄰域的差異性僅考慮一個像素或區(qū)域在局部范圍內(nèi)的顯著性,并未考慮到目標在整幅圖像中空間分布。在此基礎(chǔ)上,本文結(jié)合被廣泛使用的背景先驗知識來強化自然圖像中目標在空間分布上所具備的普遍特征。

2 本文提出的顯著性檢測方法

2.1 目標及背景區(qū)域內(nèi)部的紋理抑制

雙邊濾波(Bilateral Filtering)最早是由Tomasi和Manduchi提出的[8]。傳統(tǒng)低通濾波器,在像素空間完成濾波以后,導(dǎo)致圖像的邊緣細節(jié)丟失。雙邊濾波器可以在抑制目標以及內(nèi)部紋理的同時很好地保留目標邊緣。這主要是因為雙邊濾波在處理相鄰各像素時,不僅考慮到了灰度的空間鄰近關(guān)系,同時考慮到其相似關(guān)系。

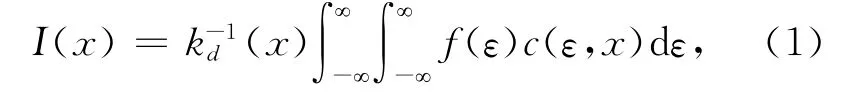

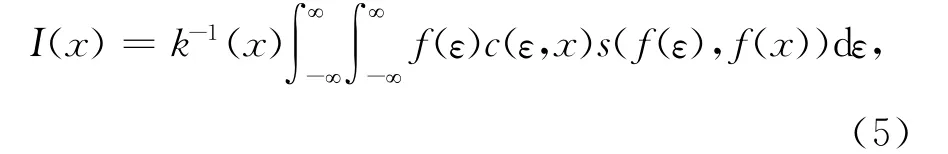

對于圖像f(x),在空間范圍內(nèi)得到低通濾波的圖像為I(x),則

其中:c(ε,x)代表中心點與其鄰近點ε的空間鄰近度,設(shè)x=(x1,x2),ε=(ε1,ε2)為圖像的空間坐標,那么

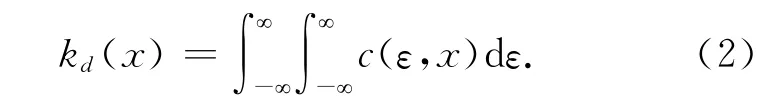

同理,在灰度范圍內(nèi)進行濾波得到的圖像表示為:

其中:s(f(ε),f(x))代表了中心點x 與它的鄰近點ε 的灰度相似度,此時

與空間鄰近度不同的是,灰度相似度是由圖像間兩點灰度的差值來決定的。根據(jù)式(1)與式(3),將空間鄰近度與灰度相似度相結(jié)合進行濾波,這樣得到的輸出圖像為:

其中:

目前對圖像的處理大都以像素為單位,用二維矩陣來表示一張圖像,但是這樣沒有考慮像素之間的空間組織關(guān)系,在很大程度上會降低算法處理效率。2003年Ren[9]等提出超像素的概念,并在2010年利用圖像超像素(superpixel)提取來獲取一致性片段,然后對超像素進行GMM 模糊聚類,最后利用Google開發(fā)的PageRank算法來計算每個超像素的顯著性。

超像素是指具有相似紋理、顏色和亮度等特征的相鄰像素構(gòu)成的圖像塊。超像素分割算法主要利用像素之間特征的相似度對像素分組以獲取圖像的冗余信息,從而降低后續(xù)圖像處理的復(fù)雜度。Achanta等[10]提出一種簡單線性迭代聚類(SLIC)算法,該算法是在LAB 空間使用聚類,由LAB顏色空間的亮度分量和兩個顏色分量以及像素坐標來計算。

2.2 基于連續(xù)分布的區(qū)域相似性度量

本文在進行相似性度量之前,先對濾波后圖像進行SLIC超像素分割的預(yù)處理。圖像預(yù)處理之后,分割成很多在顏色空間上具有相似特征的區(qū)域,我們假設(shè)每一個超像素內(nèi)部的像素集合在顏色空間內(nèi)符合多維正態(tài)分布,那么可以通過多維正態(tài)分布來擠去超像素的特征。那么第i個超像素集合可表示如下:

其中:NSi表示均值為μ,協(xié)方差為∑的多維正態(tài)分布,CSi表示該超像素的中心位置,x,y 是超像素的坐標。

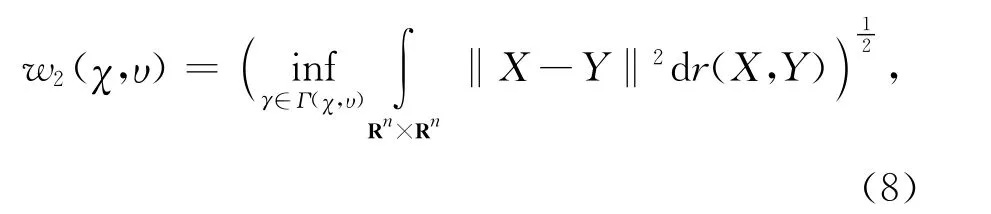

有許多用于區(qū)域?qū)Ρ鹊臋z測技術(shù)均被用來辨識局部對比。最近,Klein 和Frintrop[11]統(tǒng)計了以每個像素為中心的兩個不同尺度的高斯加權(quán)矩形區(qū)域內(nèi)像素在顏色空間內(nèi)的分布,并利用二范數(shù)約束下的Wasserstein距離來計算該像素中心-鄰域差異。在實數(shù)空間中,歐式范數(shù)約束下的Wasserstein距離定義如下:

其中:χ 和μ 是在測度空間(Rn,L2)上的概率測度,Γ(χ,μ)表示與χ 和μ 有關(guān)的在Rn×Rn上的所有測度。

簡單的說,Wasserstein距離計算了從一個分布變換到另外一個分布的最小代價,它不僅累計了在兩個分布中對應(yīng)每個點在測度空間中的個體變化,同時也考慮從一個分布到另一個分布的距離。在機器視覺中,離散化的W1距離通常被稱為推土機距離,該距離也經(jīng)常被用于比較直方圖。

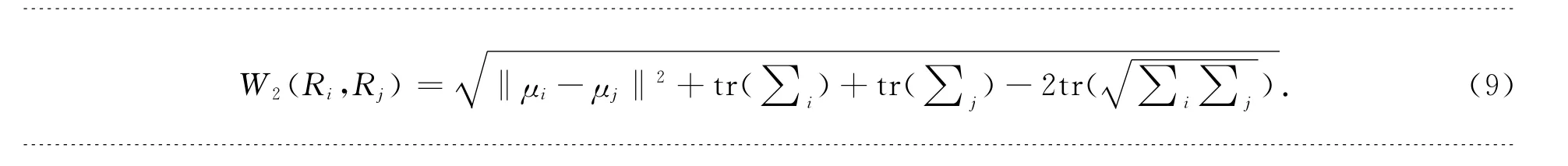

一般地,對于任意連續(xù)分布,二范數(shù)Wasserstein距離(W2距離)沒有解析的計算方法。幸運的是,針對于兩個正態(tài)分布,文獻[12]給出了其W2距離的解析解。對于任意兩個經(jīng)過SLIC超像素分割的區(qū)域Ri和Rj均服從多維正態(tài)分布,那么這兩個區(qū)域的W2距離可以由公式(9)得到:

其中:μi 和μj分別是區(qū)域Ri和Rj的均值,∑i和∑j分別是區(qū)域Ri和Rj的協(xié)方差矩陣,tr(∑i)和tr(∑j)是協(xié)方差矩陣的跡。

2.3 基于中央-周邊差的局部顯著性檢測

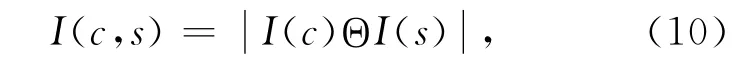

傳統(tǒng)的中心-鄰域差異性計算首先將粗尺度插值轉(zhuǎn)換到相應(yīng)的細尺度圖像,然后細尺度逐個像素進行減法運算。計算公式如(10)所示。

其中:I為亮度通道的尺度圖,用來產(chǎn)生一個高斯金字塔I(σ),σ∈[0…8],表示高斯金字塔尺度值,中心c∈{2,3,4},s∈{4,5,6},Θ 是差分算子。

傳統(tǒng)的中心-鄰域差異計算沒有考慮像素的空間相似性,易降低算法處理率,因此本文先對圖像進行SLIC超像素分割,然后提取超像素特征,在不進行多尺度插值計算下采用上文提到的W2距離進行局部顯著性檢測。

2.4 基于背景先驗的全局顯著性檢測

根據(jù)背景先驗知識,背景往往集中在圖像邊緣,那么可以通過提取邊界區(qū)域特征進行顯著性檢測得到全局顯著圖。本文整體考慮所有邊緣在特征空間的相關(guān)性,根據(jù)邊緣在特征空間中的潛在流形分布結(jié)構(gòu),采用邊界區(qū)域的流形排序方法[13-15],對邊界細節(jié)進行排序。

在SLIC超像素分割的基礎(chǔ)上,采用閉環(huán)圖模型來模擬邊界數(shù)據(jù)的流形結(jié)構(gòu)[16-17]。以超像素為節(jié)點,計算包空間的近鄰點,連接超像素和近鄰點作為加權(quán)圖的邊。

假定超像素集合由X={x1,x2…xn}∈Rm×n構(gòu)成,m 為特征空間的維數(shù),n 為超像素的個數(shù)。由集合中的n個節(jié)點構(gòu)建圖,節(jié)點之間的邊權(quán)值矩陣為:

其中:σ為給定的參數(shù),d(xi,xj)為超像素xi,xj在特征空間的距離,由前文提到的W2距離計算得到,為了防止自相似性,設(shè)wii=0,據(jù)S=D-1/2WD-1/2歸一化W。其中D 為對角陣,滿足:

定義f 為向量f={f1,f2,…fn},其中fi為像素xi的排序值,i∈{1,2,…n}。同時定義向量y,滿足y={y1,y2,…yn},如果xi是查詢元素,那么yi=1,反之為0。

定義f*為序列{fi(t)}的極限,假定f(t)收斂于f*,文獻[13]證明區(qū)域最優(yōu)查詢排序結(jié)果可由公式(12)得到:

在衡量超像素的相似性中,每一個比較后的像素作為下一個查詢元素,依次傳遞下去,所得到的排序評分記為第一個查詢元素的評分大小,那么在t+1時刻,邊界區(qū)域的排序評分為:

f(t+1)=αSf(t)+(1-α)y, (13)

其中:α為參數(shù)并且滿足α∈[0,1),它定義了在排序評分傳遞過程中,某區(qū)域所獲得的排序評分的來源。定義f*為序列{fi(t)}的極限,假定f(t)收斂于f*,那么對于公式(13)可有:

整理后可以得到:

圖1 顯著性結(jié)果對比圖Fig.1 Significant results of comparison chart

3 實驗結(jié)果分析

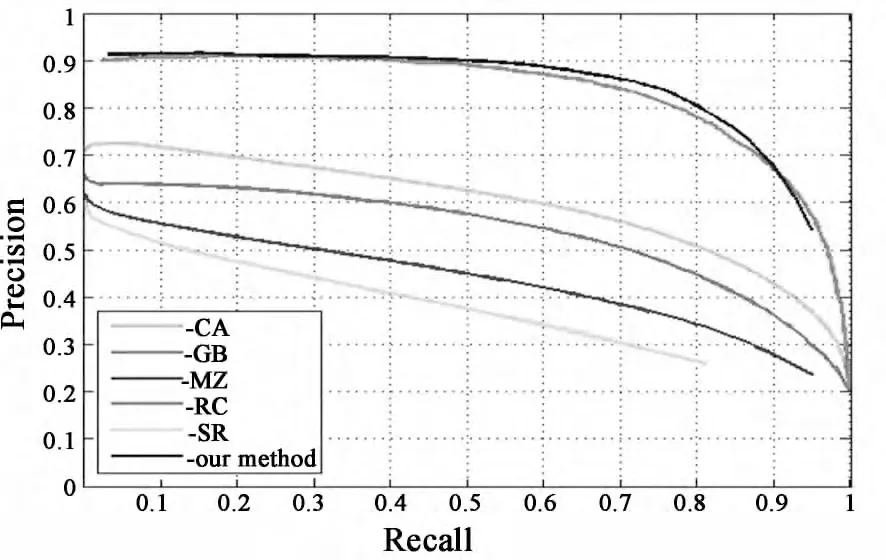

本文通過雙邊濾波和SLIC 超像素分割對圖像進行預(yù)處理,應(yīng)用W2距離度量特征相似度,結(jié)合背景先驗知識進行顯著性檢測。為了驗證本文算法的有效性,我們采用MSRA 圖像庫應(yīng)用MATLABR2010a實現(xiàn)算法有效性,并將其與經(jīng)典 的5 種 顯 著 性 算 法CA[4]、GB[2]、MZ[12]、RC[18]、SR[1]進行對比,最后將由我們的算法得到的顯著性圖對比ground truth數(shù)據(jù)庫中圖片得到精準-查全率曲線(precision-recall curves)。

MSRA 顯著性目標圖像庫中包含1 000幅可以用來準確提取ground truth的二進制結(jié)果的圖片。這些圖片每幅均含有一個顯著性目標且經(jīng)由眾多研究者認同才被收納到 MASR 中的。Ground truth是由許多學者通過提取那些他們覺得是顯著性的圖像邊框得到的標準圖片集。據(jù)我們所知,MASR 是被認可的具有精準ground truth圖片集中最大的圖像集。實驗對比結(jié)果如圖1所示。

圖2 精準-查全率曲線Fig.2 Precision-recall curves

由圖1可以看到本文算法得到的顯著性圖最接近grouth truth的結(jié)果。本文算法有效地抑制了目標內(nèi)部紋理,比其他算法更好地保留了目標與背景之間的邊界,更加突出了顯著性目標在背景中的整體輪廓。

將本文提出的顯著性檢測方法和CA、GB、MZ、RC、SR 算法分別對MSRA 數(shù)據(jù)庫1 000幅圖片進行顯著圖提取,再對比顯著圖和grouth truth二值圖像計算精度和查全率,得到圖2 精度-查全率曲線。

精度-查全率曲線提取顯著性目標最簡單的方法就是在一定的灰度值范圍內(nèi)根據(jù)固定閾值分割顯著圖。我們將所有的顯著圖歸一化到[0,255]上,并采用256 個變化閾值對其進行分割。對于每一幅圖像,通過比較計算該圖的顯著圖和數(shù)據(jù)庫的ground truth中二值圖像來得到精度和查全率。最后,我們將數(shù)據(jù)庫中所有圖片的精度和查全率平均化來得到選擇基準的全部評估。

假設(shè)顯著圖I經(jīng)固定閾值分割得到的圖形中共有S 個區(qū)域,其中有M 個是前景區(qū)域,也就是顯著區(qū)域。Ground truth中I的前景區(qū)域個數(shù)為N,定義true positive為兩者的交集,表示為:

那么精度P(presition)可表示為:

查全率R(recall)可表示為:

從圖2也可以看出,本文算法的精度和查全率明顯高于CA、GB、MZ、SR 4種方法,說明本文算法相對于這4種算法檢測效果更好。

當查全率為0.1~0.5 時,本文算法的精度-查全率曲線和RC 算法有部分是重合的,但是從曲線上可以看到,對應(yīng)的精度達到0.9,這說明本文和RC算法都能夠取得不錯的檢測效果。當查全率為0.5~0.9時,本文算法的精度略高于RC算法,表明本文算法可以獲得更精確的顯著圖。

4 結(jié) 論

提出了一種應(yīng)用雙邊濾波抑制圖像內(nèi)部紋理,通過多維正態(tài)分布提取區(qū)域特征,結(jié)合中央-周邊差異性和背景先驗知識,應(yīng)用二范數(shù)約束下的Wasserstein距離進行顯著性檢測的方法。首先對圖像進行雙邊濾波,以平滑目標以及背景區(qū)域內(nèi)部紋理的同時較好地保留圖像邊界。顯著圖提取建立在SLIC 超像素的分割基礎(chǔ)上,通過多維正態(tài)分布提取區(qū)域特征,應(yīng)用W2距離對超像素進行相似性度量,分別得到局部顯著圖和全局顯著圖,最后兩者像素相乘得到圖像顯著圖。實驗結(jié)果表明采用本文的方法獲得了較好的檢測效果。

[1] Hou X,Zhang L.Saliency detection:A spectral residual approach[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition,2007:1-8.

[2] Hare J,Koch C,Perona P.Graph-based visual saliency[C].The 20th Annual Conference on Neural Information Processing Systems,2006:545-552.

[3] Achanta R,Hemami S,Estrada F,et al.Frequency-tuned salient region detection[C].IEEE Conference on Computer Vision and Pattern Recognition,2009:1597-1604.

[4] Goferman S,Zelnik-Manor L,Tal A.Context-aware saliency detection[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(10):1915-1926.

[5] Itti L,Koch C,Niebur E.A model of saliency-based visual attention for rapid scene analysis[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1998,20(11):1254-1259.

[6] 董宇星,劉偉寧.基于灰度特性的海天背景小目標檢測[J].中國光學與應(yīng)用光學,2010,15(3):252-256.Dong Y X,Liu W N.Small target detection based on the characteristics of the gray sky background[J].Chinese Optics and Applied Optics,2010,15(3):252-256.(in Chinese)

[7] 宋建中.圖像處理智能化的發(fā)展趨勢[J].中國光學,2011,4(5):431-440.Song J Z.Development trend of intelligent image processing[J].Chinese Optics,2011,4(5):431-440.(in Chinese)

[8] Zhang X N,Liu G Q,Hu Y,et al.A new two-sided coupling channel drop filter based on a two-dimensional photonic crystal[C].The 2nd International Conference on Opto-Electronics Engineering and Materials Research,2013:417-420.

[9] Ren Z,Hu Y,Chia L T,et al.Improved saliency detection based on superpixel clustering and saliency propagation[C].The l8th Annual ACM International Conference on Multimedia,2010.

[10] Achanta R,Shaji A,Smith K,et al.SLIC superpixels compared to state-of-the-art superpixel methods[C].IEEE Transactions on Pattern Analysis and Machine Intelligence,2012:2274-2281.

[11] Klein D A,F(xiàn)rintrop S.Salient pattern detection using w2on multivariate normal distributions[C]∥The 8th Symposium on Multispectral Image Processing and Pattern Recognition,2012:246-255.

[12] Givens C R,Shortt R M.A class of wasserstein metrics for probability distributions[J].Michigan Math.,1984,31(2):33-40.

[13] Wei Y,Wen F,Zhu W,et al.Geodesic saliency using background priors[C].The 12th European Conference on Computer Vision,2012:29-42.

[14] Wan X,Yang J,Xiao J.Manifold-ranking based topic-focused multi-document summarization[C].The 20th International Joint Conference on Artificial Intelligence,2007:2903-2908.

[15] Belkin M,Niyogi P.Towards a theoretical foundation for laplacian based manifold methods[C].The 18th Annual Conference on Learning Theory,2007:486-500.

[16] Yang C,Zhang L,Lu H,et al.Saliency detection via graph-based manifold ranking[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition,2013:3166-3173.

[17] Cheng M M,Zhang G X,Mitra N J,et al.Global contrast based salient region detection[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition,2011:409-416.

[18] Ma Y F,Zhang H J.Contrast-based image attention analysis by using fuzzy growing[C].The 11th Annual ACM International Conference on Multimedia,2003:374-381.