基于深度強化學習的軌交飛輪儲能系統能量管理

摘" 要:隨著城市化進程的加速和公共交通系統的發展,地鐵系統的運營效率和能源利用效率受到越來越多的關注。飛輪儲能技術憑借其高功率循環能力,為軌道交通系統的能源利用問題提供新的解決方案。該文采用馬爾科夫決策過程來描述單飛輪儲能系統的能量管理問題,并使用基于深度Q網絡的強化學習算法來學習最優的充放電閾值動態調整策略。通過在Matlab/Simulink平臺搭建仿真環境,對開發的能量管理算法進行測試,并將其結果與固定充放電閾值、隨機充放電閾值策略進行對比,表明該策略在提高電能利用效率和系統運行穩定性方面具有顯著效果。

關鍵詞:飛輪儲能系統;能量管理;馬爾科夫決策過程;深度強化學習;深度Q網絡

中圖分類號:TP29" " " 文獻標志碼:A" " " " " 文章編號:2095-2945(2025)02-0030-05

Abstract: With the acceleration of urbanization and the development of public transportation systems, the operational efficiency and energy utilization efficiency of subway systems have attracted more and more attention. Flywheel energy storage technology provides new solutions to energy utilization problems in rail transit systems with its high-power cycle capabilities. In this paper, Markov decision process is used to describe the energy management problem of a single flywheel energy storage system, and a reinforcement learning algorithm based on deep Q network is used to learn the optimal dynamic adjustment strategy for charge and discharge thresholds. By building a simulation environment on Matlab/Simulink platform, the developed energy management algorithm is tested, and the results are compared with fixed charge and discharge threshold strategies and random charge and discharge threshold strategies, which shows that this strategy has significant effects on improving power utilization efficiency and system operation stability.

Keywords: flywheel energy storage system; energy management; Markov decision process; deep reinforcement learning; Deep Q-Network (DQN)

隨著城市化進程的加速和公共交通系統的發展,地鐵系統作為城市重要的交通工具,其運營效率和能源利用效率受到越來越多的關注。傳統的地鐵系統在能源利用方面存在一定的局限性,如制動能量回收利用不足、電網負載波動等問題。飛輪儲能技術的出現為解決這些問題提供了新的解決方案,其循環和提供高功率以及高功率梯度的能力使其非常適合頻率調節、電壓支持和功率固定等存儲應用[1],且與電池相比,容量不會因高倍率充放電而衰減,更能適應極端的溫度和天氣,對日常維護的要求較低[2]。飛輪儲能系統能夠有效地捕獲和存儲列車制動過程中產生的能量,并在需要時釋放能量,從而提高能源利用效率。通過優化飛輪儲能系統的能量管理方法,可以提高牽引網的能量流動效率,優化儲能系統的節能、穩壓效果。

飛輪儲能系統的能量管理可以通過調整充放電閾值來實現。文獻[3]將充放電閾值作為一個隨牽引網壓和飛輪SOC變化的函數,進行自適應調整,這種能量管理策略的實現較為簡單,但考慮的狀態變量較少,采用的函數形式不足以擬合系統的特性,系統的節能功能仍有較大優化空間。文獻[4]提出了一種基于多閾值的電壓-電流雙閉環控制策略,將飛輪儲能系統劃分了4種工作模式,以兼顧節能與穩壓功能,此類策略同樣由于對系統的狀態信息利用不夠充分,難以實現最優的節能與穩壓效果。

強化學習是一種機器學習方法,其主要思想是讓智能體在動態環境中,通過嘗試不同的行為并觀察環境的反饋來學習最優的行為策略。在強化學習中,不需要對數據進行事先標注,而是由智能體通過試錯和反饋來逐步改進自己的決策策略。通過不斷地嘗試不同的動作并根據環境的反饋進行學習,智能體逐步調整其行為策略,以獲得更高的累積獎勵。深度強化學習是一種結合了深度學習和強化學習的技術,與傳統的強化學習方法相比,深度強化學習通過深度神經網絡來學習從狀態感知數據到動作的映射,從而能夠處理更加復雜的環境和任務。深度Q網絡(DQN)算法是眾多深度強化學習方法中的重要代表之一。DQN算法由DeepMind團隊于2013年提出[5],旨在解決離散動作空間下的強化學習問題。DQN的核心思想是通過Q-learning算法,利用神經網絡逼近Q值函數,從而學習到最優的動作策略。

基于深度強化學習的能量管理方法已經在地面式超級電容等軌道交通用儲能系統中得到應用[6-7]。在飛輪儲能系統能量管理中,深度強化學習可以被用來優化系統的運行策略,以實現更高效的能量利用和更穩定的運行。通過將深度神經網絡應用于飛輪儲能系統的控制策略中,系統可以通過訓練優化不同工況下的充放電閾值選擇,從而提高系統的能量轉換效率,降低能量損耗,適應不同的運行條件和需求,在動態環境中實現更好的性能表現。

1" 用于飛輪儲能系統能量管理的強化學習模型設計

本文采用馬爾科夫決策過程(Markov Decision Process, MDP)來描述單飛輪儲能系統的充放電閾值動態調整問題,并使用強化學習算法來學習最優策略。以下是本文對問題中狀態、動作空間和獎勵的定義。

1.1" 狀態空間

狀態空間S定義為問題中可能的所有狀態的集合,每個時刻的狀態s是環境的一種特定觀察結果。此問題中狀態s包括儲能系統自身SOC、儲能系統所在變電所的功率P、整流機組的輸出電壓urec和電流irec。s表示為

s=[P,SOC,irec,urec]。

1.2" 動作空間

動作空間A定義為代理可以采取的所有可能動作的集合。每個動作a是代理在特定狀態下可以執行的動作。本文采用動態調整飛輪儲能系統充放電閾值的方式來實現能量管理,在變電站的空載電壓uss0的基礎上,通過疊加充電閾值調整因子或減去放電閾值調整因子來得到充電閾值uc和放電閾值ud。為了方便使用DQN算法求解,本文對閾值調整因子的選擇進行了離散化。動作空間A包含所有充放電閾值選項的組合,表示為

A={[uc=uss0+kcΔu,ud=uss0+kdΔu];kc,kd∈[1,N]},

式中:Δu為充放電閾值的單位變化量。

1.3" 獎勵函數

獎勵函數r將當前狀態和代理選擇的動作映射到一個實數值,用于評估代理在特定狀態下執行特定動作后獲得的即時反饋,獲取最大累積獎勵為代理學習的目標。本文對獎勵函數r的定義基于時間步長內節能率和穩壓率的加權和,并將節能率和穩壓率截斷在[-10,1]區間內,以減少訓練過程中的梯度爆炸或梯度消失問題、加快模型的收斂速度,以及提高模型的泛化能力。為了保證算法的穩定運行,在節能率、穩壓率的計算中對分母極小的情況進行了特殊處理。

k時刻的獎勵函數rk的定義如下

rk=0.4min(max(ek,-10),1)+0.6min(max(vk,-10),1),

式中:ek為k時刻前時間步長ΔT內的節能率。

式中:u、i為啟用飛輪儲能系統時整流機組的輸出電壓和電流;u、i為未啟用飛輪儲能系統時整流機組的輸出電壓和電流。

vk為k時刻前時間步長ΔT內的穩壓率

式中:Δu、Δu分別為啟用和未啟用飛輪儲能系統時整流機組的輸出電壓高于設置的電壓上限時與電壓上限的差值的絕對值,若未高于電壓上限則取零;Δu、

Δu分別為啟用和未啟用飛輪儲能系統時整流機組的輸出電壓低于設置的電壓下限時與電壓下限的差值的絕對值,若未低于電壓上限則取零。

2" 基于DQN的能量管理算法實現

本文應用的基于DQN的能量管理算法訓練流程如圖1所示。

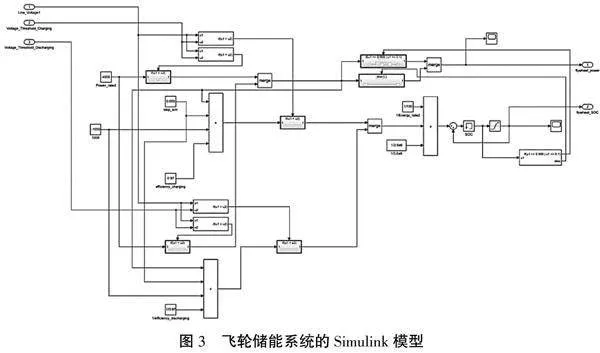

在DQN算法中,通過經驗回放和目標網絡的設計,實現了對訓練樣本的高效利用和訓練過程的穩定性提升。此外,采用了ε-greedy策略來探索動作空間,從而平衡訓練中的探索和利用。在本文中,探索概率ε隨時間指數衰減,從訓練開始時的εmax逐步衰減至80%的片段已完成時的εmax,隨后保持不變。本文選用的DQN網絡結構示意圖如圖2所示。

在本研究中,我們使用PyTorch搭建了一個由輸入層、2個隱藏層和輸出層組成的DQN模型。網絡的輸入為包含4個分量的歸一化狀態向量,每個隱藏層含有64個神經元。選擇ReLU作為激活函數,并使用均方誤差(MSE)作為損失函數,用于優化網絡參數。本文選取Adam優化器作為優化算法,Adam是一種常用的自適應學習率優化算法,能夠自動調節學習率并針對每個參數提供不同的更新步長,具有收斂速度快、能夠有效地處理稀疏梯度和噪聲等優點。

3" 模型訓練與測試

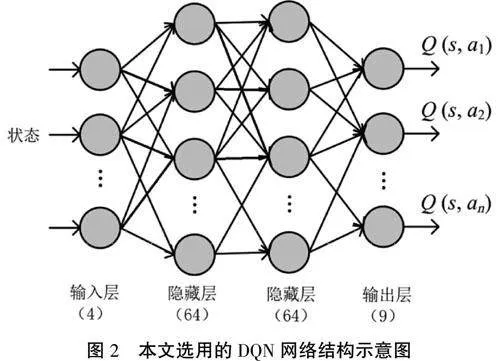

為了訓練實現的DQN模型、評估能量管理策略的性能,借助MATLAB/Simulink平臺搭建了一個仿真環境,以模擬配置有單個飛輪儲能系統的變電所及其整流機組,并搭建了對照組以模擬電阻制動,用于計算節能率與穩壓率。儲能系統所在變電所的功率P根據港鐵屯馬線的運行圖計算得出,并實時發送給仿真系統。飛輪儲能系統的Simulink模型如圖3所示。

訓練和測試中,假設變電站的空載電壓uss0為定值1 500 V,用于計算穩壓率的電壓上限uh設置為1 520 V,下限ul設置為1 480 V。動作空間設計中N取3,充放電閾值的單位變化量Δu設置為40 V,可選的充放電閾值共有9種組合。

深度強化學習算法的訓練參數選擇見表1。

圖4給出了基于深度強化學習的能量管理算法的學習曲線。深色曲線表示每個片段的總獎勵,淺色曲線表示片段總獎勵的移動平均值。可以觀察到,隨著訓練片段數量的增加,總獎勵總體上呈現出上升趨勢,這表明DQN在不斷學習和改進其策略,逐步優化其能量管理效果。

為了評估訓練得到的能量管理策略的性能,在仿真系統中對固定充放電閾值、隨機充放電閾值和基于DQN的能量管理策略進行了測試。每次測試中的仿真時間為8 000 s,對應1 600次決策。通過將ΔT視為8 000 s,可以計算出整個時間段內的節能率和穩壓率,以供比較。各種能量管理策略在5次測試中的平均節能率和穩壓率見表2。

實驗結果表明,基于DQN的能量管理策略在節能率和穩壓率方面均優于隨機充放電閾值和固定充放電閾值策略。具體來說,基于DQN的能量管理策略的平均節能率為36.4%,高于隨機充放電閾值的34.7%和固定充放電閾值的35.0%。這一結果表明,基于DQN的策略能夠更有效地回收利用能量,從而減少不必要的能量浪費。在穩壓率方面,基于DQN的能量管理策略也表現出明顯優勢,其穩壓率為75.5%,高于隨機充放電閾值的73.0%和固定充放電閾值的73.7%。這一優勢意味著基于DQN的策略能夠更好地維持系統電壓的穩定,減少電壓波動對線路運行的不利影響。

4" 結論

本文提出了一種基于深度強化學習的飛輪儲能系統能量管理策略,通過采用馬爾科夫決策過程描述能量管理問題,并利用DQN算法來學習最優的充放電閾值動態調整策略。在MATLAB/Simulink平臺上搭建了仿真環境,根據港鐵屯馬線的運行圖計算儲能系統所在變電所的功率,對能量管理策略進行了測試。結果表明,與固定充放電閾值和隨機充放電閾值策略相比,該策略不僅提高了電能利用效率,而且能夠保持系統的運行穩定性。這些結果表明深度強化學習在軌道交通儲能系統能量管理領域具有廣闊的應用前景,為未來智能交通系統的發展提供了有益的啟示。

參考文獻:

[1] DONGXU H, XINGJIAN D, WEN L, et al. A review of flywheel energy storage rotor materials and structures[J]. Journal of Energy Storage,2023(74):109076.

[2] RONGJIE R, YUNYU L, YEJIAN Y, et al. Study on magnetic flywheel energy storage system in urban rail transit[C]//2017 IEEE Transportation Electrification Conference and Expo, Asia-Pacific (ITEC Asia-Pacific). IEEE, 2017: 1-6.

[3] 趙思鋒,唐英偉,王賽,等.基于飛輪儲能技術的城市軌道交通再生能回收控制策略研究[J].儲能科學與技術,2018,7(3):524-529.

[4] 李進.城軌交通地面飛輪儲能系統控制策略研究[D].北京:北京交通大學,2022.

[5] MNIH V, KAVUKCUOGLU K , SILVER D, et al.Playing atari with seep reinforcement learning[J].Computer Science, 2013.

[6] YANG Z, ZHU F, LIN F. Deep-reinforcement-learning-based energy management strategy for supercapacitor energy storage systems in urban rail transit[J]. IEEE Transactions on Intelligent Transportation Systems, 2020, 22(2): 1150-1160.

[7] 諸斐琴.城市軌道交通地面式超級電容儲能系統自適應協調控制與容量配置綜合優化研究[D].北京:北京交通大學,2021.

基金項目:國家重點研發項目(2023YFB4302103)

第一作者簡介:王寧(1998-),男,碩士,助理工程師。研究方向高速磁浮控制技術。

*通信作者:曲建真(1990-),男,博士,工程師。研究方向為電力電子變流器。