基于關系有向圖正則化的屬性三因子分解模型

摘要: 針對零樣本圖像分類中屬性和特征之間映射不全面以及屬性空間結構挖掘不充分問題,提出了基于關系有向圖正則化的屬性三因子分解模型。首先,利用屬性矩陣三因子分解實現了屬性空間和特征空間的映射;其次,通過權值矩陣構建了屬性關系有向圖;最后,在屬性空間或特征空間計算測試樣本和各測試類別的相似性,進而實現圖像分類。在aPY和SUN數據集上的實驗結果表明,所提模型有效地提高了零樣本圖像分類精度。

關鍵詞: 零樣本圖像; 屬性三因子分解; 關系有向圖; 正則化

中圖分類號: TP18

文獻標志碼: A

文章編號: 1671-6841(2025)01-0067-07

DOI: 10.13705/j.issn.1671-6841.2023147

Attribute Tri-factorization Model with Regularization of Relation

Digraph

ZHANG Jiarui1, 2, LI Ruilin3, KONG Yi2, YU Nannan1

(1.School of Electrical Engineering and Automation, Jiangsu Normal University, Xuzhou 221116, China;

2.School of Information and Control Engineering, China University of Mining and Technology, Xuzhou

221116, China; 3.State Key Laboratory of Intelligent Construction and Healthy Operation & Maintenance

of Deep Underground Engineering, China University of Mining and Technology, Xuzhou 221116, China)

Abstract: Aiming at the problems of incomplete mapping between attributes and features, as well as the insufficient mining of the attribute space structure in zero-shot image classification, an attribute tri-factorization model with regularization of relation digraph was proposed. Firstly, the mapping between attribute space and feature space was achieved by matrix tri-factorization of attributes. Secondly, the attribute relation digraph was constructed using the weight matrix. Finally, the similarity between the testing sample and each testing class was calculated in either the attribute space or the feature space to finish image classification. Experimental results on aPY and SUN datasets showed that the proposed model was capable of efficiently improving the accuracy of zero-shot image classification.

Key words: zero-shot image; attribute tri-factorization; relation digraph; regularization

0引言

在許多應用場景中,模式分類的目的是將訓練樣本放入正確的類別。例如,計算機解讀人類神經活動實驗中,需要通過檢測人的一幅神經活動圖像(訓練樣本)來判斷他正在想什么單詞(類別)。由于單詞的數量非常龐大,為每個單詞都收集并標注一幅神經活動圖像幾乎是不可能的。這就是典型的零樣本分類問題,即在標記訓練樣本無法涵蓋所有對象類的情況下,如何對訓練階段不可見的新對象進行正確分類[1-3]。

利用屬性等語義信息建立訓練集和測試集之間的聯系是

解決零樣本圖像分類問題的關鍵。傳統的零樣本圖像分類方法通過學習從特征到語義的映射關系來實現圖像分類,其中直接屬性預測模型[4]最為經典。Akata等[5]提出結構化聯合嵌入模型,通過學習雙線性相容函數獲得從特征輸入到人工標注屬性、無監督詞嵌入及分層嵌入組合輸出的聯合框架。不同于從特征到語義的單向映射,許多學者嘗試采用不同方式學習特征和語義之間的映射關系。Yu等[6]提出潛在空間編碼模型,該編碼-解碼模型通過共享潛在空間連接屬性和特征,并通過從原始空間到潛在空間的預測和從潛在空間到原始空間的恢復實現了知識遷移。以上模型在學習屬性和特征之間的映射關系時,均未考慮各類別之間的聯系。

通過將測試類的特征或屬性分別看成訓練類特征或屬性的組合可以有效地考慮類別之間的聯系,基于該思想建立的模型統稱為混合模型。近年來,Changpinyo等[7]提出SynC模型,利用訓練類分別在語義和特征空間學習一系列虛擬類,然后通過虛擬類的凸組合合成測試類。Verma等[8]提出GFZSL模型,采用指數族類條件分布學習從類別嵌入到潛在空間的回歸函數,并利用訓練集類別屬性獲得測試類的分布參數。盡管以上混合模型學習屬性分類器時考慮了各類別之間的關系,但并未考慮屬性空間的幾何結構。屬性是零樣本分類問題中連接訓練集和測試集的橋梁,充分挖掘已有屬性關系及空間幾何結構可得到更好的類別屬性描述。然而,已有模型在挖掘屬性關系和空間結構時一般僅考慮了屬性之間的相互關系,缺乏對屬性個體差異的描述。

綜上所述,本文以如何更加合理地映射屬性和特征之間關系、如何更好地挖掘屬性空間結構為出發點,提出基于關系有向圖正則化的屬性三因子分解模型(attribute tri-factorization model with regularization of relation digraph), 簡稱為RDATF模型。本文的主要貢獻包括:利用屬性的矩陣三因子分解實現屬性空間和特征空間的映射,將投影矩陣作為訓練階段和測試階段的共享因子;通過加權屬性之間的相似性定義權值矩陣,構建屬性關系有向圖;在屬性空間或特征空間計算測試樣本和各測試類別的相似性,實現圖像分類。

1基于屬性三因子分解的零樣本圖像分類

本文所構建的RDATF模型通過利用屬性關系有向圖來挖掘屬性空間結構,并在訓練階段和測試階段共享屬性三因子分解投影矩陣以獲得更好的屬性-特征間映射,進而提高分類精度。RDATF模型由屬性矩陣三因子分解、屬性關系有向圖構建、屬性投影學習和零樣本圖像分類4個階段組成。

1.1屬性矩陣三因子分解

通過合理構造屬性與特征之間的映射,可有效建立兩者的投影關系。假設有效的投影關系滿足[9]:最大化訓練集和測試集樣本特征的經驗似然;保留屬性和特征兩個空間之間的幾何結構。為了使投影關系更好地適應訓練和測試數據,可以利用一個潛在共享因子建立兩者之間的聯系。本節通過矩陣三因子分解獲得該潛在共享因子表示。

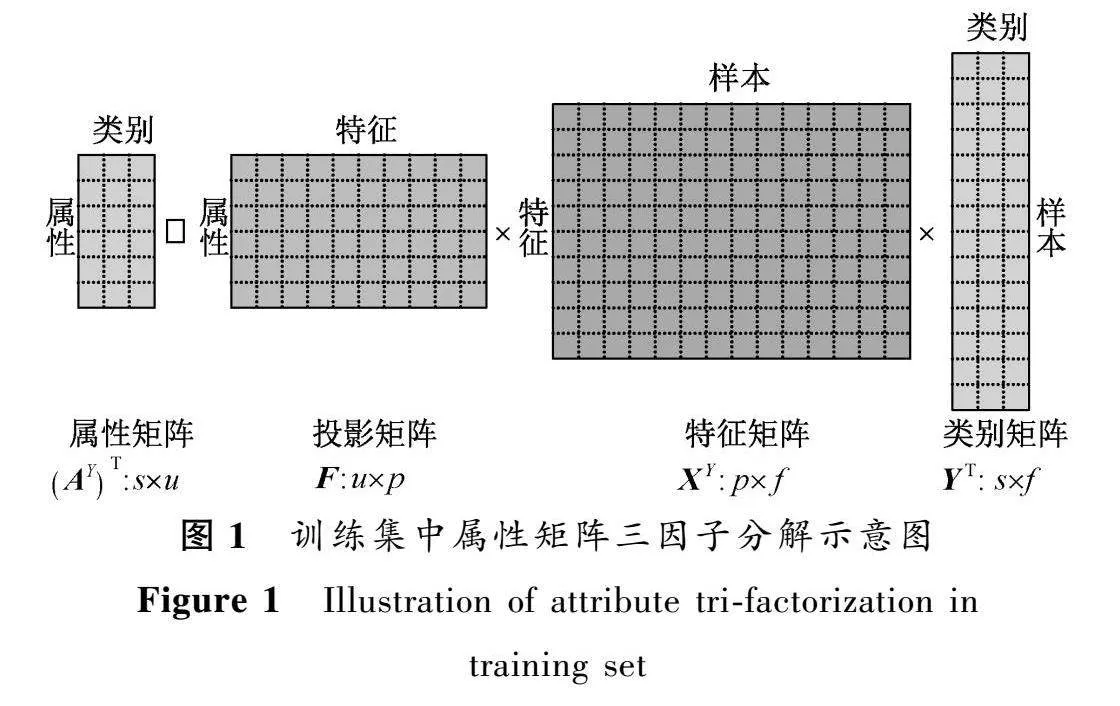

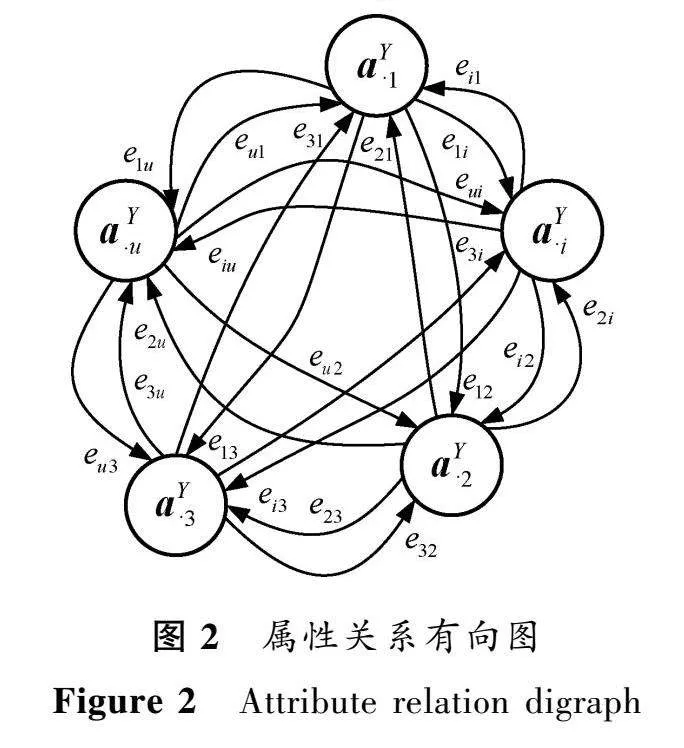

矩陣三因子分解[10]是將矩陣U分解為F、V和G三個矩陣,利VyM8dWB98kF+TiYPKHoORpohVYPLWc8VwB5rIdD0kwg=用對U的經驗似然計算最小化估計誤差,

minF,G‖

U-FVGT‖2。(1)

令U=(AY)T,

V=XY,且同時使G=Y來保證訓練集中每類樣本和其類別屬性相對應,則式(1)變為

minF

‖(AY)T-FXYYT‖2,(2)

其中:AY∈

Rs×u為訓練集類別-屬性關系矩陣,s為訓練集類別數,u為屬性個數;

F∈Ru×p為投影矩陣,p為特征維數;

XY∈Rp×f為訓練集樣本特征,f為樣本數;

Y∈Rs×f

為訓練集類別標簽。F的每一行

f(i=1,2,…,u)表示一種屬性,每一列f(d=1,2,…,p)

表示一維特征。通過在訓練和測試階段共享F,可隱式地反映訓練集和測試集中屬性與特征映射關系的一致性。圖1給出了訓練集中屬性矩陣三因子分解示意圖。

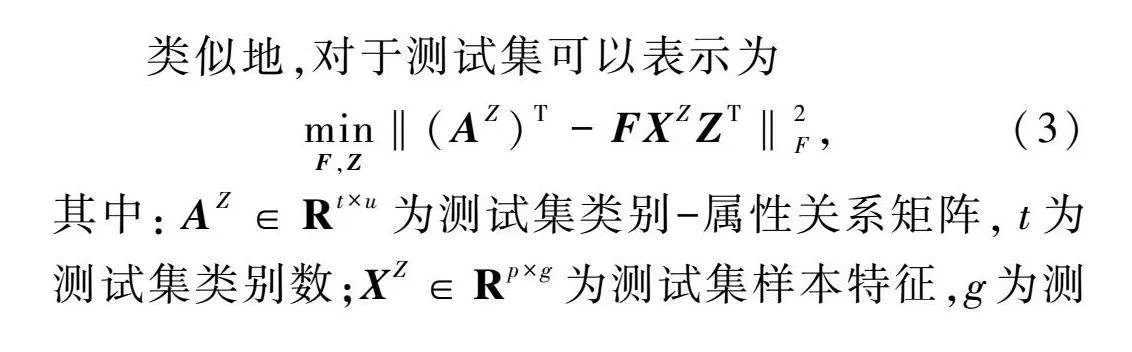

類似地,對于測試集可以表示為

minF,Z

‖(AZ)T-FXZ

ZT‖2,(3)

其中:AZ∈Rt×u為測試集類別-屬性關系矩陣,t為測試集類別數;

XZ∈Rp×g為測試集樣本特征,g為測試集樣本數;

Z∈Rt×g為測試集類別標簽。

1.2屬性關系有向圖構建

為了更好地發揮屬性在訓練集與測試集之間的橋梁作用,需要充分挖掘屬性之間的關系。構建屬性關系有向圖能夠挖掘屬性空間的幾何結構,從而更好地考慮屬性之間的相關性和差異性。

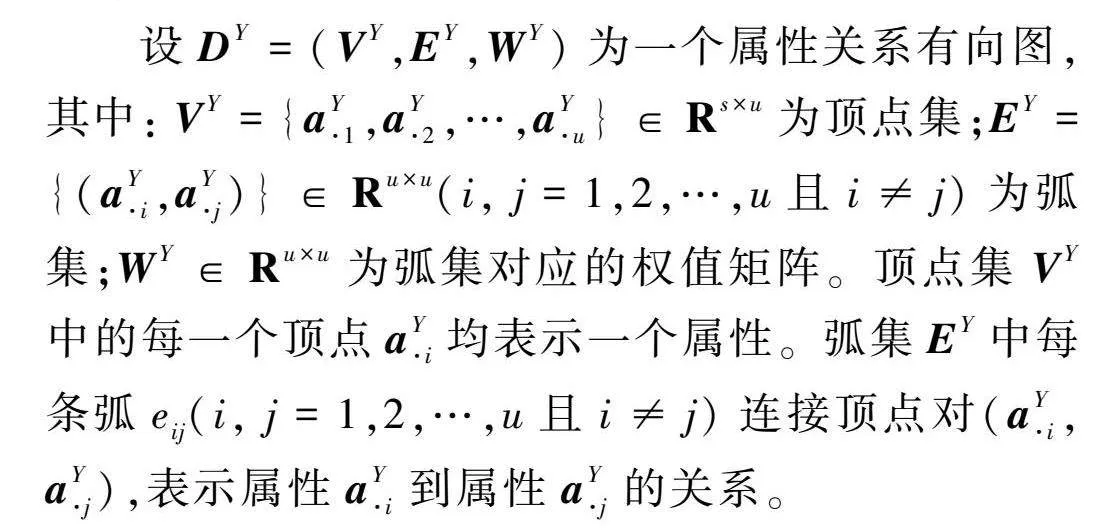

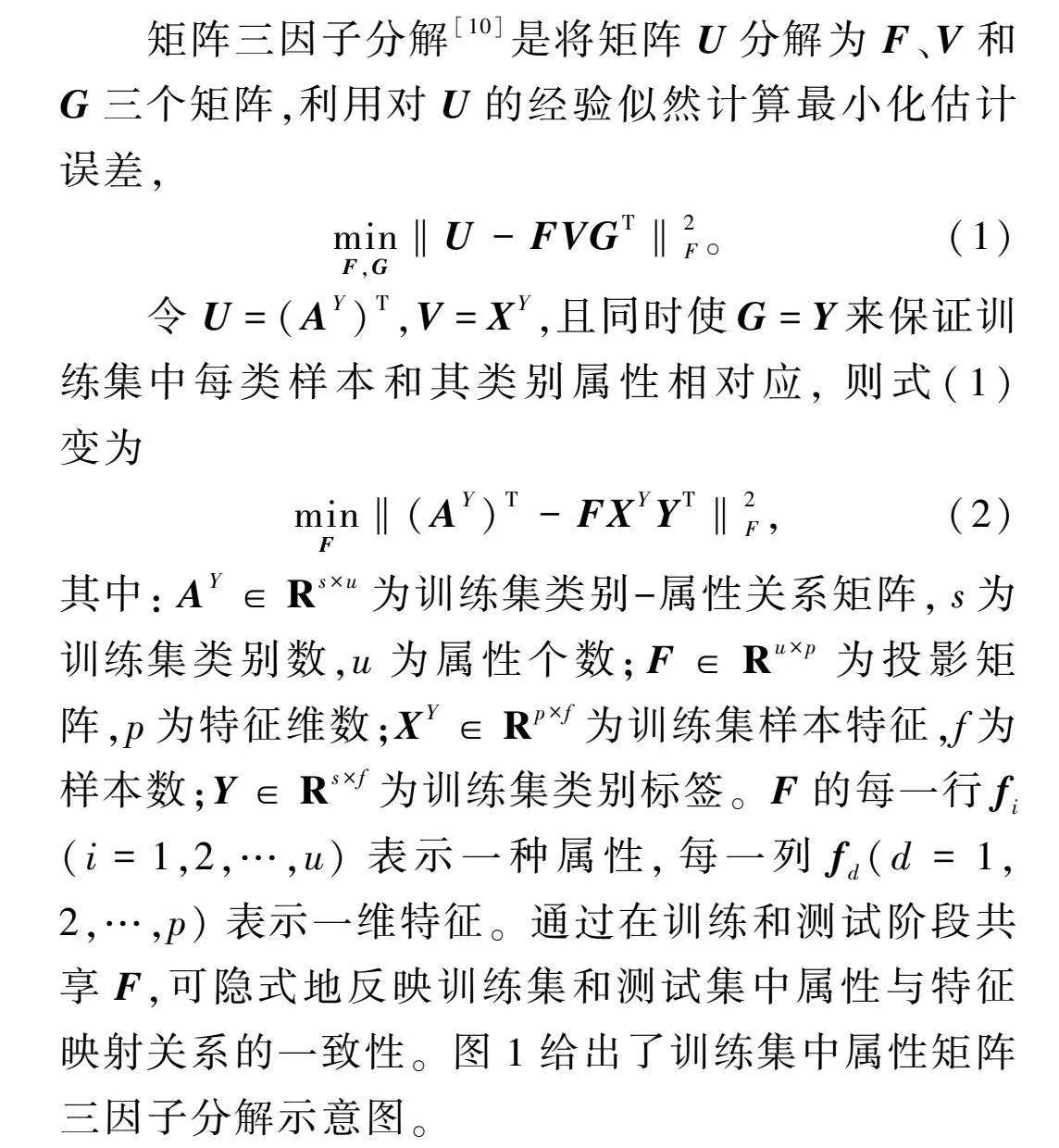

圖2為屬性關系有向圖。由于圖中任意兩個屬性之間都具有一對非零權值,因此屬性關系有向圖是強連通的。相比于無向圖,有向圖可以更好地獲得屬性對中兩個屬性之間的差異。屬性關系有向圖具體構建方法如下。

設DY=(VY,EY,WY)為一個屬性關系有向圖,其中:

VY=

{aY,aY,…,aY}

∈Rs×u為頂點集;EY=

{(aY,aY)}

∈Ru×u(i, j=1,2,…,u且i≠j)為弧集;

WY∈Ru×u

為弧集對應的權值矩陣。頂點集VY中的每一個頂點

aY均表示一個屬性。弧集EY中每條弧

e(i, j=1,2,…,u且i≠j)連接頂點對

(aY,

aY),表示屬性

aY到屬性

aY的關系。

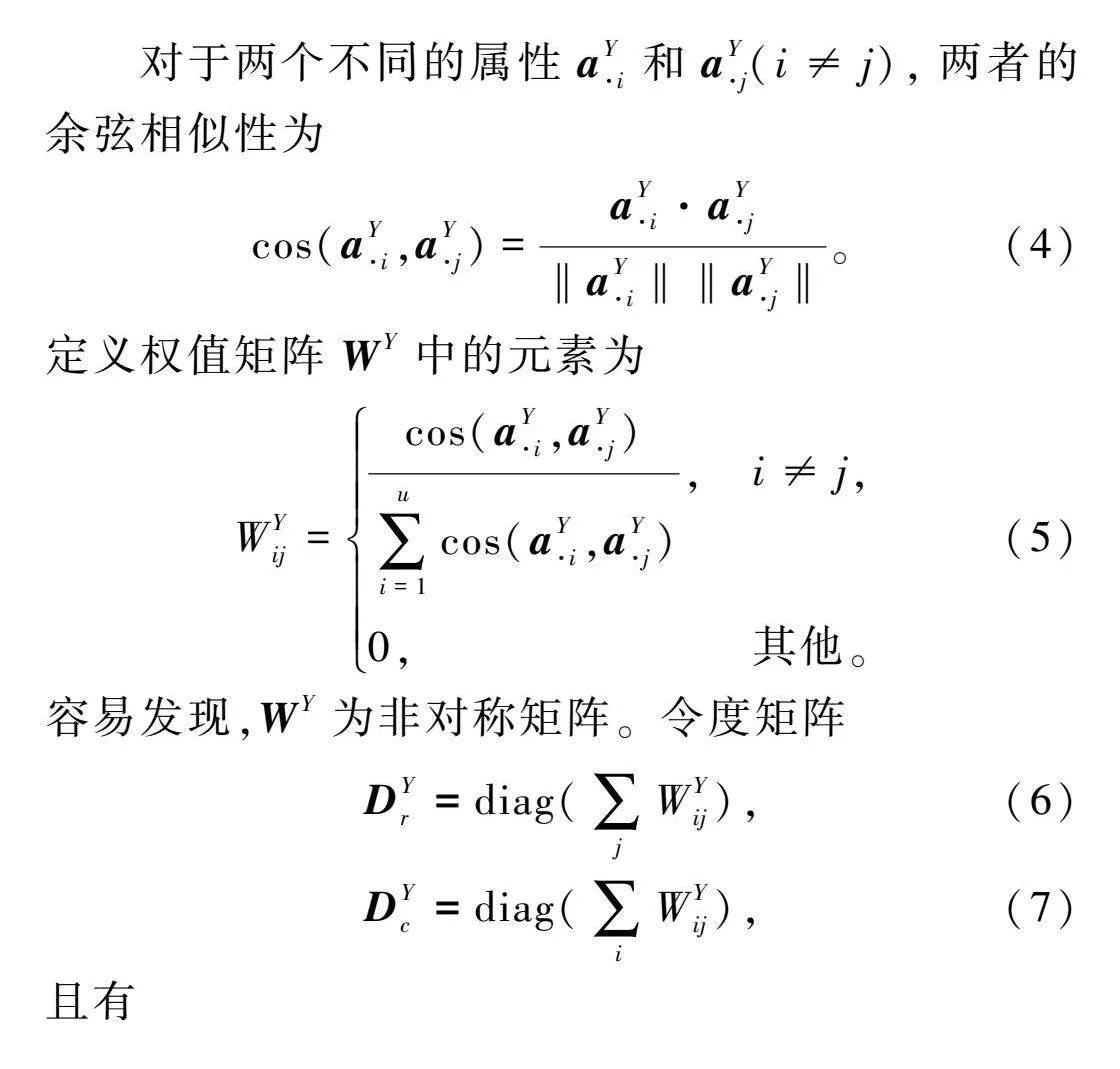

對于兩個不同的屬性aY和

aY(i≠j),兩者的余弦相似性為

cos(aY,

aY)=

aY·aY

‖aY‖‖aY‖。(4)

定義權值矩陣WY中的元素為

WY=

cos(aY,

aY)

∑ui=1

cos

(aY,aY),i≠j,

0,其他。(5)

容易發現,WY為非對稱矩陣。令度矩陣

DY=diag(∑jWY),(6)

DY=diag(∑iWY),(7)

且有

DY=12

(DY+DY),(8)

根據權值定義,有DY=I。則有向圖的拉普拉斯矩陣為

LY=

DY-WY=

12

(DY+DY)-

WY。(9)

如果屬性aY和aY在屬性空間A中距離相近,則它們在投影空間F中的映射向量

f和f也應該距離相近。因此,屬性有向圖正則項可以定義為

12

∑i,j‖

f-f‖2WY=

12

∑i,j,k(F-F)2WY=tr(FTLYF)。(10)

可以看出,屬性關系有向圖隱式地反映了屬性空間的幾何結構。

1.3屬性投影學習

結合式(2)與(10),即可得到基于有向圖正則化的屬性三因子分解模型。具體地,為學習屬性投影,模型目標函數可表示為

minF≥0‖

(AY)T-

FXYYT‖2+

λtr(FTLYF),

s.t.FT1=1,

(11)

其中:λ≥0為正則化系數,λ=0時表示沒有考慮屬性有向圖約束。1和1為元素全是1的列向量,對F的每一行進行歸一化約束使得優化更加精確[9]。以上基于有向圖正則化的屬性三因子分解模型中,第一項表示屬性與特征之間的映射關系,第二項則反映屬性空間的潛在幾何結構。由于該優化問題含有約束條件,通過采用拉格朗日乘子法在該式中添加拉格朗日函數后可得

minF

‖(AY)T-

FXYYT‖2+

λtr(FTLYF)+

tr(ΩY

(FT1-1)

(FT1-1)T),(12)

其中:ΩY∈Ru×u為拉格朗日乘子。

根據KKT(Karush-Kuhn-Tucker)補充條件[11],式(12)對F求偏導并令其值為0,得到關于F的更新規則為

F←F⊙

[

(AY)T

Y(XY)T+

λ2

(WY+

(WY)T)

F]

[FXYYT

Y(XY)T+

λDYF],

(13)

其中:⊙和[·]/[·]分別表示矩陣乘法和除法計算時按元素操作。

1.4零樣本圖像分類

通過式(13)的更新規則得到投影矩陣F后,給出測試樣本X∈XZ,

可在以下兩個空間中實現零樣本圖像分類。

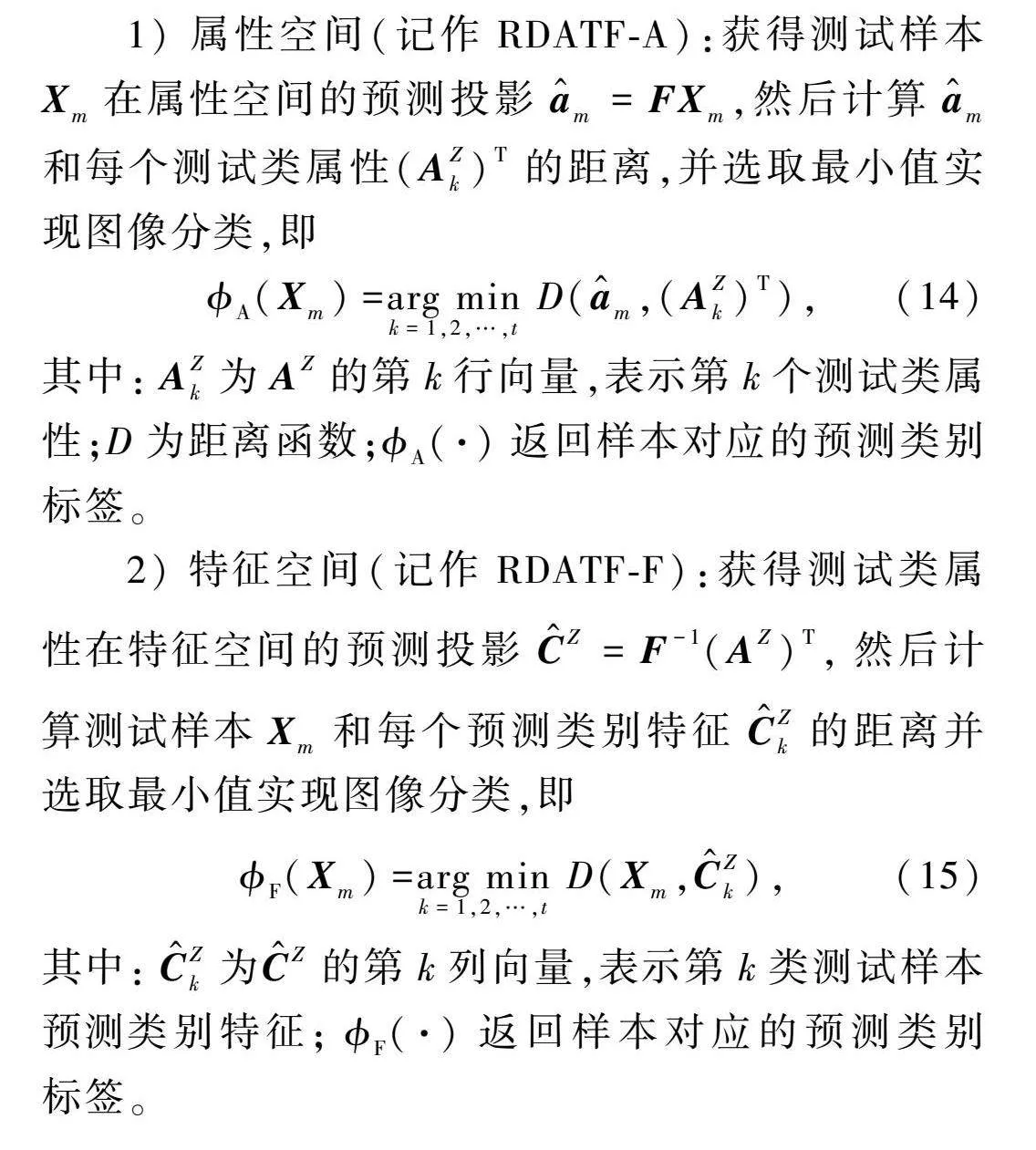

1) 屬性空間(記作RDATF-A):獲得測試樣本X在屬性空間的預測投影

a^=FX,然后計算

a^和每個測試類屬性

(AZ)T的距離,并選取最小值實現圖像分類,即

(X)=arg mink=1,2,…,t

D(a^,

(AZ)T),(14)

其中:AZ為AZ的第k行向量,表示第k個測試類屬性;D為距離函數;

A(·)返回樣本對應的預測類別標簽。

2) 特征空間(記作RDATF-F):獲得測試類屬性在特征空間的預測投影C^Z=

F-1

(AZ)T,然后計算測試樣本X和每個預測類別特征

C^Z的距離并選取最小值實現圖像分類,即

(X)=

arg mink=1,2,…,tD

(X,C^Z),(15)

其中:C^Z為

C^Z

的第k列向量,表示第k類測試樣本預測類別特征;(·)返回樣本對應的預測類別標簽。

2實驗結果與分析

2.1數據集與參數設置

實驗選取aPY和SUN兩個常用零樣本屬性數據集進行算法相關驗證,兩個數據集具有不同的規模和粒度,且在屬性和類別個數方面具有較大差異。aPY數據集是一個小規模的粗粒度數據集,選擇a-Pascal中的20類作為訓練集,a-Yahoo中的12類作為測試集。SUN數據集是一個中規模的細粒度數據集,選取其中的707類作為訓練集,10類作為測試集[12]。RDATF-A和RDATF-F模型中,僅有正則化系數λ對分類精度有影響,其在aPY數據集中分別取10和700,在SUN數據集中分別取10和50。

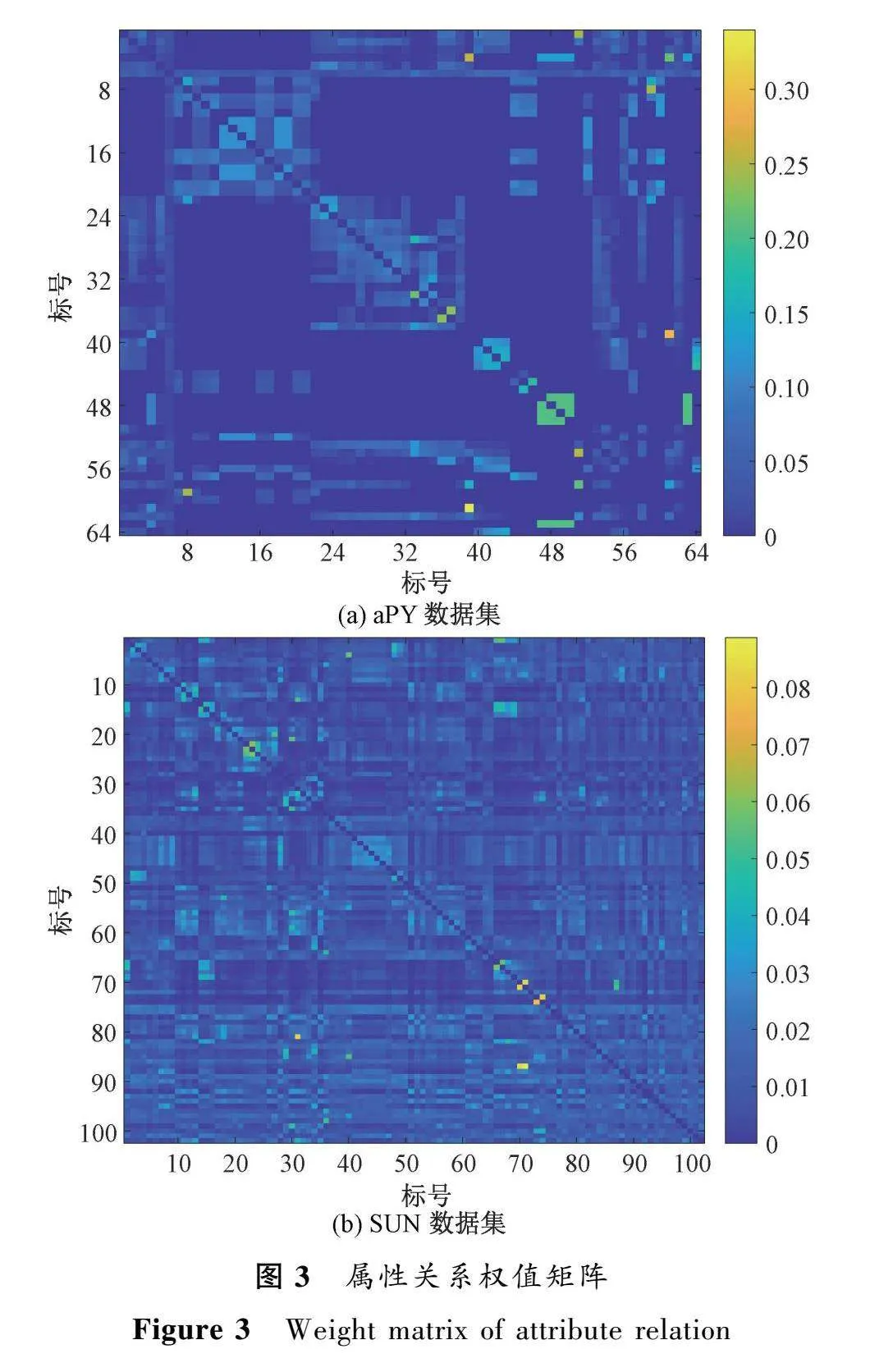

2.2屬性關系有向圖

利用數據集已知的類別-屬性關系,通過1.2節方法構建了屬性關系有向圖。圖3給出了屬性關系有向圖的權值矩陣WY。由1.2節易知,權值矩陣為u×u的非對稱矩陣,其取值范圍為[0,1)。圖中權值越趨近于0,表示對應屬性之間差異越大,越有利于區分圖像類別。反之,其數值越大,表示對應屬性之間相關性越強。可以看出,圖3中僅有部分區域數值趨近于0。這表明大部分屬性之間存在一定的相關性,充分挖掘這些屬性關系將有利于準確地進行圖像分類。

如圖3(a)所示,在aPY數據集的64個屬性中,權值矩陣最大值為0.3399,對應第61行39列,表明屬性clear(對應標號61)對屬性label(對應標號39)的相關性最大。查找第39行61列發現,label對clear的權值僅為0.2911,即label對clear的影響不如clear對label的大。類似情況廣泛存在于各屬性對之間。如圖3(b)所示,在SUN數據集的102個屬性中,權值矩陣最大值為0.0888,出現在第87行71列,對應屬性分別為cold和snow。同時,查看權值矩陣發現,snow對cold的權值僅為0.0515。上述結果表明,下雪的情況下大概率天氣會寒冷,但寒冷時不一定下雪,這與實際情況是相符的。綜合以上分析可知,這種屬性關系的挖掘更加符合人類通過屬性對類別進行劃分的認知和理解。權值矩陣的不對稱性體現了不同屬性之間相互影響力的不同。此外,aPY數據集屬性關系權值矩陣中的元素值整體要比SUN數據集中的數值大得多。這是由于aPY數據集中的屬性個數少于SUN數據集,因此屬性之間的相互關系整體較強,對應權值也就越大。

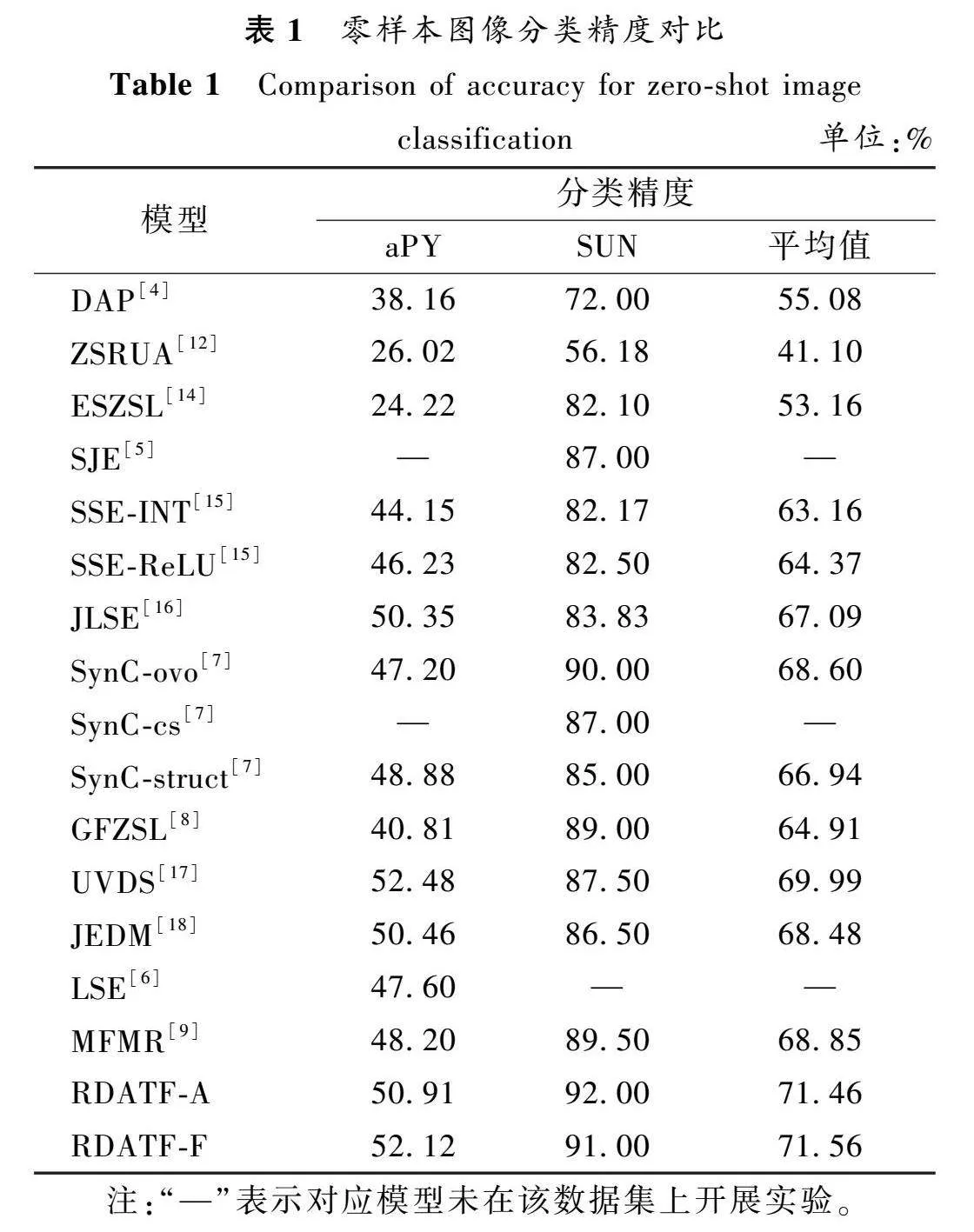

2.3屬性投影的影響

在屬性矩陣三因子分解過程中,屬性投影實現了屬性空間和特征空間的映射關系。為了更好地反映屬性投影的作用,利用t-SNE[13]將測試樣本在屬性空間的投影進行了可視化,結果如圖4所示。為清晰起見,兩個數據集均隨機選擇了一半測試類別進行展示。

圖4(a)給出了aPY數據集中6類測試樣本預測屬性的分布情況。可以看出,絕大部分樣本均較好地實現了聚類,僅有monkey和jetski類中的少部分樣本存在重疊。圖4(b)給出了SUN數據集中5類測試樣本預測屬性的分布情況。可以看出,outhouse和mineshaft、chemical_plant類存在少量混淆。其他未展示的測試類別均呈現出相似的規律。以上分析表明,通過RDATF模型學習到的屬性投影獲得了較好的樣本預測屬性。

2.4零樣本圖像分類

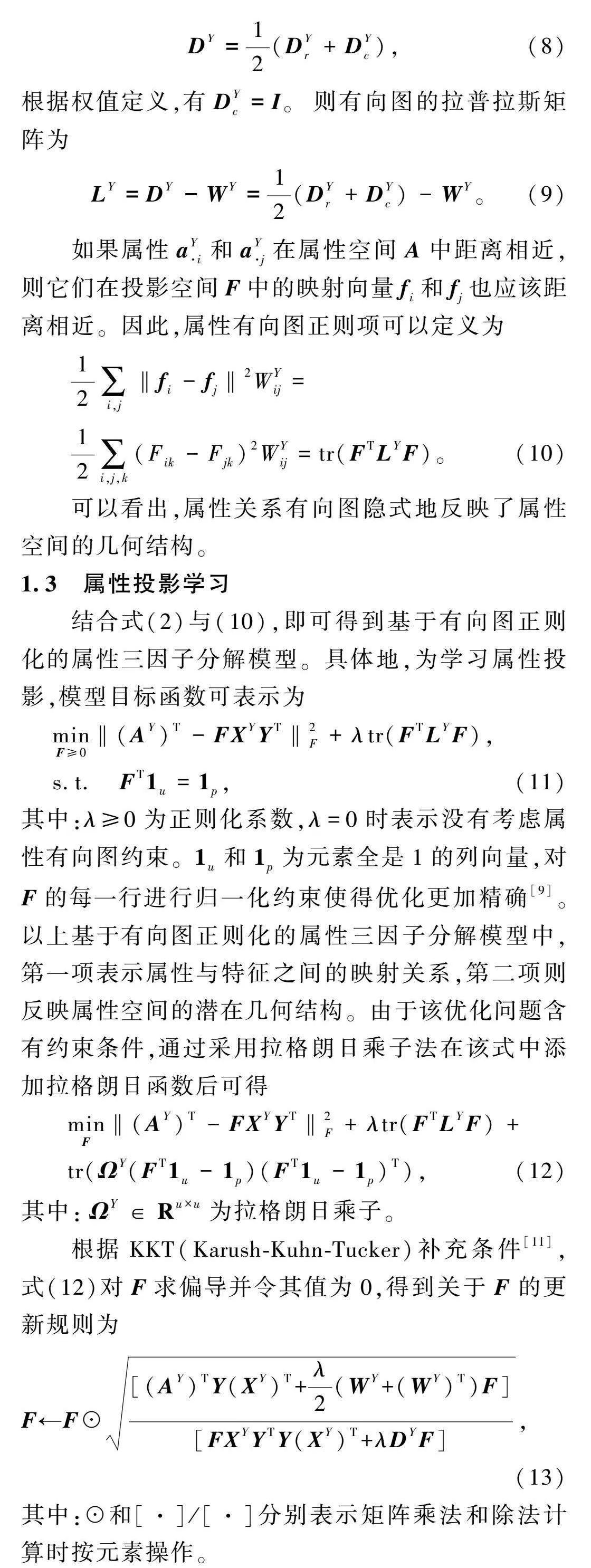

為驗證本文模型(RDATF-A、RDATF-F)對零樣本圖像分類的有效性,分別在aPY和SUN數據集上設置15種對比實驗。表1給出了17種模型在aPY數據集和SUN數據集上零樣本圖像分類精度結果。從表1可以得出以下結論。

1) 表中模型可分為三類:DAP、ZSRUA、ESZSL和SJE僅學習特征到語義的映射;SSE、JLSE、SynC、GFZSL、UVDS、JEDM和LSE考慮兩者之間的關系;

RDATF-A、RDATF-F和MFMR利用矩陣三因子分解獲得屬性與特征空間映射。在兩個數據集上,第一類模型分類精度相對較低,第二類模型居中,RDATF-A、RDATF-F等第三類模型分類精度整體最高。這說明,相較于學習特征到語義的單向映射,考慮兩者之間的關系更有利于提高分類精度。本文模型分類精度整體最高,這主要得益于測試類通過投影矩陣共享充分利用了訓練得到的映射關系。也就是說,利用矩陣三因子分解可以學習到更好的屬性與特征空間映射。

2) 在兩個數據集上,RDATF-A和RDATF-F的分類精度均高于MFMR,說明屬性關系有向圖更好地挖掘了屬性間的相關性和差異性,更有利于區分相近類別。

3) 在SUN數據集上,RDATF-A和RDATF-F分別獲得了最優和次優分類精度;在aPY數據集上,RDATF-F和RDATF-A分類精度僅略低于UVDS。由于aPY數據集中屬性和類別個數要少得多,導致本文模型構建屬性關系有向圖的作用發揮得不夠充分。相比之下,UVDS由于合成不可見視覺數據時考慮了同類樣本的過擬合問題,因而在aPY數據集上的分類精度略高于RDATF。

4) RDATF-F和RDATF-A分別在特征空間和屬性空間實現了零樣本圖像分類。RDATF-F在aPY數據集上的分類精度高于RDATF-A,但在SUN數據集上卻相反。這說明在不同數據集上進行零樣本圖像分類時,預測標簽結果與所選取的計算空間緊密相關。相比SUN數據集,aPY數據集采用的特征維數更多、屬性個數較少,因而在特征空間的預測結果要優于屬性空間。

5) 所有模型在SUN數據集上的分類結果均遠高于aPY數據集。相較于aPY數據集,SUN數據集中的訓練集類別數遠大于測試集,使得各類模型均學習到更多的數據信息,因而具有更高的分類精度。

6) RDATF-A和RDATF-F既采用屬性三因子分解獲得了屬性與特征的映射關系,又通過屬性關系有向圖挖掘了屬性間的關系,因而在兩個數據集中均達到了較高精度。

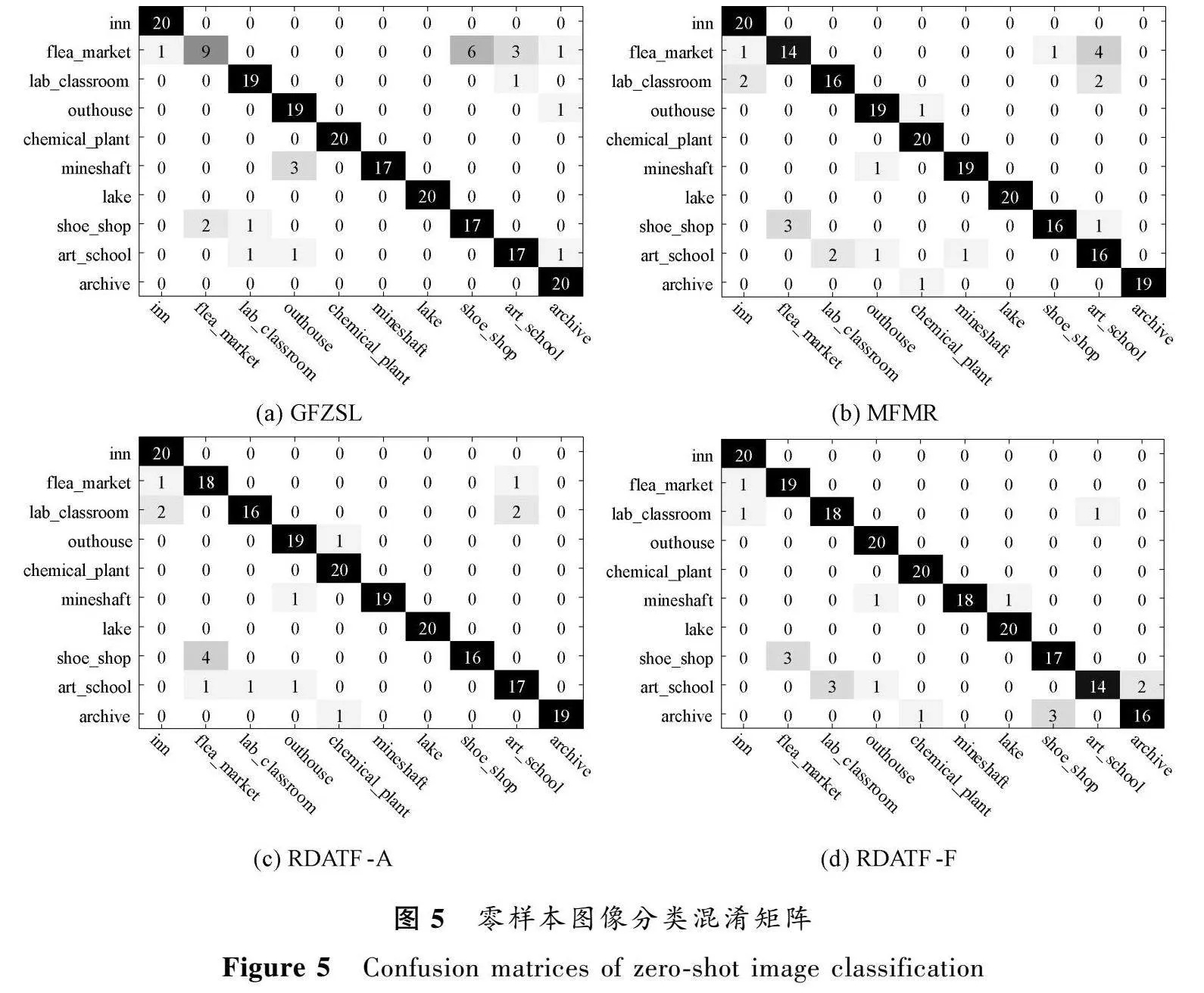

分類精度僅能反映正確分類的樣本數占測試樣本總數的比例,無法體現每個測試類的具體情況。為此,圖5分別給出了GFZSL、MFMR、RDATF-A和RDATF-F模型在SUN數據集上的零樣本圖像分類混淆矩陣。

通過對比圖5 (a)~(d)可以看出,對于10個測試類,RDATF-A模型在mineshaft和art_school類中分別分對了19和17幅,高于其他模型;RDATF-F模型在flea_market、outhouse和shoe_shop類中分別分對了19、20和17幅,均為所有模型中最高。同時,RDATF-F模型在inn、outhouse、chemical_plant和lake類別上分類精度均達到100%。綜上分析,RDATF模型總體上取得了較好的分類結果。

3結語

屬性在零樣本圖像分類問題中起著連接訓練集和測試集的關鍵作用,因此屬性與特征之間的映射關系以及屬性空間結構均對分類效果具有重要影響。為構建更加合理的屬性與特征映射關系并充分挖掘屬性空間結構,本文提出了基于關系有向圖正則化的屬性三因子分解模型,主要優點如下:

1) 采用屬性三因子分解實現了屬性和特征空間的映射,并通過在訓練和測試階段共享投影因子提高了映射關系的泛化能力;

2) 利用屬性關系有向圖更加細致地刻畫了屬性之間的差異性,充分挖掘了屬性空間的幾何結構。

未來研究可將所提模型進一步擴展到直推式零樣本圖像分類中,通過緩解領域偏移問題有效提升分類效果。

參考文獻:

[1]XIE G S, ZHANG Z, XIONG H, et al. Towards zero-shot learning: a brief review and an attention-based embedding network[J]. IEEE transactions on circuits and systems for video technology, 2023, 33(3): 1181-1197.

[2]吳蘭, 李崇陽. 深度加權子域自適應網絡[J]. 鄭州大學學報(理學版), 2022, 54(1): 54-61.

WU L, LI C Y. Deep-weight subdomain adaptive network [J]. Journal of Zhengzhou university (natural science edition), 2022, 54(1): 54-61.

[3]彭濤, 鄭傳錕, 張自力, 等. 基于時空特征融合的語音情感識別[J]. 鄭州大學學報(理學版), 2022, 54(4): 42-48.

PENG T, ZHENG C K, ZHANG Z L, et al. Speech emotion recognition based on spatio-temporal feature fusion [J]. Journal of Zhengzhou university (natural science edition), 2022, 54(4): 42-48.

[4]LAMPERT C H, NICKISCH H, HARMELING S. Attribute-based classification for zero-shot visual object categorization[J]. IEEE transactions on pattern analysis and machine intelligence, 2014, 36(3): 453-465.

[5]AKATA Z, REED S, WALTER D, et al. Evaluation of output embeddings for fine-grained image classification[C]∥IEEE Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE Press, 2015: 2927-2936.

[6]YU Y L, JI Z, GUO J C, et al. Zero-shot learning via latent space encoding[J]. IEEE transactions on cybernetics, 2019, 49(10): 3755-3766.

[7]CHANGPINYO S, CHAO W L, GONG B Q, et al. Synthesized classifiers for zero-shot learning[C]∥IEEE Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE Press, 2016: 5327-5336.

[8]VERMA V K, RAI P. A simple exponential family framework for zero-shot learning[C]∥Joint European Conference on Machine Learning and Knowledge Discovery in Databases. Cham: Springer International Publishing, 2017: 792-808.

[9]XU X, SHEN F M, YANG Y, et al. Matrix tri-factorization with manifold regularizations for zero-shot learning[C]∥IEEE Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE Press, 2017: 2007-2016.

[10]DING C, LI T, PENG W, et al. Orthogonal nonnegative matrix t-factorizations for clustering[C]∥Proceedings of the 12th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. New York: ACM Press, 2006: 126-135.

[11]BOYD S P, VANDENBERGHE L. Convex optimization[M]. New York: Cambridge University Press, 2004.

[12]JAYARAMAN D, GRAUMAN K. Zero-shot recognition with unreliable attributes [C]∥27th International Conference on Neural Information Processing Systems. Cambridge: MIT Press, 2014: 3464-3472.

[13]MAATEN L. Accelerating t-SNE using tree-based algorithms[J]. Journal of machine learning research, 2014, 15(1): 3221-3245.

[14]ROMERA-PAREDES B, TORR P H S. An embarrassingly simple approach to zero-shot learning[C]∥Proceedings of the 32nd International Conference on International Conference on Machine Learning. New York: ACM Press, 2015: 2152-2161.

[15]ZHANG Z M, SALIGRAMA V. Zero-shot learning via semantic similarity embedding[C]∥IEEE International Conference on Computer Vision. Piscataway:IEEE Press, 2016: 4166-4174.

[16]ZHANG Z M, SALIGRAMA V. Zero-shot learning via joint latent similarity embedding[C]∥IEEE Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE Press, 2016: 6034-6042.

[17]LONG Y, LIU L, SHEN F M, et al. Zero-shot learning using synthesised unseen visual data with diffusion regularisation[J]. IEEE transactions on pattern analysis and machine intelligence, 2018, 40(10): 2498-2512.

[18]YU Y L, JI Z, LI X, et al. Transductive zero-shot learning with a self-training dictionary approach[J]. IEEE transactions on cybernetics, 2018, 48(10): 2908-2919.