基于深度神經網絡的紅外與可見光圖像融合算法研究

摘要:該文提出并優化了一種基于深度神經網絡的紅外與可見光圖像融合算法,采用感知損失和對抗性訓練兩種優化策略。經實驗驗證,優化算法在圖像質量上超越傳統方法。感知損失提高了融合圖像的清晰度和語義信息,對抗性訓練增強了真實感和細節保留。這一研究為紅外與可見光圖像融合領域引入了先進的深度學習方法,為相關領域的技術應用提供了有力支持。

關鍵詞:圖像融合;深度神經網絡;感知損失;對抗性訓練

doi:10.3969/J.ISSN.1672-7274.2024.10.012

中圖分類號:TP 391.41 文獻標志碼:B 文章編碼:1672-7274(2024)10-00-03

Research on Infrared and Visible Light Image Fusion Algorithm

Based on Deep Neural Networks

Abstract: This article proposes and optimizes an infrared and visible light image fusion algorithm based on deep neural networks, using two optimization strategies: perceptual loss and adversarial training. Through experimental verification, the optimization algorithm surpasses traditional methods in image quality. Perceived loss improves the clarity and semantic information of fused images, while adversarial training enhances realism and detail preservation. This study introduces advanced deep learning methods into the field of infrared and visible light image fusion, providing stxi4UZGpiK0aCgt4U9Fm82PlT0Xn27x8QSobKu1p8LQI=rong support for technical applications in related fields.

Keywords: image fusion; deep neural networks; perceived loss; adversarial training

1 研究背景

紅外與可見光圖像融合技術在軍事、醫療、環境監測等領域有廣泛應用。深度神經網絡以其強大的特征學習能力和對復雜模式的高度抽象能力脫穎而出。在圖像融合中,深度神經網絡的應用有望提高圖像融合的準確性和魯棒性[1]。

本文通過對融合算法進行挑選,并且進行針對性優化,優化方法涉及參數調整、數據增強、損失函數的改進以及硬件加速的利用。通過實驗與性能對比,本研究旨在驗證優化方法的有效性,并為深度神經網絡在紅外與可見光圖像融合中的應用提供實際指導。

2 圖像融合算法選擇與設計

過去的研究中,已經提出了多種紅外與可見光圖像融合的算法,每種算法都有其獨特的優缺點。深度神經網絡在圖像融合領域的應用呈現出日益增長的趨勢[2]。一些典型的網絡結構如UNet、FusionNet等,以其強大的特征提取和圖像重建能力成為研究熱點[3]。綜合考慮,本文選擇UNet作為基礎圖像融合算法的主要原因在于其卓越的性能在語義分割任務中得到了驗證。

2.1 UNet網絡結構

UNet的網絡架構主要分為編碼器和解碼器兩個部分,組成U形結構,使其適用于圖像融合任務。

(1)編碼器(下采樣部分):在編碼器的每一層中的第i層的特征圖,首先對其進行卷積操作(Convolution)以提取特征,然后進行最大池化操作(Pooling)以降低分辨率。

式中,ReLU(Rectified Linear Unit)是一種激活函數,用于神經網絡中的每個神經元。ReLU激活函數的數學表達式簡單來說,對于輸入x,如果x大于零,ReLU返回x;如果x小于或等于零,則返回零。從圖形上看,ReLU函數在x大于零時是一條直線,斜率為1;而在x小于等于零時,函數值為零。

(2)解碼器(上采樣部分):解碼器的每一層包含上采樣、特征圖拼接和卷積操作。

式中,Concatenate表示將當前解碼器層與對應的編碼器層進行通道拼接,通過卷積操作進一步提取特征。上采樣通過插值方法將特征圖的分辨率提高,與低分辨率的編碼器特征進行融合,從而保留更多的細節信息。通過層層堆疊和連接,UNet實現了對輸入圖像的逐層編碼和逐層解碼,保留了豐富的語義信息。

2.2 UNet在紅外與可見光圖像融合中的適應性

2.2.1 通道融合機制

在通道融合階段,UNet通過通道拼接將編碼器和解碼器的特征圖結合起來。

式中,表示將編碼器和解碼器的特征圖進行通道拼接;為權重矩陣;為偏置;為激活函數。通道融合機制有助于網絡更好地理解紅外與可見光圖像之間的相關性。

2.2.2 適應性損失函數

適應性損失函數是為了引導網絡學習編碼器和解碼器之間更適應性的特征表示而設計的。在紅外與可見光圖像融合任務中,由于兩種圖像具有不同的傳感器特性和物理特性,學習如何適應性地融合這兩者的信息是關鍵。

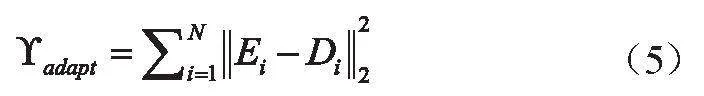

適應性損失函數通過計算編碼器和解碼器各層特征圖之間的歐幾里得距離來量化它們之間的差異。設為編碼器的第i層特征圖,為解碼器的第i層特征圖,適應性損失函數的表達式為

式中,表示歐幾里得距離,度量了編碼器和解碼器在第i層特征上的相似性。這個損失函數的目標是最小化特征圖之間的差異,從而使網絡更好地適應不同層次的信息。通過加入適應性損失,網絡被迫學習更具適應性的特征表示,有助于處理紅外與可見光圖像的差異,提升融合效果。

2.2.3 整體目標函數

整體目標函數綜合考慮了均方誤差損失和適應性損失,以綜合性的方式引導網絡學習更好的圖像融合特征表示。

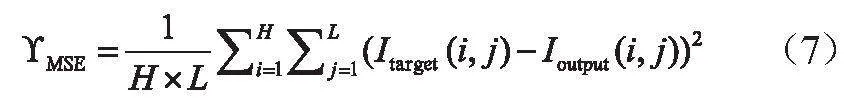

式中,為均方誤差損失函數,該損失衡量了網絡生成圖像與真實圖像之間的差異,它促使網絡學習產生與真實圖像相似的融合結果。均方誤差損失的表達式為

式中,是真實的融合圖像;是網絡生成的融合圖像;和分別是圖像的高度和寬度。

整體目標函數用于權衡均方誤差損失和適應性損失,其中是一個用于平衡兩者重要性的超參數。整體目標函數的最小化旨在使網絡在圖像融合任務中既能夠生成高質量的融合圖像,又能夠學習適應性更強的特征表示,以更好地處理紅外與可見光圖像的異質性。

3 算法優化方法

本文的主要優化方法集中在改進損失函數上。這一優化方法同時服務于提高圖像融合質量和減小計算復雜度的目標,通過更精細地約束網絡的學習過程,提高算法的性能和實際應用的效果。

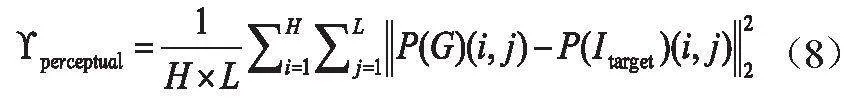

3.1 引入感知損失

為了引入感知損失,本文在網絡中添加感知層,該層基于預訓練的卷積神經網絡(如VGG16)中的中間層特征。感知損失衡量了生成圖像和真實圖像在感知層上的特征差zELX59TBc/Jy/zyE9G+/1w==異。具體而言,對于感知層上的每個位置,感知損失計算特征的歐幾里得距離表達式如下:

式中,和分別表示生成圖像和真實圖像在感知層上的特征表示。通過最小化感知損失,網絡被迫更加關注圖像的感知質量,以更自然、真實地融合紅外與可見光圖像。

3.2 對抗性訓練

對抗性訓練引入了判別器網絡,旨在使生成圖像和真實圖像在判別器層上難以區分。判別器的目標是最小化真實圖像和生成圖像之間的差異,而生成器則追求最大程度地欺騙判別器。對抗性訓練的損失函數表達式如下:

式中,表示判別器對真實圖像的判別概率;表示判別器對生成圖像的判別概率。通過最小化生成器和判別器之間的對抗性損失,網絡被迫學習生成更逼真、更真實的圖像,提高了生成圖像的質量。這種對抗性訓練機制有助于使生成圖像更符合真實圖像的分布,從而提升圖像融合效果。

4 算法實現及實驗

4.1 優化方法的引入

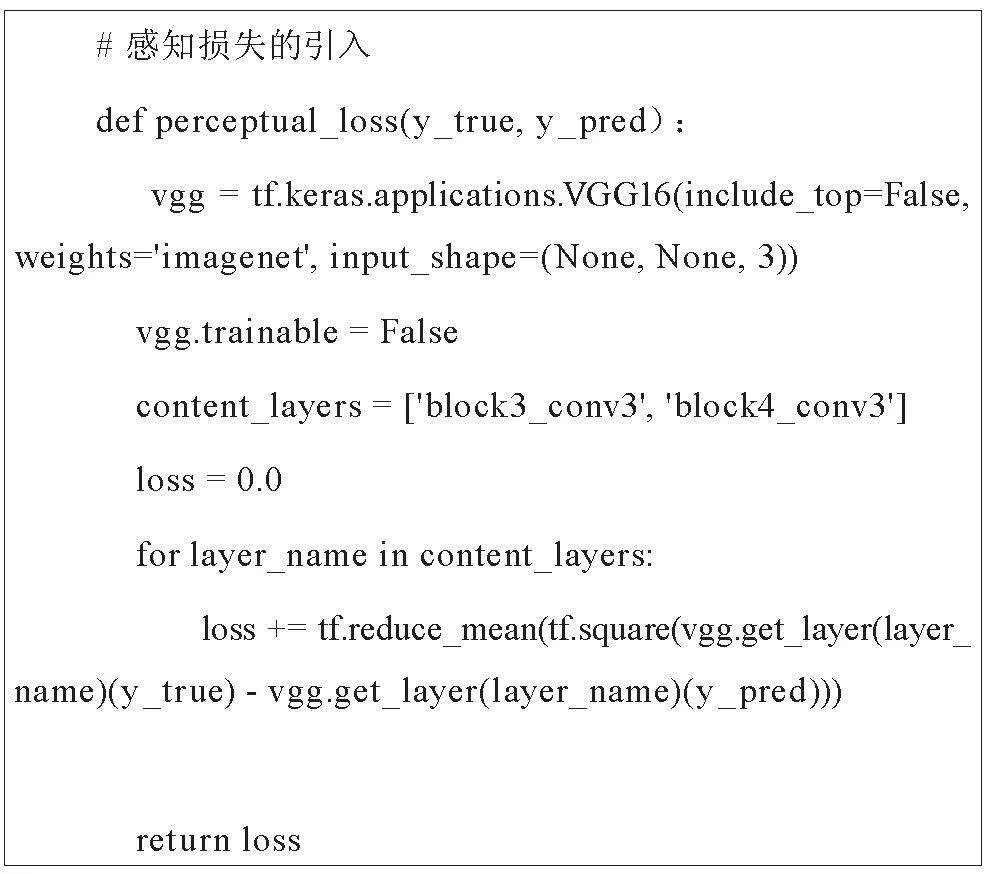

4.1.1 感知損失的引入

本文選擇一種主流深度學習框架TensorFlow,使用框架提供的API或自定義UNet網絡結構。這段代碼實現了感知損失的引入,主要通過加載預訓練的VGG16模型,選擇特定卷積層作為感知層,并計算生成圖像和真實圖像在這些感知層上的特征差異。

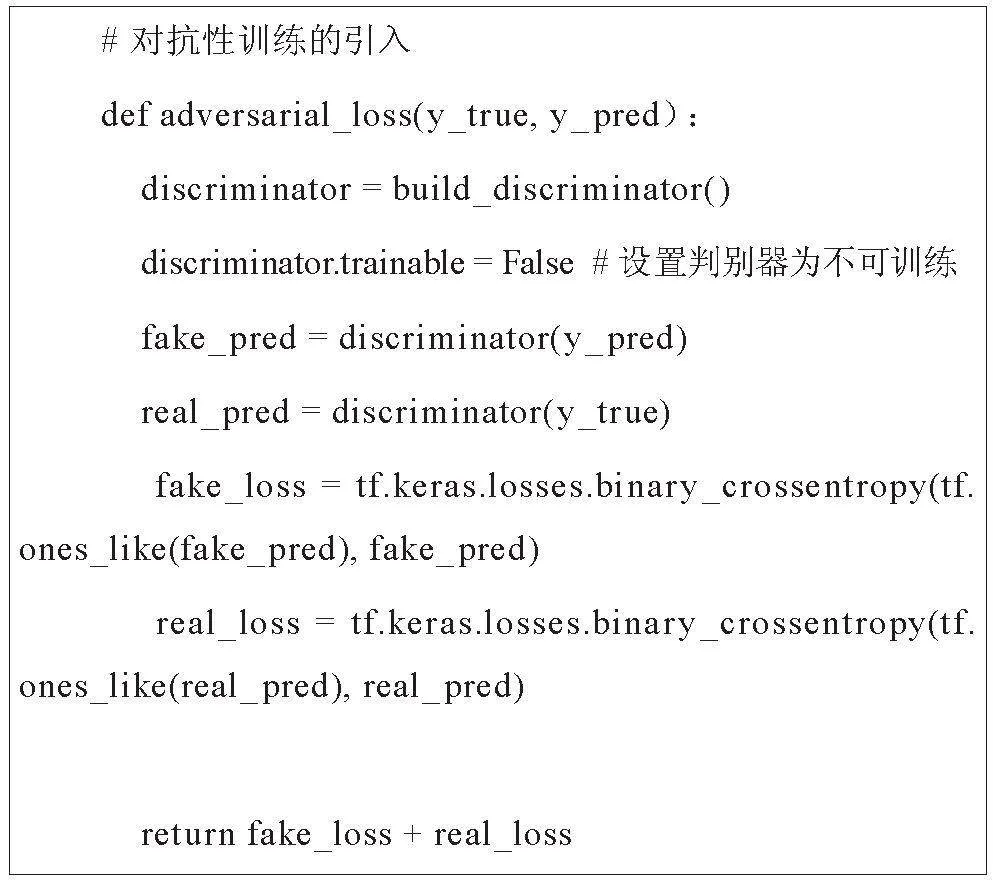

4.1.2 對抗性訓練的引入

上述代碼段實現了對抗性訓練中的對抗損失,其核心思想是通過訓練生成器來生成更具迷惑性、更逼真的圖像,以欺騙判別器。

(1)構建了一個判別器模型,其目標是對輸入的圖像進行二分類,將真實圖像判別為“真”(real)而將生成圖像判別為“假”(fake)。通過將判別器的可訓練屬性設為不可訓練,確保在對抗性訓練中僅關注生成器的優化。

(2)計算了生成圖像和真實圖像通過判別器后的預測結果,并使用二元交叉熵損失來量化生成圖像欺騙判別器的能力。生成圖像的對抗損失旨在使判別器更容易將其分類為“真”,而真實圖像的對抗損失則使判別器更容易將其分類為“真”。

(3)通過將兩者相加,形成了最終的對抗性訓練損失,該損失用于生成器的訓練過程,推動生成器生成更逼真的圖像,以應對判別器的分類挑戰。這一對抗性訓練的機制有助于提升生成器的圖像生成能力。

4.2 對比實驗

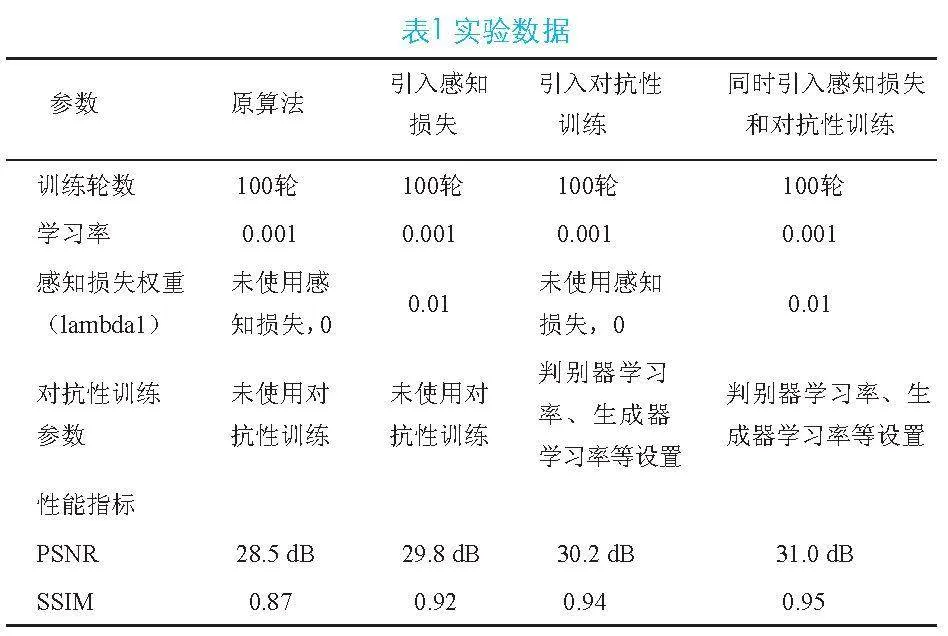

筆者進行了四組對比實驗,具體實驗參數和數據,如表1所示。

實驗數據表明,引入感知損失和對抗性訓練的算法配置相較于原算法在PSNR和SSIM上均表現更優。同時引入這兩種優化策略進一步提高了圖像質量,PSNR達到31.0 dB,SSIM達到0.95。

5 結束語

本文提出并優化了一種紅外與可見光圖像融合算法,引入了感知損失和對抗性訓練。實驗證明,感知損失和對抗性訓練的協同作用有效提高了融合圖像的清晰度、真實感和細節保留。該研究為紅外與可見光圖像融合領域提供了一種先進的深度學習方法,可為相關應用和技術的進一步發展提供參考。

參考文獻

[1] 王欣雨,劉慧,朱積成,等.基于高低頻特征分解的深度多模態醫學圖像融合網絡[J].圖學學報,2024(1):65-67.

[2] 徐慧琳,趙鑫,于波.一種基于梯度殘差網絡的紅外與可見光圖像融合算法[J].寧夏師范學院學報,2023,44(10):104-112.

[3] 王恩龍,李嘉偉,雷佳,等.基于深度學習的紅外可見光圖像融合綜述[J].計算機科學與探索2024,18(4):899-915.