基于輕量化Transformer模型的多變量風(fēng)電功率預(yù)測(cè)

摘 要:風(fēng)電功率預(yù)測(cè)對(duì)電力調(diào)度和新能源管理極為重要。為準(zhǔn)確高效預(yù)測(cè)多變量風(fēng)電功率,提出一種基于輕量化Transformer(Light Transformer)的風(fēng)電功率預(yù)測(cè)方法。首先,采用滾動(dòng)序列建模方法,確定輸入數(shù)據(jù),然后采用Transformer預(yù)測(cè)模型,改進(jìn)和精簡(jiǎn)原始結(jié)構(gòu),在前饋網(wǎng)絡(luò)模塊中使用GeLU激活函數(shù)來(lái)代替?zhèn)鹘y(tǒng)的ReLU激活函數(shù),提升模型的質(zhì)量,輕量化網(wǎng)絡(luò)結(jié)構(gòu),利用多頭注意力機(jī)制,加快模型訓(xùn)練速度,提升預(yù)測(cè)模型精度。

關(guān)鍵詞:輕量化Transformer模型;風(fēng)電功率;激活函數(shù)

中圖分類號(hào):TP391 文獻(xiàn)標(biāo)識(shí)碼:A 文章編號(hào):2096-4706(2024)16-0141-05

Multivariate Wind Power Prediction with Lightweight Transformer Model

Abstract: Wind power prediction is extremely important for power dispatching and new energy management. In order to accurately and efficiently predict the multivariate wind power, a wind power prediction method based on Light Transformer is proposed. Firstly, the rolling sequence modeling method is used to determine the input data, and then the Transformer prediction model is used to improve and streamline the original structure and use the GeLU Activation Function instead of the traditional GeLU Activation Function in the feed-forward network module to improve the quality of the model. It lightens the network structure, utilizes the multi-attention mechanism, accelerates the training speed of the model and improves the accuracy of the prediction model.

Keywords: Lightweight Transformer model; wind power; Activation Function

0 引 言

為深入落實(shí)“雙碳”目標(biāo)任務(wù),風(fēng)電功率成為加快推進(jìn)能源綠色低碳轉(zhuǎn)型的整的重要保障。因風(fēng)力發(fā)電的隨機(jī)性、波動(dòng)性和不穩(wěn)定性特點(diǎn),直接影響了風(fēng)電的消納,進(jìn)而在風(fēng)電大規(guī)模并網(wǎng)時(shí),將對(duì)電網(wǎng)系統(tǒng)的穩(wěn)定運(yùn)行及電力系統(tǒng)做出合理的調(diào)度決策帶來(lái)挑戰(zhàn)[1]。因此,準(zhǔn)確可靠的風(fēng)電功率預(yù)測(cè)對(duì)于新型電網(wǎng)系統(tǒng)的安全穩(wěn)定運(yùn)行以及提高風(fēng)電場(chǎng)管理調(diào)度具有重要意義[2]。

目前,已有多數(shù)學(xué)者對(duì)風(fēng)電功率預(yù)測(cè)做了深入研究,并且在短期風(fēng)電功率預(yù)測(cè)方面取得了顯著成果。隨著人工智能的興起發(fā)展,深度神經(jīng)網(wǎng)絡(luò)在擬合風(fēng)電功率隨機(jī)波動(dòng)能力不斷提高。因此,BP模型、LSTM模型和GRU模型在風(fēng)電功率預(yù)測(cè)方面有了大量的應(yīng)用。文獻(xiàn)[3]利用改進(jìn)序列到序列的LSTM構(gòu)建超短期風(fēng)電功率預(yù)測(cè)模型,文獻(xiàn)[4]采用CNN對(duì)數(shù)據(jù)進(jìn)行深層特征提取,然后將其送入到GRU進(jìn)行風(fēng)電功率預(yù)測(cè)。文獻(xiàn)[5]建立CNN-BiGRU模型進(jìn)行特征挖掘,再利用ISSA對(duì)模型參數(shù)智能尋優(yōu)。文獻(xiàn)[6]提出基于偏自相關(guān)函數(shù)和BiLSTM神經(jīng)網(wǎng)絡(luò)的預(yù)測(cè)方法進(jìn)行風(fēng)電功率預(yù)測(cè)。上述方法中采用的LSTM、GRU以及BiLSTM網(wǎng)絡(luò)由于自身串行結(jié)構(gòu)的限制,只能順序讀取序列數(shù)據(jù),容易出現(xiàn)梯度爆炸或梯度消失的問(wèn)題,從而難以捕捉長(zhǎng)期依賴關(guān)系。文獻(xiàn)[7]提出一種基于誤差修正的ILSTM短期風(fēng)電功率預(yù)測(cè)方法;文獻(xiàn)[8]為提高風(fēng)力發(fā)電功率短期預(yù)測(cè)的準(zhǔn)確度,提出一種將自適應(yīng)噪聲完備集成經(jīng)驗(yàn)?zāi)B(tài)分解與改進(jìn)TCN結(jié)合的短期風(fēng)電功率預(yù)測(cè)模型。文獻(xiàn)[9]采用動(dòng)態(tài)權(quán)重選擇、孤立森林算以及鄰近節(jié)點(diǎn)算法篩選并處理數(shù)據(jù),構(gòu)建多元注意力框架,提高模型預(yù)測(cè)精度。

Transformer模型由于編碼器-解碼器的結(jié)構(gòu)設(shè)計(jì)可以捕捉時(shí)間序列數(shù)據(jù)的全局依賴關(guān)系[10]。文獻(xiàn)[11]對(duì)離散化海上風(fēng)電機(jī)組進(jìn)行聚類,并采用Transformer模型進(jìn)行海上風(fēng)電功率的超短期預(yù)測(cè)。文獻(xiàn)[12]采用多級(jí)注意力機(jī)制捕捉風(fēng)電功率序列的自相關(guān)性以及功率與氣象數(shù)據(jù)間的耦合關(guān)系,并通過(guò)全連接層進(jìn)行點(diǎn)預(yù)測(cè)和區(qū)間預(yù)測(cè)。文獻(xiàn)[13]根據(jù)風(fēng)電出力的季節(jié)性特點(diǎn)劃分風(fēng)電功率大小不同的月份進(jìn)行測(cè),該方法需要更多的超參數(shù)且劃分較為粗糙,不具有普適性。

Transformer模型是一種強(qiáng)大的神經(jīng)網(wǎng)絡(luò)模型,已經(jīng)在自然語(yǔ)言處理、計(jì)算機(jī)視覺(jué)等領(lǐng)域取得了巨大突破。在風(fēng)電功率預(yù)測(cè)領(lǐng)域,也可以利用Transformer模型來(lái)進(jìn)行多變量風(fēng)電功率預(yù)測(cè)研究。傳統(tǒng)的方法通常采用基于統(tǒng)計(jì)模型或者人工智能模型,但是這些方法無(wú)法充分利用多變量之間的復(fù)雜關(guān)系。

綜上所述,通過(guò)Transformer模型可以構(gòu)建能處理多變量輸入的風(fēng)電功率預(yù)測(cè)方法。本文針對(duì)風(fēng)電預(yù)測(cè)中波動(dòng)性和隨機(jī)性帶來(lái)的風(fēng)電功率預(yù)測(cè)精低的問(wèn)題,提出一種輕量化Transformer的風(fēng)電功率預(yù)測(cè)模型。通過(guò)輕量化Transformer模型挖掘得到低維數(shù)據(jù)與風(fēng)電功率序列間的時(shí)序關(guān)系,實(shí)現(xiàn)多變量風(fēng)電功率的短期預(yù)測(cè)。最后,采用某風(fēng)電場(chǎng)的實(shí)際數(shù)據(jù)對(duì)本文所提方法進(jìn)行驗(yàn)證,實(shí)驗(yàn)結(jié)果表明,本文所提預(yù)測(cè)方法具有較高預(yù)測(cè)精度,且預(yù)測(cè)結(jié)果更穩(wěn)定,同時(shí)還降低了計(jì)算復(fù)雜性。

1 相關(guān)理論

1.1 位置編碼

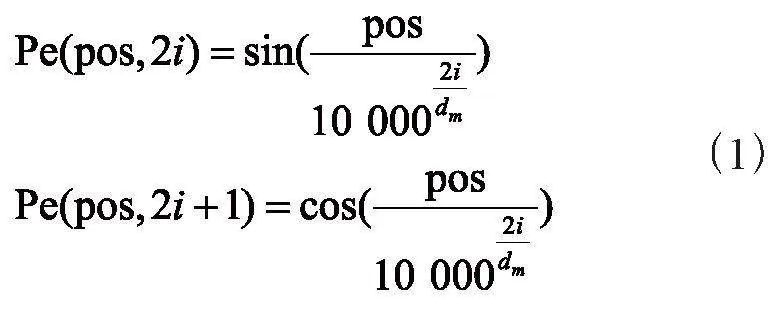

原始Transformer模型借助其精巧的自注意力并行結(jié)構(gòu),既能進(jìn)行并行計(jì)算,又同時(shí)解決了長(zhǎng)期依賴性問(wèn)題。雖然相較于LSTM模型,Transformer模型的訓(xùn)練速度遙遙領(lǐng)先,但是由于并行計(jì)算結(jié)構(gòu),也帶來(lái)了上下文關(guān)系注入問(wèn)題。因此,對(duì)于Transformer模型而言,序列的順序關(guān)系無(wú)法進(jìn)行直接獲取,自注意力模塊在計(jì)算注意力分布時(shí),只能給出輸出向量和輸入向量之間的權(quán)重關(guān)系,而不能給出位置信息。故而,需要融入位置編碼矩陣。

Transformer模型引入使用正余弦位置編碼。位置編碼通過(guò)使用不同頻率的正弦、余弦函數(shù)生成,提供輸入數(shù)據(jù)在風(fēng)電功率序列中相對(duì)位置的信息,位置編碼表示為:

其中,Pos為數(shù)據(jù)在整個(gè)序列中的位置,i為特征的第i個(gè)維度,dm為特征的維度。

1.2 自注意力機(jī)制

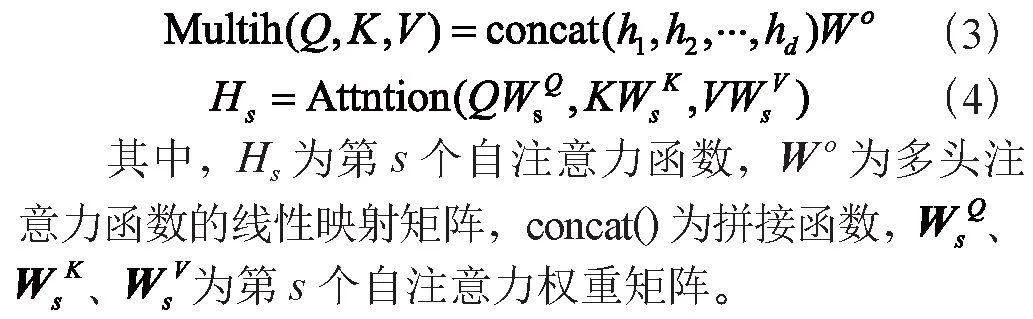

注意力機(jī)制采取學(xué)習(xí)輸入元素的相關(guān)關(guān)系,通過(guò)神經(jīng)網(wǎng)絡(luò)架構(gòu)能夠智能權(quán)衡任意輸入的個(gè)別相關(guān)性,并在執(zhí)行時(shí)序建模計(jì)算時(shí)考慮權(quán)重自調(diào)整。其基本理念是計(jì)算輸入序列的權(quán)重分布,為密切相關(guān)的元素分配較大的權(quán)值。具體來(lái)講,注意力機(jī)制是將一組K鍵、V向量和Q向量進(jìn)行計(jì)算后得到相應(yīng)的輸出。

原始Transformer模型采用自注意力機(jī)制來(lái)處理長(zhǎng)序列依賴問(wèn)題[14],在Transformer模型中,其本質(zhì)上就是使用Q向量和K鍵來(lái)計(jì)算“注意力權(quán)重”,對(duì)V向量進(jìn)行加權(quán)求和并輸出。其按比例縮放的注意力公式如下:

Transformer模型不同于BP模型、LSTM模型,它是采用多頭注意力機(jī)制模塊并行計(jì)算,用于提高模型的表達(dá)能力。多頭注意力機(jī)制公式如下:

1.3 編碼器

編碼器模塊主要是對(duì)風(fēng)電功率序列進(jìn)行特征提取,然后將位置編碼加入,最后通過(guò)解碼器提取風(fēng)電功率序列的高維特征。編碼器模塊包括多頭注意力機(jī)制、殘差連接和前饋神經(jīng)網(wǎng)絡(luò)三大部分。Transformer模型通過(guò)層規(guī)范化和殘差連接對(duì)矩陣進(jìn)行處理,層規(guī)范化和殘差連接能夠在一定程度上,解決深度神經(jīng)網(wǎng)絡(luò)因?qū)訑?shù)過(guò)多而導(dǎo)致的梯度消失和網(wǎng)絡(luò)退化問(wèn)題,加速模型預(yù)測(cè)結(jié)果的收斂。進(jìn)入前饋神經(jīng)網(wǎng)絡(luò),前饋神經(jīng)網(wǎng)絡(luò)的計(jì)算公式為:

其中,F(xiàn)x為前饋神經(jīng)網(wǎng)絡(luò)函數(shù);k為層歸一化輸出值;ω1和b1為第1個(gè)線性層的權(quán)重矩陣和偏置向量;ω2和b2為第2個(gè)線性層的權(quán)重矩陣和偏置向量。

1.4 激活函數(shù)

GeLU函數(shù)也稱為更平滑的整流線性單元函數(shù),被廣泛應(yīng)用于如Google的BERT[15]和OpenAI的GPT-2[16]等較為先進(jìn)的網(wǎng)絡(luò)模型中。其計(jì)算公式如下所示:

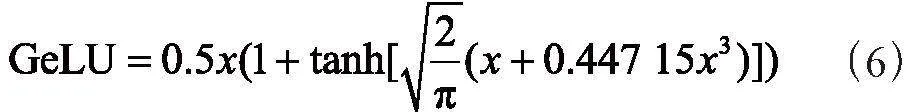

其中,X為輸入值,X為具有零均值和單位方差的高斯隨機(jī)變量。P(X<x)為X小于等于給定值x的概率。其近似結(jié)果為:

與ReLU和Sgmoid激活函數(shù)相比,GeLU激活函數(shù)引入了隨機(jī)正則化的理念,自適應(yīng)地摒棄無(wú)關(guān)的結(jié)果輸出。神經(jīng)元的輸入值越大,激活后的數(shù)值就增加了被保留的可能性,隨著輸入值的減小,激活值被歸0的概率也更大,因此激活后的輸出值更凸顯非線性化,特征的表達(dá)更為充分[17]。本實(shí)驗(yàn)發(fā)現(xiàn)在前饋神經(jīng)網(wǎng)絡(luò)層使用GeLU激活函數(shù)能夠取得更好的性能,可以促進(jìn)L-Transformer模型非線性處理能力,提高預(yù)測(cè)模型的擬合能力。

2 基于L-Transformer的風(fēng)電功率預(yù)測(cè)

2.1 預(yù)測(cè)模型結(jié)構(gòu)

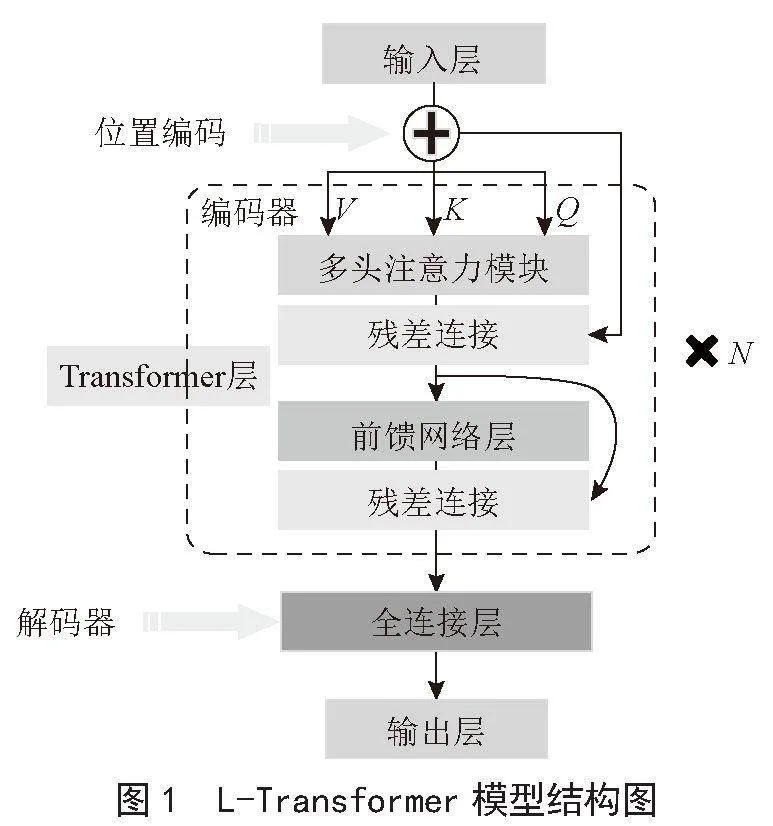

本文構(gòu)建的L-Transformer模型由1個(gè)輸入層、1個(gè)Transformer層和輸出層組成。其中Transformer模型精簡(jiǎn)化為由多層結(jié)構(gòu)的編碼器和解碼器組成,其中編碼器每一層都包括一個(gè)多頭自注意力模塊和一個(gè)前饋神經(jīng)網(wǎng)絡(luò)(FNN)子層模塊。編碼器將輸入序列映射到高維,而后將其饋送到解碼器生成輸出序列。L-Transformer的解碼器由全連接層代替。輕量化網(wǎng)絡(luò)結(jié)構(gòu)如圖1所示。

2.2 預(yù)測(cè)流程

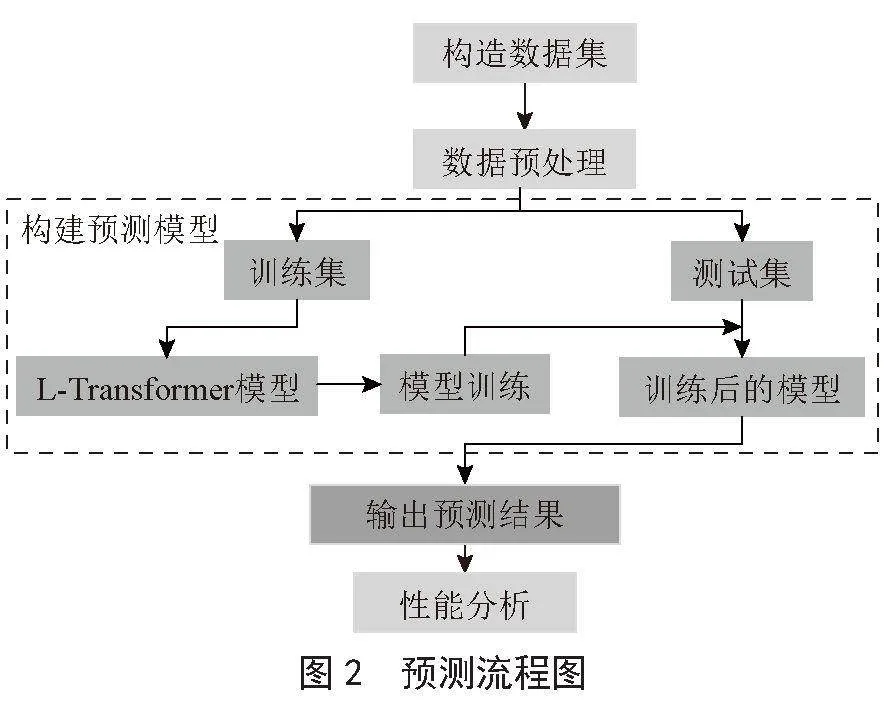

本文通過(guò)對(duì)風(fēng)電功率及影響因素的分析,確定輸入數(shù)據(jù),利用輕量化Transformer模型實(shí)現(xiàn)對(duì)風(fēng)電功率短期預(yù)測(cè),其預(yù)測(cè)流程如圖2所示。

風(fēng)電功率預(yù)測(cè)具體步驟如下:

1)構(gòu)建數(shù)據(jù)集。通過(guò)采集風(fēng)電場(chǎng)70 m的風(fēng)速、風(fēng)向、溫度、濕度、氣壓、功率等構(gòu)建數(shù)據(jù)集。

2)數(shù)據(jù)預(yù)處理。需要對(duì)輸入數(shù)據(jù)進(jìn)行預(yù)處理,將多個(gè)變量的時(shí)間序列數(shù)據(jù)整合成一個(gè)輸入序列,利用Transformer模型的自我注意力機(jī)制來(lái)學(xué)習(xí)變量之間的關(guān)系。

3)構(gòu)建預(yù)測(cè)模型。將分析后的數(shù)據(jù)按照8:2

劃分為訓(xùn)練集和測(cè)試集,通過(guò)輸入訓(xùn)練集調(diào)整L-Transformer模型中的超參數(shù)建立最優(yōu)模型,將測(cè)試集輸入到建立好的最優(yōu)模型中得到預(yù)測(cè)結(jié)果。

4)性能分析。選擇平均絕對(duì)誤差(MAE)、均方根誤差(RMSE)和決定系數(shù)R2等評(píng)價(jià)指標(biāo)來(lái)衡量模型的預(yù)測(cè)精度。

3 實(shí)驗(yàn)結(jié)果及分析

3.1 數(shù)據(jù)預(yù)處理

本文基于我國(guó)某地區(qū)某風(fēng)電場(chǎng)2019年1月1日到2019年12月31日的實(shí)際數(shù)據(jù)進(jìn)行實(shí)驗(yàn)分析,數(shù)據(jù)主要包括測(cè)風(fēng)塔70 m的風(fēng)速、測(cè)風(fēng)塔70 m的風(fēng)向、溫度、氣壓、濕度、發(fā)電功率等數(shù)據(jù),采樣周期為15 min。本文采用80%的數(shù)據(jù)作為訓(xùn)練集數(shù)據(jù),將其余20%的數(shù)據(jù)作為測(cè)試集數(shù)據(jù)。本文采用歸一化方法對(duì)數(shù)據(jù)進(jìn)行歸一化處理,歸一化公式為:

其中,ynorm為歸一化后的值,y為實(shí)際值,ymin為原數(shù)據(jù)集中的最小值,ymax為原數(shù)據(jù)集中的最大值。

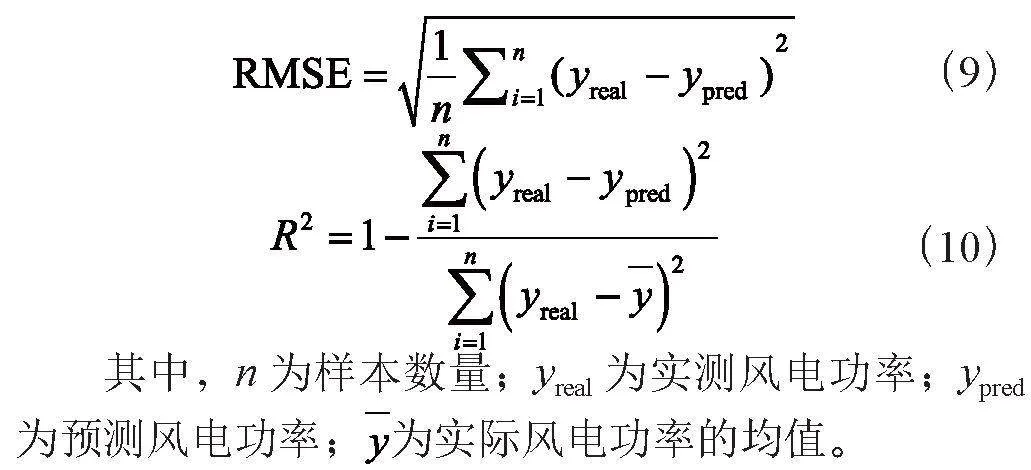

3.2 評(píng)價(jià)指標(biāo)

為了準(zhǔn)確反映預(yù)測(cè)效果,本文采取平均絕對(duì)誤差(MAE)、均方根誤差(RMSE)和決定系數(shù)(R2)來(lái)對(duì)L-Transformer模型進(jìn)行精準(zhǔn)評(píng)價(jià)。MAE、RMSE越小,或R2越接近于1,模型的預(yù)測(cè)性能越好。其中MAE、RMSE、R2的公式分別為:

3.3 實(shí)驗(yàn)結(jié)果分析

3.3.1 預(yù)測(cè)環(huán)境

本文實(shí)驗(yàn)運(yùn)行均在相同環(huán)境下進(jìn)行,在Windows 11操作系統(tǒng),8核16線程,CPU是Intel Core i5-12400F @2.5 GHz,采用Python 3.6搭建模型框架,并在NVIDIA GeForce GTX 1660 SUPER平臺(tái)進(jìn)行訓(xùn)練測(cè)試,計(jì)算平臺(tái)選擇CUDA 10.1和cuDNN。經(jīng)過(guò)多輪實(shí)驗(yàn)后,對(duì)超參數(shù)進(jìn)行調(diào)優(yōu),使用Adam優(yōu)化器訓(xùn)練模型,MSE為損失函數(shù),隱藏層的數(shù)量是256層,編碼器的數(shù)量4,解碼器是1個(gè),學(xué)習(xí)率設(shè)置為0.001,并加入dropout防止過(guò)擬合,設(shè)定值為0.5,batch_size大小為256。

3.3.2 模型性能比較

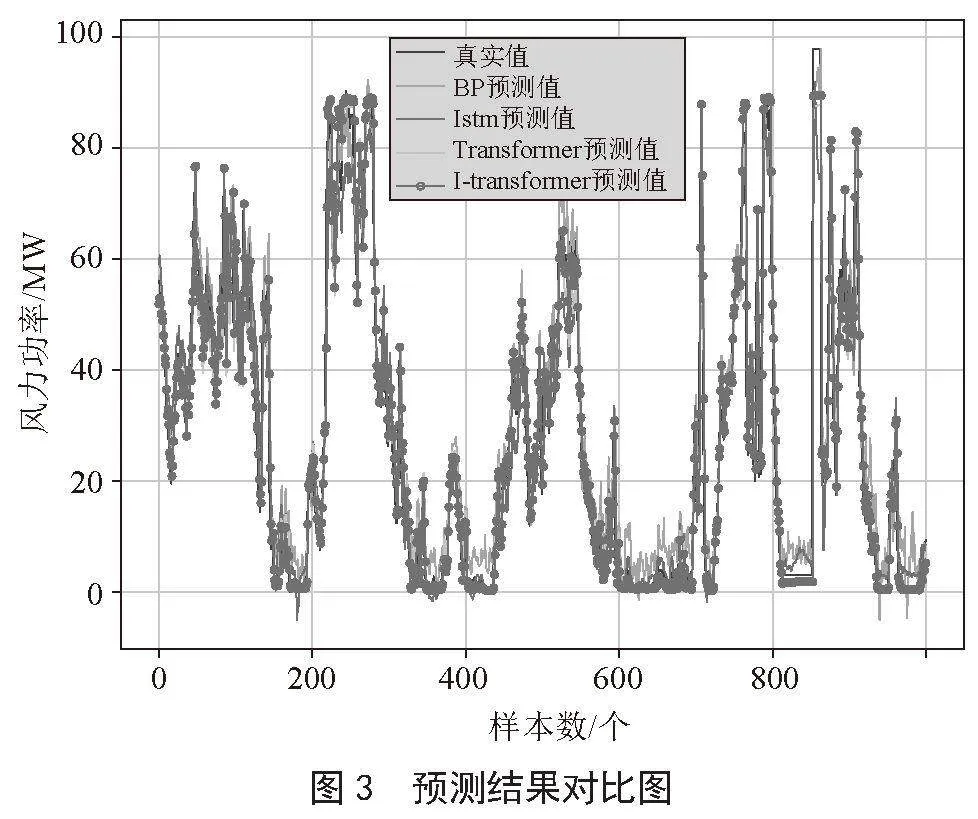

為了驗(yàn)證輕量化Transformer模型預(yù)測(cè)性能,分別與BP模型、LSTM模型和Transformer模型進(jìn)行性能對(duì)比,預(yù)測(cè)結(jié)果對(duì)比如表1和圖3所示。

由此發(fā)現(xiàn),Transformer模型與BP模型、LSTM模型相比,R2的值分別上升了0.015、0.009 8,RMSE分別降低了7.71%、6.21%,MAE分別減少了16.04%、3.20%,說(shuō)明Transformer模型更擅長(zhǎng)從長(zhǎng)序列中學(xué)習(xí)特征。

L-Transformer模型與Transformer模型相比,R2的值提升了0.019 2,其MAE、RMSE值下降了14.38%,24.46%,輕量化的L-Transformer模型其預(yù)測(cè)精度更高,誤差更小,能更準(zhǔn)確預(yù)測(cè)短期風(fēng)電功率。

3.3.3 不同激活函數(shù)選擇

針對(duì)神經(jīng)網(wǎng)絡(luò)的輸出結(jié)果,激活函數(shù)將對(duì)其展開(kāi)非線性映射處理,故而選擇不同的激活函數(shù)直接影響網(wǎng)絡(luò)模型的輸出參數(shù),進(jìn)而影響到預(yù)測(cè)模型的性能。為驗(yàn)證其結(jié)果,分別采用ReLU與GeLU激活函數(shù)對(duì)前饋神經(jīng)網(wǎng)絡(luò)層的激活函數(shù)替換,使用GeLU激活函數(shù)相比ReLU激活函數(shù)增加了隨機(jī)性,且明顯在MAE、RMSE降低了10.92%,23.72%,R2提升了0.014 9。實(shí)驗(yàn)結(jié)果如表2所示。

4 結(jié) 論

本文提出了一種基于輕量化Transformer模型的短期多變量風(fēng)電功率預(yù)測(cè)方法,并在西北某風(fēng)電場(chǎng)真實(shí)數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn),通過(guò)改進(jìn)Transformer模型,替換激活函數(shù),輕量化網(wǎng)絡(luò)結(jié)構(gòu),減半編碼器個(gè)數(shù),進(jìn)行多變量風(fēng)電功率預(yù)測(cè)研究,根據(jù)實(shí)驗(yàn)分析可知,L-Transformer模型在性能方面明顯優(yōu)于BP模型、LSTM模型和原始Transformer模型。結(jié)合多注意力機(jī)制,使用殘差連接防止出現(xiàn)梯度消失問(wèn)題,L-Transformer模型表現(xiàn)出更優(yōu)越的性能,采用GeLU激活函數(shù)也可以進(jìn)一步提升模型的預(yù)測(cè)性能。構(gòu)建的輕量化Transformer模型進(jìn)行風(fēng)電功率預(yù)測(cè),可以有效地挖掘風(fēng)速、風(fēng)向、溫度和濕度等多變量之間的關(guān)系,提高預(yù)測(cè)的準(zhǔn)確性和魯棒性,為電力調(diào)度和風(fēng)電場(chǎng)的運(yùn)營(yíng)和管理提供更準(zhǔn)確的預(yù)測(cè)結(jié)果。

參考文獻(xiàn):

[1] 王曉東,栗杉杉,劉穎明,等.基于特征變權(quán)的超短期風(fēng)電功率預(yù)測(cè) [J].太陽(yáng)能學(xué)報(bào),2023,44(2):52-58.

[2] 商立群,李洪波,黃辰浩,等.基于多變量相空間重構(gòu)和優(yōu)化深度極限學(xué)習(xí)機(jī)的短期風(fēng)電功率預(yù)測(cè) [J].南方電網(wǎng)技術(shù),2023,17(2):82-91.

[3] 郭恒寬,田建艷,劉豎威,等.基于改進(jìn)Sequence2Sequence架構(gòu)的LSTM超短期可解釋風(fēng)電功率預(yù)測(cè) [J/OL].控制工程:1-12[2024-02-24].https://doi.org/10.14107/j.cnki.kzgc.20230921.

[4] 楊芮,文武,徐虹.基于PCC-CNN-GRU的短期風(fēng)電功率預(yù)測(cè) [J].成都信息工程大學(xué)學(xué)報(bào),2022,37(2):165-170.

[5] 王瑞,徐新超,逯靜.基于特征選擇及ISSA–CNN–BiGRU的短期風(fēng)功率預(yù)測(cè) [J].工程科學(xué)與技術(shù),2024,56(3):228-239.

[6] 唐賢倫,張家瑞,郭祥麟,等.基于數(shù)據(jù)平穩(wěn)化和BiLSTM的短期風(fēng)電功率預(yù)測(cè)方法 [J].重慶郵電大學(xué)學(xué)報(bào):自然科學(xué)版,2023,35(6):1135-1144.

[7] 趙鐵成,謝麗蓉,葉家豪.基于誤差修正的NNA-ILSTM短期風(fēng)電功率預(yù)測(cè) [J].智慧電力,2022,50(1):29-36.

[8] 趙凌云,劉友波,沈曉東,等.基于CEEMDAN和改進(jìn)時(shí)間卷積網(wǎng)絡(luò)的短期風(fēng)電功率預(yù)測(cè)模型 [J].電力系統(tǒng)保護(hù)與控制,2022,50(1):42-50.

[9] 崔楊,王議堅(jiān),黃彥浩,等.基于多元注意力框架與引導(dǎo)式監(jiān)督學(xué)習(xí)的閉環(huán)風(fēng)電功率超短期預(yù)測(cè)策略 [J].中國(guó)電機(jī)工程學(xué)報(bào),2023,43(4):1334-1347.

[10] 施進(jìn)煒,張程,原冬蕓.基于數(shù)據(jù)修正的概率稀疏自注意短期風(fēng)電功率預(yù)測(cè) [J].智慧電力,2023,51(10):54-61.

[11] 林錚,劉可真,沈賦,等.考慮海上風(fēng)電多機(jī)組時(shí)空特性的超短期功率預(yù)測(cè)模型 [J].電力系統(tǒng)自動(dòng)化,2022,46(23):59-66.

[12] 張?jiān)剑昂O椋潭Y臨,等.基于自適應(yīng)時(shí)序表征和多級(jí)注意力的超短期風(fēng)電功率預(yù)測(cè) [J].電力自動(dòng)化設(shè)備,2024,44(2):117-125.

[13] 駱釗,吳諭侯,朱家祥,等.基于多尺度時(shí)間序列塊自編碼Transformer神經(jīng)網(wǎng)絡(luò)模型的風(fēng)電超短期功率預(yù)測(cè) [J].電網(wǎng)技術(shù),2023,47(9):3527-3537.

[14] 陳銳,丁凱,祖連興,等.基于AED-CEEMD-Transformer的鋰離子電池健康狀態(tài)估計(jì) [J].儲(chǔ)能科學(xué)與技術(shù),2023,12(10):3242-3253.

[15] LIU Y,WU H,WANG J,et al. Non-stationary Transformers: Exploring the Stationarity in Time Series Forecasting [J].Advances in Neural Information Processing Systems,2022,35:9881-9893.

[16] JIN W,ZHANG W,HU J,et al. Transformer for Sub-seasonal Extreme High Temperature Probabilistic Forecasting Over Eastern China [J].Theoretical and Applied Climatology,2023,151(1-2):65-80.

[17] 周嫻瑋,賴堅(jiān),陳瑋濤,等.RFC-Net:基于殘差結(jié)構(gòu)的動(dòng)作質(zhì)量評(píng)估網(wǎng)絡(luò) [J].計(jì)算機(jī)技術(shù)與發(fā)展,2022,32(11):146-153+163.