融合遷移學習和集成學習的服裝風格圖像分類方法

摘 要:針對服裝風格人工分類受主觀性、地域等因素影響而造成的分類錯誤問題,研究了一種基于人工智能的服裝風格圖像分類方法。首先,在FashionStyle14數據集基礎上篩除重復或無效圖像,構建服裝風格圖像數據集;然后,采用遷移學習方法,對EfficientNet V2、RegNet Y 16GF和ViT Large 16等模型進行微調訓練,生成新模型,實現基于單個深度學習的服裝風格圖像分類;最后,為進一步提高圖像分類的準確性、可靠性和魯棒性,分別采用基于投票、加權平均和堆疊的集成學習方法對上述單個模型進行組合預測。遷移學習實驗結果表明,基于ViT Large 16的深度學習模型在測試集上表現最佳,平均準確率為77.024%;集成學習方法實驗結果顯示,基于投票的集成學習方法在相同測試集上平均準確率可達78.833%。研究結果為解決服裝風格分類問題提供了新的思路。

關鍵詞:服裝風格;遷移學習;集成學習;ViT模型;圖像分類

中圖分類號: TP391.41;TS102. 3

文獻標志碼: A

文章編號:1009-265X(2024)09-0127-08

收稿日期:2024-01-08

網絡出版日期:2024-03-21

基金項目:江蘇省碳纖維先進材料智能制造工程技術研究開發中心項目(蘇教科[2023]11號)

作者簡介:游小榮(1981— ),男,江西臨川人,副教授,碩士,主要從事紡織服裝數字化和人工智能應用方面的研究。

時尚產業在全球經濟中發揮重要作用,目前約占全球GDP總值的2%[1]。服裝風格分類能夠幫助消費者更好地了解并選擇符合自己喜好的時尚產品,從而更快捷地找到感興趣的風格和品牌。同時,服裝風格分類在時尚研究和設計方面也非常重要,為設計師提供靈感和參考。此外,對時尚品牌公司和零售商而言,服裝風格的精確分類有助于更好地了解市場需求和消費者喜好,進而調整產品類別和推廣策略。然而,人工進行服裝風格分類具有主觀性、多樣性、變化性和地域性等特點[2],容易導致分類結果存在誤差。因此通過借助技術手段,如人工智能等,來提高分類的客觀性和準確性具有重要意義。

隨著人工智能技術的廣泛應用,尤其是深度學習技術的迅猛發展,許多學者利用海量的服裝風格圖像數據來訓練深度學習模型,從而實現對服裝風格的定性和定量分析。Takagi等[3]針對FashionStyle14數據集,采用ResNet50等模型進行服裝風格圖像分類,分類的平均精度為72%,高于普通用戶62%的人工分類精度,但低于專業用戶82%的人工分類精度;李揚等[4]使用改進Bilinear-CNN模型對服裝圖像風格進行識別,在FashionStyle14數據集上能夠達到76.4%的識別準確率。盡管上述兩位研究者為應對服裝風格分類問題提供了解決辦法,但分類精度仍有待提升。Woottisart等[5]利用卷積神經網絡對卡哇伊、泰國街頭風格和歐洲街頭風格圖像進行分類,訓練后模型的平均分類準確率可達85.53%,但這種方法研究的服裝風格數量偏少。還有一些學者試圖在風格與屬性之間建立聯系,對服裝風格進行定量分析。An 等[6]將服裝風格分成了性別、區域和個性3個維度,將服裝屬性與風格直接聯系起來,借助深度學習方法,共同輸出時尚的風格,在測試集上的平均準確率為75.21%;然而,由于未能解決服裝屬性的多標簽分類問題,這種方法未能充分確定風格與屬性之間的映射關系。Ma等[7]基于Kobayashi的美學理論構建了一個Fashion語義空間,將服裝風格分類問題視為一個回歸問題,并采用多模態深度學習模型實現服裝趨勢分析,以定量的方式描述服裝時尚風格;然而,這種方法要求對數據集中的服裝圖像屬性進行大量標注,耗時耗力且成本高。綜上所述,深度學習模型能夠通過學習圖像中的特征和模式,自動提取并理解不同的服裝風格,從而降低主觀偏見的影響,并更準確地捕捉服裝風格的多樣性。

針對服裝風格人工分類受主觀性、地域等因素影響而造成分類錯誤的問題,研究了一種融合遷移學習和集成學習的服裝風格圖像分類方法。首先,在FashionStyle14數據集基礎上構建服裝風格圖像數據集;其次,采用EfficientNet V2、RegNet和ViT Large 16等預訓練模型進行微調訓練,生成新模型;再次,對新模型進行測試,并根據評價指標評估其分類性能,從中選擇表現較好的深度學習模型;最后,分別構建基于投票、加權集成和堆疊的集成學習方法,將表現較好的3個深度學習模型進行組合分類。通過對比實驗,選擇性能最優的集成學習方法,進一步提高圖像分類的準確性、可靠性和魯棒性。

1 研究方法

1.1 數據集構建

常見的公開服裝圖像數據集包括DeepFashion、FashionGen、Fashion 144K、HipsterWars、Fashion Style14等[1]。除了HipsterWars和FashionStyle14,上述數據集均未對服裝風格單獨標記;而HipsterWars數據集只包含時髦、波西米亞、哥特等5個風格分類,數據集中的圖像數量不到2000張,風格種類和數量都偏少。因此本文選用了Fashion Style14數據集。

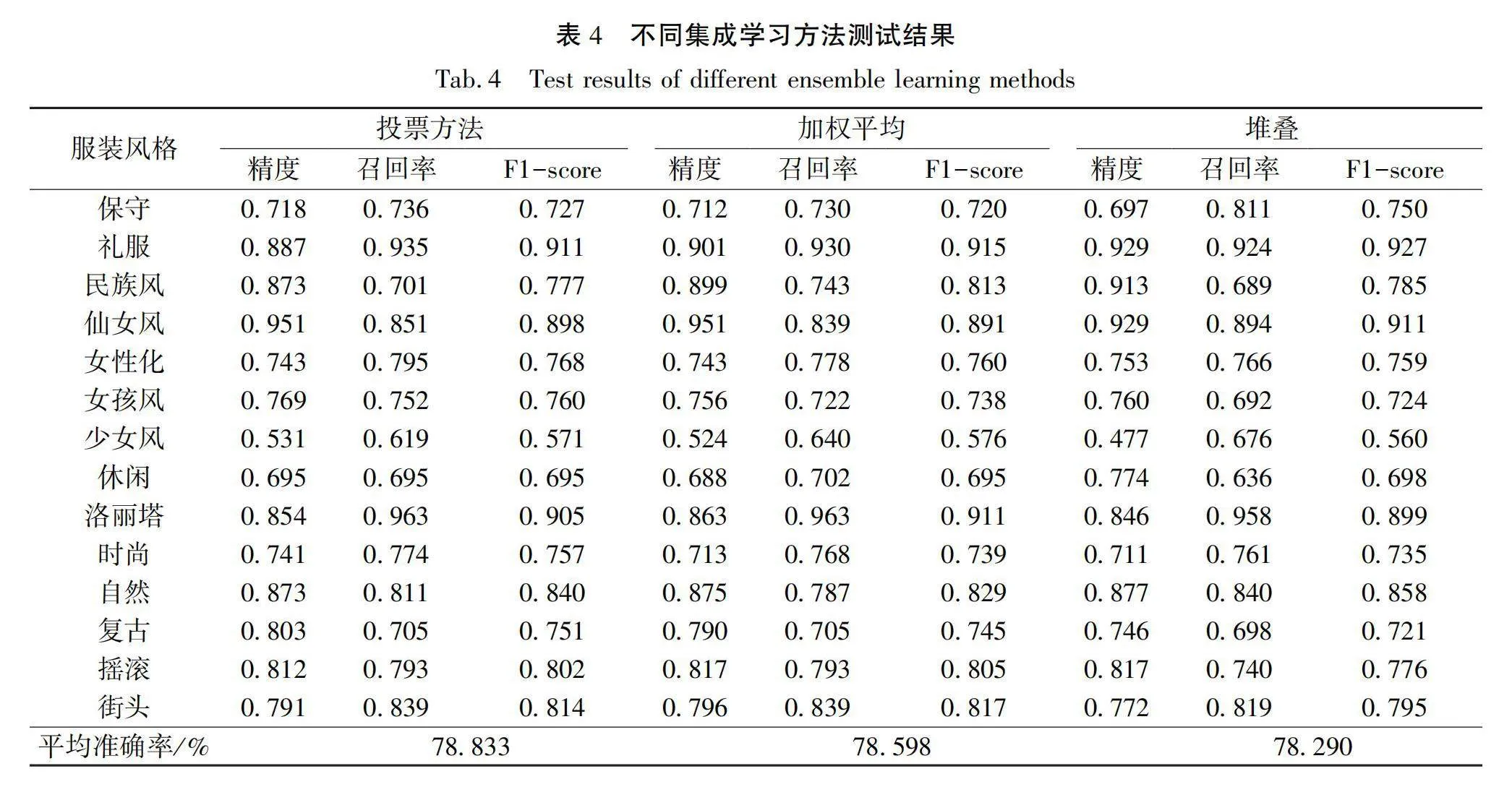

FashionStyle14數據集專門為服裝風格而設計,由服裝領域專家策劃,包含保守、禮服、民族風、仙女風、女性化、女孩風、少女風、休閑、洛麗塔、時尚、自然、復古、搖滾和街頭等14種現代服裝風格,共13126張圖像。本文在去除FashionStyle14數據集中部分重復圖像以及讀取文件出錯的無效圖像后,總計得到了11203張圖像的數據集。篩選后的數據集中,各服裝風格類別對應圖像數量情況如圖1所示。由圖1可知,每個類別圖像數量在697~907之間,類別之間的均衡性較好。然后,本文按照6∶2∶2的比例對篩選后的數據集進行劃分,分成訓練集、驗證集和測試集,分別用于訓練、驗證和測試模型。

1.2 基于遷移學習的服裝風格圖像分類模型

隨著深度學習算法的發展,各種圖像分類的深度學習模型不斷涌現,其基于深度學習模型的圖像分類精度也顯著提高。根據模型結構的不同,可以將深度學習模型分為基于卷積神經網絡的深度學習模型(如RegNet、EfficientNet、ResNet和VGG等)和基于自注意力機制的深度學習模型(包括Vision Transformer、Swin Transformer和CaiT等)[8]。

在深度學習應用中,由于相關方法對大規模數據集和計算資源的高需求,遷移學習作為一種有效的策略逐漸受到重視。該方法首先在大規模數據集上對深度神經網絡進行訓練,形成預訓練模型,然后將該模型的參數作為初始參數,在新的數據集上進行微調。這一策略顯著降低了模型訓練所需的數據量和時間,同時提高了模型的分類性能和計算效率[9]。基于此,本文采用遷移學習方法來構建服裝風格圖像分類模型。

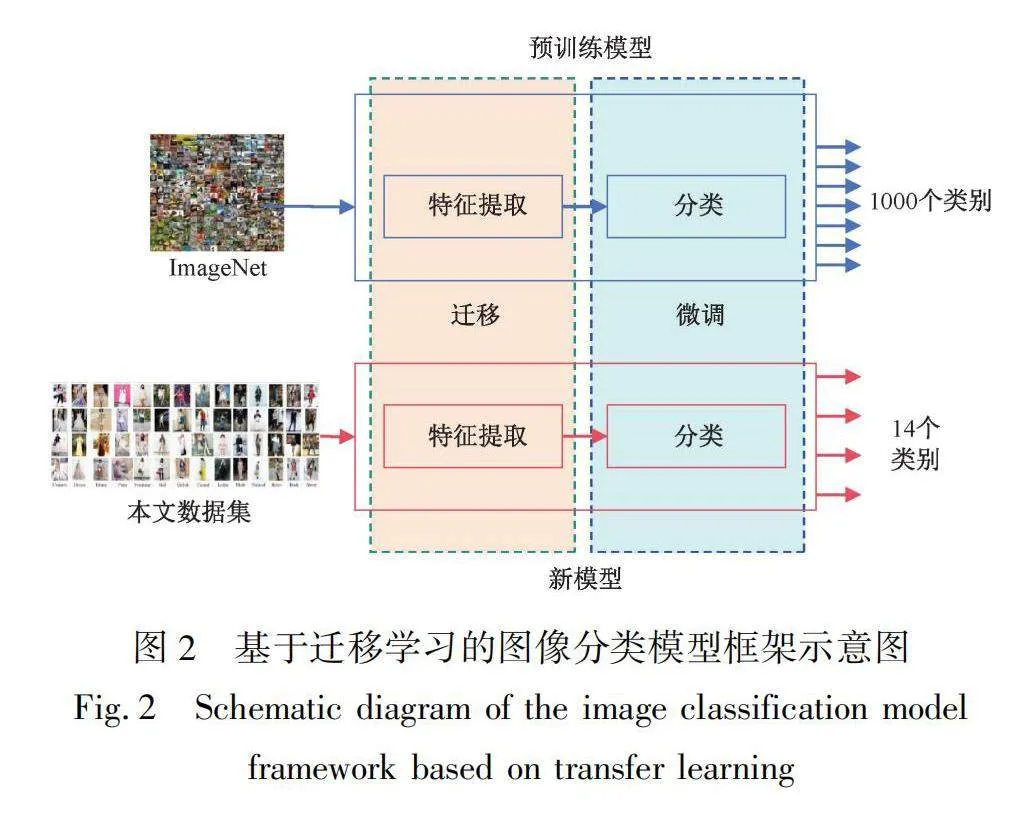

圖2展示了基于遷移學習的圖像分類模型框架。預訓練模型的網絡結構又可分為特征提取和分類兩部分。圖2所使用的預訓練模型經過大型數據集(ImageNet)的訓練,其輸出層默認包括1000個節點,用來對ImageNet中的1000個類別圖像進行分類。在訓練過程中,本文保留了特征提取的網絡結構和參數,僅對分類層的網絡結構和參數進行微調。為了適應本文中的服裝風格圖像分類任務,本文將輸出層的1000個節點修改為14個節點,對應于14種分類。然后,針對微調后的模型,在上述訓練集和驗證集上進行訓練和驗證。訓練完成后,程序將生成新的深度學習模型。

由于軟硬件資源的限制,本文選擇了在圖像分類任務中表現較好的3種預訓練模型[10]進行服裝風格圖像分類,這些模型分別是:

a)EfficientNet V2 L:該模型在處理圖像分類任務時,能夠有效地捕捉圖像中的特征,并在保持準確性的同時,具有較高的計算和參數效率[11]。

b)RegNet Y 16GF:該模型是一種基于正則化網絡的圖像分類模型,屬于RegNet Y網絡結構中的一個變種,擁有16個組和16個Gflops的計算量。其設計目標是在保持準確性的同時,盡可能減少計算和參數量,以提高模型的效率和速度[12]。

c)ViT Large 16:ViT是Vision Transformer的縮寫,是一種基于注意力機制的圖像分類模型。它在Transformer模型的基礎上進行了改進,利用自注意力機制來處理圖像分類任務。相較于傳統的卷積神經網絡,ViT Large 16模型不需要手動設計卷積核和池化操作,具有良好的可擴展性和泛化能力[13]。

1.3 基于集成學習的服裝風格圖像分類方法

集成學習方法是一種機器學習方法[14],通過組合多個基本學習器的預測結果,獲得更好的整體預測性能。該方法具有如下優點:a)減少單個學習器的過擬合風險,提高模型的泛化能力;b)通過結合

多個學習器的預測結果,提高對少數類別樣本的分類準確性,解決樣本分布不平衡的問題;c)綜合各學習器的優勢,提高整體模型的穩定性。

綜合上述集成學習方法的優點,針對服裝風格分類問題,本文選擇了以下3種集成學習方法:

a)基于投票的集成學習方法。該方法包括硬投票和軟投票。其中,硬投票是指簡單地統計每個基本模型預測結果中出現次數最多的類別作為最終預測結果。而軟投票則是考慮每個基本模型預測結果的置信度,將置信度加權求和后得到最終的預測結果。本文將選用硬投票的集成學習方法。

b)基于加權平均的集成學習方法。在該方法中,每個基本模型都會對樣本進行預測,并根據預測結果進行加權平均。各個分類器的權重大小取決于它們的測試性能表現。最終的決策結果是基于加權平均后的預測結果確定的。

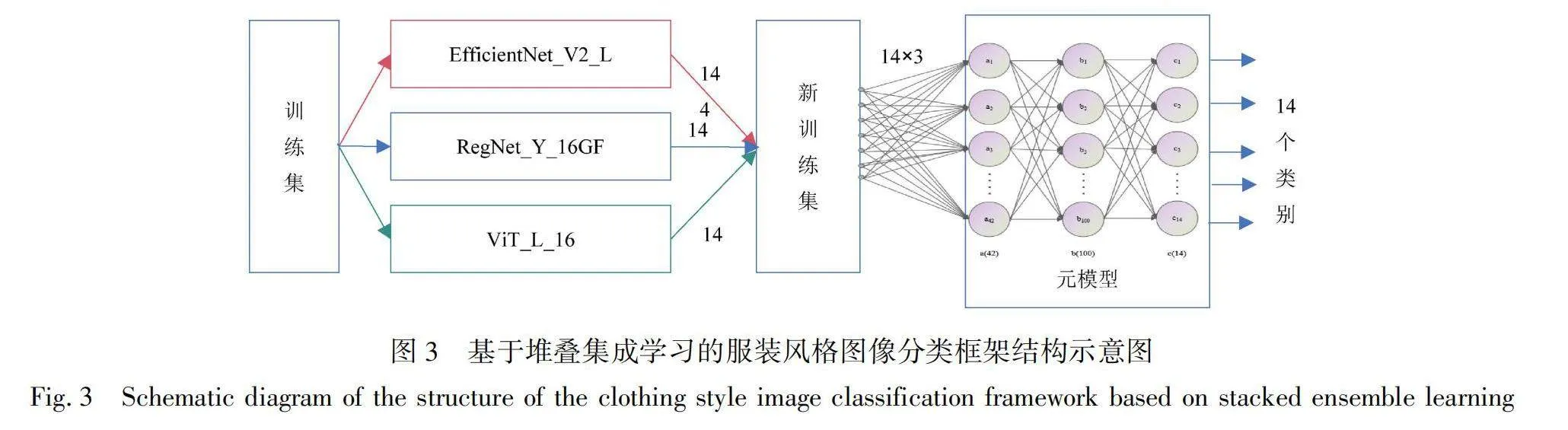

c)基于堆疊的集成學習方法。該方法將不同的基本學習器的預測結果作為新的特征輸入元模型中,形成新的訓練集。隨后,基于這一新的訓練集,構建了由3層神經網絡組成的元模型,用以輸出14個數據。其框架結構如圖3所示。由圖3可知,每種深度學習模型在每次預測后都會生成14個數據,而3個模型的輸出數據組合在一起就形成42個數據。因此,經過多次預測后,這些數據就形成了新的訓練集。此外,圖3中的元模型包括1個輸入層(a)、1個隱藏層(b)和1個輸出層(c)。其中,輸入層接收42個輸入數據,對應42個神經元;隱藏層包含100個神經元;輸出層輸出14個數據,代表14個類別。各層之間采用全連接方式。

2 實驗和結果分析

2.1 實驗環境

本實驗硬件環境包括:CPU型號為i9-13900H、內存16 Gi、固態硬盤1 TiB;軟件環境包括:操作系統為win10 64 bit、開發語言為Python 3.10.1、深度學習框架為Pytorch 1.11.0。

2.2 評價指標

在后續實驗中,采用了以下4種評價指標:

a)平均準確率(Accuracy):被正確分類的樣本數與總樣本數之間的比值,用于評估模型在所有服裝風格類別上的整體分類準確性。

b)精確度(Precision):真正屬于某一類別的樣本數與所有被分類為該類別的樣本數之間的比值,用于評估模型對某一特定服裝風格類別的判斷能力,即模型的查準率。

c)召回率(Recall):真正屬于某一類別的樣本數與所有真正屬于該類別的樣本數之間的比值,用于評估模型對某一特定服裝風格類別的覆蓋能力,即模型的查全率。

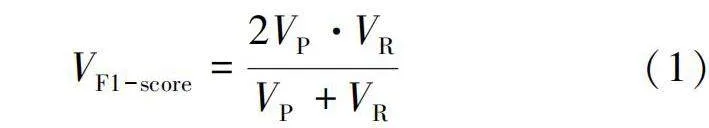

d)F1分數(F1-score):用于綜合評估模型在準確性和覆蓋能力方面的綜合表現。計算公式如下:

V=2V·VV+V(1)

式中:V為F1分數的值,V為精確度值,V為召回率值。

2.3 遷移學習訓練及測試結果與分析

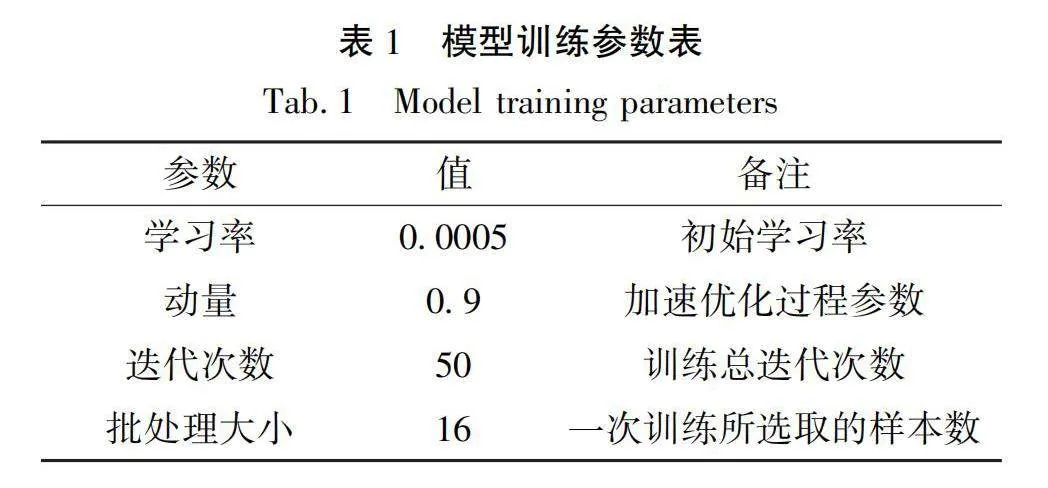

針對上述預訓練模型,訓練過程中采用了交叉熵損失函數,并選擇了隨機下降法作為優化器。同時,本文設置了表1所示的訓練參數,以取得較好的訓練效果。

訓練和驗證的過程涵蓋了多個關鍵步驟,以確保深度學習模型的有效訓練和性能評估。具體步驟包括:a)加載訓練和驗證數據集。b)選擇并加載預訓練模型。c)進入訓練階段,需要定義損失函數、優化器、學習率、動量、學習率調度器、步長、縮放因子等。d)初始化訓練和驗證損失率、準確率以及最低驗證損失率。e)迭代循環運行每一個輪次,實現訓練和驗證的交替進行。在訓練階段,模型被設置為訓練模式,梯度計算被啟用,每個批次的樣本和標簽被讀取,優化器的梯度被清零,樣本輸入模型,計算輸出和損失率值,并進行反向傳播和參數更新。在驗證階段,模型被設置為評估模式,計算當前階段的損失率、準確率和樣本數量。如果當前驗證損失更低率,更新最低驗證損失率,并保存當前模型為新模型。f)當訓練循環結束后,得到服裝風格圖像的分類模型。

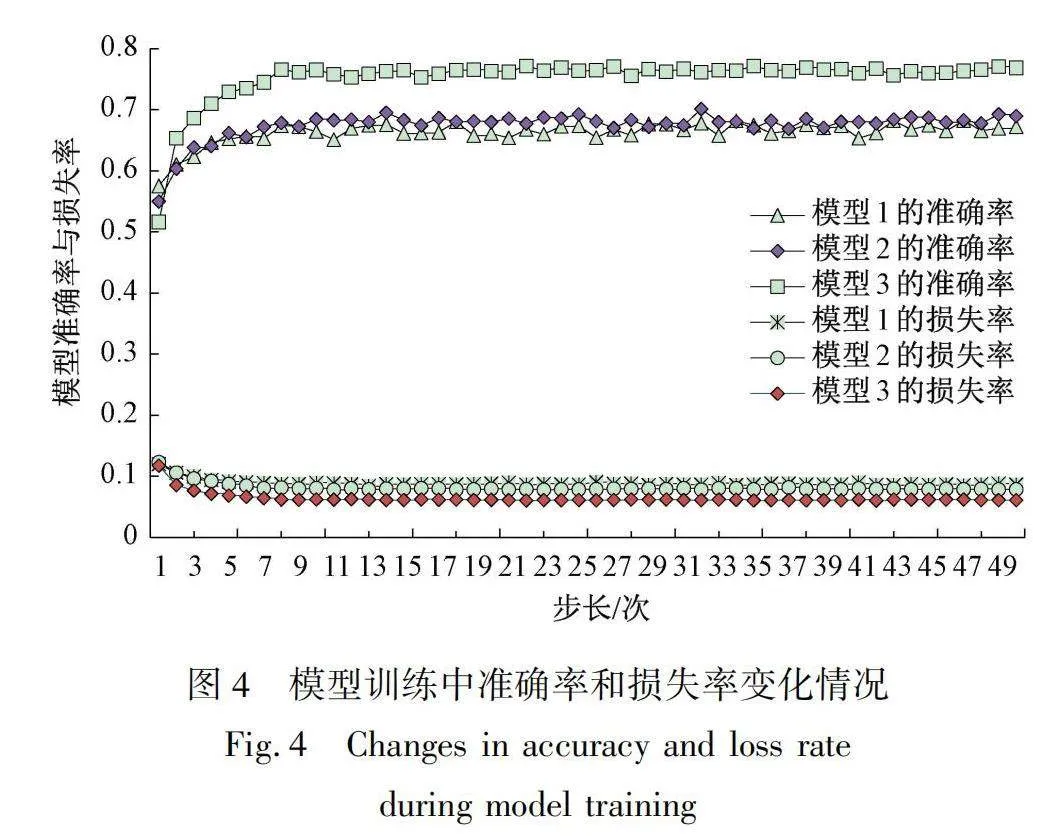

各模型在訓練過程中準確率和損失率變化情況如圖4所示,其中模型1為EfficientNet V2 L模型,模型2為RegNet Y 16GF模型,模型3為ViT Large 16模型。由圖4可知,基于ViT Large 16模型訓練的平均準確率明顯優于另外兩種基于傳統卷積神經網絡的預訓練模型EfficientNet V2 L和RegNet Y 16GF。在驗證集上,ViT Large 16模型的平均準確率達到了77.176%。

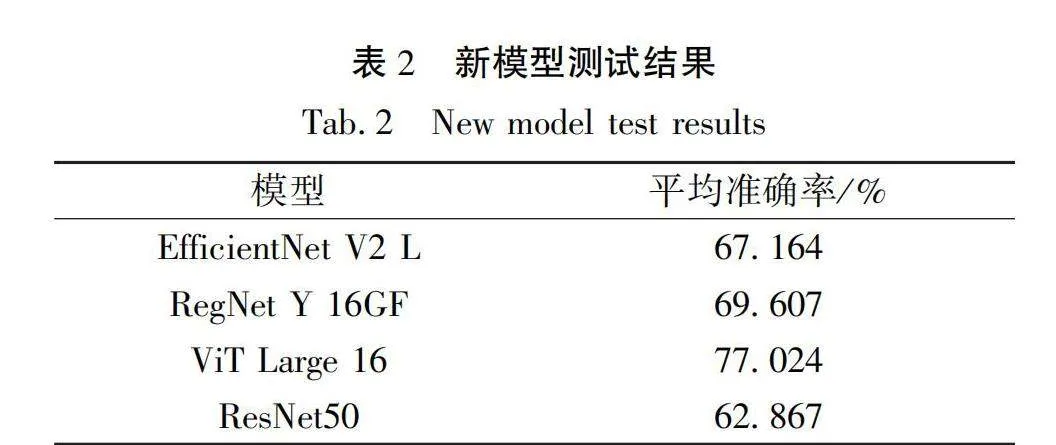

針對相同的測試集,對上述3個新模型進行測試,測試結果如表2所示。由表2可知,基于卷積神經網絡的深度學習模型EfficientNet V2 L、RegNet Y 16GF的平均準確率分別為67.164%、69.607%。而ViT Large 16模型具有最高的平均準確率,其值為77.024%,比RegNet Y 16GF模型測試結果高出7.417%,分類和識別效果更優。此外,對文獻[3]中的最優分類模型ResNet50模型進行訓練和測試,結果表明:在相同測試集的情況下,ResNet50模型的平均準確率為62.867%,比上述3種模型測試結果都低。

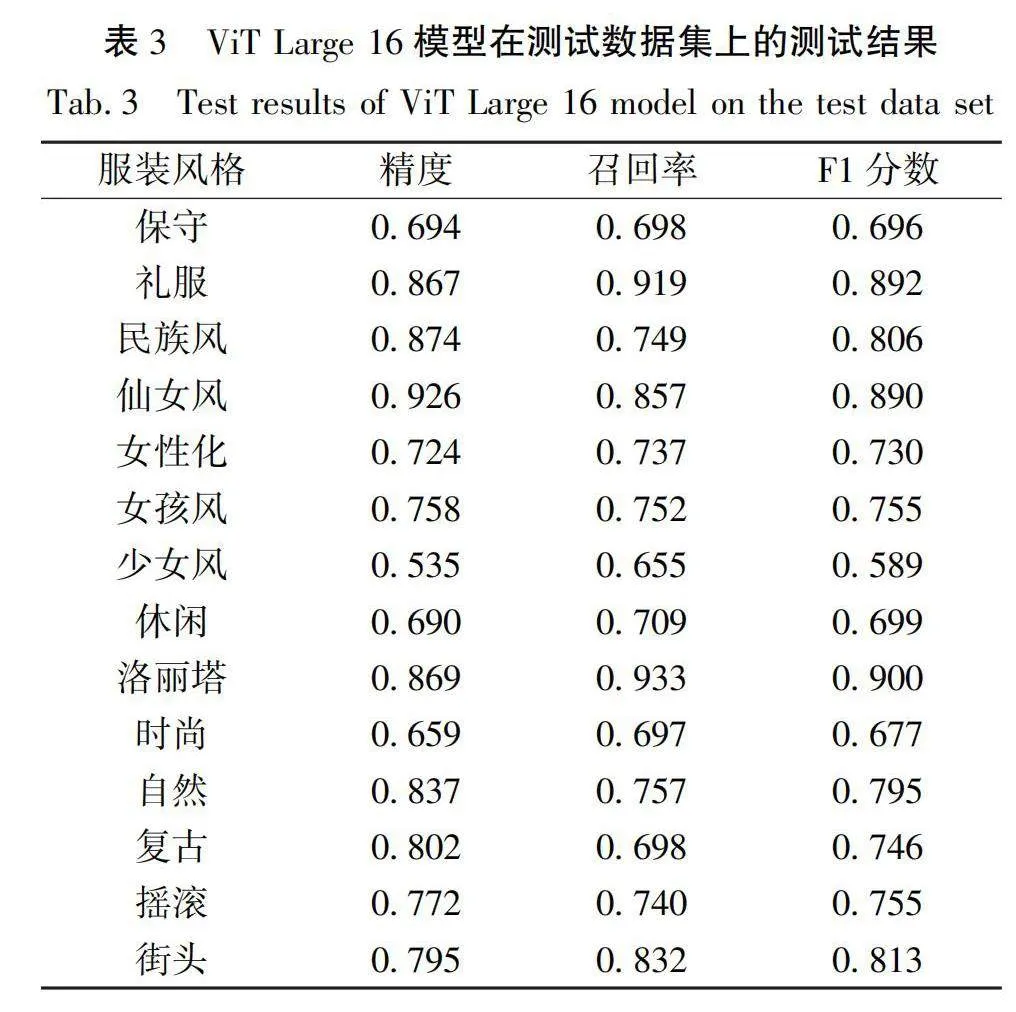

ViT Large 16模型在測試數據集上的評價指標情況見表3,評價指標包括精確度、召回率和F1分數。由表3可知,禮服、民族風、仙女風、洛麗塔、自然這5個服裝風格分類各項指標均較高,而保守、少女風、休閑和時尚這4個服裝風格分類各項指標則略低。

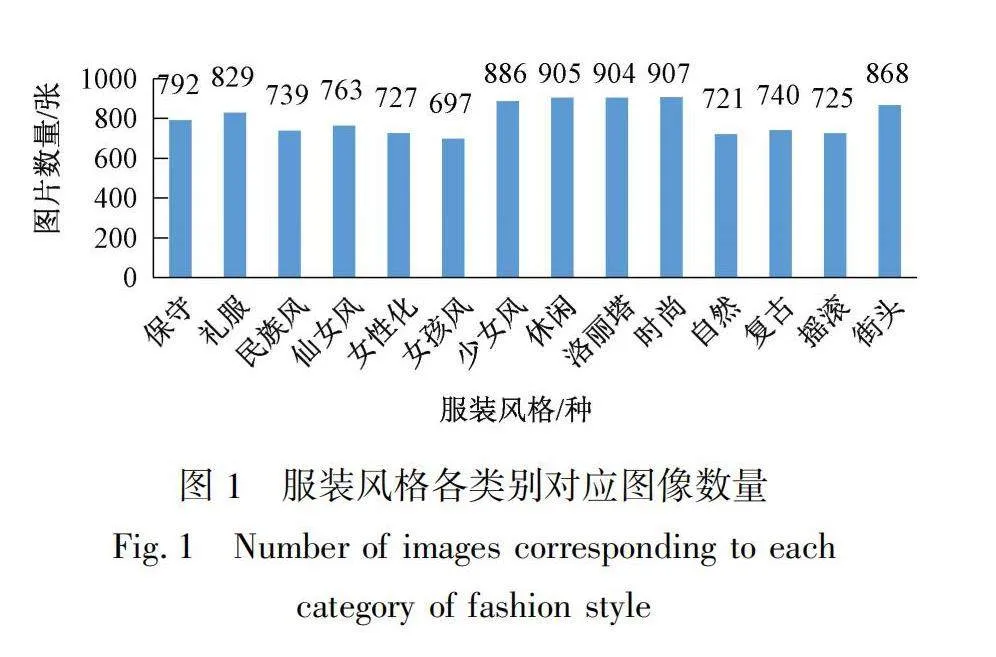

2.4 集成學習測試結果與分析

本文使用與遷移實驗相同的測試集,對基于投票、加權平均和堆疊的集成學習方法進行測試。基于投票和加權平均的集成學習方法可以直接使用上述新生成的模型,無需重新訓練。此外,根據表2測試結果,對基于加權平均的集成學習方法的權值進行分配。計算方法是按照每個模型的準確率除以所有模型平均準確率的總和,使得準確率較高的模型權值較大。計算過程和結果如式(2)—(4)所示:

W=67.164%/(67.164%+69.607%+77.024%)=0.314(2)

W=69.607%/(67.164%+69.607%+77.024%)=0.326(3)

W=77.024%/(67.164%+69.607%+77.024%)=0.360(4)

式中:W為EfficientNet V2 L模型對應的權值,W為RegNet Y 16GF模型對應的權值,W為ViT Large 16模型對應的權值。

由于基于堆疊的集成學習方法包含元模型,因此需要先對元模型進行訓練,訓練完成后再生成新的堆疊分類模型。在測試階段,使用新的堆疊分類模型進行服裝風格圖像的分類和識別。

3種集成學習方法的測試結果如表4所示。由表4可知,基于投票的集成學習方法在數據集上測得的平均準確率最高,其值為78.833%,而在3個集成學習方法之間,平均準確率的差異不到1%。此外,根據表2和表4的結果可以得出如下結論:與本文單一深度學習模型測試結果相比,基于投票的集成學習方法在服裝風格分類任務中的平均準確率提高了1.809%(從77.024%提升至78.833 %)。上述實驗結果證明,集成學習方法可以有效提高整體模型的準確率。

在對基于投票的集成學習方法進行測試后,還得到了如圖5所示的混淆矩陣結果。其中,圖中的數據為查全率。通過混淆矩陣不難看出,洛麗塔和禮服兩種風格查全率超過90%,說明這兩種風格的圖像特征具有明顯的獨特性。而女性化、女孩風以及少女風這3類風格查全率整體偏低,查全率不到80%,相互之間容易出現混淆的情況,反映出這些風格圖像之間存在一定的相似性。而對于民族風風格,其分類效果受到世界多民族服飾差異性的影響,查全率也偏低,建議對各民族服飾進一步細化分類。此外,搖滾風格和街頭風格之間也容易混淆,表明這兩種風格特征之間存在一定的重疊。

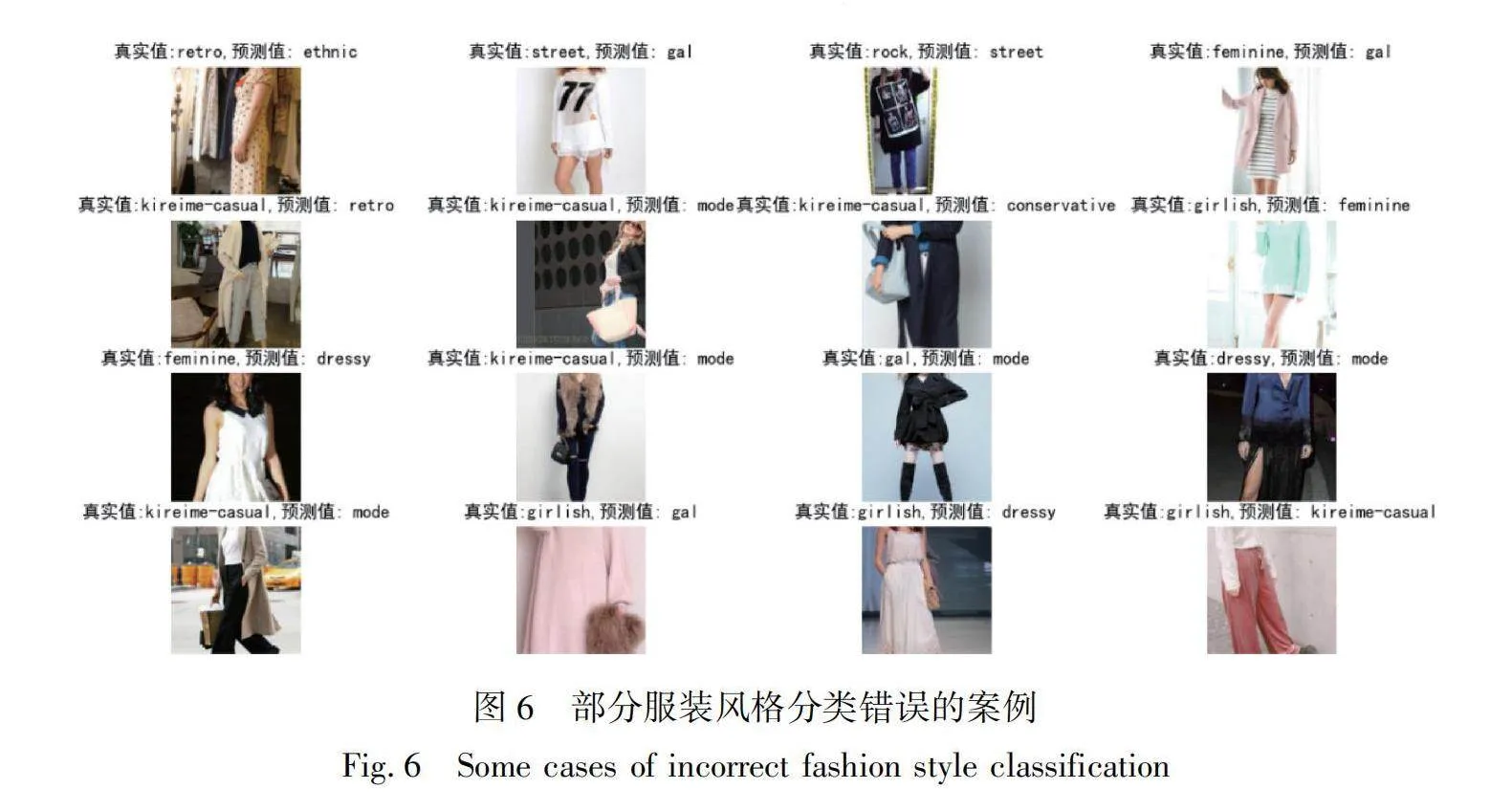

圖6中展示了一些錯誤分類的案例。由圖6可知,半身、側身或被遮擋的圖像更容易出現分類出錯的問題,這表明數據集中涵蓋了不同領域或來源的圖像,受到了環境、光照條件、拍攝設備、拍攝角度等因素的影響,可被歸類為跨域圖像。而這種跨域問題直接導致了模型分類性能的降低。因此,在實際應用中,為了提高分類準確率,應盡量選用同域圖像,即在相同的領域或環境中獲取的圖像。

3 結論

在人工進行服裝風格分類時,常受主觀性、地域等因素影響,導致服裝風格圖像分類錯誤。針對上述問題,本文研究了一種融合遷移學習和集成學習的服裝風格圖像分類方法。該方法首先采用了遷移學習方法,對預訓練模型進行微調訓練,訓練后得到新模型,然后選擇基于投票、加權平均和堆疊的集成

學習方法,分別對生成的新模型進行組合預測,最終實現服裝風格圖像分類功能。通過一系列實驗,得出如下結論:

a)與基于傳統卷積神經網絡的深度學習模型相比,基于自注意力機制的深度學習模型在服裝風格圖像分類與識別方面展現出較好的分類與識別能力,ViT Large 16模型的平均準確率比本文中的其他模型高出7.417%。

b)與單個模型相比,采用常見的集成學習方法可有效提高服裝風格圖像分類與識別的精度,在分類精度上提升了1.809%。

c)女性化、女孩風以及少女風這3類風格較相似易混淆,搖滾風格和街頭風格之間也容易混淆。

d)跨域圖像更容易導致服裝風格圖像識別的失敗。

后續研究可以根據服裝屬性等對相似風格進行更深入的分析,以提升模型的性能和分類準確性。此外,跨域服裝風格圖像分類問題有待進一步研究。

參考文獻:

[1]JEON Y, JIN S, HAN K. FANCY: human-centered, deep learning-based framework for fashion style analysis[C]//Proceedings of the Web Conference 2021. Ljubljana, Slovenia. ACM, 2021: 2367-2378.

[2]RYDING D, CLAUDIA, RUDAWSKA E, et al. Extending the consumer style inventory to define consumer typologies for secondhand clothing consumption in Poland[J].European Research Studies Journal, 2020: 410-433.

[3]TAKAGI M, SIMO-SERRA E, IIZUKA S, et al. What makes a style: Experimental analysis of fashion prediction[C]//IEEE International Conference on Computer Vision Workshops. Venice. IEEE, 2017: 2247-2253.

[4]李揚, 黃榮, 董愛華. 基于改進Bilinear-CNN的服裝圖像風格識別[J].東華大學學報(自然科學版),2021,47(3):90-95.

LI Yang, HUANG Rong, DONG Aihua. Fashion style recognition based on an improved Bilinear-CNN[J]. Journal of Donghua University(Natural Science),2021,47(3):90-95.

[5]WOOTTISART P, SRIPIAN P, THANASUAN K. The study of fashion style classification: harajuku-type kawaii and street fashion[C]//16th International Conference on Signal-Image Technology & Internet-Based Systems (SITIS). Dijon, France. IEEE, 2022: 402-408.

[6]AN H, LEE K Y, CHOI Y, et al. Conceptual framework of hybrid style in fashion image datasets for machine learning[J]. Fashion and Textiles, 2023, 10(1):18.

[7]MA Y, JIA J, ZHOU S, et al. Towards better understanding the clothing fashion styles: A multimodal deep learning approach[C]//Proceedings of the Thirty-First AAAI Conference on Artificial Intelligence. San Francisco, California, USA. ACM, 2017, 31(1):38-43.

[8]石爭浩, 李成建, 周亮, 等. Transformer驅動的圖像分類研究進展[J]. 中國圖象圖形學報, 2023, 28 (9): 2661-2692.

SHI Zhenghao, LI Chengjian, ZHOU Liang, et al. Survey on Transformer for image classification[J]. Journal of Image and Graphics, 2023, 28 (9): 2661-2692.

[9]曾華福, 楊杰, 李林紅. 基于改進ShuffleNet v1的服裝圖像分類算法[J]. 現代紡織技術, 2023, 31(2):23-35.

ZENG Huafu, YANG Jie, LI Linhong. Clothing image classification algorithm based on improved ShuffleNet v1[J]. Advanced Textile Technology,2023,31(2):23-35.

[10]LIU Z, MAO H, WU C Y, et al. A convnet for the 2020s[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans, LA, USA. IEEE, 2022: 11976-11986.

[11]TAN M, LE Q. Efficientnetv2: Smaller models and faster training[C]//International Conference on Machine Learning. Stockholm, Sweden, PMLR, 2021: 10096-10106.

[12]DOLLAR P, SINGH M, GIRSHICK R. Fast and accurate model scaling[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville, TN, USA. IEEE, 2021: 924-932.

[13]李翔, 張濤, 張哲, 等. Transformer在計算機視覺領域的研究綜述[J].計算機工程與應用, 2023, 59 (1): 1-14.

LI Xiang, ZHANG Tao, ZHANG Zhe, et al.Survey of transformer research in computer vision[J].Computer Engineering and Applications, 2023, 59 (1): 1-14.

[14]徐繼偉, 楊云. 集成學習方法:研究綜述[J]. 云南大學學報(自然科學版), 2018, 40 (6): 1082-1092.

XU Jiwei, YANG Yun. Ensemble learning methods: A research review[J]. Journal of Yunnan University (Natural Sciences Edition), 2018, 40 (6): 1082-1092.

A fashion style image classification method integrating transfer learning and ensemble learning

YOU Xiaoronga, LI Shufangb

(a. School of Intelligent Manufacturing;b. School of Intelligent Textiles and Materials, Changzhou

Vocational Institute of Textile and Garment, Changzhou 213164, China)

Abstract: The fashion industry plays an important role in the global economy, and its GDP scale shows a growing trend, currently accounting for approximately 2% of the global GDP. Fashion style classification can help consumers better understand and choose fashion products that suit their preferences, making it easier for them to find the styles and brands they are interested in. At the same time, fashion style classification also plays an important role in fashion research and design, providing inspiration and reference for designers. In addition, for fashion brand companies and retailers, the precise classification of fashion styles helps to better understand market demand and consumer preferences, thereby adjusting product categories and promotion strategies. Manual fashion style classification has the characteristics of subjectivity, diversity, variability and regionality, which can easily lead to errors in classification results. Therefore, it is important to improve the objectivity and accuracy of classification by using technical means, such as artificial intelligence.

In response to the above problems, this paper studied a fashion style image classification method that combines transfer learning and ensemble learning. Firstly, based on the FashionStyle14 data set, duplicate or invalid images were filtered out to construct a fashion style image data set. Secondly, pre-trained models such as EfficientNet V2, RegNet Y 16GF and ViT Large 16 were used for fine-tuning training to generate new models to achieve fashion style image classification with a single deep learning model. Thirdly, the new model was tested and its classification performance was evaluated according to the evaluation indicators, and a good deep learning model was selected. Fourthly, an ensemble learning method based on voting, weighted integration and stacking was built to perform combined predictions on the above models, so as to improve the generalization ability and stability of the model. Finally, the ensemble learning method with the best performance was selected to classify fashion styles. By using the above method, not only advanced algorithms were applied in artificial intelligence to fashion style classification, but also the effectiveness of the method in classifying various fashion styles was verified, and some similar fashion styles were discovered, which provided data support for further refinement of fashion style classification. It is found that compared with the deep learning model based on a traditional convolutional neural network, the deep learning model based on the self-attention mechanism shows better recognition ability in fashion style image classification and recognition; compared with a single model, the commonly used integrated learning method can effectively improve the accuracy of fashion style image classification and recognition; the three styles of femininity, girly style and maiden style are similar, and it is easy to confuse between rock style and street style; cross-domain images are more likely to lead to recognition failure of fashion style images.

In future research work, similar styles can be analyzed more deeply based on methods such as fashion attributes to improve the performance and classification accuracy of the model. In addition, in-depth research on cross-domain fashion style image classification and recognition issues is needed to explore more effective solutions.

Keywords: fashion style; transfer learning; ensemble learning; ViT model; image classification