基于鄰域特征編碼優化的液壓支架激光點云分割算法

摘要:受井下煤塵和易被遮擋的影響,液壓支架激光點云數據容易出現殘缺。現有點云分割算法難以獲取細粒度的點云特征,無法得到完整的點云結構信息,且易在鄰域內引入語義信息不相似的點,導致液壓支架激光點云分割精度低。針對上述問題,提出了一種基于鄰域特征編碼優化的液壓支架激光點云分割算法。引入了由鄰域特征編碼模塊、鄰域特征優化模塊和混合池化模塊組成的局部鄰域特征聚合模塊:鄰域特征編碼模塊在傳統三維坐標編碼的基礎上加入極坐標編碼和質心偏移來表征局部點云空間結構,提升對殘缺點云的特征提取能力;鄰域特征優化模塊通過特征距離判斷并丟棄冗余特征,來優化鄰域空間內的特征表達,從而更有效地學習點云局部細粒度特征,增強點云局部上下文信息;混合池化模塊結合注意力池化和最大池化,通過聚合鄰域內的顯著特征和重要特征來獲取具有豐富信息的單點特征,減少信息丟失。構建了由2 組局部鄰域特征聚合模塊和殘差連接組成的鄰域擴張模塊,以捕獲特征間的長距離依賴關系,擴大單個點的局部感受野,并聚合更多有效特征。實驗結果表明,該算法在液壓支架激光點云分割數據集上的平均交并比為93.26%,平均準確率為96.42%,可有效區分液壓支架不同的幾何結構,實現液壓支架各部件的準確分割。

關鍵詞:液壓支架;激光點云;點云分割;鄰域特征編碼;鄰域特征優化

中圖分類號:TD355 文獻標志碼:A

0 引言

液壓支架是綜采工作面的核心設備之一[1-2]。在回采過程中,液壓支架主要起頂板支護、保護作業人員安全等作用[3-4]。準確獲取液壓支架姿態是工作面環境感知的關鍵內容,也是工作面設備智能控制的基礎[5]。激光不受光照條件的影響,且信息具備三維特征,因此,激光點云是獲取液壓支架姿態的有效途徑之一[6]。而將液壓支架各個關鍵部件從繁雜的激光點云數據中分割出來,是獲取液壓支架姿態的前提和關鍵[7]。

傳統的點云分割算法包括基于邊緣檢測的算法、基于曲面擬合的算法及基于特征聚類的算法[8-10]。傳統的點云分割算法對于點云的質量要求較高,且依賴于手動設定特征。然而,煤塵對激光束的吸附作用使得工作面點云的質量相對較差;此外,大量液壓支架線性排列且處于動態變化中,液壓支架易受遮擋,點云數據容易出現殘缺,特征提取難度大。因此,傳統的點云分割算法難以滿足液壓支架點云精確分割的要求。

近年來,隨著以深度學習為代表的人工智能技術不斷取得突破,利用深度神經網絡處理復雜點云場景成為點云分割研究領域的熱點[11]。目前,基于深度神經網絡的點云分割算法大體上可分為3 類:基于體素的算法、基于多視圖的算法和基于點的算法。基于體素的算法是將無序的點云采樣為有序的體素,并通過三維卷積對體素進行處理[12-13]。這類算法解決了點云分布無序的難題,并保留了點云內在的幾何結構。然而,待分割對象相對于整個工作面場景來說,具有很強的稀疏性。因此,這類算法難以獲取細粒度的點云特征,且運算開銷隨著體素分辨率的提高而增大。基于多視圖的算法將三維點云投影到多個視圖中,不規則的點云數據被轉換為有序的像素數據,并使用二維卷積提取像素級別的特征,然后融合這些特征對圖像進行語義分割,再將結果映射回三維空間[14-15]。由于二維卷積在圖像分割領域的應用較為成熟,這類算法取得了一定成效。然而,點云的部分結構信息無法通過投影獲得,且無法較好處理點云間的遮擋問題。基于點的算法使用多層感知器(Multilayer Perceptron,MLP)對原始點云數據直接進行分割。如:PointNet[16]利用權值共享的MLP提取每個輸入點的特征,并通過最大池化將所有點的信息聚合得到全局特征,降低了點云的無序性;PointNet++[17]在PointNet 的基礎上引入層級聚合結構和球形鄰域查詢來學習不同分辨率的局部特征;RandLA?Net[18]采用隨機采樣法進行下采樣,并通過局部空間編碼學習保留幾何結構信息;SCF?Net[19]通過雙距離注意力池化聚合特征提升特征聚合的有效性;LEARD?Net[20]通過對顏色特征進行單獨處理并使用交叉編碼對特征進行增強。然而,基于點的算法采用基于歐氏距離的近鄰算法采集鄰域點,導致在鄰域內引入一些語義信息不相似的點,特別是在不同點云類別的分界處。

為提高液壓支架激光點云分割的精度,本文提出了一種基于鄰域特征編碼優化的液壓支架激光點云分割算法。該算法在傳統三維坐標編碼的基礎上引入極坐標編碼和質心偏移,來模擬點云的復雜空間結構;以特征距離為度量,優化局部鄰域的特征組成;通過最大池化和注意力池化來聚合鄰域內的顯著特征和重要特征,以獲取精確的單點特征表示;通過對特征進行2 次聚合來擴大局部感受野,提升特征的豐富性。

1 算法原理

1.1 整體框架

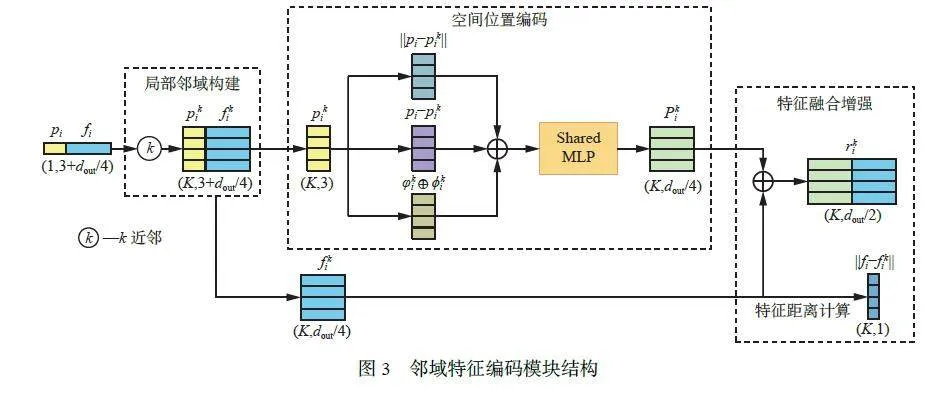

基于鄰域特征編碼優化的液壓支架激光點云分割算法框架如圖1 所示。N 為點云的點數;din 為輸入特征維度;c 為類別數量。

在編碼器中,通過1 個全連接層提取點云初級特征,并將維度提升至8。然后通過鄰域擴張模塊擴展單個點的感受野,捕獲更多上下文信息。最后通過隨機下采樣減少點數,以獲取全局特征。經過4 個鄰域擴張模塊和隨機下采樣后,點數從N 逐步減少至N/128,輸出的特征維度依次為32, 64, 128 和256。在該過程中,特征被逐步抽象和聚合,最終得到含有局部和全局信息的高維特征。這些高維特征經過一個MLP 進一步轉換和整合,產生一個統一的特征表示,以便為后續的解碼階段提供更有效的信息。

在解碼器中,使用最鄰近插值對點云進行特征的上采樣,將點云數量調整到與原始點云數量相等,逐步恢復特征的空間分辨率,并通過跳躍連接與編碼層特征進行拼接,保留更多原始信息,避免在多層特征提取過程中丟失重要的細節信息, 再通過MLP 對特征進行進一步的細化和重建。經過解碼器后輸出的特征保留了編碼器階段提取的豐富語義信息和全局上下文信息。

在分類器中,使用3 個全連接層對解碼器輸出的特征進行語義標簽預測。

1.2 鄰域擴張模塊

感受野的大小與點云語義分割的性能直接相關,較大的感受野可以使算法在處理單個點時關注到更大范圍的區域,從而更好地捕捉待分割點云的整體幾何結構。為擴展單個點的感受野,設計了鄰域擴張模塊, 結構如圖2 所示(dout 為輸出特征維度)。輸入特征首先經過一個共享MLP(Shared MLP)提取特征并轉換特征維度為dout/4,隨后經過2 組串聯的局部鄰域特征聚合模塊進行鄰域特征提取、優化和聚合,得到的單點特征再通過共享MLP 將維度升至dout,以提供更豐富和抽象的表達。同時,輸入特征通過一個共享MLP 映射添加到聚合后特征上,并經過Leaky ReLU 函數激活得到輸出特征。

鄰域擴張模塊通過對特征進行2 次聚合,有效擴展了單個點的感受野,能夠捕獲的上下文信息顯著增加。將特征映射添加到聚合后的特征上,是一種高效的殘差連接方式,可實現特征復用,彌補在特征提取過程中丟失的原始信息,也有助于算法捕捉輸入特征與聚合后特征的長距離依賴關系。

1.3 局部鄰域特征聚合模塊

在綜采工作面場景中,采集到的激光點云質量較差,且激光點云具有無序性和稀疏性等特點,直接對點云進行處理,難以提取到點云局部鄰域的幾何特征。為增強局部特征的表達能力,通過局部鄰域特征聚合模塊對單個點的局部鄰域進行特征聚合,充分利用鄰域點之間的空間關系和特征相似性,從而將局部區域內的點用一個更具代表性的特征向量來表示。局部鄰域特征聚合模塊由鄰域特征編碼模塊、鄰域特征優化模塊、混合池化模塊組成,其中混合池化模塊包括注意力池化和最大池化。

1.3.1 鄰域特征編碼模塊

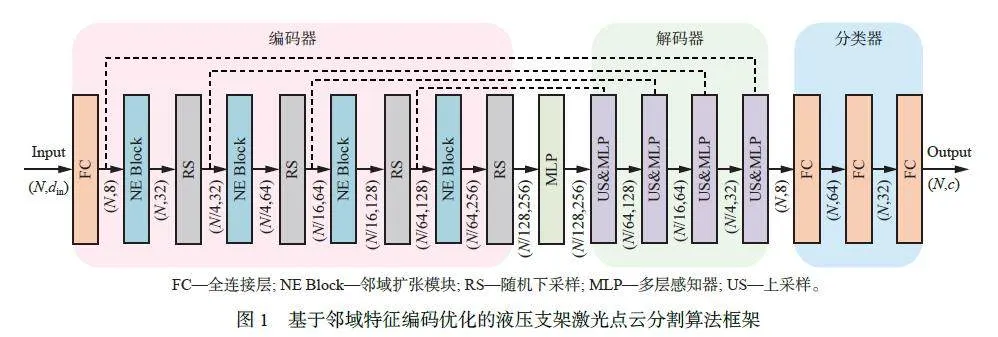

為更好地感知點云的空間結構并提升局部特征的豐富性,最大程度地減少局部細節特征的丟失,鄰域特征編碼模塊在傳統三維坐標編碼的基礎上加入極坐標編碼,并通過質心偏移來更新極坐標編碼后的局部方向角來獲得點云的空間位置關系信息。鄰域特征編碼模塊由局部鄰域構建、空間位置編碼和特征融合增強3 個部分組成,如圖3 所示。

1) 局部鄰域構建。針對輸入點云中的一個中心點i,通過近鄰算法收集K 個鄰居點作為中心點i 的鄰域,從而得到相對于中心點坐標和特征的第k 個鄰域點坐標和特征,k∈[1,K]。

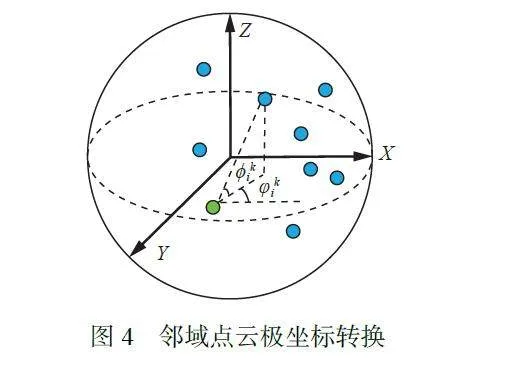

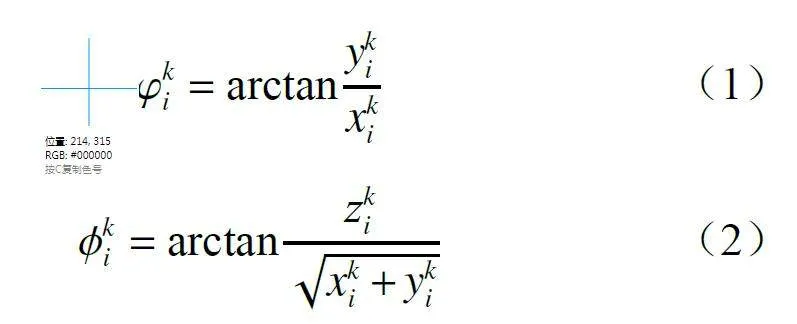

2) 空間位置編碼。為保證點云關于Z 軸的旋轉不變性,降低特征對于水平朝向的敏感度,將點云在笛卡爾坐標系下的表示轉換到極坐標系下。

式中:φki,?ki分別為極坐標系下中心點i 與第k 個鄰域點的水平方向角和垂直方向角;(xki ,yki,zki)中心點i 和第k 個鄰域點在笛卡爾坐標系下的相對坐標。

鄰域點云極坐標轉換如圖4 所示。

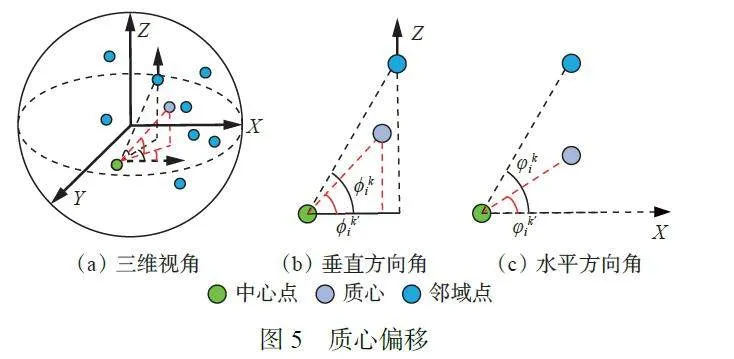

為高效模擬點云復雜的幾何結構并提升算法面對隨機采樣操作的魯棒性[21],引入質心偏移操作,即計算局部鄰域的質2SoTWom20odLK0C/qGa16fiLU/NsLFZnciR1spLdN2A=心,求得質心與中心點i 的水平方向角φi和垂直方向角?i,并對中心點與鄰域點的角度進行偏移更新。

φk′i = φki-φi (3)

?k′i = ?ki-?i (4)

式中φk′i,?k′i分別為更新后中心點 i 與第 k 個鄰域點的水平方向角和垂直方向角。

質心偏移如圖5 所示。

為完整利用鄰域空間內的可利用特征和充分學習點之間的關系信息,將中心點i 與第k 個鄰域點的相對坐標(pi - pki)、歐氏距離||pi - pki||及通過鄰域點云極坐標轉換和質心偏移更新后的水平方向角φk′i和垂直方向角?k′i拼接,再經過MLP 后得到空間位置編碼后的特征Pki。

Pki= MLP(φk′i⊕?k′i⊕(pi - pki)⊕pi - pki)(5)

式中⊕為拼接操作。

3) 特征融合增強。計算中心點i 與第k 個鄰域點的特征距離||fi - f ki||,并將鄰域點特征f ki與空間位置編碼后的特征Pki進行拼接,得到增強后的點云鄰域特征rki。

rki = Pki⊕ f ki (6)

1.3.2 鄰域特征優化模塊

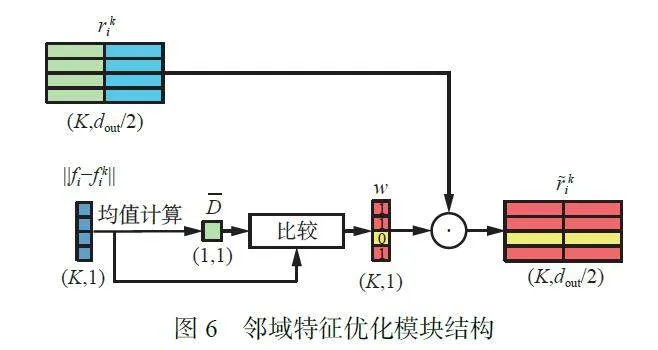

鄰域特征編碼模塊獲得點云的空間位置關系信息,但沒有考慮增強后的點云鄰域特征中是否包含冗雜的信息。同時, 近鄰算法通常以歐氏距離作為尺度來尋找鄰域點,沒有考慮到語義距離在其中起到的作用,導致部分鄰域點在語義特征上可能與中心點不相似。為解決這些問題,設計了鄰域特征優化模塊,丟棄與中心點語義特征相似度較低的點,優化整個鄰域空間的特征信息,使算法能夠更加準確地學習點云局部細粒度特征。

鄰域特征優化模塊結構如圖6 所示。首先,計算鄰域內K 個點的平均特征距離D,將平均特征距離D和中心點i與第k個鄰域點的特征距離||fi - f ki||進行比較。若||fi - f ki|| >D,則將該鄰域點的權重置為0,表明該鄰域點在語義特征中距離中心點較遠,忽視該點特征。最終將得到的權重w與增強后的點云鄰域特征rki進行點乘,得到優化后的點云鄰域特征~rki。

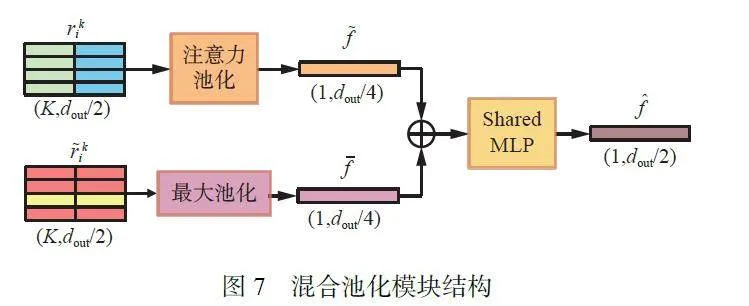

1.3.3 混合池化模塊

逐點特征表示的準確性是影響點云分割性能的關鍵性因素之一,現有算法多采用單一的池化單元聚合編碼后的局部特征,導致信息提取不夠充分,出現信息丟失。為解決上述問題,并充分利用編碼和優化后的特征,設計了混合池化模塊來聚合鄰域特征。混合池化模塊由提取顯著性特征的最大池化和輻射全局獲取特征間相似性的注意力池化組成,如圖7 所示。

首先,為強化算法對于特征的表達能力,使用注意力池化來捕捉鄰域點之間的特征相似性。這里利用增強后的點云鄰域特征rki來計算注意力分數,特征越重要則注意力分數越高。注意力分數ski通過一個共享參數的MLP 和一個softmax 函數來學習。

2 液壓支架激光點云分割實驗

2.1 數據集

2.1.1 數據采集

使用Ouster 32 線激光雷達作為液壓支架激光點云分割數據集的采集設備,將其安裝于小車和滑軌上,并沿采煤機前進方向移動,采集多幀液壓支架激光點云數據。

2.1.2 數據增強

為了使算法可以更好地學習不同空間位置、姿態和尺度的液壓支架點云,從而表現出更好的分割性能,采用Cloud Compare 軟件對點云場景進行旋轉、縮放、剪切等操作(圖8),以實現對原始點云數據的增強。

2.1.3 數據集標注與劃分

在液壓支架激光點云分割數據集中共有300 個點云場景,其中200 個點云場景用于訓練(其中50 個點云場景經過數據增強) , 100 個點云場景用于測試。激光點云的主要分割對象為液壓支架,主要包括立柱、頂梁、掩護梁、底座、連桿等,如圖9 所示。使用Cloud Compare 軟件在每個場景中標注4 個類別,分別為立柱、頂梁、掩護梁和其他,其對應標簽分別為0,1,2,3。

2.2 點云分割精度評價指標

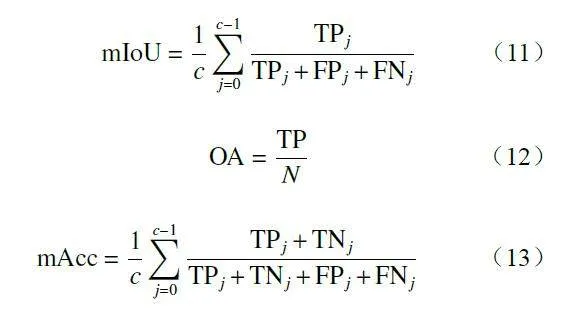

采用平均交并比(mean Intersection over Union,mIoU) 、總體準確率(Over all Accuracy,OA)和平均準確率(mean class Accuracy,mAcc)作為點云分割精度的評價指標。

式中:TPj, TNj, FPj,FNj分別為第j 個類別中真陽性、真陰性、假陽性和假陰性的點數;TP為所有為真陽性的點數。

2.3 實驗條件

實驗運行環境:CPU 為Intel Xeon(R) Gold 6146CPU@3.20 GHz,GPU 為NVIDIA Tesla T4,操作系統為Ubuntu 18.04.6 LTS。算法基于Tensorflow 框架實現。實驗選用Adam 優化算法,初始學習率設置為0.01,每訓練1 輪衰減5%。每次抽取固定數量的點(10 240 個)進行訓練,設置鄰域點的數量K 為16,批尺寸大小為4,最大訓練輪數為60。

2.4 對比實驗

為驗證本文算法在分割液壓支架激光點云上的有效性, 與常用于分割大規模點云場景數據的RandLA?Net 算法進行對比。

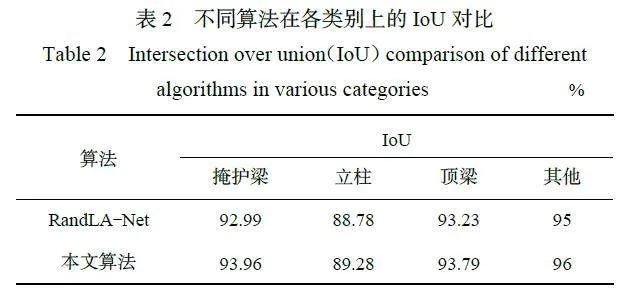

本文算法與RandLA?Net 算法在液壓支架激光點云分割數據集上測試的各項評價指標結果見表1,其中在立柱、頂梁、掩護梁和其他這4 個類別上的交并比(Intersection over Union, IoU)對比結果見表2。可看出本文算法在mAcc, OA和mIoU 上較RandLA?Net 算法分別高出0.49%, 0.52%和0.75%,在4 個類別上的IoU 均高于RandLA?Net算法。

本文算法與RandLA?Net 算法分割結果可視化對比如圖10 所示。

在場景1 中的A 處,液壓支架高度較低,且遠離激光雷達的部分液壓支架掩護梁的尾部B 處出現殘缺,導致RandLA?Net 算法對點云做出錯誤分割,如在頂梁、擋煤板和護欄距離較近的A2 位置,將頂梁錯分為擋煤板和護欄的一部分,在B2 處將掩護梁識別為立柱;而本文算法使用更加有效的空間位置編碼,全面學習了點與點的空間位置關系,強化了局部鄰域內的特征表示,從而可有效區分不同的幾何結構,得到了正確的分割結果。

在場景2 中,立柱、頂梁、擋煤板和護欄接觸的C 處部分點云較為稀疏,且點云邊界模糊,分割難度大。本文算法雖然沒有對C3 處的所有點做出完全正確的分割,但仍對邊界做出了大致的劃分,尤其是對頂梁做出了正確的分割,效果優于RandLA?Net 算法在C2 處的分割。

在場景3 中,立柱、掩護梁和頂梁在D 和E 處接觸較為緊密,RandLA?Net 算法在立柱的底部D2 位置及立柱、掩護梁和頂梁三者的交界E2 位置均做出錯誤分割;而本文算法由于加入了鄰域特征優化模塊,在不同語義類別物體接觸緊密的區域內,去除了冗余的特征,在D3 處和E3 處對不同類別的點云做出了準確分割。

在場景4 中,受激光雷達采集角度影響,點云數量較少。在擋煤板和護欄的尾部F 處, RandLA?Net 算法將其錯分為掩護梁,而本文算法則做出了正確分割。

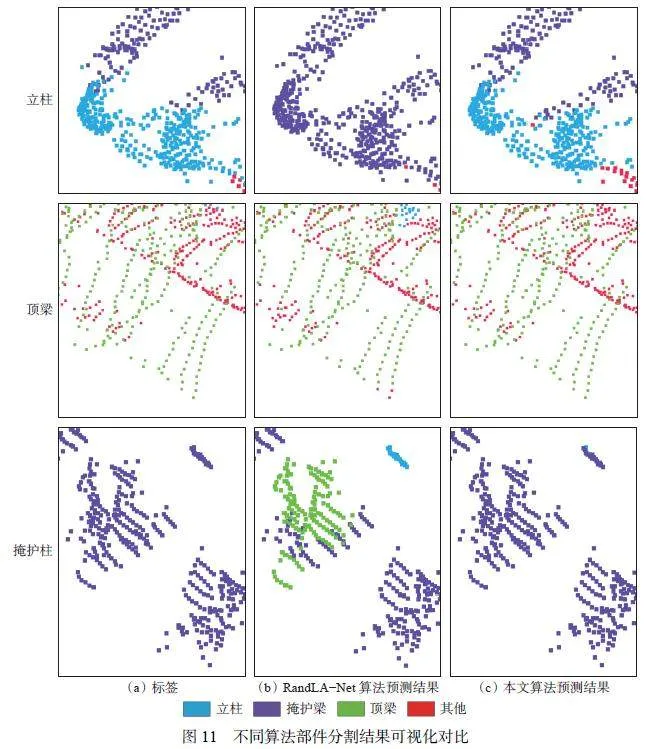

為進一步測試算法的先進性,對整體分割效果較差場景(OA 低于85%)中的部件進行對比分析,可視化結果如圖11 所示。

在立柱與掩護梁較為接近的位置, RandLA?Net 算法將立柱與掩護梁混為一體,本文算法雖對部分支柱做出了錯誤分割,但仍大致判斷出了立柱的輪廓,做出了正確的分割。

在頂梁的尾部,可利用點數較少, RandLA?Net算法做出了錯誤分割,本文算法則識別出頂梁結構。

在掩護梁被遮擋導致結構不完整的部分,RandLA?Net 算法由于無法完整學習到整體的幾何結構,將掩護梁錯分為頂梁,而本文算法充分利用空間內的特征,最終進行了正確的分割。

2.5 消融實驗

為驗證鄰域特征編碼模塊、鄰域特征優化模塊、混合池化模塊和鄰域擴張模塊對于算法性能的影響,進行消融實驗,結果見表3(以僅使用1 次注意力池化的RandLA?Net 算法為基準算法1)。

從表3 可看出:算法1 的mIoU 最低;算法2 使用以極坐標轉換和質心偏移為核心的鄰域特征編碼模塊替代原有僅在笛卡爾坐標系下進行編碼的模塊,解決了特征編碼不具體和編碼后信息不充分的問題,mIoU 得到了提升;算法3 在算法2 的基礎上引入了鄰域特征優化模塊,實現了對冗余特征的剝離,鄰域的特征表示更加準確,mIoU 較算法2 提升了0.26%;算法4 用混合池化替代注意力池化后,算法性能得到改善,這是由于混合池化使得算法可以關注局部最顯著的特征,同時也能面向所有鄰域點自適應地聚合重要特征;算法5(本文算法)在算法4 的基礎上引入了鄰域擴張模塊,通過組合殘差連接和2 組局部鄰域特征聚合模塊替代使用1 個局部鄰域特征聚合模塊的方式,擴大了局部感受野,豐富了局部鄰域的上下文信息,mIoU 達到最優。

3 結論

1) 為提高液壓支架激光點云的分割精度,提出了一種基于鄰域特征編碼優化的液壓支架激光點云分割算法。該算法引入了由鄰域特征編碼模塊、鄰域特征優化模塊和混合池化模塊組成的局部鄰域特征聚合模塊,以實現特征提取、優化和聚合;通過由2 組局部鄰域特征聚合模塊和殘差連接組成的鄰域擴張模塊來擴大感受野范圍,保留更大范圍的上下文信息。

2) 鄰域特征編碼模塊在傳統三維坐標編碼的基礎上引入鄰域空間方向角信息,使提取到的特征更加全面和具有可區分性,降低了點云數據殘缺對于特征提取的影響;鄰域特征優化模塊通過判斷特征距離保留與中心點更為相近的特征,優化局部空間內的特征表達;混合池化模塊結合注意力池化和最大池化,有針對性地聚合鄰域內的顯著特征和重要特征,從而得到具有豐富信息的特征向量,減少信息丟失。

3) 在液壓支架激光點云分割數據集上的實驗結果表明, 所提算法的mIoU 為93.26%, mAcc 為96.42%,相較于RandLA?Net 算法分別提升了0.75%和0.49%;可有效區分液壓支架不同的幾何結構,精準確定部件邊界,實現液壓支架各部件的準確分割。

參考文獻(References):

[ 1 ]王國法,劉峰,孟祥軍,等. 煤礦智能化(初級階段)研究與實踐[J]. 煤炭科學技術,2019,47(8):1-36.

WANG Guofa, LIU Feng, MENG Xiangjun, et al.Research and practice of coal mine intellectualization(primary stage) [J]. Coal Science and Technology,2019,47(8):1-36.

[ 2 ]GUO Jun, HUANG Wenbo, FENG Guorui, et al.Stability analysis of longwall top-coal caving face inextra-thick coal seams based on an innovative numericalhydraulic support model[J]. International Journal ofMining Science and Technology,2024,34(4):491-505.

[ 3 ]高有進,楊藝,常亞軍,等. 綜采工作面智能化關鍵技術現狀與展望[J]. 煤炭科學技術,2021,49(8):1-22.

GAO Youjin, YANG Yi, CHANG Yajun, et al. Statusand prospect of key technologies of intelligentization offully-mechanized coal mining face[J]. Coal Science andTechnology,2021,49(8):1-22.

[ 4 ]王國法,龐義輝,許永祥,等. 厚煤層智能綠色高效開采技術與裝備研發進展[J]. 采礦與安全工程學報,2023,40(5):882-893.

WANG Guofa, PANG Yihui, XU Yongxiang, et al.Development of intelligent green and efficient miningtechnology and equipment for thick coal seam[J].Journal of Mining & Safety Engineering, 2023, 40(5) :882-893.

[ 5 ]王國法,龐義輝,任懷偉,等. 智慧礦山系統工程及關鍵技術研究與實踐[J]. 煤炭學報, 2024, 49(1) :181-202.

WANG Guofa, PANG Yihui, REN Huaiwei, et al.System engineering and key technologies research andpractice of smart mine[J]. Journal of China CoalSociety,2024,49(1):181-202.

[ 6 ]李建,任懷偉,鞏師鑫. 綜采工作面液壓支架狀態感知與分析技術研究[J]. 工礦自動化, 2023, 49(10) :1-7,103.

LI Jian,REN Huaiwei,GONG Shixin. Research on stateperception and analysis technology of hydraulic supportin fully mechanized working face[J]. Journal of MineAutomation,2023,49(10):1-7,103.

[ 7 ]王國法,杜毅博. 智慧煤礦與智能化開采技術的發展方向[J]. 煤炭科學技術,2019,47(1):1-10.

WANG Guofa, DU Yibo. Development direction ofintelligent coal mine and intelligent miningtechnology[J]. Coal Science and Technology, 2019,47(1):1-10.

[ 8 ]XI Xiaohuan, WAN Yiping, WANG Cheng. Buildingboundaries extraction from points cloud using an imageedge detection method[C]. IEEE InternationalGeoscience and Remote Sensing Symposium, Beijing,2016:1270-1273.

[ 9 ]SCHNABEL R, WAHL R, KLEIN R. EfficientRANSAC for point-cloud shape detection[J]. ComputerGraphics Forum,2007,26(2):214-226.

[10]ZHOU Dingfu,FANG Jin,SONG Xibin,et al. Joint 3Dinstance segmentation and object detection forautonomous driving[C]. IEEE/CVF Conference onComputer Vision and Pattern Recognition, Seattle,2020:1836-1846.

[11]XU Yongyang,TANG Wei,ZENG Ziyin,et al. NeiEANET:semantic segmentation of large-scale point cloudscene via neighbor enhancement and aggregation[J].International Journal of Applied Earth Observation andGeoinformation, 2023, 119. DOI: 10.1016/j.jag.2023.103285.

[12]MATURANA D, SCHERER S. VoxNet: a 3Dconvolutional neural network for real-time objectrecognition[C]. IEEE/RSJ International Conference onIntelligent Robots and Systems, Hamburg, 2015:922-928.

[13]LE T, DUAN Ye. PointGrid: a deep network for 3Dshape understanding[C]. IEEE/CVF Conference onComputer Vision and Pattern Recognition, Salt LakeCity,2018:9204-9214.

[14]SU Hang, MAJI S, KALOGERAKIS E, et al. Multiviewconvolutional neural networks for 3D shaperecognition[C]. IEEE International Conference onComputer Vision,Santiago,2015:945-953.

[15]MILIOTO A, VIZZO I, BEHLEY J, et al. RangeNet:fast and accurate LiDAR semantic segmentation[C].IEEE/RSJ International Conference on Intelligent Robotsand Systems,Macau,2019:4213-4220.

[16]CHARLES R Q, HAO Su, MO Kaichun, et al.PointNet: deep learning on point sets for 3Dclassification and segmentation[C]. IEEE Conferenceon Computer Vision and Pattern Recognition,Honolulu,2017:77-85.

[17]QI C R, YI Li, SU Hao, et al. PointNet++: deephierarchical feature learning on point sets in a metricspace[C]. The 31st International Conference on NeuralInformation Processing Systems, Long Beach, 2017:5105-5114.

[18]HU Qingyong,YANG Bo, XIE Linhai, et al. RandLANet:efficient semantic segmentation of large-scale point clouds[C]. IEEE/CVF Conference on Computer Visionand Pattern Recognition,Seattle,2020:11105-11114.

[19]FAN Siqi, DONG Qiulei, ZHU Fenghua, et al. SCFNet:learning spatial contextual features for large-scalepoint cloud segmentation[C]. IEEE/CVF Conference onComputer Vision and Pattern Recognition, Nashville,2021:14499-14508.

[20]ZENG Ziyin, XU Yongyang, XIE Zhong, et al.LEARD-Net: semantic segmentation for large-scalepoint cloud scene[J]. International Journal of AppliedEarth Observation and Geoinformation, 2022, 112.DOI:10.1016/j.jag.2022.102953.

[21]QIAN Wei, XING Weiwei, FEI Shumin. H∞ stateestimation for neural networks with general activationfunction and mixed time-varying delays[J]. IEEETransactions on Neural Networks and LearningSystems,2021,32(9):3909-3918.

基金項目:河南省科技攻關項目(232102210040)。