基于多智能體深度強化學習的車聯網資源分配方法

摘 要:在車聯網中,合理分配頻譜資源對滿足不同車輛鏈路業務的服務質量(Quality of Service,QoS) 需求具有重要意義。為解決車輛高速移動性和全局狀態信息獲取困難等問題,提出了一種基于完全分布式多智能體深度強化學習(Multi-Agent Deep Reinforcement Learning,MADRL) 的資源分配算法。該算法在考慮車輛通信延遲和可靠性的情況下,通過優化頻譜選擇和功率分配策略來實現最大化網絡吞吐量。引入共享經驗池機制來解決多智能體并發學習導致的非平穩性問題。該算法基于深度Q 網絡(Deep Q Network,DQN),利用長短期記憶(Long Short Term Memory,LSTM) 網絡來捕捉和利用動態環境信息,以解決智能體的部分可觀測性問題。將卷積神經網絡(Convolutional Neural Network,CNN) 和殘差網絡(Residual Network,ResNet) 結合增強算法訓練的準確性和預測能力。實驗結果表明,所提出的算法能夠滿足車對基礎設施(Vehicle-to-Infrastructure,V2I) 鏈路的高吞吐量以及車對車(Vehicle-to-Vehicle,V2V) 鏈路的低延遲要求,并且對環境變化表現出良好的適應性。

關鍵詞:車聯網;資源分配;多智能體深度強化學習;深度Q 網絡

中圖分類號:TN929. 5 文獻標志碼:A 開放科學(資源服務)標識碼(OSID):

文章編號:1003-3016(2024)06-1388-10

0 引言

隨著通信技術的飛速發展,車聯網作為物聯網中車輛通信網絡的新范式,對提升交通服務的安全性和舒適性起著日益重要的作用[1]。其中,蜂窩車聯網(Cellular Vehicle-to-Everything,C-V2X)通信技術實現了車輛與車輛、車輛與基礎設施、車輛與行人以及車輛與互聯網之間通信的無縫連接,為車聯網提供了全方位的通信技術支持[2]。C-V2X 通信技術主要通過支持車對基礎設施(Vehicle-to-Infra-structure,V2I)和車對車(Vehicle-to-Vehicle,V2V)2 種通信模式為不同服務質量(Quality of Service,QoS)需求提供不同的應用服務[3]。其中,V2I 通信主要應用于提供高數據傳輸速率的非安全相關的應用服務,而V2V 通信則專注于實現低延遲和高可靠性的實時信息傳輸[4-5]。然而,面對網絡資源的稀缺性以及車聯網中服務類別的多元化,如何實現V2I 和V2V 鏈路之間的協同資源共享以保證CV2X 網絡資源的有效利用是車聯網資源分配時面臨的巨大挑戰。

目前,車聯網中的資源分配問題已得到廣泛研究,文獻[6-8]采用傳統優化算法來解決這一問題。然而,隨著無線網絡多樣性和復雜性的增加,這些傳統算法面臨著嚴峻的挑戰,例如,車聯網環境的動態不確定性使得實時獲取信道狀態信息變得困難。同時,由于車聯網用戶具有不同的服務需求,構建的優化問題和約束條件通常是非凸的,這使得優化算法在求解時容易陷入局部最優解[9]。因此,如何設計一個更智能、更靈活的資源分配算法成為車聯網中的一個重要問題。

隨著人工智能技術的不斷進步,深度強化學習(Deep Reinforcement Learning,DRL)在無線通信領域得到了廣泛應用。與傳統的優化算法相比,DRL展現出更強大的解決復雜問題的能力。通過與未知環境的交互,DRL 能夠學習如何做出最優決策,以最大化長期累積回報。此外,針對一些難以通過傳統算法優化的目標,DRL 可以通過設計相應的訓練獎勵來解決。因此,DRL 為解決車聯網中資源分配問題帶來了全新思路。文獻[10]研究了設備到設備(Device-to-Device,D2D)網絡的聯合信道選擇和功率控制問題,以最大化D2D 網絡的加權和速率為目標,提出了一種基于分布式DRL 的算法,并通過仿真結果證明了即使沒有全局瞬時信道狀態信息,該算法也能有良好的性能表現。文獻[3]在包含V2V 鏈路和V2I 鏈路的認知車輛網絡中應用了一種改進的深度Q 網絡(Deep Q Network,DQN)算法來提高頻譜利用率。上述算法在靜態環境模型上表現良好,但并不適用于動態變化的車聯網環境。文獻[11]針對V2X 通信資源分配問題,提出了一種使用DQN 進行子頻帶選擇和使用深度確定性策略梯度(Deep Deterministic Policy Gradient,DDPG)進行發射功率分配的DRL 算法,在此基礎上,加入元強化學習來提高算法對動態環境的適應性。但在該算法中,同時訓練2 種不同的DRL 算法會增加模型訓練的難度,使算法變得更復雜。文獻[12]針對不同的QoS 需求,提出了一種基于鏈路優先級集中式的強化學習頻譜資源分配算法,該算法實現了在對一般鏈路無干擾的情況下,為高優先級鏈路提供了高質量的通信支持,并且在實際場景中展現了出色的抗噪聲性能。但該算法采用的是集中式控制方案,每條鏈路都需要與基站進行信息交互,增加了通信開銷和傳輸時延。文獻[13 -15]都采用基于DQN的多智能體深度強化學習(Multi-Agent Deep Rein-forcement Learning,MADRL)算法來解決車聯網環境中的資源分配問題,然而,這些算法均未考慮多個智能體同時探索學習所引發的非平穩性問題,而這一問題將直接影響算法的收斂速度,從而降低算法的性能。

為解決上述問題,本文提出了一種完全獨立的分布式MADRL 的資源分配算法,以進一步提升動態車聯網環境下資源共享效率。在該算法中,經過訓練和學習的V2V 用戶僅依賴局部環境觀測值就可以學到最佳資源分配策略,即最優的子信道選擇和功率分配策略。為解決多智能體并發學習帶來的非平穩性問題,本文引入共享經驗池機制,以促進智能體之間更好地合作和學習。為解決每個智能體對環境的部分可觀測問題,采用長短期記憶(LongShort Term Memory,LSTM)和卷積神經網絡(Convo-lutional Neural Network,CNN)結合的殘差網絡(Re-sidual Network,ResNet)跳躍連接結構,這種結構使得智能體能夠捕捉和利用環境狀態信息的時間序列關系,從而提高了算法處理序列數據的能力,同時也增強了算法的泛化能力。最后,通過仿真實驗驗證了該算法的有效性,確保了在滿足V2V 鏈路延遲約束條件的同時減少了V2V 鏈路對V2I 鏈路的干擾。

1 系統模型

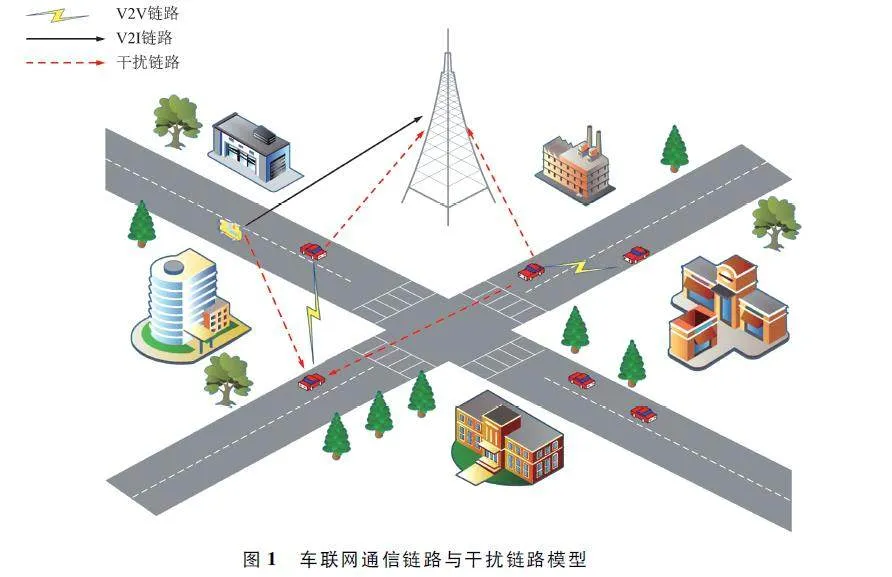

本文考慮擁有一個基站和多輛車構成的城市道路交通的C-V2X 通信場景。在該場景中,具有M 輛車的V2I 鏈路完成高吞吐量的數據傳輸任務,而具有N 輛車的V2V 鏈路實現低延遲、高可靠的實時信息傳輸任務。本文只考慮V2I 通信的上行鏈路,并假設所有車輛用戶的收發機都采用單天線,此外,假設M 條V2I 鏈路被預先分配了M 個具有固定發射功率的正交子信道,即第m 條V2I 鏈路占用第m 個子信道并且這些子信道之間無干擾。為提高頻譜利用率,這些子信道可以被V2V 鏈路重用。考慮到實際情況,V2V 鏈路的數量往往遠大于V2I 鏈路的數量,為更有效地利用有限的頻譜資源,將V2V 鏈路重用V2I 鏈路的頻譜資源是必要且合理的。因此,本文主要目標是為這些V2V 鏈路設計一種有效的頻譜共享方案,以使這2 種類型的車輛鏈路以最小的信令開銷到達各自的目標。圖1 顯示了V2V 共享V2I 鏈路時的通信鏈路和干擾鏈路的復雜關系。

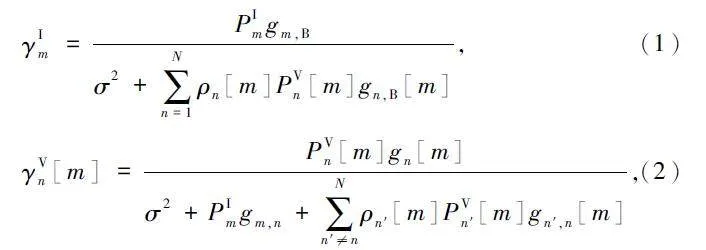

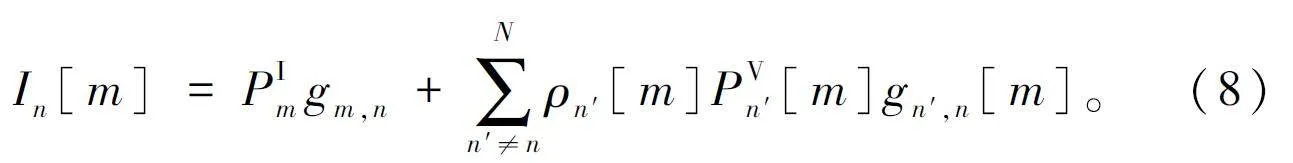

當第n 條V2V 鏈路共享第m 條V2I 鏈路的子信道時,這條V2V 鏈路的接收端可能受到來自其他V2V 鏈路以及V2I 鏈路的發射端的干擾,而第m 條V2I 鏈路的接收端會受到來自V2V 鏈路的干擾,則第m 條V2I 鏈路與第n 條V2V 鏈路的信干噪比(Signalto Interference plus Noise Ratio,SINR)分別表示為:

式中:PIm 、PVn[m]和PVn′[m]分別表示第m 條V2I 鏈路、第n 條V2V 鏈路和除n 以外的其他V2V 鏈路(如n′)的發射功率,σ2 表示噪聲功率,ρn [m]、ρn′[m]表示第n 和n′條V2V 鏈路是否重用第m 條V2I 鏈路,如果重用,其值為1,否則值為0;gm,B 表示第m 條V2I 鏈路的信道功率增益,gn,B [m]表示V2V 鏈路n 對V2I 鏈路m 的干擾信道增益,gn [m]表示第n 條V2V 鏈路的信道增益,gm,n 表示V2I 鏈路m 對V2V 鏈路n 的干擾信道增益,gn′,n [m]表示其他V2V 鏈路n′對V2V 鏈路n 的干擾信道增益。發射功率計算公式為:

g = αh, (3)

式中:α 表示與頻率無關的大尺度衰落,即陰影衰落和路徑損耗;h 表示與頻率相關的小尺度衰落信道增益。對于信道衰落,本文同時考慮大尺度和小尺度衰落,并假設信道衰落在一個子信道內大致相同并且在不同子信道之間相互獨立。由此,第m 條V2I 鏈路和第n 條V2V 鏈路的信道總吞吐量分別為:

CIm = W lb(1 + γIm ), (4)

CVn[m] = W Ib(1 + γVn[m]), (5)

式中:W 為信道帶寬。

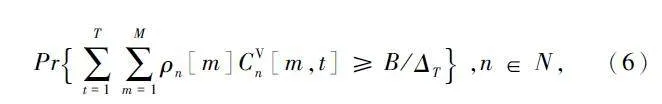

如上所述,本文的目標是在提高V2I 鏈路的總吞吐量的同時,滿足V2V 鏈路低延遲、高可靠的實時數據傳輸的要求。為此本文定義在一定時間限度內,成功傳輸有效載荷的概率為:

式中:B 表示在每個周期T 內生成的V2V 鏈路傳輸載荷的大小,單位為bit;ΔT 表示信道相干時間。

綜上所述,本文研究的車聯網中資源分配問題可以描述為:在V2V 鏈路中,如何智能地重用V2I 的子信道,并選擇適當的發射功率進行數據傳輸,以減少V2V 鏈路的傳輸時延,同時減少其對V2I 鏈路的干擾,即在追求最大化V2I 鏈路總吞吐量的同時提高V2V 鏈路的單位時間內載荷成功傳輸率。

2 算法方案設計

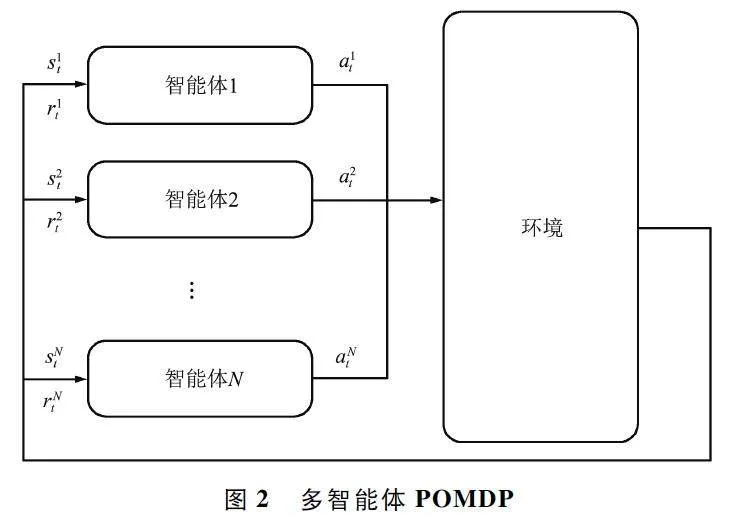

MADRL 是應對車聯網中動態不確定性以及全局信道狀態信息獲取困難的有效方法。在MADRL模型中,多個智能體采取試錯的方式不斷與環境交互,以獲得最大化累積獎勵來優化信道選擇與功率控制策略。由于V2V 鏈路中每個用戶作為獨立智能體無法完全獲取信道狀態的完整信息,因此采用部分可觀察馬爾科夫決策過程(Partially ObservableMarkov Decision Process,POMDP)對動態頻譜分配和功率選擇過程進行建模,該過程由動作、狀態和獎勵描述。如圖2 所示,在t 時刻,獲得環境狀態snt的V2V 鏈路n,根據策略做出動作ant,所有V2V 鏈路的動作同時被執行后,環境狀態依據狀態轉移概率轉移到下一時刻的狀態snt+1 ,并且每條V2V 鏈路得到執行各自動作后的獎勵rnt。

2. 1 狀態空間

V2V 鏈路用戶不能在t 時刻觀測到全局環境狀態St,而只能獲得和自己相關的環境狀態snt,并且其他V2V 鏈路的動作也是未知的。V2V 鏈路n 占用第m 條V2I 鏈路傳輸數據時,該V2V 鏈路可獲得的狀態包括V2V 鏈路n 的信道增益gn[m]、受到其他V2V 鏈路的干擾gn′,n[m]、對V2I 鏈路的干擾gn,B [m]以及受到V2I 鏈路m 的干擾gm,n。則V2V 鏈路n占用V2I 鏈路m 傳輸數據時的關聯信道增益表示為:

Gn [m] = {gn [m],gn′,n [m],gn,B [m],gm,n }。(7)

將V2V 鏈路n 在第m 條V2I 鏈路傳輸數據時受到的所有干擾表示為:

此外,為了保證每條V2V 鏈路在一定的時間限度內完成數據傳輸任務,將剩余的傳輸載荷數Bn 和剩余的可傳輸載荷時間Tn 也考慮進可獲得的環境狀態內。因此,V2V 鏈路n 的狀態空間表示為:

snt= {Bn ,Tn ,{In [m]}m∈M ,{Gn [m]}m∈M }。(9)

2. 2 動作空間

車聯網的資源分配問題可歸結為V2V 鏈路的子信道選擇和傳輸功率控制問題。每條V2I 鏈路占據被自然分成的M 條不相交的子信道中的一條,N 條V2V 鏈路可以從這M 個頻譜子信道中選擇一條鏈路進行重用并控制發射功率以便進行數據傳輸。考慮實際電路的限制,本文將功率控制分為4 個級別的離散值,即[23,10,5,-100]dBm。因此,每條V2V 鏈路的動作空間維度為4×M。

2. 3 獎勵函數

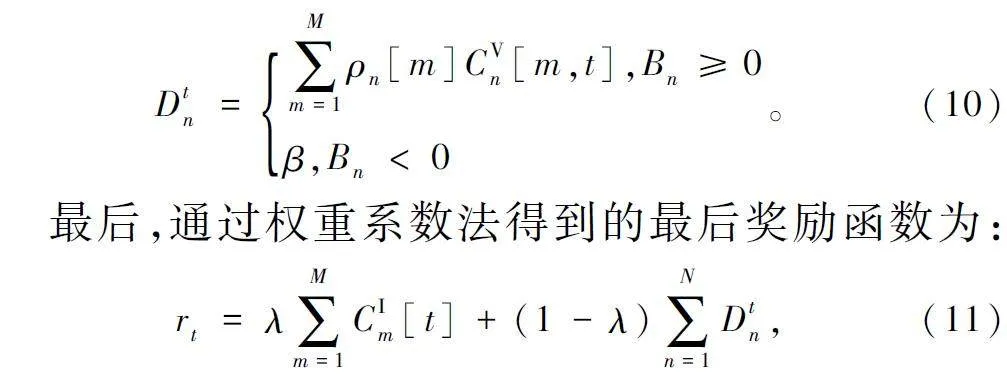

在強化學習中,獎勵函數起到驅動智能體學習策略的關鍵作用,通過對智能體采取的策略進行評估,提供相應的獎勵或懲罰,幫助智能體在復雜的環境中學會有效決策。本文研究目標是使V2I 鏈路的總吞吐量最大化和提高V2V 鏈路的載荷成功傳輸概率。本質上,這是一個多目標優化問題,本文通過權重系數法將其轉化成單目標優化問題。分別將2 個目標函數設置成2 個獎勵函數,即在t 時刻,V2I鏈路吞吐量的獎勵函數即為該鏈路獲得的總吞吐量;將t 時刻未完成傳輸的V2V 用戶獎勵函數設置為載荷傳輸速率,對于已完成傳輸的V2V 用戶獎勵函數設置為比載荷傳輸速率更大的常數β,以鼓勵V2V 用戶提高傳輸速率。因此對第二個目標的獎勵函數設置為:

式中:λ 為權重系數。

強化學習的目標是找到最佳策略π* ,任何狀態St 下的智能體都能根據π 做出最優決策,從而最大化期望獎勵,即:

式中:γ 是折扣因子,表示未來獎勵對當前狀態的重要程度。

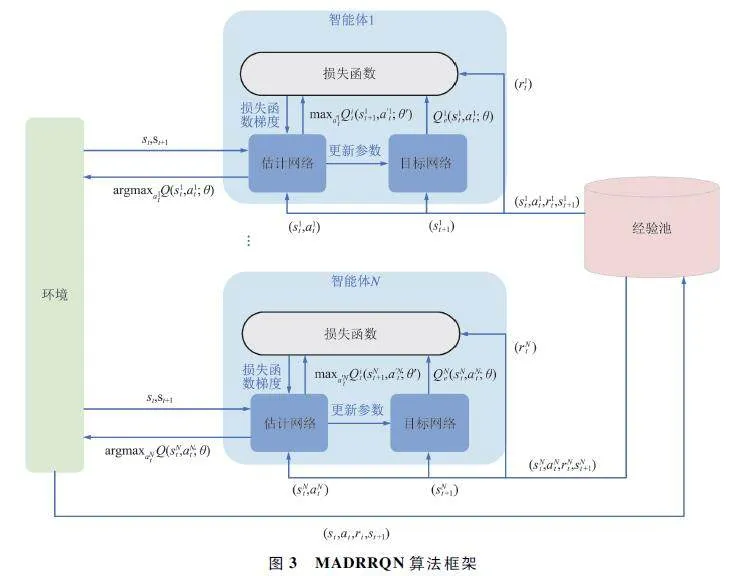

2. 4 MADRL 法

雖然將MADRL 引入車聯網環境來解決資源分配問題的方案優于傳統算法,但是仍然面臨以下挑戰:① 動態變化的車聯網環境和環境狀態信息部分可觀測;② 分布式的多智能體訓練方案會影響環境的平穩性從而影響訓練過程并削弱算法的性能。為此,本文提出基于MADRL 的完全分布式的多智能體深度循環殘差Q 網絡(Multi-Agent Deep RecurrentResidual Q Network,MADRRQN)算法,該算法整體框架如圖3 所示。

每條V2V 鏈路作為智能體擁有自己的DQN 并獨立訓練。智能體從與環境交互到學習過程主要分為動作選擇、經驗存儲和學習3 個階段。首先,將當前環境狀態snt輸入到DQN 中的估計網絡中,智能體n 根據εgreedy 策略選擇動作,即以概率ε 隨機采取動作,或以概率1-ε 從估計網絡中選擇使輸出Q 值最大的動作。智能體n 做出動作ant后得到獎勵rnt,環境狀態變為snt+1 。此時,智能體獲得了一條經驗(snt,ant,rnt,snt+1 )并將該經驗放入經驗池中。為解決多智能體分布式訓練帶來的非平穩性的問題,本文所有智能體共享經驗池中的經驗。經驗池根據容量采用先進先出的存儲方式。最后,在學習階段,從經驗池中抽取小批量經驗分別輸入到估計網絡和目標網絡中,然后從這2 個網絡中輸出Q1e(s1t,a1t;θ)和maxa′1tQit(s1t+1 ,a′1t;θ′)并計算損失值:

loss = [rnt+ γ maxa′1tQit(snt+1 ,a′nt;θ′)- Qne(snt,ant;θ)] 2 。(13)

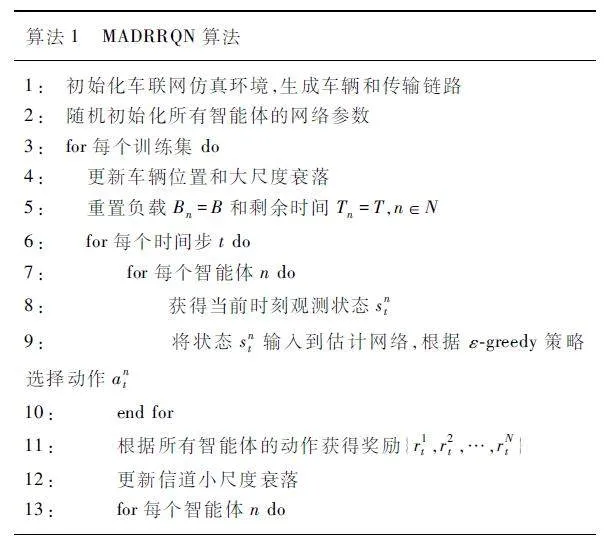

利用反向傳播計算的損失值更新估計網絡的參數θ,每隔一定時間將估計網絡的參數拷貝給目標網絡,更新其參數θ′。該過程重復進行并不斷優化智能體的行為策略,從而實現最優的動作選擇。具體如算法1 所示。

為了避免與環境交互時積累的經驗不足導致智能體做出的動作策略陷入局部最優解,有必要權衡利用(使用已知的動作)和探索(學習新的、可能更好的動作)的關系。因此,本文采用自適應的ε-greedy 探索算法,即在算法實現的初始階段,面對大的狀態和動作空間,智能體主要進行新動作和新狀態的探索。然后,隨著迭代次數的增加,逐漸增加利用概率讓智能體根據以往經驗做出最佳決策。

ε = εmin + (εmax - εmin )e-ζt, (14)

式中:εmax 和εmin 分別為ε 的最大值和最小值,ζ 為衰減因子。

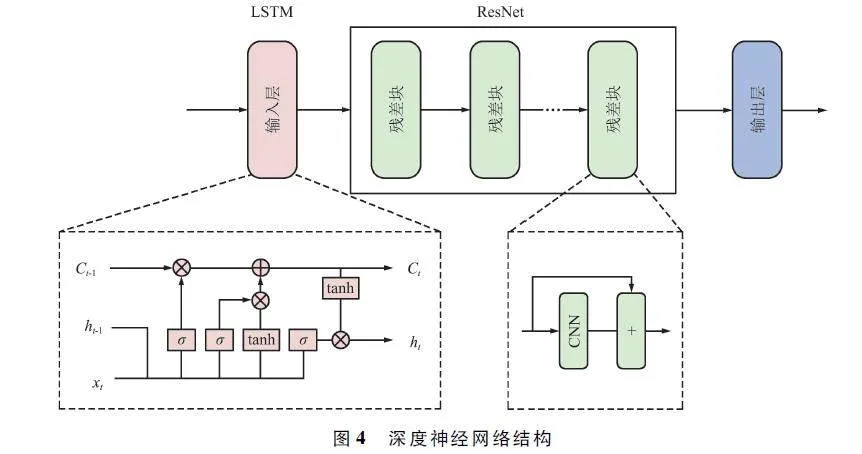

在強化學習中引入深度神經網絡的目的是為了有效處理高維度復雜的狀態和動作空間。通過深度神經網絡的強大學習能力,智能體能夠更準確地表示和近似復雜的狀態-動作映射關系,從而提高對大量和多樣化狀態信息的處理能力,進而增強訓練和決策的性能。本文提出的深度神經網絡結構如圖4 所示。

采用LSTM 網絡作為深度神經網絡的輸入層來解決MADRL 的部分可觀測問題、提高對序列數據的處理能力以及捕捉長期依賴關系,從而提高模型對動態環境的自適應能力。為了提高模型特征提取能力和預測能力,采用了CNN 的跳躍連接的ResNet結構。

3 仿真結果分析

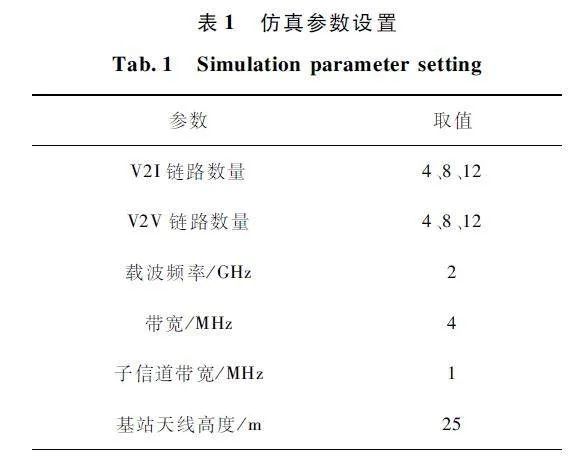

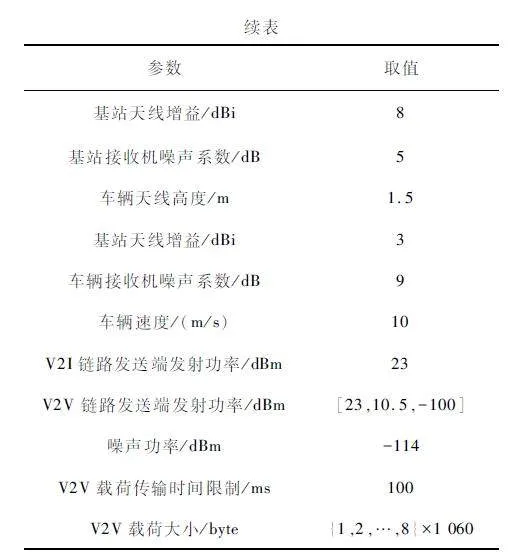

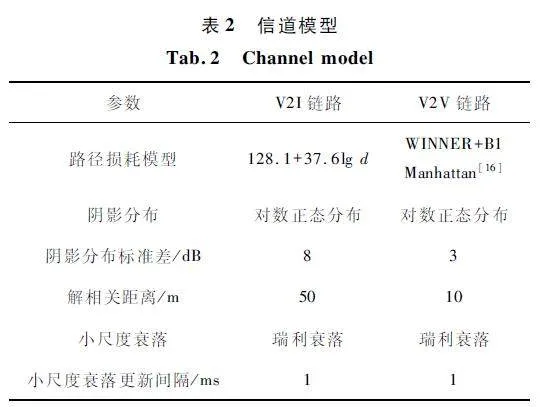

本文車聯網仿真場景遵循3GPP TR36. 885[16]中的城市交通道路場景,并遵循設置車聯網環境的仿真參數[17-18]。為了便于仿真,將交通場景面積等比例縮小一半。表1 給出了主要仿真參數,表2 給出了V2V 鏈路和V2I 鏈路的信道模型。

每個智能體的深度神經網絡由一層LSTM 作為輸入層和2 個ResNet 連接的3 層CNN 構成,各層神經元都是120 個。使用修正線性單元(RectifiedLinear Unit,ReLU)作為激活函數,并使用RMSProp優化器更新網絡參數,學習率為0. 001。采用的自適應εgreedy 算法中,ε 最大值為1,最小值為0. 02,衰減因子為0. 005,經驗池大小為20 000,每次訓練抽取的小批次樣本數為2 000,折扣因子為0. 99,總共進行1 000 個訓練回合,訓練過程的每個訓練集的時間都是100 ms。測試階段共進行100 個回合。在訓練階段,載荷大小固定為2×1 060 byte,車速固定為10 ~ 15 m / s,在測試階段,分別改變其大小以驗證所提算法的魯棒性。

為了驗證所提MADRRQN 算法的有效性,本文在Python 平臺上使用PyTorch 框架對提出的算法進行仿真,并在算法V2I 鏈路吞吐量、V2I 鏈路信道利用率以及V2V 鏈路有效傳輸等方面與其他算法的性能進行比較。其他算法包括:① 隨機算法,子信道和功率隨機選擇;② 多智能體深度Q 網絡(Multi-Agent Deep Q Network,MADQN)算法,由每層包含120 個神經元的4 層全連接結構的DQN 構成,訓練智能體時,每個智能體分配相同的獎勵值;③ 單智能體深度Q 網絡(Single-Agent Deep Q Network,SADQN)算法,所有智能體共享一個DQN,在每個時隙,只有一個智能體根據訓練的DQN 更新其動作選擇的策略,而其他智能體動作的選擇策略保持不變。

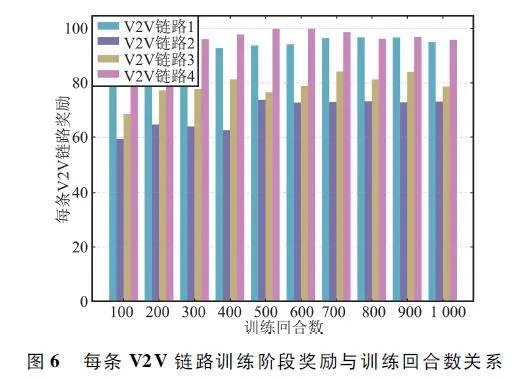

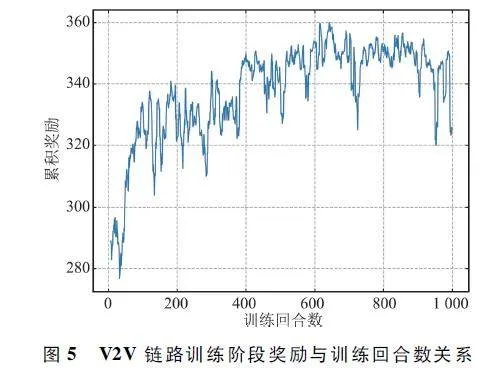

圖5 和圖6 分別顯示了車輛數為4 時,訓練階段所有智能體的總和累積獎勵和每個智能體獎勵與訓練回合數的關系。從圖中可以看出,獎勵值隨著訓練回合數的增加而增加,最后趨于收斂。從圖6可以看到,每條V2V 鏈路的獎勵值隨著訓練回合數的增加也趨于平穩。由此證明了所提MADRRQN算法的有效性。收斂的獎勵值存在波動的原因在于車輛的快速移動,導致車聯網的拓撲結構不斷變化,同時也受到信道衰落的影響。

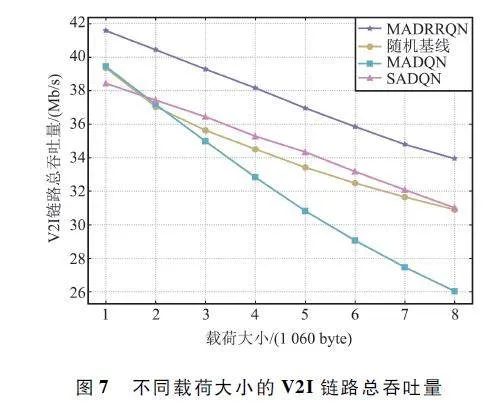

本文通過V2I 鏈路總吞吐量和V2I 鏈路利用率(實際獲得的V2I 鏈路總吞吐量與禁用所有V2V 鏈路獲得的V2I 鏈路總吞吐量的比值)來評估該算法在V2I 鏈路上的性能。圖7 和圖8 分別展示了不同載荷大小對不同算法在V2I 鏈路總吞吐量和利用率方面的性能影響。從圖中可以看出,隨著V2V 載荷大小的增加,所有算法的性能都有所下降。這是因為成功傳輸更多的載荷需要更長的傳輸時間和更高的V2V 鏈路發射功率,加劇了對V2I 鏈路的干擾,從而減小了V2I 鏈路的總吞吐量。但是,相同載荷大小的條件下,MADRRQN 算法具有更大的V2I 鏈路總吞吐量和更高的V2I 鏈路利用率。

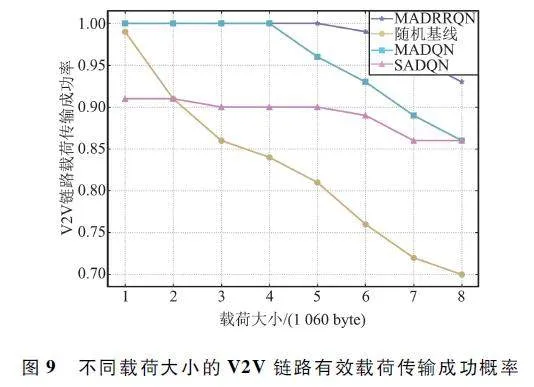

圖9 顯示了不同載荷大小,不同算法在V2V 鏈路載荷傳輸成功率方面的性能表現。所有算法的載荷傳輸成功率都隨著載荷大小的增加而降低了,但其他算法的性能表現都比MADRRQN 算法差,雖然MADQN 算法在載荷小于等于4 ×1 060 byte 時傳輸成功率達到了100% ,但是隨著載荷的增加,成功率顯著下降,而MADRRQN 算法的載荷傳輸成功率下降緩慢,即使載荷達到8×1 060 byte,其載荷傳輸成功率仍然在90% 以上。

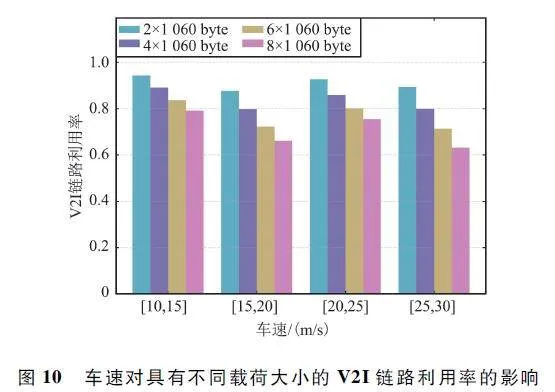

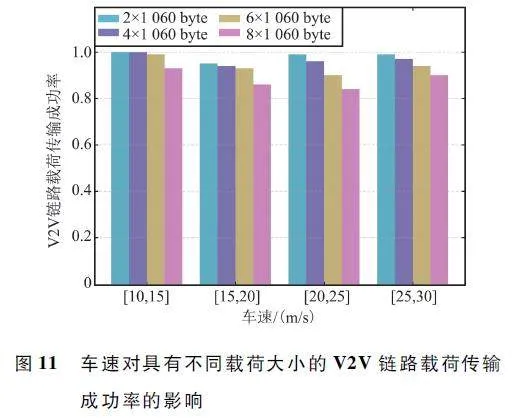

為了驗證MADRRQN 算法對環境變化的適應性,本文從車速和車輛數量兩方面驗證其對算法性能的影響。圖10 顯示了車輛數固定為4 時的車速對具有不同載荷大小的V2I 鏈路利用率的影響。僅使用鏈路利用率來評估V2I 鏈路總吞吐量的變化的原因在于,車速的改變同樣會影響沒有V2V 鏈路傳輸時的V2I 鏈路吞吐量。因此,采用V2I 鏈路利用率這一相對比值更能客觀地反映吞吐量的變化情況。從圖中可以看出,車速對于2×1 060 byte 和4×1 060 byte 載荷的V2I 鏈路利用率影響較小,其鏈路利用率都高于80% 。對于大載荷,高車速對其影響較大,這是因為隨著車速的增加,車聯網拓撲結構變化更快,而需要傳輸的載荷數量更多,這對V2V 鏈路的子信道選擇和功率分配提出了更高的要求。圖11 顯示了車輛數固定為4 時的車速與V2V 鏈路載荷傳輸成功率的關系圖。對于相同的載荷大小,所提出的MADRRQN 算法的性能隨著車速的增加而改變。這是因為車聯網環境隨著車速的增加變化地更加顯著,增加了環境的不確定性和獲取信道狀態信息的難度。然而,所提出的算法仍然可以保持高V2I 鏈路總吞吐量和V2V 鏈路成功傳輸的概率,這說明車速變化對所提MADRRQN 算法的性能影響較小,因此該算法能夠適應車聯網環境中的車速變動。

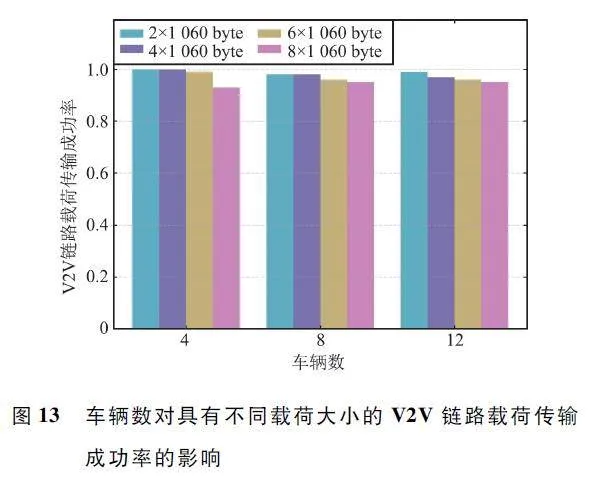

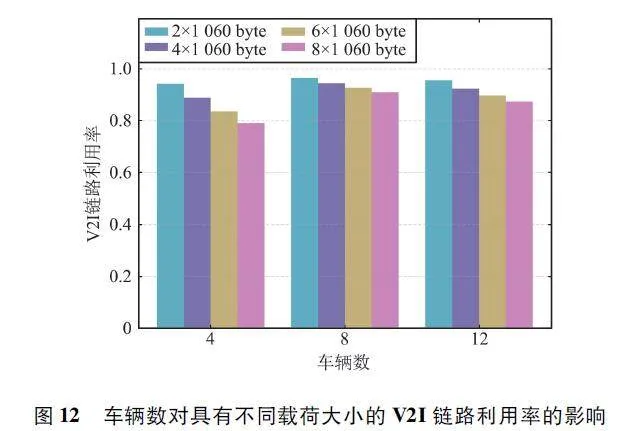

當增加車輛,即子信道的數量增加時,意味著智能體的動作空間維度也增加了,對算法性能提出了更高要求。圖12 和圖13 分別展示了車輛數對具有不同載荷大小的V2I 鏈路利用率和V2V 鏈路載荷傳輸成功率的影響。從圖中可以看出,車輛數對于所提算法的性能影響較小,甚至隨著車輛數的增加,在大載荷的情況下,V2I 鏈路利用率反而提高了。由此說明算法能夠適應不同數量車輛的環境,具備擴展到更多車輛情況的能力,并且對于傳輸載荷大小的變化具有魯棒性。

4 結束語

針對車聯網中的資源分配問題,本文采用了V2V 鏈路共享V2I 鏈路頻譜資源的策略,并基于MADRL 算法提出了MADRRQN 算法。在該算法中,每條V2V 鏈路都被視為一個獨立的智能體,每個智能體進行獨立的訓練和決策,顯著降低了決策過程中的信息傳輸開銷,增強了算法的可擴展性。通過充分的仿真實驗,本文驗證了所提算法的有效性,展示了其在最大化V2I 鏈路總吞吐量、提高V2I鏈路頻譜利用率以及提升V2V 鏈路載荷成功傳輸概率等性能方面的優越性。此外,該算法還表現出在不斷變化的車聯網環境中的魯棒性和適應性。未來研究將繼續優化該算法,以適應更為復雜的實際應用場景。

參考文獻

[1] YADAV S,PANDEY A,DO D T,et al. Secure CognitiveRadioenabled Vehicular Communications Under SpectrumSharing Constraints[J]. Sensors,2021,21(21):7160.

[2] QI W J,SONG Q Y,GUO L,et al. Energyefficient Resource Allocation for UAVassisted Vehicular Networkswith Spectrum Sharing [J ]. IEEE Transactions onVehicular Technology,2022,71(7):7691-7702.

[3] CHEN L L,ZHAO Q J,FU K,et al. Multiuser Reinforcement Learning Based Multireward for Spectrum Access inCognitive Vehicular Networks [J ]. TelecommunicationSystems,2023,83(1):51-65.

[4] 方維維,王云鵬,張昊,等. 基于多智能體深度強化學習的車聯網通信資源分配優化[J]. 北京交通大學學報,2022,46(2):64-72.

[5] XIANG P,SHAN H G,WANG M,et al. Multiagent RLEnables Decentralized Spectrum Access in Vehicular Networks[J]. IEEE Transactions on Vehicular Technology,2021,70(10):10750-10762.

[6] ZHANG M L,DOU Y,CHONG P H J,et al. Fuzzy Logicbased Resource Allocation Algorithm for V2X Communicationsin 5G Cellular Networks[J]. IEEE Journal on Selected Areasin Communications,2021,39(8):2501-2513.

[7] XIE Y C,YU K,TANG Z X,et al. An Effective CapacityEmpowered Resource Allocation Approach in LowlatencyCV2X[C]∥2022 14th International Conference on Wireless Communications and Signal Processing (WCSP ).Nanjing:IEEE,2022:794-799.

[8] 趙莎莎. 基于PSO 的D2D 蜂窩網絡聯合信道分配和功率控制[J]. 無線電工程,2023,53(7):1660-1669.

[9] LIANG L,YE H,YU G D,et al. DeeplearningbasedWireless Resource Allocation with Application toVehicular Networks[J]. Proceedings of the IEEE,2020,108(2):341-356.

[10] TAN J J,LIANG Y C,ZHANG L,et al. DeepReinforcement Learning for Joint Channel Selection andPower Control in D2D Networks [J]. IEEE Transactionson Wireless Communications,2020,20(2):1363-1378.

[11] YUAN Y,ZHENG G,WONG K K,et al. Metareinforcement Learning Based Resource Allocation for Dynamic V2X Communications [J]. IEEE Transactions onVehicular Technology,2021,70(9):8964-8977.

[12] GUAN Z,WANG Y Y,HE M. Deep Reinforcement Learningbased Spectrum Allocation Algorithm in Internet ofVehicles Discriminating Services [J]. Applied Sciences,2022,12(3):1764.

[13] HAN D,SO J. Energyefficient Resource Allocation Basedon Deep Qnetwork in V2V Communications[J]. Sensors,2023,23(3):1295.

[14] TIAN J,SHI Y,TONG X L,et al. Deep ReinforcementLearning Based Resource Allocation with HeterogeneousQoS for Cellular V2X[C]∥2023 IEEE Wireless Communications and Networking Conference (WCNC). Glasgow:IEEE,2023:1-6.

[15] VU H V,FARZANULLAH M,LIU Z Y,et al. MultiagentReinforcement Learning for Channel Assignment andPower Allocation in Platoonbased CV2X Systems[C]∥2022 IEEE 95th Vehicular Technology Conference(VTC2022Spring). Helsinki:IEEE,2022:1-5.

[16]3GPP. Study LTEbased V2X Services (Release 14 )[R]. Valbonne:3GPP Support Office,2016.

[17] KY?STI P,MEINIL? J,HENTILA L,et al. WINNER IIChannel Models[M]. Hoboken:John Wiley & Sons,2008.

[18] LIANG L,YE H,LI G Y. Spectrum Sharing in VehicularNetworks Based on Multiagent Reinforcement Learning[J]. IEEE Journal on Selected Areas in Communications,2019,37(10):2282-2292.

作者簡介

孟水仙 女,(1984—),碩士,高級工程師。主要研究方向:無線電監測、電磁兼容。

劉艷超 女,(1996—),碩士研究生。主要研究方向:認知無線傳感器網絡、強化學習。

(*通信作者)王樹彬 男,(1971—),博士,教授。主要研究方向:認知無線傳感器網絡、機器視覺。

基金項目:國家自然科學基金(62361048)