基于改進YOLOv8的PCB焊點語義分割方法

摘 要:針對具有相似灰度值的印制電路板(Printed Circuit Board,PCB) 焊點在檢測分割過程中的誤檢和漏檢問題,提出改進YOLOv8 的PCB 焊錫語義分割模型。在主干網絡引入坐標注意力(Coordinate Attention,CA) 機制,準確定位焊點空間位置,提升模型捕捉焊點空間信息能力;使用雙向特征金字塔網絡(Bi-directional Feature Pyramid Network,BiFPN)替換路徑聚合網絡(Path Aggregation Network,PANet) 特征金字塔,更好地捕捉目標的邊界信息,并在原有基礎上增加一個分割層。引入EIoU 損失函數,提供更精細的評估結果并提高泛化能力。通過對比實驗得出,所提算法的平均像素精度(mean Pixel Accuracy,mPA) 達到90. 37% ,平均交并比(mean Intersection over Union,mIoU) 達到83. 76% ,每秒推理圖片張數(Frames Per Second,FPS) 達到43,實現了PCB 板更精準的焊點分割。

關鍵詞:YOLOv8;語義分割;坐標注意力機制;雙向特征金字塔網絡;EIoU 損失函數

中圖分類號:TP751. 1 文獻標志碼:A 開放科學(資源服務)標識碼(OSID):

文章編號:1003-3106(2024)07-1614-08

0 引言

印制電路板(Printed Circuit Board,PCB)是通過自動化設備將電子元件焊接到PCB 上制作而成。制作過程中,由于設計錯誤、制造問題或材料損壞等會導致焊錫短路或開路,影響產品正常使用。所以對PCB 產品質量檢測的技術實現一直是主要的討論話題之一。早些年的實現通常依賴傳統的檢測技術和算法,例如OpenCV、halcon 和早期機器學習技術。張俊賢[1]設計了基于傳統算法的PCBA 焊錫檢測系統,利用MARK 孔使用模版匹配進行定位和仿射變換實現焊錫圖像自動獲取。雷崢鳴[2]提出基于機器視覺的PCB 焊錫缺陷檢測系統,改進傳統的霍夫圓變換,實現精準的圖像圓檢測和定位。但是近些年傳統的檢測技術逐漸不能滿足新型產品的檢測需求。

隨著神經網絡和深度學習的興起,語義分割技術逐漸在工業領域得到應用,它對圖像的每個像素進行分類,實現像素級的精細預測。語義分割技術發展分為2 個階段:傳統語義分割算法和基于深度學習的語義分割[3]算法。傳統語義分割算法中,常見方法包括閾值分割、邊緣檢測和區域法等。基于深度學習的語義分割算法中,包括全卷積網絡(Fully ConvolutionalNetwork,FCN)、U-Net、PSPNet 和Deeplab 系列等經典網絡。FCN[4]是深度學習算法進軍語義分割領域的開山之作,將卷積神經網絡(Convolutional Neural Net-work,CNN)模型(如AlexNet、VGGNet 等)中全連接層替換為全卷積層,構建像素級的語義分割網絡。這一創新使得FCN 實現從像素到像素的準確語義分割。PSPNet[5]針對FCN 在語義分割領域的問題進行改進,引入空間金字塔模塊,能夠提取圖像的上下文信息和多尺度信息,使得分割層能夠獲得更加豐富的全局上下文信息。這一改進有效降低了FCN 中圖像類別誤分割的概率。U-Net[6]也是基于FCN 架構的改進,采用Encoder 和Decoder 的U 型結構以及skip-connection,在醫學領域的圖像處理問題中廣泛應用。DeepLab 系列[7-10]是谷歌團隊開發的基于CNN 的語義分割模型。

毛萬菁等[11]運用改進的U-Net 語義分割模型,對草莓在不同病害情況下進行精準分割。在編碼器部分引入CNN-Transformer 混合結構,并在解碼器中采用雙路上采樣模塊,并以hard-swish 激活函數取代ReLU 激活函數。使得模型在像素精度上達到92.56% ,平均交并比(mean Intersection over Union,mIoU)達到84. 97% ,超越了許多分割模型。在自動駕駛領域,楊奎河等[12]提出了一種深度學習模型,架構優化基于YOLOSeg 算法,MobileNetv3 作為特征提取網絡,并引入路徑聚合網絡(Path Aggregation Net-work,PANet)融合各種尺度的特征圖。相較于過去的RefineNet,該模型在分割速度每秒推理圖片張數(Frames Per Second,FPS)上提升了35,同時交并比(In-tersection over Union,IoU)平均提高幅度達到4. 9% 。

自FCN 以來,深度學習在語義分割領域取得巨大進步,YOLO 系列模型以其端到端的快速和輕量性能力更是在工業領域得到廣泛應用。尤其是YOLOv5 模型,取得了引人矚目的成就[13-16]。

1 YOLOv8 算法

目前YOLO 系列的SOTA 模型是ultralytics 公司于2023 年發布的YOLOv8。按照模型寬度和深度不同分為YOLOv8n、YOLOv8s、YOLOv8m、YOLOv8l、YOLOv8x 五個版本。本文改進的是YOLOv8n 模型。

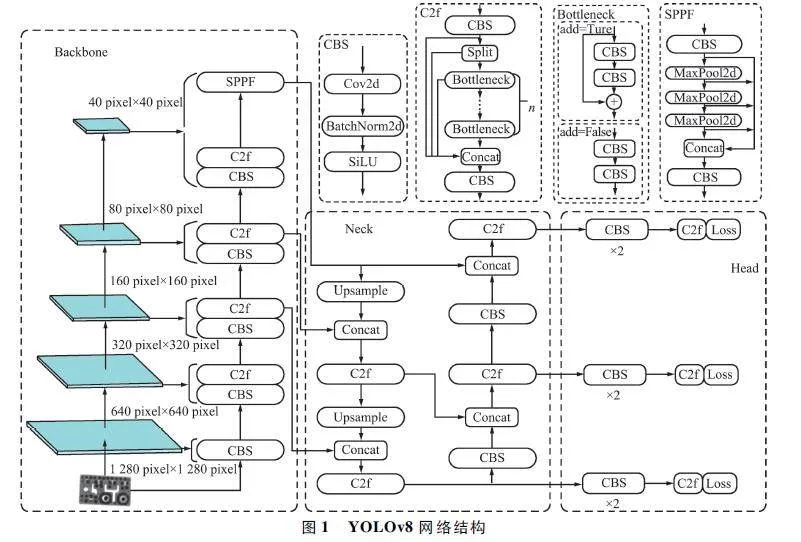

YOLOv8 的Backbone 采用CSPDarknet 結構,它是Darknet 的一種改進,引入CSP 改善網絡結構。CSPDarknet 把特征圖分為兩部分,一部分進行卷積操作,另一部分進行跳躍連接,在保持網絡深度的同時減少參數量和計算量,提高網絡效率。Neck 部分采用特征金字塔PANet[17],通過自頂向下路徑結合和自底向上特征傳播進行多尺度融合。損失函數采用了CIoU[18]。YOLOv8 的網絡結構如圖1 所示。

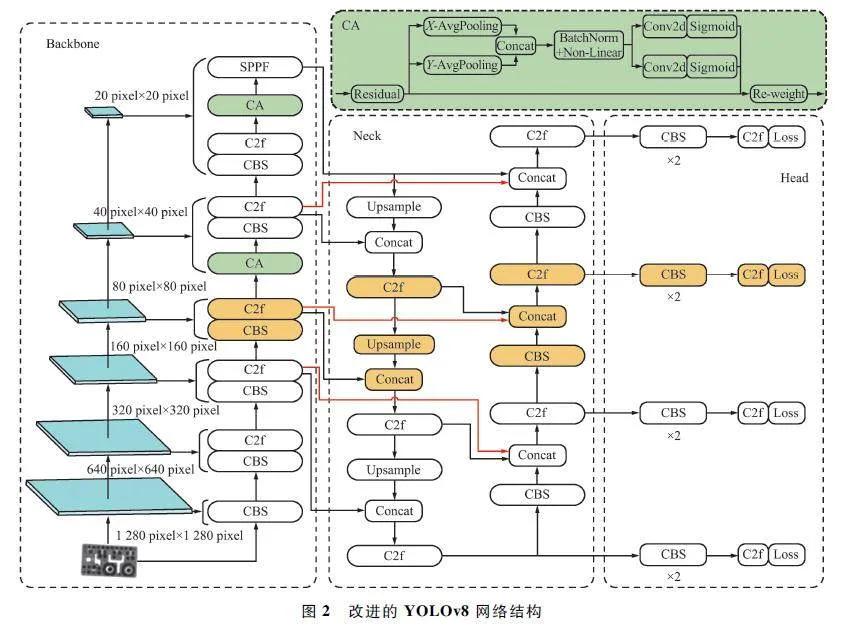

2 改進YOLOv8 算法

改進YOLOv8 算法主要有以下3 點:① 在Back-bone 的最后2 步分別添加坐標注意力(Coordinate At-tention,CA)機制模塊[19],用于捕獲圖像的全局空間信息;② 在Neck 中用雙向特征金字塔網絡(Bi-direc-tional Feature Pyramid Network,BiFPN)[20]替換PANet進行特征融合,并在原有基礎上增加一個分割層;③ 采用EIoU 損失函數替換CIoU 用于優化模型。圖2 是本文改進的YOLOv8 網絡結構。

2. 1 CA 注意力機制

為了準確提取焊點的位置空間信息,本文在主干網絡的C2f 和SPPF 之間引入CA 機制,更好地提取特征空間位置信息,達到精準分割。CA 的實現過程如圖3 所示。

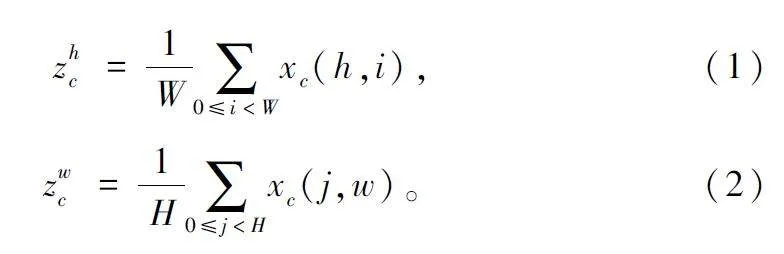

CA 的操作過程分為空間信息嵌入和空間注意力生成兩部分,CA 模塊前半部分是空間信息嵌入,輸入為x,分別沿水平和豎直方向對輸入特征圖計算一維平均池化進行全局信息提取,得到高度和寬度方向的2 個特征圖:

CA 模塊的后半部分是空間注意力生成,連接由前半部分輸出具有全局感受野的2 個特征圖并通過1×1 卷積操作將維度變成原來的C / r,批量歸一化后將得到的特征圖F1 經過Sigmoid 函數得到形如1×(W+H)×C / r 的特征圖。

f = δ(F1([zh ,zw ])), (3)

式中:f∈CC / r ×(w+h)表示空間信息的水平和垂直中間特征圖,r 表示下采樣率,δ 表示非線性激活函數。

將f 分成2 個張量f h ∈CC / r×H 和f w ∈CC / r×W ,f h和f w 再分別通過1×1 卷積得到和輸入x 相同的通道數。

gh = σ(Fh(f h )), (4)

gw = σ(Fw(f w ))。(5)

最后把空間信息加權進行融合,輸出如下:

yc(i,j) = xc(i,j)× ghc(i)× gwc(j)。(6)

捕捉位置信息和通道信息,CA 相較于其他輕量級注意力機制表現出更出色的效果。

2. 2 BiFPN 和分割層

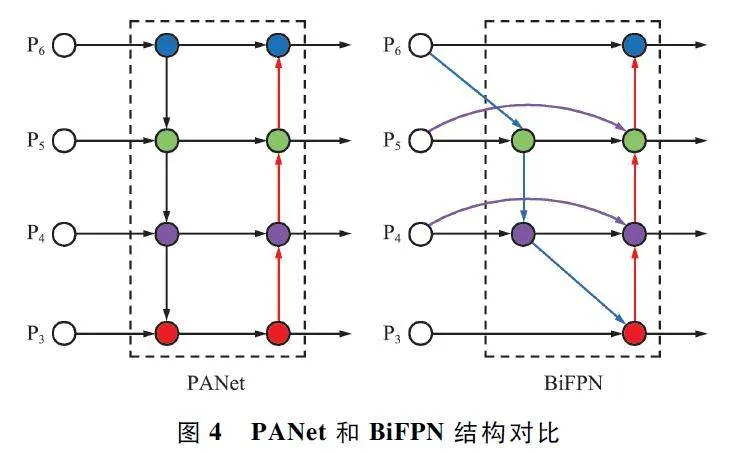

本文用BiFPN 替換YOLOv8 的PANet 特征金字塔,二者網絡結構對比如圖4 所示。

和PANet 單一的自頂向下和自底向上進行特征融合不同,BiFPN 靈活地去掉只有一條輸入邊的點,因為輸入單一,對旨在融合不同特征的網絡貢獻很小。BiFPN 在處于同一層的輸入節點和輸出節點之間額外添加一條邊,以在不增加成本情況下融合更多特征信息。和PANet 只有一個雙向路徑不同,BiFPN 將雙向路徑當做一個特征網絡層,重復使用多次以實現更高層次特征融合,并通過NAS 技術計算使用次數。

YOLOv8 本身有3 個分割層,本文在原有基礎上額外添加1 個分割層。通過添加額外的分割層,語義分割網絡可以進行更深層次的特征提取和語義表示,有助于提高分割網絡對圖像中細微特征和邊界的感知能力。多個分割層也可以引入更多的上下文信息,幫助網絡更好地理解圖像中的語義關系和全局結構。

2. 3 EIoU 損失函數

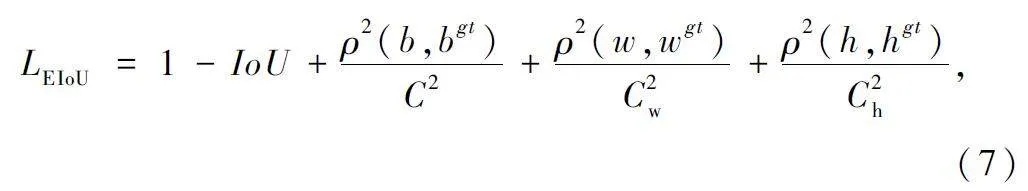

神經網絡訓練過程中,損失函數用來度量模型預測值與實際值之間的差異并做出相應處理,優秀的損失函數可以優化模型性能和訓練效果。EIoU損失函數[21]計算如下:

式中:Cw 和Ch 表示覆蓋2 個錨框的最小包圍框的寬度和高度,b 和bgt 表示預測框和目標框的中心點,ρ 表示歐幾里得距離,C 表示覆蓋2 個框的最小包圍框的對角線長度。

EIoU 引入平滑系數,在IoU 接近閾值邊界時,匹配度得分更加平滑,避免IoU 波動導致誤判,能更好地適應不同大小目標的評估,提高對小尺寸物體的檢測性能。因此本文采用EIoU 損失函數,獲得更具有精度和魯棒性的模型。

3 實驗分析

3. 1 實驗環境

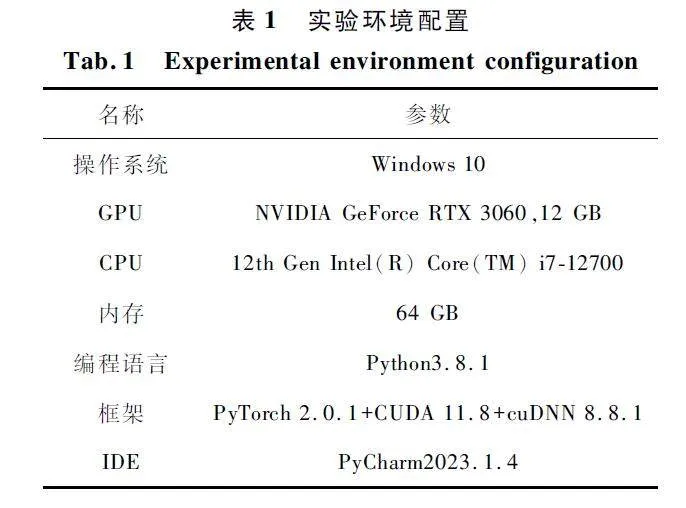

實驗使用的服務器配置和虛擬環境配置如表1所示。

3. 2 數據集的采集

數據集來自PCB 板的實際生產現場,使用XRay 設備進行采集。每張圖片的像素分辨率是1 537 pixel×1 537 pixel,共收集3 647 張產品圖片。從中選取具有代表性的500 張圖片用于模型訓練。通過使用Python 模塊進行隨機劃分,將數據集分為訓練集350 張、驗證集100 張和測試集50 張。為了確保算法的實際應用性,訓練集和驗證集中不包含相同的產品圖片。

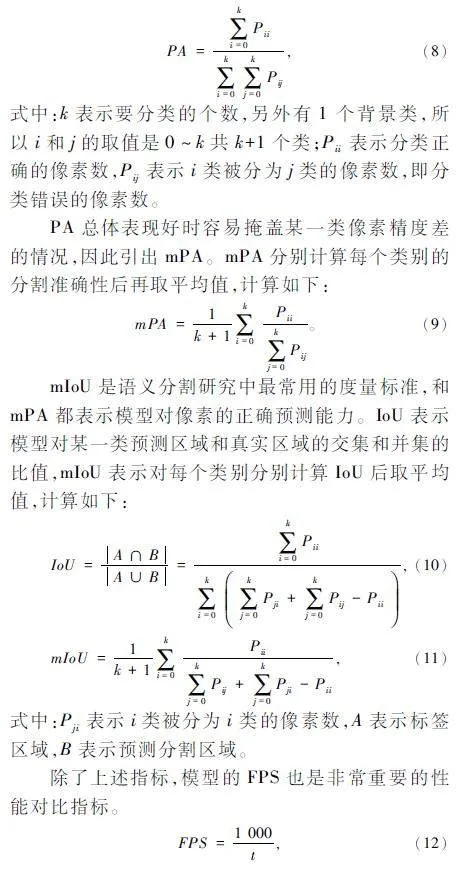

3. 3 評價指標

語義分割常用評價指標有F1-score 和宏平均(macro_average)、平均像素精度(mean Pixel Accura-cy,mPA)、mIoU 等[22]。焊錫的語義分割背景單一且類別不多,宏平均值并不作為本文模型評價重點,重點選mPA 和mIoU 作為本文模型評價指標。

像素精度(Pixel Accuracy,PA)表示語義分割過程中正確分割像素個數占所有像素數的比值。PA的計算如下:

式中:t 表示推理一張圖片需要的時間,單位ms。

3. 4 實驗與結果分析

本文通過對比實驗,評估改進的YOLOv8n 算法與U-Net、YOLOSeg 和YOLOv8n 在分割性能方面的表現。本次實驗選擇0. 01 作為初始學習速率,批量樣本數設為4,并進行150 次迭代(epoch)。在模型訓練過程中,使用在COCO 數據集上經過預訓練的模型,并通過遷移學習優化。

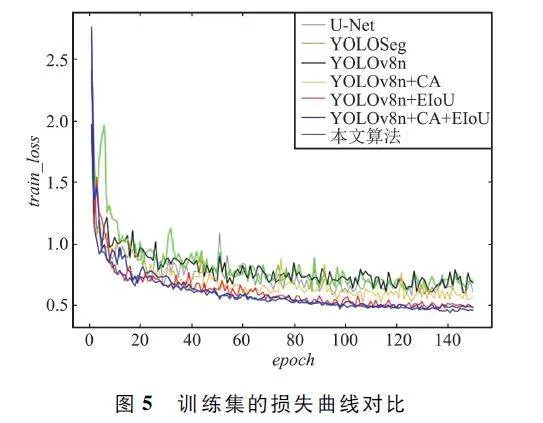

訓練集用于模型的參數優化,訓練過程中通過輸入的數據和對應的標簽計算損失函數計算二者的差異,以最小化損失函數為目的進行參數優化。訓練集的損失曲線體現模型收斂速度和魯棒性。本文改進算法引入不同模塊與U-Net、YOLOSeg 和YOLOv8n 的訓練集的損失函數對比如圖5 所示。

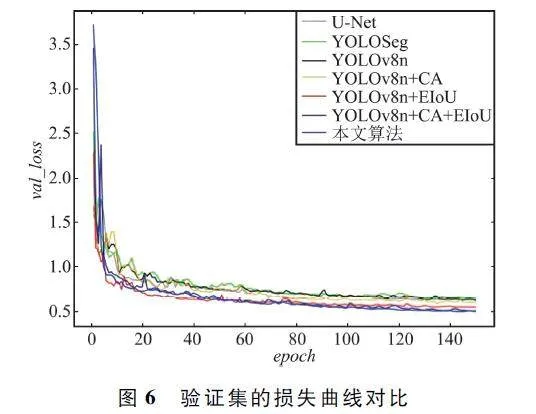

驗證集用于epoch 結束后性能評估和參數調優,防止過擬合。參數調優主要是超參數,通過選擇最佳的超參數值從而提高泛化能力等性能。其驗證集的損失函數對比如圖6 所示。

通過YOLOv8n + CA 和YOLOv8n + EIoU 與YOLOv8n 損失曲線對比得出,算法引入CA 機制后對損失曲線的收斂程度有所促進,但是效果并不明顯。YOLOv8n 算法改用EIoU 損失函數,在訓練過程收斂更快,總損失的降低也更加明顯。

通過YOLOv8n + CA 和YOLOv8n + EIoU 與YOLOv8n+CA+EIoU 損失曲線對比得出,同時引入CA 機制和EIoU 損失函數,對損失曲線的收斂程度是疊加的,模型訓練的效果更好。

通過本文算法與YOLOv8n+CA+EIoU 損失曲線對比得出,引入CA 機制和EIoU 損失函數后,使用BiFPN 或者PANet,對損失曲線的起到的優化效果相差不大。得出用BiFPN 替換PANet 并不會惡化損失曲線的收斂。但是BiFPN 會提高邊緣信息的提取能力和模型的泛化能力。

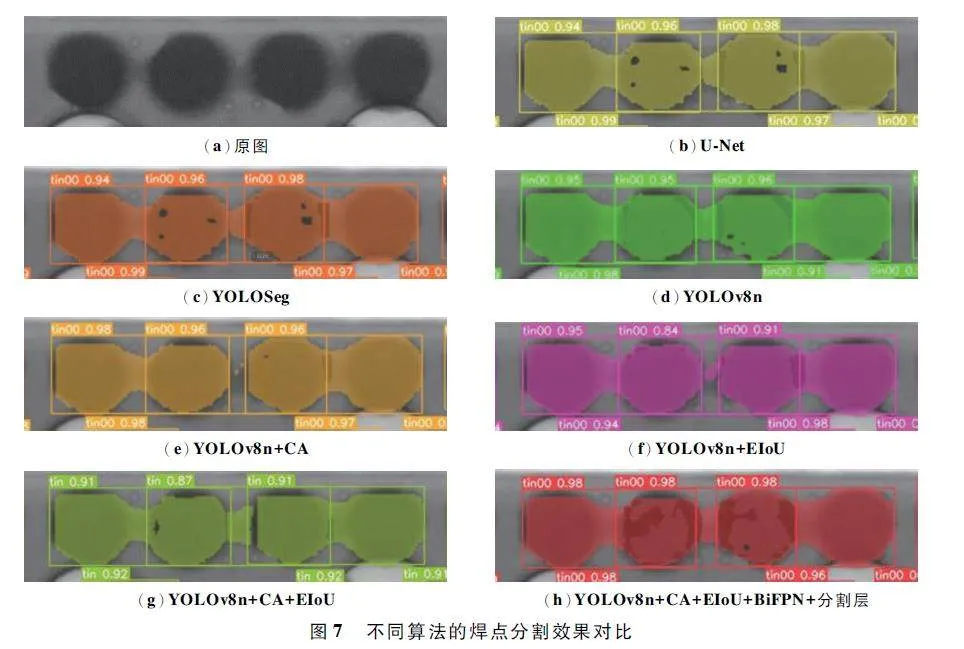

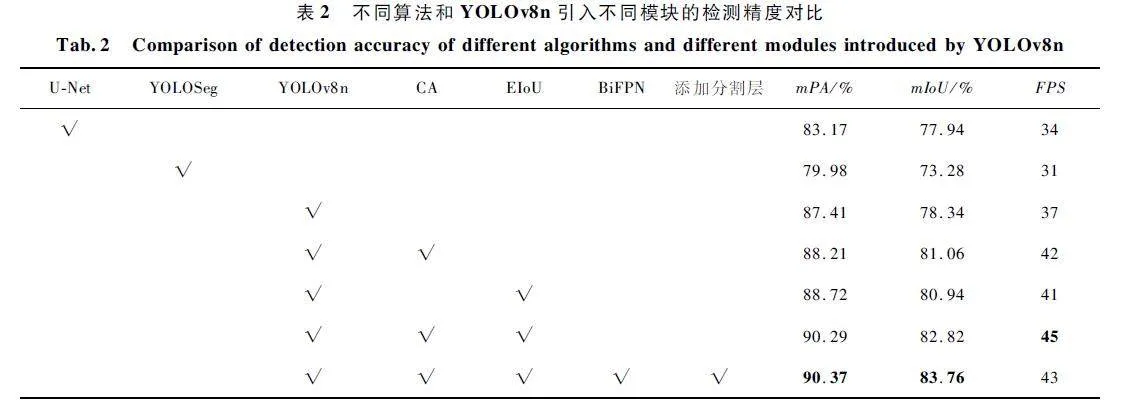

表2 為不同算法和YOLOv8n 引入不同模塊的檢測精度對比,可以看出,YOLOv8n 的檢測精度高于UNet 和YOLOSeg 模型。YOLOv8n + CA 和YOLOv8n+ EIoU 對精度有一定程度提高,而且YOLOv8n + CA + EIoU 達到了更高的精度。YOLOv8n+CA+EIoU+BiFPN+分割層與YOLOv8n+CA+EIoU 相比,mPA 和mIoU 有所提升但增幅效果不顯著,甚至FPS 降低2。但是由圖7 的焊點分割泛化能力對比結果來看,YOLOv8n + CA +EIoU+BiFPN+分割層的泛化能力最好,綜合考慮選擇YOLOv8n + CA + EIoU + BiFPN + 分割層的模型。

由圖7 可以看出,圖7(b)和圖7(c)在焊點區域和背景區域像素值相近時存在個別像素分類錯誤,即對焊點像素存在分割遺漏,模型的魯棒性不佳。圖7(e)和圖7(f)對于3 個或更多焊點存在橋接時的分割效果存在橋接遺漏問題。圖7 (b)、圖7(c)和圖7 (d)對于焊點邊緣分割效果均存在“一刀切”現象,即對于焊點細節分割魯棒性和表征能力較差。

針對以上模型存在的不足,本文基于YOLOv8n模型加入CA 機制,從而解決個別像素分類錯誤的問題。使用BiFPN 和增加分割層,解決3 個或更多焊點存在橋接時的橋接遺漏問題,其對于焊點邊緣信息分割更加準確并有更好泛化能力。采用CA 機制和EIoU 損失函數,從而避免IoU 波動導致誤判,提高模型精度。如表2 所示相應的mPA、mIoU 和FPS等參數均得到提升。本文算法相較于U-Net、YOLOSeg 和YOLO8n 而言,mPA 提高7. 2% 、10. 48%和2. 96% ,mIoU 提高5. 82% 、10. 48% 和5. 42% ,FPS 提高9、12 和6。通過使用相同數據集進行對比實驗,證明了本文算法分割效果最好。

4 結束語

針對本文所收集的產品,進行了焊錫語義分割實驗。基于YOLOv8n 的模型,本文通過在Backbone中引入CA 機制,提取各個焊點的全局位置信息,從而實現對焊點的精準分割。另外,通過采用EIoU 損失函數,提高模型的精度,增強其魯棒性。最后使用BiFPN 金字塔增強邊緣信息的提取能力并提高模型泛化能力。通過與幾個經典的語義分割模型進行對比實驗得出結論,本文改進算法的mPA 達到90. 37% 、mIoU 達到83. 76% 、FPS 達到43。實驗結果表明,本文算法優于目前主流的語義分割模型U-Net、YOLOSeg 和YOLOv8n,但是檢測速度并沒有優勢,在未來研究中可以對模型進一步改進。如使用深度可分離卷積減少模型參數量或者使用輕量型的骨干網絡等。

參考文獻

[1] 張俊賢. 基于機器視覺的PCBA 焊錫缺陷檢測系統研究[D]. 杭州:浙江大學,2021.

[2] 雷崢鳴. 基于機器視覺的PCB 焊錫缺陷檢測[D]. 廣州:廣東工業大學,2021.

[3] 楊潔潔,楊頂. 基于深度學習的語義分割綜述[J]. 長江信息通信,2022,35(2):69-72.

[4] SHELHAMER E,LONG J,DARRELL T. Fully ConvolutionalNetworks for Semantic Segmentation[J]. IEEE Transactionson Pattern Analysis and Machine Intelligence,2017,39(4):640-651.

[5] ZHAO H S,SHI J P,QI X J,et al. Pyramid Scene ParsingNetwork[C]∥2017 IEEE Conference on Computer Visionand Pattern Recognition (CVPR). Honolulu:IEEE,2017:6230-6239.

[6] RONNEBERGER O,FISCHER P,BROX T. UNet:Convolutional Networks for Biomedical Image Segmentation[C]∥ Medical Image Computing and ComputerassistedIntervention. Munich:Springer,2015:234-241.

[7] CHEN L C,PAPANDREOU G,KOKKINOS I,et al. Semantic Image Segmentation with Deep Convolutional Netsand Fully Connected CRFS [EB / OL]. (2014 - 12 - 22)[2023-09-02]. https:∥arxiv. org / abs / 1412. 7062.

[8] CHEN L C,PAPANDREOU G,KOKKINOS I,et al. Deeplab:Semantic Image Segmentation with Deep ConvolutionalNets,Atrous Convolution,and Fully Connected CRFs[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2018,40(4):834-848.

[9] CHEN L C,PAPANDREOU G,SCHROFF F,et al. Rethinking Atrous Convolution for Semantic Image Segmentation[EB / OL]. (2017-01-17)[2023-09-02]. https:∥arxiv.org / abs / 1706. 05587.

[10] CHEN L C,ZHU Y K,PAPANDREOU G,et al. EncoderDecoder with Atrous Separable Convolution for Semantic ImageSegmentation[C]∥Proceedings of the European Conferenceon Computer Vision (ECCV ). Munich:Springer,2018:833-851.

[11] 毛萬菁,阮炬全,劉朔. 基于注意力機制的改進UNet草莓病害語義分割[J]. 計算機系統應用,2023,32(6):251-259.

[12] 楊奎河,張宇. 交通場景下基于YOLOv5 的目標檢測與分割算法[J]. 長江信息通信,2023,36(4):48-50.

[13] 李孟浩,袁三男. 基于改進YOLOv5s 的交通標識檢測算法[J]. 南京信息工程大學學報(自然科版),2024,16(1):11-19.

[14] 曾耀,高法欽. 基于改進YOLOv5 的電子元件表面缺陷檢測算法[J]. 浙江大學學報(工學版),2023,57(3):455-465.

[15] 杜少聰,張紅鋼,王小敏. 基于改進YOLOv5 的鋼軌表面缺陷檢測[J]. 北京交通大學學報,2023,47 (2):129-136.

[16] 段必沖,馬明濤. 基于改進YOLOv5 算法的口罩檢測研究[J]. 計算機工程與應用,2023,59(16):223-231.

[17] LIU S L,QI L,QIN H F,et al. Path Aggregation Networkfor Instance Segmentation[C]∥2018 IEEE / CVF Conference on Computer Vision and Pattern Recognition. SaltLake City:IEEE,2018:8759-8768.

[18] ZHENG Z H,WANG P,LIU W,et al. DistanceIoU Loss:Faster and Better Learning for Bounding Box Regression[J]. Proceedings of the AAAI Conference on Artificial Intelligence,2020,34(7):12993-13000.

[19] HOU Q B,ZHOU D Q,FENG J S. Coordinate Attention forEfficient Mobile Network Design[C]∥Proceedings of theIEEE / CVF Conference on Computer Vision and PatternRecognition. Nashville:IEEE,2021:13708-13717.

[20] TAN M X,PANG R M,LE Q V. EfficientDet:Scalableand Efficient Object Detection [C]∥ 2020 IEEE / CVFConference on Computer Vision and Pattern Recognition(CVPR). Seattle:IEEE,2020:10778-10787.

[21] ZHANG Y F,REN W Q,ZHANG Z,et al. Focal and Efficient IOU Loss for Aaccurate Bounding Box Regression[J]. Neurocomputing,2022,506:146-157.

[22] 于營,王春平,付強,等. 語義分割評價指標和評價方法綜述[J]. 計算機工程與應用,2023,59(6):57-69.

作者簡介

盧子冊 男,(1997—),碩士研究生。主要研究方向:計算機視覺、圖像處理和語義分割。

劉小芳 女,(1969—),博士,教授。主要研究方向:智能信息處理、模式識別和數據挖掘等。

王德偉 男,(1998—),碩士研究生。主要研究方向:圖像處理。