基于改進YOLOv5的番茄果實識別估產方法

楊健,楊嘯治,熊串,劉力

摘? ? 要:為了實現大棚環境中番茄的智能在線產量估算,提出了一種基于改進的YOLOv5(You Only Look Once v5)番茄識別算法,對自然生長狀態下的番茄果實產量進行統計和估算。首先,使用可分離視覺轉換器(Separable Vision Transformer,SepViT)替換骨干網絡的最后一層,以增強骨干網絡與全局信息之間的聯系并提取番茄特征;其次,引入WIOU(Wise Intersection over Union)損失函數和Mish激活函數,以提高收斂速度和精度。試驗結果表明,改進后的檢測模型在平均精度(mean Average Precision,mAP)方面達到了99.5%,相較傳統的YOLOv5模型提高了1.1個百分點,每張圖像的處理時間為15 ms。此外,改進后的YOLOv5算法對密集和遮擋情況下的番茄果實識別效果更好。

關鍵詞:大棚番茄;YOLOv5;注意力機制;損失函數

中圖分類號:S641.2 文獻標志碼:A 文章編號:1673-2871(2024)06-061-08

An improved YOLOv5-based method for tomato fruit identification and yield estimation

YANG Jian, YANG Xiaozhi, XIONG Chuan, LIU Li

(School of Mechanical and Electrical Engineering, Chengdu University of Technology, Chengdu 610059, Sichuan, China)

Abstract: In pursuit of intelligent real-time yield estimation for tomatoes in greenhouse environments, we introduce an enhanced YOLOv5 tomato recognition algorithm aimed at the statistical assessment and estimation of tomato fruit yield in their natural growth conditions. Our approach involved two key enhancements: firstly, we substituted the final layer of the backbone network with a Separable Vision Transformer to augment the connectivity between the backbone network and global context, thereby facilitating tomato feature extraction; secondly, we incorporated the WIOU loss function and employ the Mish activation function to enhance convergence speed and accuracy. Experimental findings demonstrate that the improved detection model achieves a mAP score of 99.5%, reflecting 1.1 percentage points enhancement compared to the conventional YOLOv5 model, and the processing time for every image is 15ms. Furthermore, the improved YOLOv5 algorithm exhibits superior recognition performance for densely populated and occluded tomato fruits.

Key words: Greenhouse tomato; YOLOv5; Attention mechanism; Loss function

隨著我國經濟的發展,農業正在向現代化轉型,溫室大棚已成為現代農業的重要支撐,而大棚番茄種植也在全國范圍內快速發展。準確估算大棚番茄的產量是種植規劃和營銷策略的重要組成部分,實時統計和預測番茄果實產量信息,并加以相應的生產控制,可以解決番茄產能波動和生產過程中的不連續性等問題。然而,大棚內的番茄莖葉和果實密集且相互重疊[1],限制了果實圖像特征的識別,進而影響了番茄產量的準確估算。因此,實現準確獲取番茄果實視覺信息是支持智能估產的重要前提。

傳統的番茄識別方法通常是手動設計特征提取器來提取目標特征,如梯度直方圖(Histogram of Oriented Gradient,HOG)、尺度不變特征變換(Scale-invariant feature transform,SIFT)和Haar-like特征等,這些特征再輸入支持向量機(Support Vector Machine,SVM)、AdaBoost、隨機森林(Random Forest,RF)等分類器進行分類和識別[2]。Liu等[3]應用偽色去除技術和SVM達到了94.41%的識別率,但在番茄遮擋和重疊等復雜情況下,效果不佳。李寒等[4]采用RGB-D相機拍攝圖像,通過預處理得到水果輪廓,采用K均值聚類與自組織映射算法進行番茄識別,識別率達到了87.2%,但輪廓提取易受光照影響。Malik等[5]采用改進的HSV顏色空間算法和分水嶺分割算法分離紅色番茄,但識別率只有81.6%。而馬翠花等[6]采用基于密度的局部自適應閾值分割算法提高番茄檢測精度,對未成熟番茄的識別率只達到77.6%。這些傳統方法泛化性差、計算復雜度高,難以提取出合理的特征。此外,它們往往沒有考慮到大棚環境中的復雜影響因素,對各種特征的變化魯棒性不足,難以滿足實際需求。而近年來興起的深度卷積神經網絡為獲取番茄果實視覺信息提供了更好的方法。

隨著深度學習的不斷發展,目前的目標檢測算法可以分為兩類。第一類是基于候選區域的two stage算法,例如R-CNN[7]、Fast R-CNN[8]和Faster R-CNN[9]等。這類算法通過兩個步驟來進行計算:首先選擇候選框,然后對候選框進行分類或回歸。這種方法具有高魯棒性和低識別錯誤率,但運算時間長,占用磁盤空間大,并且對圖像信息進行了重復計算,不適合實時檢測應用。第二類是基于網絡模型的one stage算法,例如YOLO[10-11]和SSD[12]等。這類算法通過在圖像上以不同尺度進行遍歷抽樣,并利用卷積神經網絡提取特征后直接進行回歸。這種方法的網絡模型較為簡單,識別速度快,特別適合實時檢測應用[13]。其中,YOLO模型是Redmon等[10]于2017年提出的對象檢測模型,與two stage算法相比,YOLO模型使用單個前饋網絡直接預測邊界框及其對應的類,作為一種基于回歸的檢測器,不僅支持快速實時識別,其精度也能夠滿足一般應用要求。

2018年,周云成等[14]提出了一種基于Fast R-CNN的雙卷積鏈算法,對番茄果實識別的平均精度為63.99%。2021年,張文靜等[15]將AlexNet作為Faster R-CNN的骨干網絡,在50%的重疊度下,番茄檢測的平均精度為83.9%,每幅圖像的處理時間為245 ms。2020年,劉芳等[16]通過改進YOLO網絡模型,可在復雜環境中有效地檢測番茄果實,識別準確率達到97.13%。同年,Liu等[17]提出一種用于檢測番茄果實的改進YOLOv3模型,在輕度遮擋條件下,番茄果實的識別準確率達到94.58%,但在遮擋嚴重時表現較差。2021年,成偉等[18]使用廣義交并比(Generalized Intersection over Union[19],GIOU),作為改進YOLOv3算法的位置損失函數,在番茄果實檢測方面的平均精度達到95.7%,每幅圖像的平均處理時間為15 ms[19]。

綜上所述,筆者針對大棚環境下番茄果實重疊、枝葉遮擋、光照不均等復雜情況,提出一種改進的YOLOv5目標檢測算法。首先,使用可分離視覺轉換器(SepViT)替換骨干網絡的最后一層,以增強骨干網絡與全局信息的聯系和提取番茄的特征;其次,利用WIOU損失函數和Mish激活函數來同時提高收斂速度和精度,使得YOLOv5能夠在大棚環境下獲得對番茄果實較高的檢測精度。

1 番茄圖像數據集制作

在筆者研究中使用的番茄數據集部分是在四川省成都市拍攝的,部分是從參考文獻中獲得的。這些圖像有效地反映了番茄生長的復雜性,如大小和光線的差異、番茄之間的遮擋以及枝葉的遮擋。在各種條件下,包括側光、背光、陰影等,隨機拍攝了1000余張番茄圖像,圖1所示為已建立的番茄數據集,拍攝時間為2022年7月,該番茄識別數據集已經在Zenodo上公開發布,可以在https://zenodo.org/record/8429227上獲取。

為了增強原始圖像數據,提高數據集的普適性和魯棒性,筆者采用了空間級和像素級數據增強方法,且同時使用了這兩類增強方法,如圖2所示。空間級變換技術修改邊界框和圖像,而像素級變換技術修改圖像,同時保持邊界框不變。

2 基于改進YOLOv5的番茄識別模型

2.1 YOLOv5目標檢測算法

YOLOv5是一種基于卷積神經網絡(Convolutional Neural Networks,CNN)的無錨點對象檢測算法,相比其他對象檢測算法具有更高的效率和準確性,其原理如圖3所示。

YOLOv5算法的基本原理是將輸入的圖片分成S×S個柵格化單元格。如果檢測到的目標中心落入特定的單元格中,則該單元格負責檢測目標,即自身有目標的概率為[Pobj=1]。然后,每個單元格預設生成B個先驗邊界框,每個邊界框與真實值邊界框的交并比為IOU。因此,圖像中的目標位置和類別預測可以表示為[S×S×B×(4+1+C)]的張量,其中4表示先驗邊界框的坐標[(x,y)]和寬高[(w,h)],1表示置信度得分,總共有5個特征參數,C表示使用的數據集中目標的類別數。通過連續回歸訓練真實邊界框,可以得到最終預測的目標位置、置信度和類別信息。最后,保留置信度最高的邊界框,以篩選出最佳的識別結果[20]。

2.2 深度可分離視覺注意力機制

最近幾年,視覺轉換器(Vision Transformer,ViT)在各種計算機視覺任務中取得了巨大的成功,其性能在關鍵領域甚至超過了傳統的卷積神經網絡[21-22]。然而,這些性能提升通常是以增加計算復雜度和參數數量為代價的,而深度可分離視覺注意力機制可以通過平衡計算成本和準確性來提高模型的性能[23]。

筆者將骨干網絡的最后一層替換為SepViT Block,以增強模型的特征提取能力,并優化與全局信息的聯系。在SepViT Block中,Depthwise selfattention (DWA)和Pointwise selfattention(PWA)可以減少計算量,并實現窗口內的局部信息通信和全局信息交互。首先,輸入的特征圖劃分為多個窗口,每個窗口被認為是特征圖的一個輸入通道,不同類型的信息被包含在每個窗口中;然后,對每個窗口及其像素標記執行DWA,這有助于融合通道的空間信息,類似于MobileNet[24-26]中的深度卷積。DWA的操作如下:

[DWA(f)=Attentionf?WQ,f?WK,f?WV]? ? 。

其中[f]是特征標記,由窗口標記和像素標記組成,[WQ]、[WK]和[WV]代表常規自注意力任務中的query、key、value三個線性層,PWA類似于MobileNet中的pointwise convolution操作,不同之處在于pointwise convolution用于融合不同通道的信息,而PWA則是在窗口之間建立連接。完成DWA操作后,PWA建立窗口之間的關系,并通過Layer Normalization (LN)和Gelu激活函數生成注意力圖。PWA的運行過程如下:

PWA(f,wt)=Attention{Gelu[LN(wt)]·WQ,Gelu[LN(wt)]·WK,f}。

其中[wt]代表窗口標記。

SepViT Block可以表示為:

[fn=Concat fn-1,wt];

[fn=DWA LNfn]? ? ;

[fn,wt=Slice fn]? ?;

[fn=PWA fn,wt+fn-1]? ? ;

[fn=MLP LNfn+fn]? ? ?。

其中[fn]表示SepViT塊,[f.]n和[w·t]是特征映射和學習的窗口標記,Concat表示串聯操作,Slice表示切片操作,圖4為SepViT塊的結構。

2.3 損失函數與激活函數

YOLOv5的損失函數由兩部分組成:分類損失和邊界框回歸損失。邊界框回歸損失最經典的形式是IOU(Intersection over Union)[27]損失,YOLO系列中最常用的版本是CIOU(Complete Intersection over Union)[28]。CIOU通過預測框中心點歐氏距離和重疊率參數作為預測框偏差的偏差指標。

[CIOUij=JU-ρ2b,bgtc2-αν;α=v(1-IoU)+vν=4π2arctan ωgthgt-arctan ωh2 。]

其中([ωgt],[hgt])、([ω],[h])分別表示預測框和真實框的高與寬,[b]、[bgt]分別表示預測框和真實框的中心點,[ρ]表示兩個中心點間的歐氏距離,[c]表示最小外接矩形框對角線距離,[α]表示權重函數,[v]表示真實框與預測框矩形對角線傾斜角的差方,如圖5所示。

由于大棚內的復雜環境,訓練數據不可避免地包含了低質量示例,從而降低模型的泛化性能。一個好的損失函數應該在anchor box和target box很好重合的情況下減弱幾何因素的懲罰。因此,筆者選擇了WIOU[29]替換CIOU,來提高模型的整體性能。

[LWIOU=RWIOULIOU];

[RWIOU=exp x-xgt2+y-ygt2W2g+H2g*]? ? 。

式中[Wg]、[Hg]是最小封閉框的尺寸。為了防止[RWIOU]產生阻礙收斂的梯度,將[Wg]、[Hg]從計算圖中分離出來(上標*表示該操作)。因為它有效地消除了阻礙收斂的因素,所以不需要引入縱橫比等指標。

在YOLOv5中,原先使用ReLU作為激活函數,但ReLU在負值時會直接截斷,導致梯度的損失。因此,筆者使用Mish[30]激活函數代替ReLU激活函數,并將其應用于訓練和推理過程中。Mish是一種光滑且非單調的激活函數,其定義為:

[f(x)=xtanh [softplus(x)]=xtanh ln1+ex]

Mish激活函數的優勢在于它沒有上界,可以避免梯度飽和的問題。從圖6中可以看出,當輸入值為負時,Mish允許較小的負梯度流入,從而保證信息的流動性,同時穩定了網絡梯度的流動,起到了強正則化的作用。此外,Mish函數是一個光滑函數,允許更多的信息深入神經網絡中,因此,使用Mish函數可以提高網絡的精確度和泛化能力。

3 結果與分析

3.1 番茄檢測算法試驗

試驗的主要硬件平臺為Dell Precision 3660 Tower工作站,搭載CPU為Intel 12500×3 GHz,顯卡為NVIDIA RTX A4000,軟件平臺包括CUDA11.1、Python3.8.8和PyTorch1.8.0。在試驗中,將數據集按照8∶1∶1的比例隨機分為訓練集、驗證集和測試集,并使用SGD優化器進行模型訓練。設置批處理大小為64,初始學習率為0.01,輸入圖像的大小為640×640,訓練周期為900。

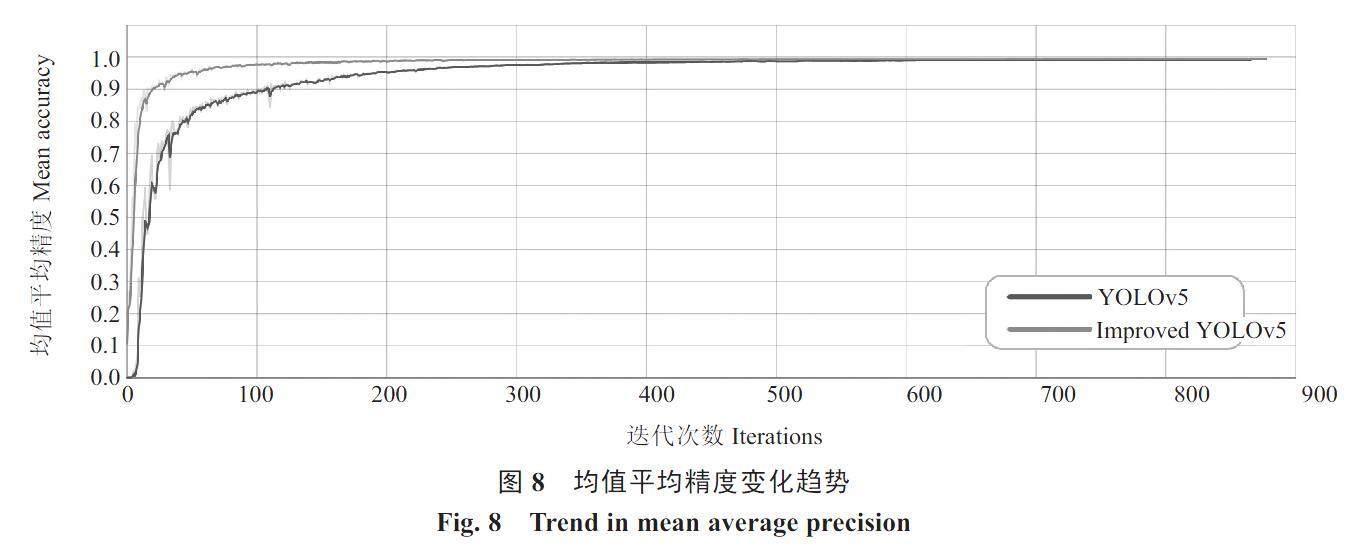

使用可視化工具TensorBoard記錄訓練過程中損失函數值和精度值的變化,圖7和圖8展示了損失函數和mAP的變化趨勢。

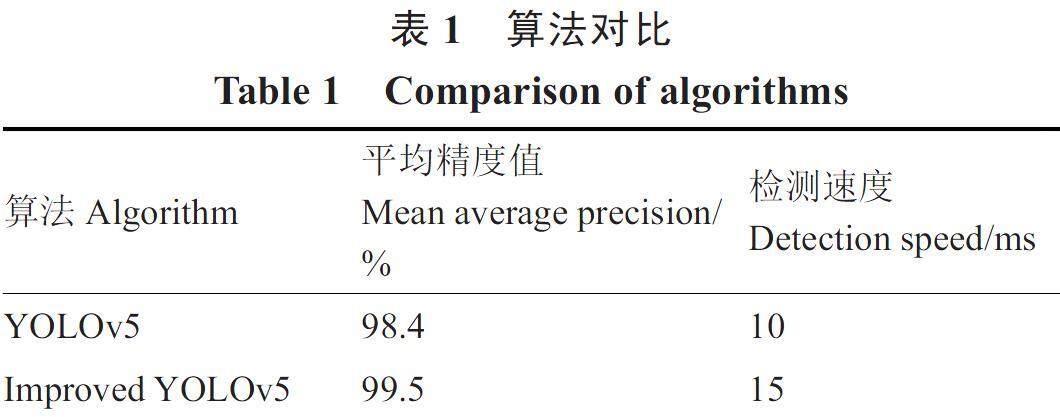

在前200個迭代循環中,損失函數的值呈明顯下降的趨勢,隨后下降速度減緩。經過600個迭代循環后,損失函數的值降至3附近,表明模型已經達到穩定收斂狀態。在訓練過程中,每隔10個迭代周期輸出1次模型,并對測試集圖像進行識別和處理。使用平均精度(mAP)作為評價指標,選擇具有最高精度的模型作為最優模型。表1是與改進模型相比,使用相同訓練過程的YOLOv5和改進模型的對比結果。

傳統YOLOv5的mAP值為98.4%,改進后的YOLOv5為99.5%,提高了1.1個百分點,檢測改進算法的效率與傳統算法基本相同。可以看出,改進后的模型具有更高的準確度,能夠更好地識別和定位番茄果實。

3.2 番茄產量估計試驗

試驗方法如下:(1)選擇不同光線和尺度的視野,隨機采集番茄植株圖像,保證數據的多樣性;(2)特意選擇一些稀疏、密集和模糊果實的特殊圖像樣本,人工統計試驗圖像中紅色和綠色果實的數量作為對照。(3)利用YOLOv5模型及改進后的YOLOv5模型對采集圖像進行模式識別,對視野內的水果進行計數,并與人工計數結果進行對比,評價產量估算模型的準確性。

通過參考紅色和綠色番茄的人工計數結果,筆者評估了YOLOv5和改進的YOLOv5對番茄的識別計數結果。對紅番茄、綠番茄和總番茄的識別計數結果與人工計數進行比較,并以計算的比值作為紅番茄、綠番茄和總番茄估產準確率的衡量指標。識別結果如圖9、10所示,統計結果如表2所示。

可以看出,改進后的YOLOv5模型對密集紅色番茄和綠色番茄的產量估算精度都有明顯提高:密集紅色番茄的估算精度提高了1.5個百分點,密集綠色番茄的估算精度提高了2.7個百分點。這表明改進后的YOLOv5模型在識別和估算密集的番茄群體時更為準確。且改進后的YOLOv5模型對遮擋紅色番茄和綠色番茄的產量估算精度也有明顯提高:遮擋紅色番茄的估算精度提高了1.8個百分點,遮擋綠色番茄的估算精度提高了3.2個百分點。這意味著改進后的YOLOv5模型在處理遮擋情況下的番茄估算更為可靠。

4 討論與結論

筆者提出了一種用于復雜環境下的改進YOLOv5算法,對自然生長條件下的番茄果實產量進行統計和估算。通過改進傳統的YOLOv5模型的骨干網絡和損失函數,構建了一種用于自然生長下番茄果實識別的模型。改進后的YOLOv5模型識別準確率得到提升,最終模型的mAP值為99.5%,比未改進的YOLOv5模型提高了1.1個百分點。改進后的YOLOv5模型對處于密集和遮擋條件下的番茄果實有更明顯的識別效果和魯棒性。密集條件下的紅色番茄和綠色番茄的估算準確率分別為99.7%和99.1%,遮擋條件下的紅色番茄和綠色番茄的估算準確率分別為99.2%和98.9%。通過應用筆者提出的番茄識別網絡模型,能夠有效解決傳統圖像檢測方法在處理番茄果實重疊、枝葉遮擋和光照不均等復雜情況下定位檢測精度低的問題,為后續研究提供了更有力的技術支持。

隨著技術不斷進步,未來的研究方向包括利用遷移學習和自監督學習來增強模型的泛化性能,實施目標跟蹤以追蹤番茄狀態,進一步優化精細的番茄定位和計數,以及將番茄識別與農業決策支持系統緊密融合,以提供實時的農田管理建議。

參考文獻

[1] 張俊寧,畢澤洋,閆英,等.基于注意力機制與改進YOLO的溫室番茄快速識別[J].農業機械學報,2023,54(5):236-243.

[2] 孫皓澤,常天慶,王全東,等.一種基于分層多尺度卷積特征提取的坦克裝甲目標圖像檢測方法[J].兵工學報,2017,38(9):1681-1691.

[3] LIU G X,MAO S Y,KIM J H.A mature-tomato detection algorithm using machine learning and color analysis[J].Sensors,2019,19(9):2023.

[4] 李寒,陶涵虓,崔立昊,等.基于SOM-K-means算法的番茄果實識別與定位方法[J].農業機械學報,2021,52(1):23-29.

[5] MALIK M H,ZHANG T,LI H,et al.Mature tomato fruit detection algorithm based on improved HSV and watershed algorithm[J].IFAC-Papers On Line,2018,51(17):431-436.

[6] 馬翠花,張學平,李育濤,等.基于顯著性檢測與改進Hough變換方法識別未成熟番茄[J].農業工程學報,2016,32(14):219-226.

[7] GIRSHICK R,DONAHUE J,DARRELL T,et al.Rich feature hierarchies for accurate object detection and semantic segmentation[C].IEEE Conference on Computer Vision and Pattern Recognition,2014.

[8] GIRSHICK R.Fast R-CNN[C].IEEE International Conference on Computer Vision,2015.

[9] REN S Q,HE K M,GIRSHICK R,et al.Faster R-CNN:Towards real-time object detection with region proposal networks[J].Advances in Neural Information Processing Systems,2015.

[10] REDMON J,FARHADI A.YOLO9000:Better,faster,stronger[C].IEEE Conference on Computer Vision and Pattern Recognition,2017.

[11] REDMON J,DIVVALA S,GIRSHICK R,et al.You only look once:Unified,real-time object detection [C].IEEE Conference on Computer Vision and Pattern Recognition,2016.

[12] LIU W,ANGUELOV D,ERHAN D,et al.Ssd:Single shot multibox detector[C].Computer Vision–ECCV 2016:14th European Conference,Amsterdam,The Netherlands,October 11-14,2016,Proceedings,Part I 14.Springer International Publishing,2016.

[13] 何斌,張亦博,龔健林,等.基于改進YOLO v5的夜間溫室番茄果實快速識別[J].農業機械學報,2022,53(5):201-208.

[14] 周云成,許童羽,鄧寒冰,等.基于雙卷積鏈 Fast R-CNN 的番茄關鍵器官識別方法[J].沈陽農業大學學報,2018,49(1):65-74.

[15] 張文靜,趙性祥,丁睿柔,等.基于Faster R-CNN算法的番茄識別檢測方法[J].山東農業大學學報(自然科學版),2021,52(4):624-630.

[16] 劉芳,劉玉坤,林森,等.基于改進型YOLO的復雜環境下番茄果實快速識別方法[J].農業機械學報,2020,51(6):229-237.

[17] LIU G X,NOUAZE J C,TOUKO P L,et al.YOLO-Tomato:A robust algorithm fortomato detection based on YOLOv3[J].Sensors-Basel,2020,20(7):2145.

[18] 成偉,張文愛,馮青春,等.基于改進YOLOv3的溫室番茄果實識別估產方法[J].中國農機化學報,2021,42(4):176-182.

[19] REZATOFIGHI H,TSOI N,GWAK J Y,et al.Generalized intersection over union:A metric and a loss for bounding box regression[C].IEEE/CVF Conference on Computer Vision and Pattern Recognition,2019:658-666.

[20] 成偉.基于深度學習的番茄植株多目標識別方法研究[D].太原:太原理工大學,2021.

[21] VASWANI A,SHAZEER N,PARMAR N,et al.Attention is all you need[C].Proceedings of the 31st Information Processing Systems,2017:6000-6010.

[22] DOSOVITSKIY A,BEYER L,KOLESNIKOV A,et al.An image is worth 16×16 words:Transformers for image recognition at scale[J].arXiv:2010.11929,2020.

[23] LI W,WANG X,XIA X,et al.Sepvit:Separable vision transformer[J].arXiv:2203.15380,2022.

[24] HOWARD A G,ZHU M L,CHEN B,et al.MobileNets:Efficient convolutional neural networks for mobile vision applications[J].arXiv:1704.04861,2017.

[25] SANDLER M,HOWARD A,ZHU M,et al.MobileNetv2:Inverted residuals and linear bottlenecks[C].IEEE/CVF Conference on Computer Vision and Pattern Recognition,2018:4510-4520.

[26] ANDREW H,MARK S,GRACE C,et al.Searching for mobilenetv3[C].Proceedings of the IEEE/CVF international conference on computer vision,2019:1314-1324.

[27] YU J H,JIANG Y N,WANG Z Y,et al.Unitbox:An advanced object detection network[C].Proceedings of the 24th ACM international conference on Multimedia,2016:516-520.

[28] ZHENG Z H,WANG P,REN D W,et al.Enhancing geometric factors in model learning and inference for object detection and instance segmentation[J].IEEE Transactions on Cybernetics,2021,52(8):8574-8586.

[29] TONG Z J,CHEN Y H,XU Z W,et al.Wise-IoU:Bounding box regression loss with dynamic focusing mechanism[J].arXiv:2301.10051,2023.

[30] MISRA D.Mish:A self regularized non-monotonic activation function[J].arXiv:1908.08681,2019.