基于改進U-net的大壩表面混凝土裂縫圖像分割方法

趙普 谷艷昌 張大偉 吳云星

摘要:大壩表面混凝土裂縫的檢測與識別對大壩安全具有重要意義,為此開展了基于深度學習方法的混凝土裂縫織別方法研究。針對裂縫圖像具有復雜拓撲結構和正負樣本不平衡等特點,在典型U-net中嵌入了ASPP和CBAM優化模塊,同時以Dice+BCE混合損失函數代替了單一交叉熵損失函數。結果表明:所創建的改進U-net在自制實例大壩裂縫圖像數據集上表現優異,交并比IoU和F1分數分別為47.05%和62.99%,對比典型U-net分別提高了5.41%和5.19%,對比PSPNet分別提高了3.05%和3.31%。改進的U-net在裂縫分割任務中像素分類更精確,多尺度信息更豐富,具有良好的泛化能力和魯棒性,可為大壩混凝土結構表面裂縫檢測與識別提供更優的手段。

關鍵詞:混凝土裂縫檢測; 深度學習; 語義分割; U-net模型優化; 大壩安全

中圖法分類號: TV698.1

文獻標志碼: A

DOI:10.16232/j.cnki.1001-4179.2024.04.033

0引 言

混凝土結構是水工建筑物的重要組成部分,由于混凝土抗拉強度低,受收縮徐變、外界溫度變化、地基變形等內外因素的共同影響[1],在施工和運行階段往往不可避免地產生各種型式的裂縫。如果不及時對裂縫進行判別和修復,隨著裂縫持續發展,會使結構承載力降低,耐久度下降甚至出現滲漏等問題[2]。因此,定期檢測和評估混凝土結構表面裂縫及其危害,對工程安全具有重要意義。

開展大壩混凝土結構裂縫檢測與識別,是當前研究的熱點和難點問題。早期裂縫檢測以人工方式為主,存在工作強度大、效率低、安全性差等缺點。而較先進的無損檢測方法例如超聲波法、紅外熱成像法、斷層掃描法[1]等,受儀器限制,也無法應用于大范圍檢測。隨著計算機技術和數字圖像處理技術的發展,以數字圖像為基礎的裂縫檢測方法(如閾值分割、邊緣檢測和滲流模型等)展現出了高精度、非接觸式和便捷直觀等優勢[3]。如王波等[4]設計的一種機器人廊道巡檢系統中就搭載了裂縫檢測模塊,通過高斯背景建模和邊緣檢測算法自動提取裂縫輪廓進行分析;馬嘉文[5]針對大壩裂縫圖像噪聲干擾問題,通過小波變換、閾值濾波等一系列算法處理,實現了良好的去噪效果。然而這些方法在實際應用中存在一些明顯的缺陷:① 這類算法通常基于圖像的底層特征,如顏色、邊緣、紋理等進行分割,對光影、復雜紋理細節等噪聲很敏感,難以保證裂縫提取質量;② 當裂紋寬度變化顯著或與圖像背景之間對比度低時,極易導致裂紋中斷或消失;③ 接縫噪聲前后處理程序復雜,需要大量人工參數調整,致使自動化檢測的實現十分困難[6]。

深度學習方法的出現使裂縫檢測技術水平邁上一個新的臺階。它的基本思想是利用多層非線性結構對數據樣本進行特征學習,從而實現對數據信息的預測或分類等任務。與傳統數字圖像處理方法相比,深度學習可以自適應地學習和優化模型,不需要設定過多參數,并且能從圖像數據中挖掘到深層特征,可以有效應對噪聲干擾。在裂縫檢測任務中,通過深度學習方法可以提取和融合不同背景尺寸和不同級別的特征圖,顯著提高裂縫檢測的效率和準確性[7]。

基于深度學習的語義分割是一種將類別標簽分配到圖像每個像素上的方法[8],通過給裂縫和背景分別貼上正和負的標簽,輸出二值分割結果圖,可實現混凝土表面裂縫缺陷檢測。U-net是語義分割領域中的典型模型之一,最先由Ronneberger等[9]提出,因其獨特的“U”型對稱結構得名,起初被用于醫學圖像分割,得益于其優異的性能,后逐漸被應用于各種分割任務。Liu等[10]首次將U-net用于混凝土裂縫檢測,相比于Cha等[11]提出的DCNN(深度卷積網絡),具有更好的魯棒性、更高的效率和識別精度。在裂縫檢測應用方面,國內也有不少學者對U-net進行優化調整,取得了良好效果。瞿中等[12]在U-net網絡的每個池化層后都進行一次上采樣操作,將其與池化之前的卷積層進行融合,最大程度提取了原始圖像細節信息和全局信息,通過與傳統滲流模型在混凝土路面裂縫的檢測對比,證實其具有更優效果。常惠等[13]在U-net網絡中引入殘差模塊,加強特征傳播,減少信息損失,然后引入注意力機制SE模塊,增強對關鍵區域信息的提取,在鐵路隧道裂縫數據集上達到了較高的精度和較短的運行耗時。曹錦綱等[14]也在U-net中引入了一種注意力機制AFM模塊,以充分利用全局信息和增加對不同尺度裂縫的魯棒性,所創建的ACNet在公共裂縫數據集CFD和CRACK500上,比典型U-net和傳統圖像處理方法裂縫定位更精確、細節更豐富。以上學者均在U-net典型網絡結構上做了改進,但主要針對網絡的特征提取能力,而較少關注裂縫圖像本身特點。本文從裂縫的形狀和分布特點出發,引入針對大壩裂縫特征提取的優化模塊,擬對典型U-net網絡結構進行改進研究,以期實現更優的裂縫圖像分割方法,拓延大壩裂縫檢測與識別技術理論。

1改進U-net

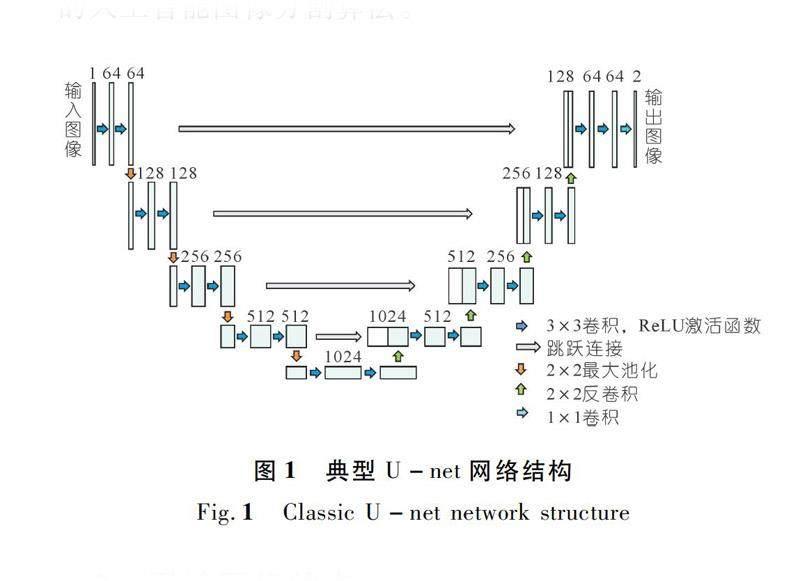

1.1典型U-net

典型U-net結構如圖1所示。網絡可分為左右兩部分,左邊部分為編碼器(Encoder),對輸入圖像用卷積和池化層的堆疊進行4次下采樣提取圖像特征;右邊為解碼器(Decoder),對特征圖進行4次上采樣,每次都與左側的特征圖采取拼接(Concatenate)操作進行特征融合,最后輸出分割結果。U-net可實現像素級的圖像分割任務,且獨特的網絡結構使其可以在數據集量較小的條件下依然表現良好,是目前十分常用的人工智能圖像分割算法。

1.2裂縫圖像特點

與常見語義分割數據集相比,裂縫圖像具有以下幾個特點,通常也是分割任務中的難點:

(1) 裂縫形狀曲折多變。裂縫圖像復雜多變,具有不同的拓撲結構和寬度,而標準卷積只能獲取單一上下文信息,無法有效同時提取細紋和寬縫特征[15],即缺乏多尺度特征提取能力。

(2) 裂縫往往貫穿整張圖片。傳統U-net采用3×3卷積核,感受野較小,導致全局信息提取能力不足。

(3) 前景與背景像素嚴重不平衡。前景像素,也就是裂縫本身的像素點,只占整張圖像的一小部分,若使用傳統的交叉熵損失函數(Cross Entropy Loss),會導致背景漸變主導[16],忽略較小的裂縫特征。

針對以上裂縫圖像特點以及典型U-net在特征提取方面的不足之處等,本文提出引進空間金字塔空洞卷積(Atrous Spatial Pyramid Pooling,ASPP)模塊和混合注意力(Convolutional Block Attention Module,CBAM)機制以加強和豐富特征提取,使用Dice Loss加交叉熵的混合損失函數以應對前景背景像素樣本失衡的問題。

1.3ASPP模塊

ASPP意為空洞空間卷積金字塔池化或多孔空間金字塔池化,是空洞(Atrous)卷積和空間金字塔池化(Spatial Pyramid Pooling)[17]的結合。空洞卷積是在標準卷積的基礎上引進了一個膨脹率(Dilation Rate)[18],圖片中相鄰的像素點往往存在信息冗余,故而空洞卷積具備兩個優勢:一是擴大感受野,二是能夠捕獲多尺度信息。由于空洞卷積得到的某一層的結果中,鄰近的像素是從相互獨立的子集中卷積得到的,相互之間缺少依賴,因此也存在局部信息丟失和遠距離信息缺少相關性的不足。

ASPP一開始在DeepLabv2[19]中提出,模塊結構如圖2所示。其以空間金字塔池化為框架,對于給定的輸入以不同膨脹率的空洞卷積并行采樣,擴大通道數,然后再通過1×1的卷積將通道數降低到預期的值,即以多個比例捕捉了圖像上下文信息,提取了多尺度特征。

1.4CBAM模塊

CBAM[20]是輕量級的卷積注意力模塊,結合了通道注意力(Channel Attention Module,CAM)和空間注意力(Spatial Attention Module,SAM)。通道注意力讓網絡關注圖像內容,而空間注意力則關注圖像中物體的位置。在卷積過程中,給定任意一個中間特征圖,CBAM將注意力沿特征圖的通道和空間兩個獨立的維度進行映射,然后將注意力乘以特征映射,對輸入特征圖進行自適應特征細化。

1.5混合損失函數

損失函數(Loss Function)用來衡量預測與實際的差距程度,在模型訓練過程中起監督作用。裂縫分割屬于二分類問題,可采用二分類交叉熵(Binary Cross Entropy,BCE)損失函數,定義如下:

Dice Loss求交形式可以理解為mask掩碼操作,固定大小的正樣本區域計算的loss不會隨著圖片大小而變,訓練更傾向于挖掘前景區域信息,而交叉熵會公平處理正負樣本,這在正樣本占比較小時是十分不利的。但使用單一的Dice損失函數有時會導致梯度發生很大變化,使訓練出現較大波動[8]。因此,本文采用“BCE+Dice”混合損失函數,可以在保證訓練穩定的條件下,很好地處理正負樣本不平衡的問題。

1.6改進U-net網絡結構

1.6.1數據集選擇

大壩裂縫相較于常見的道路和建筑缺陷裂縫,通常寬度更細、形態更多變,并且與水壓力和溫度等因素密切相關,可能涉及較高的安全風險。因此,大壩裂縫檢測的關鍵在于全面、準確地識別到已有的裂縫,不放過任何細微的、不起眼的部位。

Kaggle是全球最大的公開在線數據科學競賽平臺,包含各種內容和形式的數據集。從該平臺篩選出一個與大壩裂縫十分接近的數據集,總共288組大小為512×512的RGB混凝土表面裂縫圖像和對應的二值標簽圖,其中包含許多裂紋寬度小、形態變化多樣的圖像樣本,部分示例樣本如圖4所示。通過該數據集對網絡進行優化測試,可以保證在將優化后的網絡模型應用于實例數據集時的有效性。

1.6.2確認網絡結構

理論上ASPP和CBAM模塊可以放在網絡中的任一層,將兩個模塊以不同的數量及其組合嵌入U-net主干網絡,通過所選數據集對網絡進行初步訓練,根據訓練過程中Dice得分和Loss值變化衡量網絡性能。Dice得分最高、Loss最小為最佳網絡結構。

最終確定改進U-net網絡結構如圖5所示,在編碼層的每個初始卷積后銜接一個ASPP模塊,以增強特征提取的能力;由ASPP產生的特征圖,除了進行下采樣操作,還通過跳躍連接與對應解碼層的特征圖相融合,這樣做是為了同時保留低階和高階特征,即保持尺度多樣性;在編碼層與解碼層的過渡位置添加CBAM注意力模塊,以關注重點部位而忽略多余的背景。

2模型訓練

2.1數據準備

2.1.1數據增強

數據增強的目的是讓有限的數據產生更多信息,以增加訓練樣本數量和多樣性,提高模型魯棒性和泛化能力。本文將原數據集平均分為兩組,每組分別以不同的參數進行翻轉、旋轉、顏色抖動、對比度增強和亮度增強的操作,對樣本數量進行擴充。部分增強數據示例如圖6所示。

2.1.2數據劃分

進行數據增強后的樣本數量變為原來的6倍,一共1 728組樣本和標簽。在網絡訓練之前,將總數據的10%劃分為驗證集,在訓練過程中實時計算Dice得分以衡量訓練效果,同時防止過擬合。此外,另選30張未參與訓練且具有代表性的裂縫圖片作為測試集,以檢驗模型的魯棒性和泛化能力。

2.2參數設置

運行環境為RTX2060GPU(6G),基于Python 3.9和開源深度學習框架Pytorch。設置Batch Size(批大小,即每次輸入的圖像張數)為1,Epoch(總數據的迭代輪數)為5,初始學習率為0.001,采用RMSProp優化器加速梯度下降并自適應調整學習率,上采樣步驟使用計算速度相對較快的雙線性插值取代轉置卷積。

2.3訓練結果

分別對加入了ASPP與CBAM優化模塊和未加入模塊的模型進行訓練。訓練過程中Dice得分、loss及學習率變化對比如圖7~9所示,曲線均通過指數平均移動法(Exponential Moving Average,EMA)進行平滑處理。

從圖7可以看出,幾乎在整個訓練過程中,改進U-net的Dice得分始終大于原始模型,從第4 000步開始Dice穩定在0.82左右,最終為0.836。圖8為loss曲線,由于采用組合損失函數,loss無較大差異,在0.1左右上下波動。圖9中,改進U-net學習率下降更快,表明模型特征提取能力更強,參數更新速度大于典型網絡結構。

3模型評價

3.1評價指標

對于二分類問題,樣本有正負兩個類別,因此模型的預測結果和真實標簽的組合有4種tp,fp,fn和tn,如表1所列。分別表示:實際為正樣本預測為正樣本,實際為負樣本預測為正樣本,實際為正樣本預測為負樣本,實際為負樣本預測為負樣本。

事實上,F1等效于Dice Coefficient。以上指標取值均在0~1之間,越接近1表明模型性能越好,其中IoU和F1為二分類語義分割中最常用的指標,能綜合反映模型整體的分割效果和精度。

3.2消融試驗

為驗證本文所提出改進策略對模型性能提升的有效性,每次只引入一種優化方法,在原數據集和測試集上分別訓練和測試模型,通過與典型U-net的比較對該方法進行評價。引入ASPP和CBAM對網絡訓練過程中的Dice影響曲線以及使用不同損失函數對Dice的影響如圖10所示,每種優化模型在測試集的分割精度指標統計見表2。

從圖10可以看出,加入ASPP的網絡Dice系數穩定后為83.54%,CBAM為82.46%,相比原始網絡的81.59%分別提高約2%和1%,證實加入優化模塊可在一定程度上提升網絡性能。在圖11中,單一的損失函數在訓練前期Dice波動較大,而使用混合損失函數可以明顯提升網絡訓練穩定性。

從表2分析得知,各個改進方法對網絡性能都有一定的提升效果。其中,改進后的模型在測試集上的IoU和F1均大于典型U-net。此外,通過數據增強擴充數據集也使模型的分割精度得到了提升,IoU和F1分別提高0.62%和1.2%。

3.3對照試驗

為了評估改進U-net在不同方法中的優越性,本文選取了閾值分割方法和PSPNet(Pyramid Scene Parsing Network)作為對照組,通過在測試集上的分割效果對比表明深度學習方法和傳統數字處理方法之間以及不同深度學習方法之間的差異性。

(1) 閾值分割。

閾值分割是一種簡單常見的圖像分割方法,該方法基于一個或多個閾值將圖像像素劃分為兩個或多個組,使其在同一組中具有相似的灰度值。由于閾值分割易受圖片噪聲影響,閾值設置太高會導致分割結果噪點太多,而太低又不能完整體現裂縫形態,故人工為每一張測試圖像調整最優閾值。

(2) PSPNet。

PSPNet同樣是一種用于圖像語義分割的深度學習神經網絡模型[22]。該模型最大的特點在于采用了金字塔池化(Pyramid Pooling)結構,可以有效地捕獲不同尺度的語義信息,從而提高分割精度。對PSPNet使用相同的數據集進行訓練,基本訓練參數如下:

主干特征提取網絡,Mobilenet;Max Epoch,16;Batch Size,2;Loss Function,Dice;初始學習率,5×10-4;梯度優化器,Adam。

3.4評價結果

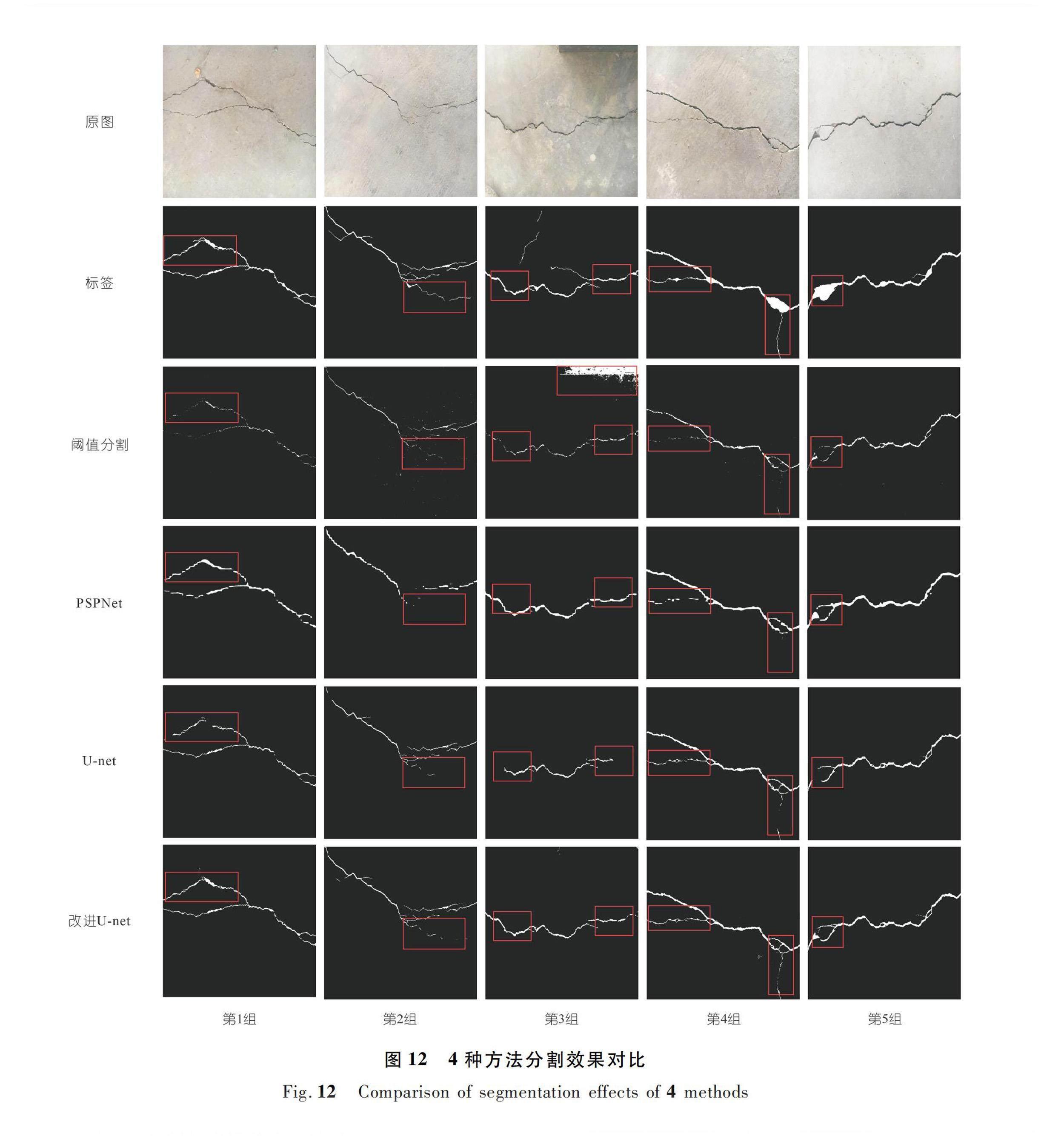

閾值分割、PSPNet、典型U-net以及改進U-net 4種方法在測試集的分割效果對比如圖12所示。

由圖12分析得知:在裂縫圖片無陰影、噪聲較少時,閾值分割方法具有不錯的表現,如第5組,但當出現陰影和其他干擾時,分割圖中出現較多噪點,如第3組右上角,且閾值分割由于參數固定無法同時保證粗紋和細支的完整性;PSPNet相比閾值分割效果有明顯提升,很好地抑制了噪聲,裂縫整體形態較完整,但細節刻畫能力不足,且存在較多斷點;典型U-net與PSPNet無較大差別,同樣存在較多斷點,并且由于U-net感受野較小,存在裂縫末端未識別的現象,如第3組;改進U-net對比前幾組效果提升顯著,不僅解決了噪聲、斷點和未識別的問題,同時細節刻畫更完整,多尺度信息更豐富。

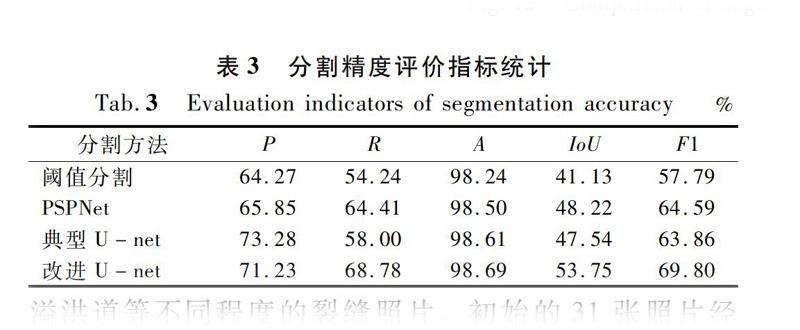

對測試集通過4種方法生成的分割圖分別計算P、R、A、IoU和F1并求算術平均值,統計結果見表3。由于裂縫標簽圖本身存在一定誤差,使得某些指標數值偏小,但從對比結果來看,PSPNet和U-net總體表現相近,各項指標均大于閾值分割,其中U-net準確率P提升9.01%,PSPNet召回率R提升10.17%,表明深度學習方法比傳統圖像處理算法定位更準確,抗噪聲能力更強;改進U-net對比閾值分割有十分顯著的提升,IoU和F1分別提高12.62%和12.01%,而對比PSPNet,IoU和F1分別提高5.53%和5.21%,表明改進U-net無論是相較于傳統數字圖像算法還是在同類深度學習算法間都體現了明顯的優勢。

4實例應用

為了驗證改進U-net在實際工程應用中的性能,筆者制作了大壩工程裂縫數據集。數據來自一座土石壩和一座混凝土壩各個部位,如上游護坡、壩頂道路、溢洪道等不同程度的裂縫照片。初始的31張照片經過固定大小的裁剪后生成93張512×512的圖片,用python第三方庫labelme對照片中的裂縫進行手動標簽繪制,生成93組裂縫圖片和對應的mask標簽,其中68組用數據增強方法生成408組訓練數據,另外的25組用于模型測試。實例工程數據集樣本示例如圖13所示。

對408組樣本進行模型訓練,網絡結構和參數設置與2.2節中相同。由于實例數據集樣本數量較少,故采用遷移學習的方法,加載上文中訓練好的模型初始權值和閾值,可使得網絡訓練收斂速度更快,并且能在一定程度上提升模型整體的泛化性能。

對25組測試圖片分別用閾值分割、PSPNet、典型U-net和改進U-net做測試,分割圖對比結果如圖14所示。從第2~4組中可以看出,在裂紋較細、路徑曲折的條件下,閾值分割和典型U-net均有模糊和中斷的現象,且在第5組中典型U-net存在較多噪點;PSPNet在抗噪方面表現出良好的性能,在第5組中消除了大部分噪點,但仍然存在斷點和消失的問題;改進U-net分割效果更清晰,保持了裂紋完整性,細節捕捉更全面,綜合性能優于其他模型。

4種方法分割精度指標統計見表4,基本趨勢與3.4節中一致。以IoU和F1為依據,分割精度排序為閾值分割<典型U-net 5結 論 本文針對混凝土結構裂縫圖像特點以及典型U-net在特征提取上的不足之處,將ASPP和CBAM模塊嵌入U-net主干網絡中,加強和豐富了網絡的特征提取能力;并用Dice+BCE的混合損失函數取代單一交叉熵損失函數,在訓練穩定的條件下解決了由正負樣本不平衡導致的訓練效果差的問題,創建了改進的U-net混凝土裂縫圖像分割識別方法。 通過自制大壩工程裂縫圖像數據集對多種分割方法進行了測試,在閾值分割、PSPNet、典型U-net以及改進U-net這4種方法中,改進U-net綜合性能最優,IoU和F1分別為47.05%和62.99%,對比典型U-net分別提高5.41%和5.19%,對比PSPNet分別提高3.05%和3.31%。改進U-net在裂縫圖像分割任務中,像素分類更精確,多尺度信息更豐富,可在干擾條件下實現混凝土表面裂縫的有效分割與識別,拓延了裂縫檢測識別技術和理論發展,對監控和評估大壩混凝土結構安全具有重要實際意義。 參考文獻: [1]溫作林.基于深度學習的混凝土裂縫識別[D].杭州:浙江大學,2019. [2]武維毓,房國忠,魏櫻,等.基于數值仿真的大壩壩頂裂縫成因及危害性分析[J].人民長江,2020,51(增2):270-274. [3]楊松,邵龍潭,郭曉霞,等.基于骨架和分形的混凝土裂縫圖像識別算法[J].儀器儀表學報,2012,33(8):1850-1855. [4]王波,趙遠,劉喜泉,等.智能巡檢機器人在大壩廊道運維中的應用[J].人民長江,2022,53(7):227-231. [5]馬嘉文.基于圖像處理的大壩裂縫檢測算法研究[D].哈爾濱:哈爾濱工程大學,2019. [6]TANG T Z,ALLEN A,ZHANG L L,et al.Pixel-level pavement crack segmentation with encoder-decoder network[J].Measurement,2021,184:109914. [7]KHERADMANDI N,MEHRANFAR V.A critical review and comparative study on image segmentation-based techniques for pavement crack detection[J].Construction and Building Materials,2022,321:126162. [8]KNIG J,JENKINS M D,BARRIE P,et al.A convolutional neural network for pavement surface crack segmentation using residual connections and attention gating[C]∥2019 IEEE International Conference on Image Processing(ICIP),2019:1460-1464. [9]RONNEBERGER O,FISCHER P,BROX T.U-net:convolutional networks for biomedical image segmentation[C]∥Medical Image Computing and Computer-Assisted Intervention:18th International Conference,2015. [10]LIUZ Q,CAO Y W,WANG Y Z,et al.Computer vision-based concrete crack detection using U-net fully convolutional networks[J].Automation in Construction,2019,104:129-139. [11]CHAY J,CHOI W,BUYUKOZTURK O.Deep learning-based crack damage detection using convolution neural networks[J].Computet-Aided Civil and Infrastructure Engineering,2017(8):1-18. [12]瞿中,謝釔.基于全U網絡的混凝土路面裂縫檢測算法[J].計算機科學,2021,48(4):187-191. [13]常惠,饒志強,趙玉林,等.基于改進U-Net網絡的隧道裂縫分割算法研究[J].計算機工程與應用,2021,57(22):215-222. [14]曹錦綱,楊國田,楊錫運.基于注意力機制的深度學習路面裂縫檢測[J].計算機輔助設計與圖形學學報,2020,32(8):1324-1333. [15]FAN Z,LI C,CHEN Y,et al.Automatic crack detection on road pavements using encoder-decoder architecture[J].Materials,2020,13(13):2960-2982. [16]張林,張雪利,路霖,等.基于殘差U-Net網絡的染色體圖像分割方法[J].重慶郵電大學學報(自然科學版),2022,34(2):208-215. [17]HE K,ZHANG X,REN S,et al.Spatial pyramid pooling in deep convolutional networks for visual recognition[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(9):1904-1916. [18]許征波,楊煜俊.基于多任務深度學習的快速人像自動摳圖[J].武漢大學學報(工學版),2020,53(8):740-745. [19]CHEN L C,PAPANDREOU G,KOKKINOS I,et al.Deeplab:semantic image segmentation with deep convolutional nets,atrous convolution,and fully connected CRFs[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2018,40(4):834-848. [20]WOO S,PARK J,LEE J Y,et al.CBAM:convolutional block attention module[C]∥ECCV,2018:3-19. [21]MILLETARI F,NAVAB N,AHMADI S A.V-Net:fully convolutional neural networks for volumetric medical image segmentation[C] ∥2016 Fourth International Conference on 3D Vision (3DV).IEEE,2016:565-571. [22]ZHAO H,SHI J,QI X,et al.Pyramid scene parsing network[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2017:2881-2890. (編輯:鄭 毅)