虛擬試穿能量法空間注意力編碼算法

孟義智,楊大偉,毛 琳

(大連民族大學 機電工程學院,遼寧 大連 116650)

虛擬試穿包含服飾試穿和人物姿態(tài)合成兩個方面的功能。主要工作是在模特人物更換試穿衣服的過程中,將待更換的服飾和人體部件從圖片中分割出來經(jīng)編碼,融合到目標模特的指定姿態(tài)上,形成試穿效果。

在虛擬試穿研究中,引入注意力的目的是提高服裝的分割精度和服飾遷移后的呈現(xiàn)效果,進一步提高虛擬試穿的可視化主觀評價感受。

現(xiàn)有基于深度學習的注意力網(wǎng)絡,對于通道注意力來說典型模型為SENet(Squeeze-and-Excitation Networks)[1],通過壓縮-激勵過程,對通道角度下的特征進行權重賦值,實現(xiàn)去除通道中冗余信息的目的;空間注意力代表為STN(Spatial Transformer Networks)[2],將源域圖像特征經(jīng)過隨機變換映射到另一個中間域,而后返回到當前域空間,在轉換過程中,實現(xiàn)空間特征的仿射不變性獲取;還有一種注意力網(wǎng)絡就是混合注意力網(wǎng)絡,其代表模型是CBAM(Convolutional Block Attention Module)[3],融合了通道和空間兩種注意力機制,來進一步提高特征的有效利用。

虛擬試穿研究與這些注意力網(wǎng)絡結合來提高服飾生成和遷移的可視化效果。王琴[4]等人,以苗族服裝數(shù)據(jù)集為研究對象,將CBAM混合注意力網(wǎng)絡,嵌入到全卷積神經(jīng)網(wǎng)絡(Fully Convolutional Networks,FCN)中,實現(xiàn)了局部特征和全局特征的交互共享;覃琴[5]等人在密集連接網(wǎng)絡上對服裝數(shù)據(jù)集進行了空間多尺度特征的融合,能夠實現(xiàn)自動地分割苗族衣服上的服裝信息;趙海英[6]等為了解決傳統(tǒng)服裝上的細小花紋邊緣提取不清晰的問題,在特征提取階段引入卷積注意力特征(Convolution Attention Feature,CAF)網(wǎng)絡,提高系統(tǒng)對花紋樣式等紋理的關注程度。以傳統(tǒng)非機器學習方法,利用空間上的能量法來對視覺目標的顯著能量進行快速有效地獲取,有效地解決目標的預分割處理問題[7]。

本文針對服飾試穿領域中,將分割作為生成器編碼的需求,為深度學習的分割網(wǎng)絡提供更好的預處理空間注意力。提出一種適用于虛擬試穿應用場景的能量法空間注意力網(wǎng)絡(Spatial Attention Feature extraction algorithm based on Energy approach for visual try-on,SAFE),利用空間各軸向上的像素位置統(tǒng)計信息,實現(xiàn)分割掩模模板的位置精準匹配問題,從而提高分割輸出的編碼質量。

1 問題分析

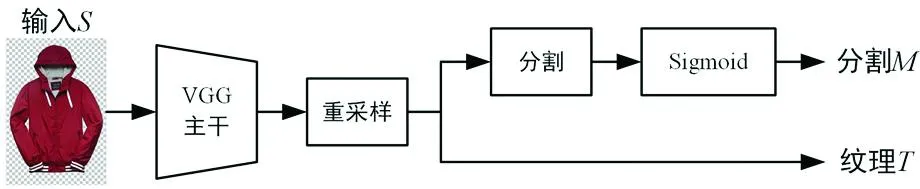

在虛擬試穿分割特征編碼部分,以文獻[8]中提及的Dior(Dressing in order network)網(wǎng)絡為例。Dior網(wǎng)絡采用輕量級分割特征編碼結構,采用一個精減的2層VGG卷積網(wǎng)絡作為主干,對服裝輸入S經(jīng)重采樣變換,分別得到特征紋理T和分割M兩路輸出,為后續(xù)模特試穿生成提供編碼基礎。Dior網(wǎng)絡中,分割編碼模塊的具體結構示意圖如圖1。其中,分割支路與紋理支路內(nèi)容特征的輸入,均來自于重采樣后的輸出結果,且分割處理模塊為3個3×3卷積。

圖1 Dior分割編碼結構示意圖

在這種輕量級分割特征編碼網(wǎng)絡里,屬于淺層信息處理范疇。特別是在分割M支路中,分割模塊原本是對全部輸入特征進行分割處理,如果能夠加入注意力機制,則可以有針對性地對特定區(qū)域著重分割,從而提高分割輸出的精度。

2 SAFE算法設計

2.1 算法設計

為提高分割編碼質量,SAFE采用預分割處理方式來提高空間位置上的特征表達能力,以傳統(tǒng)非機器學習的能量法顯著目標區(qū)域檢測思路[7]。

獲取顯著目標區(qū)域位置信息的原理如圖2。假設給定一幅圖片,其高度和寬度尺寸為(m,n)像素,則X軸和Y軸的能量就是按列或行的方向,對像素值大小的累加和結果。X=[x1,x2,……,xn]∈R,Y=[y1,y2,……,yn]∈R,且滿足如下條件:

圖2 能量法顯著目標區(qū)域檢測原理示意圖(各軸上能量區(qū)域重疊的部分,即為顯著區(qū)域)

(1)

(2)

其中,P(xi,yj)為圖片像素幅值大小,在計算任意軸某元素能量時,圖像應經(jīng)歸一化處理,使像素幅值大小的范圍在[0,1]之間。

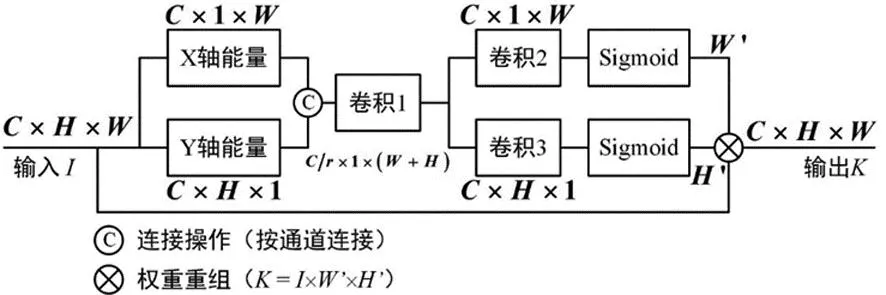

從圖2中可得,顯著區(qū)域實際是由軸和軸的能量重疊區(qū)域所構成。該顯著區(qū)域[9][(visual saliency)將可作為后續(xù)分割的預處理過程,提高分割的位置敏感性需求。為配合深度學習網(wǎng)絡的設計,本文借鑒位置注意力深度學習網(wǎng)絡CA(Coordinate Attention)[10]的設計思想,為虛擬試穿的分割模塊,提供顯著目標的位置注意力機制。能量法顯著目標注意力結構如圖3。

圖3 能量法顯著目標注意力結構(r = 16)

圖4 整體網(wǎng)絡結構

圖3中,輸入I為輸入圖像或輸入特征圖,其中,C為通道,H為特征圖高度,對應于能量法顯著目標區(qū)域檢測的Y軸方向能量計算,W為特征圖寬度,對應于X軸方向能量。遵循能量法顯著目標區(qū)域檢測思路,設定如下步驟來構建深度學習網(wǎng)絡,從而實現(xiàn)一個神經(jīng)網(wǎng)絡下的能量法顯著目標空間注意力機制。

步驟1:能量計算。各軸上的能量,為輸入特征圖I的歸一化后單個像素點(或特征空間點)的幅值大小累加和,為保證深度學習后續(xù)的梯度等計算要求,對累加和做求平均操作。即,能量計算從公式(1)和公式(2)變?yōu)榍笃骄僮鳌?/p>

(3)

(4)

步驟2:通道縮減。通道縮減是去除多個通道中的冗余信息,而通道縮減操作在注意力機制中,相當于要解決給定深度學習網(wǎng)絡要關注何種特征信息。設定通道縮減的衰減系數(shù)為常數(shù)值r。該操作由圖3中的卷積1操作完成。

步驟3:通道恢復。經(jīng)圖3中的卷積2和卷積3來實現(xiàn)通道恢復,并完成各個軸方向上的能量計算。

步驟4:權重重組。圖3中的權重重組操作,是對輸入特征圖I的注意力操作。

K=I×(W′×H′) 。

(5)

式中:I為特征圖;W'為X軸的能量計算結果;H'為Y軸的能量計算結果。K為能量法顯著目標區(qū)域對輸入特征圖I的注意力結果。

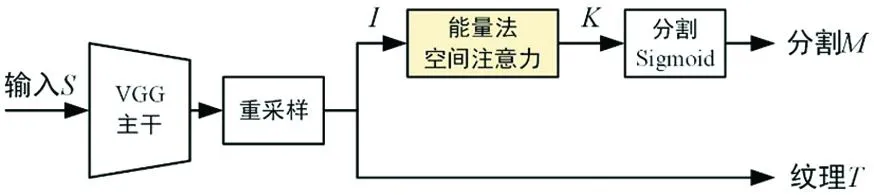

2.2 整體網(wǎng)絡結構

將本文所提的SAFE算法植入Dior網(wǎng)絡[8],置于特征圖分割支路,輸入來自于VGG主干網(wǎng)絡[11]經(jīng)重采樣的輸出結果,輸出送至分割、Sigmoid激活網(wǎng)絡,形成分割結果M。

3 仿真分析

3.1 仿真參數(shù)

SAFE算法網(wǎng)絡采用流行的服飾數(shù)據(jù)集DeepFashion[12],訓練集與測試集分開。其中,圖片尺寸均為,這里256為圖片高度,176為圖片寬度。訓練集有48 674張照片,大約占用9 GB存儲容量。測試集有4 038張照片,大約占用700 MB存儲容量。

整個網(wǎng)絡迭代30萬次,優(yōu)化器采用Adam梯度下降算法,初始的學習率為,一般來說,學習率最終會下降到。

仿真環(huán)境,采用Ubuntu 18.04操作系統(tǒng),單張NVIDIA 1070Ti顯卡(8G顯存),BatchSize=2。

3.2 評價指標

依照虛擬試穿網(wǎng)絡魔性的主流評測手段,本文SAFE算法從結構相似度SSIM[13]、分布相似度FID[14]以及感知相似度LPIPS[15]等三個角度去衡量生成結果與真實參考圖片之間的關聯(lián)性。

SSIM評價公式為

(6)

式中:x和y分別表示真實圖片和生成圖片;μ為圖片像素值的平均值;σ為圖片像素值的標準差;C1、C2為常數(shù)。

FID評價指標公式為

(7)

式中:x和y分別表示真實圖片和生成圖片;Tr為矩陣的跡;μ表示均值;σ表示方差。

LPIPS評價公式為

(8)

式中:x和x0分別為真實圖片和生成圖片的局部分塊;l是當前卷積層的序號;y和y0對應于x和x0經(jīng)過l層卷積后的結果;H和W是當前第l層特征圖的高度和寬度;ωl是通道激活系數(shù);⊙表示按通道方向的相乘。

3.3 消融實驗

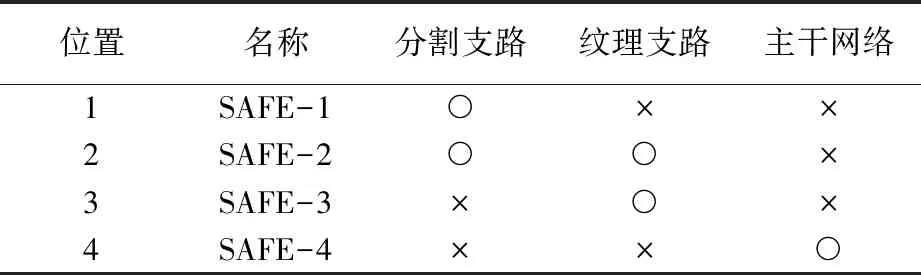

SAFE算法的設計是基于能量法的空間注意力,對分割處理關注空間信息的深度學習處理模塊來說,具有良好的處理作用。為檢驗空間注意力對系統(tǒng)各模塊的影響,設計4組消融實驗來提供佐證見表1。表1中的序號表示SAFE要加入網(wǎng)絡的位置,這里規(guī)定,每次只有1個位置插入SAFE算法模塊,保證對比實驗的結果具有可分析性。其中,位置1對應于分割支路,位置2對應于分割和紋理支路同時應用SAFE算法,位置3是僅對紋理支路進行空間注意力計算,位置4則是在主干網(wǎng)絡VGG之后。SAFE消融實驗設計示意圖如圖5。4個不同位置加入SAFE算法的消融實驗對比圖如圖6。

表1 SAFE消融實驗設計一覽表

圖5 SAFE消融實驗設計示意圖

圖6 4個不同位置加入SAFE算法的消融實驗對比

圖6中,輸入為模特圖片,根據(jù)由OpenPose[8, 12]生成的18點姿態(tài)參考骨架點為參考,合成出新的人物姿態(tài)試穿效果圖片。根據(jù)消融實驗對比發(fā)現(xiàn),從圖片1和圖片3可以看出,在圖2的位置1加入SAFE算法,相比于其他三個位置來說,模特姿態(tài)及服飾變形的還原程度最好。從圖片4和圖片2中可以看出,位置1的模特人物面部表情相對較好,與原始輸入圖片的外觀樣貌更加相近。

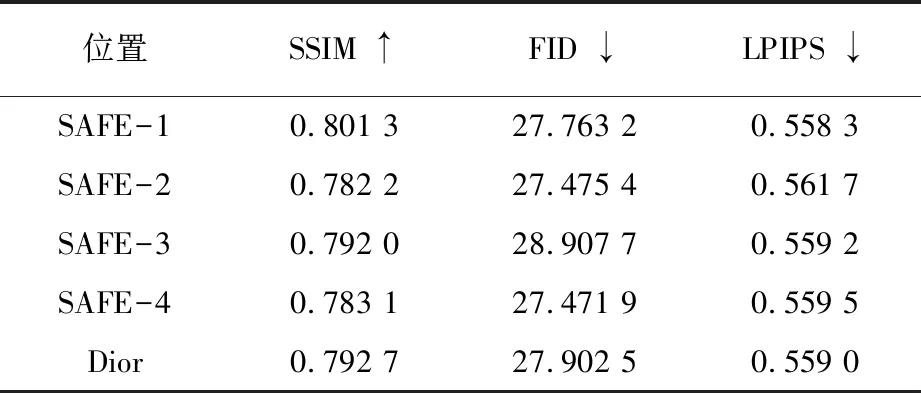

四個位置的消融實驗對結果的影響見表2。顯而易見,SAFE-1的位置1上的效果相對更好。也同時跟原有算法比較得到了一定的提高,其中SSIM提高1.08%,FID提高0.5%,LPIPS提高0.2%。

表2 不同位置的消融實驗對比結果

SAFE算法虛擬試穿的效果圖如圖7。從圖中看出來兩組實驗仿真結果,任務模特的變換效果雖然整體遷移較為成功,但是,人物臉部和衣服局部細節(jié)仍舊存在變形問題。這也是后續(xù)科研課題中要解決的主要問題之一。

圖7 SAFE算法虛擬試穿效果

4 結 語

采用深度學習的方式,還原了一種非學習的能量法空間位置注意力機制—SAFE算法網(wǎng)絡。將其應用在主流虛擬試穿網(wǎng)絡的分割編碼前端,為分割模塊提供有效的空間注意力信息。其結果不僅從參數(shù)的數(shù)值精度上有所提高,更從可視化角度上明顯感受到空間注意力對分割編碼的影響。這樣的嘗試,更為今后在服飾生成網(wǎng)絡的應用中,提供研究基礎。分割編碼需要更加精細的空間注意力,補償模特人物前后姿態(tài)變化和服飾變化的空間變形缺損,進一步加強分割的實現(xiàn)效果,提高整體的虛擬試穿指標精度。