基于深度Q網(wǎng)絡(luò)的云演藝延遲敏感業(yè)務(wù)QoE優(yōu)化

李宛青,李樹鋒,劉健章,胡峰

(中國傳媒大學(xué)信息與通信工程學(xué)院,北京 100024)

1 引言

隨著互聯(lián)網(wǎng)的普及,多種多樣的業(yè)務(wù)應(yīng)用不斷涌現(xiàn),超高清視頻流、云計算、物聯(lián)網(wǎng)等領(lǐng)域的快速增長給網(wǎng)絡(luò)資源的高效分配提出了新的挑戰(zhàn)[1]。隨著信息技術(shù)的不斷發(fā)展和普及,云計算作為一種高效、靈活的計算模式逐漸滲透到了各行各業(yè)。其中,云演藝作為云計算的一個重要應(yīng)用領(lǐng)域之一,為用戶提供了多樣化、便捷的娛樂體驗[2]。然而,云演藝服務(wù)中延遲敏感業(yè)務(wù)的體驗質(zhì)量(Quality of Experience,QoE)受到了延遲問題的嚴(yán)重影響。演藝延遲敏感業(yè)務(wù)是指需要低延遲、高實時性的音視頻傳輸和交互式應(yīng)用,如在線直播、視頻會議、互動游戲等,高延遲會導(dǎo)致視頻卡頓、聲音不同步等問題,從而影響用戶觀看體驗[3]。當(dāng)前,盡管云計算技術(shù)已經(jīng)取得了長足的發(fā)展,但在云演藝延遲敏感業(yè)務(wù)的QoE優(yōu)化方面仍存在著挑戰(zhàn)。傳統(tǒng)的網(wǎng)絡(luò)優(yōu)化方法往往難以有效地適應(yīng)云演藝業(yè)務(wù)的特點,特別是在延遲敏感和大規(guī)模用戶同時訪問的情況下。因此,尋找一種更加有效、智能的優(yōu)化方法來改善云演藝延遲敏感業(yè)務(wù)的QoE,是當(dāng)前云計算領(lǐng)域急需解決的問題之一[4]。本文重點關(guān)注以塊(block)形式發(fā)送數(shù)據(jù)的延遲敏感應(yīng)用程序。

神經(jīng)網(wǎng)絡(luò)(Neural Network,NN)由大量人工神經(jīng)元組成,能夠接受來自外部環(huán)境或數(shù)據(jù)源的輸入信息,通過前向傳播和反向傳播過程進(jìn)行訓(xùn)練。Q學(xué)習(xí)算法(QLearning)迭代更新Q值函數(shù),通過估計在每個狀態(tài)下采取每個動作的長期回報值,最終獲得最優(yōu)策略。在多業(yè)務(wù)資源調(diào)度研究領(lǐng)域,將神經(jīng)網(wǎng)絡(luò)與Q學(xué)習(xí)算法相結(jié)合受到了廣泛關(guān)注。Chmieliauskas等[5]提出了一種基于深度強(qiáng)化學(xué)習(xí)與Q-Learning的蜂窩網(wǎng)資源分配算法,以最大限度實現(xiàn)有限頻譜資源的合理利用。他們的研究旨在通過智能資源分配來降低延遲和提高用戶體驗。實驗結(jié)果顯示,他們的算法與其他算法相比收斂速度有所提高,并在傳輸速率與優(yōu)化能耗方面有明顯改進(jìn),有效解決在多目標(biāo)條件下的資源調(diào)度問題。因此,本文將神經(jīng)網(wǎng)絡(luò)作為Q學(xué)習(xí)的函數(shù)逼近器,實現(xiàn)了在復(fù)雜環(huán)境中學(xué)習(xí)并優(yōu)化多業(yè)務(wù)資源塊分配策略。

深度Q網(wǎng)絡(luò)(Deep Q-Network,DQN)是深度強(qiáng)化學(xué)習(xí)(Deep Reinforcement Learning,DRL)中的一種重要方法,已在眾多領(lǐng)域取得了顯著成果,包括圖像處理、自動駕駛、游戲和自然語言處理。Burhanuddin等[6]在無人機(jī)到無人機(jī)場景下探索了一種基于Actor-Critic(AC)與DQN的DRL算法,并通過仿真驗證此算法在QoE方面優(yōu)于Greedy算法,最終實現(xiàn)了穩(wěn)定的視頻傳輸與長期優(yōu)化。

深度Q 網(wǎng)絡(luò)結(jié)合了神經(jīng)網(wǎng)絡(luò)和Q-Learning 算法,具有自適應(yīng)性和智能性,能夠根據(jù)不同業(yè)務(wù)的需求進(jìn)行資源分配決策[7]。此方法在資源分配問題中具有廣泛的應(yīng)用潛力,特別是在延遲敏感業(yè)務(wù)領(lǐng)域[8-10]。

針對以上問題,本文旨在基于DQN 等深度強(qiáng)化學(xué)習(xí)技術(shù),探索并提出一種針對云演藝延遲敏感業(yè)務(wù)資源調(diào)度算法,使得模型能夠自適應(yīng)地根據(jù)不同業(yè)務(wù)需求進(jìn)行資源分配,提高資源利用率和用戶體驗。另外,本文提出了一種在深度強(qiáng)化學(xué)習(xí)中將神經(jīng)網(wǎng)絡(luò)用于近似Q值函數(shù)的方法,利用神經(jīng)網(wǎng)絡(luò)架構(gòu)和資源估計技術(shù),從實時網(wǎng)絡(luò)信息中學(xué)習(xí)并動態(tài)調(diào)整資源的調(diào)度。這一算法在資源分配決策上具有靈活性和智能性,能夠為不同類型的業(yè)務(wù)提供優(yōu)化的服務(wù)。仿真結(jié)果表明,與Reno 算法、Actor-Critic 算法相比,本文所提算法可以有效提高用戶體驗質(zhì)量。

2 資源調(diào)度環(huán)境架構(gòu)

2.1 典型環(huán)境架構(gòu)

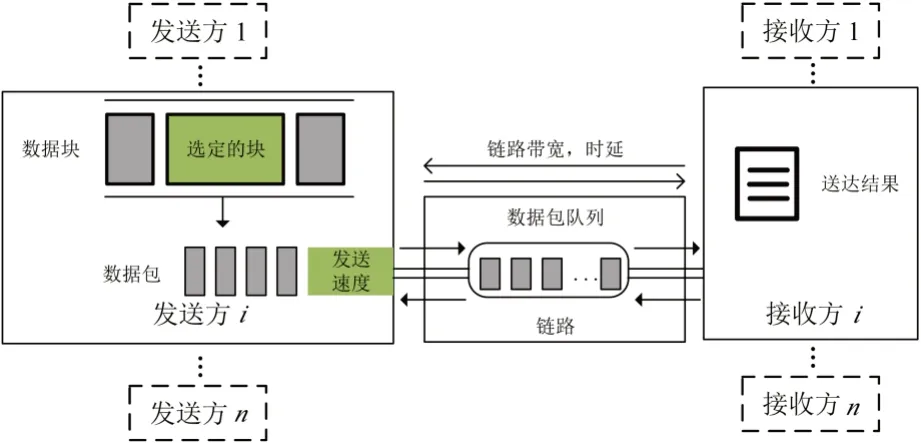

圖1展示了多業(yè)務(wù)資源調(diào)度場景下的典型環(huán)境架構(gòu),其中有數(shù)個發(fā)送方和接收方共享一個鏈接。根據(jù)不同應(yīng)用程序數(shù)據(jù)集生成數(shù)據(jù)塊,經(jīng)過塊調(diào)度模塊與帶寬估計模塊進(jìn)行調(diào)度后,以數(shù)據(jù)包的形式離開發(fā)送方進(jìn)入鏈路。在這一過程中,鏈路的總可用帶寬、最小延遲均根據(jù)網(wǎng)絡(luò)跟蹤做出相應(yīng)變化。如果數(shù)據(jù)到達(dá)時刻的速率超過帶寬,等待被發(fā)送的數(shù)據(jù)包將被臨時儲存在隊尾的先入先出(First Input First Output,F(xiàn)IFO)隊列中。當(dāng)最后一個數(shù)據(jù)包到達(dá)接收方時,就可以計算這一業(yè)務(wù)塊的完成時間,最終將其在模擬器內(nèi)用于QoE 計算。

圖1 多業(yè)務(wù)資源調(diào)度場景典型環(huán)境架構(gòu)

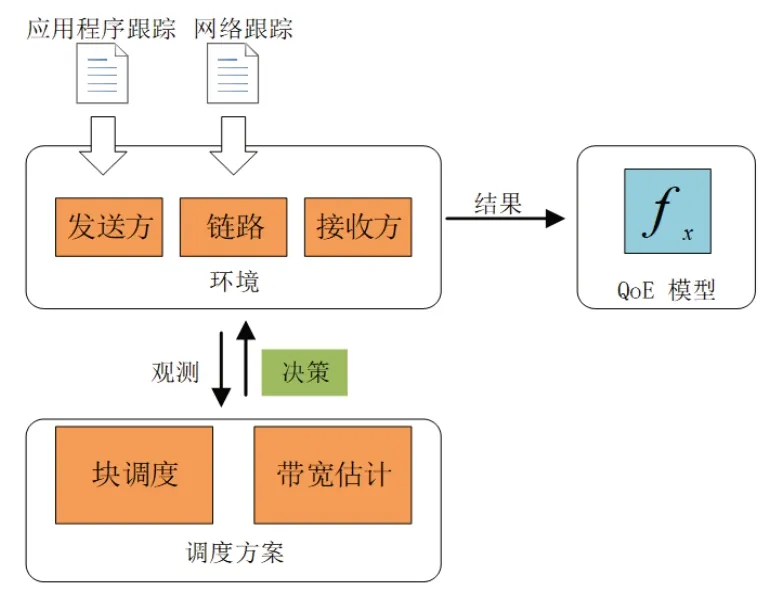

為了保證實驗環(huán)境支持?jǐn)?shù)據(jù)塊形式傳輸,并為數(shù)據(jù)塊增添有效傳輸時限,本文使用ACM 2021 Multimedia Grand Challenge 開源模擬器,數(shù)據(jù)塊遞送模擬器架構(gòu)如圖2 所示,其中主要包括三部分:調(diào)度方案、環(huán)境、QoE模型。結(jié)合圖1,在模擬之前根據(jù)環(huán)境設(shè)置多個發(fā)送方與接收方,二者經(jīng)過鏈路進(jìn)行數(shù)據(jù)的傳遞。每個發(fā)送方在每條鏈路中模擬一個應(yīng)用程序跟蹤列表,每條鏈路中基于不同的網(wǎng)絡(luò)跟蹤進(jìn)行相應(yīng)的模擬,其中應(yīng)用程序跟蹤用于模擬應(yīng)用程序的數(shù)據(jù)模式,網(wǎng)絡(luò)跟蹤用于模擬當(dāng)前網(wǎng)絡(luò)條件。

圖2 數(shù)據(jù)塊遞送模擬器架構(gòu)

2.2 QoE模型

在網(wǎng)絡(luò)通信或數(shù)據(jù)傳輸領(lǐng)域,QoE通常用于評估用戶對于服務(wù)、應(yīng)用或內(nèi)容的整體體驗和滿意度。多媒體應(yīng)用QoE通常會由于所選方法的不同發(fā)生顯著的變化,當(dāng)數(shù)據(jù)塊及時到達(dá)時,用戶感知的質(zhì)量通常得到改善。本文在基于數(shù)據(jù)塊的優(yōu)先級對QoE進(jìn)行計算的基礎(chǔ)上,考慮了數(shù)據(jù)塊的緊急程度,將QoE建模為式(1):

其中x為用于平衡優(yōu)先級和緊急程度的權(quán)重參數(shù),默認(rèn)值為0.9。priorities是每個數(shù)據(jù)塊的優(yōu)先級和權(quán)重列表,urgency表示數(shù)據(jù)塊的緊急程度。通過調(diào)整x的值,可以加強(qiáng)或減弱優(yōu)先級和緊急程度對QoE的影響。

3 資源調(diào)度算法

3.1 擁塞控制算法

3.1.1 Reno算法

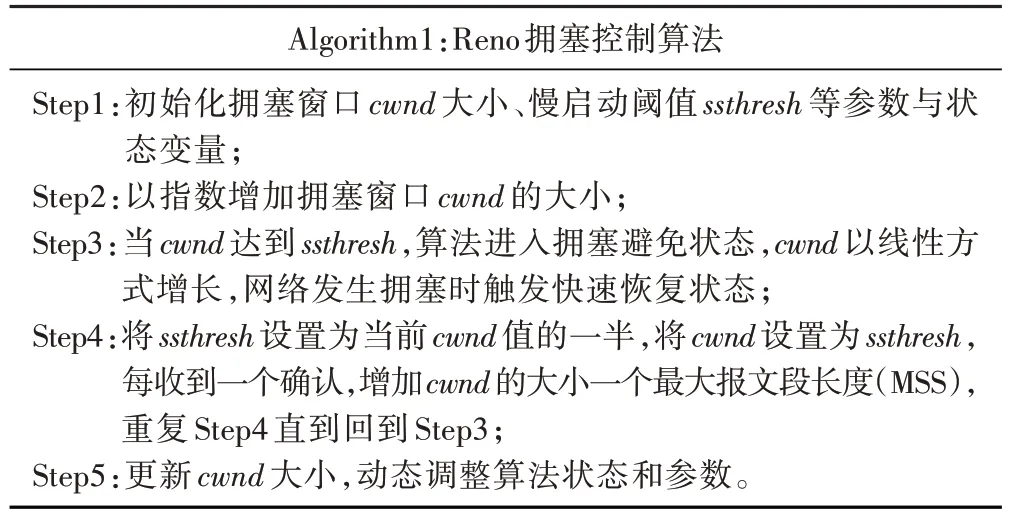

擁塞控制算法Reno 是一種用于傳輸控制協(xié)議(Transmission Control Protocol,TCP)的算法,用于控制數(shù)據(jù)包在網(wǎng)絡(luò)中傳輸?shù)乃俾省eno 算法基于擁塞避免和快速恢復(fù)的概念,通過動態(tài)調(diào)整發(fā)送數(shù)據(jù)包的數(shù)量來維持網(wǎng)絡(luò)的穩(wěn)定性[11]。

該算法主要包括三種狀態(tài):慢啟動(Slow Start)、擁塞避免(Congestion Avoidance)和快速恢復(fù)(Fast Recovery)。在慢啟動階段,擁塞窗口(cwnd)設(shè)為初始值,并以指數(shù)增長的方式逐漸增加,直到達(dá)到慢啟動閾值(ssthresh),ssthresh與cwnd計算如式(2):

其中ACK為標(biāo)志位,用來確認(rèn)序號有效。對ssthresh進(jìn)行減半處理,ssthresh與cwnd的表達(dá)式如式(3)、式(4):

其中α作為調(diào)節(jié)參數(shù),取0.5。如果發(fā)生丟包,算法會進(jìn)入快速恢復(fù)狀態(tài),然后根據(jù)情況調(diào)整閾值和cwnd,最終恢復(fù)到擁塞避免狀態(tài)。算法過程描述如表1:

表1 Reno擁塞控制算法過程描述

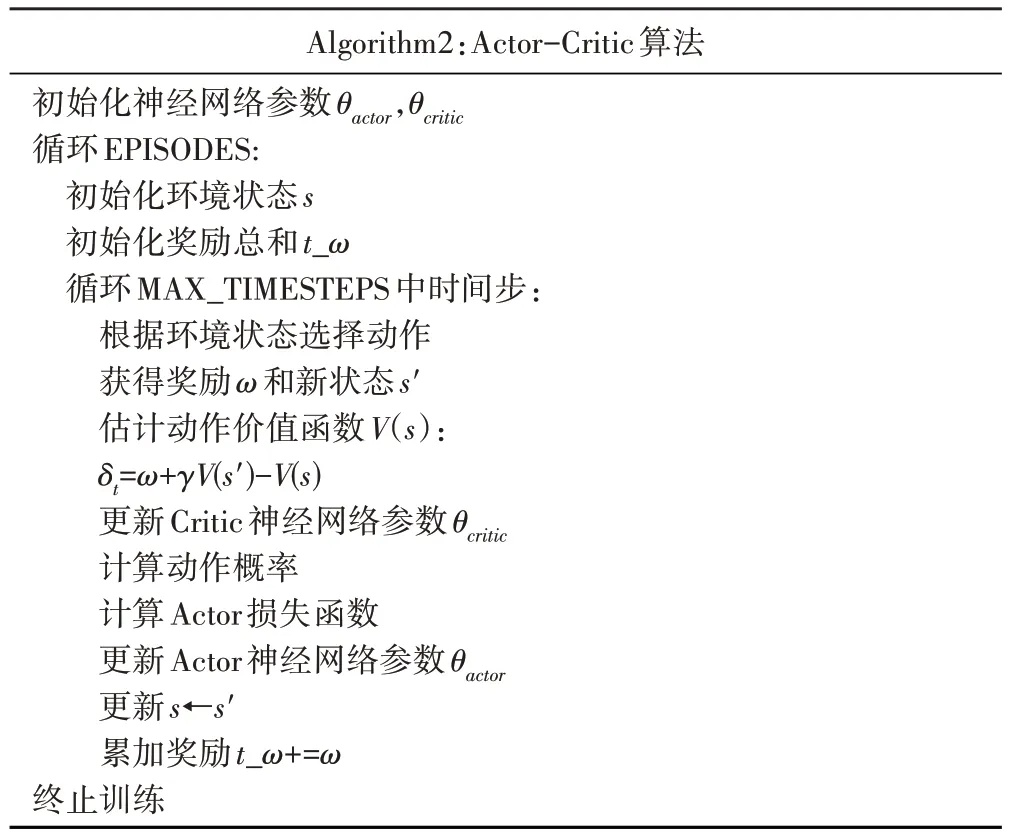

3.1.2 Actor-Critic算法

Actor-Critic的架構(gòu)包括兩個部分:

·策略網(wǎng)絡(luò)Actor:觀察網(wǎng)絡(luò)狀態(tài),結(jié)合數(shù)據(jù)傳輸速率、丟包情況等輸出選擇動作,包括增加、保持、減少發(fā)送速率;

·評論網(wǎng)絡(luò)Critic:評估Actor 網(wǎng)絡(luò)選擇動作的價值,指導(dǎo)Actor網(wǎng)絡(luò)更新策略,以獲得更好的決策[12]。

偽代碼如表2:

表2 Actor-Critic算法偽代碼

3.2 資源調(diào)度算法

Reno算法作為TCP協(xié)議中的一種經(jīng)典算法,基于擁塞窗口大小的動態(tài)調(diào)整來控制網(wǎng)絡(luò)的擁塞狀態(tài)。其主要缺陷之一是在高延遲網(wǎng)絡(luò)中表現(xiàn)不佳,并且在面對長距離或高帶寬延遲積(Bandwidth-Delay Product,BDP)的網(wǎng)絡(luò)時容易出現(xiàn)性能下降。

這種性能下降部分源于Reno 算法在擁塞控制中對丟包的處理。當(dāng)出現(xiàn)丟包時,Reno算法采用指數(shù)退避的策略,即將擁塞窗口減半,并采用線性增長的方式重新開始。然而,對于高延遲網(wǎng)絡(luò)來說,丟包往往被視為網(wǎng)絡(luò)擁塞的信號,這導(dǎo)致了Reno 算法過于保守的行為,因此未能充分利用網(wǎng)絡(luò)帶寬。

為了克服這些缺陷,本文研究了一種基于強(qiáng)化學(xué)習(xí)的動態(tài)擁塞控制方法。該方法利用神經(jīng)網(wǎng)絡(luò)和Q學(xué)習(xí)來自適應(yīng)地調(diào)整發(fā)送速率,不僅能更好地適應(yīng)網(wǎng)絡(luò)狀況的變化,還能在一定程度上減少對丟包的過度敏感。算法過程描述如表3:

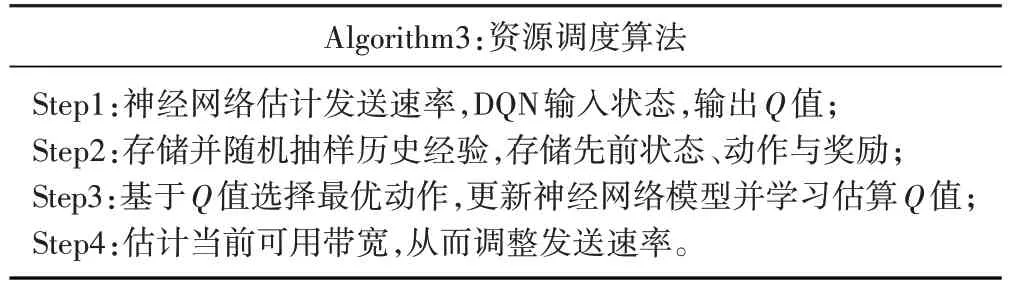

表3 資源調(diào)度算法過程描述

DQN是基于深度學(xué)習(xí)的Q-learning算法,將深度神經(jīng)網(wǎng)絡(luò)技術(shù)與價值函數(shù)相結(jié)合,采用經(jīng)歷回放、目標(biāo)網(wǎng)絡(luò)的方法進(jìn)行網(wǎng)絡(luò)訓(xùn)練。Q-function函數(shù)可用式(5)描述:

其中st為當(dāng)前時間片的狀態(tài),ɑt為采取的行為,rt為獎勵,st+1為新的狀態(tài),Eπ表示以策略π進(jìn)行動作。Q-function函數(shù)的最優(yōu)值函數(shù)為式(6):

其中為函數(shù)逼近器,α∈(0,1]為學(xué)習(xí)率,γ為折扣因子(衰減系數(shù))。

對于連續(xù)狀態(tài)與動作空間,可以使用NN 來逼近最優(yōu)動作值函數(shù)在參數(shù)為θ時,=Qθ。這時,可以將式(7)所表示的迭代過程視為回歸問題,目標(biāo)是通過上升隨機(jī)梯度,估計NN 的參數(shù)θ。在深度Q 網(wǎng)絡(luò)中,使用值rt+γmaxQθtɑrget更新Qθ,其中Qθtɑrget為目標(biāo)Q-function。對于數(shù)據(jù)[st,ɑt,rt,st+1],Q-function的損失函數(shù)構(gòu)造為均方誤差的形式,可由式(9)表示:

神經(jīng)網(wǎng)絡(luò)與Q-learning 相互結(jié)合,神經(jīng)網(wǎng)絡(luò)用于逼近Q值函數(shù)。智能體通過與環(huán)境互動,收集數(shù)據(jù)并將其用于更新神經(jīng)網(wǎng)絡(luò)的權(quán)重,從而改善Q值函數(shù)的估計。這個過程將神經(jīng)網(wǎng)絡(luò)中的權(quán)重調(diào)整為最大化長期獎勵,從而使算法能夠做出更好的決策。

這種基于強(qiáng)化學(xué)習(xí)的方法通過持續(xù)學(xué)習(xí)和調(diào)整來實現(xiàn)自適應(yīng)的擁塞控制,不僅在網(wǎng)絡(luò)變化頻繁的情況下表現(xiàn)更好,而且對丟包的反應(yīng)更加靈活。相比于Reno 算法,這種方法更能適應(yīng)各種網(wǎng)絡(luò)環(huán)境,提高了網(wǎng)絡(luò)的傳輸效率和性能。

3.3 塊選擇算法

塊選擇算法通過權(quán)衡不同的數(shù)據(jù)塊屬性來決定下一個發(fā)送的數(shù)據(jù)塊。在本文中,每個數(shù)據(jù)塊都包含優(yōu)先級、截止時間等基本屬性。算法首先根據(jù)創(chuàng)建時間確定發(fā)送順序,即先創(chuàng)建的數(shù)據(jù)塊先被發(fā)送;如果多個數(shù)據(jù)塊的創(chuàng)建時間相同,則選擇剩余時間周期與截止交付時間比例更高的數(shù)據(jù)塊作為優(yōu)先發(fā)送對象。若數(shù)據(jù)塊bi的創(chuàng)建時間為Tcreɑtei,截止交付時間為Tdeadlinei,當(dāng)前時間節(jié)點為Tcur,剩余時間周期與截止交付時間比例為Ri,則如式(10):

塊選擇算法的設(shè)計能夠有效管理本文系統(tǒng)中大量待發(fā)送的數(shù)據(jù)塊,根據(jù)時間屬性、剩余時間周期與截止交付時間的比例,對多種屬性進(jìn)行權(quán)衡,決定某一時刻應(yīng)發(fā)送的數(shù)據(jù)塊,從而提高了數(shù)據(jù)傳輸?shù)男屎拖到y(tǒng)的整體性能。

4 仿真結(jié)果分析

仿真中涉及的參數(shù)值如表4所示。

表4 仿真參數(shù)

為了驗證本文提出的資源調(diào)度算法的有效性,本文數(shù)據(jù)集由三部分組成:塊軌跡、背景流量軌跡和網(wǎng)絡(luò)軌跡。每個應(yīng)用場景都包含一個或多個塊軌跡,這些塊軌跡可以與任意網(wǎng)絡(luò)軌跡組合,模擬在特定網(wǎng)絡(luò)條件下使用延遲敏感應(yīng)用程序的過程。

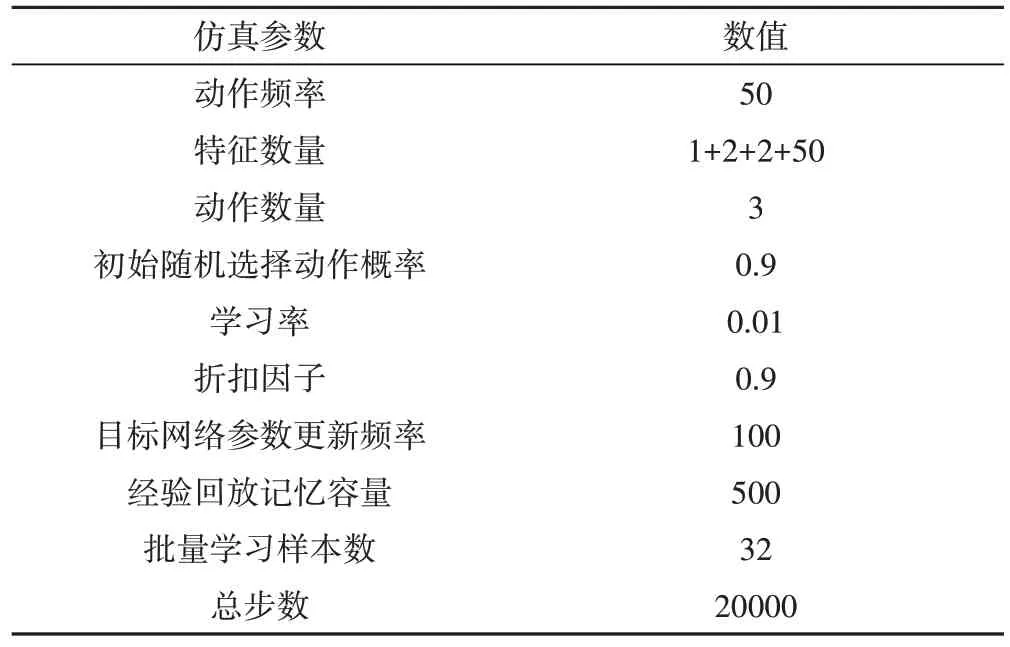

圖3 以云演藝場景中實時通信(Real-Time Communications,RTC)應(yīng)用程序為例,將來自RTC 應(yīng)用程序的流數(shù)據(jù)分為三類:第一類是控制信號,如預(yù)測帶寬、目標(biāo)比特率設(shè)置等,控制信號必須及時到達(dá),才能保證RTC 應(yīng)用服務(wù)的穩(wěn)定運(yùn)行;第二類是音頻,即剔除噪聲后的用戶語音數(shù)據(jù);第三類是攝像機(jī)錄制的視頻。這三種類型的數(shù)據(jù)具有不同的優(yōu)先級。錯過控制信號的交付時間可能會導(dǎo)致QoE的嚴(yán)重下降,因此這些信號具有最高的優(yōu)先級。在大多數(shù)RTC 應(yīng)用程序中,音頻比視頻更重要。

圖3 RTC應(yīng)用框架

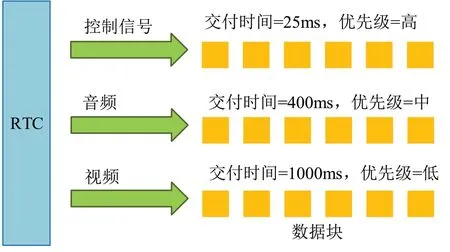

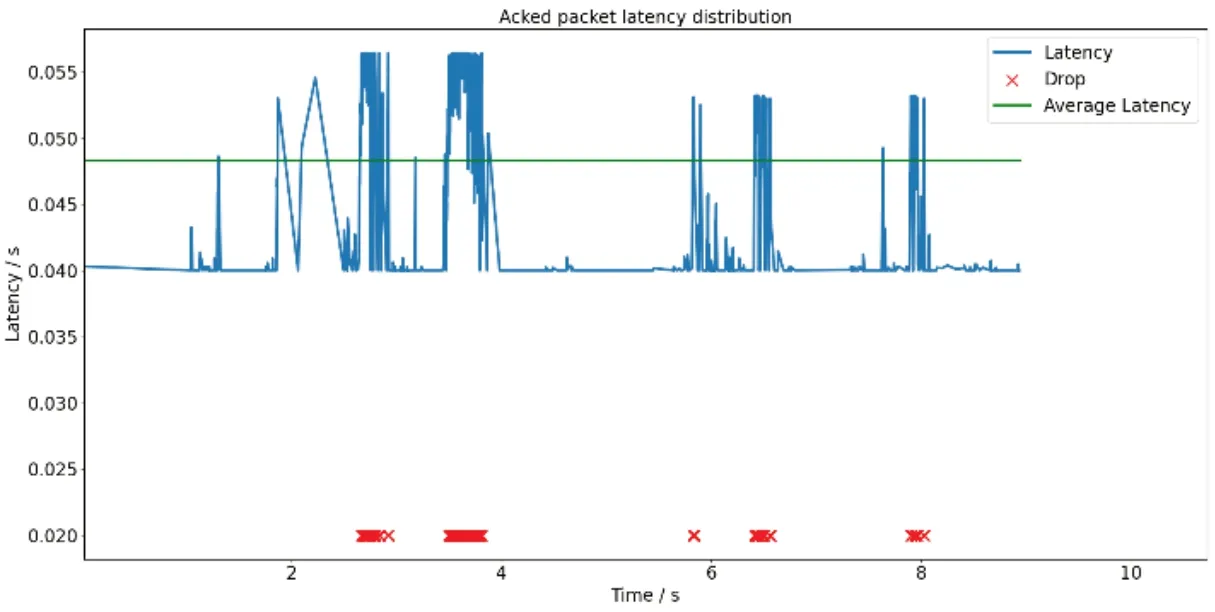

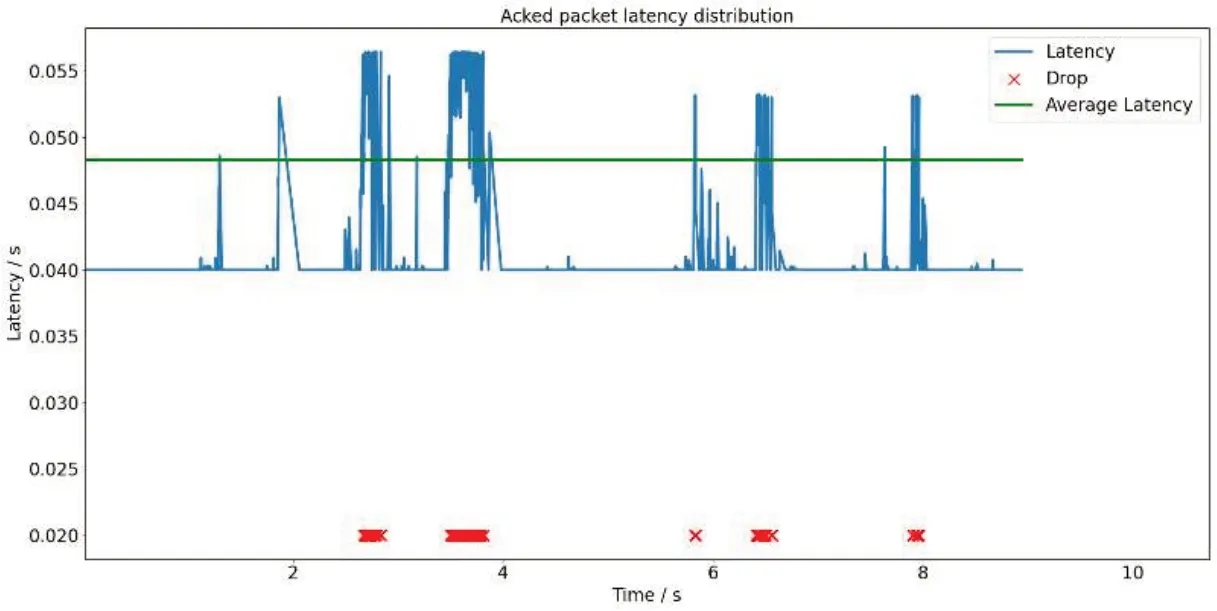

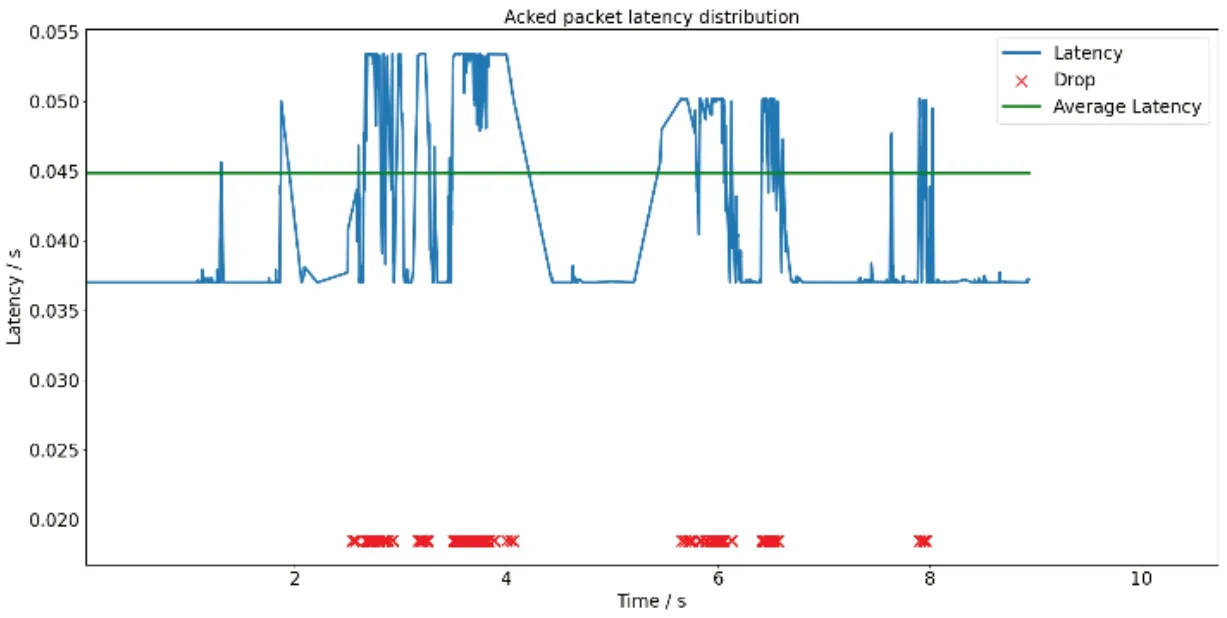

圖4、圖5與圖6分別展示了Reno算法、Actor-Critic算法作為擁塞控制模塊與本文所提算法數(shù)據(jù)包的傳輸時延、平均傳輸時延。本文算法平均傳輸時延(Lavg)為0.044990s,將Reno算法、Actor-Critic算法作為擁塞控制模塊的資源調(diào)度算法時,獲得的平均傳輸時延分別為0.048450s與0.0484375s;本文算法用戶體驗質(zhì)量(Qqoe)達(dá)到了270,將Reno算法作為擁塞控制模塊時的資源調(diào)度算法則為212。在相同的時間段內(nèi),由于本文算法適當(dāng)減少對丟包的過度敏感,因此獲得了更低延遲。

圖4 Reno算法時延

圖5 Actor-Critic算法時延

圖6 本文算法時延

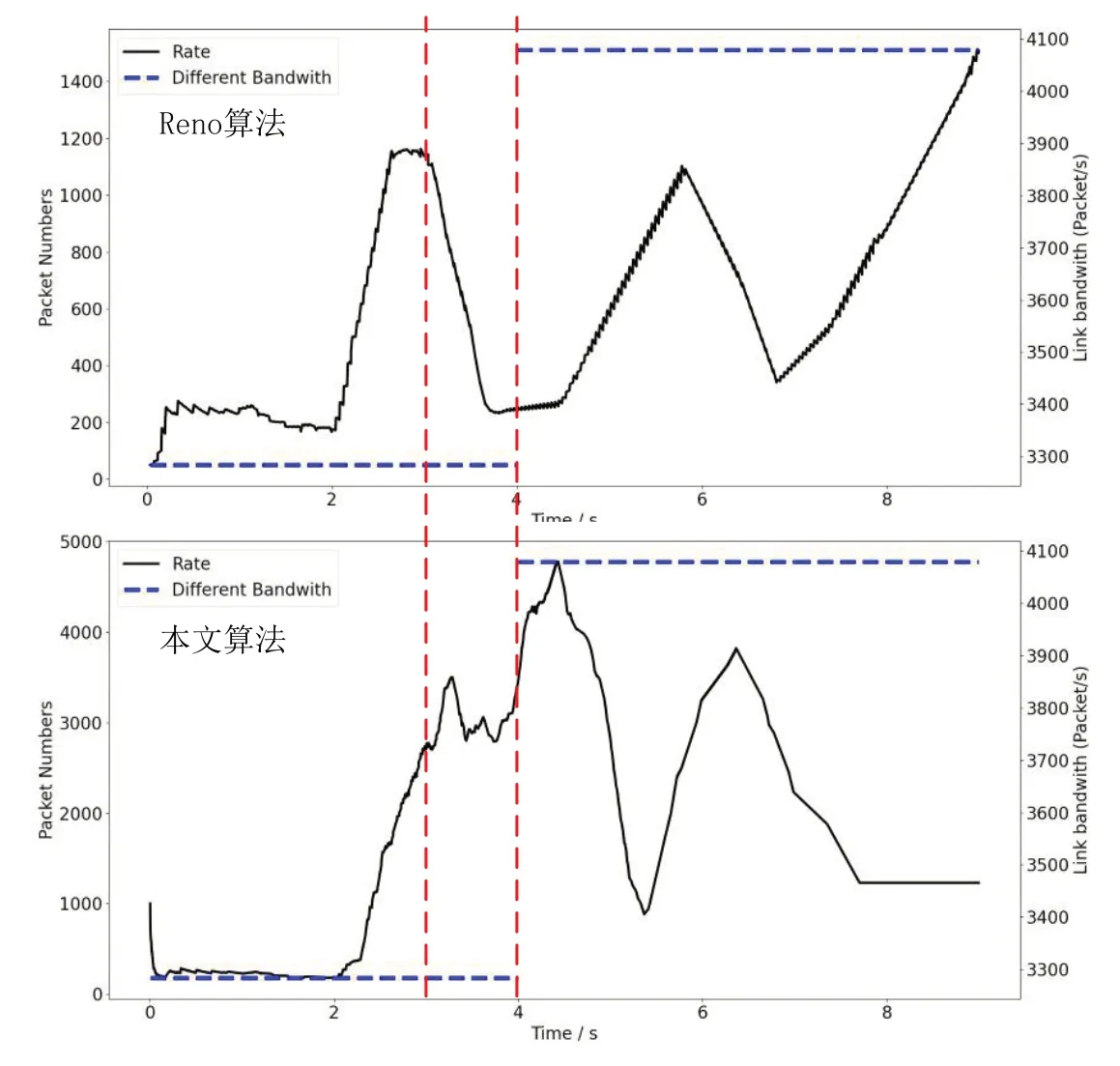

通過圖7,本文展示了Reno 算法與本文算法的窗口更改過程。可以看出,在丟包頻繁的時間內(nèi),Reno 算法的擁塞窗口出現(xiàn)較大波動,并出現(xiàn)了頻繁的波動現(xiàn)象。而本文算法不僅考慮了丟包事件,還綜合考慮了其他網(wǎng)絡(luò)狀態(tài)和特征,在丟包事件發(fā)生時擁塞窗口的改變更加穩(wěn)定,能夠更快地適應(yīng)帶寬的改變,并且能夠更高效地利用網(wǎng)絡(luò)帶寬。

圖7 Reno算法與本文算法擁塞窗口更改過程

5 結(jié)論

本文設(shè)計了一種基于DQN 的延遲敏感業(yè)務(wù)資源調(diào)度算法:首先,本文說明了DQN 用于延遲敏感業(yè)務(wù)的優(yōu)勢,基于強(qiáng)化學(xué)習(xí)對擁塞控制實現(xiàn)自適應(yīng)改變,使得算法有能力進(jìn)行動態(tài)的持續(xù)學(xué)習(xí)。其次,本文對比了在相同的排隊算法條件下,Reno 算法、Actor-Critic 算法與本文所提算法在傳輸不同優(yōu)先級數(shù)據(jù)包的延遲過程,比較了在不同網(wǎng)絡(luò)狀態(tài)下本文算法與Reno算法、Actor-Critic算法窗口更改過程。仿真結(jié)果表明,本文算法在動態(tài)丟包策略與時延上優(yōu)于Reno算法、Actor-Critic 算法,本文算法在網(wǎng)絡(luò)發(fā)生頻繁變化時窗口改變較Reno 算法更穩(wěn)定,最終本文算法用戶體驗質(zhì)量遠(yuǎn)優(yōu)于Reno算法。