基于AL-Transformer 的鐵路客運(yùn)站旅客屬性識(shí)別方法

張 波

(中國鐵路蘭州局集團(tuán)有限公司 客運(yùn)部,蘭州 730030)

隨著我國鐵路建設(shè)的快速發(fā)展和高速鐵路(簡(jiǎn)稱:高鐵)線網(wǎng)的不斷完善,高鐵已逐漸成為人們的首選出行方式。為保障旅客的候車安全,提升旅客出行體驗(yàn),鐵路客運(yùn)站內(nèi)普遍通過工作人員實(shí)時(shí)觀察旅客候車情況,盡可能地提高旅客候車舒適度。然而,鐵路客運(yùn)站面臨著日益增長的客流量和復(fù)雜的站場(chǎng)形式,人工觀察的方式大多是事后的補(bǔ)救措施,無法主動(dòng)提升候車服務(wù)質(zhì)量。

因此,有必要在旅客進(jìn)入候車室時(shí)就自動(dòng)識(shí)別到其屬性信息(年齡范圍、性別、帽子、眼鏡、衣著、乘坐輪椅、攜帶物等),從而為其主動(dòng)提供精準(zhǔn)服務(wù);增加異常行為報(bào)警的詳細(xì)描述信息,輔助工作人員快速、準(zhǔn)確鎖定異常行為人員等,從而更好地保障旅客候車安全。

行人屬性識(shí)別技術(shù)是為攝像頭捕捉的行人圖片監(jiān)測(cè)其屬性類別的技術(shù)[1]。早期的行人屬性識(shí)別技術(shù)通常依賴人工進(jìn)行屬性提取,并為每個(gè)屬性設(shè)計(jì)單獨(dú)的分類器[2-4]。然而,客運(yùn)站的復(fù)雜環(huán)境會(huì)顯著降低該技術(shù)的性能。隨著深度學(xué)習(xí)技術(shù)的發(fā)展,眾多學(xué)者嘗試使用復(fù)雜網(wǎng)絡(luò)來解決該問題[5-8],例如,利用特征金字塔網(wǎng)絡(luò)(FPN,F(xiàn)eature Pyramid Network)從多層次特征圖中提取屬性,結(jié)合注意力機(jī)制提取屬性類別。隨著Transformer 模型在計(jì)算機(jī)視覺領(lǐng)域的廣泛應(yīng)用,學(xué)者們發(fā)現(xiàn)其可捕獲長距離依賴關(guān)系,更適合于行人屬性的提取。該模型主要通過屬性相關(guān)性來完成任務(wù),然而過渡的依賴關(guān)系有時(shí)反而會(huì)降低屬性定位的準(zhǔn)確性。

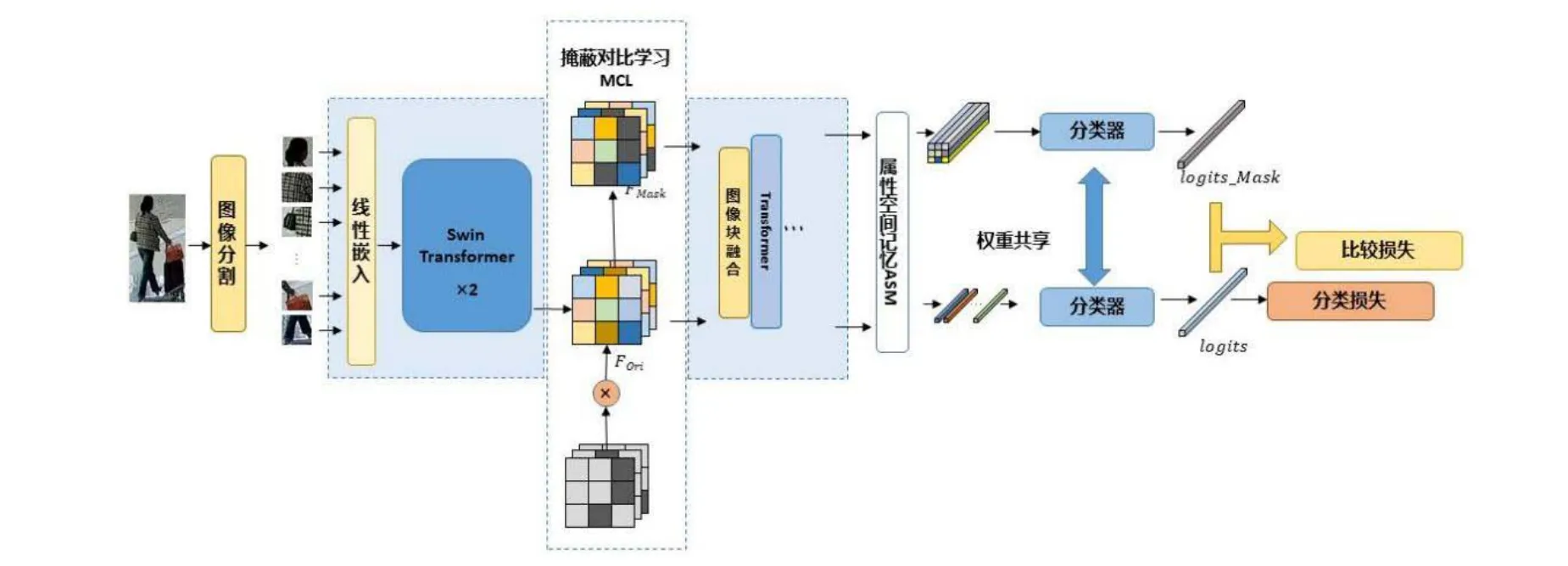

綜上,本文提出一種基于AL-Transformer(Attribute Localization—Transformer)模型的鐵路客運(yùn)站旅客屬性識(shí)別方法。該方法基于掩碼對(duì)比學(xué)習(xí)(MCL,Mask Contrast Learning)框架抑制特征區(qū)域相關(guān)性;通過屬性空間記憶(ASM,Attribute Spatial Memory)模塊獲得更有辨識(shí)度、更可靠穩(wěn)定的屬性區(qū)域。為鐵路客運(yùn)站工作人員推送更有針對(duì)性的預(yù)警信息,提高旅客服務(wù)質(zhì)量。

1 AL-Transformer 模型

AL-Transformer 模型以Swin Transformer 為骨干網(wǎng)絡(luò)[9],其總體架構(gòu)如圖1 所示。AL-Transformer 模型將給定的圖像分割成不重疊的圖像塊;隨后對(duì)每個(gè)圖像塊進(jìn)行線性嵌入,并通過Swin Transformer 骨干提取圖像特征。AL-Transformer 模型引入MCL 框架,生成隨機(jī)掩碼特征圖FMask和原始特征圖FOri,F(xiàn)Mask和FOri通過Transformer 模型和ASM 模塊,分別生成預(yù)測(cè)logits和logits_Mask。AL-Transformer 模型計(jì)算logits_Mask和logits間的比較損失并進(jìn)行回歸預(yù)測(cè),改進(jìn)屬性定位能力。

圖1 AL-Transformer 模型總體架構(gòu)

1.1 MCL 框架

AL-Transformer 模型在骨干網(wǎng)絡(luò)的基礎(chǔ)上,加入MCL 框架,降低模型中的區(qū)域相關(guān)性對(duì)于性能預(yù)測(cè)的影響。為使AL-Transformer 模型更關(guān)注于精確的屬性空間區(qū)域,MCL 框架在網(wǎng)絡(luò)中間層完成特征掩碼,通過控制特征區(qū)域間的相關(guān)性提升預(yù)測(cè)精度。

MCL 框架為每一批輸入圖像生成相應(yīng)數(shù)量的隨機(jī)FMask,隨后在分類器階段設(shè)置對(duì)比度損失函數(shù)Lcon,以評(píng)估通過隨機(jī)遮掩和沒有隨機(jī)遮掩的預(yù)測(cè)結(jié)果間的差異,損失函數(shù)Lcon公式為

式(1)中,predMask和predOri分別為原始特征圖FOri和隨機(jī)掩碼特征圖FMask的預(yù)測(cè)結(jié)果。

1.2 ASM 模塊

ASM 模塊用于解決空間注意力區(qū)域偏差問題,其架構(gòu)如圖2 所示。

圖2 ASM 模塊架構(gòu)

ASM 模塊利用輸入特征生成注意力圖,選擇可靠的注意力圖保存在記憶器模塊中,再通過注意力機(jī)制和選擇器為其生成相應(yīng)的屬性定位信息。

ASM 模塊將特征圖F∈RB×C×H×W和分類器權(quán)重w∈RM×C作為輸入,其中,F(xiàn)∈RB×C×H×W是主干網(wǎng)絡(luò)的輸出;H、W、C表示特征圖的高度、寬度和通道維度;B為訓(xùn)練批次。M是屬性的總數(shù);A∈RB×M×H×W為輸出的每個(gè)屬性的注意力圖,其公式為

式(2)中,F(xiàn)i是主干框架的特征圖;wm是第m個(gè)屬性的分類器權(quán)重。

注意力圖Ai,m表示不同空間區(qū)域的屬性預(yù)測(cè)值,ASM 模塊分別對(duì)不同屬性生成相應(yīng)的嵌入向量,對(duì)空間位置信息進(jìn)行加權(quán),從而改進(jìn)每個(gè)屬性的空間定位。再對(duì)注意力圖進(jìn)行歸一化,用作空間加權(quán)系數(shù),對(duì)特征進(jìn)行加權(quán)池化。

1.3 損失函數(shù)

AL-Transformer 模型根據(jù)二元交叉熵?fù)p失計(jì)算分類損失Lcls,公式為

式(3)中,pi,j為分類器的預(yù)測(cè)概率;yi,j為預(yù)測(cè)結(jié)果;N為預(yù)測(cè)屬性類別數(shù)。

對(duì)比損失Lcon公式為

式(4)中,probOri和probMask分別代表原始特征的預(yù)測(cè)結(jié)果和掩碼特征的預(yù)測(cè)結(jié)果。

最終損失函數(shù)Loss是分類損失Lcls和對(duì)比度損失Lcon的加權(quán)總和。

2 試驗(yàn)驗(yàn)證

2.1 性能比較

2.1.1 公共圖像數(shù)據(jù)庫介紹

本文試驗(yàn)采用PETA(PEdesTrian Attribute)公共圖像數(shù)據(jù)庫和PAl00K(Pedestrian Attribute—100K)公共圖像數(shù)據(jù)庫的公開圖像數(shù)據(jù)。其中,PETA 公共圖像數(shù)據(jù)庫包含19 000 張行人圖片,圖片的分辨率為17×39~ 169×365(PPI),同時(shí),每張行人圖片標(biāo)注了61 個(gè)二元屬性和4 個(gè)多類別屬性,例如年齡、性別、服飾和配飾等[10],其圖片示例如圖3(a)所示;PAl00K 公共圖像數(shù)據(jù)庫是目前為止最大的監(jiān)控場(chǎng)景下行人屬性識(shí)別數(shù)據(jù)庫。該數(shù)據(jù)庫擁有100 000張行人圖片,包括80 000 張訓(xùn)練集圖片,10 000 張驗(yàn)證集和10 000 張測(cè)試集圖片,每張行人圖片被標(biāo)注了26 個(gè)屬性[5],其圖片示例如圖3(b)所示。

圖3 本文采用的公共圖像數(shù)據(jù)庫圖像示例

2.1.2 實(shí)驗(yàn)設(shè)置

本文基于PyTorch 框架實(shí)現(xiàn)鐵路客運(yùn)站旅客屬性識(shí)別方法,并以端到端的方式進(jìn)行訓(xùn)練,采用Swin Transformer 作為骨干網(wǎng)絡(luò)提取行人圖像特征。本文將輸入的行人圖像尺寸統(tǒng)一調(diào)整為256×192 像素,并采用隨機(jī)水平鏡像、填充和隨機(jī)裁剪的方式進(jìn)行圖像增強(qiáng)。此外,本文采用Adamw 訓(xùn)練策略,設(shè)置衰減權(quán)重為0.000 5、初始學(xué)習(xí)率為0.000 1、批處理大小為64、訓(xùn)練階段的總迭代周期為50、動(dòng)量系數(shù)為0.999 8、標(biāo)簽平滑系數(shù)為0.2。

2.1.3 性能比較

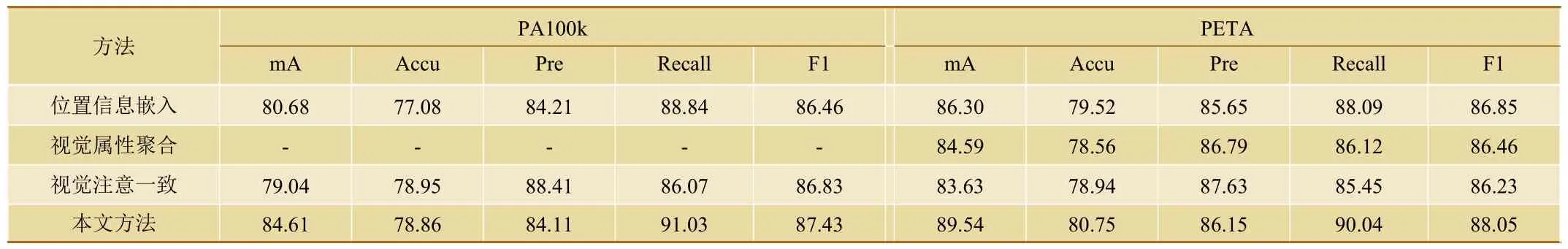

本文采用平均準(zhǔn)確率(mA)、準(zhǔn)確率(Accu)、精確率(Prec)、召回率(Recall)和 F1 值作為評(píng)價(jià)指標(biāo)[11],基于PETA 和PA100K 這2 個(gè)公共圖像數(shù)據(jù)庫,與位置信息嵌入、視覺屬性聚合和視覺注意一致等3 種常規(guī)算法進(jìn)行性能比較。

由表1 可知,AL-Transformer 模型在PETA 和PA100K 公共圖像數(shù)據(jù)庫上實(shí)現(xiàn)了更好的性能。與采用ResNet101 作為骨干網(wǎng)絡(luò)的視覺屬性聚合模型相比,本文方法在PETA 公共圖像數(shù)據(jù)庫上的mA 和F1 性能分別提高了4.95%和1.59%。與位置信息嵌入模型等基于定位的方法相比,本文方法在2 個(gè)公共圖像數(shù)據(jù)庫上的mA 性能分別提高了3.93%和3.24%。本文方法在大多數(shù)性能指標(biāo)上顯著優(yōu)于視覺注意一致方法[12]。

表1 多種方法的性能比較

2.2 可視化驗(yàn)證

如圖4 所示,在PA-100K 公開圖像數(shù)據(jù)庫的測(cè)試集上對(duì)本文方法和Swin Transformer 網(wǎng)絡(luò)關(guān)注的屬性區(qū)域進(jìn)行了可視化驗(yàn)證。其中,綠色邊框?yàn)镾win Transformer 網(wǎng)絡(luò)的屬性注意力圖;紅色邊框?yàn)楸疚姆椒ǖ膶傩宰⒁饬D。與Swin Transformer 網(wǎng)絡(luò)相比,本文方法有助于為每個(gè)屬性定位與其相關(guān)的區(qū)域,例如:在圖4 中的行人2 和行人3 中,當(dāng)識(shí)別到屬性“眼鏡”時(shí),本文方法更好地關(guān)注到了頭部區(qū)域。可視化結(jié)果表明,本文方法可有效改善每個(gè)屬性的空間位置。

圖4 本文方法與Swin Transformer 網(wǎng)絡(luò)的屬性注意力圖可視化展示

2.3 消融試驗(yàn)

本文通過消融試驗(yàn)來驗(yàn)證ASM 模塊和MCL 框架對(duì)AL-Transformer 模型性能的影響,試驗(yàn)結(jié)果如表2 所示。

表2 在PETA 和PA100K 上的消融實(shí)驗(yàn)

(1)Swing Transformer 主干網(wǎng)絡(luò)的屬性定位精度較差,識(shí)別精度較低,證明算法在沒有正確的注意區(qū)域的情況下,缺乏對(duì)屬性語義特征的辨別能力,并包含更多噪聲。

(2)相比于只使用Swing Transformer 主干網(wǎng)絡(luò),添加ASM 模塊可使在PA100K 和PETA 公共圖像數(shù)據(jù)庫的mA 性能分別提升1.18%和2.06%,這是因?yàn)椋珹SM 模塊通過屬性預(yù)測(cè)得分生成可重復(fù)使用的屬性空間注意力圖,指導(dǎo)屬性空間特征融合,提高屬性定位精度。

(3)在Swing Transformer 主干網(wǎng)絡(luò)上引入MCL框架,可在行人圖像上生成隨機(jī)遮擋,評(píng)估其預(yù)測(cè)結(jié)果與正常輸入預(yù)測(cè)結(jié)果的差異。通過抑制區(qū)域相關(guān)性來提高屬性定位能力,相比于只使用Swing Transformer 主干網(wǎng)絡(luò),引入MCL 框架后,在PA100K 和PETA 公共圖像數(shù)據(jù)庫的mA 性能分別提升了0.39%和0.47%。

(4)本文方法的mA 性能指標(biāo)在PA100k 和RETA 公共圖像數(shù)據(jù)庫上分別比只使用Swing Transformer 主干網(wǎng)絡(luò)提高了1.79%和2.34%。

2.4 白銀南站現(xiàn)場(chǎng)驗(yàn)證

基于AL-Transformer 模型的鐵路客運(yùn)站旅客屬性識(shí)別方法已在中國鐵路蘭州局集團(tuán)有限公司白銀南站試用。

(1)針對(duì)安檢區(qū)域采集的圖像,通過本文方法可自動(dòng)識(shí)別進(jìn)站人員的結(jié)構(gòu)化信息,如性別、年齡范圍、穿戴物品(帽子、眼鏡、背包、短袖、長外套、長褲、短褲、裙子、連衣裙)、衣物顏色、旅客所在位置/區(qū)域、是否攜帶輪椅嬰兒車折疊自行車等特征。

(2)根據(jù)旅客的上述屬性特征進(jìn)行主動(dòng)服務(wù),例如:針對(duì)坐輪椅的旅客,可及時(shí)將信息下發(fā)給附近區(qū)域的車站工作人員,對(duì)其進(jìn)行重點(diǎn)關(guān)注;針對(duì)攜帶折疊自行車的旅客,可及時(shí)將其信息推送給站臺(tái)和候車廳內(nèi)相關(guān)值班人員。

(3)提升旅客描述顆粒度。針對(duì)視頻分析系統(tǒng)中識(shí)別出來的異常行為人員,可提升報(bào)警信息的精確性,進(jìn)一步細(xì)化報(bào)警信息,例如,細(xì)化內(nèi)容為:身著紅色衣服的長發(fā)女性,在1 站臺(tái)距離南端口大約200 m 處,出現(xiàn)越線行為等。從而,使車站工作人員及時(shí)發(fā)現(xiàn)異常行為人員,有效阻止事態(tài)發(fā)展。

3 結(jié)束語

本文提出了一種基于AL-Transformer 模型的鐵路客運(yùn)站旅客屬性識(shí)別方法,該方法在 Swing Transformer 主干網(wǎng)絡(luò)的基礎(chǔ)上,通過融合MCL 框架和ASM 模塊來精準(zhǔn)選擇屬性信息的相關(guān)區(qū)域,從而更準(zhǔn)確地獲取旅客的結(jié)構(gòu)化信息,為工作人員推送更加精準(zhǔn)的報(bào)警信息,進(jìn)一步提升鐵路客運(yùn)站的旅客服務(wù)質(zhì)量。