基于深度學(xué)習(xí)的Attention U-Net語(yǔ)義分割模型研究

薛澤民,鄒連旭,黃志威,冉杰,余若巖,鄭國(guó)勛

(1.長(zhǎng)春工程學(xué)院,長(zhǎng)春 130012; 2.長(zhǎng)白山歷史文化與VR技術(shù)重構(gòu)吉林省重點(diǎn)實(shí)驗(yàn)室,長(zhǎng)春 130012)

0 引言

近年來(lái),深度學(xué)習(xí)在計(jì)算機(jī)視覺(jué)領(lǐng)域大放異彩,已逐漸成為主流研究方向,越來(lái)越多的研究人員將其深度學(xué)習(xí)技術(shù)應(yīng)用于圖像語(yǔ)義分割。在深度學(xué)習(xí)進(jìn)行圖像處理的研究中,通常是將圖像輸入到編碼器中,得到1個(gè)中間的上下文,再使用解碼器對(duì)該上下文進(jìn)行解碼,最后還原成1個(gè)輸出的序列。而目前的做法是使用1個(gè)循環(huán)神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)編碼器,用另外1個(gè)循環(huán)神經(jīng)網(wǎng)絡(luò)去實(shí)現(xiàn)解碼器。針對(duì)編碼器和解碼器的實(shí)現(xiàn),還有一些人采用不同模型結(jié)合的方法,比如使用雙向循環(huán)神經(jīng)網(wǎng)絡(luò)或者采用帶有長(zhǎng)短期記憶的雙向循環(huán)神經(jīng)網(wǎng)絡(luò)等[1]。這些方法均需要將大量的信息壓縮成1個(gè)固定長(zhǎng)度的中間上下文向量,因此使得大量的信息在被壓縮后產(chǎn)生損失,尤其是先輸入的信息會(huì)被后輸入的信息稀釋,且隨著輸入的序列越長(zhǎng),問(wèn)題越嚴(yán)重,最后會(huì)導(dǎo)致解碼質(zhì)量嚴(yán)重下降。

Jay Alammar為解決這種編碼器-解碼器結(jié)構(gòu)存在的問(wèn)題,在傳統(tǒng)的編碼器中引入了注意力機(jī)制。加入注意力機(jī)制后,編碼器需要將源圖像編碼成一個(gè)個(gè)向量。與傳統(tǒng)的編碼器-解碼器結(jié)構(gòu)不同的是,傳統(tǒng)方式只需要把最后1個(gè)向量當(dāng)作上下文向量傳給解碼器即可,但在注意力機(jī)制中,需要把所有的向量傳給解碼器,而在解碼時(shí),會(huì)多一個(gè)額外的步驟,即通過(guò)注意力機(jī)制找出與當(dāng)前輸出時(shí)間步長(zhǎng)最相關(guān)的編碼器時(shí)間步長(zhǎng)的輸入向量,再產(chǎn)生當(dāng)前時(shí)間步長(zhǎng)的輸出,使在產(chǎn)生每一個(gè)輸出的時(shí)候,都能夠做到充分利用輸入序列攜帶的信息,CHO等[2]采用這種方法在圖像語(yǔ)義分割中取得了非常不錯(cuò)的成果。本文針對(duì)通過(guò)生成對(duì)抗網(wǎng)絡(luò)GAN擴(kuò)充的數(shù)據(jù)集,提出了融入注意力機(jī)制的U-Net網(wǎng)絡(luò)訓(xùn)練的圖像語(yǔ)義分割模型。

1 生成對(duì)抗網(wǎng)絡(luò)

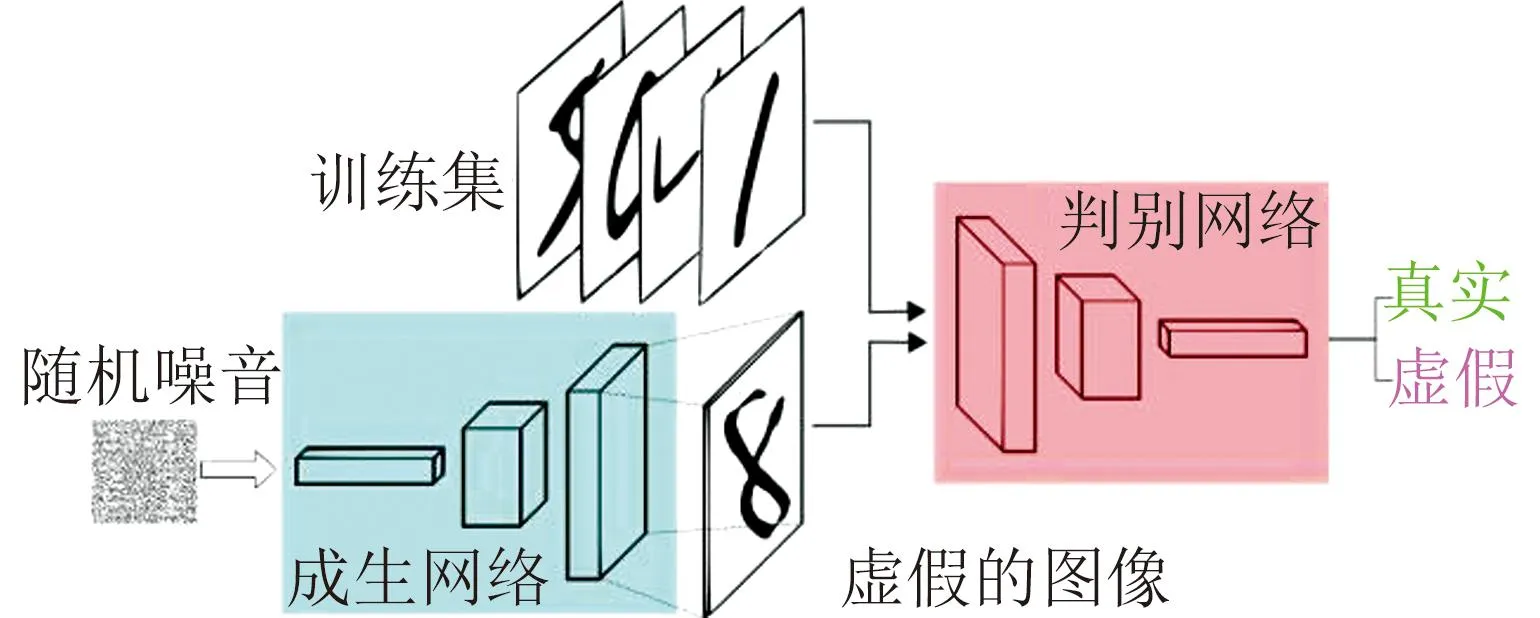

生成對(duì)抗網(wǎng)絡(luò)是一種深度學(xué)習(xí)模型,被認(rèn)為是近年來(lái)最有前景的無(wú)監(jiān)督學(xué)習(xí)方法之一,適用于處理復(fù)雜分布的數(shù)據(jù)。與傳統(tǒng)方法需要標(biāo)記大量的數(shù)據(jù)相比,生成對(duì)抗網(wǎng)絡(luò)可以在無(wú)需標(biāo)注數(shù)據(jù)的情況下進(jìn)行生成任務(wù)的學(xué)習(xí)。該網(wǎng)絡(luò)結(jié)構(gòu)由生成器和判別器兩部分組成。首先生成器從潛在空間中進(jìn)行隨機(jī)取樣并將其作為輸入,生成高度逼真的樣本。再把判別器接收的真實(shí)樣本和生成器生成的虛假樣本作為輸入,并努力將它們區(qū)分開(kāi)。生成器和判別器相互對(duì)抗、不斷學(xué)習(xí),模型通過(guò)這兩個(gè)模塊的博弈和優(yōu)化逐步達(dá)到平衡點(diǎn),從而實(shí)現(xiàn)擴(kuò)充數(shù)據(jù)的目的[3]。為了保持生成器與判別器之間平衡的穩(wěn)定性,即納什均衡,必須滿足式(1),結(jié)構(gòu)如圖1所示。

圖1 生成對(duì)抗網(wǎng)絡(luò)結(jié)構(gòu)圖

(1)

式中V(D,G)表示生成對(duì)抗網(wǎng)絡(luò)整體待優(yōu)化的損失函數(shù),z表示隨機(jī)變量,x表示真實(shí)數(shù)據(jù),Pz表示生成數(shù)據(jù)的概率分布,P表示x的概率分布,D(x)表示判別x是否為真實(shí)的概率,D(G(z))表示判別重建數(shù)據(jù)是否真實(shí)的概率。

2 注意力機(jī)制

注意力機(jī)制是一種通過(guò)模擬人類視覺(jué)和認(rèn)知系統(tǒng)的方法,通過(guò)注意力機(jī)制可以讓模型知道圖像中不同局部信息的重要性,從而提高模型的性能和泛化能力。主流的注意力機(jī)制采用編碼器-解碼器結(jié)構(gòu),如圖2所示,該結(jié)構(gòu)將一個(gè)變長(zhǎng)的輸入X=(x1,x2,…,xn)映射到一個(gè)變長(zhǎng)輸出Y=(y1,y2,…,ym)。其中編碼器把一個(gè)變長(zhǎng)的輸入序列X,通過(guò)非線性變換轉(zhuǎn)化為一個(gè)中間的語(yǔ)義表示C(C=f(x1,x2,…,xn))。解碼器則根據(jù)輸入序列X的中間語(yǔ)義表示C和先前已經(jīng)生成的y1,y2,…,yi-1,預(yù)測(cè)并生成i時(shí)刻的輸出yi=g(y1,y2,…,yi-1,C)[4],在前述過(guò)程中,f()和g()為非線性轉(zhuǎn)換函數(shù)。

圖2 注意力機(jī)制的編碼器-解碼器結(jié)構(gòu)

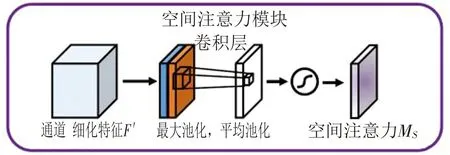

注意力機(jī)制包含多種,本文使用的是空間注意力。空間注意力是通過(guò)空間轉(zhuǎn)換模塊將原始圖片中的空間信息轉(zhuǎn)換到另一個(gè)空間,并保留關(guān)鍵信息,使關(guān)鍵區(qū)域的特征表達(dá)得到提升。它為每個(gè)位置生成權(quán)重掩膜并對(duì)特征進(jìn)行加權(quán)輸出,從而增強(qiáng)感興趣的特定目標(biāo)區(qū)域并減弱不相關(guān)的背景區(qū)域。空間注意力模塊的實(shí)現(xiàn)如圖3所示,首先對(duì)給定的H×W×C特征F′進(jìn)行全局平均池化和全局最大池化操作,得到2個(gè)H×W×1的特征圖,分別代表不同信息;然后將這2個(gè)特征圖進(jìn)行拼接,經(jīng)過(guò)一個(gè)具有較大感受野的7×7卷積層進(jìn)行特征融合;再通過(guò)Sigmoid操作生成一個(gè)權(quán)重圖Ms,并將其疊加到原始輸入特征F′上;最后根據(jù)權(quán)重圖對(duì)輸入特征進(jìn)行縮放,從而完成增強(qiáng)目標(biāo)區(qū)域的特征表達(dá),計(jì)算過(guò)程如式(2)所示。

圖3 空間注意力實(shí)現(xiàn)圖

Ms(F)=σ(f7*7([AvgPool(F),MaxPool(F)])),

(2)

式中σ表示Sigmoid函數(shù),f7*7表示7×7大小的卷積核,AvgPool表示平均池化,MaxPool表示最大池化。

3 融入空間注意力機(jī)制的U-Net

在U-Net網(wǎng)絡(luò)中,融入空間注意力模塊,可以使網(wǎng)絡(luò)更加關(guān)注感興趣的區(qū)域,并減少對(duì)不相關(guān)區(qū)域的依賴,我們稱其為Attention U-Net。即在U-Net的編碼器和解碼器之間插入空間注意力模塊,通過(guò)該模塊計(jì)算輸入特征圖的空間相關(guān)權(quán)重來(lái)調(diào)控信息的傳遞。具體來(lái)講,我們使用空間映射的方法對(duì)輸入特征圖進(jìn)行卷積操作來(lái)獲取感興趣區(qū)域的權(quán)重分布,通過(guò)卷積層和激活函數(shù)來(lái)學(xué)習(xí)感興趣區(qū)域的空間特征,然后使用空間調(diào)整法將計(jì)算得到的注意力權(quán)重與輸入特征圖逐元素相乘得到經(jīng)過(guò)調(diào)整的特征,最后將調(diào)整后的特征送入下一層網(wǎng)絡(luò)進(jìn)行處理,從而增強(qiáng)感興趣區(qū)域的特征響應(yīng)并有效抑制不相關(guān)區(qū)域的干擾。為了實(shí)現(xiàn)Attention U-Net,需要完成3部分內(nèi)容:U-Net的實(shí)現(xiàn)、注意力門模塊的實(shí)現(xiàn)和U-Net與注意力門模塊的融合。

3.1 U-Net的實(shí)現(xiàn)

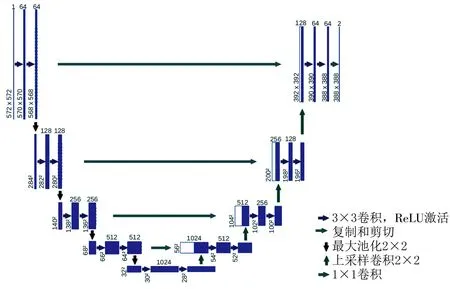

U-Net是一種基于FCN架構(gòu)構(gòu)建的U型網(wǎng)絡(luò),其結(jié)構(gòu)如圖4所示。左側(cè)部分是收縮路徑,經(jīng)過(guò)一系列卷積和池化進(jìn)行下采樣,提取圖像特征。右側(cè)部分是擴(kuò)展路徑,進(jìn)行上采樣,將特征圖與左側(cè)提取的特征相融合,在卷積層進(jìn)行特征維度的調(diào)整,然后再進(jìn)行上采樣和融合。重復(fù)前述過(guò)程直到上采樣到與原圖相同的尺寸時(shí),添加1個(gè)卷積層用于對(duì)每個(gè)像素點(diǎn)進(jìn)行分類來(lái)實(shí)現(xiàn)圖像的語(yǔ)義分割。這種結(jié)構(gòu)充分利用了上采樣和下采樣過(guò)程中提取的多尺度特征信息以及跳躍連接的方式,能夠有效地獲取全局和局部的上下文語(yǔ)義信息,并將其應(yīng)用于像素級(jí)的分割任務(wù)[5]。

圖4 U-Net結(jié)構(gòu)圖

3.2 Attention U-Net的實(shí)現(xiàn)

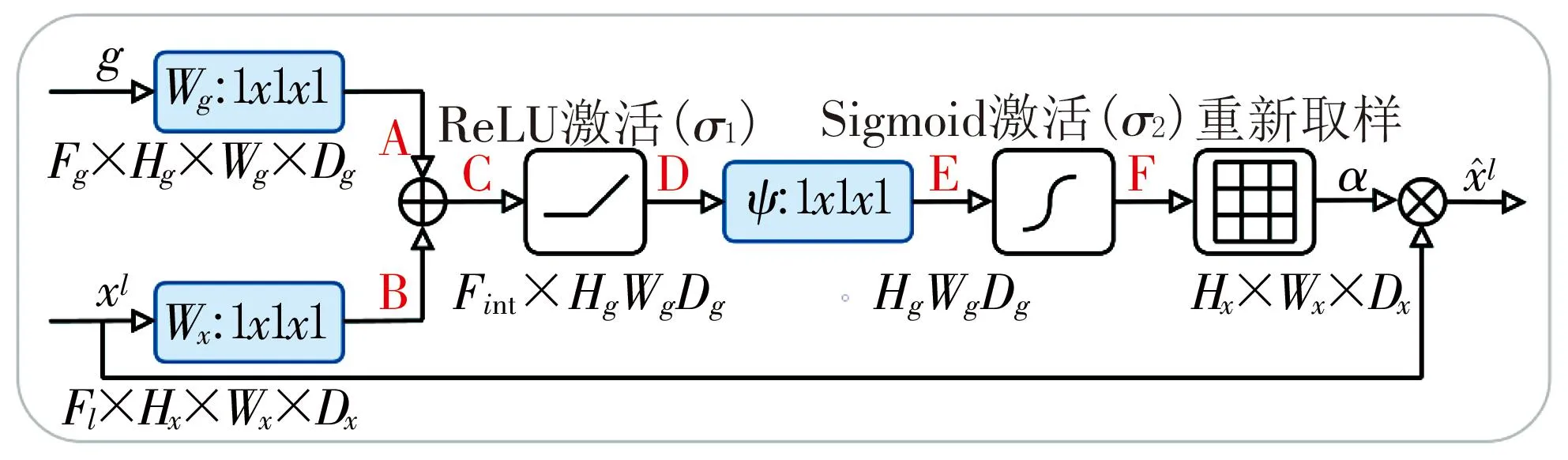

3.2.1 實(shí)現(xiàn)注意力門模塊

圖5 注意力門模塊結(jié)構(gòu)圖

(3)

式中σ1表示激活函數(shù),*表示卷積操作,k表示卷積核參數(shù),Fl表示在第l層的感受野內(nèi)的所有位置的集合。

注意力系數(shù)α用來(lái)識(shí)別圖像中的顯著區(qū)域并修剪特征響應(yīng),它將輸入特征圖與注意力系數(shù)進(jìn)行元素乘法來(lái)計(jì)算。通常情況下,我們可以通過(guò)特征圖中的每個(gè)像素向量計(jì)算出該像素標(biāo)量的注意值。當(dāng)涉及多個(gè)語(yǔ)義類別時(shí),可以學(xué)習(xí)多維的注意力系數(shù),使得每個(gè)注意力門能夠關(guān)注目標(biāo)結(jié)構(gòu)的1個(gè)子集,讓每個(gè)像素使用1個(gè)門控向量來(lái)確定聚焦區(qū)域并采用加性注意力方法來(lái)計(jì)算門控系數(shù)。通過(guò)這些方式,我們能夠建立適應(yīng)不同場(chǎng)景和任務(wù)的注意力模式,并提高關(guān)鍵特征表達(dá)的準(zhǔn)確性,加性注意力的公式如式(4)所示。

(4)

式中σ1表示激活函數(shù),σ2表示Sigmoid函數(shù),Θatt表示注意力門的一組參數(shù),Wx、Wg和Ψ表示卷積操作,bΨ和bg表示對(duì)應(yīng)卷積的偏置項(xiàng)。

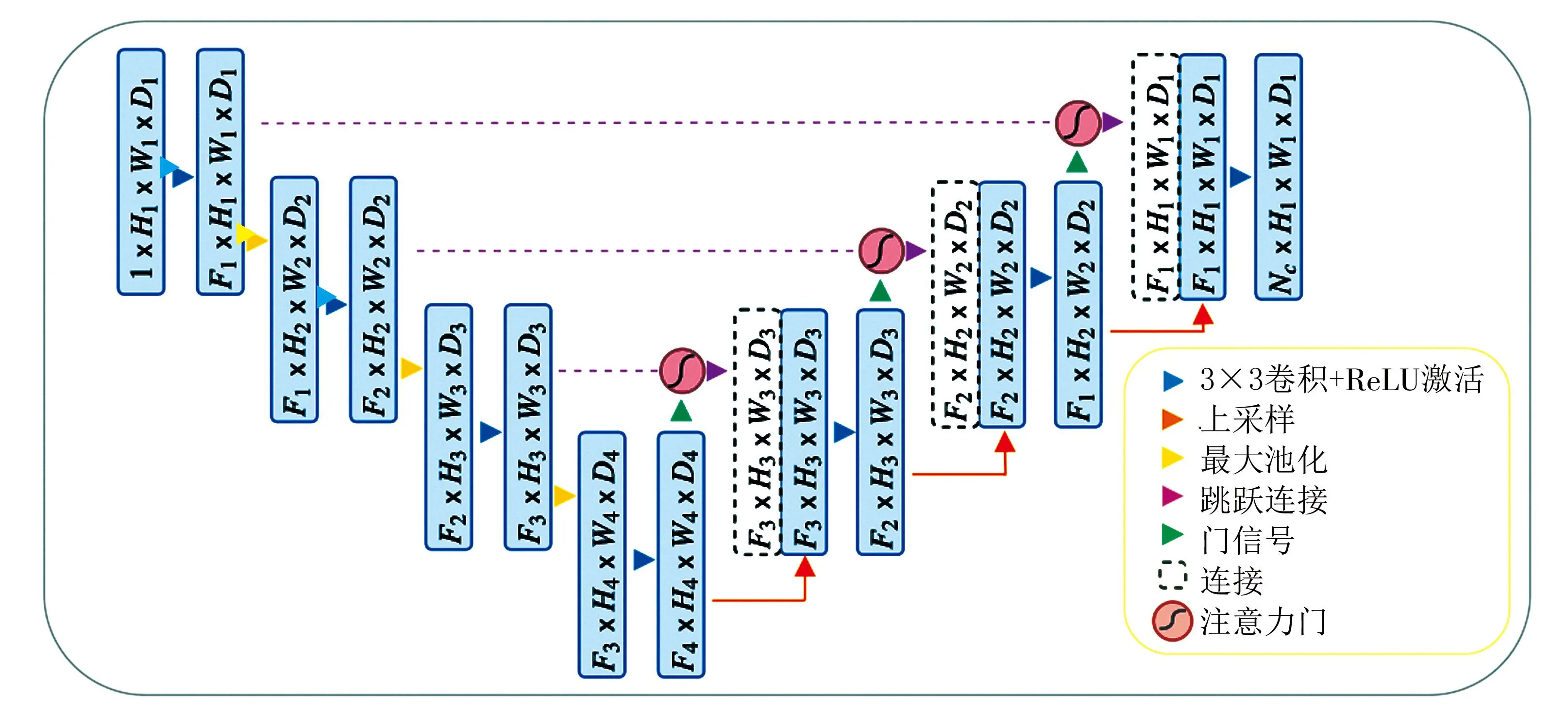

3.2.2 將注意力門模塊應(yīng)用于U-Net

在標(biāo)準(zhǔn)的U-Net架構(gòu)中融合了前文提出的注意力門模塊,通過(guò)突出跳躍連接中的顯著特征,將粗尺度提取的信息應(yīng)用于門控中,消除跳躍連接產(chǎn)生的不相關(guān)和嘈雜的響應(yīng)。在前向傳播和反向傳播過(guò)程中,使用注意力門對(duì)神經(jīng)元的激活進(jìn)行過(guò)濾和減少產(chǎn)生背景區(qū)域梯度的權(quán)重等方法,確保更新底層模型參數(shù)時(shí)更專注于與給定任務(wù)相關(guān)的空間區(qū)域。具體實(shí)現(xiàn)的結(jié)構(gòu)如圖6所示,對(duì)于l-1層的卷積參數(shù),其更新方式如式(5)所示。

圖6 Attention U-Net網(wǎng)絡(luò)結(jié)構(gòu)圖

(5)

4 試驗(yàn)

4.1 試驗(yàn)環(huán)境

本試驗(yàn)采用Windows 10操作系統(tǒng),11th Gen Intel(R) Core(TM) i5-11260H @ 2.60GHz (12 CPUs)處理器,NVIDIA GeForce RTX 3060顯卡,深度學(xué)習(xí)框架為Pytorch1.3.0版本,采用CamVid(Cambridge-driving Labeled Video Database)數(shù)據(jù)集。從中隨機(jī)挑選700張大小為970×720像素的圖像測(cè)試數(shù)據(jù)作為試驗(yàn)的數(shù)據(jù)集,并按照5∶2的比例將數(shù)據(jù)集劃分為訓(xùn)練集和測(cè)試集,訓(xùn)練集共500張,測(cè)試集共200張,通過(guò)生成對(duì)抗網(wǎng)絡(luò)將數(shù)據(jù)集擴(kuò)充到1 000張。

4.2 訓(xùn)練參數(shù)及評(píng)價(jià)指標(biāo)

4.2.1 訓(xùn)練參數(shù)

使用本文的模型與U-Net+ +、FCN、DeepLabV1對(duì)擴(kuò)充后的數(shù)據(jù)集進(jìn)行訓(xùn)練,將Batch size(1次訓(xùn)練所抓取的數(shù)據(jù)樣本數(shù)量)設(shè)置為4,迭代次數(shù)設(shè)置為100,當(dāng)損失趨于穩(wěn)定時(shí)停止訓(xùn)練。

4.2.2 評(píng)價(jià)指標(biāo)

在深度學(xué)習(xí)領(lǐng)域,常用的語(yǔ)義分割評(píng)價(jià)指標(biāo)有準(zhǔn)確率(Accuracy)和損失值(Loss)等,這些參數(shù)可以較好地反映出一個(gè)模型的性能。準(zhǔn)確率是用于評(píng)估分類模型的指標(biāo),簡(jiǎn)單來(lái)講就是模型預(yù)測(cè)正確的數(shù)量占總量的比例,計(jì)算過(guò)程如式(6)所示。損失值是用于評(píng)價(jià)模型在訓(xùn)練集上的擬合程度的指標(biāo),通常情況下,損失越小則訓(xùn)練數(shù)據(jù)越擬合。

(6)

式中TP表示真正例,TN表示真負(fù)例,FP表示假正例,FN表示假負(fù)例。

4.3 試驗(yàn)結(jié)果及分析

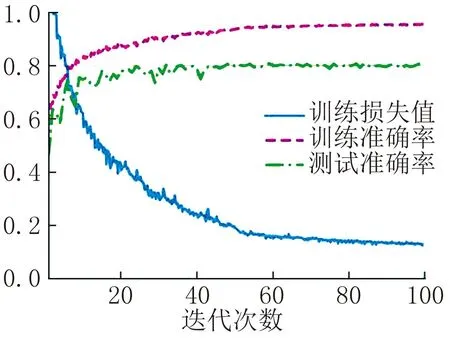

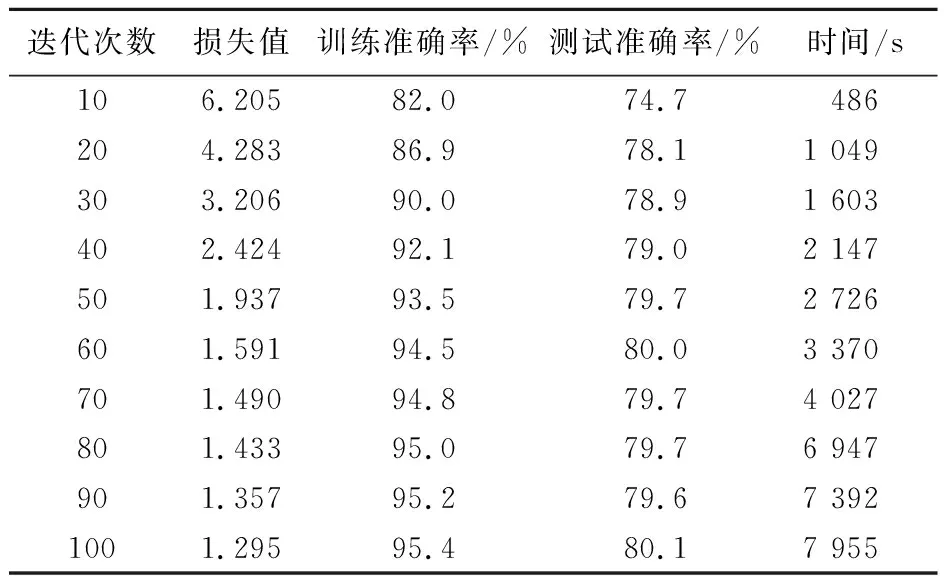

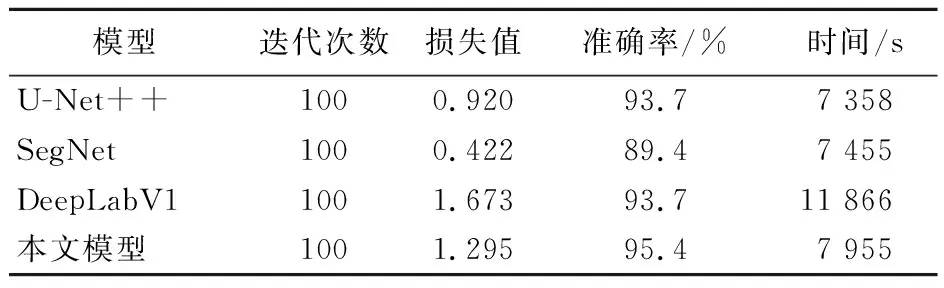

從圖7可以看出隨著時(shí)間的增長(zhǎng),在80輪以后,準(zhǔn)確率和損失值逐漸趨于穩(wěn)定,結(jié)合表1可以得出在第100輪時(shí)準(zhǔn)確率約為95.4%。從表2各種模型訓(xùn)練100輪的結(jié)果可以看出,在各自損失值趨于穩(wěn)定的情況下,與其他模型相比,本文模型的訓(xùn)練準(zhǔn)確率較高,損失值與U-Net++、DeepLabV1較為接近。

圖7 訓(xùn)練結(jié)果圖

表1 對(duì)模型進(jìn)行100輪訓(xùn)練的結(jié)果

表2 與其他模型的對(duì)比結(jié)果

5 結(jié)語(yǔ)

針對(duì)當(dāng)前深度神經(jīng)網(wǎng)絡(luò)在圖像分割過(guò)程中普遍存在的處理耗時(shí)長(zhǎng)、分割準(zhǔn)確率不高的問(wèn)題,本文在使用生成對(duì)抗網(wǎng)絡(luò)擴(kuò)充數(shù)據(jù)集后,提出了一種融入注意力機(jī)制的U-Net模型用于圖像分割。具體來(lái)講,就是以U-Net網(wǎng)絡(luò)為基本框架,在每個(gè)解碼器層中都添加1個(gè)注意力門模塊,幫助模型更準(zhǔn)確地區(qū)分前景和背景,提高學(xué)習(xí)效率,加強(qiáng)特征區(qū)分。通過(guò)對(duì)比試驗(yàn)得出,相較于各傳統(tǒng)語(yǔ)義分割模型,如U-Net++、SegNet等,本文的模型訓(xùn)練時(shí)間較短,同時(shí)又具有較高的分割準(zhǔn)確率。