基于航拍圖像與改進(jìn)U-Net的建筑外墻裂縫檢測(cè)方法

劉少華 任宜春 鄭智雄 牛孜飏

摘要:針對(duì)建筑外墻裂縫人工檢測(cè)方法檢測(cè)效率低、檢測(cè)效果和安全性差的問(wèn)題,提出基于航拍圖像與計(jì)算機(jī)視覺(jué)的裂縫檢測(cè)方法。使用無(wú)人機(jī)繞建筑物航拍采集裂縫圖像,并構(gòu)建裂縫數(shù)據(jù)集;優(yōu)化U-Net模型以解決細(xì)長(zhǎng)裂縫分割不連續(xù)、復(fù)雜背景下裂縫漏檢及背景誤檢的問(wèn)題。將模型編碼網(wǎng)絡(luò)替換為預(yù)訓(xùn)練的ResNet50以提升模型特征表達(dá)能力;添加改進(jìn)的多孔空間金字塔池化(Atrous Spatial Pyramid Pooling,ASPP)模塊,獲取多尺度上下文信息;采用改進(jìn)的損失函數(shù)處理裂縫圖像正負(fù)樣本分布極度不均的問(wèn)題。結(jié)果表明:改進(jìn)的U-Net模型解決了原模型存在的問(wèn)題,IoU指標(biāo)和F1_score分別提升了3.53%、4.18%;與經(jīng)典分割模型相比,改進(jìn)模型的裂縫分割性能最優(yōu)。與人工檢測(cè)方法相比,所提方法可以安全、高效且準(zhǔn)確地進(jìn)行建筑外墻裂縫檢測(cè)。

關(guān)鍵詞:建筑外墻裂縫;無(wú)人機(jī);計(jì)算機(jī)視覺(jué);語(yǔ)義分割;U-Net

中圖分類(lèi)號(hào):TU17? ? ?文獻(xiàn)標(biāo)志碼:A? ? ?文章編號(hào):2096-6717(2024)01-0223-09

Building exterior wall crack detection based on aerial images and improved U-Net

LIU Shaohua1, REN Yichun1, ZHENG Zhixiong2, NIU Ziyang2

(1. School of Civil Engineering, Changsha University of Science and Technology, Changsha 410114, P. R. China;

2. China Construction Fifth Engineering Bureau Co., Ltd, Changsha 410007, P. R. China)

Abstract: Aiming at the problems of low efficiency, unsatisfactory detection effect and poor safety of manual detection methods for building exterior wall cracks, a crack detection method based on aerial images and computer vision was proposed. Firstly, the Unmanned Aerial Vehicle (UAV) was used to collect the crack images through aerial photography around the buildings, and a crack dataset was constructed. Secondly, the U-Net was optimized to solve the problems of discontinuous segmentation of slender cracks as well as the missed and false detection under complex backgrounds. The encoder was replaced with pre-trained ResNet50 to improve the feature expression ability of the model. An improved Atrous Spatial Pyramid Pooling (ASPP) module was added to obtain multi-scale context information. The improved loss function was used to deal with the problem of extremely uneven distribution of positive and negative samples in crack images. Experiments show that the improved U-Net model solved the problems existing in the original model; the IoU and F1_score were increased by 3.53% and 4.18%, respectively. Compared with the classical segmentation model, the improved model has the best crack segmentation performance. Compared with manual detection methods, it can efficiently, accurately, and safely detect building exterior wall cracks.

Keywords: building exterior wall cracks; UAV; computer vision; semantic segmentation; U-Net

建筑外墻裂縫會(huì)使帶腐蝕性的雨水滲入墻體,導(dǎo)致墻體涂料與防水材料等發(fā)霉、剝落,不僅影響建筑美觀(guān),甚至銹蝕墻內(nèi)鋼筋等材料,破壞墻體結(jié)構(gòu),帶來(lái)安全隱患。準(zhǔn)確檢測(cè)出裂縫位置,可以為制定有效的維護(hù)方案提供依據(jù)。目前,建筑外墻裂縫主要采用人工檢測(cè),這是一種高空作業(yè),不僅危險(xiǎn),而且檢測(cè)效率和精度都很低。如何安全、高效地檢測(cè)建筑外墻裂縫成為亟須解決的問(wèn)題。

計(jì)算機(jī)視覺(jué)為裂縫檢測(cè)提供了一種非接觸式的檢測(cè)技術(shù)[1],包括圖像處理和深度學(xué)習(xí)兩類(lèi)方法。基于圖像處理的裂縫檢測(cè)方法根據(jù)裂縫的紋理和邊緣等特征,人為設(shè)計(jì)裂縫檢測(cè)的依據(jù),實(shí)現(xiàn)裂縫檢測(cè)[2]。這種方法夠在特定的數(shù)據(jù)集上取得良好的檢測(cè)效果,但是裂縫的檢測(cè)精度不高,且需要針對(duì)特定的圖像設(shè)計(jì)專(zhuān)門(mén)的裂縫檢測(cè)算法。近年來(lái),基于深度學(xué)習(xí)的方法在裂縫檢測(cè)領(lǐng)域取得了顯著的成果,根據(jù)裂縫檢測(cè)方式的不同可將其分為3類(lèi):圖像分類(lèi)、目標(biāo)檢測(cè)與語(yǔ)義分割。基于圖像分類(lèi)[3]與目標(biāo)檢測(cè)[4]的裂縫檢測(cè)方式,只能識(shí)別并定位裂縫,不能在像素級(jí)別上標(biāo)記裂縫,從而無(wú)法獲得裂縫形狀信息;基于語(yǔ)義分割的裂縫檢測(cè)方法是對(duì)圖像中的每個(gè)像素點(diǎn)進(jìn)行分類(lèi),能將裂縫像素準(zhǔn)確標(biāo)記出來(lái),既可以檢測(cè)有無(wú)裂縫,又能得到裂縫的位置、形狀等信息[5]。經(jīng)典語(yǔ)義分割模型U-Net[6]、DeepLabv3+[7]、PSPNet[8]及其改進(jìn)模型在橋梁、路面及隧道等領(lǐng)域的裂縫檢測(cè)中得到廣泛應(yīng)用。李良福等[9]提出了改進(jìn)的PSPNet模型,解決了橋梁裂縫分割細(xì)節(jié)信息丟失的問(wèn)題;Li等[10]提出了一種可訓(xùn)練的上下文編碼網(wǎng)絡(luò),實(shí)現(xiàn)了復(fù)雜條件下橋梁裂縫的檢測(cè);曹錦綱等[11]提出了一種基于注意力機(jī)制的網(wǎng)絡(luò),實(shí)現(xiàn)了自動(dòng)準(zhǔn)確地路面裂縫檢測(cè);Nguyen等[12]提出了一種兩級(jí)卷積神經(jīng)網(wǎng)絡(luò)來(lái)處理含噪聲和低質(zhì)量的道路圖像;孟慶成等[13]用改進(jìn)的MobileNet_v2替換U-Net編碼器,實(shí)現(xiàn)了對(duì)混凝土裂縫的實(shí)時(shí)檢測(cè);Dang等[14]提出了改進(jìn)的U-Net模型,在滿(mǎn)足裂縫分割性能要求的基礎(chǔ)上支持裂縫自動(dòng)測(cè)量。上述模型在裂縫檢測(cè)中的成功應(yīng)用,表明深度學(xué)習(xí)方法在裂縫檢測(cè)領(lǐng)域具有廣闊的應(yīng)用前景。

建筑外墻裂縫與橋梁、路面等混凝土裂縫擁有共同特征,然而建筑外墻因其材料多樣性,且墻體包含復(fù)雜建筑構(gòu)件,導(dǎo)致建筑外墻裂縫圖像背景更加復(fù)雜,存在更多的背景噪聲。因此,有必要為建筑外墻裂縫檢測(cè)針對(duì)性地設(shè)計(jì)一個(gè)深度學(xué)習(xí)模型。基于深度學(xué)習(xí)的裂縫檢測(cè)方法在訓(xùn)練和預(yù)測(cè)階段都依賴(lài)原始圖像數(shù)據(jù),人工采集大型建筑的外墻圖像需高空作業(yè),存在安全隱患大、效率低等問(wèn)題。近年來(lái),無(wú)人機(jī)技術(shù)取得快速發(fā)展,無(wú)人機(jī)搭載傳感器為高空采集圖像提供了一種安全且高效的方式,在抗震救災(zāi)、農(nóng)業(yè)植保等領(lǐng)域得到廣泛應(yīng)用[15]。筆者使用無(wú)人機(jī)航拍采集建筑外墻圖像,并根據(jù)裂縫圖像特征設(shè)計(jì)了改進(jìn)的U-Net模型用于裂縫檢測(cè)。

1 裂縫數(shù)據(jù)集構(gòu)建

1.1 圖像采集與處理

圖像采集包括裂縫數(shù)據(jù)集構(gòu)建和裂縫檢測(cè)兩個(gè)階段。在構(gòu)建數(shù)據(jù)集時(shí),為了保證訓(xùn)練后模型的魯棒性,需要廣泛采集各類(lèi)型建筑外墻圖像,包括不同光照條件、不同拍攝角度及不同航拍間距等。在裂縫檢測(cè)階段,需要根據(jù)裂縫檢測(cè)精度要求來(lái)設(shè)計(jì)圖像采集方案,規(guī)劃采集路線(xiàn)、航拍間距等以確定裂縫位置及圖像像素比例尺,從而指導(dǎo)裂縫修復(fù)與建筑維護(hù)。

廣泛采集原始建筑外墻圖像以構(gòu)建建筑外墻裂縫數(shù)據(jù)集。共得到建筑外墻裂縫圖像566張,分辨率大小為8 000×6 000。由于采集的圖像分辨率過(guò)大,不利于模型訓(xùn)練,且裁剪后的裂縫圖像細(xì)節(jié)信息更加豐富,于是對(duì)圖像進(jìn)行裁剪。利用滑動(dòng)窗口方法將原圖裁剪為512×512大小的子圖,第1步:從圖像左上角開(kāi)始,沿著自左向右、自上而下的順序依次裁剪,得到子圖165張,保證子圖覆蓋原圖,避免信息丟失;第2步:在圖像左下角7 488×5 488范圍內(nèi)隨機(jī)選擇35個(gè)點(diǎn)作為子圖左下角進(jìn)行裁剪,得到子圖35張,用于信息補(bǔ)充。在完成所有圖像裁剪后,剔除非建筑外墻圖像及不含裂縫的背景圖像后共得到裂縫圖像3 862張。

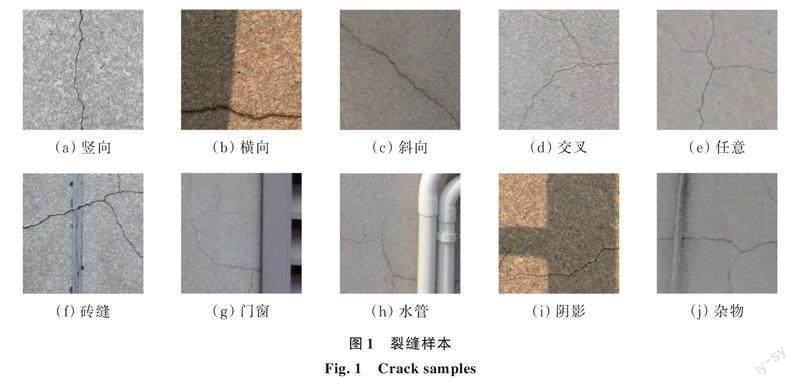

為了確保模型的泛化性能和復(fù)雜背景下裂縫分割的魯棒性,必須保證裂縫圖像數(shù)據(jù)中裂縫樣本及圖像背景的多樣性和復(fù)雜度。無(wú)人機(jī)航拍包括不同天氣狀況、一天的不同時(shí)間段,因光照條件不同,得到明暗程度不同的裂縫圖像;裂縫圖像包含的裂縫類(lèi)型全面,包括縱向、橫向、斜向、交叉及任意分布的裂縫圖像,且圖像背景豐富,包括不同材料建筑外墻下磚縫、門(mén)窗、排水管、陰影及雜物等背景,部分裂縫圖像如圖1所示。

1.2 圖像標(biāo)注

為了保證數(shù)據(jù)集的可靠性,使用開(kāi)源的分割任務(wù)標(biāo)注軟件labelme對(duì)裂縫進(jìn)行人工標(biāo)注。首先,沿著裂縫邊緣逐點(diǎn)勾勒出裂縫的輪廓,生成一個(gè)包含裂縫位置坐標(biāo)的json文件,然后用python代碼將其轉(zhuǎn)化為可供計(jì)算機(jī)學(xué)習(xí)的二值圖像,標(biāo)記結(jié)果如圖2所示。

在完成裂縫數(shù)據(jù)集構(gòu)建后,按照8∶1∶1的比例將數(shù)據(jù)集劃分為訓(xùn)練集、驗(yàn)證集和測(cè)試集,其中訓(xùn)練集3 102張,驗(yàn)證集與測(cè)試集各380張。

2 研究方法

2.1 U-Net模型

U-Net是在全卷積神經(jīng)網(wǎng)絡(luò)的基礎(chǔ)上提出用于醫(yī)學(xué)圖像分割的網(wǎng)絡(luò)模型。該模型是一個(gè)對(duì)稱(chēng)編解碼結(jié)構(gòu),包括編碼器、解碼器兩個(gè)部分。其獨(dú)特之處在于將編碼器中低分辨率特征圖通過(guò)跳躍連接直接拼接到對(duì)應(yīng)解碼器上采樣生成的特征圖,從而有效融合淺層紋理特征和深層語(yǔ)義特征,有利于圖像分割。

編碼器是由兩個(gè)無(wú)填充的3×3卷積重復(fù)應(yīng)用組成,每一個(gè)卷積后面有一個(gè)ReLU激活函數(shù),兩次卷積之后有一個(gè)2×2最大池化,用于下采樣。編碼器一共包含4個(gè)下采樣,每一個(gè)下采樣中,將特征通道的數(shù)量增加一倍,特征圖大小減為一半。編碼器主要負(fù)責(zé)提取輸入圖像的特征信息,并將多個(gè)尺度的特征圖傳入解碼器。

解碼器是模型的加強(qiáng)特征提取網(wǎng)絡(luò),利用轉(zhuǎn)置卷積對(duì)主干網(wǎng)絡(luò)獲取的5個(gè)初步有效特征層進(jìn)行上采用,并進(jìn)行特征融合,最終得到一個(gè)融合了所有特征的有效特征層。

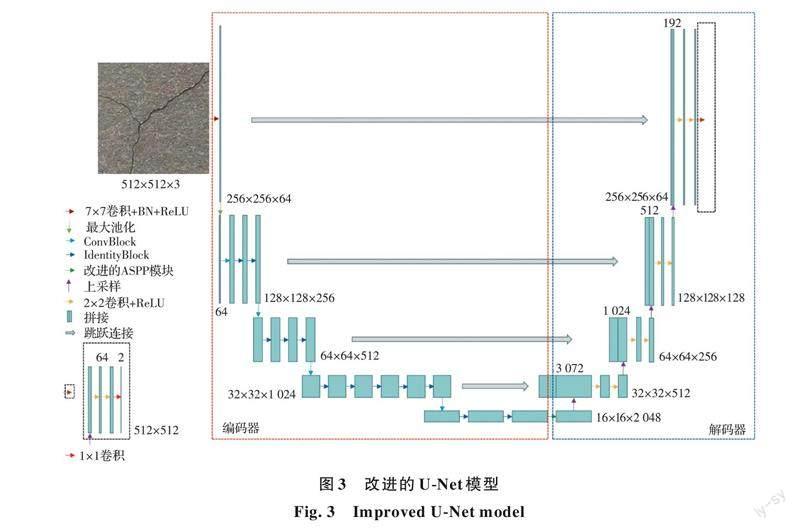

2.2 改進(jìn)的U-Net模型

研究表明:U-Net模型存在細(xì)長(zhǎng)裂縫分割不連續(xù)、復(fù)雜背景下裂縫漏檢及背景誤檢的問(wèn)題。分析其可能原因?yàn)椋?)裂縫圖像正負(fù)樣本分布不均對(duì)模型性能造成影響;2)模型特征提取能力不足導(dǎo)致裂縫漏檢及誤檢;3)缺少獲取多尺度信息的能力導(dǎo)致裂縫分割不連續(xù)及背景誤檢。在分析原因基礎(chǔ)上提出了基于U-Net的改進(jìn)模型,相對(duì)于原模型做出了3點(diǎn)具有針對(duì)性的改進(jìn):1)使用改進(jìn)的損失函數(shù)處理裂縫圖像正負(fù)樣本分布極度不均衡的問(wèn)題;2)使用預(yù)訓(xùn)練的ResNet50網(wǎng)絡(luò)替換原模型的編碼網(wǎng)絡(luò),以提升模型特征表達(dá)能力;3)添加改進(jìn)的ASPP模塊,獲取多尺度上下文信息。網(wǎng)絡(luò)結(jié)構(gòu)如圖3所示。

2.2.1 殘差神經(jīng)網(wǎng)絡(luò)

理論上,神經(jīng)網(wǎng)絡(luò)的層數(shù)越多即深度學(xué)習(xí)模型越深,網(wǎng)絡(luò)的特征表達(dá)能力越強(qiáng)。但神經(jīng)網(wǎng)絡(luò)達(dá)到一定深度時(shí),繼續(xù)加深會(huì)因?yàn)榉聪騻鞑ミ^(guò)程梯度消失導(dǎo)致模型性能變得更差。為了解決這個(gè)問(wèn)題,He等[16]提出了用跳躍連接解決網(wǎng)絡(luò)加深造成梯度消失的殘差神經(jīng)網(wǎng)絡(luò)(ResNet),包括Conv Block和Identity Block兩個(gè)基本模塊,Conv Block改變網(wǎng)絡(luò)的維度,用來(lái)調(diào)整特征圖大小和層數(shù);Identity Block不改變網(wǎng)絡(luò)維度,用來(lái)加深網(wǎng)絡(luò),結(jié)構(gòu)如圖4所示。

基于深度學(xué)習(xí)的方法對(duì)建筑外墻裂縫圖像分割,然而裂縫的標(biāo)注難度較大,自制大型數(shù)據(jù)集成本太高且不實(shí)際,為了克服深度學(xué)習(xí)方法依賴(lài)大量訓(xùn)練樣本的問(wèn)題,引入遷移學(xué)習(xí)方法。基于特征提取的遷移,用ImageNet數(shù)據(jù)集上預(yù)訓(xùn)練好的深度殘差網(wǎng)絡(luò)(刪除最后的平均池化層、全連接層和softmax層),替換U-Net網(wǎng)絡(luò)原來(lái)由兩層卷積加一層池化組成的編碼網(wǎng)絡(luò)。

2.2.2 ASPP模塊

受空間金字塔池化(Spatial Pyramid Pooling, SPP)模塊[8]啟發(fā),Chen等[7]提出了ASPP模塊,結(jié)構(gòu)如圖5所示。

采用并行的多個(gè)具有不同擴(kuò)張率的擴(kuò)張卷積,每個(gè)分支使用不同擴(kuò)張率單獨(dú)進(jìn)行圖像特征提取,并將各分支提取特征進(jìn)行融合,從而提取得到多尺度的圖像信息。該模塊可以有效避免局部信息丟失,增加遠(yuǎn)距離信息的相關(guān)性。

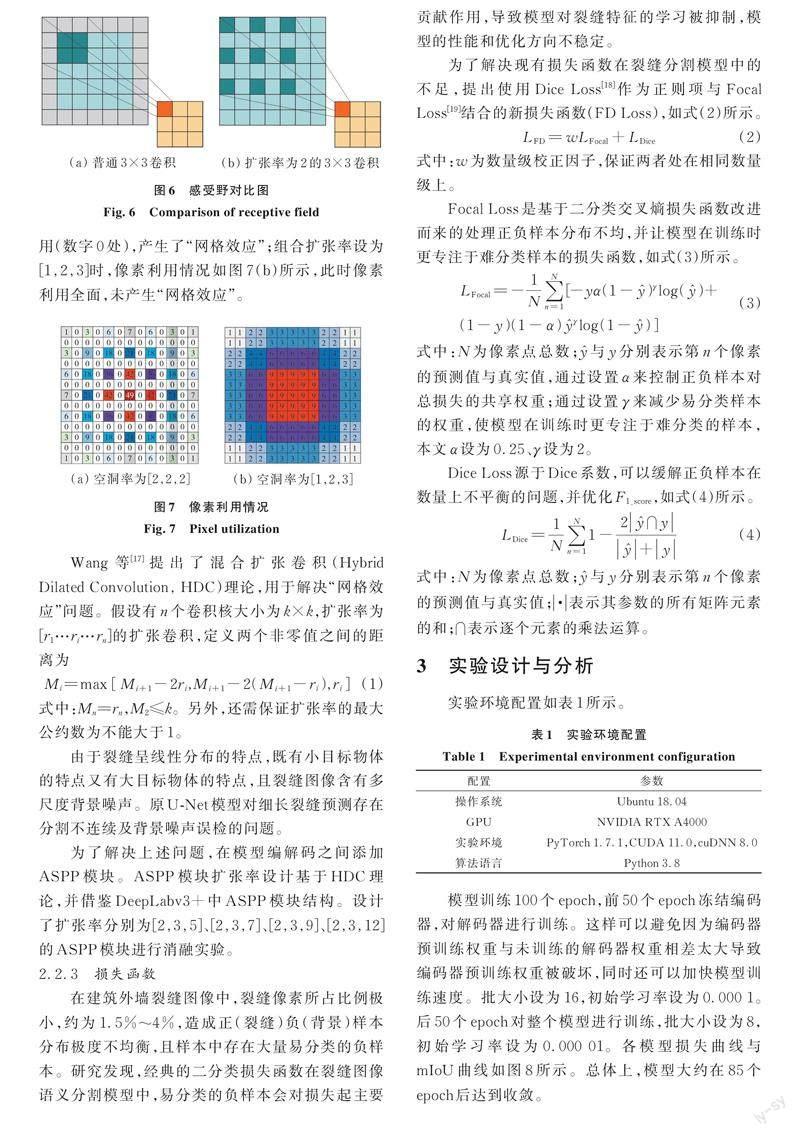

擴(kuò)張卷積是在普通卷積中增加“空洞”來(lái)擴(kuò)大感受野的卷積,相對(duì)于普通卷積增加了“擴(kuò)張率”這個(gè)超參數(shù)。通過(guò)設(shè)置擴(kuò)張率的大小,可以實(shí)現(xiàn)相同參數(shù)量和計(jì)算量下更大的感受野。如圖6所示,擴(kuò)張率為2的3×3卷積核與普通3×3卷積核相比,感受野由3×3擴(kuò)大為5×5。

值得注意的是,組合擴(kuò)張卷積的擴(kuò)張率設(shè)置不當(dāng)會(huì)產(chǎn)生“網(wǎng)格效應(yīng)”。當(dāng)卷積核大小為3×3,組合擴(kuò)張率設(shè)為[2,2,2]時(shí),像素利用情況如圖7(a)所示(數(shù)字表示像素利用次數(shù)),此時(shí),大量像素未被利用(數(shù)字0處),產(chǎn)生了“網(wǎng)格效應(yīng)”;組合擴(kuò)張率設(shè)為[1,2,3]時(shí),像素利用情況如圖7(b)所示,此時(shí)像素利用全面,未產(chǎn)生“網(wǎng)格效應(yīng)”。

Wang等[17]提出了混合擴(kuò)張卷積(Hybrid Dilated Convolution, HDC)理論,用于解決“網(wǎng)格效應(yīng)”問(wèn)題。假設(shè)有n個(gè)卷積核大小為k×k,擴(kuò)張率為[r1…ri…rn]的擴(kuò)張卷積,定義兩個(gè)非零值之間的距離為

式中:Mn=rn,M2≤k。另外,還需保證擴(kuò)張率的最大公約數(shù)為不能大于1。

由于裂縫呈線(xiàn)性分布的特點(diǎn),既有小目標(biāo)物體的特點(diǎn)又有大目標(biāo)物體的特點(diǎn),且裂縫圖像含有多尺度背景噪聲。原U-Net模型對(duì)細(xì)長(zhǎng)裂縫預(yù)測(cè)存在分割不連續(xù)及背景噪聲誤檢的問(wèn)題。

為了解決上述問(wèn)題,在模型編解碼之間添加ASPP模塊。ASPP模塊擴(kuò)張率設(shè)計(jì)基于HDC理論,并借鑒DeepLabv3+中ASPP模塊結(jié)構(gòu)。設(shè)計(jì)了擴(kuò)張率分別為[2,3,5]、[2,3,7]、[2,3,9]、[2,3,12]的ASPP模塊進(jìn)行消融實(shí)驗(yàn)。

2.2.3 損失函數(shù)

在建筑外墻裂縫圖像中,裂縫像素所占比例極小,約為1.5%~4%,造成正(裂縫)負(fù)(背景)樣本分布極度不均衡,且樣本中存在大量易分類(lèi)的負(fù)樣本。研究發(fā)現(xiàn),經(jīng)典的二分類(lèi)損失函數(shù)在裂縫圖像語(yǔ)義分割模型中,易分類(lèi)的負(fù)樣本會(huì)對(duì)損失起主要貢獻(xiàn)作用,導(dǎo)致模型對(duì)裂縫特征的學(xué)習(xí)被抑制,模型的性能和優(yōu)化方向不穩(wěn)定。

3 實(shí)驗(yàn)設(shè)計(jì)與分析

實(shí)驗(yàn)環(huán)境配置如表1所示。

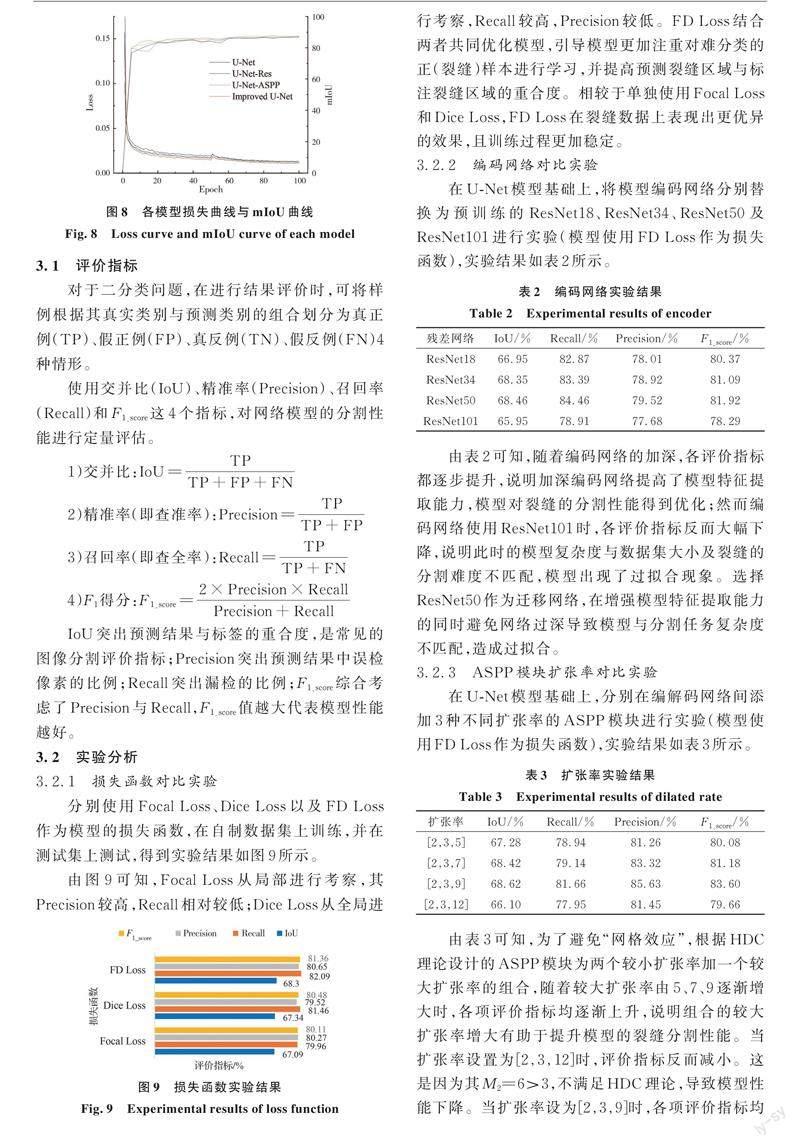

模型訓(xùn)練100個(gè)epoch,前50個(gè)epoch凍結(jié)編碼器,對(duì)解碼器進(jìn)行訓(xùn)練。這樣可以避免因?yàn)榫幋a器預(yù)訓(xùn)練權(quán)重與未訓(xùn)練的解碼器權(quán)重相差太大導(dǎo)致編碼器預(yù)訓(xùn)練權(quán)重被破壞,同時(shí)還可以加快模型訓(xùn)練速度。批大小設(shè)為16,初始學(xué)習(xí)率設(shè)為0.000 1。后50個(gè)epoch對(duì)整個(gè)模型進(jìn)行訓(xùn)練,批大小設(shè)為8,初始學(xué)習(xí)率設(shè)為0.000 01。各模型損失曲線(xiàn)與mIoU曲線(xiàn)如圖8所示。總體上,模型大約在85個(gè)epoch后達(dá)到收斂。

3.1 評(píng)價(jià)指標(biāo)

對(duì)于二分類(lèi)問(wèn)題,在進(jìn)行結(jié)果評(píng)價(jià)時(shí),可將樣例根據(jù)其真實(shí)類(lèi)別與預(yù)測(cè)類(lèi)別的組合劃分為真正例(TP)、假正例(FP)、真反例(TN)、假反例(FN)4種情形。

使用交并比(IoU)、精準(zhǔn)率(Precision)、召回率(Recall)和F1_score這4個(gè)指標(biāo),對(duì)網(wǎng)絡(luò)模型的分割性能進(jìn)行定量評(píng)估。

IoU突出預(yù)測(cè)結(jié)果與標(biāo)簽的重合度,是常見(jiàn)的圖像分割評(píng)價(jià)指標(biāo);Precision突出預(yù)測(cè)結(jié)果中誤檢像素的比例;Recall突出漏檢的比例;F1_score綜合考慮了Precision與Recall,F(xiàn)1_score值越大代表模型性能越好。

3.2 實(shí)驗(yàn)分析

3.2.1 損失函數(shù)對(duì)比實(shí)驗(yàn)

分別使用Focal Loss、Dice Loss以及FD Loss作為模型的損失函數(shù),在自制數(shù)據(jù)集上訓(xùn)練,并在測(cè)試集上測(cè)試,得到實(shí)驗(yàn)結(jié)果如圖9所示。

由圖9可知,F(xiàn)ocal Loss從局部進(jìn)行考察,其Precision較高,Recall相對(duì)較低;Dice Loss從全局進(jìn)行考察,Recall較高,Precision較低。FD Loss結(jié)合兩者共同優(yōu)化模型,引導(dǎo)模型更加注重對(duì)難分類(lèi)的正(裂縫)樣本進(jìn)行學(xué)習(xí),并提高預(yù)測(cè)裂縫區(qū)域與標(biāo)注裂縫區(qū)域的重合度。相較于單獨(dú)使用Focal Loss和Dice Loss,F(xiàn)D Loss在裂縫數(shù)據(jù)上表現(xiàn)出更優(yōu)異的效果,且訓(xùn)練過(guò)程更加穩(wěn)定。

3.2.2 編碼網(wǎng)絡(luò)對(duì)比實(shí)驗(yàn)

在U-Net模型基礎(chǔ)上,將模型編碼網(wǎng)絡(luò)分別替換為預(yù)訓(xùn)練的ResNet18、ResNet34、ResNet50及ResNet101進(jìn)行實(shí)驗(yàn)(模型使用FD Loss作為損失函數(shù)),實(shí)驗(yàn)結(jié)果如表2所示。由表2可知,隨著編碼網(wǎng)絡(luò)的加深,各評(píng)價(jià)指標(biāo)都逐步提升,說(shuō)明加深編碼網(wǎng)絡(luò)提高了模型特征提取能力,模型對(duì)裂縫的分割性能得到優(yōu)化;然而編碼網(wǎng)絡(luò)使用ResNet101時(shí),各評(píng)價(jià)指標(biāo)反而大幅下降,說(shuō)明此時(shí)的模型復(fù)雜度與數(shù)據(jù)集大小及裂縫的分割難度不匹配,模型出現(xiàn)了過(guò)擬合現(xiàn)象。選擇ResNet50作為遷移網(wǎng)絡(luò),在增強(qiáng)模型特征提取能力的同時(shí)避免網(wǎng)絡(luò)過(guò)深導(dǎo)致模型與分割任務(wù)復(fù)雜度不匹配,造成過(guò)擬合。

3.2.3 ASPP模塊擴(kuò)張率對(duì)比實(shí)驗(yàn)

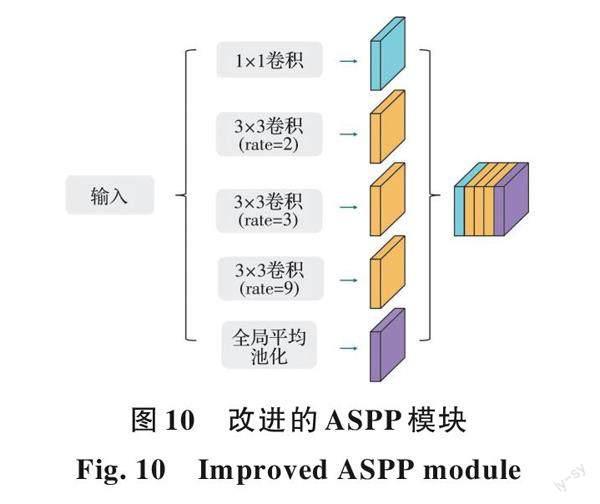

在U-Net模型基礎(chǔ)上,分別在編解碼網(wǎng)絡(luò)間添加3種不同擴(kuò)張率的ASPP模塊進(jìn)行實(shí)驗(yàn)(模型使用FD Loss作為損失函數(shù)),實(shí)驗(yàn)結(jié)果如表3所示。由表3可知,為了避免“網(wǎng)格效應(yīng)”,根據(jù)HDC理論設(shè)計(jì)的ASPP模塊為兩個(gè)較小擴(kuò)張率加一個(gè)較大擴(kuò)張率的組合,隨著較大擴(kuò)張率由5、7、9逐漸增大時(shí),各項(xiàng)評(píng)價(jià)指標(biāo)均逐漸上升,說(shuō)明組合的較大擴(kuò)張率增大有助于提升模型的裂縫分割性能。當(dāng)擴(kuò)張率設(shè)置為[2,3,12]時(shí),評(píng)價(jià)指標(biāo)反而減小。這是因?yàn)槠銶2=6>3,不滿(mǎn)足HDC理論,導(dǎo)致模型性能下降。當(dāng)擴(kuò)張率設(shè)為[2,3,9]時(shí),各項(xiàng)評(píng)價(jià)指標(biāo)均達(dá)到最高,模型分割性能最優(yōu)。基于此,改進(jìn)的ASPP模塊選擇擴(kuò)張率為[2,3,9]的一組擴(kuò)張卷積,結(jié)構(gòu)如圖10所示。

改進(jìn)的ASPP模塊首先使用一個(gè)1×1的普通卷積作為第1層,保留原特征圖以補(bǔ)充空間信息;然后使用擴(kuò)張率為[2,3,9]的擴(kuò)張卷積作為2到4層,提取多尺度物體的特征;最后使用全局平均池化作為第5層,獲取全局特征。

3.2.4 消融實(shí)驗(yàn)

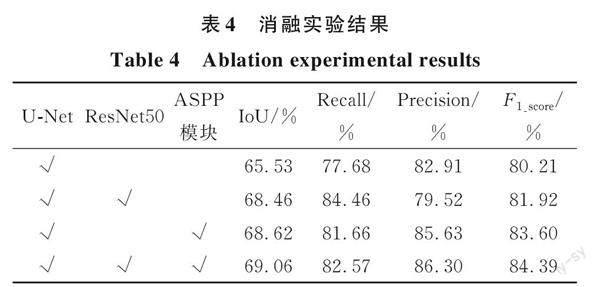

為了驗(yàn)證改進(jìn)策略對(duì)提高模型分割性能的有效性,在自制數(shù)據(jù)集上進(jìn)行消融實(shí)驗(yàn)。分別驗(yàn)證進(jìn)行遷移學(xué)習(xí)、添加改進(jìn)的ASPP模塊以及二者組合對(duì)模型分割效果的影響(模型都使用FD Loss作為損失函數(shù)),實(shí)驗(yàn)結(jié)果如表4所示。

比較實(shí)驗(yàn)結(jié)果可知,在改進(jìn)損失函數(shù)的基礎(chǔ)上用ResNet50替換編碼網(wǎng)絡(luò),Recall提升了6.78%,同時(shí)IoU、Precision和F1_score都有相應(yīng)的提升,說(shuō)明引入遷移學(xué)習(xí)的U-Net模型可以提取更豐富的裂縫特征,減少了部分裂縫不能被準(zhǔn)確分割的狀況;在改進(jìn)損失函數(shù)的基礎(chǔ)上添加改進(jìn)的ASPP模塊,Precision提升了2.72%,同時(shí)IoU、Recall和F1_score都有相應(yīng)的提升,說(shuō)明改進(jìn)的ASPP模塊獲取多尺度上下文信息的能力在U-Net模型中得到利用,降低了將背景誤檢為裂縫的狀況,保證了裂縫分割的連續(xù)性;改進(jìn)的U-Net模型是在改進(jìn)損失函數(shù)的基礎(chǔ)上引入遷移學(xué)習(xí)方法并加入改進(jìn)的ASPP模塊,與單個(gè)改進(jìn)策略相比,以上評(píng)價(jià)指標(biāo)都有一定的提升,說(shuō)明用ResNet50替代編碼網(wǎng)絡(luò)與添加改進(jìn)的ASPP模塊可以共同優(yōu)化模型,并提升模型性能。與原模型相比,IoU指標(biāo)和F1_score分別提升了3.53%、4.18%,說(shuō)明所提改進(jìn)策略有效提升了模型的裂縫分割性能。

3.2.5 經(jīng)典語(yǔ)義分割模型對(duì)比

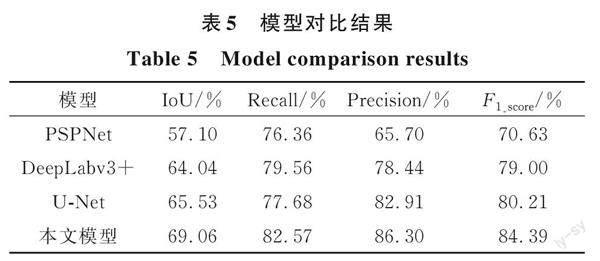

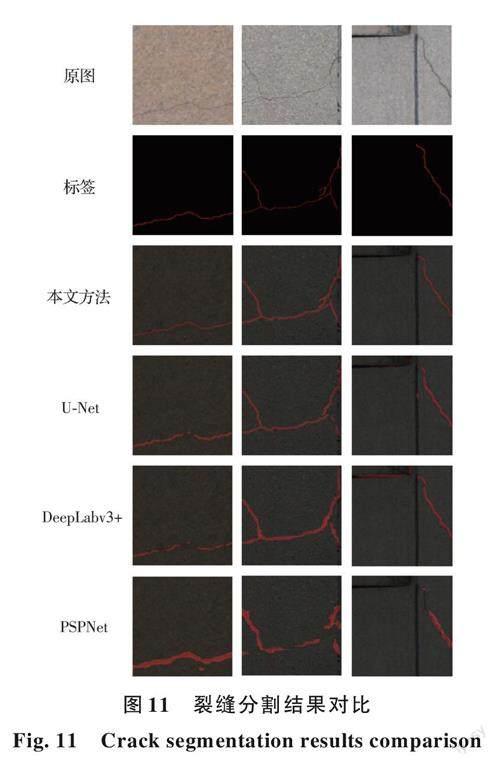

為了驗(yàn)證改進(jìn)模型的先進(jìn)性和魯棒性,在自制建筑外墻裂縫數(shù)據(jù)集上復(fù)現(xiàn)了經(jīng)典語(yǔ)義分割模型U-Net、DeepLabv3+及PSPNet,并與模型進(jìn)行對(duì)比。為了確保實(shí)驗(yàn)有效性,各模型在相同實(shí)驗(yàn)參數(shù)下進(jìn)行訓(xùn)練。通過(guò)評(píng)價(jià)指標(biāo)與分割結(jié)果進(jìn)行定性與定量地對(duì)比模型性能。不同模型在建筑外墻裂縫數(shù)據(jù)集上實(shí)驗(yàn)結(jié)果如表5所示。

由表5可知,改進(jìn)的U-Net模型各項(xiàng)評(píng)價(jià)指標(biāo)分別為69.06%、82.57%、86.3%、84.39%,均高于其他語(yǔ)義分割模型,說(shuō)明模型對(duì)建筑外墻裂縫分割具有最優(yōu)的性能。

為了更直觀(guān)地對(duì)比經(jīng)典模型與本文模型對(duì)建筑外墻裂縫圖像的分割效果,選取3張分別包含細(xì)長(zhǎng)裂縫、任意分布裂縫及復(fù)雜背景噪聲的裂縫圖像進(jìn)行預(yù)測(cè),得到各模型的分割結(jié)果如圖11所示。

由圖11可知,經(jīng)典語(yǔ)義分割模型在裂縫數(shù)據(jù)集上訓(xùn)練后均能進(jìn)行裂縫分割,但由于原模型并非針對(duì)裂縫特征進(jìn)行設(shè)計(jì),故裂縫分割效果較差,存在大量漏檢和誤檢的情況。對(duì)比經(jīng)典模型分割效果可知,U-Net模型對(duì)裂縫的分割效果較理想,存在少量誤檢和漏檢的情況;Deeplabv3+模型對(duì)裂縫的分割效果較U-Net要差,漏檢和誤檢情況更加明顯;PSPNet模型對(duì)裂縫的分割效果較差,不僅分割粗糙,且存在大量漏檢和誤檢。與經(jīng)典模型相比,針對(duì)裂縫特征改進(jìn)的U-Net模型對(duì)裂縫分割不僅準(zhǔn)確,而且分割精細(xì),與標(biāo)簽圖像基本一致;與U-Net模型相比,改進(jìn)模型解決了原模型細(xì)長(zhǎng)裂縫分割不連續(xù)、復(fù)雜背景下裂縫漏檢及背景誤檢的問(wèn)題。

4 結(jié)論

針對(duì)建筑外墻裂縫人工檢測(cè)方法效率低、檢測(cè)效果和安全性差的問(wèn)題,提出基于無(wú)人機(jī)航拍與計(jì)算機(jī)視覺(jué)的裂縫檢測(cè)方法。針對(duì)U-Net模型存在的問(wèn)題進(jìn)行改進(jìn),并進(jìn)行對(duì)比實(shí)驗(yàn),得出以下結(jié)論:

1)無(wú)人機(jī)靈活性強(qiáng),可以繞建筑飛行并快速獲取高清的外墻圖像。在構(gòu)建裂縫數(shù)據(jù)集和建筑外墻裂縫定期檢測(cè)階段,可以使用無(wú)人機(jī)繞建筑航拍實(shí)現(xiàn)安全、高效地采集建筑外墻圖像。

2)提出了組合Focal Loss與Dice Loss的FD Loss,用于模型優(yōu)化。新?lián)p失函數(shù)具有更強(qiáng)的處理正負(fù)樣本分布不均的能力,保證了模型訓(xùn)練過(guò)程的穩(wěn)定性,并提高了模型對(duì)裂縫的分割性能。

3)所提改進(jìn)的U-Net模型增強(qiáng)了模型編碼網(wǎng)絡(luò)的特征提取能力,以及模型獲取多尺度上下文信息的能力,解決了原模型細(xì)長(zhǎng)裂縫分割不連續(xù)、復(fù)雜背景下裂縫漏檢及背景誤檢的問(wèn)題,IoU指標(biāo)和F1_score分別提升了3.53%、4.18%。實(shí)驗(yàn)表明,改進(jìn)的U-Net模型可以對(duì)復(fù)雜背景下的裂縫進(jìn)行準(zhǔn)確識(shí)別,具有較強(qiáng)的魯棒性。

4)所提基于無(wú)人機(jī)航拍與計(jì)算機(jī)視覺(jué)的建筑外墻裂縫檢測(cè)方法,使用無(wú)人機(jī)獲取裂縫圖像,并利用改進(jìn)的U-Net模型對(duì)裂縫進(jìn)行檢測(cè)。該方法解決了傳統(tǒng)建筑外墻裂縫檢測(cè)方法需要人工高空作業(yè)帶來(lái)的安全問(wèn)題,并提高了裂縫檢測(cè)的效率和精度。

參考文獻(xiàn)

[1]? 周穎, 劉彤. 基于計(jì)算機(jī)視覺(jué)的混凝土裂縫識(shí)別[J]. 同濟(jì)大學(xué)學(xué)報(bào)(自然科學(xué)版), 2019, 47(9): 1277-1285.

ZHOU Y, LIU T. Computer vision-based crack detection and measurement on concrete structure [J]. Journal of Tongji University (Natural Science), 2019, 47(9): 1277-1285. (in Chinese)

[2]? MUNAWAR H S, HAMMAD A W A, HADDAD A, et al. Image-based crack detection methods: A review [J]. Infrastructures, 2021, 6(8): 115.

[3]? DAIS D, BAL I E, SMYROU E, et al. Automatic crack classification and segmentation on masonry surfaces using convolutional neural networks and transfer learning [J]. Automation in Construction, 2021, 125: 103606.

[4]? 宋立博, 費(fèi)燕瓊. 兩類(lèi)YOLOv4-tiny簡(jiǎn)化網(wǎng)絡(luò)及其裂縫檢測(cè)性能比較[J]. 同濟(jì)大學(xué)學(xué)報(bào)(自然科學(xué)版), 2022, 50(1): 129-137.

SONG L B, FEI Y Q. Comparison of two types YOLOv4-tiny simplified networks and their crack detection performance [J]. Journal of Tongji University (Natural Science), 2022, 50(1): 129-137. (in Chinese)

[5]? JU H Y, MA T, LI W, et al. Pixelwise asphalt concrete pavement crack detection via deep learning-based semantic segmentation method [J]. Structural Control and Health Monitoring, 2022, 29(8): e2974.

[6]? RONNEBERGER O, FISCHER P, BROX T. U-Net: Convolutional networks for biomedical image segmentation [C]//Proceedings of the 18th International Conference on Medical Image Computing and Computer-Assisted Intervention. Munich, Germany. 2015: 234-241.

[7]? CHEN L C, ZHU Y K, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation [C]//Proceedings of the 15th European Conference on Computer Vision. Munich, Germany. 2018: 833-851.

[8]? ZHAO H S, SHI J P, QI X J, et al. Pyramid scene parsing network [C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA. IEEE, 2017: 6230-6239.

[9]? 李良福, 王楠, 武彪, 等. 基于改進(jìn)PSPNet的橋梁裂縫圖像分割算法[J]. 激光與光電子學(xué)進(jìn)展, 2021, 58(22): 101-109.

LI L F, WANG N, WU B, et al. Segmentation algorithm of bridge crack image based on modified PSPNet [J]. Laser & Optoelectronics Progress, 2021, 58(22): 101-109. (in Chinese)

[10]? LI G, LI X, ZHOU J, et al. Pixel-level bridge crack detection using a deep fusion about recurrent residual convolution and context encoder network [J]. Measurement, 2021, 176: 109171.

[11]? 曹錦綱, 楊國(guó)田, 楊錫運(yùn). 基于注意力機(jī)制的深度學(xué)習(xí)路面裂縫檢測(cè)[J]. 計(jì)算機(jī)輔助設(shè)計(jì)與圖形學(xué)學(xué)報(bào), 2020, 32(8): 1324-1333.

CAO J G, YANG G T, YANG X Y. Pavement crack detection with deep learning based on attention mechanism [J]. Journal of Computer-Aided Design & Computer Graphics, 2020, 32(8): 1324-1333. (in Chinese)

[12]? NGUYEN N H T, PERRY S, BONE D, et al. Two-stage convolutional neural network for road crack detection and segmentation [J]. Expert Systems with Applications, 2021, 186: 115718.

[13]? 孟慶成,李明健,萬(wàn)達(dá),等.基于M-Unet的混凝土裂縫實(shí)時(shí)分割算法[J].土木與環(huán)境工程學(xué)報(bào)(中英文), 2024, 46(1): 215-222.

MENG Q C, LI M J, WAN D, et al. Real-time concrete crack segmentation algorithm based on M-Unet [J]. Journal of Civil and Environmental Engineering, 2024, 46(1): 215-222. (in Chinese)

[14]? DANG L M, WANG H, LI Y, et al. Automatic tunnel lining crack evaluation and measurement using deep learning [J]. Tunnelling and Underground Space Technology, 2022, 124: 104472.

[15]? LI Y, ZHANG J H, GUAN Z G, et al. Experimental study on the correlation between crack width and crack depth of RC beams [J]. Materials, 2021, 14(20): 5950.

[16]? HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. IEEE, 2016: 770-778.

[17]? WANG P Q, CHEN P F, YUAN Y, et al. Understanding convolution for semantic segmentation [C]//2018 IEEE Winter Conference on Applications of Computer Vision. Lake Tahoe, NV, USA. IEEE, 2018: 1451-1460.

[18]? MILLETARI F, NAVAB N, AHMADI S A. V-net: Fully convolutional neural networks for volumetric medical image segmentation [C]//2016 Fourth International Conference on 3D Vision (3DV). Stanford, CA, USA. IEEE, 2016: 565-571.

[19]? LIN T Y, GOYAL P, GIRSHICK R, et al. Focal loss for dense object detection [C]//2017 IEEE International Conference on Computer Vision. Venice, Italy. IEEE, 2017: 2999-3007.

(編輯? 胡玲)

DOI: 10.11835/j.issn.2096-6717.2022.145

收稿日期:2022?09?27

基金項(xiàng)目:湖南省自然科學(xué)基金(2021JJ30716);湖南省高新技術(shù)產(chǎn)業(yè)科技創(chuàng)新引領(lǐng)計(jì)劃(2020KG2026);長(zhǎng)沙理工大學(xué)土木工程優(yōu)勢(shì)特色重點(diǎn)學(xué)科創(chuàng)新性項(xiàng)目(16ZDXK05)

作者簡(jiǎn)介:劉少華(1999- ),男,主要從事計(jì)算機(jī)視覺(jué)與健康監(jiān)測(cè)研究,E-mail:liushaohua2020@163.com。

Received: 2022?09?27

Foundation items: Natural Science Foundation of Hunan Province (No. 2021JJ30716); High-Tech Industry Science and Technology Innovation Leading Plan Project of Hunan Province (No. 2020KG2026); Civil Engineering Advantage Characteristic Key Discipline Innovation Project of Changsha University of Science and Technology (No. 16ZDXK05)

Author brief: LIU Shaohua (1999- ), main research interests: computer vision and health monitoring, E-mail: liushaohua2020@163.com.