基于對齊卷積和橢圓損失函數的遙感圖像目標檢測算法

鄭凌云, 李佐勇, 蔡遠征,4, 唐鄭熠

(1.福建工程學院計算機科學與數學學院, 福建 福州 350118;2.閩江學院計算機控制與工程學院, 福建 福州 350121;3.福建省信息處理與智能控制重點實驗室, 福建 福州 350121;4.四創科技有限公司, 福建 福州 350100)

0 引言(Introduction)

近年來,卷積神經網絡(Convolutional Neural Network)已成功應用于計算機視覺領域的各種任務中[1-7]。得益于神經網絡的蓬勃發展,當前遙感圖像識別網絡主要圍繞經典的檢測器構建,從2017年的旋轉視網膜網絡(Rotated Retinanet)開始,遙感目標檢測的研究逐漸受到關注[8-9]。遙感目標檢測使用主干網絡的相同特征進行學習,但是分類分數和定位精度一般不會匹配,對高分類分數的目標不利。目前的損失函數側重于沿用水平框的面積計算得出交并比(Intersection over Union,IoU),導致在大長寬比的旋轉框下,細微角度的偏差會導致IoU偏差巨大,容易讓網絡過擬合。為了克服上述問題,本文提出一種基于對齊卷積和橢圓損失函數的遙感圖像目標檢測算法,該網絡引入對齊卷積,可以根據尺度、形狀和方向生成對齊特征,達到提升精度的目的;使用橢圓框,減少學習過程中IoU損失函數振蕩;使用均方誤差損失進一步優化回歸損失。

1 相關工作(Related work)

隨著深度學習的發展,目前的檢測器分為兩種類別,即單級檢測器和兩級檢測器。單級檢測器只需提取一次特征即可實現目標檢測,其速度比兩級檢測器快,但總體精度略低。目前的單級檢測器例如YOLO(You Only Look Once)[10],能直接完成從特征到分類和回歸的預測,使用相同的完全連接層實現分類和回歸。SSD(Single Shot MultiBox Detector)[11]網絡是一個完全卷積網絡,即通過VGG16進行特征提取后,提取38×38、19×19、10×10、5×5、3×3和1×1六層不同尺度的特征,用于SSD分類和回歸。兩級檢測器需要提取多種特征,學習速度慢,但是精度高于單級檢測器。常見的兩級檢測器包括R-CNN[12]、Fast R-CNN[13]、Faster R-CNN[14]、Mask R-CNN[15]和Feature Pyramid Network(FPN)[16]。FPN網絡構建了一個特征金字塔,可以學習不同尺度的特征和處理大規模的對象變化。綜上所述,上述檢測模型主要依賴兩階段網絡分別進行特征提取和識別。

目前研究人員在遙感圖像識別領域取得了如下的研究成果。ReDet[17]用于提取旋轉等變特征,可以準確預測方向并大幅度減小模型尺寸。滑動頂點(Gliding Vertex)[7]方法沒有回歸通常矩形的4個頂點,而是在每個矩形框上移動頂點形成旋轉框。旋轉不變CNN在現有CNN體系結構的基礎上,引入和學習一個新的旋轉不變層[18]。LIU等[19]構建了一個近似封閉的船舶旋轉框空間,WANG等[20]提出了一個中心地圖OBB(Oriented Bounding Boxes),通過減少OBB中背景因素進而更好地表示OBB。通過在經典的水平邊界框表示法中添加四個滑動偏移變量,可以獲得圖像的新表示法,檢測器也可以學習新的特征。YANG等[8]提出的RepPoints是一種新的對象檢測表示,它由一組表示對象空間范圍和語義重要局部區域的點組成。這種表示是通過弱定位監督和矩形錨點隱式識別反饋實現學習的。ZHANG等[21]開發的CAD-net(Context-Aware Detection Network)由全局上下文網絡組成,該網絡利用注意力調制特征以及聯系全局特征與局部特征檢測圖像。

2 方法(Method)

2.1 網絡架構

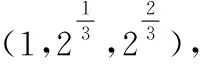

圖1 單階段對齊檢測網絡框架Fig.1 Single-stage alignment detection network framework

2.2 對齊卷積模塊

標準的卷積可以用公式(1)表示:

(1)

其中:W表示卷積核的參數,r為卷積像素相對于當前位置的偏移,p表示當前卷積的空間位置,R為常規的采樣位置。

本文研究的網絡中,在改進視網膜網絡模塊中增加了對齊卷積模塊(Alignment Convolution Module),與標準卷積不同的是,對齊卷積增加了一個偏移量o:

(2)

其中:o為采樣到的錨框坐標和真實值之間的偏差值,p中含有如下參數(x,y,h,θ)表示p位置的錨框,對于每個規則位置的r,基于錨框的采樣位置為

(3)

(4)

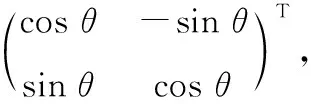

圖2為對齊卷積網絡模塊的圖例,通過在網絡中加入對齊卷積將W*H*KA錨框中預測的位置解碼成旋轉矩形(x,w,h,θ),K為分類的類別,在DOTA1.0數據集中的K為15,本次實驗采用9個不同的錨框,所以A為9。與輸入特征一起計算對齊卷積,提取對齊卷積的特征。對齊卷積網絡模塊由輸入通道和輸出通道都為256的5層可變形卷積組成,經每個卷積層后使用ReLU作為激活函數。

圖2 對齊卷積網絡模塊Fig.2 Aligned convolutional network module

2.3 橢圓損失函數(Elliptic loss function)

計算橢圓IoU的流程如圖3所示,首先將邊界框轉換為高斯分布,將邊界框的中心點重合,其次使用卡爾曼濾波獲得重疊區域的分布函數,最后將得到的分布函數值和旋轉框計算IoU。

(a)將矩形框轉變為橢圓框

2D旋轉框可轉換為高斯分布G(μ,Σ)形式表示:

Σ=RΛRT

(5)

μ=(x,y)T

(6)

其中,R表示旋轉矩陣,Λ表示特征值的對角矩陣。

對于2D目標B2(x,y,h,w,θ):

(7)

(8)

此處,可基于方差公式計算出高斯分布旋轉框的面積VB,由于遙感圖像識別檢測的是二維平面,因此此處帶入n=2,并使用協方差累乘,可得面積VB公式如下:

(9)

進一步引入高斯分布計算預測框與真實值之間的重疊部分的面積Gs,該過程可以通過由兩個高斯分布G1和G2的乘積得到:

αGs(μ,Σ)=G1(μ1,Σ1)G2(μ2,Σ2)

(10)

其中:α可以表示為

α=Gα(μ2,Σ1+Σ2)

(11)

μ、Σ可表示為

(12)

公式(12)中,K=Σ1(Σ1+Σ2)-1。需要注意的是,公式(12)計算后得到的高斯分布的協方差Σ,與協方差Σ1與Σ2有關,該公式沒有體現出位置對于協方差的影響,其原因在于該計算過程中采用的高斯分布αGs(μ,Σ)并不是標準高斯分布,不能在不考慮中心點系數α的情況下,直接計算出重疊面積。在計算面積時,要同時把α考慮進去。所以,引入中心點損失使得兩個分布同中心,這樣就不需要考慮中心點系數。橢圓損失函數如下:

(13)

接下來,我們就可以將軸對齊的框的特征轉換成任意方向上的特征。

2.4 損失函數

在單階段圖像識別中,正樣本僅占很少的一部分,更多的負樣本對訓練沒有幫助。本次實驗不使用傳統的交叉熵損失函數,改為使用能解決正負樣本不平衡問題的Focal Loss損失函數。

Focal Loss損失函數定義如下:

LossF=-(1-pt)γlog(pt)

(14)

其中:γ是范圍在[0,5]的參數,pt定義為

(15)

其中:p為模型屬于前景的概率,y的取值為1和-1,分別代表前景和背景。(1-pt)γ作為一個調制因子,當背景容易分辨時,(1-pt)γ較低,說明對損失的貢獻較小,即降低了易區分樣本的損失比例。

由于SmoothL1損失函數對長寬比完全不敏感,所以本次實驗在回歸網絡中使用均方誤差損失,公式如下[24]:

(16)

其中:y為真實值,y0為預測值。

均方誤差損失的優點在于函數曲線連續、光滑、處處可導,適用于梯度下降算法,并且誤差減小時,損失也會減小,有利于收斂。即使使用固定的學習速率,也能很好地收斂到最小值。

在本文的SAN網絡中,不同的網絡模塊損失函數的計算方式不同,視網膜模塊損失函數的計算方法為

Losstotal=LossF+LossE

(17)

旋轉檢測模塊損失函數的計算方法為

(18)

3 實驗(Experiment)

3.1 數據集

DOTA[25]是一個用于定向目標檢測的大型航空圖像數據集,目前一共有DOTA1.0、DOTA1.5、DOTA2.0三個版本。DOTA1.0包含2 806張800×800~4 000×4 000的圖像和188 282個實例,包含15個常見目標類別:飛機(PL)、棒球場(BD)、橋梁(BR)、田徑場(GTF)、小型車輛(SV)、大型車輛(LV)、船舶(SH)、網球場(TC)、籃球場(BC)、儲罐(ST)、足球場(SBF)、環島(RA)、港口(HA)、游泳池(SP)和直升機(HC)。其中,數據集的1.5版本使用了和1.0版本相同的圖片,但是額外標注了非常小的目標(小于10個像素),并且多了一個類別(集裝箱起重機,CC),而DOTA2.0包含了18個類別,并且有11 268張圖像和1 793 658個實例。與DOTA v1.5相比,DOTA2.0進一步增加了新的圖像類別。

DOTA數據集提供了訓練集、驗證集和測試集,其中測試集的數據不公開。將訓練集和驗證集的數據都用于訓練。在DOTA之后,從原始圖像中裁剪了一系列1 024×1 024的補丁,步幅為824。為了避免過擬合,沒有使用其他技巧。

HRSC2016是一個帶有旋轉框的船舶檢測數據集,包含1 061張船舶的遙感圖像,大小范圍為300×300~1 500×900。訓練集、驗證集和測試集分別包含436、181和444張圖像。使用訓練集、驗證集進行訓練,測試集用于測試。根據原網絡的設置不同,把所有圖像的大小改為800×512或者512×800,但不改變圖像的長寬比。訓練過程采用隨機翻轉方式,隨機翻轉的方向包含水平和豎直方向。

3.2 實驗設置

本次實驗在兩張NVIDIA RTX A4000的環境下運行,實驗都使用ResNet50初始化。所有網絡使用同樣的參數設置,學習率為0.002 5,動量和動量衰減分別為0.9和0.000 1,在DOTA數據集下,epoch為12,在HRSC2016數據集中,epoch為36。使用SGD梯度衰減。

在DOTA數據集中,本次實驗采用平均精度均值(mAP)作為評價指標,此評價指標被PASCAL VOC、COCO、ImageNET、Google Open Image Challenge等圖像檢測比賽所使用。在mAP的計算中,涉及以下概念。

TP:實際為正樣本,同時被分類器劃分為正樣本的樣本數。

FP:實際為正樣本,但是被分類器劃分為負樣本的樣本數。

FN:實際為負樣本,但是被分類器劃分為正樣本的樣本數。

TN:實際為負樣本,同時被分類器劃分為負樣本的樣本數。

召回率Recall的計算方式為

(19)

準確率Precision的計算方式為

(20)

P-R曲線是所有Precision-Recall點連成的曲線,用于計算AP值。通常,P在縱軸,R在橫軸,P值越高,R值越低。AP值就是P-R曲線圍成的面積,由于檢測精度需要IoU作為度量的邊界,使用不同IoU度量的P-R曲線的AP值也不同,mAP是使用不同IoU得出的AP值的均值。AP50是IoU閾值取0.5時得出的AP值,研究人員在HRSC2016數據集中使用此評判方法。

將典型的Rotate Retina Net(RR)作為基線,視網膜網絡作為單級檢測器檢測速度快,但也會因為添加了模塊而增加了計算量。視網膜網絡的焦點損失表現較好,在當時精度超過了二級檢測器,計算速度超過了單級檢測器,是一個很好的挑戰目標。

3.3 實驗結果

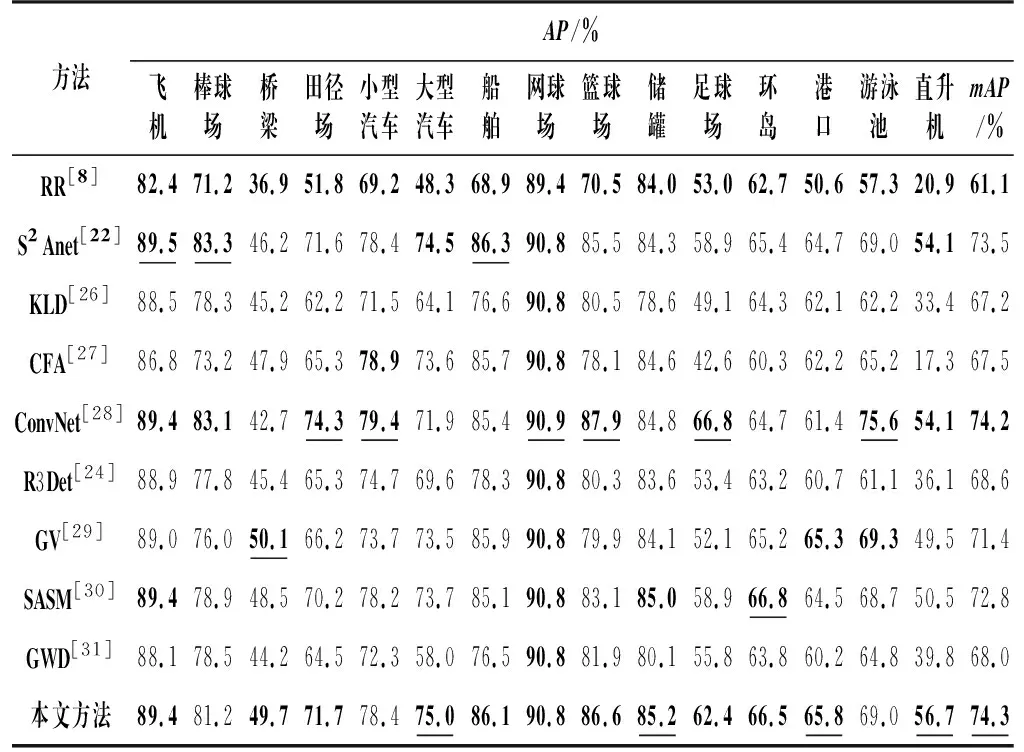

表1是本文方法與當前的主流網絡的精度對比結果,表1中有些網絡的名稱使用縮寫,黑體數字下劃線表示類別中最高的精度,黑體數字表示次高的精度,可以看到,本文方法的mAP比基線方法提高了13.2%,比當前主流網絡有了較大的提升,并且對難以識別的一些目標(直升機、田徑場、大型汽車)也表現出最優的檢測效果。在大長寬比的物體識別中,對比其他的網絡的mAP也有較大的提升,說明網絡改進的方向是正確的。

表1 本文方法與各個主流網絡的精度比較

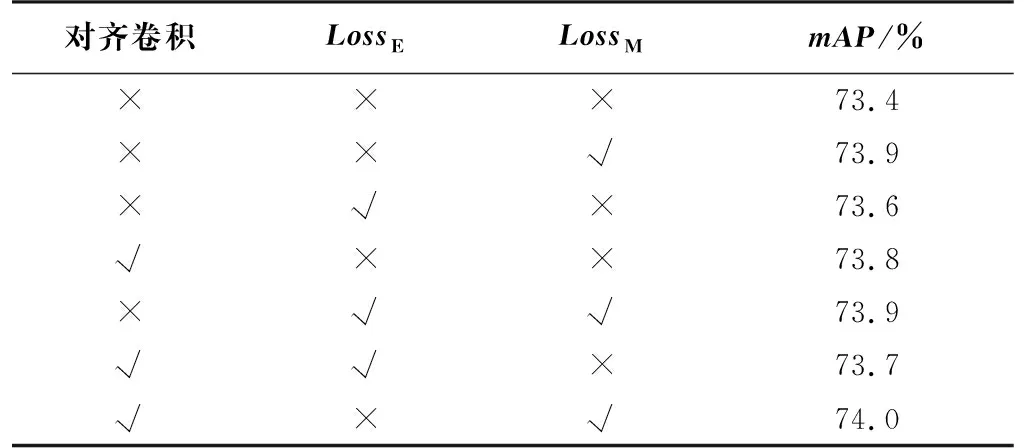

對網絡進行消融實驗,分別對網絡是否添加了橢圓損失函數、對齊卷積和均方誤差損失做了對比,如表2所示,對齊卷積網絡模塊能讓網絡學習到角度信息、橢圓損失函數能夠更加精確地計算交并比、均方誤差損失函數能優化梯度計算。從表2中可以看到,當使用了更多的對齊卷積或者卷積函數時,精度會比沒使用或者使用更少的方法高,證明每個模塊的引用是有意義的。

表2 使用不同算法的結果

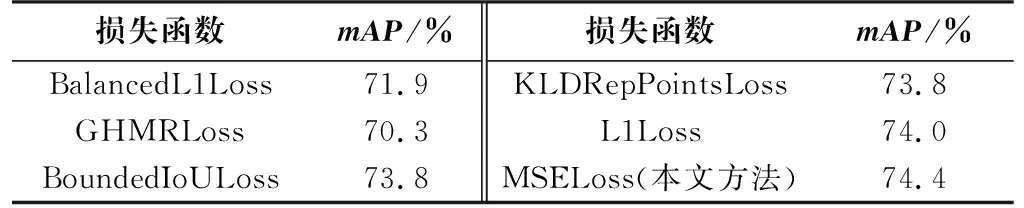

替換旋轉檢測網絡模塊中的回歸損失函數,比較結果如表3所示,從表3中可以看到,在相同的網絡下,均方誤差損失在本文方法里發揮的最好,均方誤差損失便于梯度下降和利于收斂的性質更契合本文網絡,并且模塊的增多也會相應地提升精確率。

表3 本文方法與其他損失函數的比較

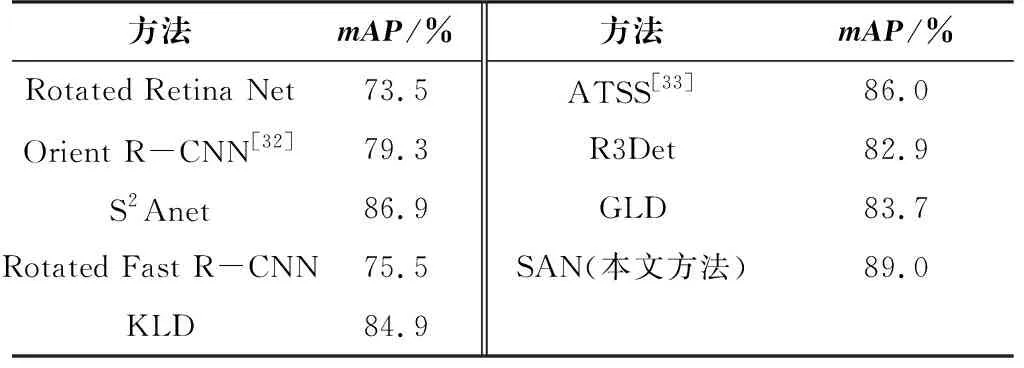

表4是本文方法與其他主流方法在HRSC2016數據集上的結果。我們用AP50作為評判標準。在HRSC2016數據集上,本文所提網絡的精確率比基線提高了15.5%,并且優于當前的主流方法。HRSC2016數據集包含的船舶目標都是任意方向和大長寬比的,表明本文所提網絡在遙感圖像識別領域的表現出色。

表4 各方法在HRSC2016數據集上的結果

圖4是DOTA實例的識別結果。對于相同的圖像,圖4(b)和圖4(d)是本文網絡的實驗結果,圖4(a)和圖4(c)是基線的實驗結果。基線網絡對于角度的回歸不是很穩定,會出現檢測框大小正確,但方向有誤的情況。圖4(a)和圖4(b)展示了常見的遙感圖像,從中可以看出遙感圖像的目標更加密集,本文方法對于每個目標的置信度相對于基線方法更高,并且旋轉框的定位更加準確,在圖像尺寸明顯增大的情況下,基線方法有較大的缺點:旋轉框的定位不精確,會出現明顯的角度偏差,并且由于圖像尺寸過大,導致某些目標難以檢測。本網絡顯著提升了定位精度和置信度,也能檢測出基線網絡檢測不出來的實例。

(a)基線方法

4 結論(Conclusion)

本文研究了遙感目標檢測技術的發展現狀以及目前存在的問題,提出了一種使用橢圓旋轉框和對齊卷積的單階段檢測網絡。使用高斯分布將矩形錨框轉變為橢圓錨框,有效彌補了水平錨框因為角度偏差出現的IoU與實際精度不匹配的缺陷。同時,引入對齊卷積網絡模塊與協變性特征,解決定位精度和分類分數不高的問題。本文方法和其他主流網絡比較,具有明顯的優勢,在現階段流行的數據集中取得了優于主流算法的精度。在將來的工作中,要進一步考慮當前算法對于小目標實例召回率不高的問題,通過添加對小目標友好的網絡模型子網絡分支與顯著性模塊增強等方式,逐步提升小目標的召回率。