全天實時跟蹤無人機目標的多正則化相關濾波算法

王法勝 李 富 尹雙雙 王 星 孫福明 朱 兵

近年來,無人機 (Unmanned aerial vehicle,UAV)目標跟蹤技術在道路規劃、交通監控等問題中得到廣泛應用[1].目前,有兩類目標跟蹤算法得到研究人員的高度關注: 基于相關濾波(Correlation filter,CF)的跟蹤方法和基于深度學習(Deep learning,DL)的跟蹤方法[2].后者使用一個或多個深度網絡對目標進行跟蹤,大大提高了跟蹤的準確性和魯棒性.但是這類方法需要較高的算力,導致其在無人機平臺上難以滿足實時跟蹤目標的要求.而CF 跟蹤方法因具有較低的計算成本和較高的跟蹤精度,在無人機目標跟蹤領域得到了廣泛的應用[3].這類方法通過空間域中的循環移位生成訓練樣本[4],但循環移位操作會導致出現邊界效應問題,從而降低濾波器的判別力.為此,研究人員提出在跟蹤框架中加入余弦窗口來抑制邊界效應[4-5],并在此基礎上結合其他策略來進一步增強算法的判別能力.例如,具有尺度和旋轉自適應的長時目標跟蹤算法[6],提出將傅里葉-梅林變換與核相關濾波方法結合,以提高濾波器對尺度和旋轉參數估計的魯棒性和準確性.融合顯著性與運動信息的相關濾波跟蹤算法[7],將目標的像素級概率性表征模型與相關濾波算法融合,并且提出一種基于顯著性的觀測模型,提高算法面對復雜跟蹤場景時識別目標的能力.另有研究人員提出空間正則化[5,8-10]和上下文學習[11-14]等策略提高相關濾波的性能.但這些算法均使用余弦窗口,而余弦窗口的引入對訓練樣本造成了污染,降低了算法的跟蹤性能.

CF 跟蹤算法中采用的手工特征主要包括灰度特征、方向梯度直方圖(Histogram of oriented gradient,HOG)和顏色名稱(Color names,CN)等.Bolme 等[15]首次提出了僅使用灰度特征的CF 跟蹤算法.后續的一些工作[4,16-17]為了學習具有多通道的濾波器,使用了灰度特征、HOG、CN 等多種特征的組合.但手工特征無法表述目標全部的語義信息.隨著ResNet、VGG (Visual geometry group)等提取深度特征的卷積神經網絡(Convolutional neural network,CNN)在諸如圖像分類和圖像識別等具有挑戰性視覺任務上取得巨大成功,研究人員開始將深度特征加入到CF 跟蹤框架中[18-19],顯著提高了CF 跟蹤算法的魯棒性.但CNN 特征的計算負擔較高,嚴重影響跟蹤器的實時性.受到無人機平臺本身計算性能的限制(僅搭載CPU),現有的無人機目標跟蹤算法[20-22]大都僅使用手工特征來描述目標的外觀.此外,這些跟蹤算法僅能較好地處理光照條件良好的跟蹤場景,而在跟蹤夜間場景下的目標時則遇到性能嚴重下降的挑戰.

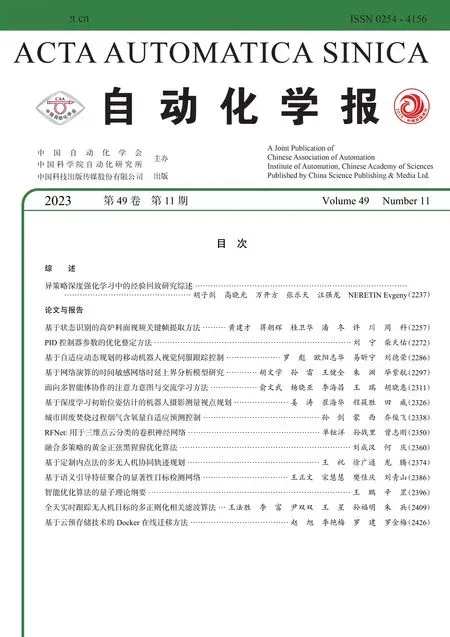

為了解決以上問題,本文提出一種全天實時多正則化相關濾波算法(All-day and real-time multiregularized correlation filter,AMRCF)跟蹤無人機目標,即,以多正則化的相關濾波器為基礎框架[21],引入自適應圖像增強模塊、輕量型深度網絡和高斯形狀掩膜.首先,引入一個自適應圖像增強模塊,在不影響圖像各通道顏色比例的前提下,對獲得的圖像進行增強,以提高夜間目標的跟蹤性能.其次,引入一個輕量型的深度網絡來提取目標的深度特征,并與手工特征一起來表示目標的語義信息.此外,在算法框架中嵌入高斯形狀掩膜,在抑制邊界效應的同時,有效避免訓練樣本污染.AMRCF 與其他先進的目標跟蹤算法在DTB70 基準數據集[23]上的總體比較如圖1 所示.

圖1 AMRCF 與其他算法在DTB70 上的總體性能比較Fig.1 Overall performance of AMRCF compared with other algorithms on DTB70

本文主要貢獻如下:

1)以多正則化的相關濾波器為基礎框架,引入一個自適應圖像增強模塊,自動判別無人機目標場景的光照條件,并在不改變圖像各通道顏色比例的前提下,根據判別結果對圖像進行相應的處理.

2)引入輕量型的深度網絡[24]來提取目標的深度特征,并與手工特征一起表示目標的語義信息.該網絡的計算量小,使用CPU 平臺便可以進行特征的提取,并且不會大幅降低算法的跟蹤速度.

3)在CF 跟蹤框架中嵌入高斯形狀掩膜,建立相關濾波跟蹤算法模型,并使用交替方向乘子方法優化求解,在抑制邊界效應的同時,減少樣本污染問題.

4)在5 個公開的無人機基準數據集DTB70[23]、UAVTrack112[25]、UAVDark135[26]、VisDrone-SOT2018[27]和UAV123[28]上進行綜合實驗.結果表明,所提出的算法具有較高的精確度和魯棒性.本文算法代碼及結果發布于https://gitee.com/he_bing_DLMZ/amrcf.

1 相關工作

本節簡要介紹與本文內容相關的跟蹤算法,包括基于相關濾波的跟蹤算法以及無人機目標跟蹤算法.

1.1 基于相關濾波的跟蹤算法

基于CF 的跟蹤算法將跟蹤任務描述為嶺回歸問題,目的是訓練濾波器來區分目標與背景區域.首個CF 跟蹤器MOSSE[15]被提出后,Henriques 等[4,29]將核技巧(Kernel trick)引入到相關濾波公式中,并利用循環矩陣的特性將求解過程轉換到傅里葉域,簡化了濾波器優化過程.此后,研究人員又從很多方面提出不同方法來提高CF 跟蹤器的性能,包括尺度估計[30-31]、邊界效應抑制[5,8-10,32-33]、時間退化解決方案[34-36]、特征表示[19,37]、注意力機制[38-40]以及特征去冗余[14,41-42].

CF 跟蹤算法通過空間域的循環移位操作來生成更多的訓練樣本,導致出現邊界效應問題.Danelljan 等[5]提出空間正則化相關濾波跟蹤算法(Spatially regularized discriminative correlation filter,SRDCF),該算法加入空間正則化組件,根據相關濾波器的空間位置,對濾波器系數進行懲罰來抑制邊界效應.蒲磊等[10]結合SRDCF 與CNN,提出了基于深度空間正則化的CF 算法.該算法選取VGG網絡第5 層卷積特征提取目標的空間可靠區域,將該區域信息用于對樣本進行裁剪并引入目標函數,從而建立空間約束模型.Xu 等[35]在時空正則化相關濾波算法[34](Spatial-temporal regularized correlation filter,STRCF)的基礎上,通過將多特征通道與濾波器的結構進行關聯,以在空間維度上進行組特征選擇來解決邊界效應問題.王科平等[43]以跟蹤目標的鄰域信息為基礎,引入掩膜矩陣,提取目標的空間信息,并通過在目標函數中構建時空感知約束項,強化相關濾波器對時空二元信息的學習能力,增強濾波器對干擾信息的魯棒性.

上述方法在抑制邊界效應上存在一個共同點,即使用余弦窗口.余弦窗口與采樣區域相乘之后,邊界附近區域被強制為零,使得獲取的訓練樣本極易受到噪聲的污染,進而導致濾波器性能下降.為此,Li 等[44]提出在背景感知相關濾波算法[8](Background aware correlation filter,BACF)中用高斯掩膜替換余弦窗口以解決樣本污染問題.與使用空間域循環移位產生的樣本來訓練濾波器不同,文獻[45]通過傳統的滑動窗口對一組真實且密集的塊進行采樣,用采樣后的樣本來訓練濾波器,進而從根本上抑制邊界效應.

1.2 無人機目標跟蹤算法

基于CF 的跟蹤器在無人機目標跟蹤中得到了廣泛的應用,但平面內外旋轉、光照不足、遮擋、形變等給無人機目標跟蹤帶來了極大的挑戰.為了更好地應對這些挑戰,研究人員進行了大量的研究工作以改進無人機目標跟蹤算法.Li 等[22]提出一種自適應時空正則化無人機跟蹤算法,通過超參數對正則化項進行自動調整來抑制邊界效應,同時利用隱藏在響應圖中的局部和全局信息平滑時間.Fu 等[46]提出一種具有雙重正則化策略的無人機跟蹤器,通過對涉及相關運算的濾波器直接正則化來抑制邊界效應,并利用正則化器識別目標區域來減少背景噪聲.為了應對無人機目標的外觀突變,文獻[20]在CF跟蹤框架中嵌入自適應混合標簽以增強算法對外觀突變的抗性,并將理想標簽與相關濾波器進行聯合優化來保持時間一致性.傳統的CF 無人機跟蹤算法沒有考慮歷史樣本信息與不同通道之間的差異性,Ye 等[21]通過規范響應的偏差對響應變化進行平滑,同時通過通道的可靠性來實現自適應通道權重分布,從而更好地適應對象外觀變化,以此增強跟蹤器從背景中區分目標的能力.針對目前沒有專用于夜間跟蹤的算法,Li 等[26]在目標跟蹤框架中加入自適應光照強度模塊,利用該模塊改善夜間目標序列的質量,以此提高算法的夜間跟蹤效果.

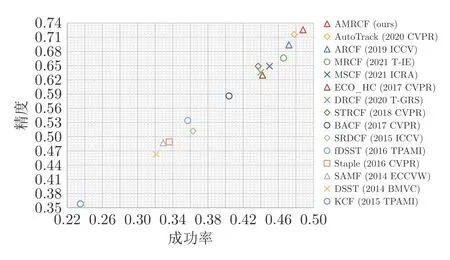

2 本文算法

本節介紹所提出的跟蹤算法AMRCF,算法的整體框架如圖2 所示.AMRCF 由三部分組成,第一部分是自適應圖像增強模塊,第二部分是特征提取模塊,第三部分是嵌入高斯形狀掩膜的多正則化相關濾波(Multi-regularized correlation filter,MRCF)模塊.對于輸入的視頻序列,首先將序列的第1 幀取出做光照條件判別,并根據判別結果對后續圖像做不同的處理.隨后,在每一幀中,計算高斯形狀掩膜,并提取樣本區域中的手工特征和深度特征,將兩種特征進行線性加權.最后,將優化的濾波器hk,通道權重分布βk與樣本特征進行相關運算以得到響應圖,響應圖中的最大值位置即為目標位置.

圖2 AMRCF 跟蹤算法框架圖Fig.2 Framework of the proposed AMRCF algorithm

2.1 自適應圖像增強模塊

為了提高算法的夜間跟蹤能力,本文引入一種自適應圖像增強模塊.該模塊首先使用光照強度表達式,將圖像復雜的光照信息轉換成一個常數,并利用該常數構建光照條件判別式.然后在像素級別上根據判別結果對圖像采取不同的處理措施,以達到到圖像增強的目的.

對于一幅大小為a×b的RGB 圖像I ∈Ra×b×3,利用式(1)計算出它的光照強度L

其中,L(i,j,I)表示圖像I在坐標 (i,j)處的光照強度,ψm(I(i,j))表示圖像I在顏色通道m的坐標 (i,j)處的光照強度值.具體來說,ψR(I(i,j))表示紅色通道中對應位置的光照強度值,且顏色通道系數αR,αG,αB滿足αR+αG+αB=1.

將式(1)代入式(2)中,得到圖像I的光照強度對數平均值

其中,δ是一個很小的非零數.至此,便完成了由復雜光照信息到簡單常數的轉換.

文獻[26]針對式(2)有效性的實驗結果表明,光照強度的對數平均值可以有效地表達圖像的光照強度信息.基于此,構建式(3)所示的判別式

式(3)是一個夜間場景判決器,其中τ為給定閾值,也就是說,S(I)=1 表明圖像I是一幅夜間圖像,反之則是白天圖像.

通過以上公式,便可以判別圖像所處的光照場景,但自適應圖像增強模塊的最終目的是對圖像進行增強.為此,采取下面的方案對圖像進行增強處理.

首先,使用L(i,j,I)和計算出式(4)所示的全局自適應因子Lgb(i,j,I)

其中,Lmax(I)=max(L(i,j,I)).

然后用全局自適應因子Lgb(i,j,I)對圖像I進行像素級別的增強處理

其中,Ie為增強后的圖像.

通過式(1)~(5),實現對圖像的自適應增強處理,具體的實驗效果對比如圖3 所示.與黑暗場景下的原始圖像相比,經過自適應圖像增強模塊處理后,圖像的質量得到了明顯提升,體現在光照強度變化和圖像顏色變化上,這有利于特征提取模塊提取目標特征.

2.2 輕量型深度網絡

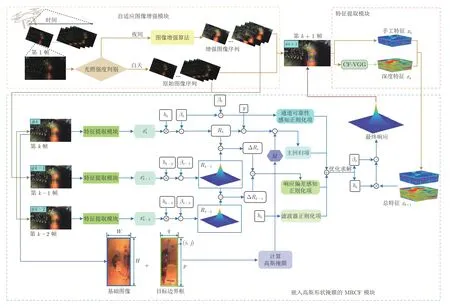

VGG、ResNet 等深度網絡大大提升了目標跟蹤算法的性能,但大幅降低了跟蹤的實時性,難以滿足無人機目標跟蹤需求.Wang 等[24]提出一種輕量型的深度網絡,該網絡的計算量較小,在提高算法精度的同時,能達到實時的跟蹤速度.

文獻[24]將VGG-M 作為教師網絡,使用知識蒸餾[47]來生成輕量型的學生網絡CF-VGG.教師網絡和學生網絡的具體架構如圖4 所示.在蒸餾的過程中,使用式(6)所示的語義保真度損失Lfidelity來確保學生網絡能夠保持與教師網絡相似的特征表示能力

圖4 教師網絡和學生網絡的架構Fig.4 Architectures of the teacher network and the student network

其中,t和s分別表示目標區域和搜索區域,Ltarget,Lsearch是目標區域損失和搜索區域損失.φ(·)表示學生網絡可訓練的特征嵌入,?(·)表示教師網絡的固定嵌入.

學生網絡的離線提取過程在主要面向目標識別任務的ImageNet 數據集[48]上進行.為此,文獻[24]提出式(7)所示的相關跟蹤損失Ltracking,將學生網絡的任務從目標識別轉移到目標跟蹤

其中,⊙ 表示哈達瑪積(Hadamard product),F-1表示逆離散傅里葉變換,c∈{low,middle,high}表征低中高卷積層的特征表示的索引,是相應卷積層濾波器的復共軛,表示相應層特征嵌入的復共軛,rc,vc分別是相關響應圖和真實值標簽,相關跟蹤損失是兩者之間的歐氏距離.相關跟蹤損失將分類的源目標轉換為回歸目標進行跟蹤,同時通過學習相似度(或模板匹配)來評估目標對象在幀之間的微小外觀變化.

本文將CF-VGG 引入到AMRCF 框架中來提取目標的深度特征,與手工提取的特征一起來描述目標.具體而言,對于第k+1 幀,以上一幀k的目標位置為中心,以自適應的方式裁剪樣本區域,對于該區域,CF-VGG 使用stride=2 的步長進行下采樣,并用 ReLU 函數對更有助于精確定位[18]的第3 卷積層上的CNN 特征進行處理,以描述目標的語義信息.

2.3 AMRCF 算法

2.3.1 基線算法

MRCF 的目標函數如式(8)所示

其中,T 表示矩陣的轉置,y∈RN是期望響應,分別是第 k 幀的第 d 通道所對應的矢量化特征和濾波器.?代表空間域的卷積操作,而P是用于減輕邊界效應的二進制矩陣.κ是預定義的系數,ε1和ε2分別是響應偏差感知正則化項(Response deviation-aware regularization)和通道可靠性感知正則化項(Channel reliability-aware regularization),表達式分別如式(9)、式 (10)所示.λ是控制響應偏差感知正則化權重的超參數,γ是預定義的常數.βk,β0分別是模型訓練過程中的通道權重分布和初始權重分布,表征兩個連續幀之間的響應差異,其具體表達式見式(11)

2.3.2 高斯形狀掩膜

CF 跟蹤器通過空間域中的循環移位操作來獲取訓練樣本,但沒有考慮到采樣區域的邊界而導致訓練樣本出現邊界不連續性,從而引起邊界效應.為抑制邊界效應,研究人員在模型的訓練過程中加入余弦窗口.但余弦窗口更強調基礎圖像的中心區域,與采樣區域相乘之后,邊界附近區域被強制為零,從而在模型訓練過程中造成樣本污染.為此,本文將高斯形狀掩膜嵌入跟蹤器的目標函數中,在抑制邊界效應的同時,減少訓練樣本污染問題.高斯掩膜M的定義如下所示

其中,p×q和H×W分別是目標邊界框和基礎圖像的尺寸,(i,j)是樣本區域中的坐標點.υ是用來控制訓練樣本權重衰減速度的參數.

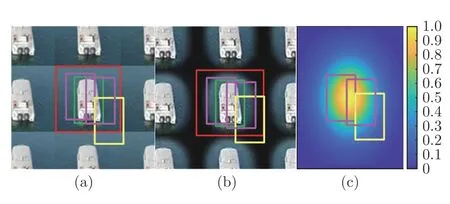

圖5 為相關的可視化圖.圖5(a)中的紅框是基礎圖像區域,用于獲取訓練樣本,綠框是目標區域,其大小分別是H×W和p×q.訓練樣本附帶的邊界效應是基礎圖像循環移位而使樣本邊界不連續造成的,圖中紫色框所代表的樣本中包含了目標區域及其周圍的背景區域,其內部區域為連續區域,不包含圖像邊界.而黃色框所代表的樣本中則包含了圖像邊界.圖5(b)是循環樣本與余弦窗口相乘后的可視化圖,樣本的邊界效應得到抑制,但也抑制了目標邊界框之外的像素.黃色框中的樣本存在大量的黑色區域,使得該樣本被黑色區域污染.因此,引入余弦窗口后存在使遠離目標中心的負樣本質量降低的風險.圖5(c)是高斯掩膜的可視化圖像,從圖像中心到四周,權值呈遞減趨勢,以此突出中心樣本,并降低邊緣樣本的重要性,達到抑制邊界效應和防止樣本污染的目的.

圖5 邊界效應抑制可視化圖((a)空間域循環移位產生的帶有邊界效應的訓練樣本;(b)加入余弦窗口后,帶有污染的訓練樣本;(c)高斯形狀掩膜可視化圖,樣本的中心距離圖像中心越近,其權重越大,重要性越高,反之則越低)Fig.5 Visualization of boundary effect suppression ((a)Training samples with boundary effect generated by cyclic shifts in the spatial domain;(b)Training samples with contamination after adding cosine window;(c)Gaussian-shaped mask visualization,the closer the center of the sample is to the center of the image,the higher the weight and importance,and vice versa)

2.3.3 AMRCF 算法的建模和優化

在目標函數中嵌入高斯形狀掩膜,得到本文算法AMRCF 的目標函數,如式(13)所示

為了最大限度地提高求解速度,應用交替方向乘子法(Alternative direction multiplier method,ADMM),通過迭代求解以下子問題來優化式(16).

3)子問題β

4)更新拉格朗日乘子

與文獻[49]一致,本文分別使用式(23)和式(24)來更新拉格朗日乘子和懲罰因子

2.3.4 模型更新

2.3.5 跟蹤框架

跟蹤過程中,對于每一個視頻序列,首先用式(3)來判別序列第1 幀圖像的光照條件,并根據判別結果使用自適應圖像增強模塊對后續幀進行不同的處理.隨后,對于每一幀k+1,以前一幀k中的目標位置為中心來裁剪相應尺度的樣本區域,以提取其手工特征和深度特征,并采用式(26)將兩種特征進行線性求和以得到最終的目標特征

其中,xh和xd分別是手工特征和深度特征,而xtotal是總特征,?是平衡兩種特征的參數.

最后,將每個通道的響應與優化的通道權重進行元素乘積,則最終的響應函數Rk+1為

3 實驗分析

本節采用5 個公開的無人機目標跟蹤基準DTB70、UAVTrack112、UAVDark135、VisDrone-SOT2018 和UAV123,與14 個先進的相關濾波跟蹤算法進行對比實驗,包括ARCF[50]、AutoTrack[22]、MRCF[21]、MSCF[20]、DRCF[46]、SRDCF[5]、STRCF[34]、Staple[51]、SAMF[52]、ECO_HC[37]、DSST[30]、fDSST[30]、KCF[4]和BACF[8].

3.1 實驗細節

為公平起見,受測跟蹤算法的參數均來自官方版本,均在同一平臺進行.

1)實驗平臺.本文所有實驗都在配備Intel(R)Xeon(R)E-2 224 CPU @ 3.4 GHz 16 GB 內存的Windows10 系統上進行,使用的軟件是Matlab R2018a.

2)實驗特征.AMRCF 采用HOG、CN、灰度特征和深度特征的組合來表示目標對象.其他算法采用的目標特征與原文保持一致,實驗時未作修改.

3)實驗參數.顏色通道強度系數αR,αG,αB分別取0.299、0.587、0.114,夜間場景指示器的判決閾值τ取0.148,光照強度對數平均值式(2)中δ取0.001.高斯掩膜中用來控制訓練樣本權重衰減速度的參數υ=4.在目標函數求解中,設置ADMM 的迭代次數為3,學習率是η=[0.0199,0.0199],正則化系數分別是κ=0.01,λ=0.004,γ=10,并用μ=1,μmax=100,σ=10 來更新拉格朗日乘子,用?=0.7來平衡手工特征與深度特征.

4)評估指標.所有評估均基于一次性評估(Onepass evaluation,OPE),其包括兩個指標,即精確度和成功率[53].通過估計邊界框與真實邊界框之間的中心位置誤差(Center location error,CLE)來衡量精確度,用精確度圖(Precision plot,PP)中CLE 低于20 像素的幀的百分比對跟蹤器進行排名.通過計算估計邊界框與真實邊界框之間的交并比(Intersection over union,IoU)來衡量成功率,并使用成功圖(Success plot,SP)的曲線下面積(Area under curve,AUC)對跟蹤器進行排名.此外,使用幀率對算法的跟蹤速度進行排名.

3.2 消融實驗

3.2.1 跟蹤性能對比

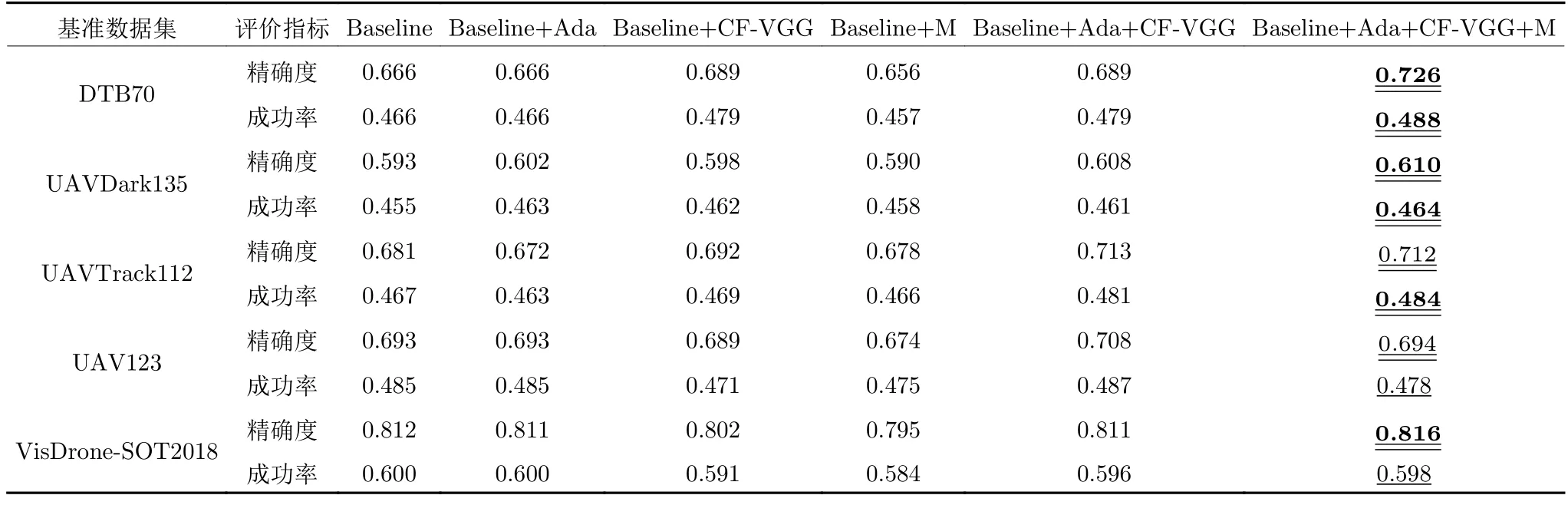

為驗證AMRCF 算法中自適應圖像增強模塊、輕量型深度網絡和高斯掩膜對本文算法性能的影響,在5 個無人機目標跟蹤基準數據集上進行了消融實驗,實驗結果如表1 所示.

表1 消融實驗結果對比Table 1 Comparison of ablation experiment results

其中,與基線算法相比,雙下劃線表示性能增強,單下劃線表示性能減弱.Baseline 是基線算法MRCF,Baseline+Ada、Baseline+CF-VGG、Baseline+M、Baseline+Ada+CF-VGG 分別表示在MRCF 框架中加入自適應圖像增強模塊、輕量型深度網絡、高斯掩膜、自適應圖像增強模塊和輕量型深度網絡.Baseline+Ada+CF-VGG+M 則是加了所有模塊的本文算法AMRCF.

在由白天序列構成的DTB70 數據集上,根據式(4)的判別結果,不進行圖像增強處理,所以只添加自適應圖像增強模塊的算法結果與基線算法結果持平.只添加高斯掩膜的算法結果低于基線算法結果,當某一幀的估計邊界框發生漂移時,下一幀由基礎圖像循環移位產生的訓練樣本因不包含目標而使高斯掩膜無效,致使跟蹤性能降低.而同時添加3 個模塊的算法達到了最好的實驗效果.

在由夜間序列構成的UAVDark135 基準數據集上,Baseline+Ada、Baseline+CF-VGG、Baseline+M 和Baseline+Ada+CF-VGG 算法的性能都超越了基線算法,且在只添加單個模塊的算法中,Baseline+Ada 獲得了最好的實驗結果,與基線算法相比,在精確度和成功率上分別獲得0.9% 和0.8% 的提升.這表明,自適應圖像增強模塊的引入能顯著提升算法的夜間跟蹤效果.添加3 個模塊的Baseline+Ada+CF-VGG+M 提升最大,分別提升1.7%和0.9%.

在UAV123 數據集上,除Baseline+Ada 和Baseline+Ada+CF-VGG 外,其他改進算法的成功率均低于基線算法.UAV123 包含動畫游戲等虛擬視頻序列和較多快速移動序列,本文算法對于此類序列難以獲得提升.在精確度方面,Baseline+Ada+CF-VGG 以及加入3 個模塊的算法均比基線算法的精確度高,表明深度特征與其他模塊共同作用能夠在一定程度上提高算法精確度.

綜合上述的分析,同時添加自適應圖像增強模塊、輕量型深度網絡和高斯形狀掩膜后,本文算法在5 個基準數據集、共10 組指標數據上,有8 組結果得到提升,而減弱的指標數據與基線算法的對應指標相比,其降幅較小,從而驗證了AMRCF 算法中各模塊的有效性.

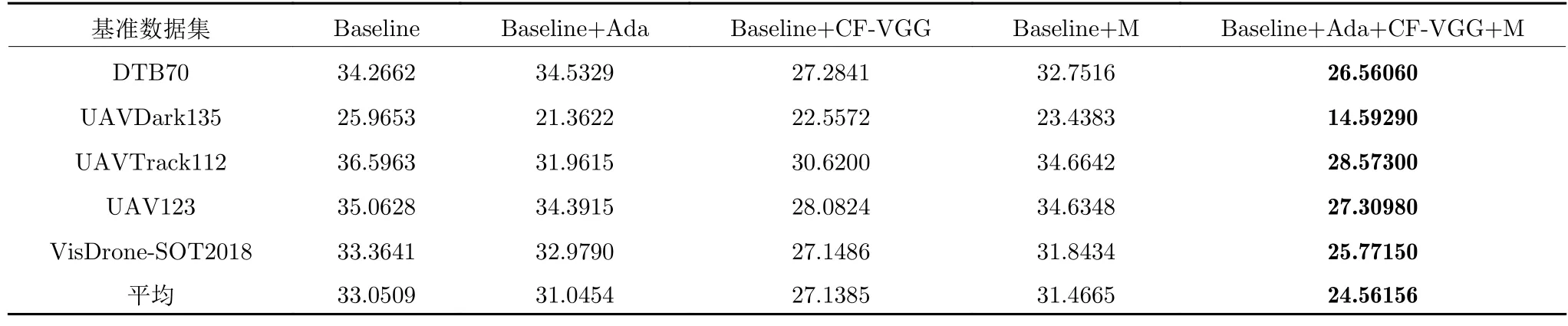

3.2.2 跟蹤速度對比

為比較不同模塊對計算復雜度及跟蹤速度的影響,本節在5 個數據集上,對包含不同模塊的算法進行幀率對比,實驗結果如表2 所示.Ada 代表自適應圖像增強模塊,它根據序列首幀的光照情況對整個序列采取不同的處理策略,對夜間序列需要采取逐像素重計算的方式來進行增強,因此該模塊的計算復雜度取決于圖像幀的大小.UAVDark135和UAVTrack112 數據集中均含有夜間序列,Baseline+Ada 對此類序列進行增強處理,相較于基線算法,計算復雜度增加,幀率都下降了約4.6 fps.DTB70、UAV123 和VisDrone-SOT2018 不含夜間序列,自適應圖像增強模塊判斷每序列首幀的光照條件,不做增強處理,幀率下降可忽略不計.

表2 消融實驗幀率對比Table 2 Frame rate comparison of ablation experiment

本文使用輕量級深度網絡CF-VGG 第10 層的輸出作為深度特征來描述目標的語義信息,該層數據輸出的計算量大,耗費時間長,對幀率影響明顯,在5 個數據集上的平均幀率下降了約5.9 fps.高斯掩膜的計算復雜度取決于目標邊界框和基礎圖像的尺寸,嵌入跟蹤框架后,算法整體復雜度略有上升,在5 個數據集上的平均幀率下降了約1.6 fps.引入3 個模塊的AMRCF 算法計算復雜度最高,在UAVDark135 和UAVTrack112 上分別為14.5929 fps和28.573 fps,平均幀率約為25 fps,降低約8.5 fps,但整體上仍然可滿足實時性的要求.需要強調的是,本文實驗均是在僅配備有單CPU 的計算機上進行,以最大程度模擬無人機運行環境.

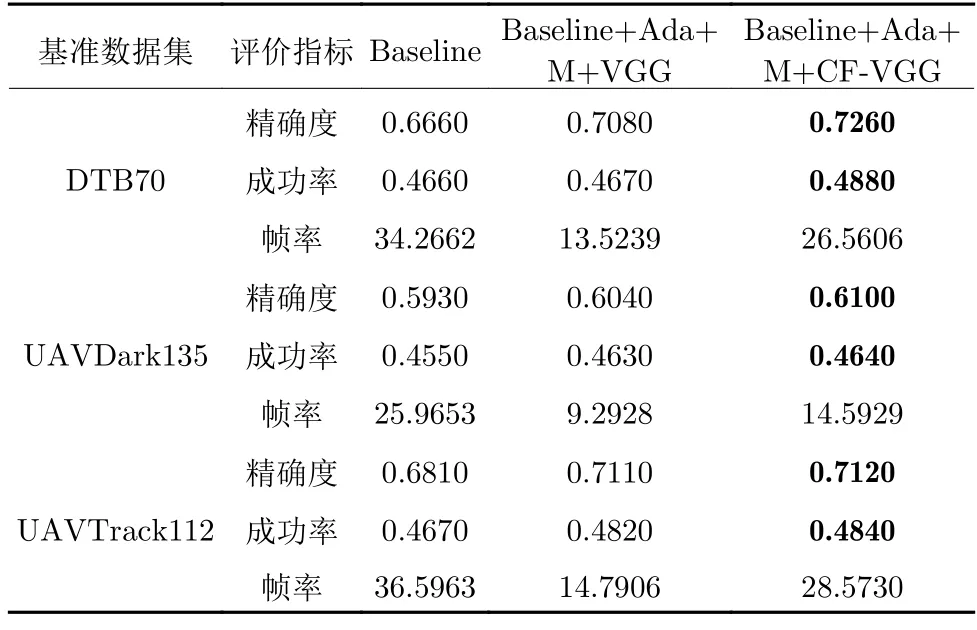

3.2.3 不同深度網絡的對比

本節將CF-VGG 與其教師網絡VGG 進行對比消融實驗.在本文算法框架中,將CF-VGG 替換成其教師網絡,得到Baseline+Ada+M+VGG,實驗結果如表3 所示.由表3 可知,與基線算法相比,采用VGG 深度網絡的特征能夠顯著提高跟蹤的精確度和成功率,但算法幀率卻急劇下降,3 個數據集分別下降約20.7 fps、16.7 fps 和21.8 fps.這表明,VGG 網絡結構復雜,特征提取過程耗費大量時間.而本文算法Baseline+Ada+M+CF-VGG 在3 個數據集上的精確度和成功率均高于采用VGG 網絡的算法,且幀率方面大大超過了采用VGG 網絡的算法.該結果充分說明,相較于教師網絡VGG,使用CF-VGG 網絡能夠大幅提高跟蹤幀率,而其在精確度和成功率方面的提升則歸因于在生成CFVGG 過程中采用了相關跟蹤損失.

表3 CF-VGG 與教師網絡VGG 性能對比Table 3 Comparison of performance between CF-VGG and teacher network VGG

3.3 定量分析

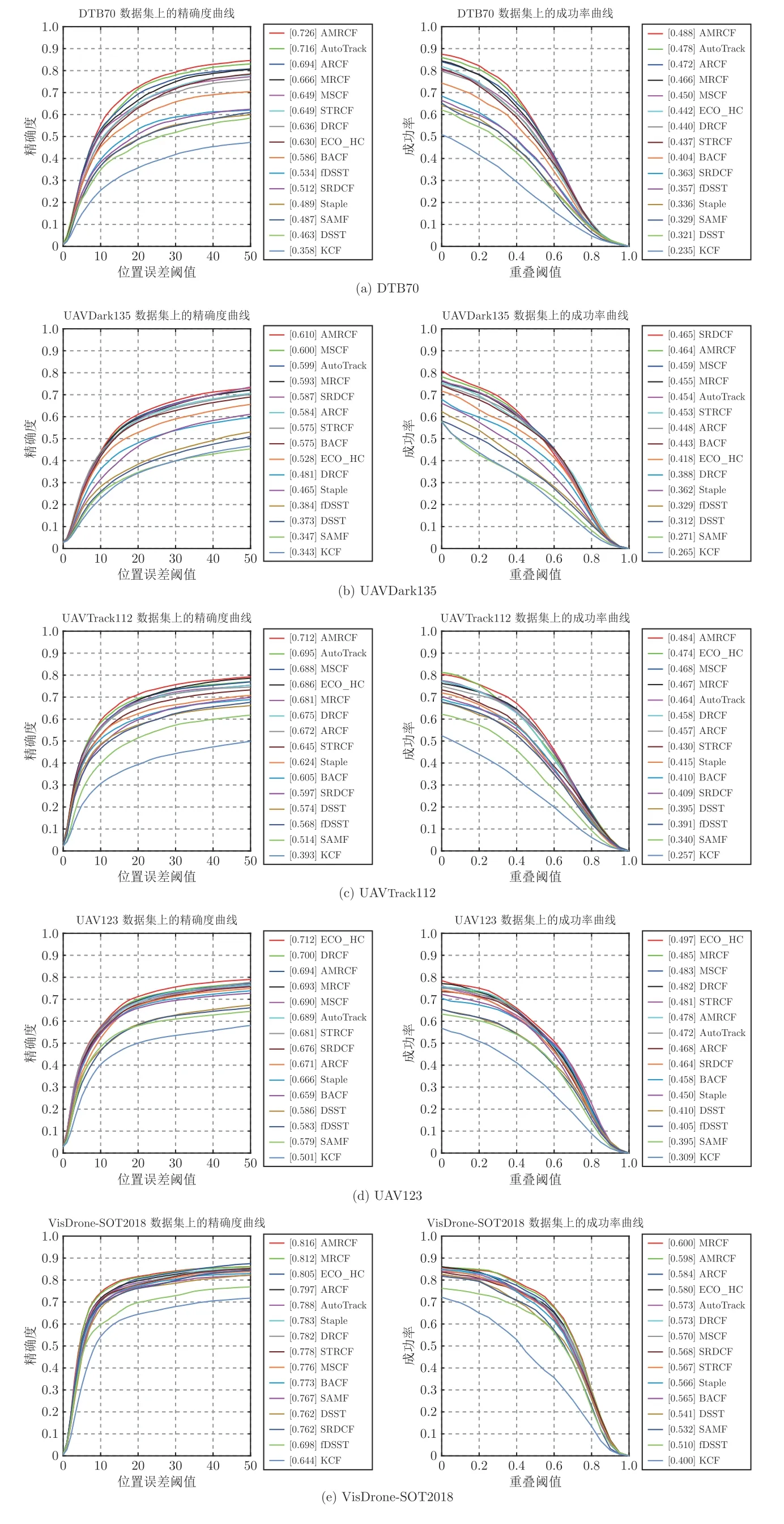

消融實驗證明了AMRCF 算法中各模塊的有效性,本節為得到更加準確的實驗結果,在5 個無人機目標跟蹤數據集上,與14 種CF 跟蹤算法進行實驗對比,結果如圖6 所示.

圖6 AMRCF 與其他算法在5 個無人機目標跟蹤基準上的實驗結果Fig.6 Experimental results of AMRCF and other algorithms on five UAV target tracking benchmarks

3.3.1 整體性能評估

1)白天跟蹤性能.所使用的5 個基準數據集中,DTB70、UAV123 和VisDrone-SOT2018 均由白天序列構成,使用這3 個數據集進行白天跟蹤性能的評估.在DTB70 上,AMRCF 以72.6% 的精確度和48.8% 的成功率位居第1,兩項指標均比排名第2 的AutoTrack 高1.0%,而且比基線算法MRCF分別高6.0% 和2.2%.在UAV123 上,本文算法雖未獲得最好的性能,但以69.4% 的精確度(比MRCF 高0.1%)和47.8% 的成功率位于前列.在Vis-Drone-SOT2018 上,本文算法分別以81.6% 的精確度位居第1 和59.8% 的成功率位居第2,在成功率上比MRCF 低0.2%,但精確度要高0.4%.

2)夜間跟蹤性能.UAVDark135 是包含135 個夜間序列的無人機目標跟蹤數據集.為了驗證AMRCF 的夜間跟蹤性能,本文在該基準數據集上進行了相關實驗.實驗結果表明,本文算法能對夜間目標進行精確跟蹤,并以61.0% 的精確度位居第1,以46.4%的成功率位居第2.在成功率上,僅比排名第1 的SRDCF (46.5%)低0.1%,但在精確度上,比排名第2 的MSCF 高1.0%.且本文算法在兩組指標上分別比基線算法高1.7% 和0.9%.

3)全天跟蹤性能.本文提出的跟蹤器能夠進行全天目標跟蹤,為此,在同時含有白天序列和夜間序列的UAVTrack112 上進行驗證.由圖6(c)可知,AMRCF 分別以71.2% 的精確度和48.4% 的成功率位居第1.在兩項指標上,比排名第2 的跟蹤器分別高1.7% 和1.0%,且分別比基線算法高3.1% 和1.7%.而在UAV123 數據集上排名第1 的ECO_HC,在UAVTrack112 的精確度圖上僅排名第4,比AMRCF 低2.6%.

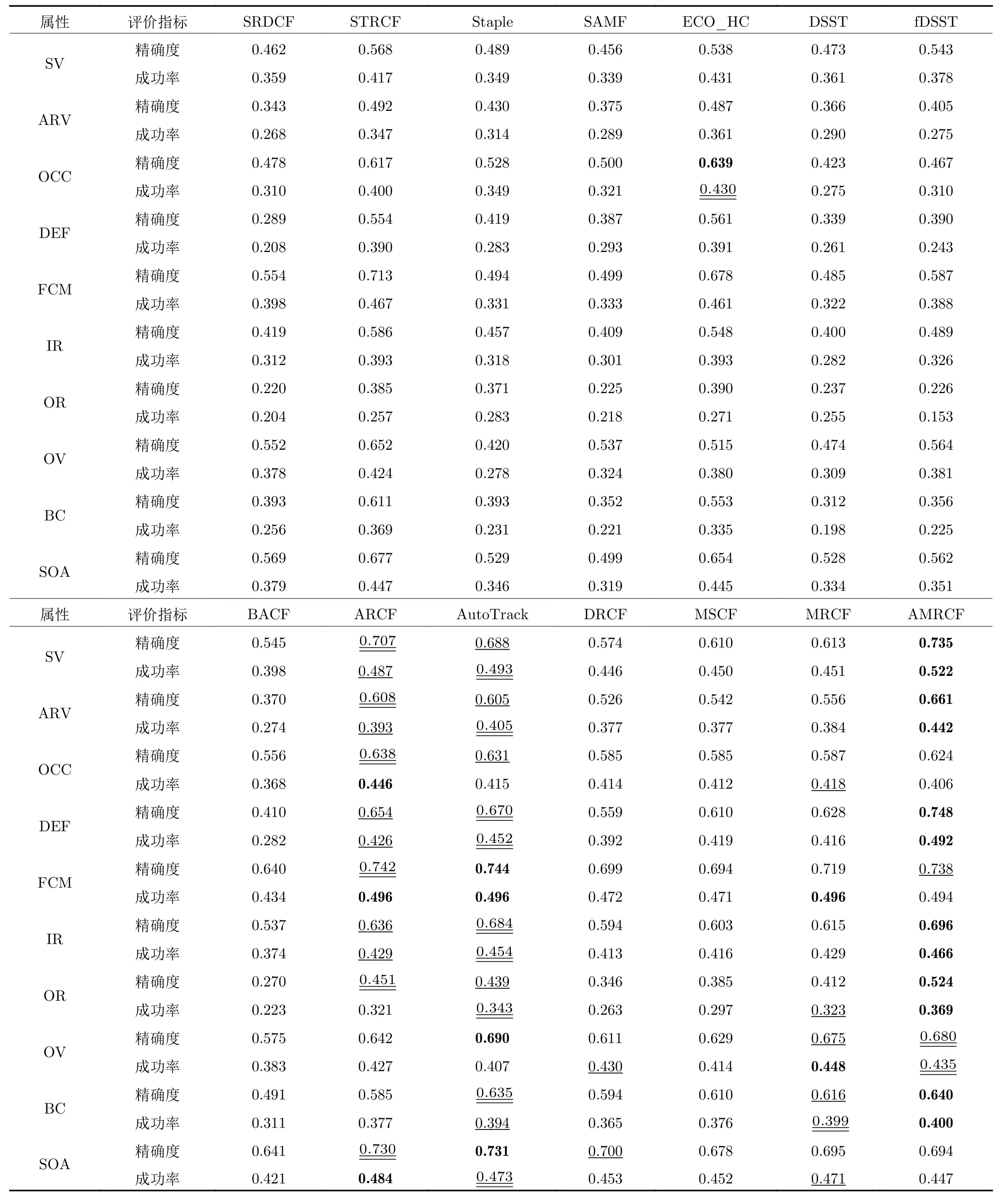

4)跟蹤速度.對無人機目標跟蹤來說,幀率是至關重要的評價指標,它表征算法每秒內跟蹤的序列幀數.各算法在5 個無人機基準數據集上的幀率如表4 所示.其中,粗體、雙下劃線、單下劃線分別表示排名前3 的算法.在夜間數據集UAVDark135上,AMRCF 對每幀圖像都要進行光照增強處理,會耗費大量時間,故幀率較低,約為14 fps.在其他4 個基準數據集上的幀率都超過25 fps,并且在5個數據集上達到24.6 fps 的平均幀率,能夠滿足實時跟蹤的需求.

表4 各跟蹤算法在無人機目標跟蹤基準上的幀率比較Table 4 Comparison of frame rates of various tracking algorithms on UAV target tracking benchmarks

3.3.2 與無人機目標跟蹤算法的比較

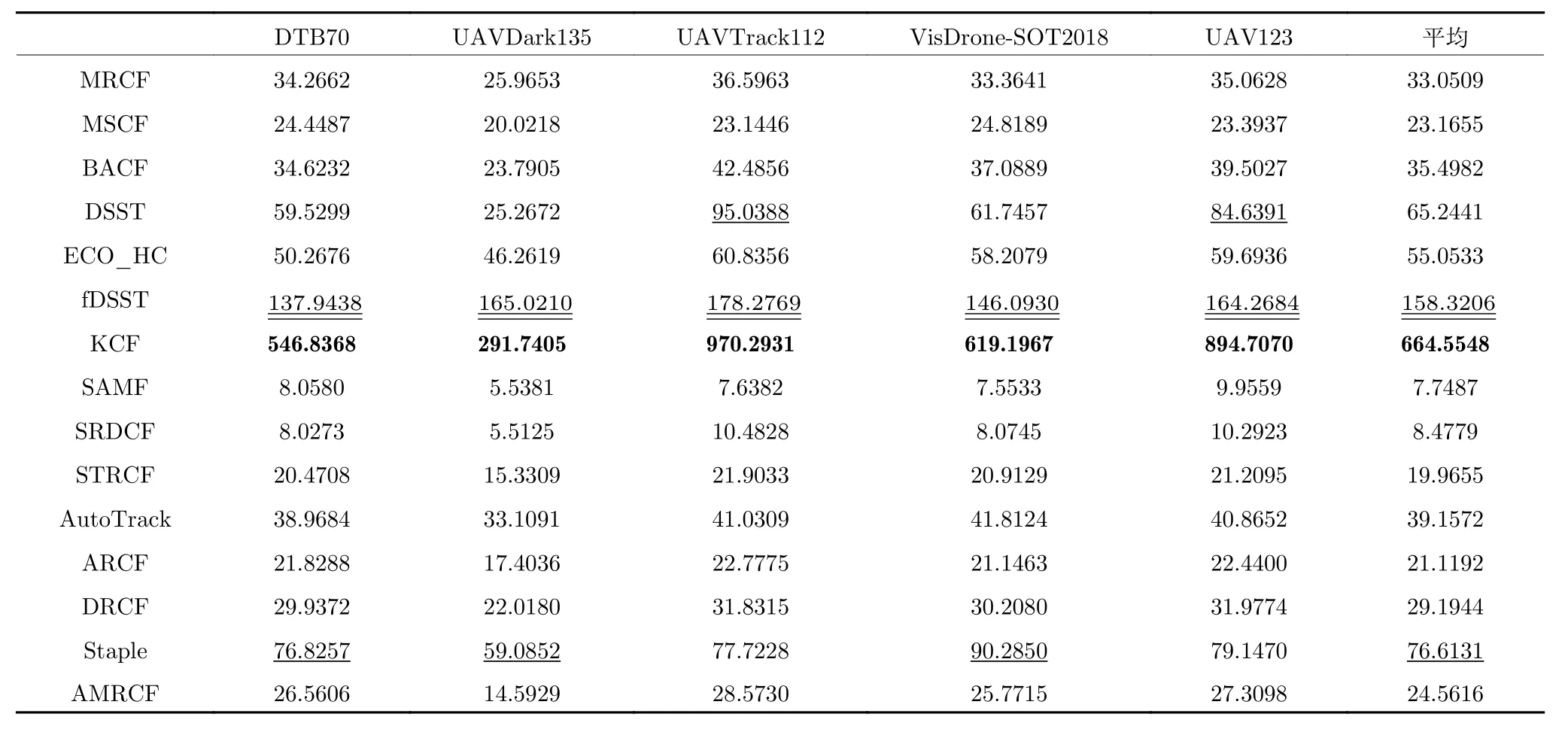

AMRCF 是面向無人機目標的跟蹤算法,為此,將AMRCF 與5 個先進的無人機目標跟蹤算法在5 個基準數據集上的性能進行比較,結果如表5 所示.其中,粗體、雙下劃線、單下劃線分別表示排名前3 的算法.

表5 AMRCF 與無人機目標跟蹤算法的性能比較Table 5 Performance comparison of AMRCF and UAV target tracking algorithms

AMRCF 在5 個基準數據集上,有9 組指標排在前3 名,且有7 組指標數據是第1 名,與排名第2 的算法相比,領先0.4%~1.7%.而基線算法MRCF 有兩組指標排在第1,與排名第2 的算法相比,僅有0.2% 的提升.在UAV123 上,AMRCF 以69.4% 的精確度排第2,比排名第1 的DRCF低0.6%.在VisDrone-SOT2018 上,AMRCF 以59.8% 的成功率排第2,僅比基線算法MRCF 低0.2%,比排名第3 的ARCF 高1.4%.這表明AMRCF 在無人機目標跟蹤中的出色性能.

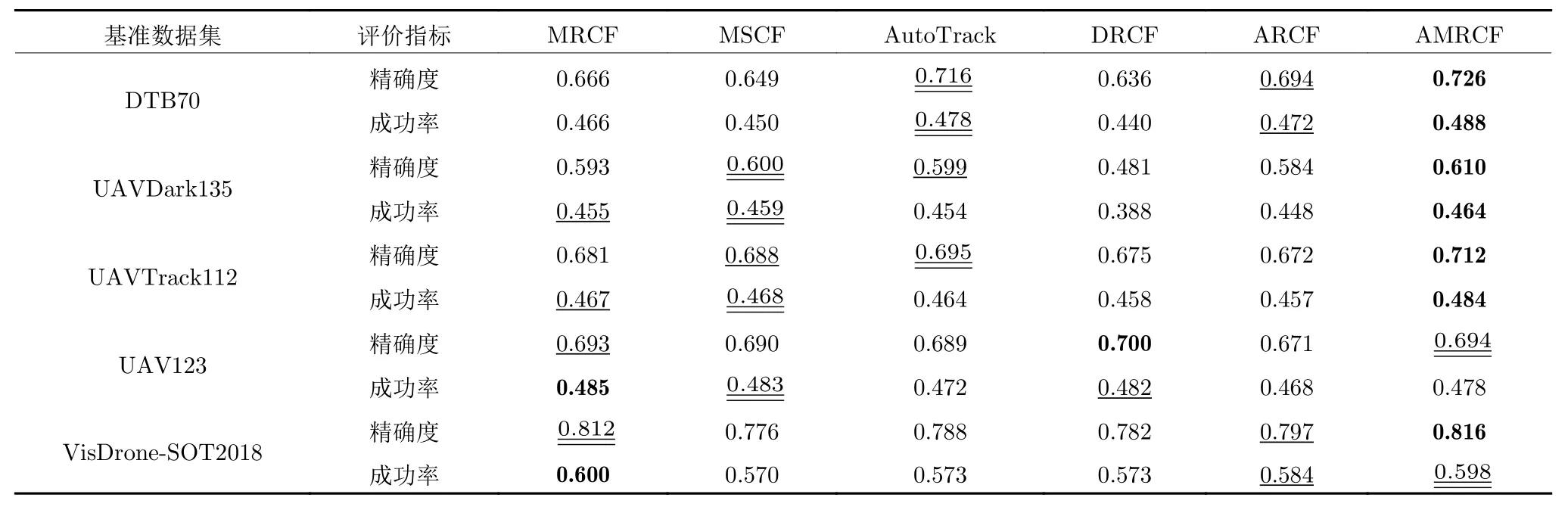

3.3.3 針對挑戰屬性的評估

為評估AMRCF 在不同挑戰屬性上的表現,本節將跟蹤算法在DTB70 數據集不同挑戰屬性上的性能進行了匯總,如表6 所示.其中,粗體、雙下劃線、單下劃線分別表示排名前3 的算法.SV、ARV、OCC、DEF、FCM、IR、OR、OV、BC 和SOA 代表的挑戰屬性分別是尺度變化、縱橫比變化、遮擋、形變、相機快速移動、平面內旋轉、平面外旋轉、移出視野、背景雜波和相似物體.

表6 各算法在DTB70 基準不同屬性上的性能比較Table 6 Performance comparison of each algorithm on different attributes of the DTB70 benchmark

本文算法在SV、ARV、DEF、IR、OR、BC 上獲得最好的性能,在精確度上分別比排名第2 的跟蹤器高2.8%、5.3%、7.8%、1.2%、7.3%、0.5%,在成功率上高2.9%、3.7%、4.0%、1.2%、2.6%、0.1%.AMRCF 在OV 上位居第2 名,在OCC、FCM 和SOA 屬性上沒有排進前3 名,但在評測算法中依然名列前茅.由此表明,本文算法能夠很好地應對無人機目標跟蹤中的各種挑戰.

3.4 定性分析

3.4.1 跟蹤成功案例分析

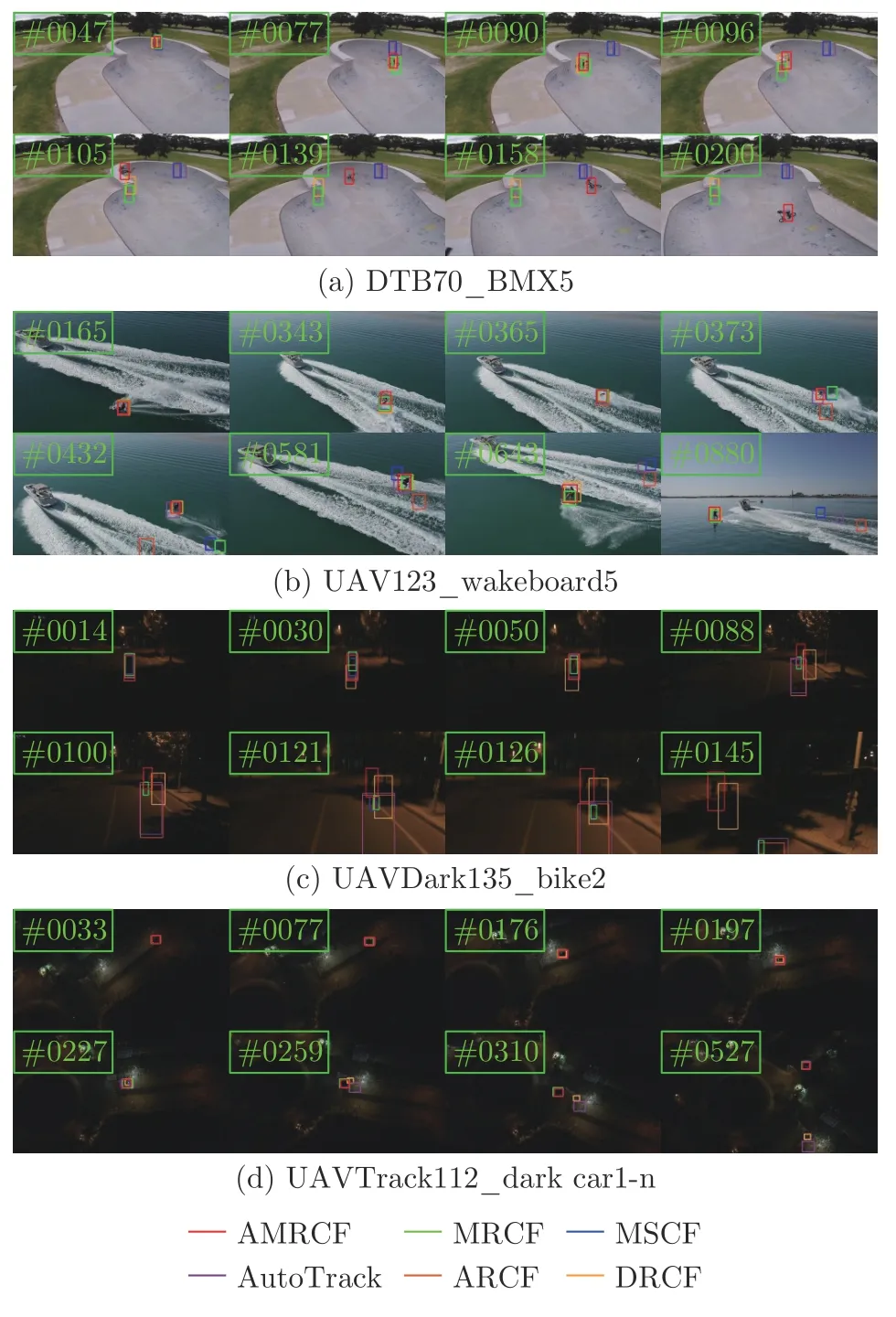

為更加直觀地展示AMRCF 相對于其他無人機目標跟蹤算法的優勢,本節對以上6 個無人機算法在具有平面內外旋轉、遮擋、光照不足、形變等特定場景下的跟蹤結果進行了可視化,可視化結果如圖7 所示(完整的視頻在該站點中可以訪問https://gitee.com/he_bing_DLMZ/amrcf/tree/master/A MRCF/results/vis-video).

圖7 6 個無人機目標跟蹤算法的跟蹤結果在部分序列上的可視化對比Fig.7 Visual comparison of tracking results of six UAV tracking algorithms on selected sequences

1)平面內外旋轉.在視頻序列DTB70_BMX5中,相對于拍攝平面,序列中的目標做極限動作時,在第47、77、158 和200 幀圖像中發生平面內外旋轉.其他幾個算法在前幾幀對目標進行了跟蹤,但在后續幀中跟蹤框發生漂移而丟失目標.AMRCF 算法能夠持續捕獲目標,未發生目標丟失情況.在視頻序列UAV123_wakeboard5 中,目標在第343、581 和643 幀中發生旋轉,AMRCF 算法對目標進行了精準的定位.這表明,通過引入高斯形狀掩膜并用CF-VGG 提取目標的深度特征,有效解決了因目標旋轉而導致跟蹤失敗的問題.

2)遮擋.遮擋是無人機目標跟蹤中占重要比例的挑戰因素,在視頻序列DTB70_BMX5 和UAV-123_wakeboard5 中都存在遮擋現象.在DTB70_BMX5 的第96 幀,目標被部分遮擋時,其他算法都丟失了目標,而AMRCF 和DRCF 成功捕獲目標.不同的是,本文算法對目標進行了精準的定位,而DRCF 邊界框發生漂移,導致僅捕獲到部分目標.在第105 幀,目標發生完全遮擋后重現時,DRCF徹底失去目標,而本文算法對目標進行了精準捕獲.在視頻序列UAV123_wakeboard5 的第365 幀,目標被海浪遮擋,在第373 幀再次出現時,僅本文算法、AutoTrack 和DRCF 定位到了目標.引入高斯形狀掩膜來抑制邊界效應和防止樣本污染,使得本文算法的定位精度要高于AutoTrack 和DRCF.

3)光照不足.UAVDark135_bike2 和UAVTrack112_dark car1-n 是夜間拍攝的,光照不足是它們共有的挑戰.在視頻序列UAVDark135_bike2的前30 幀,6 個算法都對目標進行了精準定位,但在第30 幀后,其他算法無法應對黑暗場景而紛紛丟失目標.在第88 幀后,除AMRCF 外,其他5 個算法徹底丟失目標.在視頻序列UAVTrack112_dark car1-n 的前197 幀,測試算法都定位到目標,但AutoTrack 發生小幅度的漂移而未精準定位.在第227 幀到259 幀,目標從相對較亮的區域移至黑暗區域時,AutoTrack、ARCF 和DRCF 丟失目標,AMRCF 引入的自適應圖像增強模塊,可以在不改變圖像各通道顏色比例的前提下對圖像進行增強處理,而未丟失目標,且對目標進行精準定位.

4)形變.在視頻序列UAV123_wakeboard5 的跟蹤過程中,目標要通過不同的動作來維持自身平衡而發生大幅度形變,致使目標特征變化較大.在第373 幀和432 幀,隨著目標形態的變化,MRCF、MSCF、ARCF 算法相繼失去對目標的跟蹤能力,且AutoTrack 在目標尺度估計上出現較大偏差.而本文算法使用CF-VGG 來提取深度特征,并結合CN等手工特征來描述目標的語義信息,實現了對目標的魯棒跟蹤.

通過以上分析和可視化結果可以看出,本文將MRCF 與自適應圖像增強模塊、CF-VGG 和高斯形狀掩膜結合而構建的AMRCF,可以輕松應對諸如平面內外旋轉、遮擋、光照不足、形變等挑戰.

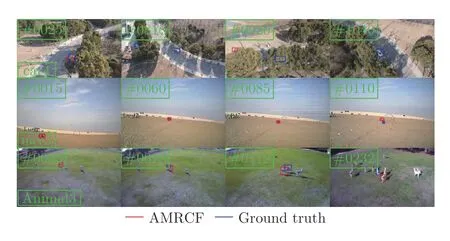

3.4.2 跟蹤失敗案例分析

本文所提出的AMRCF 跟蹤器在5 個無人機數據集上的總體跟蹤效果優于當前其他先進的無人機目標跟蹤算法,但在無人機目標的跟蹤過程中仍存在局限性.如圖8 所示,當場景中出現完全遮擋、相似物體、背景雜波以及低分辨率等因素時,會導致AMRCF 目標框發生漂移甚至丟失目標.

圖8 失敗案例的可視化對比Fig.8 Visual comparison of failure cases

如圖8 第1 行所示,在目標車輛未被遮擋前,AMRCF 能夠對目標進行精確跟蹤,未產生漂移或目標丟失現象.在第818 幀,車輛被樹木遮擋致使提取的目標特征減少而產生漂移;在第920 幀,目標被完全遮擋,提取的深度特征及手工特征中不包含目標信息,目標丟失;在第1 040 幀,目標在長期完全遮擋重現后,AMRCF 算法缺少重檢測策略而未能重新捕獲目標.在第2 行中,目標的快速移動使其與拍攝設備之間的距離逐漸增大,在視野中的分辨率變小并受到背景雜波的干擾,提取的特征中目標特征占據極小的比重而無法繼續定位并跟蹤目標.

圖8 第3 行是AMRCF 算法跟蹤相似物體的失敗情形.跟蹤前期,跟蹤目標未與相似目標產生重疊,目標框始終定位于跟蹤目標而未產生漂移;跟蹤到第18 幀時,跟蹤目標與其他目標重疊,目標框發生漂移;第232 幀中,兩目標之間不再重疊,跟蹤框未重新找回目標,定位于錯誤目標直至跟蹤結束.由于AMRCF 沒有重檢測模塊,無法檢測到目標何時消失及重現而導致完全遮擋挑戰下的跟蹤失敗,未來可以通過為算法添加重檢測機制來進一步提高其性能.

4 結論

本文提出一種全天實時跟蹤無人機目標的多正則化相關濾波算法AMRCF,在不改變圖像各通道顏色比例的前提下,使用自適應圖像增強模塊對夜間圖像進行光照增強處理,以應對夜間無人機目標跟蹤的挑戰;同時,在保證實時性的前提下,引入一個輕量型深度網絡CF-VGG 來提取目標的深度特征,聯合手工特征一起描述目標的語義信息,提高跟蹤器的魯棒性;通過嵌入高斯形狀掩膜,在抑制邊界效應的同時,解決訓練樣本污染問題,提高濾波器的訓練質量.在5 個公開的無人機基準數據集上的實驗結果表明,與先進的無人機目標跟蹤算法相比,AMRCF 算法表現出較強的競爭力,并且具有較好的實時性.在下一步工作中,將考慮在本文算法框架中加入重檢測模塊,進一步提升算法的性能.