基于雙邊采樣對比增強的不平衡圖像分類研究

彭祎祺 林珊玲 林志賢 周雄圖 郭太良

1(福州大學(xué)物理與信息工程學(xué)院 福建 福州 350116) 2(中國福建光電信息科學(xué)與技術(shù)創(chuàng)新實驗室 福建 福州 350116) 3(福州大學(xué)先進制造學(xué)院 福建 晉江 362200)

0 引 言

近年來,深度學(xué)習(xí)在圖像分類任務(wù)中的應(yīng)用愈加廣泛,并且大多實驗方法都能達到極佳分類效果。現(xiàn)有的圖像分類的數(shù)據(jù)集通常呈均勻分布,即數(shù)據(jù)集中各個類別與其相對應(yīng)樣本的數(shù)目大致相同。但實際分類任務(wù)中的數(shù)據(jù)集通常會產(chǎn)生極端不平衡長尾分布現(xiàn)象[1],也就是數(shù)據(jù)集的頭部類別對應(yīng)樣本數(shù)量較多,而尾部類別對應(yīng)樣本數(shù)目只占據(jù)極少部分。數(shù)據(jù)長尾分布現(xiàn)象使得模型在訓(xùn)練時,頭部類別數(shù)據(jù)易產(chǎn)生過擬合并且對尾部數(shù)據(jù)的建模能力不足,從而使模型預(yù)測精度降低,因此尋找一種能夠?qū)﹂L尾分布數(shù)據(jù)進行有效分類是當(dāng)前的亟待解決的問題。針對訓(xùn)練數(shù)據(jù)不平衡的問題,目前的方法主要是訓(xùn)練時將樣本采樣進行重新平衡,即過采樣或欠采樣、重新加權(quán)。

過采樣方法主要是重復(fù)抽取少數(shù)類別中樣本,以降低類別不平衡程度;文獻[2]提出使用類平衡采樣,首先對類別標(biāo)簽采樣,再對包含被采樣類別的圖像進行統(tǒng)一采樣從而達到類別均衡。雖然過采樣方法能夠?qū)?shù)據(jù)不足的類別樣本進行較大改進,但在訓(xùn)練階段容易產(chǎn)生過擬合現(xiàn)象。而欠采樣方法的核心是刪除多數(shù)樣本類別中的一些可用訓(xùn)練數(shù)據(jù),達到數(shù)據(jù)平衡;文獻[3]使用卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network,CNN)進行目標(biāo)檢測,訓(xùn)練過程中隨機選取背景圖像塊的10%進行模型訓(xùn)練,解決背景圖像塊與目標(biāo)圖像塊類別樣本不平衡問題。但由于長尾數(shù)據(jù)中頭部數(shù)據(jù)和尾部數(shù)據(jù)不平衡比例較大,重采樣方法會丟失數(shù)據(jù)的重要信息使深度網(wǎng)絡(luò)喪失泛化能力。

重加權(quán)法是為不同訓(xùn)練樣本分配權(quán)重,文獻[4]通過類別頻數(shù)的倒數(shù)和使用平滑的類別頻數(shù)的平方根倒數(shù)兩種加權(quán)法達到數(shù)據(jù)平衡;在樣本水平進行加權(quán)中,文獻[5]通過增加難以判別樣本的權(quán)重和減少對應(yīng)容易區(qū)分樣本權(quán)重,使神經(jīng)網(wǎng)絡(luò)對誤差敏感;在損失函數(shù)改造上,文獻[6]提出Softmax equalization同時應(yīng)用在樣本水平和類別水平訓(xùn)練,解決頭部數(shù)據(jù)訓(xùn)練的負梯度抑制同期訓(xùn)練的尾部數(shù)據(jù)的學(xué)習(xí)問題,對不同樣本分配不同權(quán)值從而有效對長尾數(shù)據(jù)進行分類。

在特征學(xué)習(xí)和分類結(jié)合方面,文獻[7]將傳統(tǒng)的分類網(wǎng)絡(luò)分解為特征學(xué)習(xí)和分類器學(xué)習(xí)兩部分,首先使用三種不同采樣策略抽取數(shù)據(jù)來訓(xùn)練并提取特征,然后使用類別均衡數(shù)據(jù)重新訓(xùn)練線性分類器的參數(shù),對學(xué)習(xí)到的特征進行KNN分類,利用歸一化分類器的權(quán)值來使得權(quán)值的尺度使數(shù)據(jù)更加平衡。文獻[8]引入記憶模塊,由于尾部數(shù)據(jù)無法利用特征提取器充分提取特征,將每個通過特征提取器的特征從記憶模塊對應(yīng)類似特征的表示信息,促進長尾數(shù)據(jù)的分類。這些方法將長尾類別分布問題視為訓(xùn)練期間批量采樣的不平衡因素,雖然重平衡模型可以正確分類尾部數(shù)據(jù),但類內(nèi)分布更稀疏,而且在一定上損害深度網(wǎng)絡(luò)學(xué)習(xí)的深度特征的表示能力。

對比學(xué)習(xí)在自監(jiān)督領(lǐng)域取得很好效果,其通過相似類別樣本和不同類別樣本學(xué)習(xí)特征,并且無須關(guān)注樣本的每個細節(jié),學(xué)到特征就能夠與其他樣本進行區(qū)分。文獻[9]提出一種基于視覺表示對比框架,計算同一數(shù)據(jù)示例的不同增強視圖之間潛在空間中的對比損失,在特征和對比損失間引入可學(xué)習(xí)線性變換達到特征質(zhì)量提高。文獻[10]在自監(jiān)督學(xué)習(xí)基礎(chǔ)上,將每個樣本進行數(shù)據(jù)增強使同類圖像的特征更接近,實現(xiàn)了同類特征接近、異類特征遠離的效果。

針對上述方法存在的問題以及對比學(xué)習(xí)的特征學(xué)習(xí)原理,本文提出一種基于雙邊采樣對比增強的漸進式學(xué)習(xí)分類網(wǎng)絡(luò)。首先將訓(xùn)練樣本進行均勻采樣和倒置采樣;將均勻采樣后樣本經(jīng)過兩種隨機增強,生成視圖樣本;之后倒置采樣樣本和對視圖樣本分別送入卷積神經(jīng)網(wǎng)絡(luò)進行特征學(xué)習(xí);進一步利用對比學(xué)習(xí)方法得到高質(zhì)量的視圖樣本特征,達到聚合同類分散異類的效果;通過漸進式學(xué)習(xí)累加提取到的兩種特征向量并送入分類器學(xué)習(xí),最后計算整個網(wǎng)絡(luò)的損失函數(shù),訓(xùn)練整個模型得到更加精準(zhǔn)的分類準(zhǔn)確率。

1 相關(guān)概念

1.1 ResNet50卷積神經(jīng)網(wǎng)絡(luò)

深度網(wǎng)絡(luò)能夠提取豐富特征,但由于梯度消失等原因,訓(xùn)練數(shù)據(jù)和測試數(shù)據(jù)的準(zhǔn)確率隨著網(wǎng)絡(luò)層增多而降低。正則化和初始化梯度問題的解決方法會使網(wǎng)絡(luò)逐漸退化,優(yōu)化效果更差[11-12]。ResNet是利用殘差塊搭建的深度神經(jīng)網(wǎng)絡(luò),殘差學(xué)習(xí)將輸入信息給到輸出,減少信息的損失以保證網(wǎng)絡(luò)的整體性能。它由49個卷積層和1個全連接層組成并且有兩種殘差模塊,一種是以兩個3×3的卷積網(wǎng)絡(luò)串接的殘差模塊,一種是1×1、3×3、1×1的3個卷積網(wǎng)絡(luò)依次串接的殘差模塊。每個殘差模塊首先使用1×1卷積下采樣,高和寬減半削減維度,使分辨率降低,然后用3×3的卷積核下采樣,最后用1×1的卷積恢復(fù)維度,能夠避免造成數(shù)據(jù)損失。利用網(wǎng)絡(luò)的殘差函數(shù)F(x)=H(x)-x,擬合恒等映射網(wǎng)絡(luò)。使用shortcut連接,不會引入額外的參數(shù)和增加模型的復(fù)雜度。殘差塊將輸入通過shortcut通道直接給到輸出,再與經(jīng)過卷積后的輸出相加。這種跳躍結(jié)構(gòu),能在網(wǎng)絡(luò)訓(xùn)練到最優(yōu),繼續(xù)加深層數(shù)時,恒等映射理論上保留最優(yōu)狀態(tài)。本文中選用三層殘差塊,能夠降低網(wǎng)絡(luò)中參數(shù)的數(shù)目,且達到充分訓(xùn)練網(wǎng)絡(luò)的效果。

1.2 圖像增強

圖像增強是通過對給定數(shù)據(jù)樣本做隨機變換,產(chǎn)生相似但與原始圖像不同的訓(xùn)練樣本,以增多訓(xùn)練數(shù)據(jù)集的數(shù)量,增強模型對未學(xué)習(xí)過的數(shù)據(jù)的分類效果,降低模型對樣本的依賴性,提升模型的泛化能力[13]。

常用的圖像增強主要包括空間變換法、像素變換法和增強對比度法。隨機翻轉(zhuǎn)的空間變化法是以一定的概率隨機水平或垂直翻轉(zhuǎn)圖片,翻轉(zhuǎn)結(jié)果不會改變圖像的類別,從而達到圖片增強目的;隨機裁剪的空間變化法則會讓目標(biāo)隨機出現(xiàn)在圖像的不同位置,生成包含不同信息的目標(biāo)樣本;通過隨機空間增強,降低模型對目標(biāo)位置的敏感性。像素變換法是通過增加噪聲、濾波、調(diào)整對比度和亮度等生成不同樣本。當(dāng)訓(xùn)練過程中經(jīng)常出現(xiàn)某類圖像時,神經(jīng)網(wǎng)絡(luò)會學(xué)習(xí)高頻特征,從而導(dǎo)致模型發(fā)生過擬合;加入噪聲使高頻特征失真,生成極為有用的圖像以增加有效樣本。圖像亮區(qū)與暗區(qū)的灰度比值即為對比度,采用增強對比度以更突出目標(biāo)區(qū)域,將暗區(qū)變得更加清晰;通過調(diào)整亮度、色彩等因素能降低模型對色彩的敏感度。

1.3 對比學(xué)習(xí)

對比學(xué)習(xí)主要包括正樣本和負樣本兩個部分,通過潛在空間的對比損失最大限度地提高相同數(shù)據(jù)樣本的不同擴充視圖間的一致性來學(xué)習(xí)特征[14]。對比學(xué)習(xí)的計算流程:首先選取一個批次樣本N個,對每個樣本進行兩次隨機數(shù)據(jù)增強,得到2N個新圖像數(shù)據(jù)送入網(wǎng)絡(luò)訓(xùn)練,經(jīng)過特征提取產(chǎn)生2N個特征向量。對于任意一幅圖像,其余2N-1幅圖像都會存在與該圖像類似的樣本,將同一樣本的兩幅圖像即正樣本和其他樣本的圖像即負樣本的特征分別對比,達到區(qū)分樣本特征的目的,極大地提高了學(xué)習(xí)特征的質(zhì)量。在沒有標(biāo)簽的數(shù)據(jù)的自監(jiān)督對比學(xué)習(xí)中,由于無法預(yù)知圖像類別,只能讓相同圖像特征彼此接近。對于有圖像類別的監(jiān)督學(xué)習(xí),可以將同類圖像的特征更接近,正樣本對來自同一個訓(xùn)練樣本,通過數(shù)據(jù)增強等操作得到的兩個特征向量,使得兩個特征越接近越好,負樣本對來自不同訓(xùn)練樣本的兩個特征向量,使得兩個特征越遠離越好,實現(xiàn)了同類特征接近、異類特征遠離的效果。

2 基于雙邊采樣對比增強算法

2.1 BBRCL模型結(jié)構(gòu)

模型主要分為特征學(xué)習(xí)部分、分類器學(xué)習(xí)部分和對比學(xué)習(xí)部分。

為解決圖像分類中類別不平衡的問題,通常會對訓(xùn)練數(shù)據(jù)進行重采樣或重加權(quán)法來調(diào)整類別的均衡性以此影響分類器的權(quán)重更新,但這種方法在一定程度上破壞學(xué)習(xí)到的深度特征,使得類別分布更加離散。為改善傳統(tǒng)平衡類別存在的缺陷,本文提出的BBRCL模型,通過均勻采樣和倒置采樣數(shù)據(jù)訓(xùn)練網(wǎng)絡(luò)提取深層特征訓(xùn)練分類器,且隨機增強樣本的對比學(xué)習(xí)能得到更豐富的特征優(yōu)化分類效果,模型的整體結(jié)構(gòu)如圖1所示。

圖1 BBRCL模型的整體結(jié)構(gòu)

特征學(xué)習(xí)部分包含均勻采樣特征學(xué)習(xí),倒置采樣特征學(xué)習(xí),通過神經(jīng)網(wǎng)絡(luò)訓(xùn)練進行特征學(xué)習(xí)。當(dāng)訓(xùn)練集驗證集收集完成時,訓(xùn)練樣本輸入該模型,為對應(yīng)標(biāo)簽,上部分經(jīng)過均勻采樣處理,獲得一組樣本(xc,yc),下部分經(jīng)過倒置采樣處理,獲得一組樣本(xr,yr)。并且兩部分使用相同的殘差網(wǎng)絡(luò)結(jié)構(gòu),除最后一個殘差塊外均共享網(wǎng)絡(luò)權(quán)重。兩組樣本輸入到上下部分網(wǎng)絡(luò)中通過全局平均池化層獲得特征向量fc和fr。其中均勻采樣為每個樣本在一輪訓(xùn)練中被采樣的概率相同,且僅被采樣一次;倒置采樣為每類被采樣的概率與樣本數(shù)量成反比,一個類的樣本越多,該類采樣的概率越小。假設(shè)類別i的樣本數(shù)為Ni,所有類的最大樣本數(shù)為Nmax,權(quán)重可表示為wi=Nmax/Ni,因此具體的采樣概率如式(1)所示。

(1)

根據(jù)Pi隨機采樣,可得到一批訓(xùn)練數(shù)據(jù)。在網(wǎng)絡(luò)中共享權(quán)重,不僅有利于兩部分的特征學(xué)習(xí),而且降低了網(wǎng)絡(luò)訓(xùn)練的復(fù)雜度,減少計算量。

分類器學(xué)習(xí)部分主要采取漸進式學(xué)習(xí)策略,通過控制主干網(wǎng)絡(luò)提取到的特征向量fc、fr和分類損失函數(shù)L,來平衡兩部分的學(xué)習(xí)。

具體過程首先設(shè)置自適應(yīng)參數(shù)α,根據(jù)訓(xùn)練的周期以拋物線形式衰減,計算公式如式(2)所示。

(2)

式中:Tmax是總訓(xùn)練周期;T是當(dāng)前訓(xùn)練周期數(shù)。再給兩個特征分別加上權(quán)重得到對應(yīng)加權(quán)特征αfc,(1-αfr)輸入到各自的分類器中,通過逐元素相加得特征輸出概率分數(shù),如式(3)所示。

z=αWcfc+(1-α)Wrfr

(3)

式中:Wc與Wr為正常采樣倒置采樣分別對應(yīng)的分類器,最后使用softmax函數(shù),預(yù)測樣本的類別。

由式(4)計算兩種采樣bloss,其中E(·)為交叉熵。

(4)

在特征學(xué)習(xí)和分類器學(xué)習(xí)的基礎(chǔ)上,加入對比學(xué)習(xí)策略。輸入的每個樣本經(jīng)過均勻采樣后,會隨機進行兩種不同的隨機數(shù)據(jù)增強,生成兩個來源同一個樣本的圖像,輸入到各自不經(jīng)過全連接層的殘差網(wǎng)絡(luò),通過MLP多層感知器映射到對比損失的空間。將來自同一樣本的圖像對,與其他樣本生成的圖像對使用矩陣相似對比法的對比學(xué)習(xí)策略,得到高質(zhì)量的樣本特征。整個模型的損失函數(shù)如式(5)和式(6)所示。

(5)

(6)

式中:Nyi是一個批次中數(shù)據(jù)總量;yi是i圖像的標(biāo)簽。多層感知器的層與層之間每個神經(jīng)元都有連接,本模型采用的MLP使用基礎(chǔ)的三層結(jié)構(gòu),輸入層、一層隱藏層和輸出層,使用ReLU激活函數(shù),隱藏層大小為2 048,輸出向量大小為128維。對該向量進行歸一化,使其位于單位超球面上,從而可以使用內(nèi)積測量投影空間中的距離。

最后將對比學(xué)習(xí)部分損失closs加入BBRCL的損失中,理想收斂情況下,可以增加樣本數(shù)量,使得同類樣本特征足夠相似,以此優(yōu)化分類器學(xué)習(xí)的預(yù)測準(zhǔn)確率。

因此,整個BBRCL模型的總損失如式(7)所示。

loss=lboss+lcoss

(7)

2.2 模型訓(xùn)練

訓(xùn)練數(shù)據(jù)集數(shù)據(jù)(xi,yi),i=1,2,…,n,依次進行均勻采樣(xc,yc),倒置采樣(xr,yr),經(jīng)過均勻采樣的樣本(xc,yc)隨機進行兩種數(shù)據(jù)增強,得到來自同個樣本兩個的不同視圖(xci,yc),(xcj,yc),倒置采樣的樣本經(jīng)過隨機數(shù)據(jù)采樣得到(xri,yr)。將這三組樣本輸入相應(yīng)的CNN網(wǎng)絡(luò),經(jīng)過全局平均池化層獲得特征向量fc、fci和fr。fc和fr輸入進行分類器Wc、Wr訓(xùn)練,分類器的學(xué)習(xí)主要采取漸進式學(xué)習(xí),通過自適應(yīng)參數(shù)α控制權(quán)重,輸入特征向量得到概率,從而計算得到兩種采樣的bloss函數(shù)。均勻采樣的特征向量fc、fcj,輸入多層感知器MLP映射到投影空間,對比學(xué)習(xí)計算closs函數(shù)。最后,由總的損失函數(shù)loss控制網(wǎng)絡(luò)訓(xùn)練,訓(xùn)練至分類準(zhǔn)確率最高,得到最優(yōu)的分類模型。

3 實驗結(jié)果與分析

3.1 數(shù)據(jù)集介紹

CIFAR-10數(shù)據(jù)集中包含10個類,每類有6 000幅圖像,總共6 000幅32×32的彩色圖像,其中劃分成50 000幅訓(xùn)練集和10 000幅測試集[15]。測試集數(shù)據(jù)取自10類中的每一類,每一類隨機取1 000幅,剩余數(shù)據(jù)隨機排列組成每批次10 000幅圖像的五批訓(xùn)練集。這些類完全相互排斥。

為創(chuàng)建不平衡的版本[16],人為減少每個類別的訓(xùn)練樣本數(shù)量,并保持驗證集不變。設(shè)計一個不平衡參數(shù)η來控制數(shù)量最多和數(shù)量最少樣本之間的比率,η=maxNi/minNi,調(diào)整η可以改變數(shù)據(jù)不平衡的程度。訓(xùn)練的過程中訓(xùn)練集采取隨機裁剪,隨機垂直或水平翻轉(zhuǎn),隨機色彩失真,0.2概率轉(zhuǎn)為灰度圖,驗證集不進行任何隨機變換。

3.2 對比實驗

為了探究BBRCL算法訓(xùn)練過程,在不平衡系數(shù)為20的CIFAR-10,設(shè)置訓(xùn)練輪數(shù)200個epoch,初始學(xué)習(xí)率為0.1,使用隨機梯度下降法,在前5個epoch使用學(xué)習(xí)率優(yōu)化策略-線性學(xué)習(xí)率warm up對學(xué)習(xí)率進行初步調(diào)整,在100和150 epoch學(xué)習(xí)率各衰減0.01。

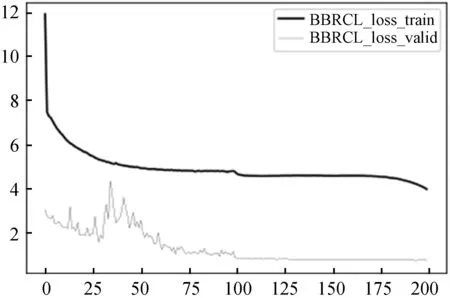

圖2為BBRCL在不平衡系數(shù)為20的CIFAR-10上訓(xùn)練集與驗證集準(zhǔn)確率。200個epoch訓(xùn)練過程中,前50個epoch更關(guān)注樣本數(shù)據(jù)大的類別,即頭部數(shù)據(jù),訓(xùn)練精度train_acc不斷增加,而后模型開始提取樣本較少的類別特征,逐漸關(guān)注尾部數(shù)據(jù),訓(xùn)練準(zhǔn)確率train_acc開始下降。經(jīng)過學(xué)習(xí)率的衰減和分類器的訓(xùn)練,在140個epoch后train_acc急劇上升,訓(xùn)練集準(zhǔn)確率達到98.49%。驗證集valid_acc前期迅速上升,在開始關(guān)注少量樣本時,有短暫不穩(wěn)定的下降,而當(dāng)訓(xùn)練穩(wěn)定,valid_acc一直穩(wěn)步上升,直到擬合達到最大分類準(zhǔn)確率84.64%。

圖2 訓(xùn)練集與驗證集準(zhǔn)確率曲線

圖3為BBRCL在不平衡系數(shù)為20的CIFAR-10上訓(xùn)練集與驗證集的損失函數(shù)。train_loss為均勻采樣隨機增強兩個視圖之間的對比closs與兩種采樣間bloss之和,valid_loss為多分類交叉熵softmax計算得到的loss。由圖中可看出,train_loss在前期急速減少,之后平穩(wěn)減少,valid_loss在關(guān)注少量樣本時,有段不穩(wěn)定的波動變化,而后穩(wěn)步下降直至擬合。

圖3 訓(xùn)練集與驗證集loss曲線

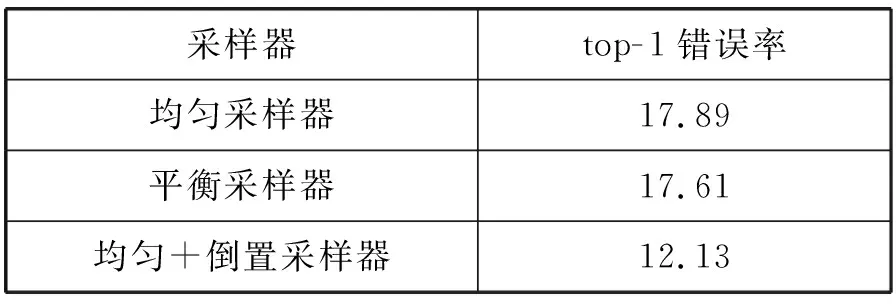

為對比不同采樣器對于分類的影響,使用均勻采樣器,平衡采樣器和倒置采樣器。均勻采樣能夠保持數(shù)據(jù)的原始分布;平衡采樣器使每個類具有相同的采樣概率,構(gòu)建標(biāo)簽平衡的分布;倒置采樣使樣本少的數(shù)據(jù)采樣概率大,使得訓(xùn)練時更關(guān)注數(shù)據(jù)少的類別[17]。CIFAR-10在不平衡參數(shù)設(shè)置為20,表1為使用不同采樣器訓(xùn)練的模型top-1錯誤率。

表1 top-1錯誤率(%)

其中使用均勻采樣器與倒置采樣器結(jié)合訓(xùn)練的模型準(zhǔn)確率有較大的提高。由此可見漸進式學(xué)習(xí)頭部數(shù)據(jù)與尾部數(shù)據(jù)的特征有益于分類準(zhǔn)確率的提升。

實驗選取三個不同的不平衡參數(shù)ratio:20、50、100,分別在CIFAR-10數(shù)據(jù)集、CIFAR-100數(shù)據(jù)集上訓(xùn)練。表2給出不同平衡參數(shù)設(shè)置下訓(xùn)練的模型top-1錯誤率。

表2 數(shù)據(jù)集信息

在均勻采樣使用數(shù)據(jù)增強每個樣本產(chǎn)生隨機兩個視圖,通過映射到投影空間對比計算類別距離的方法,能夠在兩個數(shù)據(jù)集訓(xùn)練中最佳準(zhǔn)確率得到較大的提升。

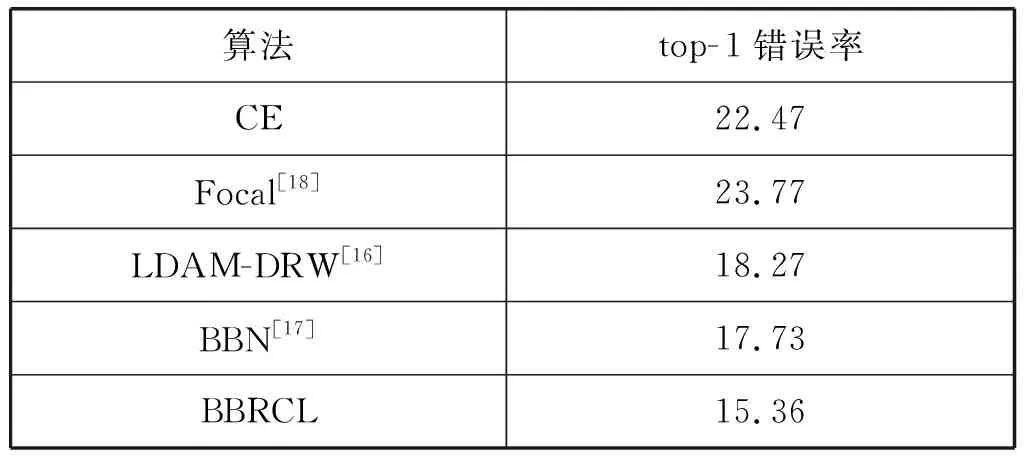

本文選擇四種訓(xùn)練不平衡數(shù)據(jù)的方法,與BBRCL進行實驗對比。使用CrossEntropy交叉熵損失函數(shù)CE、Focal損失函數(shù)[17]、LDAM-DRW邊緣損失函數(shù)、BBN算法訓(xùn)練模型。表3給出五種不平衡分類算法在CIFAR-10數(shù)據(jù)集,設(shè)置不平衡參數(shù)為50的模型訓(xùn)練的模型top-1錯誤率。圖4為五種算法的top-1準(zhǔn)確率曲線。

表3 CIFAR-10數(shù)據(jù)集上ratio 50各算法top-1錯誤率(%)

圖4 不同算法的top-1準(zhǔn)確率曲線

CE、Focal、LDAM-DRW采樣訓(xùn)練樣本的概率均相同,準(zhǔn)確率處于不斷上升直到收斂狀態(tài)。BBN、BBRCL使用均勻采樣與倒置采樣漸進進行,在關(guān)注尾部數(shù)據(jù)準(zhǔn)確率有短周期下降,繼而波動最終穩(wěn)定上升到收斂。從結(jié)果上看,BBRCL模型準(zhǔn)確率顯著提升。

改進后的算法不僅能提取圖像更深層的特征有益于模型學(xué)習(xí),而且在準(zhǔn)確率上比現(xiàn)有最優(yōu)算法提升2%,相比于傳統(tǒng)方法提升6%~7%,模型的穩(wěn)定性也高于傳統(tǒng)算法。對比傳統(tǒng)的處理數(shù)據(jù)不平衡方法,BBRCL算法具有很大的優(yōu)勢。

4 結(jié) 語

本文針對極度不平衡的長尾問題,提出一種基于雙邊采樣增強的漸進式學(xué)習(xí)分類網(wǎng)絡(luò),同時訓(xùn)練特征學(xué)習(xí)器分類器,對訓(xùn)練樣本分別進行均勻采樣和倒置采樣,使用兩種不同的數(shù)據(jù)增強方法得到樣本的不同視圖,進行對比學(xué)習(xí)使得類內(nèi)距離更近,全面提高模型分類能力。實驗部分在兩個數(shù)據(jù)集上與其他再平衡方法進行比較,結(jié)果表明,本文提出的方法在數(shù)據(jù)不平衡分類的任務(wù)中性能優(yōu)于其他方法。對于樣本數(shù)據(jù)極度不平衡的任務(wù),具有一定的參考價值和實用性。本文提出的對比學(xué)習(xí)方法也可以擴展到無標(biāo)簽訓(xùn)練任務(wù)中,在自監(jiān)督領(lǐng)域能夠得以使用。