基于CNN 網(wǎng)絡(luò)的手寫(xiě)體數(shù)字識(shí)別系統(tǒng)的實(shí)現(xiàn)

楊之杰, 林雪剛, 阮 杰

(江蘇大學(xué) 計(jì)算機(jī)科學(xué)與通信工程學(xué)院, 江蘇 鎮(zhèn)江 212013)

0 引言

隨著機(jī)器學(xué)習(xí)的發(fā)展,基于神經(jīng)網(wǎng)絡(luò)的深度學(xué)習(xí)已成為熱點(diǎn),深度學(xué)習(xí)技術(shù)已被廣泛應(yīng)用在文字、圖像識(shí)別分類研究中。 目前在國(guó)內(nèi)外,針對(duì)手寫(xiě)體數(shù)字識(shí)別技術(shù)已經(jīng)比較成熟,相較于傳統(tǒng)光學(xué)字符識(shí)別(OCR)圖像識(shí)別技術(shù),基于深度學(xué)習(xí)的卷積神經(jīng)網(wǎng)絡(luò)算法可以在復(fù)雜場(chǎng)景下快速、準(zhǔn)確、有效地獲取并識(shí)別場(chǎng)景中文字。 由于手寫(xiě)體存在形態(tài)各異、千差萬(wàn)別、隨意性大、書(shū)寫(xiě)不規(guī)范的情況,同時(shí)還會(huì)存在數(shù)據(jù)采集時(shí)的光線、角度不同等問(wèn)題,手寫(xiě)數(shù)字識(shí)別問(wèn)題有著很大的挑戰(zhàn)性[1]。

卷積神經(jīng)網(wǎng)絡(luò)是一種受到人類的視覺(jué)神經(jīng)系統(tǒng)和早期的時(shí)延神經(jīng)網(wǎng)絡(luò)( Time - Delay Neural NetWork)的啟發(fā)而設(shè)計(jì)提出的多層神經(jīng)網(wǎng)絡(luò)。 卷積神經(jīng)網(wǎng)絡(luò)結(jié)合了共享權(quán)重、局部感受野、空間或時(shí)間上的下采樣三種思想,使得網(wǎng)絡(luò)具有較少的訓(xùn)練參數(shù)、簡(jiǎn)單的網(wǎng)絡(luò)結(jié)構(gòu)且適應(yīng)性強(qiáng)等優(yōu)點(diǎn)[2]

1994年,文獻(xiàn)[3] 提出LeNet,定義了卷積神經(jīng)網(wǎng)絡(luò)的基本架構(gòu)是卷積和池化,在手寫(xiě)體數(shù)字領(lǐng)域識(shí)別率達(dá)到99.13%。 2012年,文獻(xiàn)[4] 提出AlexNet,采用雙GPU 網(wǎng)絡(luò)結(jié)構(gòu)并使用ReLU作為激活函數(shù),使得網(wǎng)絡(luò)能夠獲得更加豐富的特征。 2014年,文獻(xiàn)[5] 提出VGG 系列模型(包括VGG-11/VGG-13/VGG-16/VGG-19),使用很“深”的網(wǎng)絡(luò)結(jié)構(gòu)并在同年的ImageNet Challenge 上獲得分類任務(wù)第二名、定位(Localization)任務(wù)第一名。

隨著神經(jīng)網(wǎng)絡(luò)的發(fā)展,網(wǎng)絡(luò)結(jié)構(gòu)越來(lái)越深,但是對(duì)于小圖像容量的手寫(xiě)體數(shù)字識(shí)別的實(shí)現(xiàn)并不需要大而深的網(wǎng)絡(luò)結(jié)構(gòu),否則對(duì)計(jì)算機(jī)處理性能將會(huì)造成巨大負(fù)擔(dān),因此,本文設(shè)計(jì)一個(gè)簡(jiǎn)單適宜的CNN網(wǎng)絡(luò)結(jié)構(gòu),實(shí)現(xiàn)了一個(gè)可以用于高精度識(shí)別的手寫(xiě)體數(shù)字識(shí)別系統(tǒng)。 本文研發(fā)的手寫(xiě)體數(shù)字識(shí)別系統(tǒng)主要分為2 個(gè)部分:GUI 交互界面與CNN 網(wǎng)絡(luò)模型。 其中,GUI 交互界面是通過(guò)Pyqt5 工具包進(jìn)行搭建,再通過(guò)所搭建CNN 網(wǎng)絡(luò)模型進(jìn)行相應(yīng)的圖像訓(xùn)練與測(cè)試,實(shí)驗(yàn)仿真不同模式下的圖像識(shí)別場(chǎng)景,得出結(jié)論為:基于CNN 網(wǎng)絡(luò)的圖像識(shí)別算法的識(shí)別率可以達(dá)到99.9% ,具有高精度的識(shí)別性能。 本文實(shí)現(xiàn)的CNN 手寫(xiě)體數(shù)字識(shí)別系統(tǒng)不僅可以有效實(shí)現(xiàn)手寫(xiě)體數(shù)字識(shí)別,同時(shí)還具有簡(jiǎn)單易行、識(shí)別性能優(yōu)良的優(yōu)點(diǎn)。

1 基于CNN 的手寫(xiě)體數(shù)字識(shí)別系統(tǒng)

1.1 系統(tǒng)實(shí)現(xiàn)概述

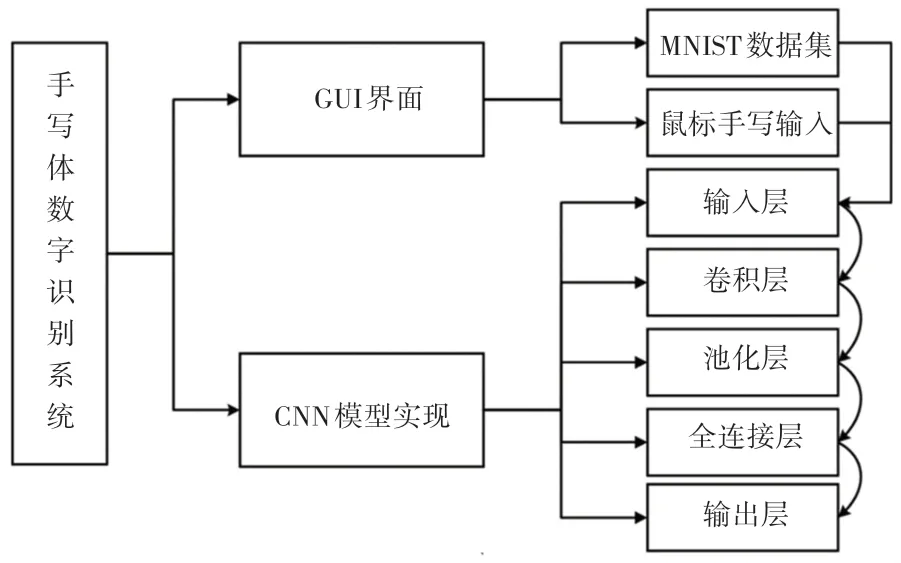

本文提出的手寫(xiě)體數(shù)字識(shí)別系統(tǒng)是基于卷積神經(jīng)網(wǎng)絡(luò)模型實(shí)現(xiàn)的一種高效簡(jiǎn)易的圖像識(shí)別系統(tǒng)。主要實(shí)現(xiàn)流程如圖1 所示。

圖1 手寫(xiě)體數(shù)字識(shí)別系統(tǒng)實(shí)現(xiàn)流程圖Fig. 1 The flow chart of handwritten digit recognition system implementation

由圖1 可見(jiàn),手寫(xiě)體數(shù)字識(shí)別系統(tǒng)主要分為2 個(gè)主要模塊,分別是:基于Pyqt5 的GUI 界面和基于CNN 的深度學(xué)習(xí)模型。 其中,Pyqt5 實(shí)現(xiàn)的GUI 界面用于用戶與PC 端的人機(jī)交互,用戶可以選擇系統(tǒng)識(shí)別的模式:MNIST 數(shù)據(jù)集隨機(jī)抽取、鼠標(biāo)手寫(xiě)輸入;基于卷積神經(jīng)網(wǎng)絡(luò)的識(shí)別模型主要通過(guò)5 個(gè)網(wǎng)絡(luò)層:輸入層、卷積層、池化層、全連接層以及輸出層,實(shí)現(xiàn)對(duì)用戶所選取的識(shí)別模式下的手寫(xiě)體圖片識(shí)別。

1.2 圖像采集與處理

1.2.1 MNIST 數(shù)據(jù)集識(shí)別模式

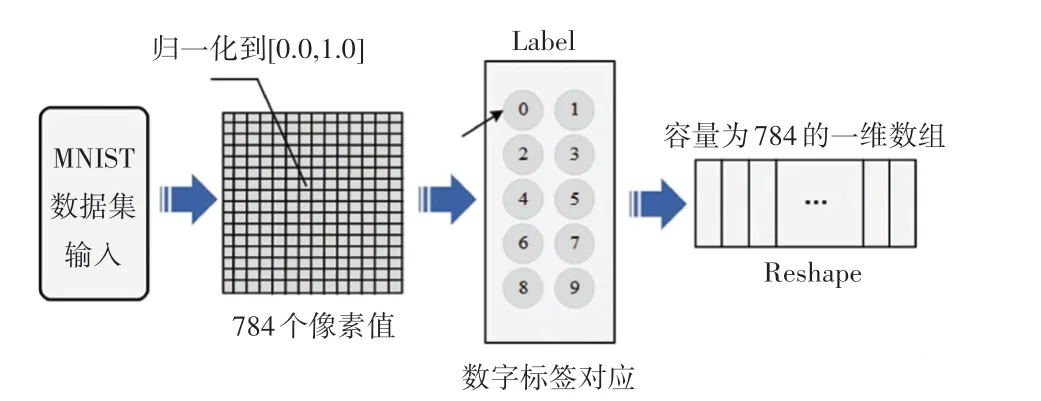

MNIST 數(shù)據(jù)集是由手寫(xiě)數(shù)字的圖片和相應(yīng)的標(biāo)簽組成,共有10 類,分別對(duì)應(yīng)數(shù)字為0 ~9。 訓(xùn)練圖片一共有60000張,可采用學(xué)習(xí)方法訓(xùn)練出相應(yīng)的模型。 測(cè)試圖片一共有10000 張,可用于評(píng)估訓(xùn)練模型的性能[6]。

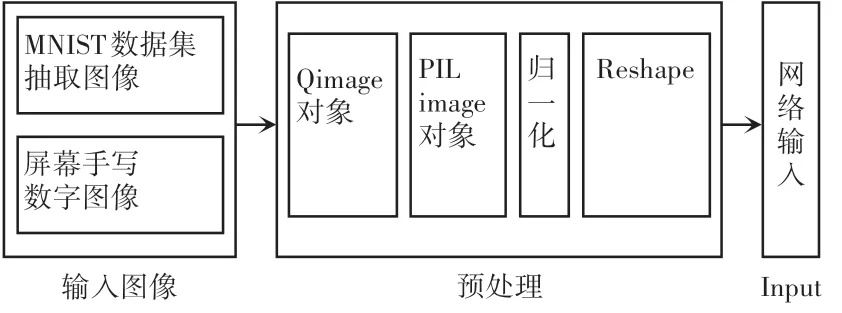

MNIST 數(shù)據(jù)集預(yù)處理過(guò)程如圖2 所示。 MNIST數(shù)據(jù)集抽取模式,要先將MNIST 數(shù)據(jù)集下載,手寫(xiě)數(shù)字識(shí)別系統(tǒng)使用自定義load_mnist函數(shù)進(jìn)行數(shù)據(jù)集的下載與本地保存。 本文中先將訓(xùn)練集與測(cè)試集中的手寫(xiě)體圖像進(jìn)行預(yù)處理,下載的數(shù)據(jù)集圖像保存為歸一化的像素值(范圍是0.0 ~1.0),同時(shí)將對(duì)應(yīng)的數(shù)字標(biāo)簽輸入展開(kāi)為一個(gè)784 的一維數(shù)組。 這樣有助于后續(xù)網(wǎng)絡(luò)模型的輸入處理。 同時(shí),在GUI界面的畫(huà)板區(qū)域內(nèi)將MNIST 數(shù)據(jù)集的抽取圖像轉(zhuǎn)換成Qimage 對(duì)象,用于后續(xù)的識(shí)別圖像處理。

圖2 MNIST 數(shù)據(jù)集預(yù)處理過(guò)程Fig. 2 Preprocessing process of MNIST dataset

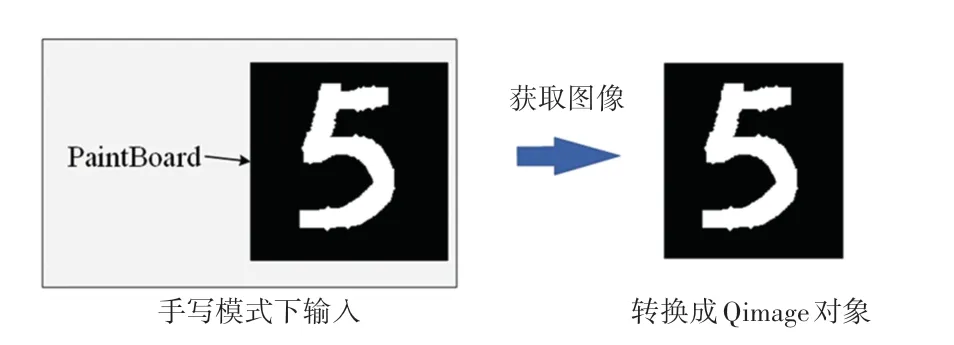

1.2.2 手寫(xiě)輸入識(shí)別模式

鼠標(biāo)手寫(xiě)模式是基于Pyqt5 的GUI 開(kāi)發(fā)框架實(shí)現(xiàn)的[7],在GUI 界面上設(shè)置一個(gè)空白畫(huà)板,背景色設(shè)置RGB(0,0,0),也就是純黑色;設(shè)置畫(huà)筆顏色為(255,255,255),也就是純白色。 利用Pyqt5 類庫(kù)中的繪圖工具進(jìn)行手寫(xiě)數(shù)字的交互事件實(shí)現(xiàn),本文實(shí)現(xiàn)的鼠標(biāo)手寫(xiě)圖像是只有黑白色的圖像,以方便2種圖像輸入模式后續(xù)使用相同的圖像識(shí)別處理過(guò)程。 用戶在GUI 界面的畫(huà)板上寫(xiě)下相應(yīng)的數(shù)字,點(diǎn)擊“識(shí)別”后,本程序就可以將畫(huà)板的內(nèi)容獲取并轉(zhuǎn)換成Qimage 對(duì)象,再通過(guò)Reshape 將其變換成符合網(wǎng)絡(luò)輸入規(guī)范的三維向量,用于后續(xù)CNN 網(wǎng)絡(luò)模型識(shí)別處理。 手寫(xiě)模式的圖像采集過(guò)程如圖3 所示。

圖3 手寫(xiě)模式的圖像采集過(guò)程Fig. 3 Image acquisition process in handwriting mode

1.2.3 CNN 網(wǎng)絡(luò)實(shí)現(xiàn)

識(shí)別處理是針對(duì)上述的2 種輸入識(shí)別模式所采集的手寫(xiě)體數(shù)字圖像進(jìn)行CNN 網(wǎng)絡(luò)模型輸入的規(guī)范化圖像對(duì)象處理,保證統(tǒng)一化的網(wǎng)絡(luò)輸入層的參數(shù)輸入。 在獲取了Qimage 對(duì)象后,需要將其轉(zhuǎn)換成Python 中的PIL image 對(duì)象,將圖像大小修改成1 通道的28×28 像素大小,同時(shí)批量大小為1,再將其轉(zhuǎn)換成灰度值歸一化的數(shù)組,規(guī)范成網(wǎng)絡(luò)輸入類型。手寫(xiě)體數(shù)字圖像的預(yù)處理過(guò)程如圖4 所示。

圖4 手寫(xiě)體數(shù)字圖像的預(yù)處理過(guò)程Fig. 4 Preprocessing of handwritten digital images

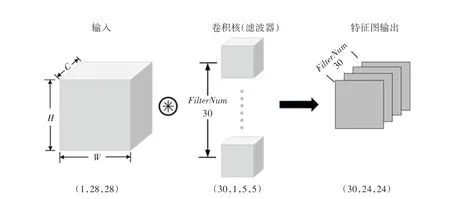

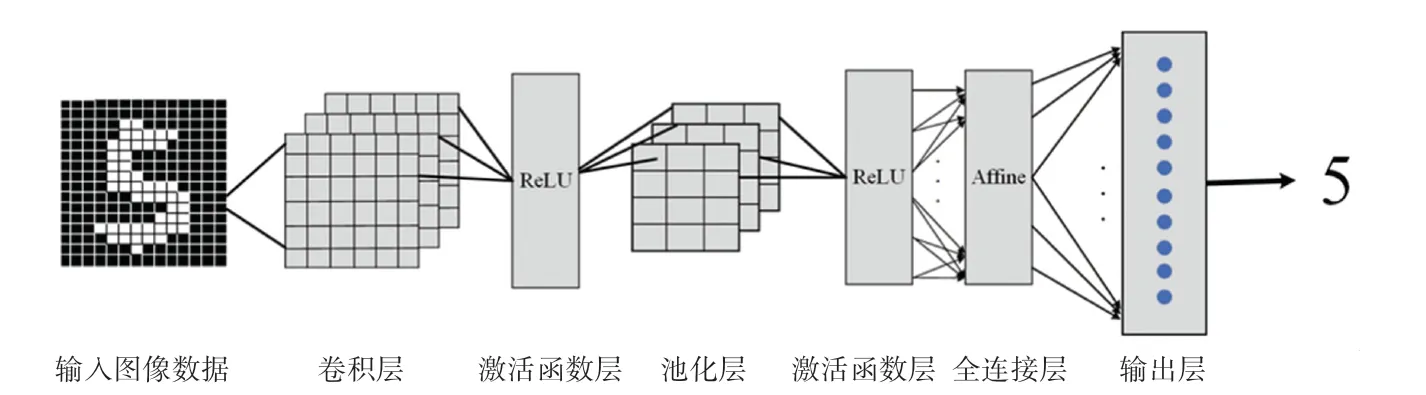

相比較傳統(tǒng)神經(jīng)網(wǎng)絡(luò),CNN 網(wǎng)絡(luò)新增了卷積層(Convolution 層)和池化層(Pooling 層),因此一般的CNN 模型就是由卷積層、池化層和全連接層構(gòu)成的。 Convolution 層實(shí)現(xiàn)結(jié)構(gòu)如圖5 所示。 本文通過(guò)一個(gè)簡(jiǎn)單合適的CNN 模型進(jìn)行手寫(xiě)體數(shù)字識(shí)別實(shí)現(xiàn),網(wǎng)絡(luò)結(jié)構(gòu)為“Convolution-ReLU-Pooling-Affine-ReLU-Affine-Softmax”。 CNN 網(wǎng)絡(luò)模型實(shí)現(xiàn)架構(gòu)如圖6 所示。 由圖6 可看到,對(duì)其中各組成部分?jǐn)M展開(kāi)闡釋分述如下。

圖5 Convolution 層實(shí)現(xiàn)結(jié)構(gòu)Fig. 5 Convolution layer implementation structure

圖6 CNN 網(wǎng)絡(luò)模型實(shí)現(xiàn)架構(gòu)Fig. 6 Implementation architecture of CNN network model

(1)卷積層。 在通過(guò)前一步的圖像采集與預(yù)處理后,輸入到卷積層(Convolution 層),該層的參數(shù)是通過(guò)反向傳播算法優(yōu)化得到的,隨后再將輸入元素進(jìn)行卷積運(yùn)算輸入到激活函數(shù)中,得到該層的輸出特征圖,卷積運(yùn)算見(jiàn)式(1):

卷積層的作用相當(dāng)于圖像處理過(guò)程中的“濾波器”運(yùn)算,以此獲取圖像的特征,本文設(shè)計(jì)的卷積層的卷積核(濾波器)的數(shù)量為30,大小為5×5,步幅為1,填充為0。

(2)ReLU層。ReLU層可以理解為激活函數(shù)層,當(dāng)輸入為正的時(shí)候,導(dǎo)數(shù)不為零,從而進(jìn)行基于梯度的學(xué)習(xí),對(duì)于圖像數(shù)據(jù)輸入而言,ReLU函數(shù)很適合進(jìn)行模型中非線性映射學(xué)習(xí),減少了參數(shù)之間的相互依存關(guān)系,避免了過(guò)擬合現(xiàn)象的發(fā)生[8]。ReLU函數(shù)的數(shù)學(xué)公式為:

(3)池化層(Pooling 層)。 可以縮小圖像尺寸,減少運(yùn)算量,通常在卷積層之后會(huì)得到維度很大的特征,將特征切分為多個(gè)區(qū)域,取其最大值,得到新的、維度較小的特征,并在偏置處理后通過(guò)激活函數(shù)輸出,如式(3)所示:

本文實(shí)現(xiàn)的池化層,主要通過(guò)數(shù)據(jù)展開(kāi)、求最大值、Reshape 成規(guī)范大小三個(gè)步驟來(lái)實(shí)現(xiàn)。 其中,數(shù)據(jù)展開(kāi)是為了簡(jiǎn)化本網(wǎng)絡(luò)中的向量運(yùn)算,將四維向量展開(kāi)成二維向量,便于數(shù)據(jù)處理;接著,求出每一行的最大值,作為輸出的元素;最后,將先前處理后的元素Reshape 成一個(gè)(30,1,12,12)的四維向量,輸入到下一層。

(4)Affine 層。 可以理解為全連接層,在網(wǎng)絡(luò)層中的正向傳播中進(jìn)行矩陣乘積運(yùn)算,主要是進(jìn)行神經(jīng)網(wǎng)絡(luò)中的加權(quán)運(yùn)算與偏置運(yùn)算,在本文系統(tǒng)設(shè)計(jì)中運(yùn)算為:np.dot(X,W)+B。

(5)Softmax 層。 作為最后的輸出層,主要用來(lái)將前一層(全連接層)的輸出作為輸入值進(jìn)行正規(guī)化,調(diào)整到0~1 之間后再輸出,用于實(shí)現(xiàn)最終的圖像識(shí)別分類。 此處需用到的數(shù)學(xué)公式為:

其中,yi是前一層的輸出目標(biāo)值。

1.2.4 界面顯示

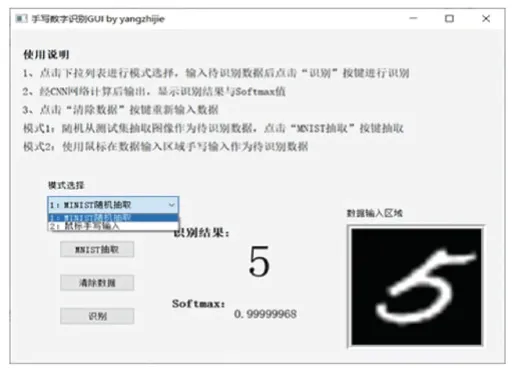

本文實(shí)現(xiàn)的PC 端的手寫(xiě)體數(shù)字識(shí)別系統(tǒng)界面是通過(guò)Pyqt 工具包搭建的,Pyqt 是一個(gè)用于創(chuàng)建GUI 應(yīng)用程序的跨平臺(tái)工具包,可將Python 與Qt 庫(kù)融為一體。 也就是說(shuō),PyQt 允許使用Python 語(yǔ)言調(diào)用Qt 庫(kù)中的API。 本文使用Python3.0 版本在VScode 編輯器進(jìn)行手寫(xiě)體數(shù)字識(shí)別GUI 應(yīng)用開(kāi)發(fā)。

通過(guò)Qt 界面生成器(Qt designer)[9],可以將所需要的控件進(jìn)行可視化的拖拽放置,大大提高了界面設(shè)計(jì)效率。 手寫(xiě)體數(shù)字識(shí)別系統(tǒng)設(shè)計(jì)界面如圖7所示。 由圖7 可看到,本文的系統(tǒng)界面主要是2 個(gè)部分。 第一部分是手寫(xiě)體數(shù)字識(shí)別模式選擇,模式選擇的布局就是通過(guò)QLabel、QComboBox 以及QPushButton 控件組成的。 其中,QComboBox 下拉框組件實(shí)現(xiàn)“MNIST 隨機(jī)抽取”與“鼠標(biāo)手寫(xiě)輸入”模式選擇,3 個(gè)QPushButton 按鈕用于實(shí)現(xiàn)MNIST 圖片抽取、清除數(shù)據(jù)、識(shí)別事件。

圖7 手寫(xiě)體數(shù)字識(shí)別系統(tǒng)設(shè)計(jì)界面Fig. 7 Design interface of handwritten digit recognition system

第二個(gè)部分是顯示區(qū)域,主要是實(shí)現(xiàn)所識(shí)別手寫(xiě)體數(shù)字圖像的顯示與識(shí)別結(jié)果、識(shí)別率的顯示。通過(guò)一個(gè)QLabel 組件用于顯示當(dāng)前所識(shí)別的手寫(xiě)體數(shù)字圖像,后續(xù)的圖像采集和預(yù)處理過(guò)程都是通過(guò)Qimage 對(duì)象變換實(shí)現(xiàn)的。

2 仿真結(jié)果與分析

基于上述的GUI 界面與網(wǎng)絡(luò)模型的實(shí)現(xiàn),本小節(jié)主要針對(duì)實(shí)驗(yàn)仿真結(jié)果進(jìn)行分析,并且得出有效的實(shí)驗(yàn)結(jié)論,證明本文所實(shí)現(xiàn)的手寫(xiě)體數(shù)字識(shí)別系統(tǒng)有著優(yōu)良性能。

實(shí)驗(yàn)仿真測(cè)試分為2 部分。 第一部分是按照“MNIST 隨機(jī)抽取”識(shí)別模式進(jìn)行仿真測(cè)試,第二部分是按照“鼠標(biāo)手寫(xiě)輸入”識(shí)別模式進(jìn)行仿真測(cè)試。2 種模式下分別進(jìn)行10 組手寫(xiě)體數(shù)字圖像識(shí)別仿真測(cè)試,每組選取10 張手寫(xiě)體圖像進(jìn)行識(shí)別。

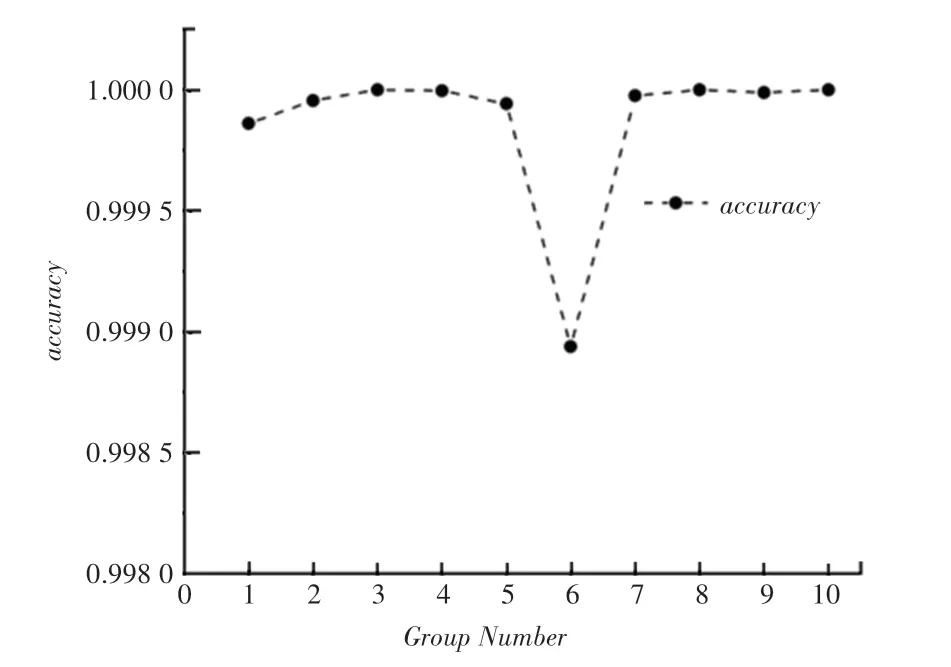

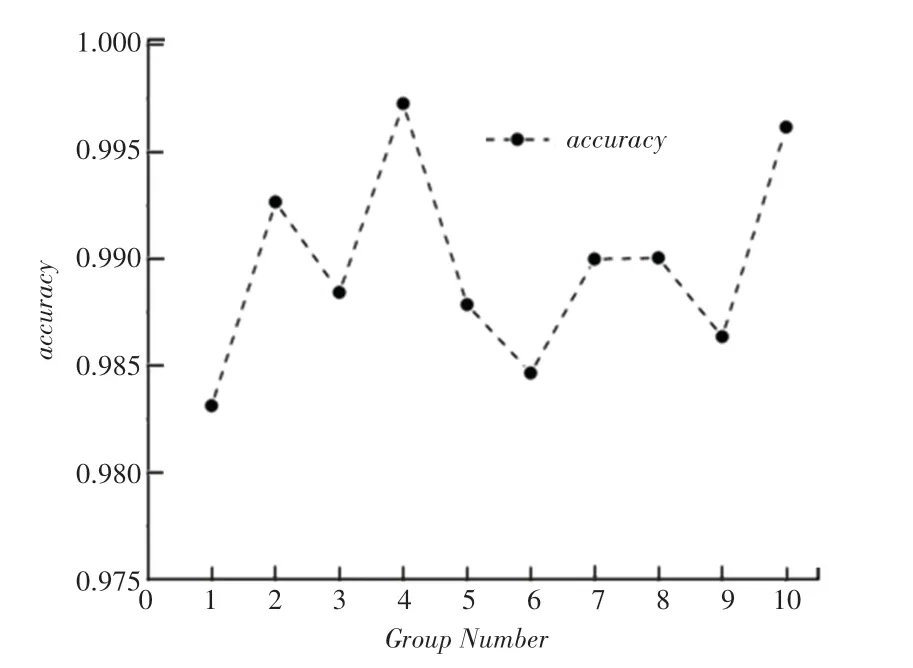

在第一種識(shí)別模式下,通過(guò)MNIST 數(shù)據(jù)集連續(xù)抽取10 張圖片進(jìn)行識(shí)別,分別進(jìn)行10 組圖像隨機(jī)抽取實(shí)驗(yàn),以每組的識(shí)別率均值作為本組實(shí)驗(yàn)數(shù)據(jù);在第二種模式下,通過(guò)本系統(tǒng)的GUI 界面連續(xù)手寫(xiě)輸入0~9、共10 個(gè)數(shù)字進(jìn)行識(shí)別,重復(fù)實(shí)驗(yàn)10 組,以每組的識(shí)別率均值作為本組實(shí)驗(yàn)數(shù)據(jù)。 MNIST 隨機(jī)抽取識(shí)別率如圖8 所示,手寫(xiě)輸入的識(shí)別率如圖9 所示。

圖8 MNIST 隨機(jī)抽取識(shí)別率Fig. 8 Recognition rate of MNIST random extraction

圖9 手寫(xiě)輸入的識(shí)別率Fig. 9 Recognition rate of handwritten input

實(shí)驗(yàn)結(jié)果顯示,MNIST 隨機(jī)抽取的10 組實(shí)驗(yàn)圖像識(shí)別率都在99.9% 以上,識(shí)別準(zhǔn)確率很高;相比之下,鼠標(biāo)手寫(xiě)輸入的仿真結(jié)果中,識(shí)別率分布在98.75% ~99.75% 區(qū)間,相較于MNIST 數(shù)據(jù)集測(cè)試的識(shí)別率而言,有所降低。

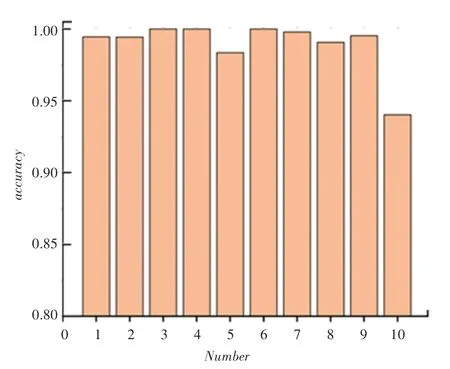

對(duì)于手寫(xiě)輸入模式下的手寫(xiě)體數(shù)字識(shí)別,在仿真實(shí)驗(yàn)中可以觀察到不同手寫(xiě)數(shù)字的識(shí)別率會(huì)出現(xiàn)較大差異,如圖10 所示。 由圖10 可看到,數(shù)字中“0”、“1”、“2”、“3”、“5”、“6”、“7”、“8”的識(shí)別率都較穩(wěn)定,在99%左右,而數(shù)字“4”的識(shí)別率在97.5%左右,數(shù)字“9”的識(shí)別率在94%左右,識(shí)別精確度相較于其他數(shù)字較低。

圖10 數(shù)字0 ~9 的識(shí)別率Fig. 10 Recognition rate of numbers 0 ~9

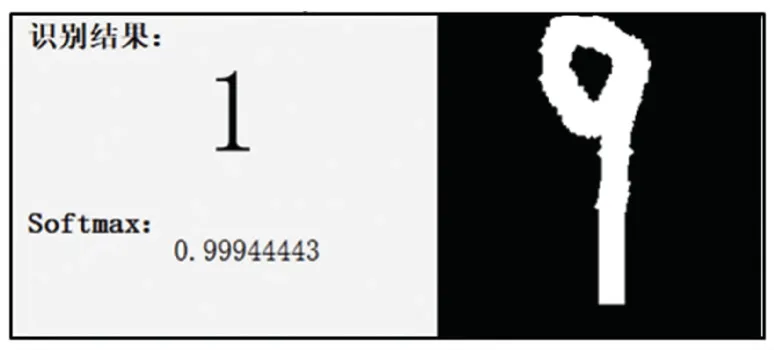

以數(shù)字“9”為例,數(shù)字“9”的手寫(xiě)體與“1”、“7”數(shù)字的形體十分相似,對(duì)識(shí)別造成了干擾。 誤判結(jié)果如圖11 所示,即使識(shí)別率達(dá)到了99.94% 但是卻誤判成數(shù)字“1”,也就是本文設(shè)計(jì)實(shí)現(xiàn)得到的CNN深度學(xué)習(xí)網(wǎng)絡(luò)對(duì)容易混淆的數(shù)字手寫(xiě)體的識(shí)別會(huì)出現(xiàn)誤判現(xiàn)象[10]。 即使是人為判斷,因個(gè)體差異也會(huì)出現(xiàn)對(duì)數(shù)字的錯(cuò)誤辨別,對(duì)于機(jī)器識(shí)別出現(xiàn)特殊字體的誤判也在合理范圍內(nèi)。

圖11 數(shù)字“9”的誤判Fig. 11 Misjudgment of the number “9”

3 結(jié)束語(yǔ)

從2 種識(shí)別模式下的仿真結(jié)果可以看出,MNIST 數(shù)據(jù)集抽取的圖像,系統(tǒng)識(shí)別率接近99.9%,說(shuō)明本文實(shí)現(xiàn)的CNN 網(wǎng)絡(luò)的識(shí)別性能優(yōu)良,簡(jiǎn)單易行,具有很好的實(shí)用性,基本達(dá)到了高精度目標(biāo)識(shí)別的要求;而鼠標(biāo)手寫(xiě)輸入下的圖像,系統(tǒng)識(shí)別率卻會(huì)在98%~99%之間波動(dòng),同時(shí)也會(huì)根據(jù)用戶書(shū)寫(xiě)規(guī)范程度有很大關(guān)系,這說(shuō)明了本文的CNN 網(wǎng)絡(luò)模型出現(xiàn)了過(guò)擬合現(xiàn)象,只針對(duì)MNIST 數(shù)據(jù)集中的數(shù)據(jù)有很好的識(shí)別性能,而對(duì)于個(gè)體差異的書(shū)寫(xiě)體卻不能做到精準(zhǔn)識(shí)別。 因此需要對(duì)網(wǎng)絡(luò)模型進(jìn)行再深層的優(yōu)化,提高可信度。