室外動態場景圖的構建及其三維重建方法研究

李健 康景堯 楊鈞 何斌

摘要:合理有效的表示空間和場景語義信息是計算機視覺高級任務的基礎之一.目前多數場景表示工作都是基于室內靜態環境展開的,對室外場景表示時,存在三維建模結果易受到光照等干擾以及分層表示的屬性、結構不適用的問題.故提出了一種針對室外環境的空間感知統一表示——室外3D動態場景圖,根據室外場景中對象的不同尺度、種類等,對分層的屬性及邏輯進行改進.特別針對現有三維重建方法易受到室外環境干擾的問題,結合深度特征度量改進稀疏重建中關鍵點調整和束調整步驟,通過改進后的關鍵點位置和相機位姿提高稠密重建的結果.在ETH3D數據集與自采室外圖像上進行三維重建實驗,并從準確率、完整率以及F1分數等指標上與其他多視幾何方法進行了對比.實驗結果表明,所提方法能夠更精確的重建室外場景,并且在光照等室外條件不理想情況下重建效果更好.

關鍵詞:場景理解; 室外3D動態場景圖; 室外三維重建; 運動恢復結構; 多視圖立體

中圖分類號:TP391文獻標志碼: A

Research on construction of outdoor dynamic scene graphs and

3D reconstruction method

LI Jian KANG Jing-yao YANG Jun HE Bin(1.School of Electronic Information and Artificial Intelligence, Shaanxi University of Science & Technology,? Xi′an 710021, China;? 2.College of Electronic and Information Engineering, Tongji University, Shanghai 201804, China)

Abstract:It is one of the fundamental problems in high-level computer vision tasks to represent the scene semantic information and spatial information comprehensively.Most current work aim at the indoor static environment.When representing outdoor scenes,there are problems that the three-dimensional modeling results are susceptible to interference such as lighting and the properties and structures of the hierarchical representation are not applicable.Therefore,a unified representation of spatial perception for the outdoor environment is proposed——outdoor 3D dynamic scene map,and the properties and logic of the layer are improved according to the different scales and types of objects in the outdoor scene.In particular,aiming at the problem that the existing three-dimensional reconstruction method is susceptible to outdoor environmental interference,combined with the depth featuremetric to improve the key point adjustment and bundle adjustment steps in the sparse reconstruction,the result of the dense reconstruction is improved by improving the key point position and camera posture.3D reconstruction experiments were performed on the ETH3D dataset and the self-production outdoor images,and compared with other multi-view geometry methods in terms of accuracy,completeness and F1 score.Experimental results show that the proposed method can reconstruct the outdoor scene more accurately,and the reconstruction effect is better under the unsatisfactory outdoor conditions such as lighting.

Key words:scene understanding; outdoor 3d dynamic scene graph; 3d reconstruction; structure from motion; multi view stereo

0引言

合理有效的將一個場景中不同層次的空間和語義信息統一表示并形成模型結構,是推動計算機在人機交互、自動駕駛、智能建造等領域應用的關鍵因素.Armeni等[1]針對室內場景,首先利用激光掃描獲取室內場景的高精度三維模型,其次使用場景圖[2]結構,建立了對象、3D空間和相機之間的關系;同樣針對室內場景,Rosinol等[3]首先對采用雙目相機獲取到的圖像和IMU(Inertial Measurement Unit)信息進行處理,使用Kimera這種方法[4]恢復場景的三維網格信息,然后提出了3D動態場景圖(3D Dynamic Scene Graphs, DSG)作為可操作空間感知的統一表示,添加了動態對象的語義信息,通過五層不同抽象的層捕獲場景的三維幾何和語義信息.目前多數工作都是針對室內場景,相較于室外場景的規模,對象之間不同的尺度、種類,以及豐富的區域屬性等特點,上述工作在進行室外場景表示時,可能會造成分層邏輯混亂、對象語義不完整等情況.

因此本文針對室外場景與室內場景的差異,在DSG[3]的基礎上,提出了室外3D動態場景圖(Outdoor 3D Dynamic Scene Graphs,ODSG),根據室外場景的規模、對象尺度、種類等特點,劃分不同的層次,支撐對室外場景的表示,并且可以通過更改不同節點的屬性關系,為其他計算機視覺任務提供不同級別的抽象信息特征.

三維模型作為3D場景圖的基礎,能夠提供任意的3D、遮擋等信息,并且ODSG中不同計算機任務的執行也依賴一個精確的三維模型.為了從圖像中重建出完整的場景三維模型,通用的方法是將重建分解為圖像檢索、圖像特征點匹配、稀疏重建和稠密重建等步驟.特征匹配作為重建的上游任務,特征點提取的準確與否決定了最終的重建效果.而在室外場景中,由于光照、幾何約束條件不理想等問題,會導致特征點的提取存在很大誤差.因此本文結合深度特征的魯棒性,通過深度特征度量優化傳統重建方法,提高重建模型的精度.

綜上所述,本文的主要貢獻是定義了室外3D場景圖ODSG的框架,并且對ODSG中的三維重建模塊進行了改進,結合深度特征解決室外三維建模中由于光照和約束不足造成的影響,提高稠密重建的質量.

1相關工作

1.1場景圖

場景圖是一種流行的計算機圖形模型,通過節點表示場景中的對象、邊表示節點間的關系,并進而描述、操作和渲染復雜的場景.相較于其他圖像的表示,場景圖包含了更多的視覺、語義、邏輯等信息.傳統的場景圖通常用于描述計算機視覺中的2D圖像內容,目前已經被用在圖像檢索、動作檢測、視覺回答等領域.但傳統的場景圖出現于深度學習之前,因此缺少了高級語義理解.Kim等[5]開創了3D場景圖在機器人和計算機視覺中的應用,但他們只捕獲了對象,缺少多個可以操作的層次.Armeni等[1]設計了一個半自動的框架,構建了場景中對象、相機語義以及實體間關系的場景圖,克服了手工制作耗時耗力的難題.目前多數工作的研究重點都是針對室內環境的,針對室外環境的工作還十分匱乏,但隨著數字孿生、智能建造等概念的提出,面向室外的場景圖表示也有大量的需求.

1.2三維重建

早期的三維重建方法通常使用圖像檢索、圖像特征點匹配、稀疏重建和稠密重建等子步驟完成重建.其中稀疏重建是根據圖像中的2D特征點進行匹配,獲取稀疏點云和相機位姿,是三維重建的核心任務.稠密重建是根據場景中相機的位姿參數,獲取更豐富的場景表達形式[6].但傳統方法依賴于場景中的幾何關系,對于弱紋理、光線不理想以及遮擋等情況的重建仍然有一定的挑戰.

近年來,由于神經網絡的發展,人們提出各種基于學習的重建方法.Eigen等[7]已經將基于監督學習的模型成功應用于單幅圖像深度估計.但是利用監督學習方法訓練這些模型需要場景準確的深度信息,而在室外場景中往往難以獲得這些深度信息.為了解決這個問題,Mayer等[8]研究在合成數據集上進行訓練 ,Chen等[9]通過收集相對深度注釋,并且將圖像映射到深度函數,表示成神經網絡來學習.雖然這些研究在一定程度上克服了監督學習的問題,但是大量的數據集依舊是一個挑戰,自監督學習方法因其能夠從原始立體對(Godard等[10])或者單目視頻(Zhou等[11]) 中直接學習單目深度估計模型的能力,而受到了很大的關注.自監督學習的核心思想是應用可微翹曲,使光度重投影的誤差最小.Godard等[10]利用Spatial Transformer Networks將立體圖像右側和左側圖像所預測出的深度幾何變化,合成為左側圖像.然后使用結構相似度和額外的深度正則化,以完全可微的方式定義合成圖像和原始左圖像之間的損失,從而允許深度網絡以端到端的方式進行自監督.

但是在室外環境寬基線、深度范圍較大的情況下,傳統方法基于強烈的幾何約束,重建結果準確率優于基于學習的方法.因此針對室外環境的三維重建,本文選擇在傳統方法上進行改進,通過融入深度特征,以提升室外場景三維重建方法的魯棒性.

2ODSG與三維重建方法

2.1ODSG框架

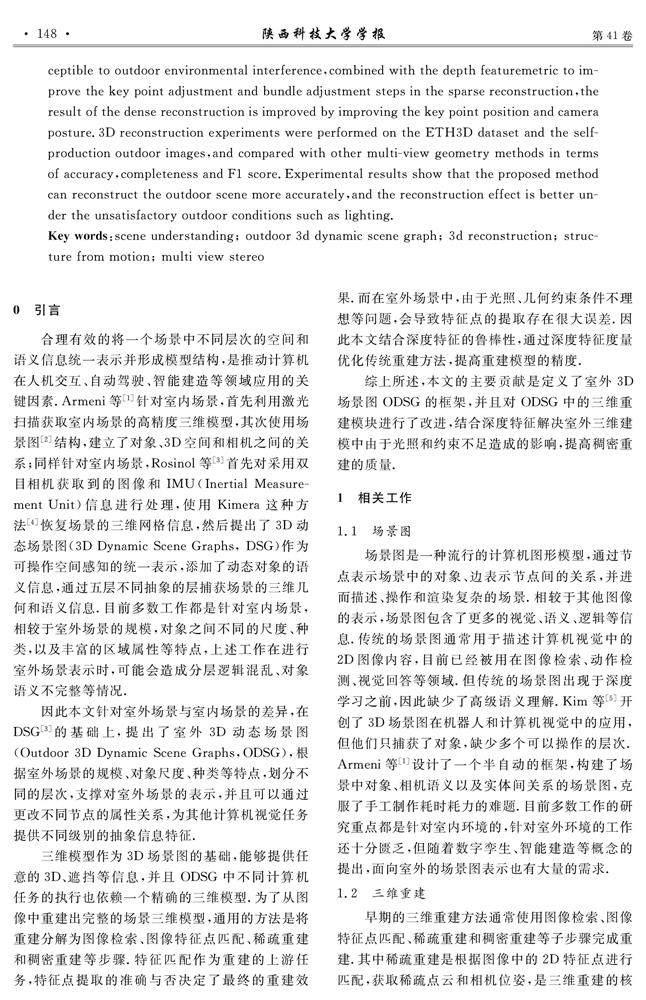

室外3D動態場景圖(ODSG)是一種針對室外場景的可操作空間感知的統一表示,它在不同的抽象層次上捕獲場景的三維幾何和語義信息,并對靜態對象、動態對象、地點、結構以及其之間的視覺關系進行建模,其框架如圖1所示.ODSG是一個具有分層結構的有向圖,每一層均有一組節點,每個節點都包含一組具體實例空間坐標、形狀或邊界框信息的屬性,節點之間均有一條表示關系的邊.ODSG將場景的抽象級別從低到高分為:(1)度量語義網格層(Metric-Semantic Mesh Layer,M);(2)對象層(Objects Layer,O);(3)結構層(Structures Layer,S);(4)區域層(Reigon Layer,R);(5)建筑層(Building Layer,B).層次劃分以及對應元素、屬性、不同層次之間的關系如表1所示.

(1)度量語義網格層:ODSG的最底層是場景的三維模型,該層中的節點是三維點(區域頂點),每個節點均具有兩個屬性:(i)三維位置;(ii)全景語義標簽,節點關系包括:本層節點之間的相對空間信息(M,M)以及節點與上層父級之間的關系(M,O).

(2)對象層:對象層主要由語義注釋的圖像分割與目標檢測數據所構成,其中包含兩種類型的節點:靜態對象與動態對象.

靜態對象表示環境中非結構化的靜態元素(桌椅、路標等),該層中的節點是三維包圍框中心點,每個節點均具有兩個屬性:(i)邊界框;(ii)語義標簽.

動態對象代表室外場景中的動態實體,包括非剛性類與剛性類.雖然存在許多類型的動態實體,但在這里為了不失一般性,ODSG主要關注兩類:非剛性的人類,剛性的車類.本層節點具有兩個共同的屬性:(i)3D包圍框;(ii)語義類.而非剛性類節點還具有3D位姿信息,3D位姿信息是由數學離散模型中定義的節點和邊組成的,節點是某時刻的位姿,邊是相對測量的位姿.節點關系包括:可見性、相對大小、距離、是否接觸等同層關系(O,O)、上層父級關系(O,S)與下層子級關系(O,M).

(3)結構層:結構層是不同空間之間的分隔物,這一層的主要任務為:捕獲不同空間之間的分割部件(道路、圍欄、墻壁等).將場景分割成不同功能區域的結構集合,結構的節點屬性包括邊界框、語義標簽與三維空間信息;節點的關系分為同層位置關系(S,S),以及集合內區域和結構關系(S,R)三種.

(4)區域層:區域層描述了場景中被分割的區域情況,節點分別對應著被分割的各個區域.每個節點均具有三個屬性:(i)三維信息;(ii)邊界框和(iii)語義標簽(休閑區、施工區、飲食區等).節點關系包括:區域之間的空間信息(R,R)、區域與上層父級的關系(R,B)、區域與下層子級關系(R,S).

(5)建筑層:建筑層描述了不同建筑物的信息,以建筑物為節點.每個節點均具有三個屬性:(i)三維信息;(ii)邊界框;(iii)語義標簽(如辦公樓、住房樓).節點關系包括:建筑物之間的空間信息(B,B)、建筑物與下層子級關系(B,R)兩種.

ODSG的基礎是度量語義網格層,該層中的元素為場景中的3D模型.在對整個場景以及場景中的對象、區域、建筑等進行3D建模后,ODSG使用SMPL[12]模型對場景中的人類進行建模,之后用語義分割算法提取節點的語義信息,通過關系網絡提取各節點的關系,將不同的層次連接起來,最終整合節點的屬性和關系構建ODSG.由于度量語義網格層的模型精度會影響到ODSG后續的操作,因此本文接下來主要聚焦于ODSG中度量語義網格層的三維重建任務.

2.2三維重建改進

目前,使用最廣泛的三維重建方法就是COLMAP[13].COLMAP不斷對主流三維重建中多個關鍵技術進行改進和優化,用于稀疏重建、稠密重建和表面重建.但是Germain等[14]的實驗表明,COLMAP使用的SIFT算子(Scale Invariant Feature Transform)在視覺變換強烈的室外環境會產生一定誤差,基于深度學習的特征提取方法在光照和約束條件不足的情況下表現更加優異.本文受Lindenberger等[15]的啟發,利用深度特征度量約束關鍵點之間的位置,對COLMAP方法進行改進,使得在光照和約束條件不足的室外環境場景三維重建中表現得更加優異.

本文方法框架如圖2所示,對于一組輸入的圖像,首先執行SFM(Structure from Motion)以實現面向稀疏重建的特征匹配,同時提取輸入圖像的深度特征;在試探性匹配后,通過最小化稀疏關鍵點之間的深度特征度量,優化關鍵點的位置;之后使用優化后的關鍵點進行后續的SFM操作.完成SFM操作后,用深度特征度量代替傳統束調整方法中3D點和重投影點之間的距離,通過最小化深度特征度量,獲得更準確的相機位姿和關鍵點的3D位置.接著使用COLMAP中的MVS(Mulit View Stereo)方法實現稠密重建,輸入優化后的相機位姿和稀疏點云,完成后續的稠密重建工作;最終使用更精確的三維點云構建ODSG.

在SFM稀疏重建的操作中,空間位置中的某一個3D點是由許多不同視角的2D稀疏關鍵點觀察得到,這些2D稀疏關鍵點之間的對應關系被稱為軌跡.SFM稀疏重建的幾何驗證就是通過2D關鍵點的對應關系進行的.由于3D點在每個圖像平面上只有一個投影點,所以有效的軌跡在一幅圖片中只能包含一個關鍵點.根據這一特性,本文借鑒Dusmanu等[16]的軌跡分離算法,在試探性匹配階段采用貪心策略,設所有軌跡中的節點集合為V,對V中任意兩個連接不同軌跡的節點u和v,以及邊u→v進行精煉.只有當u和v的patch來自不同的圖像時,連接這兩條軌跡,該方法能夠有效地刪除大多數不正確的匹配,降低匹配中的噪聲.下面重點對本文方法中不同于傳統方法的關鍵點調整優化和束調整優化做進一步闡釋.

(2)束調整優化.傳統的束調整通過最小化關鍵點與重投影關鍵點之間的差值,來獲得最優的相機參數和三維空間的關鍵點坐標.與傳統方法不同,本文采用方法是通過最小化深度特征點之間的距離來進行優化.首先采用公式(2)找到一個與軌跡j中所有關鍵點距離最小的向量,

3實驗結果與討論

3.1數據集與評價指標

本文的定量與定性實驗均使用ETH3D High-Res數據集[18]中的室外場景展開.ETH3D數據集提供了毫米級的相機位姿和激光掃描儀重建的稠密地面真實值,對于每個場景的地面真實值記錄2 800萬個點.ETH3D數據集使用專業的單反相機進行采集,采集圖像為2 400萬像素,分辨率為6 048×4 032像素.除此之外,為了驗證本文采用方法的泛化能力,本文定性實驗中還對自采的室外校訓石圖像進行了三維重建.

ETH3D數據集從完整率(ACC)、準確率(COM)以及F1分數三個方面對點云模型進行評估.輸入生成的點云文件,通過和真值點云進行計算可以得到評估的數據.其中,完整率定義為:與最近重建點的距離小于一定閾值的地面真實點的數量;準確率定義為:在距離閾值內的重建點和所有點的比值;F1分數綜合考量準確率和完整率,定義為:

3.2實驗細節

3.3實驗結果及其分析

3.3.1定量分析

本節通過與其他主流傳統方法進行對比評估,以驗證本文所用方法的有效性.實驗結果如表2所示.可以看出,本文方法在1 cm和2 cm范圍無論從準確率、完整率還是F1分數均優于其他方法,雖然在5 cm閾值內沒有達到最好的結果,但是總體上趨向于最好的結果.在運行時間方面,Gipuma表現更好,本文方法與COLAMP方法耗時相近.

這是因為本文在COLMAP的方法中結合了深度學習的方法,因此表現優于COLMAP與Gipuma[19].而Gipuma方法首先使用SFM進行稀疏重建,獲取相機參數,之后利用多視幾何方法進行稠密重建,在多視幾何的PatchMatch流程中,Gipuma采用了紅黑棋盤的傳播策略,能夠充分利用GPU實現大規模并行操作,提高了算法的效率,但是Gipuma方法并沒有使用視圖選擇策略,這會導致在視圖選擇中,沒有優先選擇具有足夠基線、類似分辨率及非傾斜拍攝方向的圖像,導致重建的魯棒性下降.COLMAP方法同樣首先使用SFM方法進行稀疏重建,獲取相機參數,之后使用多視幾何方法進行稠密重建,區別在于稠密重建時PatchMatch流程中選擇的策略不同.COLMAP使用了從上到下、從左到右的傳播策略,并且選擇了基于馬爾科夫鏈模型的視圖選擇策略,以運行時間為代價提高重建結果,因此在性能方面優于Gipuma.

3.3.2定性分析

為了進一步驗證本文方法的有效性,本節對校訓石和ETH3D數據集中的室外場景進行重建.實驗結果如圖3所示.其中,圖3(a)為校訓石的稠密重建,圖3(b)為數據集中室外場景(facade)的稠密重建,可以看出COLMAP可以較完整的重建場景,但由于圖3(a)中采集的圖像處于逆光狀態,導致紅框中的細節受到噪聲影響,而改進后的方法可以更好的恢復結果;在圖3(b)場景中,由于重復紋理區域以及噪聲干擾,COLMAP方法中的特征提取及匹配會出現一定誤差,導致區域幾何結構不正確,像素置信度降低,在結果中出現空洞,而本文方法在特征提取時結合神經網絡,增加了方法在特征提取時的魯棒性,同時能夠剔除一部分有誤差的匹配,因此表現優于COLMAP方法.驗證了融合傳統方法和深度學習方法在室外情況下的重建能力.

3.3.3消融實驗

為驗證本文引入方法的有效性,分析結合深度特征度量對重建的影響,本文從稀疏重建和稠密重建兩部分進行關鍵點調整模塊(EFKA)和束調整模塊(EFBA)的消融實驗.實驗在ETH3D數據集中的6個室外場景上進行,最終結果為6個場景評估數值的平均值.

稀疏重建的實驗結果如表3所示,第一行是無任何優化的稀疏重建結果,第二行是添加本文的關鍵點優化EFKA的結果,在1 cm、2 cm、5 cm閾值的條件下,準確率分別提升了13.89%、10.65%、6.06%,完整率分別提升了0.05%、0.17%、0.71%,準確率和完整率均有提高;第三行是添加本文的束優化EFBA結果,在1 cm、2 cm、5 cm閾值的條件下,準確率分別提升了16.8%、13.59%、8.59%,完整率分別提升了0.06%、0.22%、0.86%,準確率有較大的提高,完整率也有所提高;第四行是同時添加關鍵點優化和束優化的結果,達到了最好的效果,準確率較無任何優化的方法分別提升了18.37%、15.13%、9.27%,完整率分別提升了0.06%、0.24%、0.96%.傳統SFM使用SIFT算子提取關鍵點,并利用關鍵點進行后續的步驟,因此關鍵點的準確與否對重建結果影響很大.本文方法采用深度特征代替關鍵點,實驗的準確率提升較大.

針對稠密重建,為了驗證束調整對相機位姿、3D關鍵點位置的影響,實驗采用SFM估計的相機參數進行稠密重建,并使用ICP算法(Iterative Closest Point)與真值進行配準后,在1 cm、2 cm、5 cm的閾值內進行評估.實驗結果如表4所示,其中第一行是未做任何優化的結果,第二行是添加關鍵點優化(EFKA)的結果,整體結果均有提升,F1整體結果分別提升了2.48、4.68、1.95;第三行是添加束優化(EFBA)的結果,準確率有較大提升,完整度也有提升,F1整體結果分別提升了2.02、4.28、7.74;第四行是聯合優化的結果,準確率在1 cm、2 cm閾值均有提升,完整度有較大提升,F1整體結果分別提升了1.88、6.29、10.36.由于ICP配準算法的誤差存在,可能導致某項指標結果上下略有浮動,但是整體結果趨勢表明:結合深度特征度量的優化能夠有效提高稠密重建的結果.

4結論

本文構建了具有五層空間感知表示支撐的室外3D動態場景圖,根據室外場景對象的不同尺度、種類以及功能進行分層表示;并且通過結合深度特征,對度量語義網格層的三維重建進行改進,提升在室外視覺情況下重建的魯棒性.三維重建的效果在ETH3D數據集中以及實際場景中都取得了一定的進步,但是重建的完整性仍然有提升的空間.在后續工作中,將結合基于學習的方法,利用其強大的數據先驗能力進一步改進三維重建效果,提高重建的完整率.

參考文獻

[1] Armeni I,He Z Y,Gwak J Y,et al.3d scene graph:A structure for un-ified semantics,3d space,and camera[C]//Proceedings of the IEEE/C IEEE/CVF International Conference on Computer Vision.Seoul:IEEE,2019:5 664-5 673.

[2] Johnson J,Krishna R,Stark M,et al.Image retrieval using scene graphs[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Boston:IEEE,2015:3 668-3 678.

[3] Rosinol A,Gupta A,Abate M,et al.3D dynamic scene graphs:Actionable spatial perception with places,objects,and humans[DB/OL].https://arxiv.org/abs/2002.06289,2020-06-16.

[4] Rosinol A,Abate M,Chang Y,et al.Kimera:An open-source library for real-time metric-semantic localization and mapping[C]//2020 IEEE International Conference on Robotics and Automation (ICRA).Paris:IEEE,2020:1 689-1 696.

[5] Kim U H,Park J M,Song T J,et al.3d scene graph:A sparse and semantic representation of physical environments for intelligent agents[J].IEEE Transactions on cybernetics,2019,50(12):4 921-4 933.

[6] 顏深,張茂軍,樊亞春,等.大規模室外圖像3維重建技術研究進展[J].中國圖象圖形學報,2021,26(6):1 429-1 449.

[7] Eigen D,Puhrsch C,Fergus R.Depth map prediction from a single image using a multi-scale deep network[J].Advances in Neural Information Processing Systems,2014,27(2):2 366-2 374.

[8] Mayer N,Ilg E,Hausser P,et al.A large dataset to train convolutional networks for disparity,optical flow,and scene flow estimation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas:IEEE,2016:4 040-4 048.

[9] Chen W,Fu Z,Yang D,et al.Single-image depth perception in the wild[J].Advances in Neural Information Processing Systems,2016,29:730-738.

[10] Godard C,Mac Aodha O,Brostow G J.Unsupervised monocular depth estimation with left-right consistency[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Honolulu:IEEE,2017:270-279.

[11] Zhou H,Ummenhofer B,Brox T.Deeptam:Deep tracking and mapping[C]//Proceedings of the European Conference on Computer Vision (ECCV).Munich:Springer,2018:822-838.

[12] Loper M,Mahmood N,Romero J,et al.SMPL:A skinned multi-person linear model[J].ACM Transactions on Graphics (TOG),2015,34(6):1-16.

[13] Schonberger J L,Frahm J M.Structure-from-motion revisited[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Lasvegas:IEEE,2016:4 104-4 113.

[14] Germain H,Bourmaud G,Lepetit V.S2dnet:Learning accurate correspondences for sparse-to-dense feature matching[DB/OL].https://arxiv.org/abs/2004.01673,2020-04-03.

[15] Lindenberger P,Sarlin P E,Larsson V,et al.Pixel-perfect structure-from-motion with featuremetric refinement[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision.Montreal:IEEE,2021:5 987-5 997.

[16] Dusmanu M,Schnberger J L,Pollefeys M.Multi-view optimization of local feature geometry[C]//European Conference on Computer Vision.Glasgow:Springer,2020:670-686.

[17] Hampel F R,Ronchetti E M,Rousseeuw P J,et al.Robust statistics:The approach based on influence functions[M].New York:John Wiley & Sons,2011.

[18] Schops T,Schonberger J L,Galliani S,et al.A multi-view stereo benchmark with high-resolution images and multi-camera videos[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Honolulu:IEEE,2017:3 260-3 269.

[19] Galliani S,Lasinger K,Schindler K.Massively parallel multiview stereopsis by surface normal diffusion [C]//Proceedings of the IEEE International Conference on Computer Vision (ICCV).Santiago:IEEE,2015:873-881.

【責任編輯:蔣亞儒】