基于改進Swin-Unet腹部多器官圖像分割方法研究

王雅麗

(西南民族大學電子信息學院,成都 610225)

0 引言

對現今的醫學工作者來說,腹部器官分割在研究腹部器官病變時具有不可或缺的輔助作用[1],是利用計算機進行輔助診斷、手術導航、三維重建以及后期治療的重要步驟[2]。

腹部CT 的精確測量,包括器官體積、形狀和位置,能夠幫助醫生快速做出精確的診療。由于視野(FOV)很小,而且沒有方向,特別是對于資歷尚淺的醫生來說,器官的定位十分困難[3]。針對上述問題,用于腹部多器官的圖像引導技術可以幫助提供方向和跟蹤線索,甚至在FOV 之外。為了幫助器官導航和跟蹤,我們需要對多個器官進行分割,如胃腸器官、胰腺和相鄰器官。然而,對腹部CT 圖像進行多器官自動分割依然具有挑戰性。首先,腹部器官周圍的軟組織、大的變化和變形使患者的器官大小和形狀明顯不同[4]。其次,每個相鄰器官之間的低強度對比[5],為手動描繪相鄰器官之間模糊的邊界增加了難度。腹部CT 圖像中的器官通常與周圍器官具有相似的強度,尤其是在非對比增強數據中。現如今隨著計算機性能的提升,深度學習已被證實在醫學圖像分割中非常有效,即使在低強度對比圖像中也是如此[6]。深度學習能夠實現更好的圖像分割、目標檢測及三維重建。但是,目前大都是對腹部單一器官進行分割,對于腹部多器官自動化分割的研究還尚淺,值得深入研究。

在本文中,為了更好地獲得腹部器官的細節信息,提出了一種基于改進Swin-Unet[7]的腹部多器官自動化分割方法SF-Unet,該方法的網絡架構利用Focal Transformer[8]來搭建UNet[9]提出的U 形架構,并使用FFM 模塊作為下采樣層來提高體積較小組織的分割精度。

1 網絡架構設計

1.1 整體網絡架構

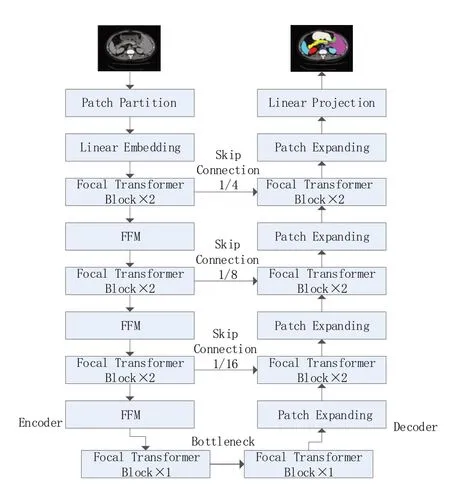

本文提出的SF-Unet 算法實現腹部多器官分割,網絡架構如圖1 所示。Focal Transformer 作為骨干網絡,提出一個新的下采樣層FFM 模塊,使得網絡獲取更多有效的細節信息,實現更加精確的多器官分割。

圖1 SF-Unet網絡架構

1.2 主干網絡Focal Transformer

在Focal Transformer 中,提出一種新的焦點注意力機制,該機制能夠在視覺變換器中實現有效的遠程交互。與以往的方法不同,它在精細的圖像上運用局部關注,在粗糙的圖像上運用全局關注,提供一種以可管理的計算成本捕獲短距離和長距離上下文的有效方法,將焦點注意力機制應用到多尺度Transformer架構中。

通過全面實證研究,結果表明在各種設置(即模型大小和復雜性方面)下,Focal Transformer的焦點注意力機制在視覺Transformer方面可有效獲取有利的圖像特征。

1.3 下采樣層FFM模塊

一直以來Transformer 通過扁平化投影圖像塊或者合并2 × 2 相鄰塊的特征,再進行線性化的處理,來形成一個多層次網絡。但是,該方法很容易導致大量細節特征信息的丟失,不利于對腹部圖像密集且體積較小的組織器官進行語義分割。因此,本文設計了FFM 作為主干網絡的下采樣層,能夠最大程度地緩解上述問題帶來的影響,因而可以提升體積較小組織的分割效果。

FFM具有兩個分支,如圖2所示。其中一個分支具有空洞卷積,它通過擴張感受野來廣泛地獲取體積較小組織器官的特征信息。其先是利用1 × 1 卷積增加維數,之后經過3 × 3 擴張卷積層獲得廣泛的結構信息,然后采用全局平均池化操作來獲得特征圖在空間方向(垂直和水平)上的統計數據。具體來說,各方向元素的計算公示如下:

圖2 下采樣FFM模塊

其中:i,j和k表示垂直方向、水平方向和通道的 索 引。特 征z?=f(z),f(·) 是 帶 有 歸 一 化 和GELU 激活函數的擴張卷積層。Vh和Vw為在空間上特征圖的收斂權重,因此將兩者相乘以獲得與位置相關的特征圖。最后加入1 × 1 卷積層減少了特征尺度。

另一個分支則引入軟池化操作來獲得更加精細的降采樣。軟池化可以用指數加權的方式激活池內核中的像素,以保存更詳細的信息。然后,將軟池化后的特征輸入到一個卷積層(增加的維數),以獲得目標輸出結果。

簡而言之,一個分支的功能是獲得體積較小組織器官的特征,而另一個分支的功能是保留更多細節,這兩個分支都是同樣重要的。因此,它們以相同的比例合并為下采樣層的輸出。

2 實驗

2.1 數據集

使用Synapse 數據集用于腹部多器官分割。該數據集包括30 例患者,共計3779 張腹部臨床CT 圖像。提取其中18 個案例來構建訓練集,而剩余12 個案例用于測試。實驗用95%Hausdorff距離(HD95)和Dice 評分(DSC)評估了8 個腹部器官(主動脈、膽囊、脾臟、左腎、右腎、肝臟、胰腺和胃),進而展示模型性能。

2.2 實驗訓練

SF-Unet 是 基 于Python 3.6 和Pytorch 1.7.0 實現的。對于所有訓練案例,使用翻轉和旋轉等數據增強來增加數據多樣性。輸入圖像大小和補丁大小分別設置為224 × 224 和4。我們在具有32 GB 內存的Nvidia V100 GPU 上訓練模型,在ImageNet 上預先訓練的權重用于初始化模型參數。訓練期間,批量大小為24,并且使用動量為0.9、權重衰減為1e-4的流行SGD優化器來優化模型以進行反向傳播。

損失函數方面,由于數據集中的類別比例不平衡,這導致模型訓練側重于數據集中占比較大的類別,而“忽略”占比較小的類別。為了解決這一問題,我們采用聯合損失[10]LDice和交叉熵損失LCE進行監督。聯合損失L表示如下:

2.3 實驗對比

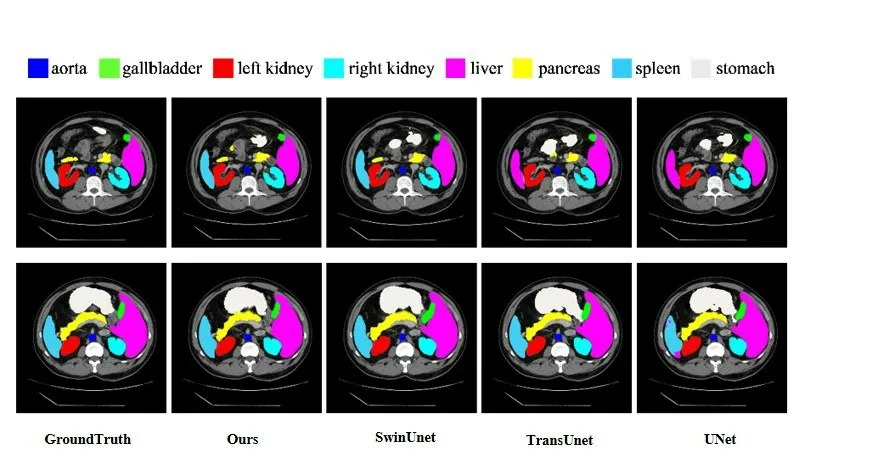

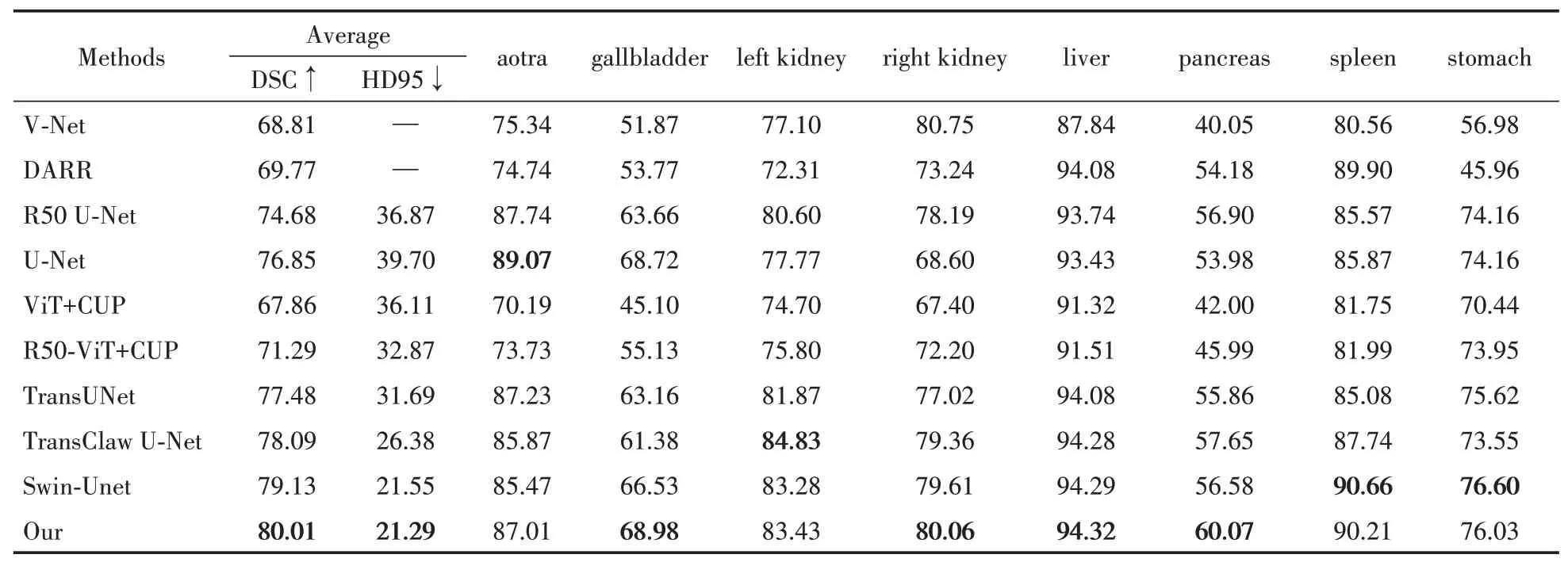

在Synapse 多器官CT 數據集上,所提出的SF-Unet 與現有方法比較結果如表1 所示。實驗結果表明,本文方法實現了最佳性能,分割精度為80.01%(DSC↑)和21.29%(HD↓),并且在膽囊(Gallbladder)、右腎(Left Kidney)、肝臟(liver)、胰腺(pancreas)這四個器官的分割中表現優秀。分割可視化結果如圖3所示。

圖3 不同方法可視化比較

表1 不同方法在Synapse多器官CT數據集上的分割精度

3 結語

本文提出了一種基于改進Swin-Unet 的腹部多器官分割方法SF-Unet,設計了新的下采樣層FFM 以保留更多的圖像詳細特征,以提高方法的全局建模能力。所提方法對比當前主流醫學語義分割方法,分割精度有一定提高,器官分割位置清晰,器官邊緣信息保留程度高。我們將在接下來的研究中繼續探討SF-Unet 在三維醫學圖像分割中的應用。