基于雙重判別解碼器的三維點(diǎn)云形狀補(bǔ)全網(wǎng)絡(luò)

孫進(jìn) 馬昊天 雷震霆 梁立

摘? 要:針對(duì)碗狀文物模型由于碎片缺失導(dǎo)致的逆向幾何重建保真度不高的問(wèn)題,為此提出了一種基于雙重判別解碼器的三維點(diǎn)云形狀補(bǔ)全網(wǎng)絡(luò)。首先基于編碼解碼器構(gòu)建基本點(diǎn)云生成網(wǎng)絡(luò),然后根據(jù)生成對(duì)抗網(wǎng)絡(luò)框架優(yōu)化解碼器結(jié)構(gòu),通過(guò)將全局特征進(jìn)行解碼獲取目標(biāo)骨架點(diǎn)云,保證點(diǎn)云的全局特征,進(jìn)而在對(duì)骨架點(diǎn)云的基礎(chǔ)上進(jìn)一步進(jìn)行局部點(diǎn)云細(xì)化生成判別,保證目標(biāo)點(diǎn)云的局部特征。最后面向特征缺失拼接模型搭建雙分支形狀補(bǔ)全網(wǎng)絡(luò)。實(shí)驗(yàn)結(jié)果表明在公開(kāi)數(shù)據(jù)集ShapeNet的點(diǎn)云補(bǔ)全實(shí)驗(yàn)中,本文方法的平均誤差更小,相較對(duì)比網(wǎng)絡(luò),本文方法在碗狀文物模型的三維形狀補(bǔ)全任務(wù)更好,平均倒角距離提高了20.2%,為后續(xù)的模型逼真化提供了一個(gè)基礎(chǔ),具有更強(qiáng)的性能和良好的應(yīng)用價(jià)值。

關(guān)鍵詞:幾何重建;深度學(xué)習(xí);生成對(duì)抗網(wǎng)絡(luò);雙重判別解碼器;雙分支形狀補(bǔ)全;倒角距離

DOI:10.15938/j.jhust.2023.05.009

中圖分類號(hào): TP301.6

文獻(xiàn)標(biāo)志碼: A

文章編號(hào): 1007-2683(2023)05-0068-07

Two-branch Shape Complement Network for Feature Missing Splicing Mode

SUN Jin,? MA Haotian,? LEI Zhenting,? LIANG Li

(1.School of Mechanical Engineering, Yangzhou University, Yangzhou 225263, China;

2.Jiangdu High-end Equipment Engineering Technology Institute, Yangzhou University, Yangzhou 225263, China)

Abstract:Aiming at the problem of low fidelity of reverse geometric reconstruction of bowl-shaped cultural relics model due to the missing fragments, a 3D point cloud shape completion network based on double discrimination decoder is proposed. Firstly, a basic point cloud generation network is built based on the codec, and then the decoder structure is optimized according to the framework of generation confrontation network. By decoding the global features, the target skeleton point cloud is obtained, and the global features of the point cloud are guaranteed. Then, on the basis of the skeleton point cloud, the local point cloud generation is further refined to ensure the local features of the target point cloud. Finally, a two-branch shape completion network is built for the feature missing splicing model. The experimental results show that the average error of this method is smaller in the point cloud completion experiment of ShapeNet, an open data set. Compared with the comparison network, this method is better in completing the three-dimensional shape of the bowl-shaped cultural relics model, and the average chamfer distance is increased by 20.2%, which provides a foundation for the subsequent model fidelity, and has stronger performance and good application value.

Keywords:geometric reconstruction; deep learning; generative adversarial network; double discrimination decode; two-branch shape completion; chamfer distance

收稿日期: 2022-05-17

基金項(xiàng)目:

國(guó)家自然科學(xué)基金(51775484,51475409);2020年江蘇省產(chǎn)學(xué)研合作項(xiàng)目(BY2020663);2021年揚(yáng)州市產(chǎn)業(yè)前瞻與共性關(guān)鍵技術(shù)項(xiàng)目(YZ2021020);2020年揚(yáng)州大學(xué)市校合作專項(xiàng)(YZ2020166).

作者簡(jiǎn)介:

馬昊天(1998—),男,碩士研究生;

雷震霆(1995—),男,博士研究生.

通信作者:

孫? 進(jìn)(1973—),男,博士,碩士研究生導(dǎo)師,E-mail:sunjin1001_bzr@126.com.

0? 引? 言

我國(guó)悠久的歷史使得周圍的海域下埋藏著眾多的文化遺跡,隨著航海技術(shù)的不斷發(fā)展,打撈出大量的海底沉船,其中發(fā)掘出了許多破碎的文物碎片[1],其中大多數(shù)為碗狀的陶瓷碎片。由于破損的文物數(shù)量眾多,利用計(jì)算機(jī)視覺(jué)技術(shù)將其數(shù)字化之后進(jìn)行輔助生成,對(duì)文物保護(hù)有著十分重要的意義。目前的考古學(xué)家利用計(jì)算機(jī)輔助技術(shù)對(duì)這些文物進(jìn)行數(shù)字化,進(jìn)行虛擬重組與匹配實(shí)現(xiàn)文物模型的復(fù)現(xiàn)。

在歷史文物重建過(guò)程中,通常使用三維掃描儀獲取目標(biāo)的數(shù)字化模型,但是當(dāng)目標(biāo)存在缺失或缺損的情況下,這樣通過(guò)三維掃描儀獲取的數(shù)字化模型會(huì)不完整,對(duì)文物逆向工程的效果會(huì)產(chǎn)生較大的影響。人們可以通過(guò)雙眼觀察文物的現(xiàn)有特征,并根據(jù)經(jīng)驗(yàn)推斷出缺失部位的信息,計(jì)算機(jī)卻很難推測(cè)缺失的部位的原始形狀信息。

現(xiàn)有的殘缺點(diǎn)云數(shù)據(jù)的補(bǔ)全的方法一般分為三類,第一類是基于幾何方法,這類方法是在不需要任何外部輔助數(shù)據(jù)的情況下,利用已有輸入點(diǎn)云的幾何信息來(lái)完成對(duì)整體形狀的補(bǔ)全。此類方法的優(yōu)點(diǎn)是簡(jiǎn)單,容易通過(guò)簡(jiǎn)單的算法實(shí)現(xiàn)。但是該種方法存在對(duì)輸入點(diǎn)云數(shù)據(jù)要求高,泛化性較差的問(wèn)題。第二類是基于對(duì)齊方法,這類方法的基本思想是通過(guò)將殘缺的輸入點(diǎn)云與點(diǎn)云形狀數(shù)據(jù)庫(kù)中的模型匹配來(lái)完成補(bǔ)全。雖然數(shù)據(jù)庫(kù)先驗(yàn)知識(shí)的方法能夠完成較大面積的模型補(bǔ)全,但其主要限制仍是全局結(jié)構(gòu)不容易被概括,不能推廣到任意的三維模型,需要昂貴的優(yōu)化成本,并且對(duì)噪聲不魯棒。

第三類方法是基于學(xué)習(xí)的方法,從前基于學(xué)習(xí)的點(diǎn)云補(bǔ)全方法通常將點(diǎn)云數(shù)據(jù)轉(zhuǎn)換為體素網(wǎng)格或其他形式再使用卷積,但是,該種方法[2]對(duì)內(nèi)存的需求特別大,并且不適合形狀不規(guī)則的物體。Pointnet[3]提出后,可以直接處理無(wú)序點(diǎn)云,節(jié)省了點(diǎn)云數(shù)據(jù)的處理時(shí)間。L-GAN[4]提出了第一個(gè)點(diǎn)云的深度生成模型,可以通過(guò)簡(jiǎn)單的代數(shù)運(yùn)算對(duì)點(diǎn)云進(jìn)行形狀補(bǔ)全,但是其網(wǎng)絡(luò)架構(gòu)不是專門用于點(diǎn)云補(bǔ)全的,在點(diǎn)云補(bǔ)全任務(wù)中效果不是很好。Foldingnet[5]提出了一種端到端的自動(dòng)編碼器,它可以將2D網(wǎng)格變形到三維點(diǎn)云中的物體表面上,并且與直接使用完全連接的層相比,所提出的解碼器可以保持準(zhǔn)確性。PCN[6]提出了基于深度學(xué)習(xí)的形狀補(bǔ)全網(wǎng)絡(luò),應(yīng)用Foldingnet對(duì)生成的點(diǎn)云進(jìn)行形狀完善,通過(guò)編碼器解碼器產(chǎn)生粗輸出,然后使用并行多層感知器進(jìn)行細(xì)輸出,這種方法能夠通過(guò)點(diǎn)云作為輸入生成密集和完整的結(jié)果,但是PCN不能產(chǎn)生高保真度的結(jié)果。

在現(xiàn)階段,點(diǎn)云生成任務(wù)中經(jīng)常使用到生成對(duì)抗網(wǎng)絡(luò)[7]的框架,例如,3D-GAN[11]第一個(gè)將體卷積網(wǎng)絡(luò)與生成對(duì)抗網(wǎng)絡(luò)結(jié)合從概率空間生成三維對(duì)象,能夠較好的完成點(diǎn)云補(bǔ)全任務(wù),但是,體素網(wǎng)格降低了精細(xì)形狀的分辨率,并且需要巨大的計(jì)算量。2018年,Li等提出了point cloud GAN[8]適用于點(diǎn)的完成,然而結(jié)果卻嚴(yán)重失真。為了減少細(xì)節(jié)的丟失,后續(xù)的研究[9-11]通過(guò)添加約束條件以最小化輸入形狀與其對(duì)應(yīng)的輸出區(qū)域之間的距離,上述方法都不重視局部結(jié)構(gòu)信息。L-GAN介紹了第一個(gè)深度生成的點(diǎn)云模型,雖然L-GAN能夠在一定程度上執(zhí)行形狀完成任務(wù),但其架構(gòu)主要不是為完成形狀完成任務(wù)而構(gòu)建的,因此其性能并不理想。PF-Net[12]提出將最終產(chǎn)生的預(yù)測(cè)點(diǎn)云與真實(shí)點(diǎn)云共同輸入判別器,以達(dá)到提高生成點(diǎn)云的逼真度,但是,其判別器用在最終生成的點(diǎn)云上,產(chǎn)生的作用較小。為了提高點(diǎn)云補(bǔ)全的準(zhǔn)確率,MGA-PT[13-15]等提出通過(guò)嵌入Transformer、ALL-MLP的方法提高編碼器的特征提取能力,提高了點(diǎn)云補(bǔ)全的保真度。上述方法都使用生成器和鑒別器,這種結(jié)構(gòu)的網(wǎng)絡(luò)將把生成器中產(chǎn)生的點(diǎn)云傳送給判別器,通過(guò)鑒別器確定生成點(diǎn)云的真假。總體上,基于生成對(duì)抗網(wǎng)絡(luò)結(jié)構(gòu)的點(diǎn)云生成模型的保真度較高。

針對(duì)上述對(duì)點(diǎn)云補(bǔ)全網(wǎng)絡(luò)中,生成點(diǎn)云保真度不高,重建方式復(fù)雜的缺點(diǎn),本文提出了一種針對(duì)編碼解碼點(diǎn)云生成網(wǎng)絡(luò)的雙重判別解碼器,其具體貢獻(xiàn)為:

1)提出一種雙重判別的解碼器結(jié)構(gòu),通過(guò)將全局特征進(jìn)行解碼獲取目標(biāo)骨架點(diǎn)云,進(jìn)而在對(duì)骨架點(diǎn)云判別生成的基礎(chǔ)上進(jìn)一步進(jìn)行局部點(diǎn)云細(xì)化生成判別,實(shí)現(xiàn)對(duì)存在特征缺失模型的形狀重建,有效的保證了目標(biāo)點(diǎn)云的全局特征。

2)提出了一種針對(duì)碗狀文物特征缺失模型的點(diǎn)云補(bǔ)全方法,優(yōu)化了編碼解碼判別點(diǎn)云生成網(wǎng)絡(luò)中的解碼器結(jié)構(gòu),在三維物體數(shù)據(jù)集Shape Net及碗狀文物數(shù)據(jù)集中取得了更優(yōu)的補(bǔ)全效果。

1? 點(diǎn)云生成網(wǎng)絡(luò)

由于碗狀文物碎片的丟失,重建碗狀文物三維模型所需的點(diǎn)云數(shù)據(jù)會(huì)不完整,將通過(guò)多次三維掃描儀獲取破損碎片的三維點(diǎn)云數(shù)據(jù)設(shè)為V,其中,V是各碎片點(diǎn)的信息的集合{v1,v2,v3,…},通過(guò)點(diǎn)云的拼接算法將各碎片點(diǎn)云集V拼接成U,通過(guò)三維建模軟件或?qū)ν暾霠钗奈镞M(jìn)行三維掃描獲取完整模型所對(duì)應(yīng)的點(diǎn)Y。

如圖1所示,本文將破碎碗狀文物三維模型重建的任務(wù)定義為:已知點(diǎn)云U求解相對(duì)于Y的缺失部分,通過(guò)對(duì)碗狀文物完整模型的點(diǎn)云Y進(jìn)行隨機(jī)塊的刪除,獲取所對(duì)應(yīng)的訓(xùn)練數(shù)據(jù)X,本文采用基于學(xué)習(xí)的方法訓(xùn)練本文的模型N,求解X相對(duì)于Y的缺失部分。

1.1? 編碼器

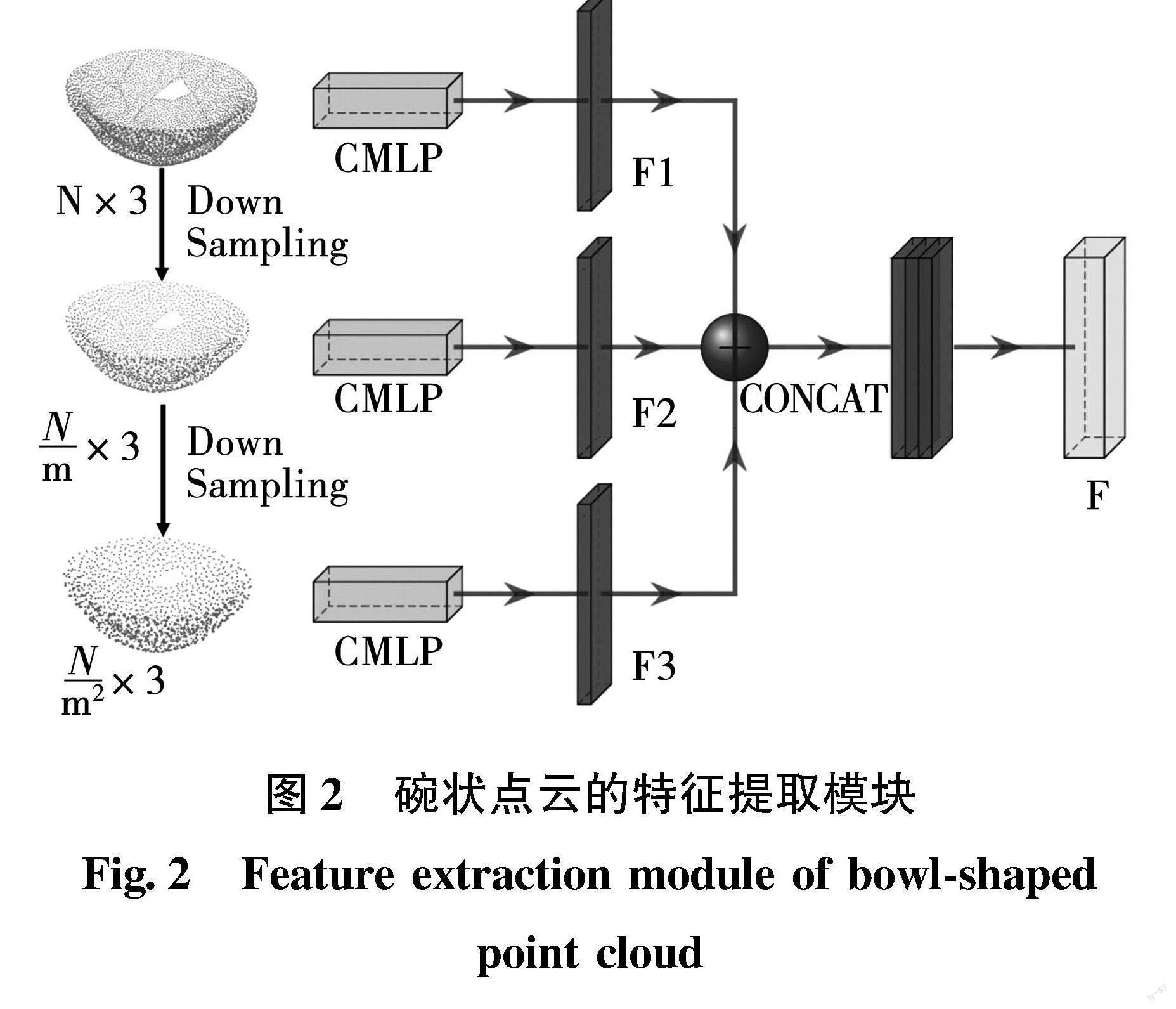

在編碼器網(wǎng)絡(luò)中,本文的輸入數(shù)據(jù)為缺失點(diǎn)云的三維坐標(biāo)。首先,通過(guò)最遠(yuǎn)點(diǎn)抽樣[16]分別在256、512和1024的標(biāo)度上采樣,比例是指用于表示對(duì)象點(diǎn)云的點(diǎn)數(shù)。然后,對(duì)采樣后獲得的三個(gè)不同輸入執(zhí)行特征提取。在特征提取階段,本文使用了PF-Net中的組合多層感知的方法,通過(guò)將使用三個(gè)獨(dú)立的組合多層感知將尺度為256、512和1024的點(diǎn)云映射為三個(gè)單獨(dú)的組合潛在向量F1、F2、F3。每個(gè)向量代表從不同分辨率點(diǎn)云中提取的特征。最后,將所有向量連接起來(lái),形成1920×3大小的潛在特征映射F。

本文使用的特征提取模塊如圖2所示,左側(cè)輸入的點(diǎn)云是通過(guò)最遠(yuǎn)點(diǎn)采樣獲取的256、512、1024維度的點(diǎn)云,組合多層感知代表了PFNet提出的組合多層感知,三個(gè)維度的點(diǎn)云通過(guò)組合多層感知分別獲取特征F1、F2、F3,對(duì)三個(gè)特征進(jìn)行組合,通過(guò)全連接及支持向量機(jī)獲取最終提取的特征F。

1.2? 判別器

判別器是生成對(duì)抗網(wǎng)絡(luò)中常用的網(wǎng)絡(luò)結(jié)構(gòu),在點(diǎn)云生成任務(wù)中,將解碼器生成的點(diǎn)云輸入到判別器中,通過(guò)判別器判斷生成點(diǎn)云的真假,進(jìn)行識(shí)別和不斷生成訓(xùn)練網(wǎng)絡(luò),實(shí)現(xiàn)生成準(zhǔn)確的點(diǎn)云模型。因?yàn)榻獯a器的輸出是點(diǎn)云數(shù)據(jù),通過(guò)線性層對(duì)鑒別器的輸入進(jìn)行預(yù)處理。處理后的結(jié)果依次通過(guò)三個(gè)卷積層,這些卷積層的輸出維數(shù)分別為64、128和256,本文將每個(gè)卷積的輸出分別Y存儲(chǔ)在變量Ypre_64、Ypre_128、Ypre_256中。這些變量分別通過(guò)最大池化并轉(zhuǎn)換維度進(jìn)行連接,最終的特征向量依次通過(guò)四個(gè)輸出維度為256、128、16和1的全連接層,結(jié)果通過(guò)最后一個(gè)全連接的層輸出。

如圖3所示,輸入為生成器生成的點(diǎn)云,Linear為全連接層,輸出數(shù)據(jù)分別為256×1,128×1,16×1和1×1,最后輸出0或1判斷生成點(diǎn)云是否符合真實(shí)點(diǎn)云幾何形狀特征。

2? 改進(jìn)的雙分支形狀補(bǔ)全網(wǎng)絡(luò)

通過(guò)使用兩個(gè)判別器分別對(duì)生成的全局點(diǎn)云和細(xì)節(jié)點(diǎn)云進(jìn)行判別,首先將第一分支生成的全局點(diǎn)云作為輸入數(shù)據(jù)輸入判別器,通過(guò)判別器判斷的點(diǎn)云作為進(jìn)一步生成細(xì)化點(diǎn)云的骨架點(diǎn)云,將生成的細(xì)化點(diǎn)云通過(guò)判別器的二次判別,將獲取的結(jié)果與骨架點(diǎn)云進(jìn)行整合,獲取最終的生成模型。

2.1? 雙重判別解碼器

解碼器的輸入為編碼器網(wǎng)絡(luò)的輸出,解碼器的輸出是輸入點(diǎn)云的缺失部分。以前的研究[5-7]表明使用全連接層的解碼器能夠較好的預(yù)測(cè)稀疏點(diǎn)集,這些生成的稀疏點(diǎn)集可以粗略地表示物體的三維形狀。本文的網(wǎng)絡(luò)解碼器的思路是先生成稀疏的骨架點(diǎn)云集合后進(jìn)行判別,獲取缺失點(diǎn)云的骨架點(diǎn)云,在骨架點(diǎn)云的基礎(chǔ)上進(jìn)行細(xì)化點(diǎn)云的二次生成,并對(duì)二次生成的細(xì)化點(diǎn)云進(jìn)一步進(jìn)行判別,提高生成點(diǎn)云的形狀信息的準(zhǔn)確率。

解碼器的結(jié)構(gòu)框圖如圖4所示。在解碼器生成點(diǎn)云的過(guò)程中,本文采用了由全局到局部的思想進(jìn)行生成,定義兩個(gè)不同的全連接層Fc1、Fc2分別生成對(duì)應(yīng)的全局特征及細(xì)節(jié)特征,輸出大小分別為1024、256。以編碼器獲取的特征F作為輸入,依次通過(guò)Fc1、Fc2。本文將每個(gè)完全連接的層的結(jié)果存儲(chǔ)在不同的變量中,通過(guò)這個(gè)過(guò)程,特征向量的維數(shù)降低到256,為之后的全局點(diǎn)云的生成做準(zhǔn)備。

圖中的輸入是編碼器提取的特征F,Y_1代表的是生成的包含缺失部位全局形狀信息的點(diǎn)云,Y_2代表的是生成的細(xì)節(jié)點(diǎn)云,判別器判別為真的Y_1作為骨架點(diǎn)云,在骨架點(diǎn)云的基礎(chǔ)上進(jìn)一步細(xì)化獲取Y_2,通過(guò)判別器的二次判別獲取最終包含全局特征及細(xì)節(jié)點(diǎn)云的缺失點(diǎn)云。解碼器將編碼器中提取到的全局特征和局部特征結(jié)合起來(lái),生成一組完整的點(diǎn)云。

本文通過(guò)先生成少量能描述目標(biāo)模型形狀特征的關(guān)鍵點(diǎn)作為描述物體的形狀特征的骨架點(diǎn)云,其次,在此基礎(chǔ)上進(jìn)一步生成細(xì)節(jié)點(diǎn)云,直到最后生成密集點(diǎn)云數(shù)據(jù)的缺失部分。本文定義了兩個(gè)不同的全連接層,使用FC_2的輸出作為FC_1的輸入,通過(guò)對(duì)兩個(gè)輸出的整形疊加,獲取目標(biāo)三維模型的生成模型。

2.2? 損失函數(shù)

雙分支缺失點(diǎn)云生成網(wǎng)絡(luò)的損失函數(shù)由雙分支補(bǔ)全損失和對(duì)抗網(wǎng)絡(luò)損失兩部分組成。補(bǔ)全損失是指缺失部位點(diǎn)云的真實(shí)值與預(yù)測(cè)點(diǎn)云之間的差值,用來(lái)減少真實(shí)值與生成點(diǎn)云之間的差異,對(duì)抗性損失通過(guò)優(yōu)化生成器使預(yù)測(cè)點(diǎn)云數(shù)據(jù)更接近真實(shí)點(diǎn)云數(shù)據(jù)。CD損失衡量的是點(diǎn)云缺失部分的真實(shí)值與預(yù)測(cè)值之間的差異。對(duì)抗性損失試圖通過(guò)優(yōu)化最大似然估計(jì)來(lái)使預(yù)測(cè)更真實(shí)。

在本網(wǎng)絡(luò)中,選擇CD損失作為衡量指標(biāo)。CD損失計(jì)算預(yù)測(cè)點(diǎn)云S2和真實(shí)點(diǎn)云S1之間的平均最近點(diǎn)距離:

dCD(S1,S2)=1|S1|∑x∈S1miny∈S2‖x-y‖22+

1S2∑x∈S2miny∈S1‖y-x‖22(1)

雙分支缺失點(diǎn)云生成網(wǎng)絡(luò)的損失函數(shù)由雙分支的補(bǔ)全損失L1和對(duì)抗損失L2兩部分組成。通過(guò)最小化L2使得生成器產(chǎn)生“真實(shí)”樣本U來(lái)通過(guò)判別器的判別,而D旨在最小化L2,并對(duì)真實(shí)樣本P和生成樣本P進(jìn)行區(qū)分。雙分支點(diǎn)云生成網(wǎng)絡(luò)的損失由dCD1和dCD2,并使用超參數(shù)β加權(quán):

L1=dCD1(U1,U′1)+βdCD2(U2,U′2)(2)

其中:U1為精密點(diǎn)云;U2為骨架點(diǎn)云;U′1和U′2分別為對(duì)應(yīng)的真實(shí)點(diǎn)云。

對(duì)抗網(wǎng)絡(luò)的損失函數(shù)L2通過(guò)最小平方損失表示:

L2=12[D(U)2+(D(U′)-1)2](3)

其中:U為生成點(diǎn)云,U′為對(duì)應(yīng)真實(shí)值。

雙分支缺失點(diǎn)云生成網(wǎng)絡(luò)的損失函數(shù)定義為:

L=θ1L1+θ2L2(4)

其中:θ1和θ2分別為補(bǔ)全損失與對(duì)抗損失,并且θ1+θ2=1,在訓(xùn)練過(guò)程中,通過(guò)Adam優(yōu)化器對(duì)G和D交替優(yōu)化。

3? 實(shí)? 驗(yàn)

3.1? 實(shí)驗(yàn)環(huán)境

本文的網(wǎng)絡(luò)使用python語(yǔ)言,在Windows 11系統(tǒng)上訓(xùn)練,實(shí)驗(yàn)的硬件環(huán)境:掃描儀為SHINING SE,CPU AMD Ryzen 5 4600H with Radeon Graphics,主頻3.0Hz;GPU NVIDIA GeForce GTX 1650;操作系統(tǒng)Win10;深度學(xué)習(xí)環(huán)境為Pyorch 1.10.2,Python3.7.11,初始學(xué)習(xí)率0.0001,批量4,通過(guò)Adam優(yōu)化器優(yōu)化網(wǎng)絡(luò)。

3.2? 實(shí)驗(yàn)數(shù)據(jù)

本文所構(gòu)建的數(shù)據(jù)集包含兩個(gè)部分,第1個(gè)部分是通過(guò)三維掃描儀獲取碗狀文物碎片的數(shù)字化模型,通過(guò)文[17]的拼接方法獲取待補(bǔ)全模型。第2個(gè)部分是通過(guò)三維建模軟件繪制的三維模型,經(jīng)過(guò)處理獲取碗狀文物的點(diǎn)云模型。

如圖5所示,本文主要通過(guò)三維建模軟件繪制的三維模型作為網(wǎng)絡(luò)的訓(xùn)練數(shù)據(jù),三維掃描儀獲取的碗狀文物碎片的數(shù)字化模型作為實(shí)際驗(yàn)證數(shù)據(jù)。

其中,圖5(a)為通過(guò)三維掃描儀獲取碗狀文物碎片的網(wǎng)格模型,圖5(b)為采集的點(diǎn)云模型;圖5(c)為通過(guò)三維建模軟件繪制的三維模型,圖5(d)為采集的點(diǎn)云模型,作為網(wǎng)絡(luò)的訓(xùn)練數(shù)據(jù),圖5(a)(b)作為網(wǎng)絡(luò)驗(yàn)證的數(shù)據(jù)。

3.3? 驗(yàn)證集點(diǎn)云補(bǔ)全實(shí)驗(yàn)

本文在驗(yàn)證集上進(jìn)行驗(yàn)證,通過(guò)將缺失點(diǎn)云輸入基于雙重判別解碼器的點(diǎn)云補(bǔ)全網(wǎng)絡(luò),對(duì)碗狀點(diǎn)云缺失部分形狀進(jìn)行補(bǔ)全,補(bǔ)全效果如圖6所示。

本文的網(wǎng)絡(luò)輸入的數(shù)據(jù)為存在缺失的點(diǎn)云數(shù)據(jù),為了滿足網(wǎng)絡(luò)輸入的要求,本文從不同的視點(diǎn)觀察構(gòu)建的碗狀文物的三維點(diǎn)云模型,如圖6左側(cè)所示,隨機(jī)選取一個(gè)視點(diǎn)作為為球心,刪除球面上以R為半徑的所有點(diǎn),剩下的點(diǎn)視為缺失點(diǎn)云作為網(wǎng)絡(luò)輸入,以刪除的點(diǎn)云作為真實(shí)點(diǎn)云。

3.4? 待補(bǔ)全模型缺失生成

第1個(gè)部分是通過(guò)三維掃描儀獲取碗狀文物碎片的數(shù)字化模型,拼接后的待補(bǔ)全模型。獲取現(xiàn)有的碗狀文物碎片的數(shù)字化點(diǎn)云,對(duì)現(xiàn)有的數(shù)字化碎片模型進(jìn)行拼接,獲取待檢測(cè)模型,如表1所示。

從左到右分別是碗狀文物碎片邊緣碎片缺失、內(nèi)部碎片缺失及多塊碎片缺失的點(diǎn)云生成情況,從上到下分別為待補(bǔ)全模型、缺失部位生成的點(diǎn)云、生成點(diǎn)云與缺失點(diǎn)云組合的完整點(diǎn)云、生成點(diǎn)云的封裝模型及真實(shí)的缺失部位點(diǎn)云。相應(yīng)的本文訓(xùn)練的生成網(wǎng)絡(luò)能夠較好的對(duì)碗狀文物缺失部位的點(diǎn)云進(jìn)行較好的生成。同時(shí),對(duì)生成的點(diǎn)云數(shù)據(jù)進(jìn)行進(jìn)一步點(diǎn)云封裝能夠滿足模型形狀重建的需求。

3.5? 結(jié)果對(duì)比

本文使用的評(píng)價(jià)指標(biāo)[18]。它包含兩個(gè)指標(biāo):Pred→GT(預(yù)測(cè)點(diǎn)云與真實(shí)點(diǎn)云)誤差和GT→Pred(真實(shí)點(diǎn)云與預(yù)測(cè)點(diǎn)云)誤差。Pred→GT衡量的是預(yù)測(cè)與實(shí)際情況的差距。GT→Pred表示預(yù)測(cè)的形狀覆蓋的地面真值曲面的程度。

在表2中顯示GT→Pre和Pre→Gt誤差與經(jīng)典方法在公開(kāi)數(shù)據(jù)集的五個(gè)類別進(jìn)行對(duì)比的比較結(jié)果(顯示的數(shù)字是[Pred→GT誤差/ GT→Pred誤差],按比例乘以1000)。由于平均誤差值太小,無(wú)法顯示在表格中,本文將得到的GT→Pre與Pre→Gt值乘以1000,最后保留三位小數(shù)作為最終的測(cè)試結(jié)果。

由表2可見(jiàn),在給定的5個(gè)類別的模型點(diǎn)云補(bǔ)全測(cè)試中,本文的雙分支點(diǎn)云補(bǔ)全網(wǎng)絡(luò)在形狀特征信息簡(jiǎn)單的模型中的補(bǔ)全效果更好,如表2所示在杯子、桌子、帽子中,雙分支點(diǎn)云補(bǔ)全網(wǎng)絡(luò)生成的點(diǎn)云補(bǔ)全效果更好。

如表2所示,現(xiàn)有的經(jīng)典網(wǎng)絡(luò)中PF-Net在點(diǎn)云完成任務(wù)中效果較好,其中,本文網(wǎng)絡(luò)在幾何形狀信息簡(jiǎn)單的補(bǔ)全任務(wù)中效果更好。

將本文網(wǎng)絡(luò)在碗狀文物待補(bǔ)全模型中與PF-Net進(jìn)行實(shí)驗(yàn)對(duì)比。如表3所示,通過(guò)對(duì)PF-Net在邊沿塊、內(nèi)部塊、組合塊中的補(bǔ)全效果對(duì)比,我們可以觀察到,本文的方法比PF-Net[6]生成的點(diǎn)云更致密、更均勻,由表平面部分生成的點(diǎn)密度更大,恢復(fù)程度也更高。表4表示對(duì)應(yīng)邊沿塊、內(nèi)部塊、組合塊的CD值(倒角距離 Chamfer distance)及平均倒角距離,其中,CD值越小,最終結(jié)果越好。由表4可見(jiàn),在邊沿缺失補(bǔ)全、內(nèi)部缺失補(bǔ)全和多塊缺失補(bǔ)全中分別提高了18.1%、12.6%、29.9%,相對(duì)于PF-Net本文網(wǎng)絡(luò)在真實(shí)點(diǎn)云數(shù)據(jù)的補(bǔ)全中平均提高了20.2%。綜上,雙重判別解碼器的結(jié)構(gòu)提高了生成點(diǎn)云的精度,在形狀信息簡(jiǎn)單的模型中有著較好的效果由表1所示,并且在碗狀文物的形狀重建任務(wù)中精度更高,如表4所示。

4? 結(jié)? 論

針對(duì)碗狀文物拼接模型存在特征信息缺失的修復(fù)補(bǔ)全問(wèn)題,本文提出了一種有效的雙分支點(diǎn)云生成網(wǎng)絡(luò)。結(jié)合生成對(duì)抗網(wǎng)絡(luò)框架,在點(diǎn)云生成網(wǎng)絡(luò)框架的解碼器結(jié)構(gòu)中使用了兩次判別器,構(gòu)建了一種雙重判別解碼器結(jié)構(gòu),分別從全局特征及細(xì)節(jié)特征對(duì)缺失部位的形狀進(jìn)行生成,保證點(diǎn)云骨架特征的同時(shí)進(jìn)一步細(xì)化點(diǎn)云的細(xì)節(jié)特征,可以有效的提高生成點(diǎn)云特征的保真度。相較于傳統(tǒng)的文物修復(fù)方法,本文通過(guò)實(shí)驗(yàn)表明深度學(xué)習(xí)的方式能夠?qū)崿F(xiàn)缺失部位的自動(dòng)補(bǔ)全,本文的網(wǎng)絡(luò)相較于已有網(wǎng)絡(luò)分別提高了18.1%、12.6%、29.9%,平均提高了20.2%。同時(shí)在公開(kāi)數(shù)據(jù)集的實(shí)驗(yàn)表明本文的網(wǎng)絡(luò)在其他形狀的補(bǔ)全任務(wù)中有著較好的泛化性能。

參 考 文 獻(xiàn):

[1]? LI J, HE B, Liu S, Liu Q. Nondestructive Analysis of Jingdezhen and Longquan Celadon Wares Excavated from Nanhai No.1 Shipwreck. Spectrosc Spect Anal 36:1500.

[2]? TCHAPMI L P, KOSARAJU V, REZATOFIGHI H, et al. Topnet: Structural Point Cloud Decoder[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 383.

[3]? QI C R, SU H, MO K, Guibas L J. Pointnet: Deep Learning on Point Sets for 3D Classification and Segmentation[J]. CVPR, 2017: 77.

[4]? WU J, ZHANG C, XUE T, et al. Learning a Probabilistic Latent Space of Object Shapes Via 3D Generative-Adversarial Modeling[J]. Advances in Neural Information Processing Systems, 2016:1.

[5]? YANG Y, FENG C, SHEN Y, et al.Foldingnet: Point Cloud Auto-Encoder Via Deep Grid Deformation[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 206.

[6]? YUAN W, T KHOT, D HELD, et al. PCN: Point Completion Network[C]. 3DV, 2018: 728.

[7]? CRESWELL A, WHITE T, DUMOULIN V, et al. Generative Adversarial Networks: An Overview[J]. IEEE Signal Processing Magazine, 2018, 35(1): 53.

[8]? ACHLIOPTAS P, DIAMANTI O, MITLIAGKAS I, et al. Learning Representations and Generative Models For 3d Point Clouds[C]//International Conference on Machine Learning. PMLR, 2018: 40.

[9]? LI C L,ZAHEER M, ZHANG Y, et al. Point Cloud Gan[J]. arXiv Preprint arXiv:1810.05795, 2018: 82.

[10]SARMAD M, LEE H.J, KIM Y.M. Rl-gan-net: A Reinforcement Learning Agent Controlled Gan Network for Real-Time Point Cloud Shape Completion[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 5898.

[11]GURUMURTHY S, AGRAWAL S. High Fidelity Semantic Shape Completion for Point Clouds Using Latent Optimization[C]// Proceedings of the IEEE Winter Conference on Applications of Computer Vision (WACV), IEEE, 2019: 1099.

[12]HUANG Z, YU Y, XU J, et al. PF-Net: Point Fractal Network for 3D Point Cloud Completion[J]. (CVPR), 2020: 7659.

[13]CHEN X, LI Y. Multi-feature Fusion Point Cloud Completion Network[J]. World Wide Web 25, 2022:1551.

[14]劉心溥,馬燕新,許可,等.嵌入Transformer結(jié)構(gòu)的多尺度點(diǎn)云補(bǔ)全[J].中國(guó)圖象圖形學(xué)報(bào),2022,27(2):538.

LIU Xinpu, MA Yanxin, XU Ke, et al. Multi-scale Point Cloud Completion Embedded in Transformer Structure[J]. Journal of Image and Graphics,2022,27(2):538.

[15]張京軍,鄭燦,高瑞貞.學(xué)習(xí)點(diǎn)云鄰域信息的三維物體形狀補(bǔ)全[J].計(jì)算機(jī)應(yīng)用研究,2022,39(5):1586.

ZHANG Jingjun, ZHENG Can, GAO Ruizhen. Shape Complement of 3D Objects by Learning Neighborhood Information of Point Clouds [J]. Research on Computer Application,2022,39(5):1586.

[16]QI C R,L Yi, SU H, et al. Pointnet++: Deep Hierarchical Feature Learning on Point Sets In A Metric Space[J]. Advances in Neural Information Processing Systems, 2017, 30: 5105.

[17]孫進(jìn),丁煜,王寧, 等.結(jié)合點(diǎn)云占比和平滑度的碗狀碎塊內(nèi)表面識(shí)別算法[J].哈爾濱理工大學(xué)學(xué)報(bào),2020, 25(3):157.

SUN Jin, DING Yu, WANG Ning, et al. Identification Algorithm for Inner Surface of Bowl-shaped Broken Pieces Based on Point Cloud Proportion and Smoothness[J]. Journal of Harbin University of Science and Technology,2020,25(3):157.

[18]GADELHA M, WANG R,? MAJI S. Multiresolution Tree Networks for 3D Point Cloud Processing[C]// The 15th European Conference on Computer Vision, Munich, Germany, 2018: 105.

(編輯:溫澤宇)