自適應不規(guī)則紋理的膠囊內(nèi)鏡圖像無損壓縮

黃勝,向思皓,胡峰,馬婷,盧冰

(1.重慶郵電大學 通信與信息工程學院,重慶 400065;2.江蘇勢通生物科技有限公司,江蘇 南通 226399;3.重慶郵電大學 光通信與網(wǎng)絡重點實驗室,重慶 400065)

0 概述

無線膠囊內(nèi)鏡在體內(nèi)通過胃腸道蠕動緩慢前進,將捕獲的圖像經(jīng)無線傳輸設備傳輸至包裹在患者腰部的數(shù)據(jù)記錄器中,并把接收到的圖像存儲至計算機硬盤。醫(yī)生利用計算機對數(shù)據(jù)記錄器中接收到的圖像進行篩查[1]。膠囊內(nèi)鏡在病患體內(nèi)可連續(xù)工作約8 h,過程中以每秒2~6 張的拍攝頻率得到數(shù)萬張圖像。當大量患者就診時,膠囊內(nèi)鏡將產(chǎn)生大量的圖像數(shù)據(jù),給圖像的存儲與傳輸帶來一定挑戰(zhàn)。為避免有損壓縮算法解碼出失真的圖片給醫(yī)生診斷帶來干擾,在醫(yī)學圖像壓縮存檔過程中將無損壓縮作為硬性要求[2],目的是重建出與原始圖像完全一致的圖像數(shù)據(jù),并且沒有任何失真,其壓縮比遠低于有損壓縮。因此,高效的無損壓縮算法可以減小醫(yī)學圖像的文件尺寸,對于圖像編碼具有重要意義。

圖像壓縮算法與視頻幀內(nèi)編碼算法[3]成為研究熱點[4-6],而預測編碼是減少圖像空間冗余數(shù)據(jù)的有效方式。文獻[7]將CALIC 算法的空間預測應用到圖像的亮度分量中,并對色度分量進行分層預測,使當前像素下方的像素也作為參考像素的候選。文獻[8-9]將離散小波變換與預測編碼相結(jié)合,提升圖像壓縮質(zhì)量。文獻[10-11]針對高效視頻編碼(High Efficiency Video Coding,HEVC)幀內(nèi)預測,利用更遠處的參考像素對當前編碼像素進行預測,尋找不相鄰但存在潛在相關性的像素,在一定程度上提升預測質(zhì)量。文獻[12]根據(jù)預測角度在兩條參考線上投影點的垂直與水平方向進行線性插值計算,每種模式同時使用兩條參考線的像素信息,在提升預測質(zhì)量的同時也引入額外的復雜度。在醫(yī)學圖像的壓縮算法中,無損與有損混合的編碼算法能有效保證重要信息的壓縮質(zhì)量且提高壓縮比,其中基于感興趣區(qū)域(Region Of Interest,ROI)的壓縮算法具有較優(yōu)的性能。文獻[13]利用泛洪算法將核磁共振圖像分為ROI 與非ROI 部分,并分別進行無損壓縮與有損壓縮,在不影響重要區(qū)域視覺效果的同時增大壓縮比。文獻[14]結(jié)合三維U-Net分割區(qū)域,利用SPIHT算法對核磁共振圖像進行壓縮,以提高壓縮比和重構(gòu)質(zhì)量。由于膠囊內(nèi)鏡設備鏡頭與消化道內(nèi)壁同時處于運動狀態(tài),因此攝像頭在狹窄空間內(nèi)采集到的區(qū)域較小,難以區(qū)分前景與背景。準確判斷并劃分ROI 區(qū)域是當前無損與有損混合壓縮領域的研究重點,錯誤劃分ROI 區(qū)域使重要區(qū)域重構(gòu)模糊,從而影響診斷。

近年來,基于深度學習的圖像壓縮算法解決了傳統(tǒng)無損預測編碼算法難以有效利用像素空間相關性適應圖像紋理的問題。文獻[15]提出一種用于自適應熵編碼的完全并行分層概率模型,當GPU 需要較少的編碼數(shù)時,能解決PixelCNN[11]復雜度較大的問題。文獻[17]利用殘差與通道間相關性漸進學習的方式訓練多層感知器,以準確預測圖像中的像素值,從而提高編碼壓縮比與編碼速度。然而,基于深度學習的算法存在網(wǎng)絡復雜度高、泛化能力較差的問題,難以滿足硬件低功耗的要求。

本文結(jié)合無線膠囊內(nèi)鏡圖像的特點,提出一種自適應不規(guī)則紋理的膠囊內(nèi)鏡圖像無損壓縮算法。通過對膠囊內(nèi)鏡圖像進行分塊處理,針對每個圖像塊,自適應選取圖像塊最優(yōu)的預測模式以消除像素間的空間冗余信息,利用跨分量預測模式去除預測殘差分量間的相關性,并將殘差數(shù)據(jù)傳入熵編碼模塊進行編碼,以形成比特流。

1 自適應不規(guī)則紋理的兩階段預測

1.1 角度預測模式

HEVC 通過大量的角度預測模式,在參考像素間進行線性插值,并對當前像素進行預測以消除空間冗余數(shù)據(jù)。角度預測模式可以適應圖像塊內(nèi)不同的紋理方向,從而提高預測的準確度。無損HEVC 幀內(nèi)編碼結(jié)合空間相關性原理[18],基于樣本的自適應預測(Sample-based Adaptive Prediction,SAP)模式,在待預測像素最鄰近參考像素間進行33 個角度預測。然而,HEVC 的幀內(nèi)預測仍無法在像素值不規(guī)則變化時發(fā)揮最大作用。研究人員基于圖像像素間像素值差值服從均值為零、方差為常數(shù)的高斯分布假設,研究圖像像素間的相關性。基于該假設,像素Ix,y與Ix′,y′之間的相關性可以建模為[19]:

其中:x和y分別表示像素在水平和垂直方向上的坐標。該函數(shù)通過選擇φ以及ψ的值來表示不同方向上像素間的相關性。像素間的空間相關性是基于相鄰像素間差值的絕對值來建模,僅表達了相鄰像素間像素值的相似性,即通過鄰近的像素來表示當前像素,能夠有效減少圖像的空間冗余數(shù)據(jù)。但局部區(qū)域像素值的分布是影響預測結(jié)果的主要因素,簡單的預測模型難以有效獲取鄰近像素的變化信息,導致預測結(jié)果精度降低。

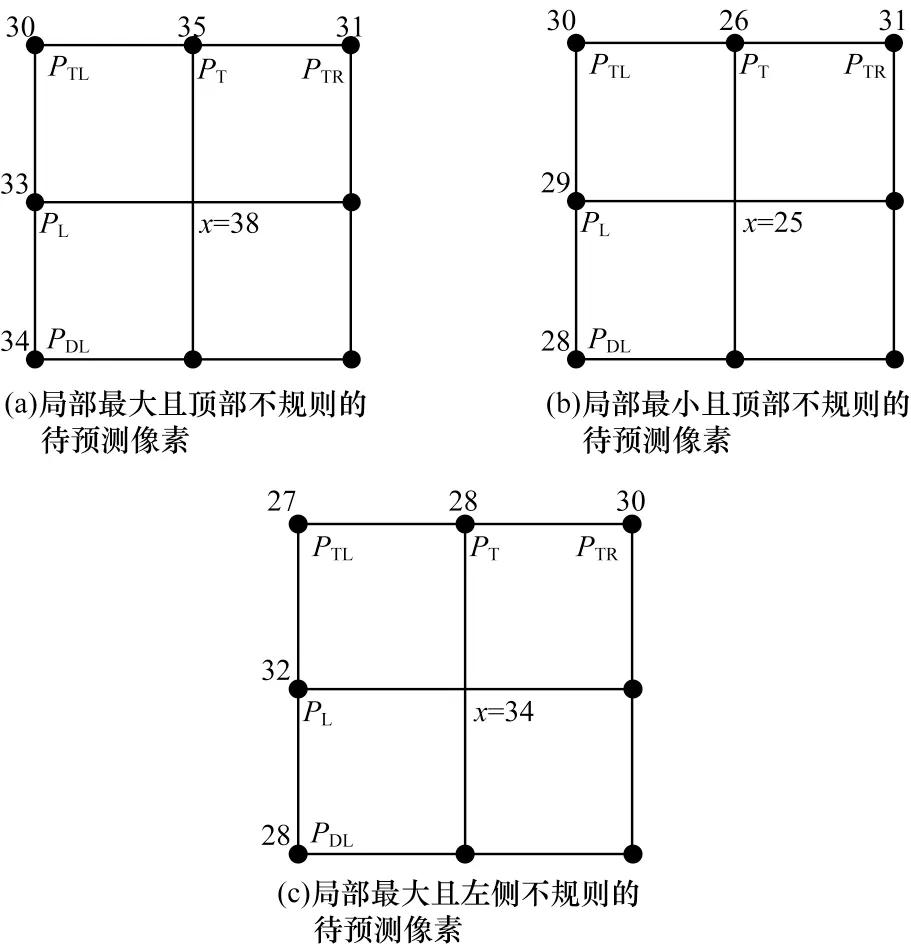

在膠囊內(nèi)鏡圖像中,局部區(qū)域的顏色大致相近,因此,數(shù)值相同或相近的像素集分布在同一區(qū)域內(nèi),在滿足空間相關性的同時,相同或差值較小的像素值會間隔出現(xiàn),導致連續(xù)的像素值變化不規(guī)律,從而影響預測質(zhì)量。圖1 所示為一幅膠囊內(nèi)鏡圖像中3 種局部像素灰度值的分布情況,其中x表示當前待預測像素,PL、PT、PTR、PTL、PDL分別表示當前待預測像素的左、上、右上、左上、左下像素。

圖1 在膠囊內(nèi)鏡圖像局部區(qū)域內(nèi)像素灰度值的分布Fig.1 Distribution of pixel gray value in local area of capsule endoscopy image

從圖1(a)可以看出,像素x周圍局部區(qū)域內(nèi)的像素值非常相近,而在像素值增大的過程中存在像素值突然減小的情況,如PTL至PTR像素值的變化,PTR像素值并沒有根據(jù)PTL、PT增大的規(guī)律增長,而是小于其左側(cè)的PT像素值,且與PTL的像素值十分相近,即上述差值較小的像素值間隔出現(xiàn)。假設待預測像素x的像素值為38,在鄰近的像素中利用無損HEVC的幀內(nèi)預測模式SAP 對兩個像素進行線性內(nèi)插,并計算33 個紋理方向的預測值,在PDL至PL的參考線上得到預測值區(qū)間為[33,34],在PL至PTL的參考線上預測值區(qū)間為[30,33],在PTL至PT的參考線上預測值區(qū)間為[30,35],在PT至PTR的參考線上預測值區(qū)間為[31,35],最終利用SAP 模式可得到預測值區(qū)間為[30,35]。該預測區(qū)間由5 個參考像素中的最小值與最大值組成,而待預測的像素值為38,因此,無法準確地預測未落在由參考像素組成預測區(qū)間內(nèi)的像素值。圖1(b)、圖1(c)也存在與圖1(a)類似的問題。

1.2 擴展角度預測模式

針對膠囊內(nèi)鏡圖像的像素變化以及分布特點,本文提出擴展角度預測模式來優(yōu)化角度預測模式,以克服線性內(nèi)插的局限性,從而選擇圖像塊內(nèi)更優(yōu)的預測結(jié)果。

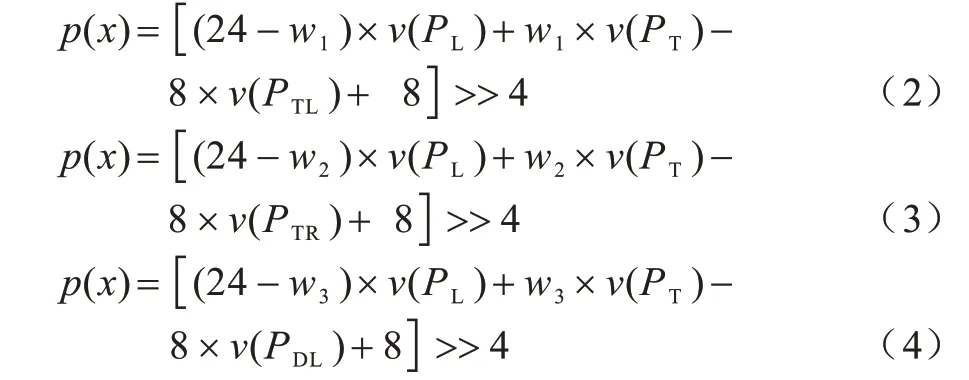

多角度預測模式的作用是在圖像塊內(nèi)按照光柵掃描順序?qū)γ總€像素進行預測。采用SAP 遍歷HEVC 幀內(nèi)預測的33種角度模式,隨著角度變化選取與當前像素鄰近的左、左下、左上、上、右上5 個像素中相鄰的2 個參考像素進行線性內(nèi)插,得到預測值[18]。本文在進行33 個角度預測后,將進行加權(quán)運算的像素增加至3 個,并為參考像素分配不同權(quán)重,以尋找在不同角度上更優(yōu)的預測結(jié)果。通過3個像素進行加權(quán)運算,如式(2)~式(4)所示:

其中:p(x)為當前待編碼像素的預測值;PL、PT、PTR、PTL、PDL分別為當前像素的左、上、右上、左上、左下像素;v(·)為像素值;wi為賦給像素的權(quán)重,滿足0 ≤wi≤24;>>為二進制右移操作。若采用的預測值計算模式使用了PDL像素,解碼時需要將水平的光柵掃描切換成垂直型,以保證參考像素的可用性。

在圖1(a)所示的情況中,本文根據(jù)式(2)計算得到的預測值區(qū)間為[35,38],待預測像素值38 包含在預測值區(qū)間中,當賦予PT像素權(quán)重為24 時,計算所得的預測值與真實值的差值為零,從而解決視頻編碼幀內(nèi)預測模式的局限性問題。同理,式(3)和式(4)分別為圖1(b)和圖1(c)的像素變化情況提供更多的預測值選擇。擴展角度預測模式的目的是基于待預測像素周圍的參考像素,遍歷不同權(quán)重分配,尋找存在的最大像素值減去較小像素值以擴大預測區(qū)間的上限,同時尋找最小像素值減去較大像素值以降低預測區(qū)間的下限,擴大預測值的選擇范圍。

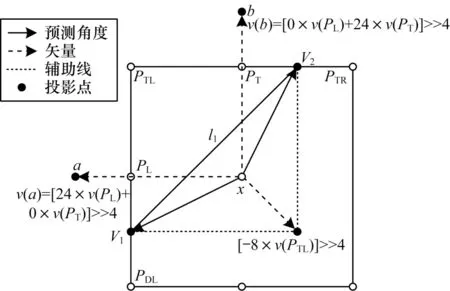

新參考線形成及預測方向示意圖如圖2 所示。

圖2 新參考線生成及預測方向示意圖Fig.2 Schematic diagram of new reference line generation and prediction direction

本文以式(2)為例,通過參考像素相對于待預測像素x的方向以及所分配的權(quán)重來確定預測角度,假設待預測像素x到每個參考像素的距離為16。圖2中a點像素值通過給PL像素分配最大權(quán)重24 且給PT像素分配權(quán)重0,則待預測像素x至a點的距離為24。b點像素值通過給PT像素分配最大權(quán)重,且給PL像素分配權(quán)重0,即給像素x至b點的距離為24。相應的計算方式標注在圖2 中。圖2 中產(chǎn)生了一條新的參考線l1,其端點為V1和V2。V1的預測值為[24×v(a)-8×v(PTL)]>>4;V2的預測值為[24×v(b)-8×v(PTL)]>>4。當根據(jù)式(2)計算不同權(quán)重時,最終投影點將分布在參考線l1上。本文將通過式(2)計算得到的預測值落在參考線l1上,并通過V1、V2線性插值得到投影點的灰度值。

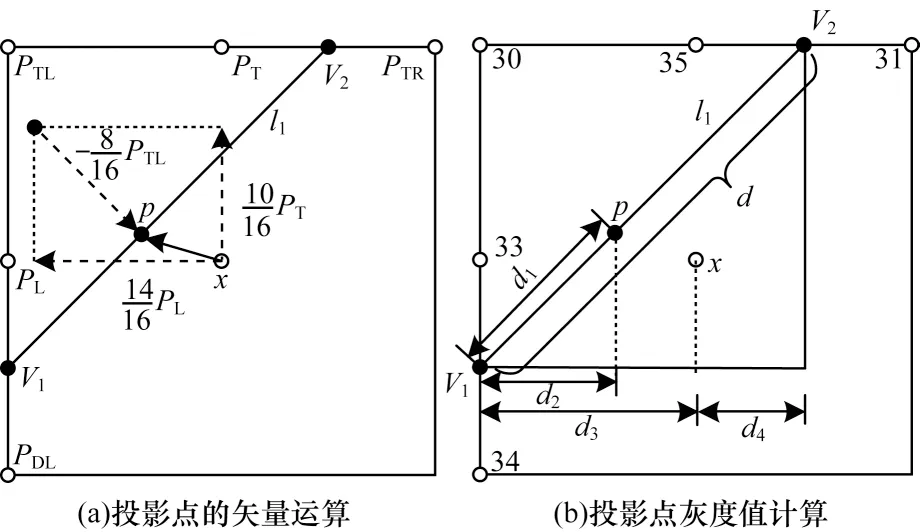

投影點線性插值示意圖如圖3 所示。

圖3 投影點線性插值示意圖Fig.3 Schematic diagram of linear interpolation of projection point

此時分配的權(quán)重w1=10,計算得到V1=35,V2=38。圖3(a)所示為使用式(2)計算預測值,通過矢量運算最終落在參考線的p點處,其預測值為36。本文設待預測像素x到由參考像素構(gòu)成參考行的距離為16,因此圖3(b)中d3=16,d4=8,p點在參考線上與垂直方向的偏移距離d2=10,因此:

通過式(5)可得d1=d。在參考線l1上進行線性插值,則p點預測值的計算如(6)所示:

線性插值得到的v(p)與式(2)所得的值相同。根據(jù)式(2)~式(4)分配不同權(quán)重,本文計算所得的值也分布在對應的參考線上。

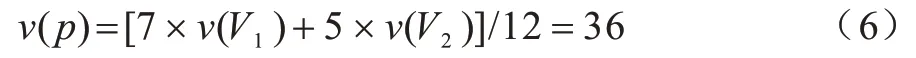

本文按照分配給鄰域像素的權(quán)重將式(2)~式(4)繪制成角度圖,以得到擴展角度預測模式,其示意圖如圖4 所示。

圖4 擴展角度預測模式示意圖Fig.4 Schematic diagram of extended angle prediction mode

擴展角度預測模式將HEVC 的33 個角度預測擴展為56 個,其中每種角度預測線對應一個計算公式。在圖4 中有3 種線型,且每個模式對應一種權(quán)重分配。擴展角度預測模式的權(quán)重選擇:圖4 中根據(jù)式(2)計算模式35~模式45 的預測值,權(quán)重w1在集合{0,1,3,5,8,12,16,19,21,23,24}中進行選擇,即模式35 對應w1為0,模式36 對應w1為1,以此類推,模式45 對應w1為24;根據(jù)式(3)計算模式46~模式51的預測值,權(quán)重w2在集合{0,2,4,20,22,24}中選擇,即模式46 對應的w2為0,模式47 對應的w2為2,以此類推,模式51 對應的w2為24;利用式(4)計算模式52~模式56 的預測值,權(quán)重w3在{0,2,18,21,24}中選擇,即模式52 對應w3為0,模式53 對應w3為2,以此類推,模式56 對應w3為24。

圖4顯示了新生成的3條參考線,即由點V1和V2組成的l1,點V3和V4組成的l2以及點V5和V6組成的l3。在3條參考線上,通過HEVC的模式2~模式34得到參考線中段的預測值,而在不同的像素值變化情況下,靠近參考線的端點處會得到不同的預測值。因此,根據(jù)式(2)~式(4)的計算模式,在參考線的端點附近分配更密集的角度,即端點附近的相鄰權(quán)重變化更小。

從圖4 可以看出,待預測像素隨著預測方向投影至更遠處的參考線上,如點V3、IL、IT、V6。由于本文只利用待預測像素x周圍最鄰近的5 個像素(PL、PT、PTL、PTR、PDL)進行計算,因此與多條參考線預測模式[11]不同,擴展角度預測模式是根據(jù)最鄰近的參考像素形成的梯度變化規(guī)律計算預測值。具體地,點V3在圖4 中對應模式46,通過給PL像素分配最大權(quán)重24 并與PTR的像素值的差值共同形成,而不是通過遠處的左左下像素(PDLL)與左左(PLL)像素線性內(nèi)插得到。擴展角度預測模式學習待預測像素最鄰近的梯度變化情況,當圖像塊內(nèi)像素值沿著紋理方向逐漸增大時,而在某一像素點出現(xiàn)像素值突然減小或未遵循其增大的規(guī)律時,待預測像素無法充分利用參考像素的紋理變化規(guī)律,影響其預測結(jié)果。擴展角度預測模式可以依據(jù)已有像素值增大的規(guī)律,補全因像素值明顯減小帶來的紋理空缺,在充分利用最優(yōu)空間相關性的同時,在圖像塊的紋理方向上尋找區(qū)間更廣的預測結(jié)果。

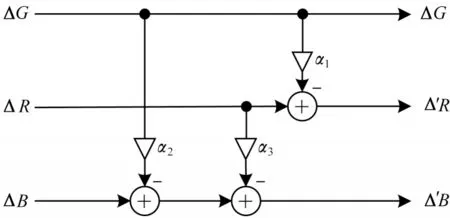

1.3 跨分量預測模式

在膠囊內(nèi)鏡圖像中不僅局部區(qū)域內(nèi)不同像素間的像素值有很大的空間相關性,而且像素的3 個顏色分量紅(R)、綠(G)、藍(B)之間也具有高度相關性。根據(jù)1.2 節(jié)所述的擴展角度預測模式,每個像素都生成了預測殘差,其中圖像塊中每個像素的3 個分量使用同一種預測模式,在減小存儲開銷的同時保留了像素分量間的相關性。本節(jié)采用基于最小二乘的線性回歸模型來尋找圖像塊內(nèi)分量間的最佳線性關系,利用包含最多能量的分量(通常為G 分量)預測其他分量的強度,以去除像素分量間冗余數(shù)據(jù)。

本文通過G 分量殘差ΔG來預測R、B 分量的殘差值ΔR和ΔB,以消除分量間的相關性。線性回歸模型[20]的計算如(7)所示:

其中:Δ′y為將單個顏色通道的殘差值Δy與利用Δx進行線性預測后生成的殘差預測值做差所得的剩余殘差。

跨分量預測模式示意圖如圖5 所示,首先,利用G、R 分量 的殘差值ΔG和ΔR預測B 分量的 殘差值ΔB,利用ΔG預測ΔR。將真實的殘差值與其預測值作差,得到剩余殘差。

圖5 跨分量預測模式示意圖Fig.5 Schematic diagram of cross-component prediction mode

跨分量預測模式通過選擇圖像塊最優(yōu)的預測系數(shù)α構(gòu)建適應圖像塊內(nèi)殘差分布規(guī)律的線性關系,利用其他分量來表示當前分量,進一步消除冗余數(shù)據(jù)。最終的剩余殘差由經(jīng)過多角度預測模式與跨分量預測模式R、B 分量的剩余殘差Δ′R、Δ′B以及只進行多角度預測模式的G 分量殘差ΔG組成。由于存儲了ΔG以及跨分量預測系數(shù)αi(i=1,2,3),因此在解碼時可以無損地按順序恢復ΔR和ΔB。

1.4 算法分析

像素間的多角度預測根據(jù)式(2)~式(4)在滿足圖像塊內(nèi)主紋理方向的同時,解決HEVC 幀內(nèi)預測在圖1所示的3 種梯度變化情況下預測質(zhì)量較低的問題。通過分配權(quán)重完成多角度的預測,在圖像塊內(nèi)紋理分布、像素梯度變化不規(guī)則的情況下,多角度預測模式為待預測像素在紋理方向上提供更多的預測值選擇,以適應當前像素周圍的紋理情況。跨分量預測模式在每個獨立圖像塊內(nèi)尋找最優(yōu)的預測系數(shù),通過最優(yōu)預測系數(shù)得到符合圖像塊內(nèi)分量間像素強度變化趨勢的線性模型,使得圖像塊內(nèi)的總體預測誤差最小。經(jīng)過兩階段預測生成最終的預測殘差,每種預測模式以及預測系數(shù)都是在基于圖像塊內(nèi)預測誤差以及信息熵最小的基礎上篩選得出,因此篩選出的預測模式可以有效適應圖像塊內(nèi)的紋理分布情況,消除大量冗余數(shù)據(jù),有效提高后續(xù)熵編碼工作的質(zhì)量和效率。

2 實驗結(jié)果與分析

2.1 實驗細節(jié)

對于擴展角度預測模式,本文實驗的權(quán)重選擇規(guī)則在1.2 節(jié)中進行了詳細說明。

對于跨分量預測模式,為減小計算復雜度以及保證壓縮效率,α在[-2,2]中取值,且在集合{0,±0.125,±0.25,±0.5,±0.75,±1,±1.25,±1.5,±2}內(nèi)非線性量化。為了避免浮點運算,本文在集合{0,±2,±4,±8,±12,±16,±20,±24,±32}內(nèi)尋找最優(yōu)預測系數(shù)α,再通過右移4 位得到最終的預測值。

對于熵編碼,本文采用Deflate 算法對兩步預測后的殘差數(shù)據(jù)、存儲的預測模式索引以及跨分量預測系數(shù)進行熵編碼。

2.2 實驗結(jié)果

本文在配置為Intel?CoreTMi5-8500CPU@3.00GHz的Windows10 系統(tǒng)Microsoft Visual Studio 2017 軟件上進行實驗。

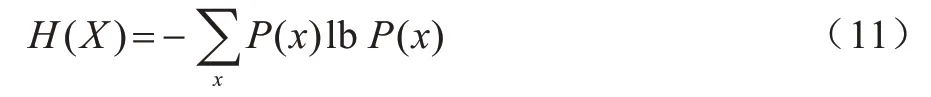

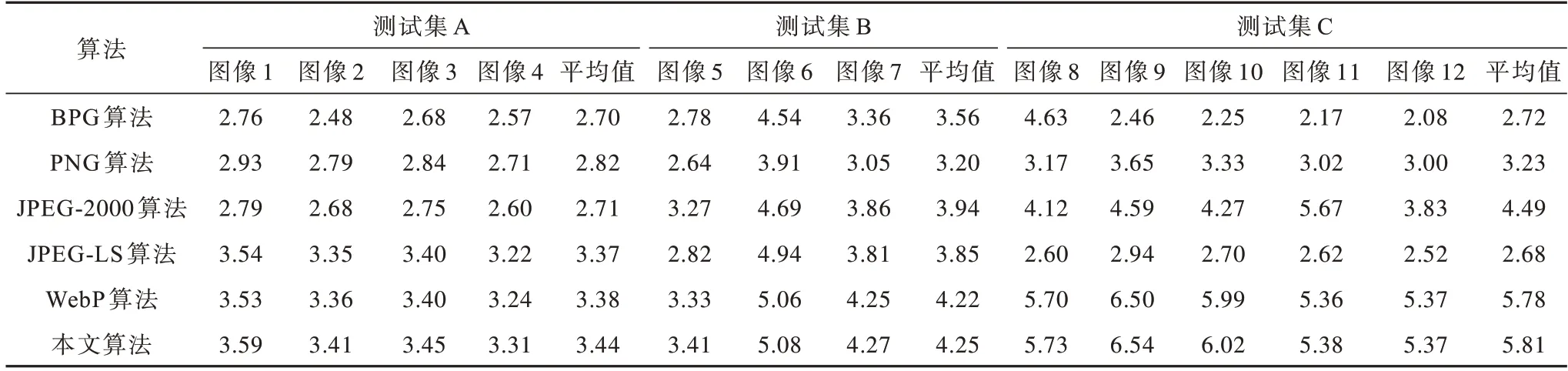

測試圖像為無線膠囊內(nèi)鏡設備采集的食道、胃腸道等部位的圖像,均為未經(jīng)過壓縮的BMP 位圖文件格式,比特深度為8,由R、G、B 3 個分量組成,每個分量占1 個字節(jié)。本文分別測試了擴展角度預測模式的冗余消除率以及所提壓縮算法的壓縮性能,其中冗余消除率通過預測殘差的香農(nóng)信息熵H(X)進行度量。H(X)的計算過程如式(11)所示:

其中:x為殘差數(shù)據(jù);P(x)為殘差x在圖像塊中出現(xiàn)的概率。H(X)越小表示圖像所含信息量越少,冗余消除率越高。

表1 所示為本文預測算法與其他預測算法的香農(nóng)信息熵對比,其中EAPM 為本文提出的擴展角度預測模式,CCP 為跨分量預測模式,采用的測試集為公司提供的膠囊內(nèi)鏡圖像。

表1 不同算法的香農(nóng)信息熵對比Table 1 Shannon information entropy comparison among different algorithms

從表1 可以看出,WebP[21]具有較優(yōu)的預測性能,而本文的預測算法EAPM 預測所得殘差的香農(nóng)信息熵相較于WebP 平均減小約1.5%。EAPM+CCP 算法是將跨分量預測模式CCP 加入至圖像的預測殘差中,進一步減小了圖像的信息熵,相較于WebP 算法預測所得殘差的香農(nóng)信息熵平均減小1.9%。

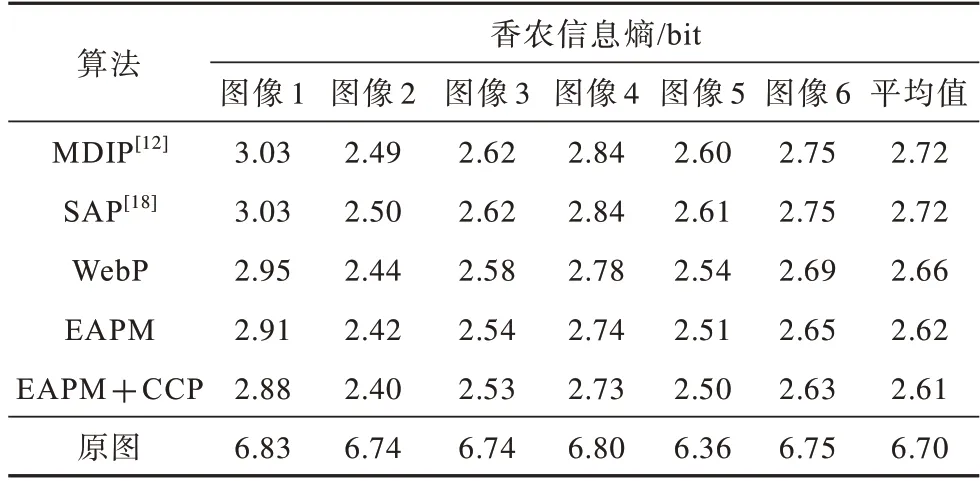

圖6 所示為WebP 算法與本文算法的預測模式可視化結(jié)果對比。圖6(a)所示為兩幅膠囊內(nèi)鏡原圖,圖6(b)所示為剩余殘差構(gòu)成的灰度圖,其中左側(cè)為WebP算法預測后的剩余殘差灰度圖,右側(cè)為本文算法預測后的剩余殘差灰度圖。在圖像塊中紋理方向上的梯度變化相較于其他方向更小,相鄰像素的像素值也更接近當前待預測像素。從圖6(b)可以看出:左側(cè)圖是WebP算法預測后的剩余殘差灰度圖,因像素值變化不規(guī)則,構(gòu)建出與真實值相差較大的預測殘差灰度圖,導致預測殘差出現(xiàn)紋理斷層(如圖中白色方框),未保留原有的圖像紋理,從而導致圖像塊內(nèi)像素預測誤差較大;右側(cè)圖是本文預測模式生成的預測殘差灰度圖,更好地適應了圖像的紋理方向,殘差灰度圖更平滑。當出現(xiàn)影響預測效果的不規(guī)則像素變化情況時,本文算法仍可以適應圖像原有的紋理,以得到更小的預測誤差,從而提升熵編碼質(zhì)量。

圖6 不同算法的預測模式可視化結(jié)果對比Fig.6 Visualization results of prediction modes comparison among different algorithms

由于圖像無損壓縮的峰值信噪比(Peak Signal to Noise Ratio,PSNR)為∞,因此本文將原始圖像大小與壓縮文件大小的比值,即壓縮比(Compression Ratio,CR)作為壓縮性能的評價指標。壓縮比越大,壓縮性能越好。CCR如式(12)所示:

其中:Sorigin為原始圖像的大小;Scompressed為經(jīng)過壓縮后圖像的大小。

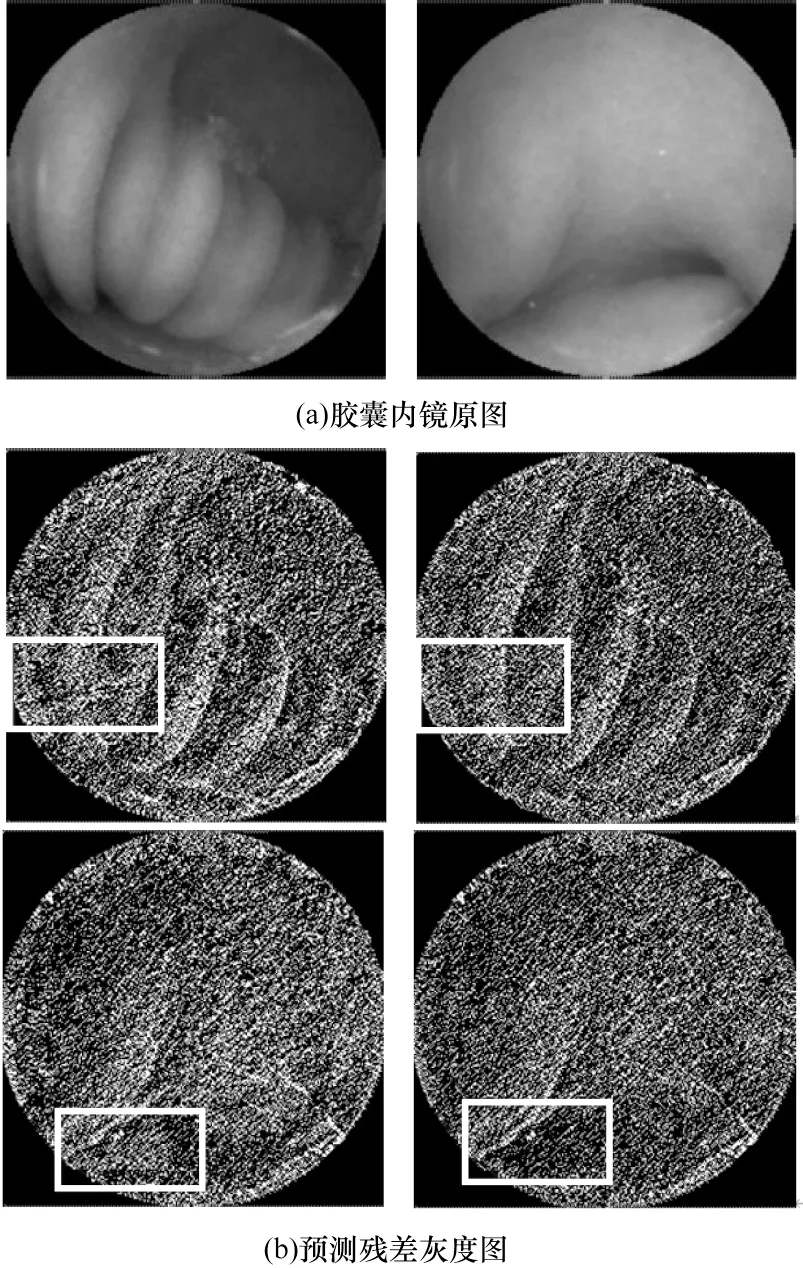

本文分別對3 個測試集中數(shù)百張圖像進行實驗。表2 所示為不同算法的壓縮比對比。測試集A為公司提供膠囊內(nèi)鏡圖像集,測試集B 為文獻[7]提供的醫(yī)學圖像數(shù)據(jù)集,測試集C 為公開數(shù)據(jù)集Kvasir-Capsule[22]中未標注的膠囊內(nèi)鏡圖像。從表2可以看出,在不同的測試集中,圖像壓縮算法的壓縮比不同。在Kvasir-Capsule 公開數(shù)據(jù)集上,本文壓縮算法的壓縮性能最優(yōu),對于單張圖像的平均壓縮比為5.81,相比傳統(tǒng)圖像壓縮算法中表現(xiàn)最優(yōu)的WebP提升了0.52%。在測試集A 上,本文算法的壓縮比相較于WebP 平均提升約1.77%,能夠有效改進圖像的無損壓縮效果。

表2 不同壓縮算法的壓縮比對比Table 2 Compression ratio comparison among different compression algorithms

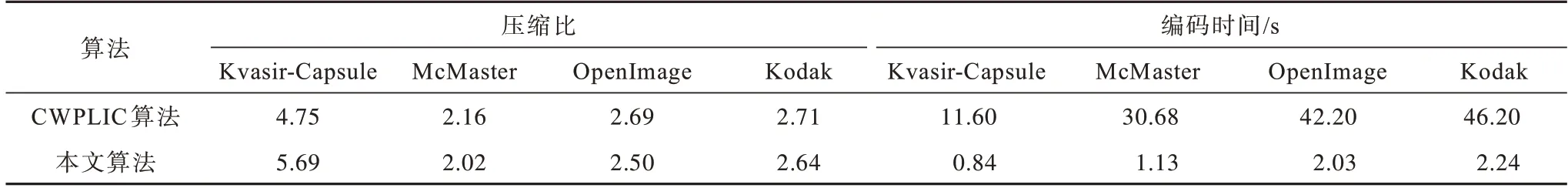

表3 所示為在不同測試集上,本文算法與基于深度學習的無損壓縮算法CWPLIC[17]的壓縮比以及壓縮一張圖像所需的編碼時間對比。測試集包括膠囊內(nèi)鏡圖像數(shù)據(jù)集Kvasir-Capsule 和標準圖像數(shù)據(jù)集McMaster[23]、OpenImage[24]以及Kodak[25]。

表3 在不同測試數(shù)據(jù)集上各壓縮算法的壓縮比與編碼時間對比Table 3 Compression ratio and coding time comparison among each compression algorithms on different test datasets

從表3可以看出,在McMaster、OpenImage 和Kodak 標準圖像測試集上,CWPLIC 比本文算法的壓縮比平均提升2.6%~7.1%,但在Kvasir-Capsule 測試集上本文算法壓縮比遠優(yōu)于CWPLIC,且編碼復雜度低。實驗結(jié)果表明,基于深度學習的預測編碼算法相對于本文線性預測算法在預測精度上具有一定的優(yōu)勢,能夠顯著提高壓縮比,但本文算法在保證高效壓縮的同時,在多個圖像測試集上仍能穩(wěn)定工作。基于深度學習的壓縮算法雖然通過大量的各類型圖像訓練網(wǎng)絡,但是在穩(wěn)定性上存在一定不足。從編碼時間角度分析,為提升壓縮比,深度學習算法需要花費較長時間進行逐像素的推理預測。對于采集大量圖像數(shù)據(jù)的膠囊內(nèi)鏡設備,對硬件友好、穩(wěn)定的低功耗算法是更優(yōu)的選擇。

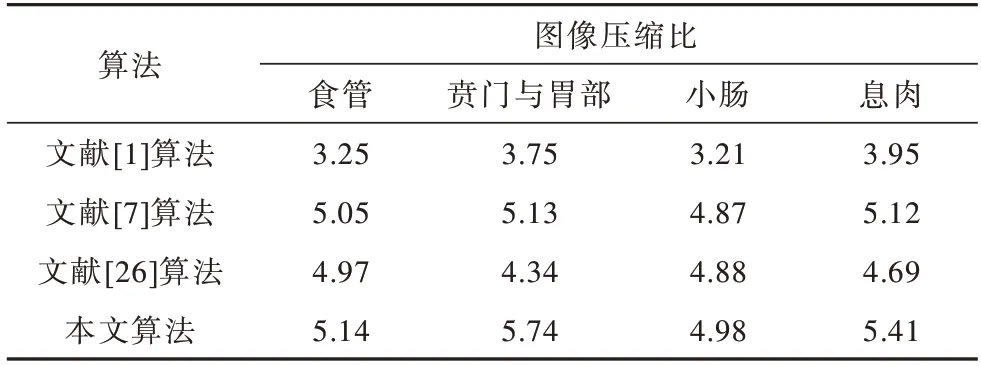

在Kvasir-Capsule 數(shù)據(jù)集上不同壓縮算法對每個部位的數(shù)百張圖像(包括正常消化道圖像以及病變圖像)的壓縮性能的對比結(jié)果如表4 所示。

表4 不同壓縮算法在每個部位的壓縮比對比Table 4 Compression ratios comparison among different compression algorithms at different positions

從表4 可以看出,本文壓縮算法在胃部以及出現(xiàn)息肉的紋理復雜區(qū)域內(nèi)具有較優(yōu)的圖像壓縮性能,而在食管、小腸等紋理相對平滑的部位上圖像壓縮性能略差于紋理復雜區(qū)域。當膠囊內(nèi)鏡采集到紋理復雜、像素變化不規(guī)律的消化道圖像時,本文壓縮算法較其他算法具有更優(yōu)的壓縮性能。

3 結(jié)束語

本文提出一種自適應無損壓縮算法,用于處理不規(guī)則紋理的膠囊內(nèi)鏡圖像。根據(jù)鄰近像素值梯度變化規(guī)律,通過擴展角度預測模式適應圖像塊內(nèi)的不規(guī)則紋理,以提高圖像空間的冗余消除率,同時結(jié)合跨分量預測模式提升圖像的無損壓縮性能。在膠囊內(nèi)鏡圖像測試集上的實驗結(jié)果表明,相比WebP、SAP、MDIP 等算法,本文算法在圖像紋理較復雜的區(qū)域內(nèi)具有較優(yōu)的壓縮性能。下一步將通過基于感興趣區(qū)域無損、非重要區(qū)域有損的混合壓縮算法對膠囊內(nèi)鏡圖像進行壓縮與優(yōu)化,構(gòu)建復雜度較低、準確度較高的神經(jīng)網(wǎng)絡,并對圖像進行感興趣區(qū)域分割,在保證重要區(qū)域(如存在病理信息)無信息損失且重構(gòu)圖像質(zhì)量不影響診斷的前提下進一步提升壓縮比。