基于GAN的人臉圖像三維重建

羅健,郝泳濤

(同濟大學CAD研究中心,上海 201804)

1 引言

人臉圖像三維重建的意義主要可以從兩個方面來考量:在實際應用方面,在許多與人們生活密切相關的領域中,人臉三維模型都有著極其廣泛的應用和十分旺盛的需求。例如在游戲影音這樣的傳統娛樂領域,人們需要更逼真的三維模型來提升沉浸感以期獲得良好的體驗,在公共安全領域,高精度的人臉模型也能夠幫助獲得更詳細的外貌信息從而在一定程度上減小人力物力的損耗。在這些情況下,人臉圖像三維重建能夠獲得人臉三維模型的難度和成本,從而更加拓寬人臉三維重建技術的應用范圍,并通過降低需要獲取人臉模型行業成本的方式促進其發展。另一方面,從科學研究的角度來看,人臉圖像三維重建不是一門孤立的技術,而是與圖像處理、特征提取等多個研究領域都息息相關。對于人臉圖像三維重建的研究能夠對當下諸多的熱門領域例,如人臉關鍵點檢測、人臉識別、人臉編輯等方向的研究提供一些啟發和經驗,在一定程度上促進這些方向研究的發展,提升其應用能力,以便更好地造福人類的生活。

1.1 相關工作

基于圖像人臉三維重建方法,總體上來說可以分為基于從運動恢復結構、基于明暗恢復形狀、基于三維形變模型三種方法。

1)基于從運動恢復結構的三維人臉重建方法

這種方法的主要原理是通過多幅圖像中與運動視差信息中隱含著被測物體的三維結構信息,通過這些信息來進行三維人臉的構建。其中有兩個具有代表性的方法。Sun等在文獻[1]提出的算法是利用非線性最小方差模型和約束的獨立成分分析(Constrained Independent Component Analysis,CICA)模型估計人的正臉和非正臉圖像中一些重要特征點的深度值;Dai等在文獻[2]提出一種基于塊的SFM算法,首先利用稀疏的人臉特征點重建粗糙的三維人臉模型,接著采用核偏最小二乘算法,根據人臉輪廓優化彌補基于稀疏人臉特征點的SFM算法的局限性,細化粗糙的三維人臉模型。

2)基于從明暗恢復形狀的三維人臉重建方法

這種方法源自由Horn等在文獻[3]提出的僅需輸入的單幅圖像就可以獲得人臉的三維信息算法。主要原理是通過坐標變換和敏感信息計算出人臉各個點位所對應的深度值,并以此為依據,構建人臉重建模型。Liao等在文獻[4]中將SFS算法與局部形變模型相結合,首先利用SFS算法快速獲取人臉的三維輪廓線,接著通過局部形變模型恢復精確的三維數據,最后在得到的人臉三維輪廓線和精確三維數據上,不斷迭代平滑從而獲得高質量的三維人臉模型;Maurer等在文獻[5]中將SFS算法與雙目視覺算法相結合,為能量函數添加保留細節的各向異性二階平滑項,通過這種方式擴展結果模型,使其可以估計深度、反射率和照度,從而使該方法適用于反射率不均勻的物體以及光照條件未知的場景。基于從明暗恢復形狀的三維人臉重建算法能夠更好地對低紋理人臉圖像進行三維重建,但這類方法在處理人臉五官時可能會存在變形問題。因此在效果上存在一定的不穩定性。

3)基于三維形變模型的三維人臉重建方法

這種算法的核心在于三維形變模型(3DMM),它的本質是一個通用的三維人臉模型,用固定的點數來表示人臉。核心思想就是人臉可以在三維空間中進行一一匹配,并且可以由其他許多幅人臉正交基加權線性相加而來。Blanz等人1999年在文獻[6]中提出了三維形變模型。規模面部模型(LSFM)—一種由9663個不同的面部身份自動構建的3D可變形模型(3DMM)是由Booth等人在文獻[7]中提出的一個能夠適應不同人種、膚色等情況的模型。除此之外,還有許多效果比較好的非線性3DMM模型陸續被提出,例如由Tran等人在文獻[8]中提出的非線性3DMM模型,作者提出了一種新的框架,在不采集三維人臉掃描數據的情況下,從大量無約束的人臉圖像中學習非線性3DMM模型,它比傳統的線性模型具有更大的表示能力。本文的方法中就用到了3DMM模型從單張圖片獲取粗糙的人臉模型。

但是對于人臉圖像三維重建這一具體問題來說,需要考慮問題與寬泛概念下的三維重建有著很大的區別。首先,人臉一般都是對稱結構,不需要考慮重建不對稱的情況,如果使用和一般三維重建相同的方法,就意味著會增加一部分不必要的開銷。其次,人臉有著明顯的特征區域(如眼睛、嘴巴、鼻子等),如果在這些區域內的細節處理可以達到很好的效果,那么在方法中即使存在對其他區域的粗放處理,對于最終呈現效果的影響也可以被降到較低水平的。因此,將GAN與人臉圖像三維重建的具體情景相結合,進行因地制宜的調整和優化,并吸納其他人臉三維重建方法的優點和成果,將它們結合起來共同作用,來取得更好的生成效果,是筆者工作的重點。

2 網絡模型

2.1 生成器

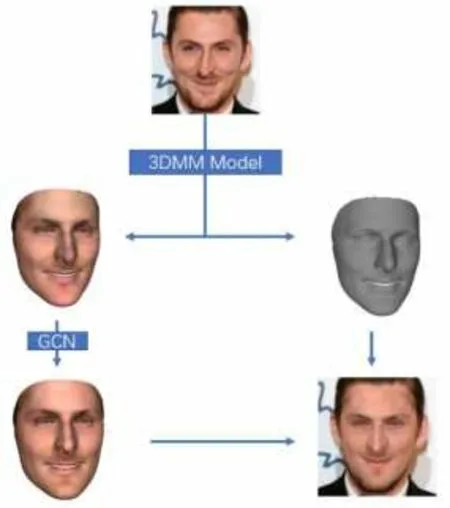

首先是用于從輸入的圖片中提取出三維結構形狀和粗糙紋理的模塊,這一部分采用了一個CNN網絡,從輸入圖片中提取出表示光照和面部姿勢的矢量,和3DMM模型中必要的參數向量,然后把這些向量作為輸入,來獲取人臉三維立體結構的形狀和面部的粗糙紋理貼圖。

其次是從文獻[9]中提取出的網絡結構FaceNet。它的作用也是提取輸入圖片中的特征向量,其目的有兩個,一是提供給下一部分的紋理細化網絡作為輸入,二是用來衡量身份距離,用來計算網絡的身份距離損失函數。

最后是采用了圖卷積網絡(GCN)的技術,共使用Decoder、Refiner、Combiner三個圖卷積網絡的紋理優化模塊,把接收第一部分中的結果作為輸入,輸出細化后的紋理結果。其中,Decoder部分接收并處理FaceNet的結果,Refiner接收3DMM的結果并細化模型數據中的頂點顏色,最后的Combiner負責綜合其他兩部分的輸出,得到最終結果的模型中每個頂點的顏色,結合原來的頂點坐標、法線、面等信息,作為生成器最后的結果輸出。

圖1 人臉三維重建流程

2.1 判別器

判別器工作的原理是將生成的人臉三維模型重新投影到輸入圖片的像平面上(姿勢監督數據和光照信息數據都在第一個模塊中獲得)之后得到一張新的圖片,進而通過判別這兩張圖片是重投影得到的,還是自然輸入的原始圖片,來和生成器網絡進行對抗訓練,提升人臉三維模型生成的效果。在重投影的策略上,筆者選擇參照了文獻[10]中的可微渲染層。在該文獻中,Genova等人提出了基于一種延遲著色模型的泛用性較強的可微光柵化器。這種光柵化器利用三角形的ID和像素的重心坐標來計算屏幕空間緩沖,模型網格結構中的顏色和發現都會在像素間進行插值。在訓練中,頂點法線會使用鄰近的三角形的法線的平均值替代。筆者應用這個文獻中的可微渲染層來完成三維模型到輸入圖片像平面的重投影工作。然后將生成圖片和輸入圖片一起送入判別器網絡。網絡一共包含6個核大小為3的卷積層,同時每個卷積層之后都有一個最大池化層。訓練中筆者遵循帶有梯度懲罰的Wasserstein GANs中描述的流程進行處理和訓練。

2 損失函數

2.1 逐像素的損失

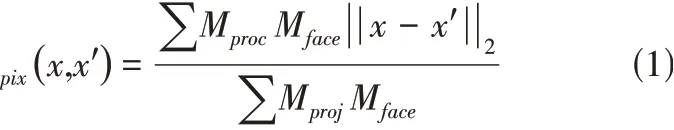

考慮到在輸入的圖片中人臉部分可能被各種物品遮擋(如頭發、眼鏡、口罩等),而筆者的模型生成時卻并不會生成這些結構,因此在計算像素損失時這些區域不能夠被計算進去,只需要計算能夠生成區域的損失,設這個區域為Mface,包含面部、眼睛、嘴巴、鼻子、眉毛等部位,筆者使用了預訓練的一個人臉識別網絡來進行這些部位的分辨。Pixel wise loss定義如下,其中x和x'分別代表輸入圖片和重投影出的圖片結果,Mproj表示面部三維模型可以被投影到的區域。

2.2 身份保留損失

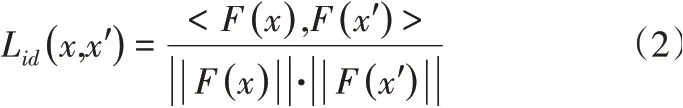

在使用像素級別損失的情況下,一般的情景已經可以產生比較良好的結果了,但是這樣產生的人臉模型可能還與輸入的二維圖片有明顯差異,尤其是在一些極端的情況下。因此筆者在模型中應用了所謂的身份保留損失,這是一種面部特征級別的損失函數,它要求將輸入圖片和生成的圖片使用FaceNet提取到的特征信息向量應該盡可能地接近。如公式(2),它的定義是輸入圖片和重投影圖片通過FaceNet得到的特征信息之間的余弦距離,其中<>代表內積,F()代表FaceNet得到的輸出。

2.3 逐頂點損失

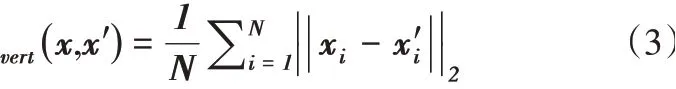

在圖卷積網絡訓練的早期過程中,圖像中面部的遮擋物可能還會導致其無法正確地判斷頂點的顏色數據的情況出現,造成模型的效果下降,因此在第一個三維形狀和粗糙紋理提取模塊提取出的粗糙紋理的基礎上,在網絡中使用了一個逐頂點的損失,并在訓練過程中逐步降低這一損失的權重。除此之外還要考慮到,為了獲取人臉的細節特征,還需要將面部頂點投影到2D圖片上來取回頂點顏色,然后將其和3DMM模型的紋理顏色一起送入Refiner中。綜合考慮下逐頂點損失的定義為式(3),其中N表示頂點個數,xi表示由三維形狀和粗糙紋理提供模塊提取出的粗糙問題反照率值T或者取回的頂點顏色Tp,x'i則表示Refiner得到的顏色'。

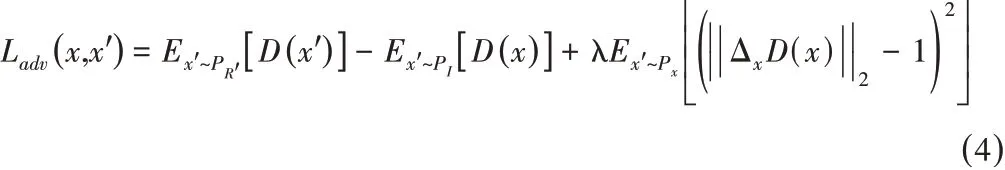

2.4 對抗損失

對于對抗學習中的對抗損失GAN loss來說,筆者采用了參考文獻[11]中的改進的Wasserstein GAN范式,將對抗損失定義如公式(3),其中x和x'分別代表輸入圖片和重投影出的圖片結果,x是沿輸入圖像分布PI和渲染圖像分布PR'采樣的點之間的直線均勻采樣的隨機樣本。

2.5 最終損失

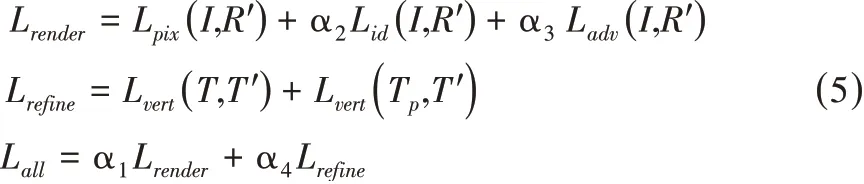

綜合上述四種需要計算的損失,網絡整體上的損失函數可以定義如公式(5):

在訓練過程中,控制身份保留損失與對抗學習損失的權重α2,α3均為固定值,分別為α2=0.2,α3=0.002。α1和α4的初始值設定分別為0和1,每經過一輪訓練,就下調α1的值并上調α4的值,但始終保持α1+α4=1,直至最后一輪α1和α4變為1和0。

2 實驗結果與討論

該數據集的原始圖片是由文獻[12]中的CelebA數據集中挑選而來的。并且通過文獻[13]中的方法進行了分割,生成了不同部位的mask圖片。通過這些mask圖片可以很簡單地挑選需要的部位進行實驗。數據集中包含有:30000張分辨率為1024×1024的原始圖片,每個原始圖片的每個分割部位的mask圖片,其分辨率為512×512,以黑白二值圖的形式儲存。除此之外還包含有:每個圖片與CelebA數據集中圖片的對應關系,每個圖片的人臉包含的屬性信息,每個人臉的姿勢信息(以歐拉角形式存儲)。

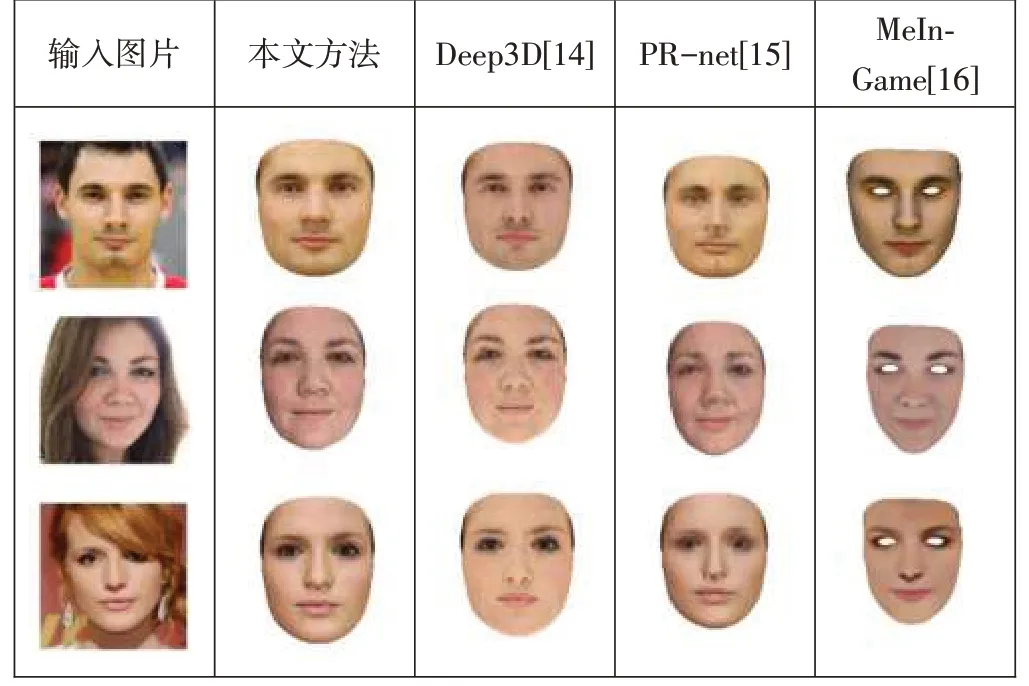

接下來,將本文的模型生成三維結構的效果與其他幾個常見的人臉三維重建模型進行了對比,實驗如圖3所示。可以看出,本文的方法生成的三維模型的效果具有更貼近原圖片的紋理信息和三維結構,具有更好的表現。

圖3 對比實驗結果圖

3 結束語

基于GAN的人臉圖像三維重建算法在試驗中取得了比較好的表現,但是仍然存在著一些問題,最明顯的一個問題就是,盡管人臉部分的生成已經具有很高的質量,但是頭發部位的生成卻很難進行,一方面,頭發部位不同于人臉這樣的基本一致結構,因為發型等的不同,其立體結構很難找到共同點,無法使用類似于3DMM這樣的思路來解決其生成問題;另一方面,頭發的加入會導致集合上的遮擋關系快速復雜化,現有的思路下,在訓練中處理這些遮擋關系可能需要花費十分高昂的代價,因此需要新的思路來解決這一問題。如果僅有人臉部模型而沒有其他區域,那么這項技術的應用領域就會受到極大限制,獲取其他部位模型的難度也會降低人臉圖像三維重建技術在降低三維模型獲取成本上的作用。