一種基于定位和非對稱補償?shù)膫窝b目標(biāo)分割方法

徐義飛, 李曉冬, 李新德

(1. 東南大學(xué)自動化學(xué)院, 江蘇 南京 210096; 2. 信息系統(tǒng)工程重點實驗室, 江蘇 南京 210000;3. 南京數(shù)學(xué)應(yīng)用中心, 江蘇 南京 211135)

0 引 言

偽裝是生物或者物體通過改變外表顏色、光照或者材料與紋理等手段隱藏本體,將自身“完美”嵌入周圍環(huán)境中。隱蔽方式的成功主要得益于生物對知覺選擇性的認知誤導(dǎo),即欺騙觀察者的感知系統(tǒng),使其錯將前景誤認為是背景的一部分。如圖1所示,偽裝目標(biāo)的特征表現(xiàn)在前景與背景的高度相似性,相較于顯著目標(biāo)而言更難分辨。通過對偽裝目標(biāo)數(shù)據(jù)集、顯著目標(biāo)數(shù)據(jù)集分別進行前景、背景的信息熵處理發(fā)現(xiàn):偽裝數(shù)據(jù)集相比顯著目標(biāo)數(shù)據(jù)集而言,前景信息與背景信息的貼近程度更高。因此,偽裝物體檢測通常需要投入大量的視覺感知進行信息提取與聚焦,遠比傳統(tǒng)的顯著目標(biāo)檢測或通用目標(biāo)檢測更具挑戰(zhàn)性。

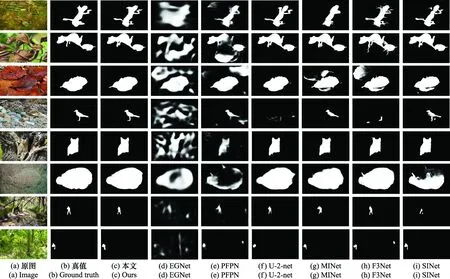

圖1 偽裝目標(biāo)示例Fig.1 Examples of camouflaged object

偽裝目標(biāo)分割(camouflaged object segmentation, COS)作為檢測的一種像素級表現(xiàn)形式,其研究除具備學(xué)術(shù)價值外,更具備廣闊應(yīng)用前景:軍事上,可在一定程度上提高軍事反偵察能力;工業(yè)上,有利于安全監(jiān)視和救援(如礦工搜尋);農(nóng)業(yè)上,有助于推動病蟲害預(yù)警與防治(如蝗蟲入侵監(jiān)控);醫(yī)學(xué)上,可促進醫(yī)療影像的病灶定位與診斷(如息肉分割)。

然而,COS目前仍是一項極具挑戰(zhàn)的檢測任務(wù)。早期的偽裝物體分割主要利用手工提取圖像顏色對比度、紋理邊緣差異等低級特征的方式來區(qū)分前景與背景。這類方法可較好分割簡單圖像中的偽裝物體,但考慮到偽裝策略會將目標(biāo)較好地嵌入周圍環(huán)境中,直接利用低級特征界定偽裝物體,方法的泛化能力非常有限。近些年,隨著深度學(xué)習(xí)模型在計算機視覺領(lǐng)域取得了顯著的成功,基于深度學(xué)習(xí)的偽裝物體分割逐漸受到了研究人員的關(guān)注。Le等人提出集成分類信息的像素級分割網(wǎng)絡(luò)結(jié)構(gòu)。Fan等人提出基于搜索與識別網(wǎng)絡(luò),同時COD10K數(shù)據(jù)集的公開很大程度上推動了偽裝目標(biāo)分割的發(fā)展。Lv等人基于排序的偽裝物體檢測網(wǎng)絡(luò)同時對偽裝目標(biāo)進行定位、分割和排序。盡管這些探索取得了不錯的效果,但高度相似的前景與背景所產(chǎn)生的歧義區(qū)域處理仍會導(dǎo)致不可靠的分割結(jié)果,如何提升高相似性區(qū)域的分割準(zhǔn)確率仍是需要解決的問題。

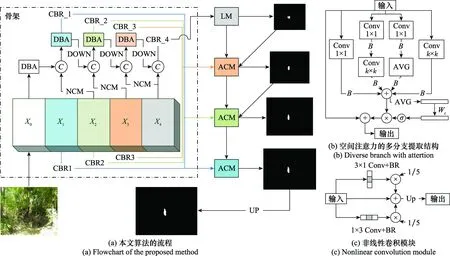

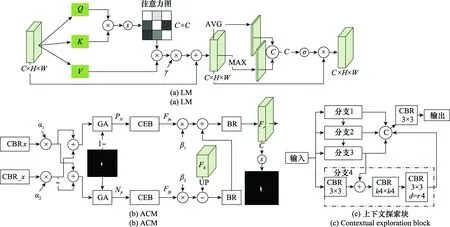

在自然界中,生物利用偽裝策略保護自身在環(huán)境中不被捕食者發(fā)現(xiàn)。然而,獵物和捕食者的自然博弈過程也促使了捕食策略的進化,形成一套行之有效的偽裝獵物捕捉機制:搜索→聚焦→捕獲。受捕食前兩階段的啟發(fā),本文提出一種定位和補償網(wǎng)絡(luò)(locating and compensation network, LCNet)用于目標(biāo)分割,具備了對高相似偽裝物體的準(zhǔn)確分割能力。LCNet主要包含兩個關(guān)鍵模塊:定位模塊(locating module, LM)和非對稱補償模塊(asymmetric compensation module, ACM)。LM主要用于模擬捕食搜索確立的過程,對文獻[21]提出的雙注意力并聯(lián)結(jié)構(gòu)進行改進,通過級聯(lián)通道和空間注意力的雙注意力方式減少信息冗余,并對目標(biāo)進行初步定位。然后,ACM對定位的結(jié)果進行補償,對強化后的前景/背景,結(jié)合對立的掩膜和高斯函數(shù)對背景/前景施加注意力加權(quán)得到像素歧義區(qū),在特征提取后去除假陰性/假陽性(即前景/背景)區(qū)域的干擾。最后,通過構(gòu)建多層級特征的ACM結(jié)構(gòu),實現(xiàn)對歧義區(qū)域歸屬的逐步細化,得到精確的偽裝目標(biāo)分割結(jié)果。本文的主要貢獻如下:

(1) 提出一種新穎的偽裝目標(biāo)分割方法LCNet。該方法首先通過復(fù)合主干網(wǎng)提取復(fù)雜特征,并通過級聯(lián)的雙注意力模塊對目標(biāo)進行搜索定位,最后采用非對稱的高斯注意力獲取歧義區(qū)進行補償,細化偽裝目標(biāo)區(qū)域的分割結(jié)果。

(2) 采用復(fù)合主干網(wǎng)的雙主干(dual-backbone, DB)結(jié)構(gòu),強化對偽裝目標(biāo)的感知提取,將前一主干相鄰層級的輸出與后續(xù)主干的輸入合并作為后續(xù)主干新的輸入。同時,為避免主干網(wǎng)絡(luò)模塊過多導(dǎo)致計算復(fù)雜度增大,本文移除輔主干網(wǎng)的第一階段,并對輔主干網(wǎng)的整體結(jié)構(gòu)進行輕量化。

(3) 實驗結(jié)果表明,提出的方法在3個公開偽裝數(shù)據(jù)集上實現(xiàn)了最優(yōu)的分割效果,并通過消融實驗驗證了方法的有效性。

1 LCNet算法

為了更好地定位和細化特征歸屬,本文提出一種基于定位和非對稱補償?shù)膫窝b目標(biāo)分割網(wǎng)絡(luò),整體結(jié)構(gòu)如圖2(a)所示。網(wǎng)絡(luò)包含兩個關(guān)鍵模塊:LM和ACM,以及負責(zé)多尺度特征提取的復(fù)合主干網(wǎng)的DB。具體而言:首先,將包含偽裝目標(biāo)的圖像輸入復(fù)合主干網(wǎng)的DB結(jié)構(gòu),進行多尺度特征提取與融合。然后,在主主干網(wǎng)與輔主干網(wǎng)最深層特征圖的拼接結(jié)果上引入LM,對潛在的物體位置進行初步定位。接著,將主主干網(wǎng)與輔主干網(wǎng)剩余3個層級的特征輸出至卷積塊(convolution+batch normalization+ReLU, CBR)中進行通道減縮。將水平相近的主輔減縮結(jié)果輸入至同一個ACM。最后,通過ACM級聯(lián)的方式,完成對定位結(jié)果的逐步細化與補償,得到最終的COS結(jié)果。

圖2 定位補償網(wǎng)絡(luò)Fig.2 LCNet

1.1 復(fù)合主干網(wǎng)

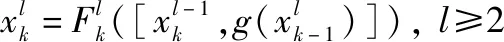

具體而言,若只有一個主干網(wǎng),第-1級特征-1作為輸入,第級特征作為輸出,第級映射關(guān)系為,輸入和輸出關(guān)系可表示為

=(-1),≥2

(1)

(2)

(3)

式中:包含核尺寸為1×3與3×1的CBR處理模塊;Up(·)為上采樣操作。特征通過兩個不同核尺寸的CBR處理模塊后,加權(quán)與輸入相加。最后,以上采樣操作調(diào)整回流特征尺寸,保證特征拼接尺寸一致。

輔主干網(wǎng)中的DBA模塊主要包含多分支提取結(jié)構(gòu)后綴通道注意力處理。文獻[24]指出,將兩個具有不同表征能力的分支(例如1×1卷積和3×3卷積)組合起來比兩個相同分支(例如兩個3×3卷積)更好。本文提出的多分支拓撲將具有多尺度卷積、順序1×1-×卷積、平均池化等分支,并對拓撲分支的求和結(jié)果施加高效序列提取(effective squeeze-and-excitation, eSE)注意力,明確地建模了特征映射通道之間的相互依賴關(guān)系,以增強其表示性:

=((_gap()))?

(4)

式中:為多分支結(jié)構(gòu)提取完的結(jié)果;為sigmoid激活函數(shù)將輸入映射到0~1之間;_gap為通道域全局平均池化(global average pooling, GAP)操作。最后,本文借鑒ResNet的殘差思想,將原始輸入特征圖按元素添加至中。通過主干提取的多層級特征會分別借助通道減縮輸入至LM以及ACM中。

1.2 定位模塊

本文所提出的LM結(jié)構(gòu)如圖3(a)所示,其中MAX表示最大池化,GA表示高斯注意力。LM由通道注意力與空間注意力串聯(lián)構(gòu)成,其主要作用于DB深層次拼接的特征圖上,以獲取語義增強的特征。LM中通道注意力利用特征的通道間關(guān)系生成通道注意圖,關(guān)注的是單個檢測器內(nèi)容語義提取,在本文中以非局部的方式實現(xiàn)。在通道注意力之后,級聯(lián)空間注意力模塊,增強位置信息的提取,進而與前者在信息提取上互補。

圖3 兩大關(guān)鍵模塊Fig.3 Two main building blocks

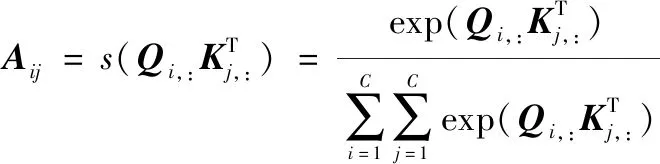

具體而言,給定特征輸入?××,首先通過形狀變換得{,,}?×,=×,然后對,矩陣叉乘,并采用softmax函數(shù)歸一化得到通道注意力圖?×:

(5)

式中:為輸入特征總的通道維數(shù);值表示第個通道,:與第個通道,:的相似度程度。最后,與矩陣叉乘,得到通道注意力的輸出特征?××:

(6)

式中:為第個通道特征加權(quán)后的結(jié)果;(·)是價值變換函數(shù),以線性函數(shù)的方式實現(xiàn);歸一化因子()采用softmax函數(shù);是范圍1~的點集。在此基礎(chǔ)上,為減少信息的傳輸損失,引入一個可學(xué)習(xí)的殘差跳躍連接,最終的非局部通道注意力可表示為

=γ+

(7)

式中:為比例系數(shù);?××為增強后的特征(為其第個通道成份),其建模了特征圖通道之間的長范圍語義依賴關(guān)系,加強了特征的可判別性。在通道注意力的基礎(chǔ)上,本文引入了一個空間注意力模塊,對通道注意力輸出結(jié)果分別采用空間域的GAP_gap及全局最大池化_gmp,并將兩結(jié)果拼接作為卷積的輸入,最后借助sigmoid函數(shù)對結(jié)果進行映射處理,得到空間注意力圖:

()=(conv([_gap(),_gmp()],(7,7)))

(8)

將得到的注意力圖對輸入特征加權(quán),篩選出空間位置信息,操作過程可表示如下:

′=()?

(9)

式中:?為元素乘法運算;輸出特征′?××。通過LM的處理,初步確立了目標(biāo)的通道語義與空間位置信息,以便后續(xù)的ACM級聯(lián)補償與逐步細化。

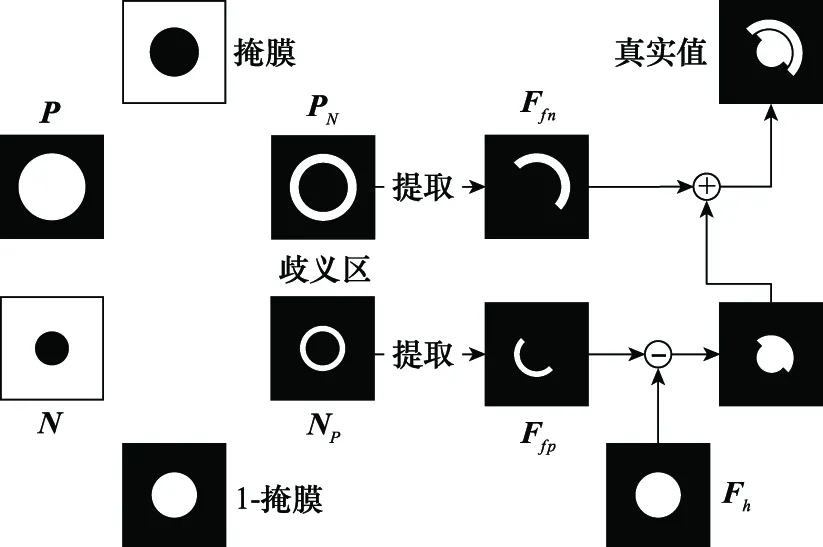

1.3 ACM

偽裝物體在紋理上通常與背景極其相近,如何劃分歧義區(qū)域的歸屬將直接影響最終的分割精準(zhǔn)度。本文從兩個對立面進行信息的逐步細化與補償,實施細節(jié)如圖3(b)所示,而對應(yīng)的補償機理見圖4。

圖4 推理分析補償Fig.4 Reasoning analysis compensation

首先引入LM或上一級ACM的輸出特征,其相較于真實值會存在歧義區(qū)域的錯誤劃分,需查漏補缺。本文對DB的同等級輸出施加差異化的求和,進而得到側(cè)重于前景信息的特征與側(cè)重于背景信息的特征。進一步借助對立的,分別對與施加全局高斯注意力,得到歧義區(qū)域(中關(guān)注背景得歧義成份以及中關(guān)注前景得歧義成份),最后對()進行進一步特征提取與融合得假陰性特征(假陽性),并對輸入特征進行信息補償,即正補償、負補償。

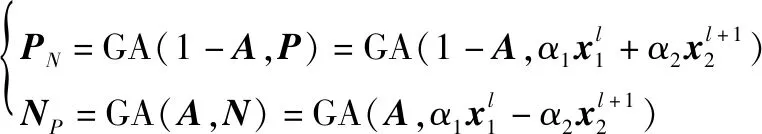

(10)

式中:/為歧義區(qū)域(前景背景中關(guān)注得到的背景前景);為上一級模塊輸出的真值預(yù)測;GA為文獻[4]所提出的高斯注意力,以增強目標(biāo)特征的提取。在此基礎(chǔ)上分別輸入圖3(c)所示的上下文探索分支結(jié)構(gòu),主要利用擴張卷積結(jié)構(gòu)增大感受野,然后借助通道維度的疊加融合,以增強大范圍內(nèi)感知豐富上下文的能力,借此獲得歧義區(qū)域的最終歸屬,并利用劃分結(jié)果對特征圖進行補償:

=BR(BR(Up()-)+)

(11)

式中:BR為批歸一化和ReLU激活函數(shù)的組合;,為可學(xué)習(xí)的比例系數(shù)。

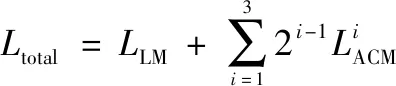

1.4 損失函數(shù)

考慮到交叉熵損失只能刻畫圖像在像素層面的不同,無法較好反映出整體、局部以及邊緣信息的差異。本文在該損失的基礎(chǔ)上引入交并比損失,即=+,用于描述LM在空間位置的偏差。而ACM更加關(guān)注邊緣歧義區(qū)域的像素歸屬,故引入結(jié)構(gòu)相似性損失去引導(dǎo)ACM對邊緣區(qū)域的補償與細化,即=+。為突出不同層級的貢獻度,本文通過不同權(quán)重系數(shù)加以區(qū)別,總的損失可描述如下:

(12)

2 實驗驗證

2.1 實驗設(shè)置

數(shù)據(jù)集。本文主要在3個基準(zhǔn)數(shù)據(jù)集上對本文提出的方法進行評估:CPD1K、CAMO以及COD10K。COD10K是目前最大的偽裝數(shù)據(jù)集,且標(biāo)注精度很高,總共包含5 066張偽裝圖片,其中3 040張圖片用于訓(xùn)練,2 026張用于測試:CAMO總共包含1 250張不同類別的數(shù)據(jù)樣本,其中1 000張用于訓(xùn)練,250張用于測試;CPD1K總共包含1 000張只有人的數(shù)據(jù)樣本。由于數(shù)據(jù)集未對樣本做測試和訓(xùn)練的劃分,本文隨機將其中800張用于訓(xùn)練,200張用于測試。本文將訓(xùn)練所有數(shù)據(jù)(COD10K+CAMO+CPD1K)作為方案Ⅰ,只訓(xùn)練COD10K數(shù)據(jù)集作為方案Ⅱ。

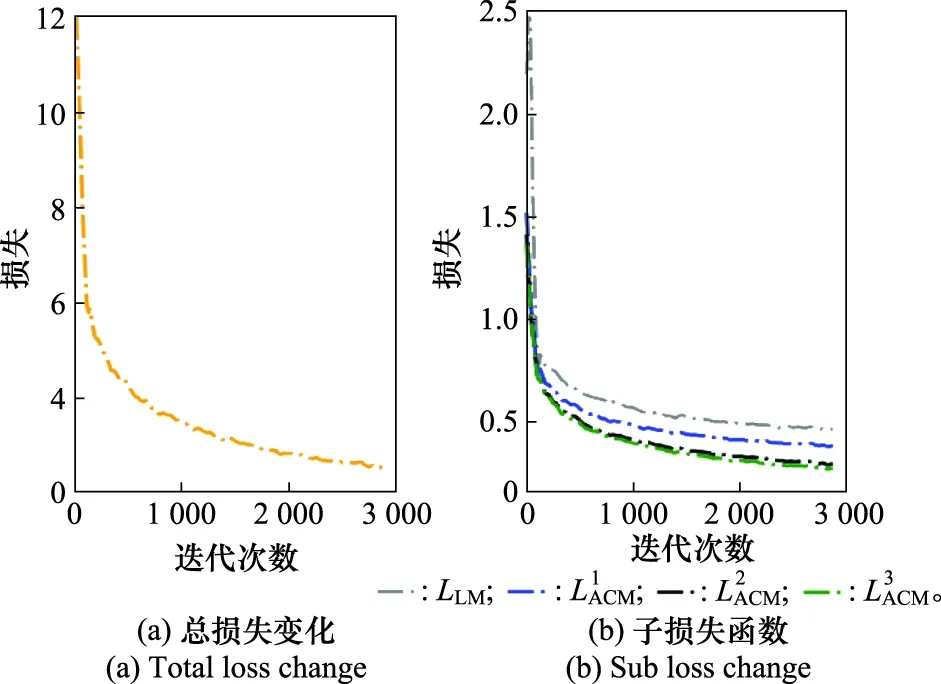

實施細節(jié)。本文的LCNet采用Pytorch實現(xiàn),訓(xùn)練和測試均使用一臺8核16線程的工作站,配備Intel i7-11700 CPU @2.5 GHz,32 GB RAM和2塊NVIDIA GeForce RTX 3090 GPU 24 GB。在訓(xùn)練和測試階段,圖像尺寸統(tǒng)一調(diào)整為416×416。隨機白噪聲以及圖像隨機翻轉(zhuǎn)被用于在訓(xùn)練階段進行數(shù)據(jù)擴增。主主干網(wǎng)采用由ResNet-50模型在ImageNet上進行預(yù)訓(xùn)練獲得的權(quán)重來初始化,其余參數(shù)通過隨機方式初始化。本文批量載入圖像的數(shù)量為64,采用Adam優(yōu)化器進行梯度下降處理,遍歷樣本45輪耗時約56 min,訓(xùn)練過程損失變化見圖5。圖5(a)為總損失變化,圖5(b)為對應(yīng)的4個子損失函數(shù)(式12),

可看出本文方法在訓(xùn)練階段以較快的速度收斂。

圖5 訓(xùn)練損失曲線Fig.5 Training loss curve

2.2 方法對比

為驗證本文提出方法的分割性能,本文與6種最新的基于深度學(xué)習(xí)的目標(biāo)分割模型進行比較,并按照訓(xùn)練方案Ⅰ,使用原文推薦的參數(shù)來訓(xùn)練。借助指標(biāo)在測試集上進行效果評估,得到的比較效果如表1所示,其中標(biāo)注↑的指標(biāo)值越大越好,標(biāo)注↓的指標(biāo)值則相反。表1中最好的結(jié)果已加粗表示,而藍色字體為現(xiàn)有方法的最好值。由表1可以看到,在訓(xùn)練方案Ⅰ下,本文所提出的方法在各項指標(biāo)上均優(yōu)于現(xiàn)有方法。

為了進一步衡量本文方法的分割性能,對本文方法采取了方案Ⅱ的訓(xùn)練方式,實驗結(jié)果如表1的本文(Ⅱ)部分。可以看到,在COD10K、CAMO數(shù)據(jù)集上,本文方法的多個評估指標(biāo)結(jié)果仍高于6種最新方法的平均值(表1中綠色字體所示),體現(xiàn)了本文分割方法的高效性。而本文方法在CPD1K上效果欠缺明顯,主要原因在于CPD1K中包含較小樣本,與COD10K的數(shù)據(jù)分布差異較大。

圖6展示了本文方法與6種最新方法的分割效果定性對比。從左到右依次是原始圖像、分割真值圖像、本文方法的真值預(yù)測以及6種最新方法的真值預(yù)測。通過對比可以看出,本文方法的偽裝目標(biāo)分割結(jié)果與真值圖像最為一致,無論是大偽裝物體(第1、2、3、6行)還是小偽裝物體(第7、8行)以及背景復(fù)雜的偽裝物體(第4、8行)。本文方法的高分割精確性主要得益于主干強感知、雙注意力定位以及邊緣細節(jié)的層層補償,最終感知物體位置并合理劃分了歧義區(qū)域的像素。

圖6 本文提出的方法與6種最新方法的分割效果對比示例Fig.6 Comparison of segmentation result between the proposed method and the six latest methods

2.3 消融分析

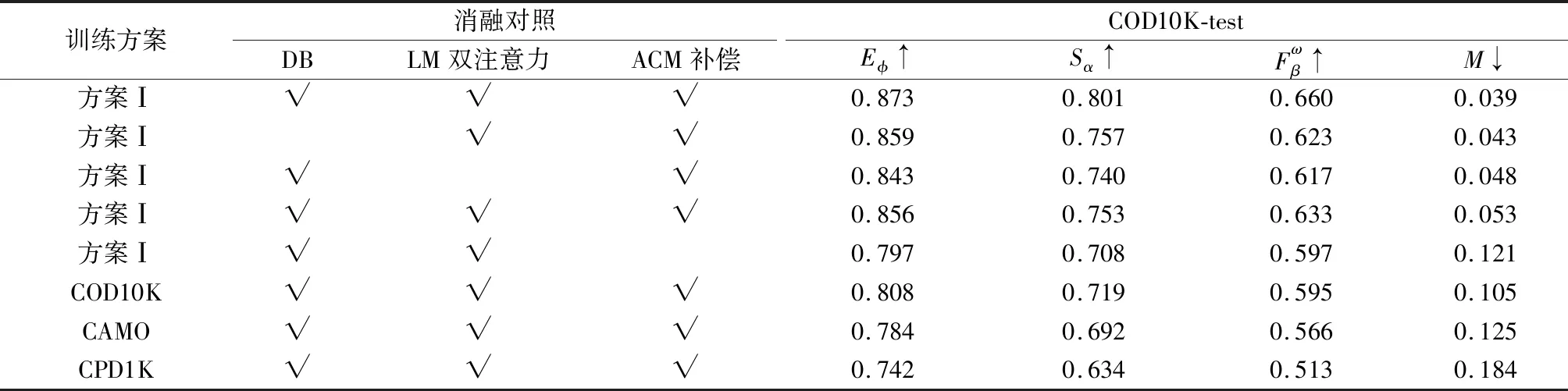

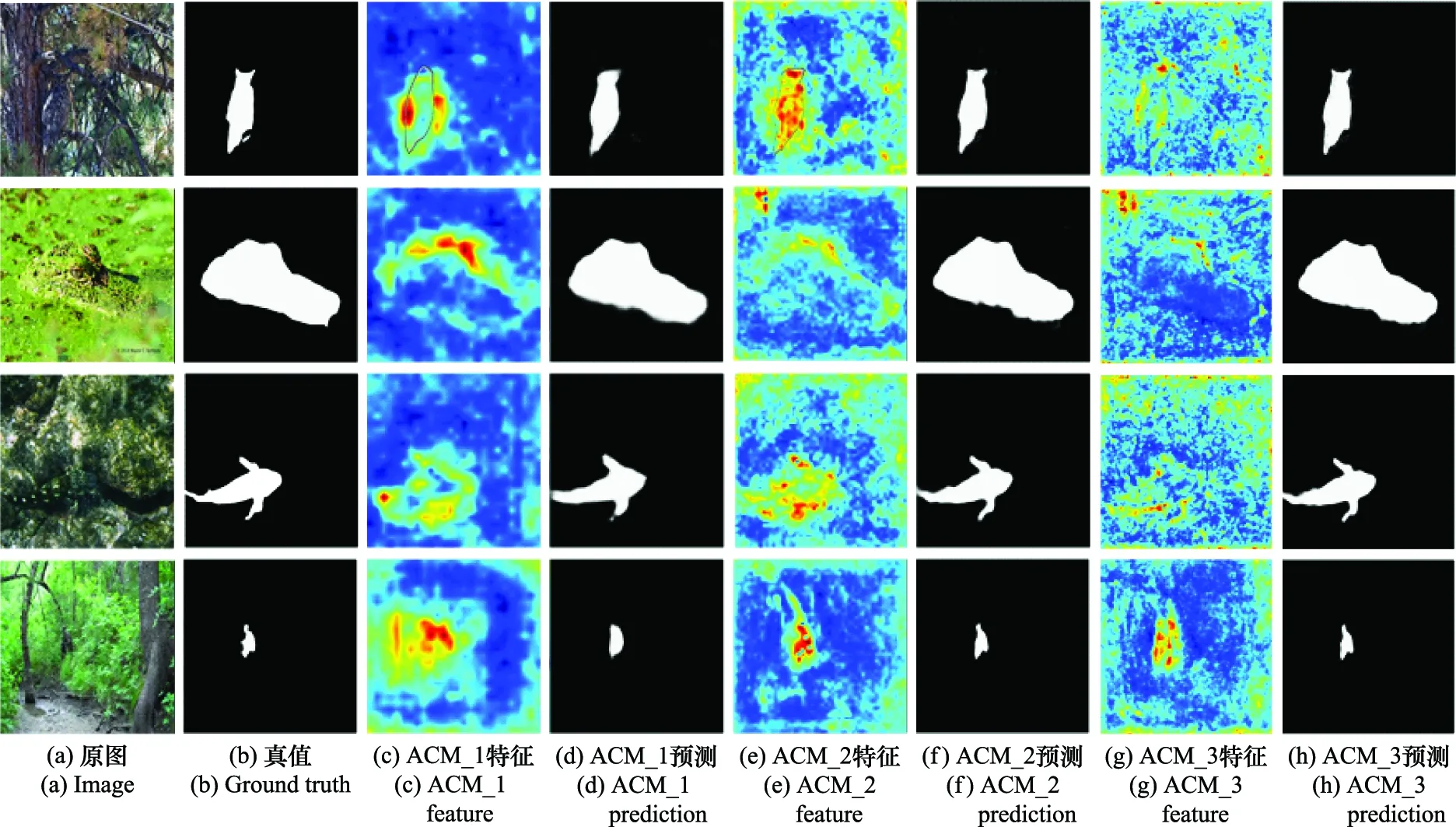

為驗證LCNet中DB、LM以及ACM等模塊的有效性,本文進行消融實驗對照,結(jié)果如表2所示。其中,未打“√”表示方法缺失該模塊。可以看出,在同一訓(xùn)練方案下,3個模塊的缺失均會顯著降低方法的分割表現(xiàn)。其中,ACM的影響最為顯著。為了進一步描述ACM如何影響分割效果,本文從定性的角度進行分析,如圖7所示。

圖7從左到右依次為原圖、真值,第1、2、3個ACM的預(yù)測特征圖以及預(yù)測真值。由圖7可以看出,隨著級聯(lián)ACM的作用,預(yù)測真值的歧義像素歸屬逐步細化。為了對比,在圖中第1行預(yù)測特征圖中,標(biāo)注出上一階段(LM或上一級ACM)的真值。通過與真實值的對比可直觀發(fā)現(xiàn)特征的改變:原本在LM作用下的貓頭鷹只關(guān)注到軀干的大體位置特征,在ACM_1的作用下,施加了對頭部與翅膀處的歧義區(qū)域的注意,補償缺失的前景與剔除背景的干擾,預(yù)測真值中多出右耳朵的模糊雛形(見圖7(d))。ACM_1輸出在ACM_2作用下細化貓頭鷹的左耳朵周圍的特征,使預(yù)測真值多出了左耳朵(見圖7(f))。而ACM_2輸出在ACM_3作用下,使預(yù)測值的左右耳朵變尖,進而更貼近真值(見圖7(h))。可以看出,在本文級聯(lián)ACM補償作用下,目標(biāo)細節(jié)特征逐步精準(zhǔn),具備較強的分割性能。

表2 消融實驗Table 2 Ablation experiment

圖7 級聯(lián)ACM的逐步細化Fig.7 Gradual refinement of cascading ACM

3 結(jié) 論

為克服偽裝目標(biāo)的前景與背景的高度相似性,本文提出一種基于定位和非對稱補償?shù)木W(wǎng)絡(luò)結(jié)構(gòu)LCNet,通過DB結(jié)構(gòu)強化對底層特征的感知提取,然后引入雙注意力的定位模塊對偽裝目標(biāo)位置進行初步確定,最后采用級聯(lián)的ACM,逐步細化歧義區(qū)域的像素歸屬。通過實驗表明,本文提出方法在3個公開數(shù)據(jù)集上達到最優(yōu)的分割性能。下一步,將改進模型并融入類別信息,以使偽裝物體研究在軍事、工業(yè)、農(nóng)學(xué)、醫(yī)學(xué)、生物學(xué)等領(lǐng)域具備更深廣的應(yīng)用潛力。