一種改進的U-Net網絡用于黑色素瘤病變分割研究

代楚航 文正洙

摘要:殘差網絡(ResNet)和密集連接網絡(DenseNet)顯著提高了深度卷積神經網絡(DCNNs)的訓練效率和性能,但二者存在識別連續特征能力不足、模型復雜等缺陷。密集殘差(DR-Net)網絡將殘差網絡與密集連接網絡的優異處結合起來,模型結構較DenseNet精簡,與ResNet相比,額外加入了的跳躍鏈接。研究將該方法集成到一個編碼器-解碼器DCNN模型中,用于圖像分割。利用ISIC2017挑戰測試集,得到訓練完成的DRU-Net卷積網絡評估指標。結果表明,與基于ResNet、基于DenseNet的方法相比,該研究方法獲得了更高的分割精度。

關鍵詞:卷積神經網絡;醫學圖像分割;黑色素瘤;DR-Net;ResNet;DenseNet

中圖分類號:TP183? ? ? 文獻標識碼:A

文章編號:1009-3044(2022)18-0001-02

開放科學(資源服務)標識碼(OSID):

1 引言

黑色素瘤作為一種常見且高危險性的皮膚癌,目前的檢測方法是在皮膚鏡下生成高分辨率的皮損圖像。但醫療資源緊張,癌變診斷耗時且對醫生專業素養要求極高,因此計算機輔助醫療顯得格為重要,而皮膚病變圖像分割在該診斷研究中占據尤其重要的位置。過去十年間,有如閾值處理、活動輪廓模型、監督學習等[1-2]算法被開發出來用于皮損圖像分割。但以上方法均有耗時、復雜、對醫學知識儲備要求較高等不足之處。由Long等人開發的一種用于語義分割[3]的全卷積網絡(Fully Convolutional Network,FCN),該模型DCNN反卷積層被卷積層替換,對標簽圖進行上采樣獲取每一特征像素的分類結果。2015,U-Net[4]這種新類FCN結構被Ronneberger等人提出,首次被應用于細胞圖像分割。目前提出的U-Net的幾種變體,主要集中于提高特征信息在層內和層間傳遞的分割精度和效率。

如,H-DenseU-Net[5]結合了密集連接的網絡[6]和U-Net的方法,用于三維肝臟和腫瘤分割。U-Net++[7]應用不同層間的密集跳躍連接,將編碼器與解碼器連接到一起。MDU-Net[8]提出在U-net中同時增加三個多尺度的密集連接,即密集編碼器、解碼器及其之間的連接。以往的研究,多通過集成復雜的網絡模塊獲得更好的性能,這需要學習更多參數。本研究對比殘差網絡與密集網絡的性能,提出一些改進。相較殘差網絡、密集網絡的方法,本研究的方法需要更少的模塊參數。

2 DRU-Net

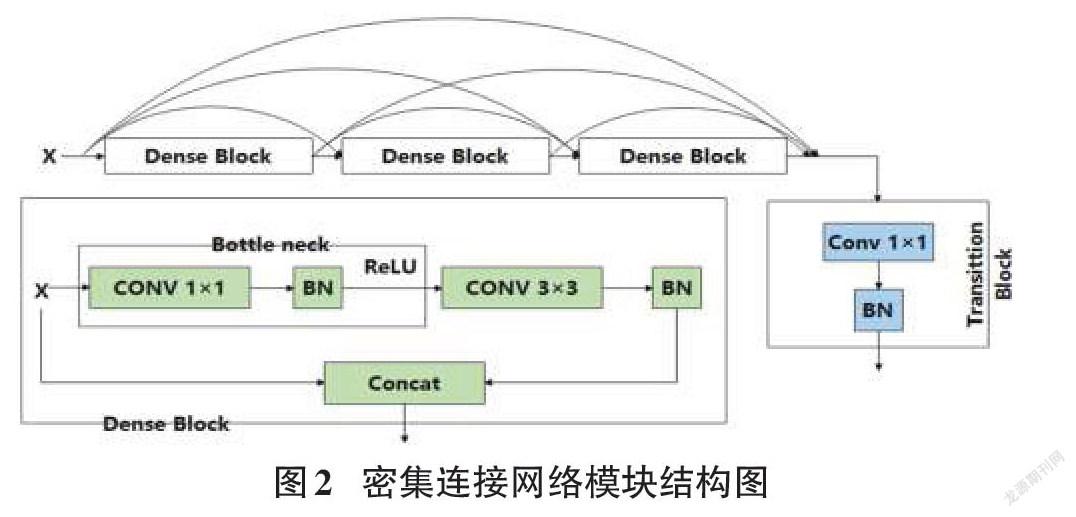

選擇U-Net作為不同網絡塊性能比較的基本結構。除了原始的U-Net之外,每一層都添加一個批規范化(BN),用于網絡模型實現更快更穩定的訓練任務。區別于傳統Conv-ReLU,ResNet在C-R-C-R的環節中加入了快速連接,如圖1所示。DenseNet結構由數個相互連接的密集塊組成,如圖2所示。每個密集塊的輸入,是當前所有密集塊的輸出與第一個密集塊的原始輸入連接的特征圖。

殘差連接原理是將輸入與輸出特征相加,密集連接模塊將之前連接模塊的輸出與原本輸入連接到一起。殘差網絡最大的不足之處是缺少先前卷積輸入的連續特征。而密集連接網絡可以從先前的卷積塊中提取特征,保證梯度有效傳輸的同時,融合更豐富的信息,在連續圖層中進行特征提取,但此方法需額外進行特征圖降維,高效特征圖合并的代價是額外的運算參數與繁雜的網絡結構。

綜合兩種兩個網絡的優缺點,DRU-Net在編碼器與解碼器中應用如圖3兩種方法。

研究將第一個Conv-BN操作的輸出和最后一個Conv-BN的輸出之間添加一個額外的連接(圖1中的圓形部分)進行特征圖求和操作。將編碼器中的第一個卷積與最后一個卷積結果做殘差連接,再與輸入連接得到合并輸出結果。在解碼器中,在第一個卷積塊與最后的卷積結果間,應用殘差連接操作,再與輸入經卷積1×1降維后的結果拼接,得到合并輸出結果。綜合兩種操作的模塊即為密集殘差模塊(DR)。研究將集成的密集殘差模塊(DR)應用到U-Net的編碼器和解碼器中,得到改進的DRU-Net網絡模型。基于上述修改,DRU-Net的總體方案如圖4所示。

3 實驗與結果

3.1 實驗數據集與運行環境

3.1.1 ISIC2017

本研究應用國際皮膚成像協作組織(ISIC)提供的開源黑色素瘤病變皮膚鏡圖像數據庫ISIC2017數據集。包含2000幅訓練圖片、150幅驗證圖片和600幅測試圖片,尺寸540×722~4499×6748。每幅圖像均包含人工標注。經裁剪翻轉等處理后,擴增為13000張,尺寸統一改為512×512。

3.1.2 運行環境

實驗的仿真平臺為Pycharm,利用TensorFlow框架對模型進行了訓練和測試。GPU為RTX2080Ti(11G),操作系統為Windows 10,編程語言Python3.7。對比模型的編碼器與解碼器路徑層數均為5。實驗選用Adam優化器,損失函數為交叉熵損失函數,初始學習率設為0.001。對ISIC2017數據集,所有方法均進行50次迭代訓練,批次大小為8。

3.2 算法評價指標

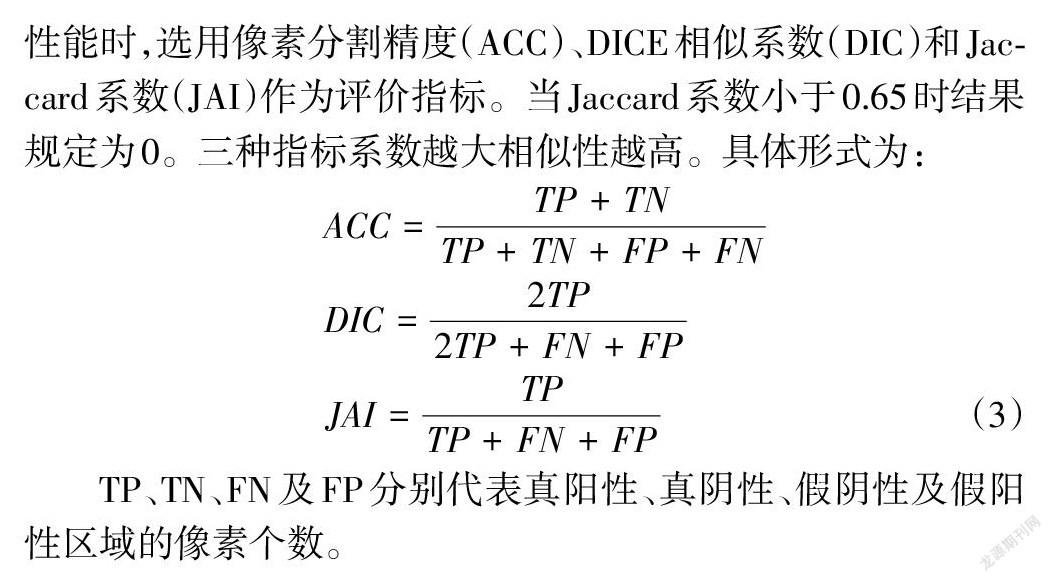

皮膚病圖像分割主要工作是分割病變區域,因此衡量算法性能時,選用像素分割精度(ACC)、DICE相似系數(DIC)和Jaccard系數(JAI)作為評價指標。當Jaccard系數小于0.65時結果規定為0。三種指標系數越大相似性越高。具體形式為:

[ACC=TP+TNTP+TN+FP+FN]

[DIC=2TP2TP+FN+FP]

[JAI=TPTP+FN+FP]? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ?(3)

TP、TN、FN及FP分別代表真陽性、真陰性、假陰性及假陽性區域的像素個數。

3.3 實驗結果

在ISIC 2017數據集分別對訓練好的U-Net、殘差U-Net網絡(RU-Net)、密集連接U-Net網絡(DU-Net)與改進DRU-Net網絡進行評估。實驗結果表1表明,U-Net的ACC精度,DIC系數與Jaccard系數值最低。在DIC、Jaccard與精度ACC方面,DU-Net的性能優于U-Net與RU-Net。對比本次實驗的其他網絡,本研究的改進DRU-Net在各項指標性能上均為最優。U-Net、RU-Net、DU-Net的可視化預測圖如圖5所示。可以看出,DRU-Net的分割結果,尤其是病變邊界周圍區域,與真實標簽更為接近。U-Net與RU-Net無法精確的分割病變邊界。

4 討論

本研究將基于編碼-解碼器結構的改進卷積網絡DRU-Net用于黑色素瘤病變分割任務。結合Dense-Net和Res-Net的優勢。將每一層的輸入到輸出進行連接,利用特征映射聚合的方?式,使得模型學習效率更高。通過在ISIC2017皮膚損傷數據集上評估U-Net,RU-Net,DU-Net與改進DRU-Net方法。本研究的改進DRU-Net具有顯著的優異性,尤其針對像素少、待分割區域面積小的皮損圖像。筆者只證明了改進DRU-Net在編碼器-解碼器DCNN模型中圖像分割精度的優異性。將此改進模型應用于其他具有更大數據集的適用性與優異性將會在之后的工作中研究。

參考文獻:

[1] Korotkov K,Garcia R.Computerized analysis of pigmented skin lesions:a review[J].Artificial Intelligence in Medicine,2012,56(2):69-90.

[2] Silveira M,Nascimento J C,Marques J S,et al.Comparison of segmentation methods for melanoma diagnosis in dermoscopy images[J].IEEE Journal of Selected Topics in Signal Processing,2009,3(1):35-45.

[3] Shelhamer E,Long J,Darrell T.Fully convolutional networks for semantic segmentation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(4):640-651.

[4] Ronneberger O,Fischer P,Brox T.U-net:convolutional networks for biomedical image segmentation[J/OL].[2015?05?18].https://arxiv.org/pdf/1505.04597.pdf.

[5] Li X M,Chen H,Qi X J,et al.H-DenseUNet:hybrid densely connected UNet for liver and tumor segmentation from CT volumes[J].IEEE Transactions on Medical Imaging,2018,37(12):2663-2674.

[6] Huang G,Liu Z,van der Maaten L,et al.Densely connected convolutional networks[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition.July 21-26,2017,Honolulu,HI,USA.IEEE,2017:2261-2269.

[7] Zhou Z W,Rahman Siddiquee M M,Tajbakhsh N,et al.UNet++:a nested U-net architecture for medical image segmentation[C]//Deep Learning in Medical Image Analysis and Multimodal Learning for Clinical Decision Support,2018:3-11.

[8] Zhang J W, Jin Y Z, Xu J L, et al, MDU-Net: Multi-scale Densely Connected U-Net for biomedical image segmentation[J] .10.48550/arXiv.1812.00352,2018.

【通聯編輯:唐一東】