基于元圖卷積的異質(zhì)網(wǎng)絡(luò)嵌入學(xué)習(xí)算法

任嘉睿 張海燕 朱夢(mèng)涵 馬 波

1(寧夏大學(xué)信息工程學(xué)院 銀川 750021)2(寧夏財(cái)經(jīng)職業(yè)技術(shù)學(xué)院 銀川 750021)

隨著各種社交媒體的廣泛流行,在虛擬社交網(wǎng)絡(luò)上產(chǎn)生了大量的交互數(shù)據(jù),虛擬社會(huì)網(wǎng)絡(luò)是現(xiàn)實(shí)社會(huì)的一種映射,從而分析和研究社會(huì)網(wǎng)絡(luò)為解決現(xiàn)實(shí)社會(huì)問(wèn)題提供了有效的方法.社會(huì)網(wǎng)絡(luò)呈現(xiàn)出圖網(wǎng)絡(luò)的結(jié)構(gòu)形式,圖網(wǎng)絡(luò)中的節(jié)點(diǎn)通常代表現(xiàn)實(shí)社會(huì)的諸多實(shí)體,邊代表節(jié)點(diǎn)之間的各種有意義的現(xiàn)實(shí)關(guān)系.圖神經(jīng)網(wǎng)絡(luò)[1]可將圖數(shù)據(jù)轉(zhuǎn)換為低維向量表示的方法,在處理高維圖數(shù)據(jù)方面具有優(yōu)勢(shì),且由于其在各種應(yīng)用領(lǐng)域處理圖數(shù)據(jù)顯示出的高效率,引起了廣泛的研究興趣,使其在推薦系統(tǒng)[2-3]、實(shí)體識(shí)別[4-5]、相似搜索[6-7]等領(lǐng)域發(fā)揮了重要作用.

已有許多的圖神經(jīng)網(wǎng)絡(luò)模型被提出,基于圖譜的圖神經(jīng)網(wǎng)絡(luò)模型,例如圖卷積網(wǎng)絡(luò)(graph con-volutional network, GCN)[8]、自適應(yīng)的圖卷積網(wǎng)絡(luò)(adaptive graph convolutional network, AGCN)[9],這類(lèi)模型是從圖信號(hào)處理的角度引入濾波器來(lái)定義圖卷積,對(duì)圖的傅里葉域進(jìn)行卷積運(yùn)算,以學(xué)習(xí)圖的嵌入表示.另一種基于圖上空間的圖神經(jīng)網(wǎng)絡(luò)模型,如GraphSAGE(graph sample and aggregate)[10]、圖注意力網(wǎng)絡(luò)(graph attention network, GAT)[11],通過(guò)聚集鄰居節(jié)點(diǎn)的信息來(lái)構(gòu)建圖卷積,得到目標(biāo)節(jié)點(diǎn)的聚合表示.但以上模型主要是針對(duì)同質(zhì)網(wǎng)絡(luò),即同種類(lèi)型的節(jié)點(diǎn)及邊類(lèi)型,對(duì)于包含多類(lèi)型節(jié)點(diǎn)及多維關(guān)系的異質(zhì)信息網(wǎng)絡(luò)將不再適用.

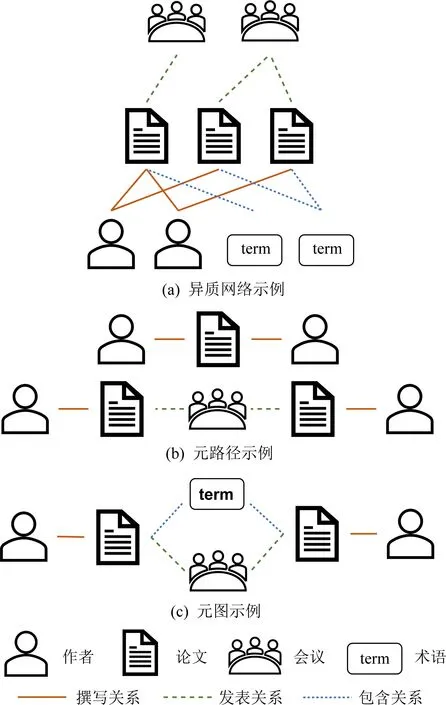

然而真實(shí)世界中的網(wǎng)絡(luò)數(shù)據(jù)大多都為異質(zhì)網(wǎng)絡(luò),例如引文網(wǎng)絡(luò)、交通網(wǎng)絡(luò)、蛋白質(zhì)網(wǎng)絡(luò)等.由于之前的圖神經(jīng)網(wǎng)絡(luò)模型無(wú)法挖掘出異質(zhì)網(wǎng)絡(luò)蘊(yùn)含的豐富語(yǔ)義信息和結(jié)構(gòu)信息,因此為了能夠處理異質(zhì)網(wǎng)絡(luò),許多工作都基于元路徑對(duì)異質(zhì)網(wǎng)絡(luò)進(jìn)行建模.元路徑是一種實(shí)體類(lèi)型和關(guān)系交替而成的序列,可以描述異質(zhì)圖中特有的語(yǔ)義信息.雖然現(xiàn)有的研究在處理異質(zhì)網(wǎng)絡(luò)以及社會(huì)計(jì)算的基本應(yīng)用任務(wù)上取得了一定的進(jìn)展,例如節(jié)點(diǎn)分類(lèi)和聚類(lèi)任務(wù),但仍存在一些局限:

1) 大多數(shù)模型的圖卷積層沒(méi)有充分利用異質(zhì)網(wǎng)絡(luò)中高階鄰居的信息.相比于同質(zhì)網(wǎng)絡(luò),在異質(zhì)網(wǎng)絡(luò)中對(duì)于要分類(lèi)或聚類(lèi)的同類(lèi)型節(jié)點(diǎn)不會(huì)直接相連,因此它們之間存在更高階的間接關(guān)系,而現(xiàn)有的模型很多只利用到了二階鄰居的信息,即“鄰居的鄰居”,如何挖掘節(jié)點(diǎn)之間的高階關(guān)系來(lái)學(xué)習(xí)更有效的網(wǎng)絡(luò)節(jié)點(diǎn)嵌入是非常重要的.

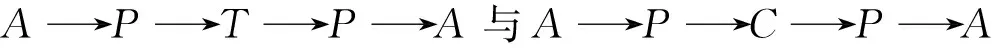

2) 單條元路徑無(wú)法準(zhǔn)確地反映出節(jié)點(diǎn)間的復(fù)雜語(yǔ)義.比如在引文網(wǎng)絡(luò)中,如果想要捕獲2個(gè)作者(Author)在同一會(huì)議(Conference)發(fā)表論文(Paper)的語(yǔ)義,同時(shí)又要滿(mǎn)足這2篇論文中出現(xiàn)了相同的關(guān)鍵術(shù)語(yǔ)(Term),即2篇論文研究的是相似的主題,這時(shí)僅靠一條元路徑Author→Paper→Conference→Paper→Author顯然無(wú)法滿(mǎn)足.雖然之前的很多工作使用元路徑來(lái)建模異質(zhì)網(wǎng)絡(luò),但如何融合多條元路徑上所包含的語(yǔ)義信息,仍是一個(gè)值得研究的問(wèn)題.

對(duì)于以上的局限以及挑戰(zhàn),本文提出了一種基于元圖卷積的異質(zhì)網(wǎng)絡(luò)嵌入學(xué)習(xí)算法MGCN(meta-graph convolutional network).元圖在文獻(xiàn)[12]和[13]中被用來(lái)計(jì)算異質(zhì)網(wǎng)絡(luò)中同類(lèi)型實(shí)體之間的相似度,是一種比元路徑能夠包含更多語(yǔ)義信息的異質(zhì)網(wǎng)絡(luò)表示模式.本文提出的算法利用元圖融合不同元路徑上的信息,挖掘異質(zhì)網(wǎng)絡(luò)中同類(lèi)型節(jié)點(diǎn)之間的高階間接關(guān)系.本文工作的主要貢獻(xiàn)有3個(gè)方面:

1) 引入元圖的概念,提出基于元圖的異構(gòu)鄰接矩陣計(jì)算方法,用以融合多條元路徑上的不同語(yǔ)義信息,挖掘節(jié)點(diǎn)間的高階間接關(guān)系,保留異質(zhì)網(wǎng)絡(luò)中的復(fù)雜語(yǔ)義信息.

2) 提出基于元圖卷積的異質(zhì)網(wǎng)絡(luò)嵌入學(xué)習(xí)算法MGCN,在不影響模型性能的情況下,相比于基于空間卷積的圖神經(jīng)網(wǎng)絡(luò)基線(xiàn)模型顯著縮短了訓(xùn)練時(shí)間.

3) 分別在DBLP,IMDB數(shù)據(jù)集上進(jìn)行了大量的實(shí)驗(yàn),結(jié)果說(shuō)明本文提出的MGCN在多個(gè)指標(biāo)上優(yōu)于基線(xiàn)模型.

1 相關(guān)工作

目前已有許多研究工作致力于借用元路徑對(duì)異質(zhì)網(wǎng)絡(luò)進(jìn)行建模.Sun等人[14]在2011年提出元路徑的概念用以處理異質(zhì)網(wǎng)絡(luò),他們提出的PathSim算法,通過(guò)計(jì)算2個(gè)節(jié)點(diǎn)間的元路徑實(shí)例的數(shù)量關(guān)系來(lái)衡量節(jié)點(diǎn)之間的相似性,可以捕獲對(duì)象間的相似性的細(xì)微之處.之后在2012年提出的PathSelClus算法[15],基于用戶(hù)的引導(dǎo)對(duì)元路徑進(jìn)行選擇,進(jìn)而對(duì)網(wǎng)絡(luò)中的對(duì)象進(jìn)行聚類(lèi),具體實(shí)現(xiàn)方法是首先為每個(gè)聚類(lèi)提供一個(gè)種子節(jié)點(diǎn),算法學(xué)習(xí)元路徑的權(quán)值,根據(jù)權(quán)值進(jìn)一步產(chǎn)生社區(qū).

針對(duì)PathSim沒(méi)有探索異質(zhì)網(wǎng)絡(luò)結(jié)構(gòu)中的相似性以及沒(méi)有生成頂點(diǎn)的嵌入向量這2個(gè)問(wèn)題, Shang等人[16]提出了ESim算法,結(jié)合給定的元路徑和網(wǎng)絡(luò)結(jié)構(gòu)來(lái)學(xué)習(xí)頂點(diǎn)嵌入向量,以更好地捕捉節(jié)點(diǎn)間的相似度.

Wang等人[17]借助注意力機(jī)制,提出了一種基于層次注意的異質(zhì)圖注意力網(wǎng)絡(luò)(heterogeneous graph attention network, HAN),包括節(jié)點(diǎn)級(jí)和語(yǔ)義級(jí)的注意力機(jī)制.節(jié)點(diǎn)級(jí)的注意力目的是為了挖掘基于元路徑的鄰居對(duì)該目標(biāo)節(jié)點(diǎn)的重要性,而語(yǔ)義級(jí)的注意力則能夠挖掘不同元路徑對(duì)目標(biāo)節(jié)點(diǎn)的重要性.然后,該模型通過(guò)分層聚合基于元路徑的鄰居的特征來(lái)生成節(jié)點(diǎn)嵌入,用于下游任務(wù).

但HAN在聚合基于元路徑的鄰居信息過(guò)程中,只考慮了由元路徑連接的頭尾2個(gè)節(jié)點(diǎn),拋棄了元路徑上中間節(jié)點(diǎn)的信息.針對(duì)這個(gè)限制,F(xiàn)u等人[18]提出了一種基于元路徑的聚合圖神經(jīng)網(wǎng)絡(luò)(meta-graph aggregated graph neural network, MAGNN).具體來(lái)說(shuō),MAGNN使用了3個(gè)主要組件,其中節(jié)點(diǎn)內(nèi)容轉(zhuǎn)換用以封裝輸入節(jié)點(diǎn)的屬性,元路徑內(nèi)聚合用來(lái)合并元路徑上的中間語(yǔ)義節(jié)點(diǎn),最后元路徑間聚合組件合并來(lái)自多條元路徑的信息.但由于需要為每個(gè)目標(biāo)節(jié)點(diǎn)計(jì)算多頭注意力,以及在模型訓(xùn)練過(guò)程中需要計(jì)算大量的元路徑,因此HAN以及MAGNN這2個(gè)模型需要很大的訓(xùn)練時(shí)間以及資源.為了避免選擇大量的元路徑,Zhao等人[19]提出了一種基于元路徑的高階異質(zhì)圖卷積網(wǎng)絡(luò)(higher-order heterogeneous graph convolutional network, HOHGCN),他們?cè)O(shè)計(jì)了一種基于高階元路徑的鄰接矩陣計(jì)算方法,在消息傳遞的每一步,線(xiàn)性地聚合來(lái)自高階元路徑鄰居的信息.但該模型對(duì)于具有多種節(jié)點(diǎn)和邊類(lèi)型的異質(zhì)圖,必須使用較大的嵌入維數(shù)來(lái)編碼來(lái)自各種高階元路徑的信息,會(huì)導(dǎo)致大量的矩陣運(yùn)算,從而影響計(jì)算效率.

這些基于圖神經(jīng)網(wǎng)絡(luò)的方法已經(jīng)在學(xué)習(xí)異質(zhì)網(wǎng)絡(luò)嵌入表示方面取得了一定的進(jìn)展,但對(duì)于挖掘節(jié)點(diǎn)間高階的間接關(guān)系以及對(duì)多條元路徑的融合方案上,仍有改進(jìn)的空間.

2 概念定義

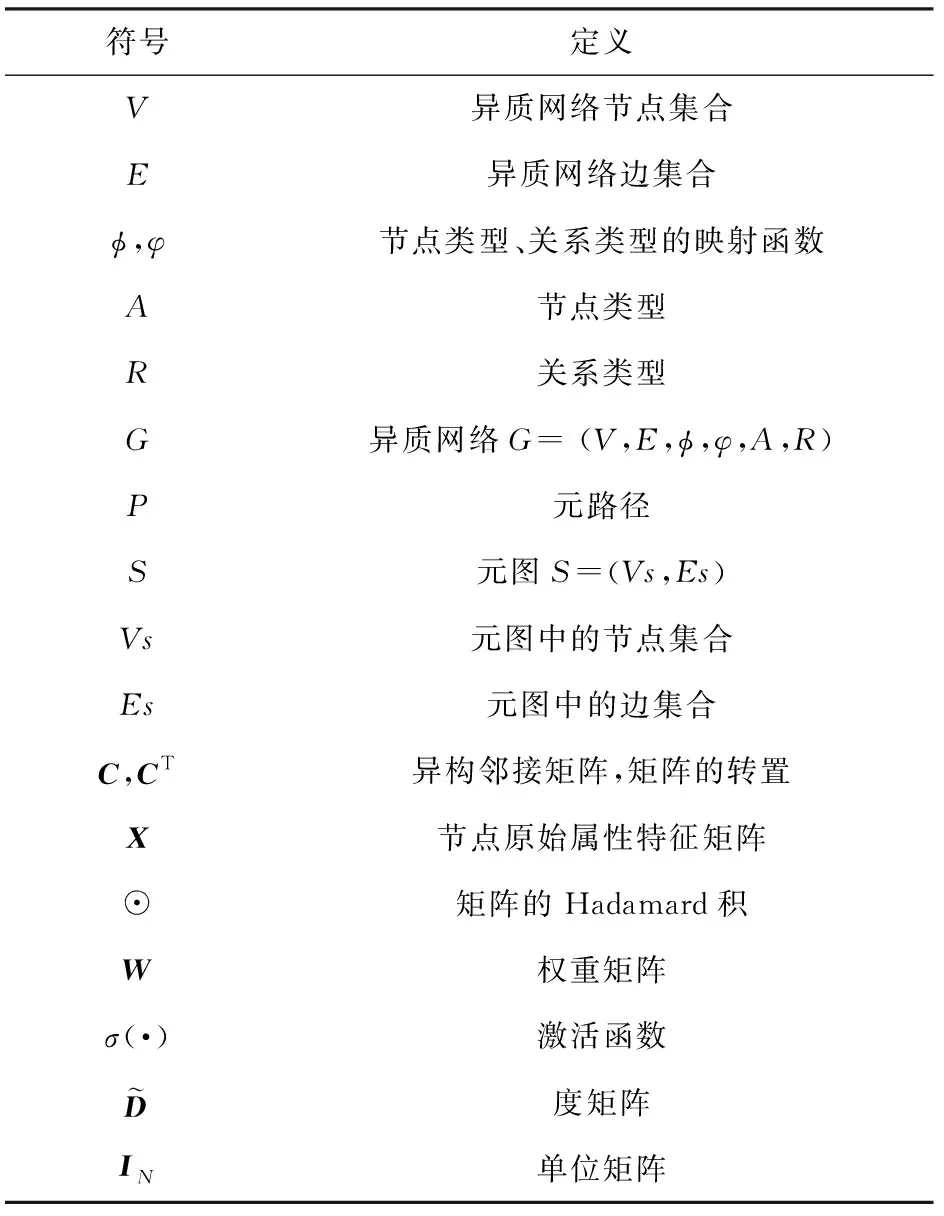

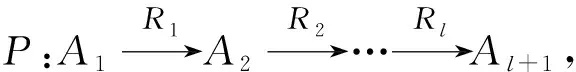

本節(jié)介紹相關(guān)概念及定義,本文使用的符號(hào)如表1所示:

Table 1 Notation Explanation Table表1 符號(hào)對(duì)照表

定義1.異質(zhì)網(wǎng)絡(luò)[20].異質(zhì)網(wǎng)絡(luò)被定義為有向圖G=(V,E,φ,φ,A,R),其中V代表節(jié)點(diǎn)集,E代表邊集.對(duì)于每個(gè)節(jié)點(diǎn)v∈V和邊e∈E,都有其到各自對(duì)象類(lèi)型的映射函數(shù)φ(v):V→A和φ(e):E→R,其中A和R分別表示節(jié)點(diǎn)類(lèi)型和關(guān)系類(lèi)型,且|A|+|R|>2.

圖1(a)是一個(gè)在DBLP引文網(wǎng)絡(luò)中異質(zhì)網(wǎng)絡(luò)的例子,該異質(zhì)網(wǎng)絡(luò)擁有4個(gè)節(jié)點(diǎn)類(lèi)型,即作者(Author)、論文(Paper)、會(huì)議(Conference)和論文中出現(xiàn)的關(guān)鍵術(shù)語(yǔ)(Term),以及3個(gè)關(guān)系類(lèi)型,即作者撰寫(xiě)論文(Author→Paper)、論文發(fā)表在會(huì)議(Paper→Conference)和論文中包含某個(gè)關(guān)鍵術(shù)語(yǔ)(Paper→Term).由此可見(jiàn),異質(zhì)網(wǎng)絡(luò)不僅包括多種類(lèi)型的對(duì)象,還提供了豐富的高級(jí)語(yǔ)義.

Fig. 1 An example of related concepts in a heterogeneous network圖1 異質(zhì)網(wǎng)絡(luò)中相關(guān)概念的示例

定義3.元圖[13].一個(gè)元圖S被定義為一個(gè)有向無(wú)環(huán)圖,只有一個(gè)源節(jié)點(diǎn)(入度為0)和一個(gè)目標(biāo)節(jié)點(diǎn)(出度為0).具體地,S=(Vs,Es),其中Vs為節(jié)點(diǎn)的集合,Es為邊的集合.對(duì)于每個(gè)節(jié)點(diǎn)v∈Vs,都有φ(v)∈A.同理,對(duì)于每條邊e∈Es,都有φ(e)∈R.

CP=CA1A2?CA2A3?…?CAl-1Al,

(1)

3 基于元圖卷積的異質(zhì)網(wǎng)絡(luò)嵌入學(xué)習(xí)算法

由于GCN具有很強(qiáng)的聚合圖中鄰居節(jié)點(diǎn)信息的能力,本文基于GCN設(shè)計(jì)了元圖卷積算法模型MGCN.本節(jié)對(duì)提出的MGCN算法框架進(jìn)行介紹,并詳細(xì)描述基于元圖的異構(gòu)鄰接矩陣的計(jì)算方法,以及MGCN的圖卷積網(wǎng)絡(luò)層的學(xué)習(xí)節(jié)點(diǎn)嵌入表示的過(guò)程.

3.1 算法框架描述

為了對(duì)異質(zhì)網(wǎng)絡(luò)中多條元路徑上的語(yǔ)義信息進(jìn)行有效融合,本文提出的基于元圖卷積的異質(zhì)網(wǎng)絡(luò)嵌入學(xué)習(xí)算法MGCN,能夠保存比單條元路徑更復(fù)雜的語(yǔ)義信息.

在以往學(xué)習(xí)異質(zhì)網(wǎng)絡(luò)中的語(yǔ)義信息和結(jié)構(gòu)信息時(shí),通常先將異質(zhì)網(wǎng)絡(luò)轉(zhuǎn)化為同質(zhì)網(wǎng)絡(luò),即將對(duì)稱(chēng)元路徑的頭尾節(jié)點(diǎn)直接進(jìn)行連接,忽略元路徑上的中間節(jié)點(diǎn),將異質(zhì)網(wǎng)絡(luò)簡(jiǎn)化為一個(gè)新的只有同類(lèi)型節(jié)點(diǎn)的同質(zhì)網(wǎng)絡(luò),然后利用圖神經(jīng)網(wǎng)絡(luò)模型學(xué)習(xí)節(jié)點(diǎn)嵌入.然而,僅使用孤立的單條元路徑無(wú)法對(duì)一些特定復(fù)雜語(yǔ)義進(jìn)行有效的描述,即割裂了多條元路徑之間的潛在聯(lián)系,因此,需要對(duì)多條元路徑上包含的不同的語(yǔ)義信息進(jìn)行融合,本文利用元圖對(duì)多條元路徑上的語(yǔ)義信息進(jìn)行融合,該過(guò)程將整條元路徑上的所有節(jié)點(diǎn)信息都計(jì)算在內(nèi).

該算法主要包括2個(gè)階段:1)異構(gòu)鄰接矩陣的計(jì)算;2)節(jié)點(diǎn)嵌入表示學(xué)習(xí).整體框架如圖2所示.首先計(jì)算基于元圖的異構(gòu)鄰接矩陣,該矩陣含有目標(biāo)節(jié)點(diǎn)間基于元路徑的高階語(yǔ)義信息,并融合了不同元路徑上的復(fù)雜語(yǔ)義,之后將歸一化后的異構(gòu)鄰接矩陣與目標(biāo)節(jié)點(diǎn)的屬性特征矩陣輸入MGCN的卷積層,MGCN使用了2層的圖卷積網(wǎng)絡(luò),學(xué)習(xí)節(jié)點(diǎn)的嵌入表示,并將該嵌入表示應(yīng)用于社會(huì)計(jì)算的下游任務(wù)中.

Fig. 2 The overall architecture of MGCN圖2 MGCN總體框架

3.2 基于元圖的異構(gòu)鄰接矩陣

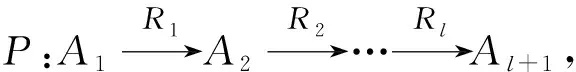

為了更清楚地解釋元圖的概念,本文選取DBLP數(shù)據(jù)集中的部分?jǐn)?shù)據(jù)來(lái)說(shuō)明,如圖3所示,S1,S2,S3表示DBLP中的3條元路徑,它們都可以看作是一種特殊的元圖.S4和S5表示元圖,可以看到它們都是有向無(wú)環(huán)圖,具體地,以元圖S5來(lái)說(shuō)明基于元圖的異構(gòu)鄰接矩陣的計(jì)算問(wèn)題.

Fig. 3 Meta-graph used for DBLP datasets圖3 DBLP數(shù)據(jù)集元圖示例

為了計(jì)算基于該元圖的異構(gòu)鄰接矩陣,并融合這2條元路徑上不同的語(yǔ)義信息,本文對(duì)這2條元路徑未重合的子結(jié)構(gòu)部分的異構(gòu)鄰接矩陣進(jìn)行Hadamard乘積來(lái)融合不同的語(yǔ)義信息,之后再通過(guò)矩陣乘法得到包含元圖復(fù)雜語(yǔ)義的異構(gòu)鄰接矩陣.基于元圖S5的異構(gòu)鄰接矩陣具體計(jì)算過(guò)程如算法1所示,⊙表示矩陣的Hadamard積.此基于元圖的異構(gòu)鄰接矩陣,不僅包含了節(jié)點(diǎn)間基于元路徑的高階語(yǔ)義信息,還融合了不同元路徑之間的語(yǔ)義信息,在挖掘異質(zhì)網(wǎng)絡(luò)節(jié)點(diǎn)間的高階關(guān)系和多條元路徑語(yǔ)義的融合方案上提供了新的思路.

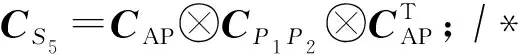

算法1.基于元圖S5的異構(gòu)鄰接矩陣計(jì)算.

輸入:不同類(lèi)型節(jié)點(diǎn)間的鄰接矩陣CAP,CPC,CPT;

輸出:基于元圖S5的異構(gòu)鄰接矩陣CS5.

① https://dblp.uni-trier.de/

② https://www.imdb.com/

③CP1P2=CP1⊙CP2;/*計(jì)算CP1P2*/

⑤ returnCS5./*返回結(jié)果*/

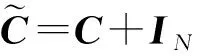

3.3 MGCN節(jié)點(diǎn)嵌入學(xué)習(xí)過(guò)程

在異質(zhì)網(wǎng)絡(luò)中,節(jié)點(diǎn)彼此之間的連接分布不均勻,導(dǎo)致部分節(jié)點(diǎn)擁有大量的鄰居節(jié)點(diǎn),部分節(jié)點(diǎn)的鄰居節(jié)點(diǎn)非常稀少,進(jìn)而導(dǎo)致鄰接矩陣內(nèi)部元素的差值非常巨大.所以在計(jì)算得到基于元圖的異構(gòu)鄰接矩陣C之后,和傳統(tǒng)的GCN類(lèi)似,本文對(duì)異構(gòu)鄰接矩陣C進(jìn)行度歸一化,降低異質(zhì)網(wǎng)絡(luò)中節(jié)點(diǎn)鄰居數(shù)量不一致的影響,具體計(jì)算方法:

(2)

(3)

其中,H(l)∈N×D表示第l層的輸出,H(0)=X為節(jié)點(diǎn)的原始屬性特征矩陣,W(l)表示特定層的可訓(xùn)練權(quán)重矩陣,σ(·)表示一個(gè)激活函數(shù),本文使用函數(shù)ReLU(·)=max(0,· ).

整個(gè)正向傳播過(guò)程如算法2所示.行①②表示基于輸入的元圖利用算法1中的計(jì)算方法,計(jì)算相應(yīng)的異構(gòu)鄰接矩陣,行③表示選擇輸入到圖卷積層的異構(gòu)鄰接矩陣Cs,行④~⑦表示計(jì)算每個(gè)節(jié)點(diǎn)v∈V的低維嵌入表示zv的過(guò)程.

算法2.異質(zhì)網(wǎng)絡(luò)嵌入學(xué)習(xí)算法MGCN.

輸入:異質(zhì)網(wǎng)絡(luò)G=(V,E,φ,φ,A,R),元圖集合S,層數(shù)L,節(jié)點(diǎn)原始屬性特征矩陣X;

輸出:節(jié)點(diǎn)的低維嵌入表示{zv,?v∈V}.

① forsinSdo/*處理元圖*/

使用算法1計(jì)算基于元圖s的異構(gòu)鄰接矩陣Cs;

② end for/*終止循環(huán)*/

③ 選擇異構(gòu)鄰接矩陣Cs;

④ forl=1…Ldo

/*多層圖卷積層計(jì)算節(jié)點(diǎn)嵌入向量*/

⑥ end for/*終止循環(huán)*/

⑦ returnzv←H(L),?v∈V.

/*返回輸出結(jié)果*/

4 實(shí) 驗(yàn)

本節(jié)詳細(xì)介紹實(shí)驗(yàn)過(guò)程中使用的數(shù)據(jù)集、對(duì)比的基準(zhǔn)方法與實(shí)驗(yàn)度量標(biāo)準(zhǔn),同時(shí)展示實(shí)驗(yàn)結(jié)果并對(duì)該結(jié)果進(jìn)行分析.

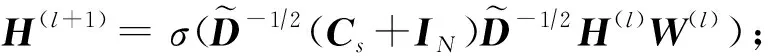

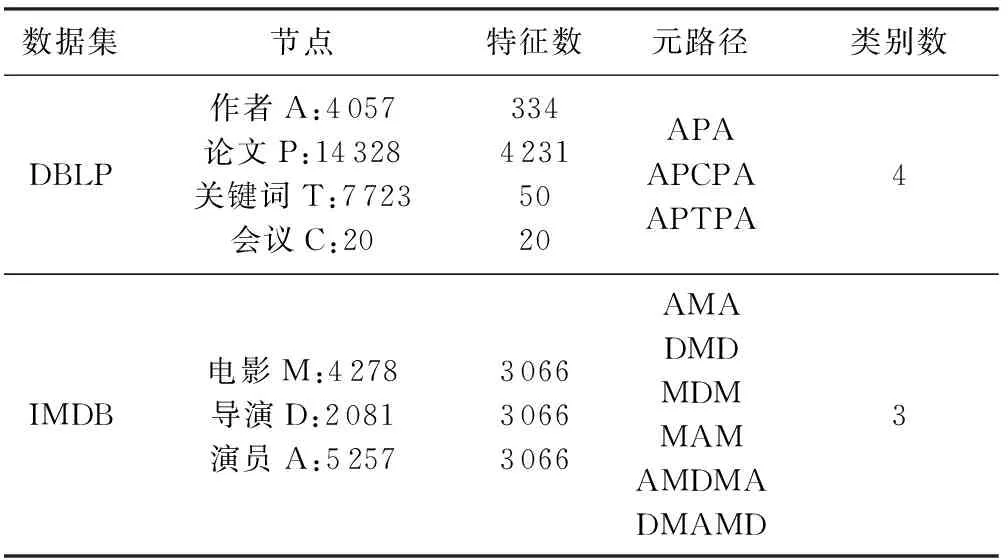

4.1 實(shí)驗(yàn)數(shù)據(jù)集

為了評(píng)估提出的MGCN的有效性,本文采用來(lái)自不同領(lǐng)域的2種廣泛使用的異質(zhì)網(wǎng)絡(luò)數(shù)據(jù)集,即DBLP和IMDB數(shù)據(jù)集,之后針對(duì)這2個(gè)數(shù)據(jù)集本文進(jìn)行節(jié)點(diǎn)分類(lèi)與節(jié)點(diǎn)聚類(lèi)實(shí)驗(yàn),表2總結(jié)了2個(gè)數(shù)據(jù)集的相關(guān)統(tǒng)計(jì)信息.

Table 2 Statistics of Datasets表2 數(shù)據(jù)集統(tǒng)計(jì)信息

1) DBLP數(shù)據(jù)集①.DBLP是計(jì)算機(jī)領(lǐng)域內(nèi)一個(gè)英文文獻(xiàn)的集成網(wǎng)站.本文采用與文獻(xiàn)[18]相同的DBLP數(shù)據(jù)集,該數(shù)據(jù)集是文獻(xiàn)[21]提取的DBLP子集,整個(gè)數(shù)據(jù)集包括4個(gè)計(jì)算機(jī)研究領(lǐng)域(數(shù)據(jù)庫(kù)、數(shù)據(jù)挖掘、人工智能和信息檢索)的文獻(xiàn)、作者以及學(xué)術(shù)會(huì)議信息.包括4 057個(gè)作者節(jié)點(diǎn)、14 328個(gè)論文節(jié)點(diǎn)、7 723個(gè)關(guān)鍵字節(jié)點(diǎn),以及20個(gè)學(xué)術(shù)會(huì)議節(jié)點(diǎn)(其中每個(gè)研究領(lǐng)域選擇5個(gè)學(xué)術(shù)會(huì)議).作者節(jié)點(diǎn)的屬性特征為他們所發(fā)表論文關(guān)鍵詞組成的詞袋,其中在對(duì)作者節(jié)點(diǎn)的分類(lèi)和聚類(lèi)任務(wù)中,訓(xùn)練集、驗(yàn)證集以及測(cè)試集的大小分別為400(9.86%),400(9.86%),3257(80.28%).

2) IMDB數(shù)據(jù)集②.IMDB是一個(gè)關(guān)于電影、電影演員和電影導(dǎo)演的在線(xiàn)數(shù)據(jù)庫(kù),包括影片的演員、內(nèi)容介紹、分級(jí)、評(píng)論等眾多信息.本文同樣使用與文獻(xiàn)[18]相同的IMDB數(shù)據(jù)集,包括3個(gè)類(lèi)型(動(dòng)作電影、喜劇電影和戲劇電影)的電影、導(dǎo)演以及演員信息.其中包括4 278個(gè)電影節(jié)點(diǎn)、2 081個(gè)導(dǎo)演節(jié)點(diǎn)、5 257個(gè)演員節(jié)點(diǎn).電影節(jié)點(diǎn)的屬性特征是描述電影情節(jié)的詞袋特征向量,對(duì)電影節(jié)點(diǎn)的分類(lèi)和聚類(lèi)任務(wù)中,訓(xùn)練集、驗(yàn)證集以及測(cè)試集的大小分別為400(9.86%),400(9.86%),3478(80.28%).

4.2 實(shí)驗(yàn)對(duì)比方法

為了更好地說(shuō)明本文提出的算法MGCN,選擇6種不同類(lèi)型的圖嵌入模型在節(jié)點(diǎn)分類(lèi)和節(jié)點(diǎn)聚類(lèi)任務(wù)比較各自的性能,包括傳統(tǒng)的經(jīng)典算法、基于圖神經(jīng)網(wǎng)絡(luò)的同質(zhì)網(wǎng)絡(luò)嵌入模型和異質(zhì)網(wǎng)絡(luò)嵌入模型:

1) Node2vec[22].一個(gè)基于傳統(tǒng)機(jī)器學(xué)習(xí)方法的同質(zhì)網(wǎng)絡(luò)嵌入模型,Node2vec是對(duì)DeepWalk[23]的拓展,引入有偏的隨機(jī)游走,使所選擇的隨機(jī)游走序列更有指向性.本文將其應(yīng)用在異質(zhì)網(wǎng)絡(luò)上,需要忽略圖結(jié)構(gòu)的異質(zhì)性,并清除所有節(jié)點(diǎn)上的屬性特征.

2) Metapath2vec[24].一個(gè)基于傳統(tǒng)機(jī)器學(xué)習(xí)方法的異質(zhì)網(wǎng)絡(luò)嵌入模型,該算法基于元路徑進(jìn)行隨機(jī)游走,使用skip-gram將節(jié)點(diǎn)映射為低維的嵌入向量,但元路徑的選擇需要用戶(hù)指定.

3) GCN[8].一個(gè)同質(zhì)圖神經(jīng)網(wǎng)絡(luò)模型,通過(guò)譜圖卷積學(xué)習(xí)節(jié)點(diǎn)的嵌入表示.本文中,在基于元路徑的同質(zhì)網(wǎng)絡(luò)上對(duì)GCN進(jìn)行實(shí)驗(yàn).

4) GAT[11].一個(gè)同質(zhì)圖神經(jīng)網(wǎng)絡(luò)模型,使用注意力機(jī)制為不同鄰居節(jié)點(diǎn)指定不同的權(quán)重,聚合鄰居節(jié)點(diǎn)上的信息.類(lèi)似地,本文在基于元路徑的同質(zhì)網(wǎng)絡(luò)上對(duì)GAT進(jìn)行實(shí)驗(yàn).

5) HAN[17].一個(gè)異質(zhì)圖神經(jīng)網(wǎng)絡(luò)模型,同樣使用注意力機(jī)制為多條元路徑分配不同的權(quán)重,融合多條元路徑上的信息,學(xué)習(xí)生成基于元路徑的節(jié)點(diǎn)嵌入表示.

6) MAGNN[18].一個(gè)異質(zhì)圖神經(jīng)網(wǎng)絡(luò)模型,可以看作是HAN的拓展,其將元路徑上的中間節(jié)點(diǎn)也計(jì)算在內(nèi),利用注意力機(jī)制學(xué)習(xí)得到最終的節(jié)點(diǎn)嵌入表示.

與文獻(xiàn)[18]相同,對(duì)于傳統(tǒng)的圖嵌入模型,包括Node2vec和Metapath2vec,本文將窗口大小設(shè)置為5,隨機(jī)游走的長(zhǎng)度設(shè)置為100,每個(gè)節(jié)點(diǎn)的隨機(jī)游走序列個(gè)數(shù)為40.對(duì)于基于圖神經(jīng)網(wǎng)絡(luò)的模型,包括GCN,GAT,HAN,MAGNN以及本文提出的MGCN,使用相同的訓(xùn)練集、驗(yàn)證集和測(cè)試集劃分方式,使用dropout率為0.5,權(quán)重衰減為0.001的Adam優(yōu)化器.對(duì)于節(jié)點(diǎn)分類(lèi)和節(jié)點(diǎn)聚類(lèi)任務(wù),使用一小部分有標(biāo)簽的節(jié)點(diǎn)以一種半監(jiān)督的方式訓(xùn)練.對(duì)于GAT,HAN和MAGNN,將多頭注意力的數(shù)量設(shè)置為8個(gè).特別地,對(duì)于HAN和MAGNN,將元路徑間聚合的注意力向量維數(shù)設(shè)置為128.為了便于實(shí)驗(yàn)的比較,本文將上述所有模型的嵌入維數(shù)都設(shè)置為64,訓(xùn)練輪次為100輪,并使用容忍度為30 輪的提前終止策略.

4.3 實(shí)驗(yàn)結(jié)果及分析

4.3.1 節(jié)點(diǎn)分類(lèi)

本文在DBLP和IMDB數(shù)據(jù)集上進(jìn)行了節(jié)點(diǎn)分類(lèi)任務(wù),比較不同的圖嵌入模型在不同數(shù)據(jù)集上的性能.對(duì)于2個(gè)數(shù)據(jù)集,本文分別對(duì)作者節(jié)點(diǎn)和電影節(jié)點(diǎn)進(jìn)行分類(lèi).具體方法是,將模型學(xué)習(xí)生成的節(jié)點(diǎn)嵌入表示輸入到一個(gè)可以應(yīng)用不同比例的數(shù)據(jù)進(jìn)行訓(xùn)練的SVM分類(lèi)器中.為了公平比較,本文只將測(cè)試集中的節(jié)點(diǎn)提供給SVM分類(lèi)器,即DBLP為3 257個(gè)作者節(jié)點(diǎn),IMDB為3 478個(gè)電影節(jié)點(diǎn),因?yàn)樵诎氡O(jiān)督模型的訓(xùn)練過(guò)程中,對(duì)訓(xùn)練集和驗(yàn)證集中的數(shù)據(jù)標(biāo)簽已經(jīng)知曉.

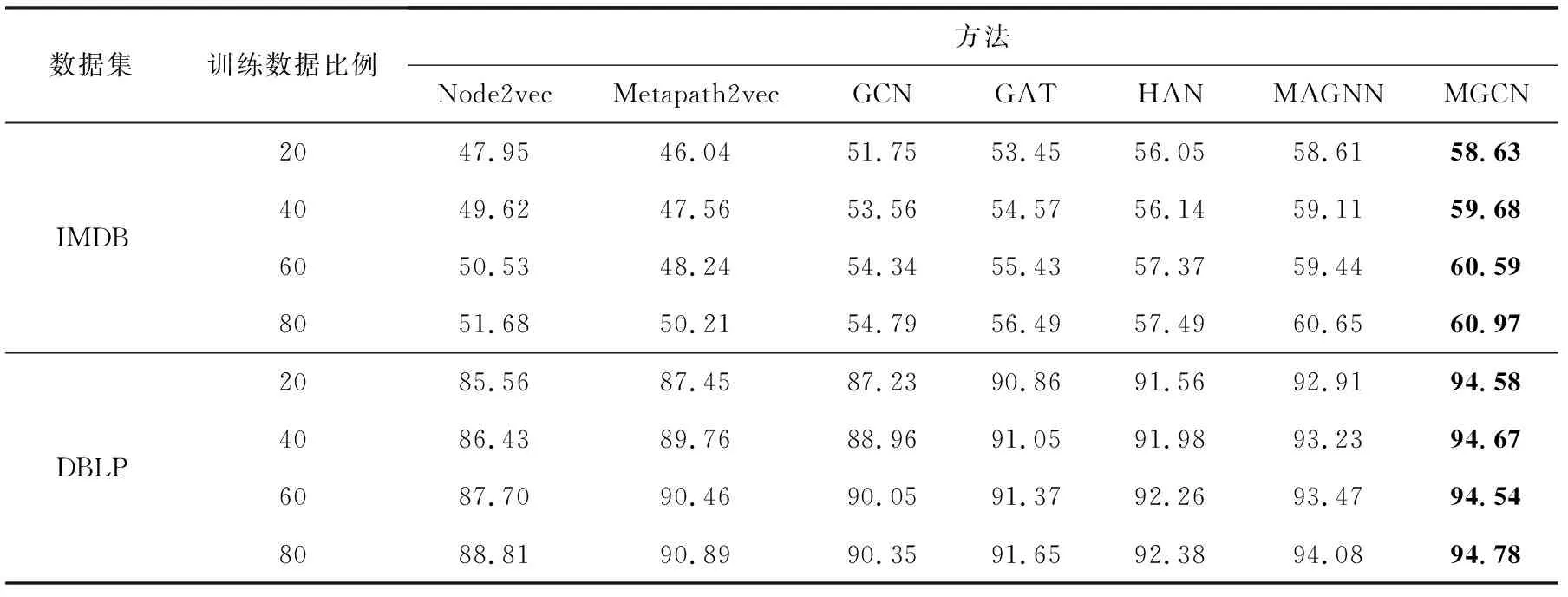

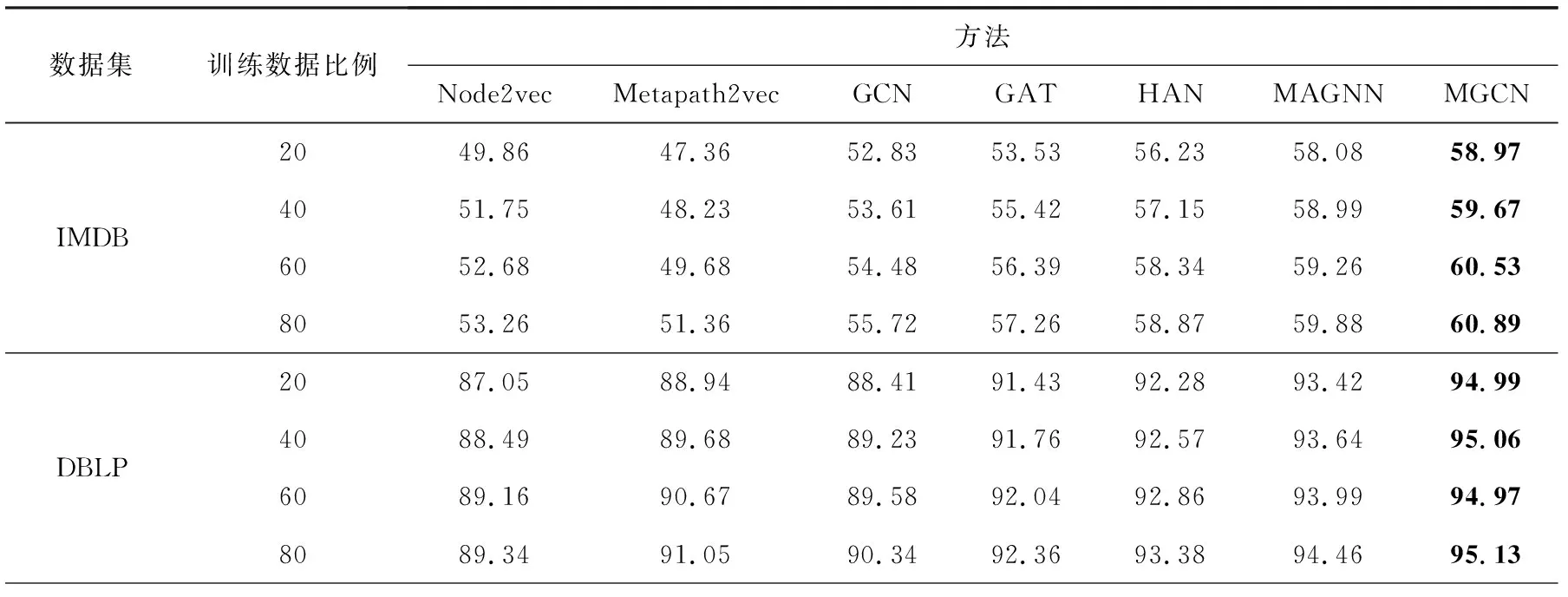

每個(gè)圖嵌入模型運(yùn)行10次的平均Macro-F1值和Micro-F1值如表3和表4所示,在不同比例的訓(xùn)練數(shù)據(jù)以及不同的數(shù)據(jù)集上,MGCN的分類(lèi)性能始終優(yōu)于其他基線(xiàn)模型.與最好的基線(xiàn)模型相比,對(duì)于DBLP數(shù)據(jù)集,在Macro-F1值和Micro-F1值上分別提高了0.7%和0.67%,同時(shí)對(duì)于IMDB數(shù)據(jù)集,分別提高了0.32%和1.01%.說(shuō)明本文所提出的算法能夠?qū)Σ煌窂缴系膹?fù)雜語(yǔ)義信息有效融合,且能夠有效利用節(jié)點(diǎn)間的高階間接關(guān)系.

Table 3 Experimental Results of Different Methods on Macro -F1 for Node Classification表3 節(jié)點(diǎn)分類(lèi)任務(wù)中不同方法在Macro -F1值上的實(shí)驗(yàn)結(jié)果對(duì)比 %

Table 4 Experimental Results of Different Methods on Micro -F1 for Node Classification表4 節(jié)點(diǎn)分類(lèi)任務(wù)中不同方法在Micro -F1值上的實(shí)驗(yàn)結(jié)果對(duì)比 %

其次,可以看到基于圖神經(jīng)網(wǎng)絡(luò)的深度圖嵌入模型要比傳統(tǒng)的圖嵌入模型Node2vec和Metapath2vec具有更好的分類(lèi)效果,說(shuō)明深層的模型具有更強(qiáng)的學(xué)習(xí)表達(dá)能力,能夠生成更有效的節(jié)點(diǎn)嵌入.以及異質(zhì)圖嵌入模型HAN,MAGNN和MGCN的性能要比同質(zhì)圖嵌入模型GCN和GAT更好,說(shuō)明異質(zhì)圖神經(jīng)網(wǎng)絡(luò)對(duì)圖中的復(fù)雜語(yǔ)義信息具有更強(qiáng)的捕獲及表達(dá)能力.

4.3.2 節(jié)點(diǎn)聚類(lèi)

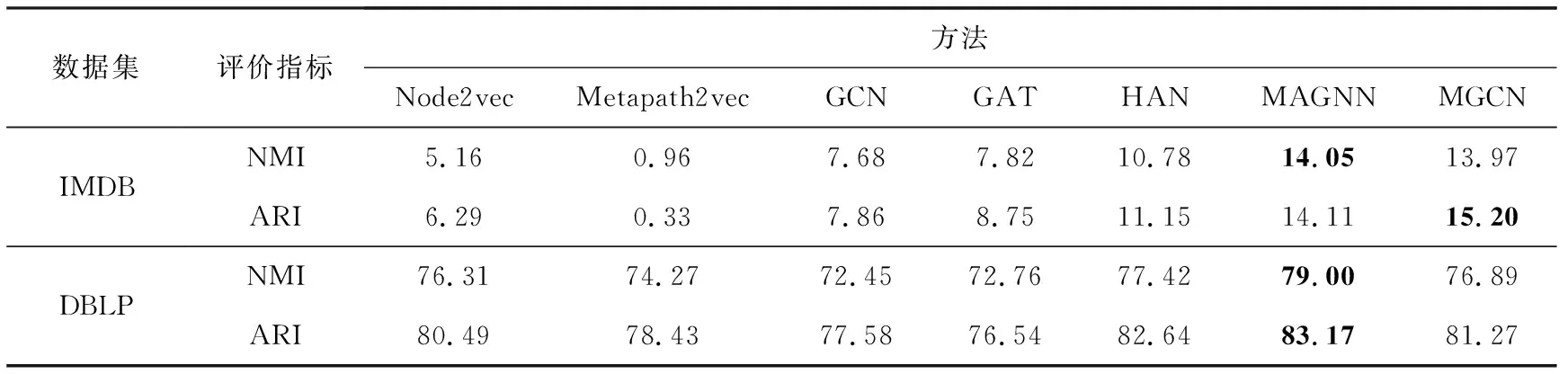

本文在DBLP和IMDB數(shù)據(jù)集上進(jìn)行了節(jié)點(diǎn)聚類(lèi)任務(wù),比較不同的圖嵌入模型在不同數(shù)據(jù)集上的性能.與分類(lèi)任務(wù)中的策略類(lèi)似,將測(cè)試集中的節(jié)點(diǎn)提供給HC層次聚類(lèi)器,對(duì)每個(gè)圖嵌入模型學(xué)習(xí)生成的節(jié)點(diǎn)嵌入表示進(jìn)行聚類(lèi)(DBLP中的作者節(jié)點(diǎn)和IMDB中的電影節(jié)點(diǎn)).本文采用NMI和ARI指數(shù)作為評(píng)價(jià)指標(biāo),將每個(gè)模型的節(jié)點(diǎn)嵌入在聚類(lèi)器運(yùn)行10次的平均結(jié)果記錄在表5內(nèi).

Table 5 Experimental Results of Different Methods for Node Clustering表5 節(jié)點(diǎn)聚類(lèi)任務(wù)中不同方法的實(shí)驗(yàn)結(jié)果對(duì)比 %

從聚類(lèi)結(jié)果可以看出,本文提出的MGCN優(yōu)于傳統(tǒng)的圖嵌入模型以及基于同質(zhì)圖神經(jīng)網(wǎng)絡(luò)的深度模型,原因是MGCN借助元圖卷積融合了不同元路徑上的高階語(yǔ)義信息.但在DBLP數(shù)據(jù)集上略低于2種異質(zhì)圖神經(jīng)網(wǎng)絡(luò)模型HAN和MAGNN,是因?yàn)镠AN和MAGNN利用多頭注意力機(jī)制從元路徑聚合鄰居節(jié)點(diǎn)的語(yǔ)義信息,而本文的算法基于GCN直接對(duì)包含不同元路徑語(yǔ)義信息的異構(gòu)鄰接矩陣做聚合.另外本文提出的MGCN利用GCN能夠聚合鄰居信息的優(yōu)勢(shì),收集目標(biāo)節(jié)點(diǎn)基于元圖的高階鄰居的信息,在損失函數(shù)的收斂性能以及模型的訓(xùn)練時(shí)間上要明顯優(yōu)于其他所有的基線(xiàn)方法,減少了因多頭注意力機(jī)制產(chǎn)生的計(jì)算開(kāi)銷(xiāo),具體對(duì)比結(jié)果在4.3.3節(jié)做詳細(xì)分析.

4.3.3 可視化

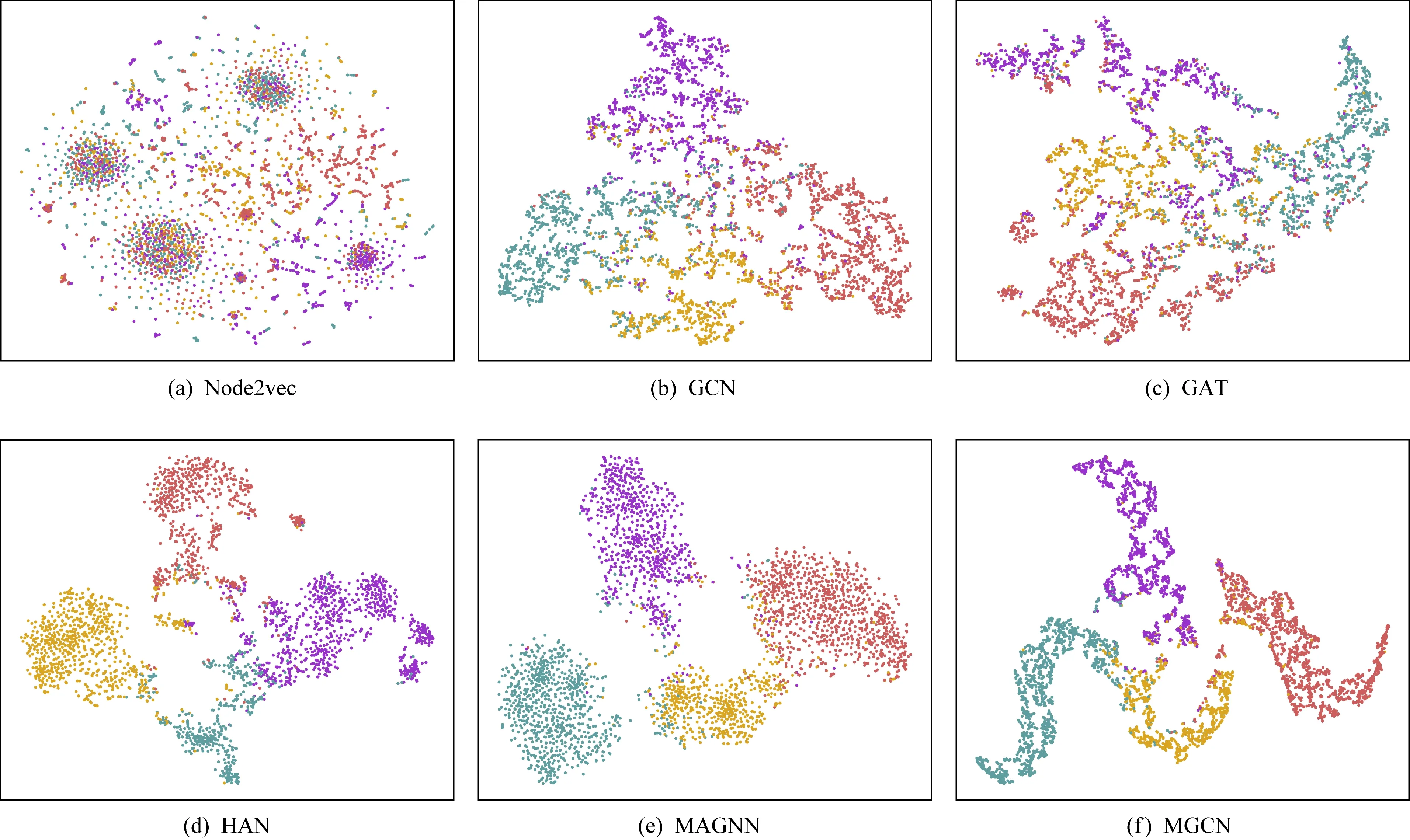

為了更直觀地比較,本文在圖4中展示了不同圖嵌入模型節(jié)點(diǎn)嵌入的可視化結(jié)果.首先使用不同的圖嵌入模型在DBLP數(shù)據(jù)集上學(xué)習(xí)作者節(jié)點(diǎn)的嵌入表示,之后本實(shí)驗(yàn)利用t-SNE方法對(duì)節(jié)點(diǎn)嵌入表示進(jìn)行降維,將學(xué)習(xí)到的嵌入表示投影到一個(gè)二維空間中得到二維的可視化結(jié)果,為每個(gè)作者節(jié)點(diǎn)確定一個(gè)坐標(biāo),并根據(jù)不同的研究領(lǐng)域?yàn)楣?jié)點(diǎn)確定不同的顏色.

從圖4可以看出,傳統(tǒng)的同質(zhì)網(wǎng)絡(luò)圖嵌入模型Node2vec不能很好地學(xué)習(xí)節(jié)點(diǎn)嵌入表示,可視化結(jié)果較為分散,不能有效區(qū)分不同類(lèi)別的節(jié)點(diǎn).與傳統(tǒng)模型相比,基于同質(zhì)圖神經(jīng)網(wǎng)絡(luò)的模型GCN和GAT,大致劃分出了每個(gè)研究領(lǐng)域的節(jié)點(diǎn),但4個(gè)區(qū)域的交界還是存在大量不同顏色節(jié)點(diǎn)相互混雜的情況.而與同質(zhì)圖神經(jīng)網(wǎng)絡(luò)模型相比,異質(zhì)圖神經(jīng)網(wǎng)絡(luò)模型HAN,MAGNN以及本文提出的MGCN,明顯優(yōu)于上述圖嵌入模型,能夠很好地將節(jié)點(diǎn)嵌入劃分為4個(gè)區(qū)域,且區(qū)域彼此之間邊界明顯.以上的分析結(jié)果表明,MGCN能夠?qū)W習(xí)到異質(zhì)網(wǎng)絡(luò)中有意義的節(jié)點(diǎn)嵌入表示,但與HAN和MAGNN不同,MGCN減少了因計(jì)算多頭注意力而花費(fèi)的訓(xùn)練時(shí)間.

Fig. 4 Embedding visualization of nodes on the DBLP dataset圖4 DBLP數(shù)據(jù)集上的節(jié)點(diǎn)嵌入表示可視化

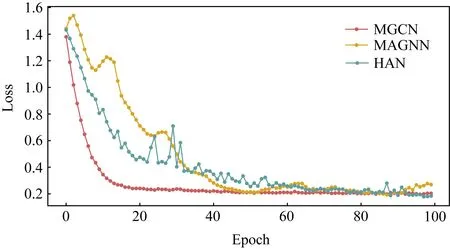

圖5顯示了MGCN與另外2種異質(zhì)圖神經(jīng)網(wǎng)絡(luò)模型HAN和MAGNN在訓(xùn)練過(guò)程中損失函數(shù)值收斂性能的具體對(duì)比,在100輪的訓(xùn)練中,可見(jiàn)MGCN的損失在第20輪之后就達(dá)到了一個(gè)穩(wěn)定的值,MAGNN在第50輪左右下降到局部最低,在60輪左右出現(xiàn)一個(gè)明顯的波動(dòng)之后也逐漸達(dá)到穩(wěn)定值,而HAN在第70輪之后才逐漸收斂.以上結(jié)果表明,本文提出的MGCN在損失函數(shù)值收斂的性能上要明顯優(yōu)于另外2種異質(zhì)圖神經(jīng)網(wǎng)絡(luò)模型HAN和MAGNN.

Fig. 5 Comparison of convergence performance of loss圖5 不同方法的損失函數(shù)收斂性能對(duì)比

如圖6所示,本文對(duì)比了MGCN,HAN以及MAGNN這3種異質(zhì)圖神經(jīng)網(wǎng)絡(luò)模型每輪次的平均訓(xùn)練時(shí)間.在100輪的訓(xùn)練中,可以看到MGCN每輪次的平均訓(xùn)練時(shí)間要明顯少于其他2種基線(xiàn)模型,為3.39 s,其次是HAN,每輪次的平均訓(xùn)練時(shí)間為13.04 s,訓(xùn)練時(shí)間最長(zhǎng)的是MAGNN,每輪次為23.64 s.在3個(gè)模型的訓(xùn)練過(guò)程中,采用了相同的提前終止策略,進(jìn)而MGCN能夠在損失函數(shù)收斂之后就可停止訓(xùn)練保存模型.以上結(jié)果表明在模型的訓(xùn)練時(shí)間上,本文提出的MGCN具有顯著的優(yōu)勢(shì).

Fig. 6 Comparison of average training time per epoch圖6 不同方法每輪平均訓(xùn)練時(shí)間對(duì)比

5 總 結(jié)

本文提出了一種基于元圖卷積的異質(zhì)網(wǎng)絡(luò)嵌入學(xué)習(xí)算法MGCN,設(shè)計(jì)了基于元圖的異構(gòu)鄰接矩陣計(jì)算方法,用以融合多條元路徑上的不同語(yǔ)義信息,挖掘節(jié)點(diǎn)間的高階間接關(guān)系,以解決單條元路徑無(wú)法對(duì)異質(zhì)網(wǎng)絡(luò)中的特定復(fù)雜語(yǔ)義進(jìn)行描述的困難.在實(shí)驗(yàn)中,MGCN在2個(gè)公開(kāi)的真實(shí)異質(zhì)網(wǎng)絡(luò)數(shù)據(jù)集的節(jié)點(diǎn)分類(lèi)等任務(wù)上取得了更好的性能以及更少的模型訓(xùn)練時(shí)間.未來(lái)的研究工作計(jì)劃將該模型應(yīng)用到具體的社區(qū)發(fā)現(xiàn)任務(wù)中,設(shè)計(jì)以節(jié)點(diǎn)聚類(lèi)為目標(biāo)導(dǎo)向的社區(qū)發(fā)現(xiàn)算法.