擁擠場景下的行人姿態(tài)估計研究*

任 超 趙 波 張偉偉

(上海工程技術(shù)大學(xué) 上海 201620)

1 引言

二維人體姿態(tài)估計一直是計算機視覺領(lǐng)域的一個基本問題。目標(biāo)是定位人體骨骼關(guān)鍵點(如肘部、腕部等)或部位。近年來,對于單個行人的姿態(tài),通過各個行人的預(yù)測框和骨骼關(guān)鍵點的位置來預(yù)測單個行人位姿,整體方法較簡單,預(yù)估姿態(tài)精度較低,且無法滿足行人擁擠環(huán)境。最近的工作解決多人姿態(tài)估計主要有自上向下和自下而上兩種方法[1~2]:1)自下而上方法,檢測關(guān)節(jié)并將關(guān)節(jié)與相對應(yīng)的行人聯(lián)系起來。Cao[3]等利用部分親和域和貪婪算法將關(guān)節(jié)關(guān)聯(lián)起來,帕潘德里歐等[4]檢測單獨的關(guān)節(jié)并且預(yù)測關(guān)節(jié)的相對位移,基于身體部分檢測方法由于只考慮局部小區(qū)域和輸出較小的響應(yīng)熱圖,所以輸出結(jié)果相對容易受到干擾;2)自上而下方法,該兩步法首先進行行人檢測[5~6],然后再進行單人姿態(tài)估計[7~8]。目前最先進方法評價得分明顯高于自下而上框架的方法。然而,該方法很大程度上依賴于人類的檢測結(jié)果,在擁擠的場景[9]中是失敗的。當(dāng)人們在人群中彼此靠得很近時,現(xiàn)有的姿態(tài)估計方法的效果急劇下降。

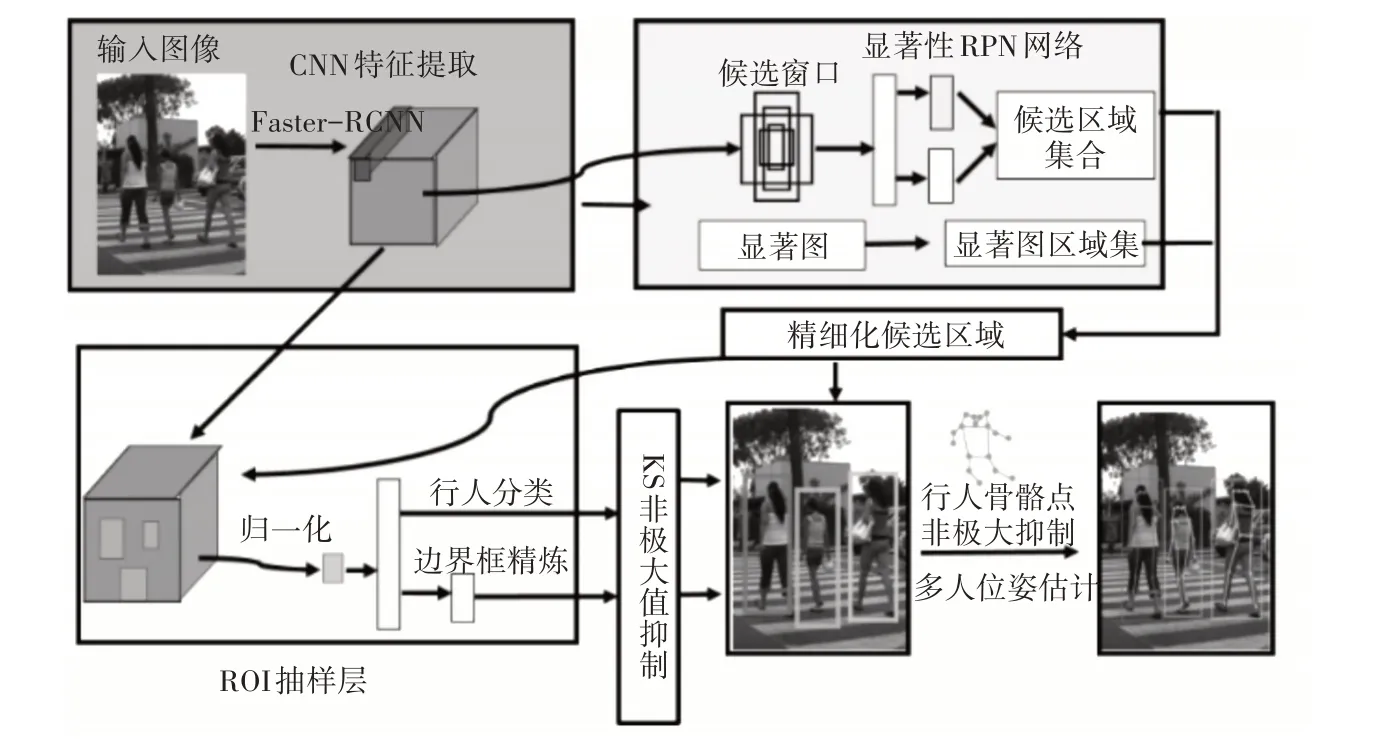

針對以上問題,本文提出了一種新的有效的解決擁擠狀態(tài)下多人檢測以及姿態(tài)估計的方法。該方法遵循自上而下的框架方法由兩部分組成,首先利用Faster-RCNN 行人檢測器預(yù)測出包含行人位置和大小相接近的多個矩形框,實現(xiàn)行人檢測。在第二階段,在行人檢測矩形框中預(yù)測行人每個關(guān)鍵點位置。在全卷積方式中應(yīng)用ResNet[10]預(yù)測每個關(guān)鍵點的熱力圖和偏移量,再與一種新的熱圖偏移量聚合形式相結(jié)合完成行人姿態(tài)預(yù)測。通過一種新的基于關(guān)鍵點的非最大抑制(NMS)機制避免重復(fù)位姿檢測(稱之為KS-NMS),提出一個新穎的基于關(guān)鍵點的置信度分?jǐn)?shù)預(yù)測器,最終預(yù)測結(jié)果與使用Faster-RCNN 框分?jǐn)?shù)相比較提高了平均精度(AP)。使用了基于骨骼關(guān)鍵點的非極大值抑制和熱力圖置信度分?jǐn)?shù)預(yù)測的新方式,最終輸出的行人姿態(tài)結(jié)果更加精確。

2 多人姿態(tài)估計方法

本文提出的多人姿態(tài)估計方法是基于自上而下框架的兩步級聯(lián)方法,如圖1 所示。第一步以Faster-RCNN 為特征提取的基礎(chǔ)結(jié)構(gòu),可以獲得輸入圖像的多通道高層低維特征表達。顯著性區(qū)域候選網(wǎng)絡(luò)(RPN)可以整合傳統(tǒng)RPN 網(wǎng)絡(luò)和顯著性區(qū)域搜索算法的優(yōu)勢,融合候選區(qū)域和顯著性區(qū)域,為獲得精細化候選區(qū)域奠定基礎(chǔ)。ROI 抽樣層在輸入圖像坐標(biāo)參考系范疇內(nèi),對深度卷積特征進行尺寸裁剪歸一化和坐標(biāo)調(diào)整,最終精確判定各候選區(qū)域內(nèi)的行人分類邊界框。第二步在行人分類邊界框中預(yù)測骨骼關(guān)鍵點,結(jié)合骨骼關(guān)鍵點的非極大值抑制和熱力圖置信度分?jǐn)?shù)預(yù)測的新方式,輸出擁擠場景下較為精確的姿態(tài)估計結(jié)果。

圖1 多人姿態(tài)估計方法

2.1 行人檢測

行人檢測器主要基于Faster-RCNN 利用ResNet-101 網(wǎng)絡(luò)主干,通過對空洞卷積進行修改,在不做池化損失信息的情況下增大感受野,加強網(wǎng)絡(luò)的特征提取能力,以生成輸出步幅為8 像素的更密集熱力圖。CNN 的主干已經(jīng)在ImageNet 中進行了圖像分類預(yù)訓(xùn)練,F(xiàn)aster-RCNN 檢測器的區(qū)域建議和預(yù)測框分類器組件都使用COCO 數(shù)據(jù)集中的行人類別進行訓(xùn)練,其余79個COCO類別的框注釋都被忽略,為了簡單便于實現(xiàn),F(xiàn)aster-RCNN 在行人檢測框階段沒有使用多尺度預(yù)測,這樣的增強可以進一步改進行人預(yù)測的結(jié)果。

2.2 行人姿態(tài)估計

基于第一階段輸入的每個行人分類邊界框,通過姿態(tài)估計方法預(yù)測出行人17 個骨骼關(guān)鍵點所對應(yīng)的位置。

2.2.1 利用卷積神經(jīng)網(wǎng)絡(luò)的熱力圖與偏移量預(yù)測

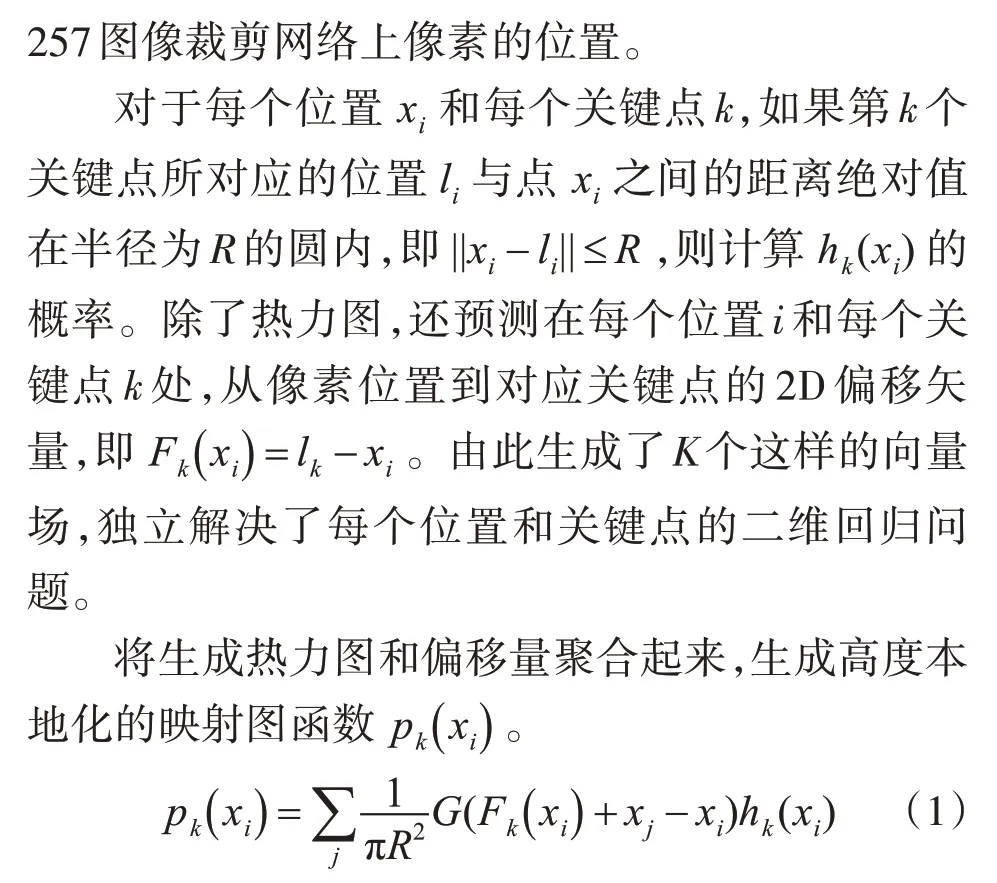

針對擁擠場景下,輸入圖像中包含多個行人導(dǎo)致骨骼關(guān)鍵點相重疊的問題,本文采用了分類與回歸相結(jié)合的方法。在裁剪后的圖像上以全卷積的方式應(yīng)用ResNet-101,生成熱力圖(每個關(guān)鍵點一個通道)和偏移量(x 和y 方向的每個關(guān)鍵點兩個通道),總共3K 輸出通道,其中K=17 是關(guān)鍵點的數(shù)量。在公開可用的Imagenet 預(yù)訓(xùn)練ResNet-101 模型初始化本文模型,用3×K 輸出的1×1 卷積替換其最后一層。使用空洞卷積生成3·K 預(yù)測,輸出步幅為8像素,并將它們雙上采樣達到353×257裁剪大小。

其中G(·)是是雙線值插值的內(nèi)核。式(1)是霍夫投票的一種形式:圖像裁剪網(wǎng)格中的每個點j 通過對每個關(guān)鍵點估計的位置進行投票,投票的權(quán)重依賴于點j 在對應(yīng)的關(guān)鍵點影響磁盤圓中的概率,正則化因素等同于磁盤圓的面積,確保在熱力圖和偏移量較合理下,pk( )xi是一個以第k 個關(guān)鍵點為中心的單位質(zhì)量函數(shù)。

該過程由圖2 展示,通過預(yù)測單獨的熱力圖和偏移通道并融合投票過程的建議結(jié)果,得到高度本地化的激活映射圖,精確定位關(guān)鍵點的位置。

圖2 預(yù)測單個行人全部骨骼關(guān)鍵點本地化過程

2.2.2 模型訓(xùn)練

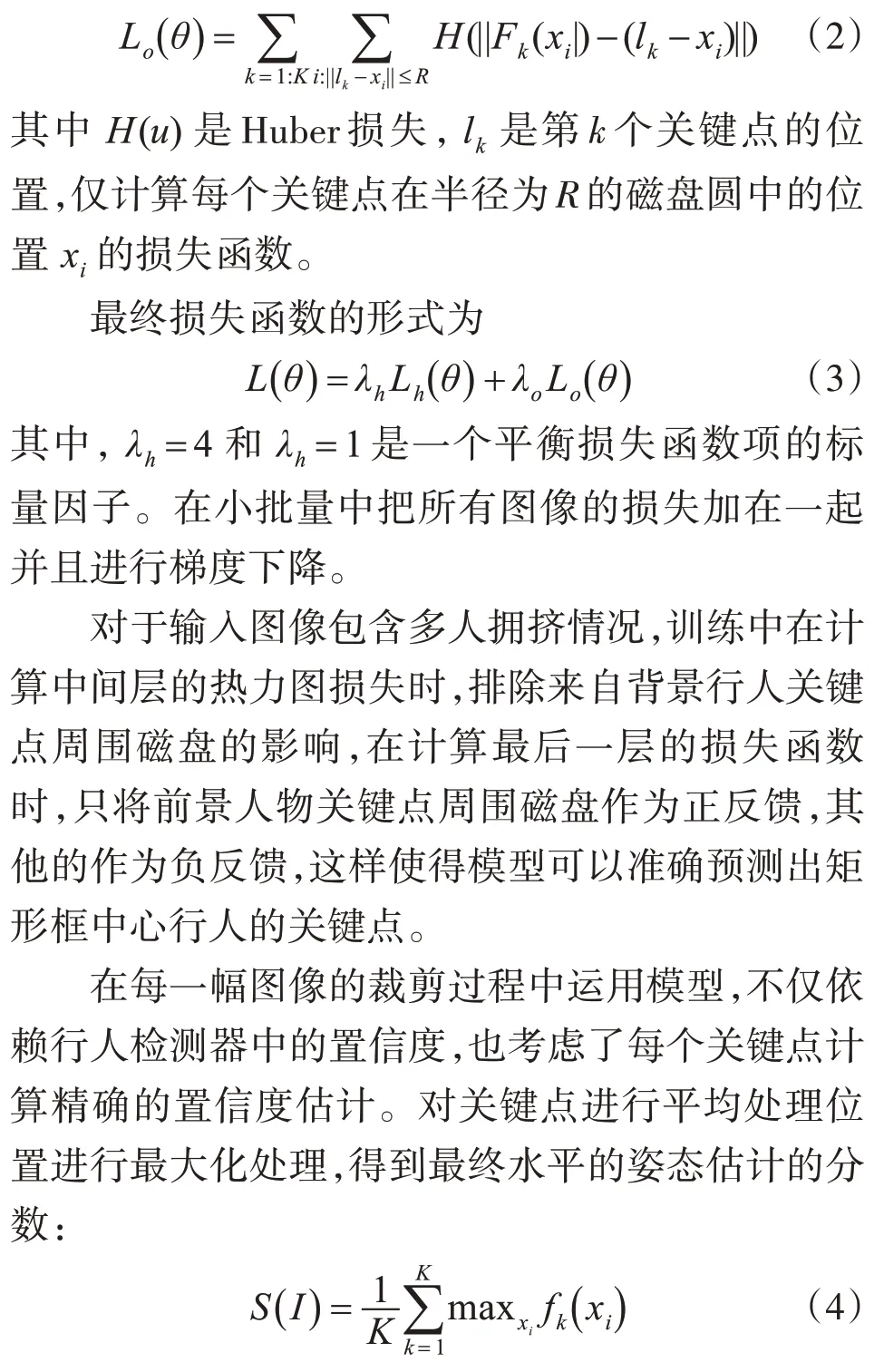

本文使用一個帶有兩個卷積輸出的單一ResNet 模型。第一個卷積經(jīng)過一個sigmoid 函數(shù)輸出,產(chǎn)生每個位置xi和每個關(guān)鍵點k對應(yīng)的熱力圖概率hk(xi)。訓(xùn)練目標(biāo)hk(xi)是一個由0 和1 組成的熱力圖,如果||xi-li||≤R,則hk(xi) = 1,否則為hk(xi)=0。hk(xi)相對應(yīng)的損失函數(shù)Lh(θ)是每個位置和單獨關(guān)鍵點邏輯損失的總和。為加快訓(xùn)練速度,在ResNet-50 中間層增加了一個額外的熱力圖預(yù)測層提供相應(yīng)的輔助損失。第二個卷積訓(xùn)練偏移量回歸,對預(yù)測值與地面真實值之間的偏差進行了補償。相應(yīng)的損失函數(shù)為

該方法使用式(4)中的的姿態(tài)評估與Faster-RCNN檢測器評分相比,顯著提升了平均精度。

2.2.3 KS非極大值抑制方法(KS-NMS)

為避免擁擠場景下行人關(guān)鍵點檢測階段的重復(fù)多次檢測,應(yīng)用KS-NMS方法。通常使用盒的交并比(IOU)來測量重疊,本文KS-NMS 方法是考慮關(guān)鍵點的極大值抑制方法改進。對于兩個候選的姿態(tài)檢測使用行人關(guān)鍵點相似度來測量,通常在行人矩形框檢測器的輸出處使用一個相對較高的IOU-NMS 閾值(設(shè)置為0.6)來過濾高度重疊的矩形框。KS-NMS 方法在姿態(tài)估計中能夠輸出更適合于確定兩個候選檢測是對應(yīng)于假陽性(同一人的兩次重復(fù)檢測)還是真陽性(兩個相距很近的倆個人)的預(yù)測結(jié)果。

3 實驗結(jié)果與分析

3.1 數(shù)據(jù)集

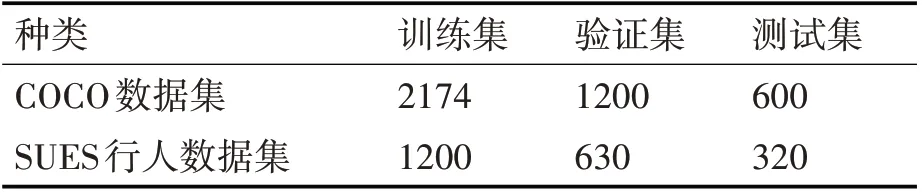

本文使用兩個數(shù)據(jù)集進行實驗,分別為COCO數(shù)據(jù)集和SUES 行人數(shù)據(jù)集。COCO 數(shù)據(jù)集使用關(guān)鍵點標(biāo)注數(shù)據(jù)集[11],COCO數(shù)據(jù)集中使用2174個作為模型訓(xùn)練集和1200 個模型驗證集,均包含行人實例。COCO 數(shù)據(jù)集中包含的擁擠的行人圖像較少,出于驗證本方法在部分擁擠狀態(tài)下的姿態(tài)估計情況,本文以圖3 所示的自主研制的智能車采集校園內(nèi)學(xué)生上下課時間段,采集行人擁擠場景下數(shù)據(jù)集,并定義一個人群指數(shù)衡量一幅圖像的擁擠程度,即建成SUES 行人數(shù)據(jù)集。表1 提供了數(shù)據(jù)集具體分配信息,單人或者多人不擁擠場景下的行人數(shù)據(jù)集來自于COCO 數(shù)據(jù)集,行人部分較擁擠狀態(tài)場景來自于SUES 校園行人數(shù)據(jù)集。訓(xùn)練Faster-RCNN 行人檢測矩形框模塊應(yīng)用COCO 數(shù)據(jù)集,訓(xùn)練ResNet 姿態(tài)估計模塊運用COCO 數(shù)據(jù)集或SUES校園行人數(shù)據(jù)集進行訓(xùn)練。

圖3 SUES行人數(shù)據(jù)采集車

表1 數(shù)據(jù)集分配信息

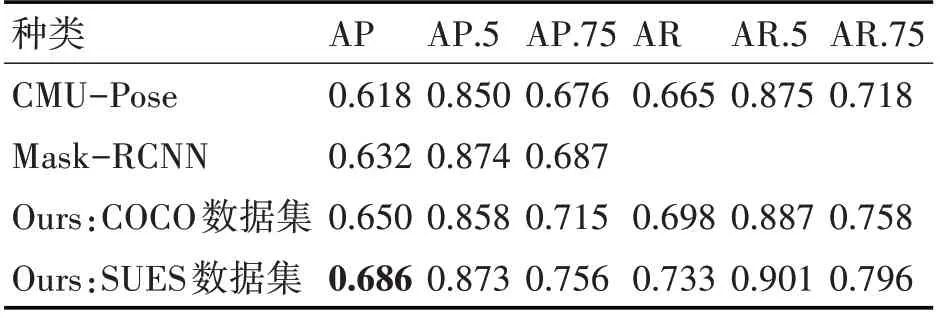

3.2 關(guān)鍵點檢測試驗結(jié)果

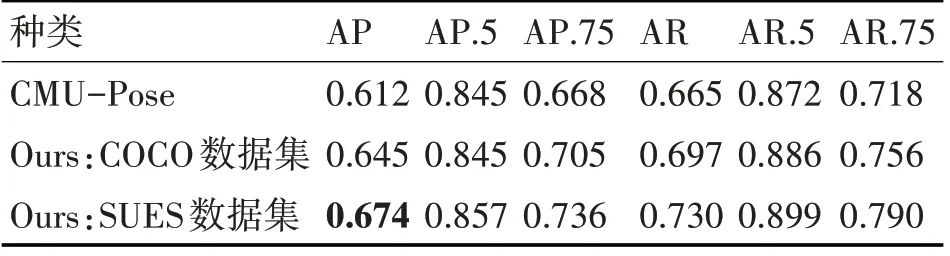

表2 顯示本文方法在COCO 或SUES 校園行人數(shù)據(jù)集上訓(xùn)練的關(guān)鍵點測試與驗證集上表現(xiàn)。

表2 不同方法檢測AP和AR對比結(jié)果

表3 顯示了本文方法在關(guān)鍵點測試標(biāo)準(zhǔn)分割結(jié)果,其中姿態(tài)估計器在COCO 或SUES 校園行人數(shù)據(jù)集上訓(xùn)練。

表3 關(guān)鍵點測試標(biāo)準(zhǔn)分割結(jié)果對比圖

即使僅在COCO 數(shù)據(jù)集中訓(xùn)練,在COCO 測試開發(fā)和測試標(biāo)準(zhǔn)分割上也取得了較好的結(jié)果,超過了CMUPose團隊[12]和最近的Mask-RCNN的方法[13]。最佳結(jié)果是使用基于SUES校園行人數(shù)據(jù)集的姿態(tài)估計器訓(xùn)練得到的,AP 評分為0.673,與CMUPose[14]的0.611測試標(biāo)準(zhǔn)分?jǐn)?shù)相比,提升了6.2%。

3.3 消融實驗

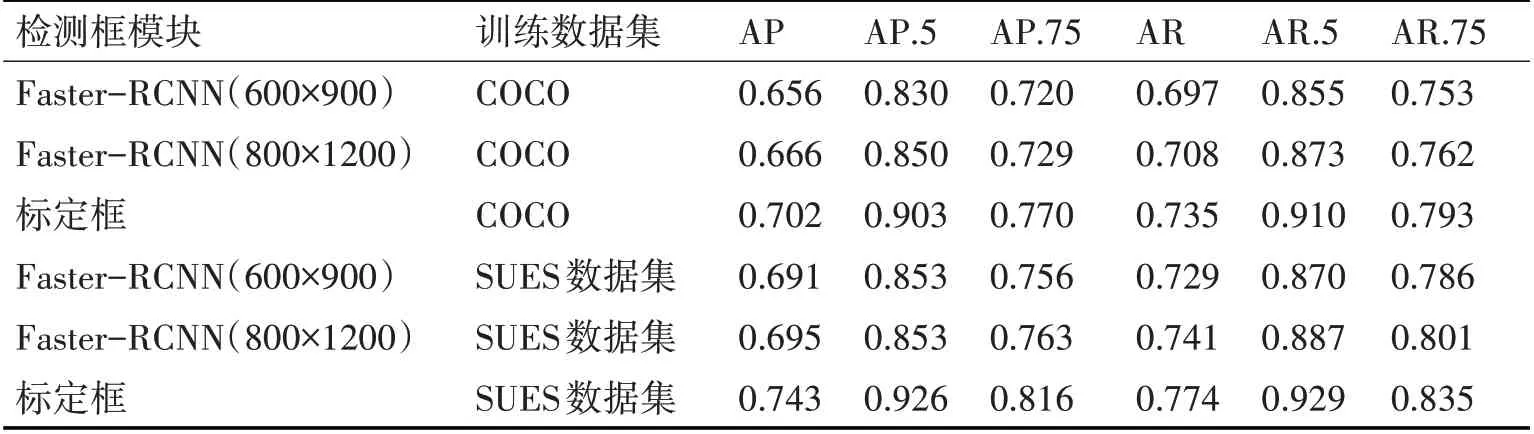

3.3.1 行人檢測矩形框模塊消融實驗

測試了基于Faster-RCNN 行人檢測器ResNet-101 網(wǎng)絡(luò)的倆個變體:1)使用小邊600 像素和大邊900 像素作為輸入圖像的一個600×900 變體,2)精確的800×1200 變體,使用小邊800 像素和大邊1200 像素的輸入圖像。在COCO 驗證集中行人檢測AP 分別是0.466 和0.500。在COCO 測試集上行人檢測AP[15]分別為0.456 和0.487。向姿態(tài)估計器模塊提供真實檢測框,以便在框檢測模塊隔離的情況下檢查它的預(yù)測性能。表4中表明了在COCO 數(shù)據(jù)集或SUES 行人數(shù)據(jù)集中訓(xùn)練的姿態(tài)估計器COCO驗證集的結(jié)果。

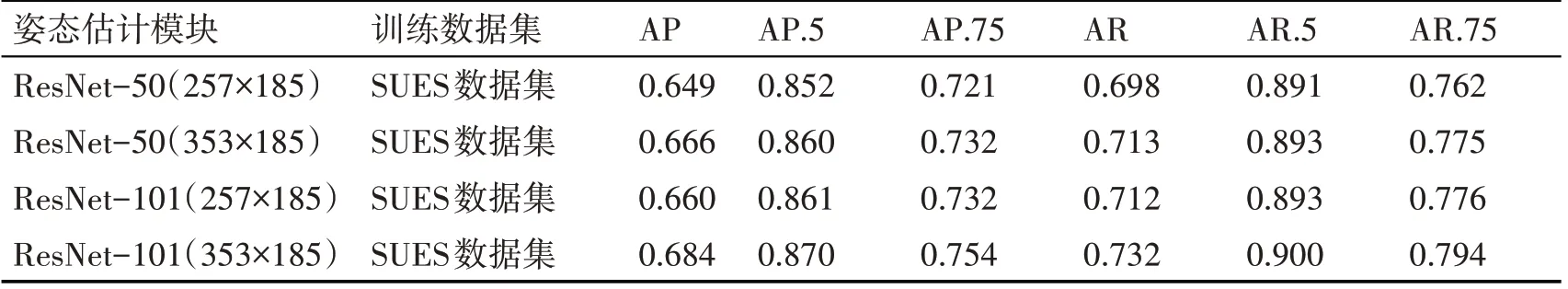

3.3.2 姿態(tài)估計模塊消融實驗

為姿態(tài)估計模塊實驗替代的CNN 設(shè)置,測試了更快的ResNet-50 或更準(zhǔn)確的ResNet-101 的CNN 網(wǎng)絡(luò)主干,同時保留ResNet-101 作為Faster-RCNN 行人矩形框檢測模塊的CNN 主干。使用兩種不同尺寸的圖像作為姿態(tài)估計的輸入[16]。表4 展示了使用SUES 行人數(shù)據(jù)集進行姿態(tài)估計訓(xùn)練,在COCO 數(shù)據(jù)集測試和驗證集下,關(guān)于四種不同CNN主干/裁剪圖像大小組合所展示的結(jié)果。由表可知ResNet-101 性能提高了2%,本文使用ResNet-101(353×257)姿態(tài)估計器,其磁盤半徑R=25像素。

表4 COCO數(shù)據(jù)集或SUES行人數(shù)據(jù)集中行人檢測模塊消融對比結(jié)果

表5 SUES數(shù)據(jù)集下四種不同CNN主干/裁剪圖像大小組合對比結(jié)果

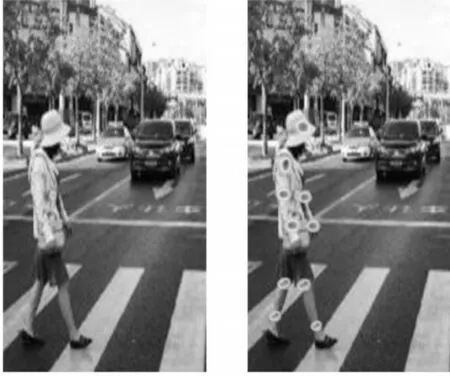

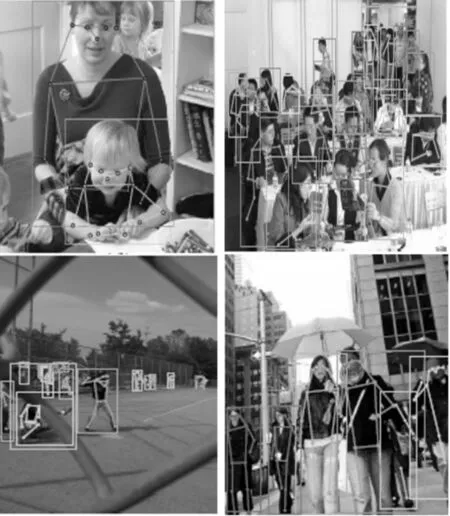

3.4 行人檢測與姿態(tài)估計結(jié)果

利用本文方法從COCO 測試和驗證數(shù)據(jù)集中隨機選擇部分圖片進行行人檢測檢測和姿態(tài)估計。部分擁擠環(huán)境下,對于每個被檢測到的行人,顯示檢測到的邊界框和估計的關(guān)鍵點。對于同一個行人的所有檢測使用同樣的方式著色,同一幅圖片中的不同的行人人采取不同的方式顏色表明檢測和姿態(tài)估計結(jié)果。值得注意的是,該方法在SUES行人數(shù)據(jù)集(環(huán)境復(fù)雜,遮擋較嚴(yán)重)中,也表現(xiàn)出較好的性能。

圖6 行人姿態(tài)估計結(jié)果展示

4 結(jié)語

針對行人擁擠場景下姿態(tài)密集交叉、識別能力急劇下降等問題,本文提出了一種有效解決擁擠場景下多人檢測以及姿態(tài)估計的方法。該方法主要由兩個關(guān)鍵部分組成,首先利用Faster-RCNN 行人檢測器,預(yù)測出包含行人位置和大小規(guī)模的矩形框。然后,預(yù)測每個矩形框中可能包含的行人骨骼關(guān)鍵點,使用全卷積ResNet 網(wǎng)絡(luò)來預(yù)測每個骨骼關(guān)鍵點的熱力圖和偏移量并輸出。對于擁擠狀態(tài)下的行人姿態(tài)估計也變現(xiàn)較好的性能。實驗結(jié)果表明,本文提出的方法在包含大量部分擁擠場景下的SUES 行人數(shù)據(jù)集以及COCO 數(shù)據(jù)集中,具備較強的魯棒性和較高的行人檢測與姿態(tài)估計準(zhǔn)確度。